L'utilisation de l' architecture von Neumann pour des applications avec intelligence artificielle est inefficace. Qu'est-ce qui va la remplacer?

L'utilisation des architectures existantes pour résoudre les problèmes d'apprentissage automatique (MO) et d'intelligence artificielle (AI) est devenue impossible. L'énergie consommée par l'IA a considérablement augmenté et le CPU, ainsi que le GPU, semblent de plus en plus être des outils inappropriés pour ce travail.

Les participants à plusieurs colloques ont convenu que les meilleures opportunités de changement significatif se présentent en l'absence de caractéristiques héritées qui doivent être entraînées. La plupart des systèmes ont évolué progressivement au fil du temps - et même si cela garantit une progression sûre, un tel schéma ne fournit pas de solutions optimales. Quand quelque chose de nouveau apparaît, il devient possible de jeter un regard neuf sur les choses et de choisir une meilleure direction que ce que les technologies conventionnelles offriront. C'est exactement ce qui a été discuté lors d'une récente conférence, où la question a été étudiée de savoir si la structure complémentaire métal-oxyde-semi-conducteur (

CMOS ) est la meilleure technologie de base sur laquelle il vaut la peine de construire des applications d'IA.

Un Chen, nommé par IBM en tant que directeur exécutif de la Nanoelectronics Research Initiative (NRI), a ouvert la voie à la discussion. «Depuis de nombreuses années, nous recherchons de nouvelles technologies modernes, notamment la recherche d'une alternative au CMOS, notamment en raison de ses problèmes liés à la consommation électrique et à la mise à l'échelle. Après toutes ces années, une opinion s'est développée que nous n'avons rien trouvé de mieux comme base pour créer des circuits logiques. Aujourd'hui, de nombreux chercheurs se concentrent sur l'IA, et elle offre vraiment de nouvelles façons de penser et de nouveaux modèles, et ils ont de nouveaux produits technologiques. Les nouveaux appareils AI pourront-ils remplacer CMOS? »

AI aujourd'hui

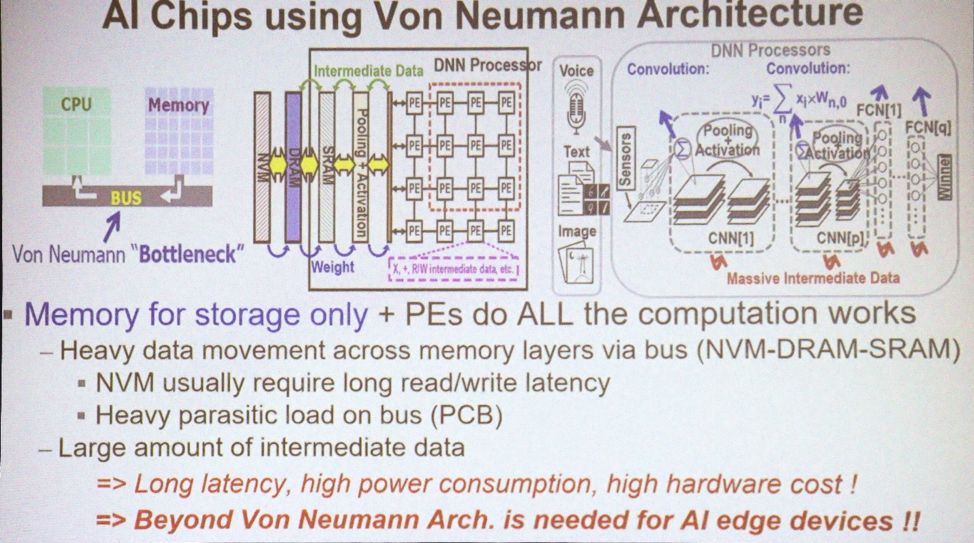

La plupart des applications MO et AI utilisent l'architecture von Neumann. "Il utilise de la mémoire pour stocker des tableaux de données, et le CPU effectue tous les calculs", explique Marvin Chen, professeur de génie électrique à l'Université nationale de Xinhua. «De grandes quantités de données circulent dans le bus. Aujourd'hui, les GPU sont également souvent utilisés pour une formation approfondie, y compris les réseaux de neurones convolutifs. L'un des principaux problèmes est l'apparition de données intermédiaires nécessaires pour tirer des conclusions. Le déplacement de données, en particulier au-delà de la puce, entraîne des pertes d'énergie et des retards. Il s'agit d'un goulot d'étranglement technologique. »

Architectures utilisées pour l'IA

Architectures utilisées pour l'IACe dont vous avez besoin aujourd'hui, c'est de combiner le traitement des données et la mémoire. «Le concept de l'informatique en mémoire est proposé par les experts en architecture informatique depuis de nombreuses années», explique Chen. - Il existe plusieurs schémas pour la mémoire SRAM et la mémoire non volatile, avec lesquels ils ont essayé d'utiliser et de mettre en œuvre un tel concept. Idéalement, si cela réussit, vous pouvez économiser une énorme quantité d'énergie en éliminant le mouvement des données entre le CPU et la mémoire. Mais c'est idéal. "

Mais pour aujourd'hui, nous n'avons aucun calcul en tête. "Nous avons toujours AI 1.0 utilisant l'architecture von Neumann, car les dispositifs en silicium qui implémentent le traitement en mémoire ne sont jamais apparus", se plaint. Chen "La seule façon d'utiliser 3D TSV de quelque manière que ce soit est d'utiliser la mémoire haute vitesse avec le GPU pour résoudre le problème de bande passante." Mais cela reste un goulot d'étranglement pour l'énergie et le temps. "

Y aura-t-il suffisamment de traitement de données en mémoire pour résoudre le problème de la perte d'énergie? "Le cerveau humain contient cent milliards de neurones et 10

15 synapses", a déclaré Sean Lee, directeur adjoint de Taiwan Semiconductor Manufacturing Company. «Maintenant, regardez IBM TrueNorth.» TrueNorth est un processeur multicœur développé par IBM en 2014. Il comprend 4 096 cœurs et chacun possède 256 neurones artificiels programmables. «Supposons que nous voulons l'échelle et reproduire la taille du cerveau. La différence est de 5 ordres de grandeur. Mais si nous augmentons simplement les nombres et multiplions TrueNorth, consommant 65 mW, nous obtenons alors une machine avec une consommation de 65 kW contre le cerveau d'une personne consommant 25 watts. La consommation doit être réduite de plusieurs ordres de grandeur. "

Lee offre une autre façon d'imaginer cette opportunité. "Le supercalculateur le plus efficace à ce jour est le Green500 du Japon, qui émet 17 Gflops par watt, soit 1

flop à 59 pJ." Le site Web Green500 indique que le système ZettaScaler-2.2 installé au Advanced Computing and Communications Center (RIKEN) du Japon a mesuré 18,4 Gflops / W pendant le test Linpack, qui a nécessité 858 TFlops. «Comparez cela avec

le principe de Landauer , selon lequel à température ambiante l'énergie de commutation minimale du transistor est de l'ordre de 2,75 zJ [10

-21 J]. Encore une fois, la différence est de plusieurs ordres de grandeur. 59 pJ est d'environ 10

-11 contre le minimum théorique d'environ 10

-21 . Nous avons un immense champ de recherche. "

Est-il juste de comparer de tels ordinateurs avec le cerveau? «Après avoir examiné les récents succès de la formation approfondie, nous verrons que, dans la plupart des cas, les personnes et les machines sont en concurrence au cours des sept dernières années consécutives», explique Kaushik Roy, professeur émérite de génie électrique et d'informatique à l'Université Purdue. «En 1997, Deep Blue a battu Kasparov, en 2011, IBM Watson a remporté le jeu Jeopardy!, Et en 2016, Alpha Go a vaincu Lee Sedola. Ce sont les plus grandes réalisations. Mais à quel prix? Ces machines consommaient de 200 à 300 kW. Le cerveau humain consomme environ 20 watts. Grand écart. D'où viendra l'innovation?

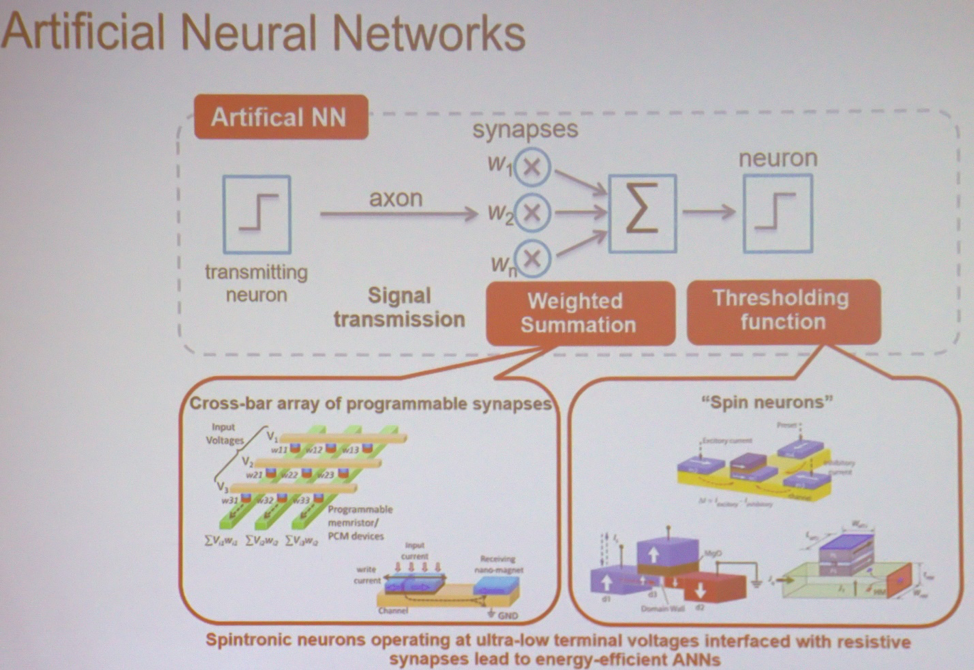

Au cœur de la plupart des applications, MO et AI sont les calculs les plus simples effectués à grande échelle. «Si vous prenez le réseau neuronal le plus simple, il effectue une sommation pondérée, suivie d'une opération de seuil», explique Roy. - Cela peut être fait dans différents types de matrices. Il peut s'agir d'un appareil de spintronique ou de mémoire résistive. Dans ce cas, la tension d'entrée et la conductivité résultante seront associées à chaque point d'intersection. En sortie, vous obtenez la somme des tensions multipliée par la conductivité. Ceci est le courant. Ensuite, vous pouvez prendre des appareils similaires qui effectuent une opération de seuil. L'architecture peut être imaginée comme un ensemble de ces nœuds connectés entre eux afin d'effectuer des calculs. »

Les principaux composants du réseau neuronal

Les principaux composants du réseau neuronalDe nouveaux types de mémoire

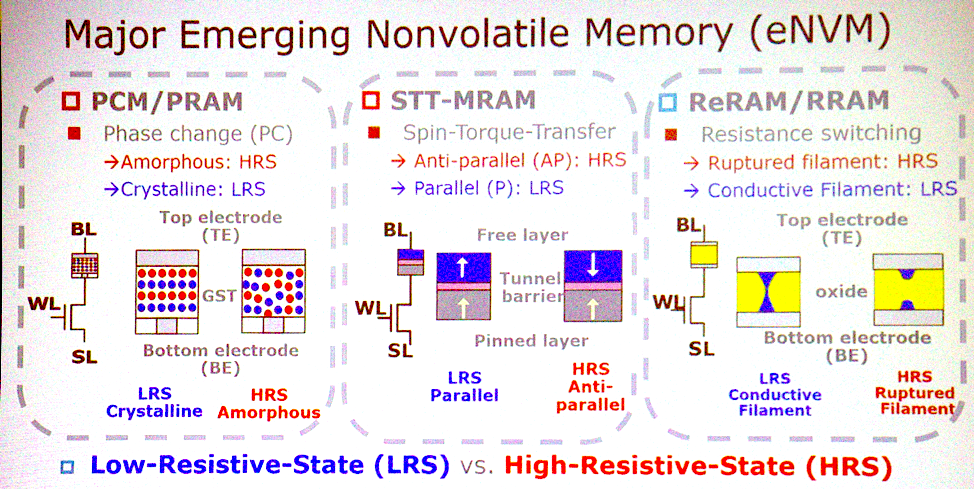

La plupart des architectures potentielles sont associées à des types émergents de mémoire non volatile. "Quelles sont les caractéristiques les plus importantes?" «Demande Jeffrey Barr, chercheur chez IBM Research. «Je mettrais une mémoire résistive analogique non volatile, comme une mémoire avec changement de phase, des memristors, etc. L'idée est que ces appareils sont capables de faire toutes les multiplications pour des couches entièrement connectées de réseaux de neurones en un cycle. Sur un processeur, cela peut prendre un million de cycles d'horloge, et dans un appareil analogique, cela peut être fait en utilisant la physique travaillant à l'emplacement des données. Il y a suffisamment d'aspects très intéressants en termes de temps et d'énergie pour que cette idée se transforme en quelque chose de plus. "

Nouvelles technologies de mémoire

Nouvelles technologies de mémoireChen est d'accord avec cela. «PCM, STT a de sérieuses enchères à gagner. Ces trois types de mémoire sont de bons candidats pour l'implémentation du calcul en mémoire. Ils sont capables d'opérations logiques de base. Certaines espèces ont des problèmes de fiabilité et ne peuvent pas être utilisées pour la formation, mais il est possible de tirer une conclusion. "

Mais il peut s'avérer qu'il n'est pas nécessaire de basculer vers cette mémoire. «Les gens parlent d'utiliser SRAM exactement dans le même but», ajoute Lee. «Ils font de l'informatique analogique avec SRAM.» Le seul point négatif est que la SRAM est trop grande - 6 ou 8 transistors par bit. Par conséquent, ce n'est pas un fait que nous utiliserons ces nouvelles technologies en informatique analogique. »

La transition vers l'informatique analogique implique également que la précision des calculs ne sera plus une nécessité. «L'IA se spécialise, classe et prévoit», dit-il. «Il prend des décisions qui peuvent être grossières.» En termes de précision, nous pouvons renoncer à quelque chose. Nous devons déterminer quels calculs résistent aux erreurs. Ensuite, certaines technologies peuvent être appliquées pour réduire la consommation d'énergie ou accélérer l'informatique. Le CMOS probabiliste travaille depuis 2003. Il s'agit notamment de baisser la tension jusqu'à l'apparition de plusieurs erreurs, dont le nombre reste tolérable. Aujourd'hui, les gens utilisent déjà des techniques de calcul approximatives, telles que la quantification. Au lieu d'un nombre à virgule flottante 32 bits, vous aurez des entiers 8 bits. Les ordinateurs analogiques sont une autre fonctionnalité déjà mentionnée. »

Sortez du laboratoire

Passer de la technologie du laboratoire au public peut être difficile. «Parfois, il faut chercher des alternatives», explique Barr. - Lorsque la mémoire flash bidimensionnelle n'a pas décollé, la mémoire flash tridimensionnelle a semblé ne plus être une tâche aussi difficile. Si nous continuons à améliorer les technologies existantes, obtenant un doublement des caractéristiques ici, doublant là, alors les calculs analogiques à l'intérieur de la mémoire seront abandonnés. Mais si les améliorations suivantes s'avèrent insignifiantes, la mémoire analogique sera plus attrayante. En tant que chercheurs, nous devons nous préparer à de nouvelles opportunités. »

L'économie ralentit souvent le développement, en particulier dans le domaine de la mémoire, mais Barr dit que cela ne se produira pas dans ce cas. «L'un de nos avantages est que ce produit ne sera pas lié à la mémoire. Ce ne sera pas quelque chose avec des améliorations mineures. Ce n'est pas un produit de consommation. C'est une chose en concurrence avec le GPU. Ils sont vendus à un prix 70 fois supérieur au coût de la DRAM placée sur eux, il s'agit donc clairement d'un produit sans mémoire. Et le coût du produit ne différera pas beaucoup de la mémoire. Cela semble bien, mais lorsque vous prenez des décisions valant des milliards de dollars, tous les coûts et le plan de développement de produits doivent être clairs. Pour surmonter cet obstacle, nous devons livrer des prototypes impressionnants. »

Remplacement CMOS

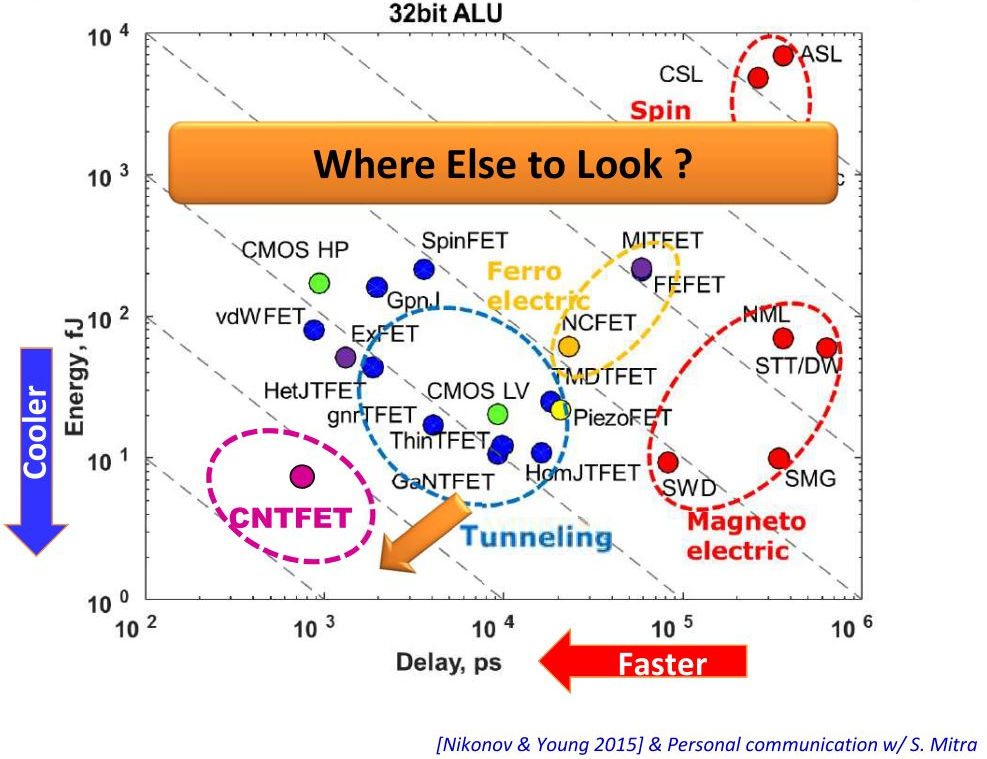

Le traitement des données en mémoire peut offrir des avantages impressionnants, mais davantage est nécessaire pour mettre en œuvre la technologie. Tout autre matériel que le CMOS peut-il aider à cet égard? "En examinant la transition du CMOS à faible consommation aux FET tunnel, nous parlons d'une réduction de 1 à 2 fois de la consommation", explique Lee. - Une autre possibilité est les circuits intégrés tridimensionnels. Ils réduisent la longueur de câblage à l'aide de TSV. Cela réduit à la fois la consommation d'énergie et la latence. Regardez les centres de données, ils retirent tous le câblage métallique et connectent l'optique. "

Vertical - consommation d'énergie, horizontal - retards d'appareil

Vertical - consommation d'énergie, horizontal - retards d'appareilBien que vous puissiez obtenir certains avantages lorsque vous passez à une technologie différente, ils n'en valent peut-être pas la peine. «Il sera très difficile de remplacer le CMOS, mais certains des appareils discutés peuvent compléter la technologie CMOS afin qu'elle effectue des calculs en mémoire», explique Roy. - CMOS peut prendre en charge les calculs en mémoire sous forme analogique, éventuellement dans la cellule 8T. Est-il possible de créer une architecture avec un net avantage sur CMOS? Si tout est fait correctement, le CMOS me donnera des milliers de fois plus d'efficacité énergétique. Mais cela prend du temps. »

De toute évidence, CMOS ne remplacera pas. «Les nouvelles technologies ne rejetteront pas les anciennes et ne seront pas fabriquées sur des substrats autres que CMOS», conclut Barr.