Les couvercles et les caméras sont deux éléments de configuration standard pour presque tous les robots. Le premier et le deuxième fonctionnent avec de la lumière réfléchie. Dans le même temps, les caméras fonctionnent en mode passif, c'est-à-dire qu'elles captent la réflexion de sources lumineuses tierces, mais les lidars génèrent des impulsions laser, puis mesurent la "réponse" réfléchie par les objets voisins. Les caméras forment une image en deux dimensions et les lidars forment une image en trois dimensions, quelque chose comme un «nuage de points».

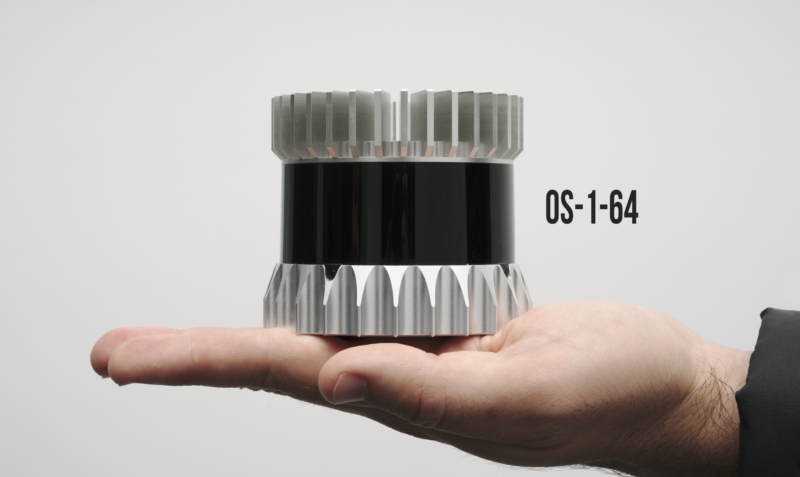

Ouster a

développé un appareil hybride qui fonctionne à la fois comme appareil photo et comme lidar. Ce système est appelé OS-1. Cet appareil a une ouverture plus grande que la plupart des reflex numériques et le capteur créé par l'entreprise est très sensible.

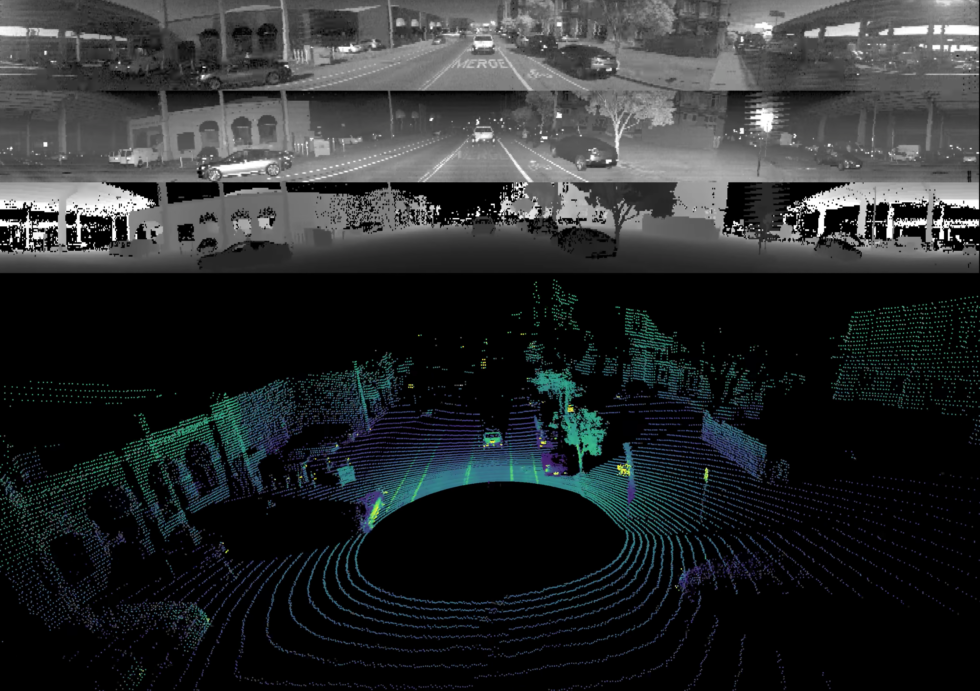

Les images obtenues par le système se composent de trois couches. La première est l'image obtenue comme par une caméra normale. La seconde est une couche «laser» obtenue par réflexion du faisceau laser. Et le troisième est le calque «profond», qui vous permet d'estimer la distance entre les pixels individuels des deux premiers calques.

Il convient de noter que les images présentent encore des limitations importantes. Premièrement, ce sont des images basse résolution. Deuxièmement, ils sont en noir et blanc, pas en couleur. Troisièmement, le lidar ne fonctionne pas avec une source de lumière visible; il traite un spectre proche de l'infrarouge.

À l'heure actuelle, le coût du lidar est assez élevé - environ 12 000 $. À première vue, il n'y a aucun intérêt dans un système qui reçoit des images de résolution inférieure à celle des caméras standard, mais coûte comme un pont en fonte. Mais les développeurs affirment qu'un principe de travail différent est utilisé ici que dans le cas habituel.

Ce sont des documents graphiques fournis par Ouster. Trois couches d'images et une «image» générale sont présentées ici, qui résulte de

Ce sont des documents graphiques fournis par Ouster. Trois couches d'images et une «image» générale sont présentées ici, qui résulte deDans une situation typique, les robomobiles combinent des données provenant de plusieurs sources différentes, ce qui prend du temps. Les caméras et les lidars fonctionnent dans différents modes, le résultat est également différent. De plus, ils sont généralement montés à divers endroits de la carrosserie de la voiture, de sorte que l'ordinateur doit également gérer la corrélation d'images afin qu'ils soient compatibles. De plus, les capteurs nécessitent un recalibrage régulier, ce qui n'est pas si simple.

Certains développeurs de lidar ont déjà essayé de combiner la caméra avec le lidar. Mais les résultats n'étaient pas très bons. Il s'agissait d'un système «caméra standard + lidar», qui ne différait pas trop des schémas existants.

Ouster utilise à la place un système qui permet à OS-1 de collecter toutes les données dans un standard et à partir d'un emplacement. Les trois couches de l'image sont parfaitement corrélées, à la fois dans le temps et dans l'espace. Dans ce cas, l'ordinateur comprend la distance entre les pixels individuels de l'image finale.

Selon les auteurs du projet, un tel schéma est presque idéal pour l'apprentissage automatique. Pour les systèmes informatiques, le traitement de ce type d'image n'est pas difficile. Après avoir «alimenté» le système de plusieurs centaines d'images, il peut être formé pour comprendre exactement ce qui est montré dans la «photo» finale.

Certains types de réseaux de neurones sont conçus de manière à fonctionner sans problème avec des multicouches de cartes de pixels. De plus, les images peuvent contenir une couche rouge, bleue et verte. Former de tels systèmes à travailler avec le résultat de OS-1 n'est pas difficile. Ouster a déjà accompli cela.

En tant que matériel source, ils ont pris plusieurs réseaux de neurones conçus pour reconnaître les images RVB et les ont modifiés pour répondre à leurs besoins, leur apprenant à travailler avec différentes couches de leurs images. Le traitement des données est effectué sur l'équipement avec le Nvidia GTX 1060. À l'aide de réseaux de neurones, l'ordinateur de voiture a appris à «peindre» la route en jaune et les obstacles potentiels - d'autres voitures - en rouge.

Selon les développeurs, leur système s'ajoute aux systèmes existants et non à un remplacement. Il est préférable de combiner toutes sortes de capteurs, capteurs, caméras, lidars et systèmes hybrides pour former une image claire de l'environnement qui aidera la voiture à naviguer.