En juin, une équipe de scientifiques de l'Université de Californie à San Francisco a

publié une étude qui éclaire la façon dont les gens changent de ton dans leur discours.

Les résultats de cette étude peuvent être utiles pour créer des synthétiseurs de discours à consonance naturelle - avec des émotions et diverses intonations.

À propos de l'étude - dans notre article d'aujourd'hui.

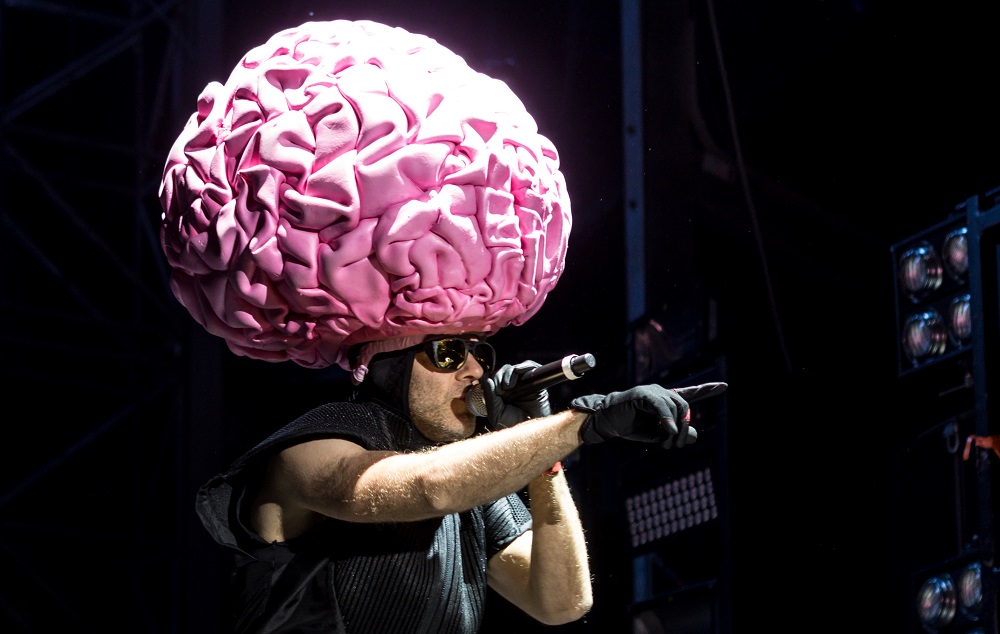

Photo Florian Koppe / CC

Photo Florian Koppe / CCComment était l'étude

Une équipe de scientifiques de l'Université de Californie a récemment mené une série d'expériences. Elle étudie la relation entre les différentes parties du cerveau et les organes de la parole. Les chercheurs tentent de découvrir ce qui se passe dans le cerveau lors d'une conversation.

Le travail en question dans l'article se concentre sur la zone contrôlant le larynx, y compris au moment du changement de hauteur.

Le principal spécialiste de l'étude était le neurochirurgien Edward Chang (Edward Chang). Il travaille avec des patients épileptiques - il effectue des opérations qui préviennent les convulsions. Chang surveille l'activité cérébrale de certains de ses patients à l'aide d'un équipement spécial.

L'équipe a recruté des bénévoles pour leurs recherches dans ce groupe particulier de patients. Les capteurs connectés vous permettent de surveiller leur activité neuronale lors des expériences. Cette méthode - connue sous le nom d'

électrocorticographie - a aidé les scientifiques à trouver la zone du cerveau responsable des changements de hauteur.

Les participants à l'étude ont été invités à répéter la même phrase à haute voix, mais à mettre l'accent à chaque fois sur des mots différents. De là, le sens de la phrase a changé. Dans le même temps, la fréquence du son fondamental a également changé - la fréquence des cordes vocales.

L'équipe a découvert que les neurones d'une zone du cerveau étaient activés lorsque le patient élevait le ton. Cette zone de la zone motrice du cortex est responsable des muscles du larynx. Les chercheurs ont stimulé l'électricité vers les neurones dans cette zone, à laquelle les muscles du larynx ont répondu avec tension, et certains patients ont en même temps émis des sons involontaires.

Les participants à l'étude ont également inclus un enregistrement de leurs propres votes. Cela a provoqué une réponse des neurones. À partir de cela, les membres de l'équipe ont conclu que cette zone du cerveau participe non seulement à la modification de la fréquence du ton fondamental, mais également à la perception de la parole. Cela peut donner une idée de la façon dont le cerveau participe à l'imitation du discours de quelqu'un d'autre - cela vous permet de changer la hauteur et d'autres caractéristiques pour parodier l'interlocuteur.

Utile dans le développement de synthétiseurs vocaux

Le journaliste Robbie Gonzalez de Wired

estime que les résultats de l'étude peuvent être utiles dans les prothèses du larynx et permettre aux patients sans voix de "parler" de façon plus réaliste. Ceci est confirmé par les scientifiques eux-mêmes.

Les synthétiseurs de la parole humaine - par exemple, celui

utilisé par Stephen Hawking - sont toujours capables de reproduire des mots, interprétant l'activité neuronale. Cependant, ils ne peuvent pas souligner, comme le ferait une personne avec un appareil de parole sain. Pour cette raison, le discours ne semble pas naturel, et il n'est pas toujours clair si l'interlocuteur pose une question ou fait une déclaration.

Les scientifiques continuent d'explorer la zone du cerveau qui est responsable du changement de la fréquence du ton fondamental. On suppose qu'à l'avenir, les synthétiseurs vocaux seront en mesure d'analyser l'activité neuronale dans ce domaine et, sur la base des données obtenues, de construire des phrases de manière naturelle - mettez l'accent sur les bons mots avec la hauteur, formulez des questions et des déclarations de manière intonationnelle en fonction de ce que la personne veut dire.

Autres études sur le modèle de la parole

Il n'y a pas si longtemps, une autre

étude a été menée dans le laboratoire d'Edward Chang, qui peut aider au développement d'appareils de formation de la voix. Les participants ont lu des centaines de phrases, au son desquelles presque toutes les constructions phonétiques possibles de l'anglais américain ont été utilisées. Et les scientifiques ont suivi l'activité neuronale des sujets.

Photo PxHere / PD

Photo PxHere / PDCette fois, la coarticulation est devenue un objet d'intérêt - comment les organes du tractus vocal (par exemple, les lèvres et la langue) fonctionnent lorsqu'ils prononcent des sons différents. Une attention particulière a été portée aux mots dans lesquels différentes voyelles suivent la même consonne solide. Lorsque vous prononcez de tels mots, les lèvres et la langue fonctionnent souvent différemment - en conséquence, notre perception des sons correspondants est également différente.

Les scientifiques ont non seulement déterminé les groupes de neurones responsables de mouvements spécifiques des organes du tractus vocal, mais ont également constaté que les centres de la parole du cerveau coordonnent les mouvements des muscles de la langue, du larynx et d'autres organes du tractus vocal, en s'appuyant sur le contexte de la parole - l'ordre dans lequel les sons sont émis. Nous savons que le langage prend différentes positions en fonction de ce que sera le prochain son du mot, et il existe un grand nombre de ces combinaisons sonores - c'est un autre facteur qui rend le son de la parole humaine naturel.

L'étude de toutes les options de coarticulation contrôlées par l'activité neuronale jouera également un rôle dans le développement de technologies de synthèse vocale pour les personnes qui ont perdu la capacité de parler, mais dont les fonctions neuronales ont été préservées.

Pour aider les personnes handicapées

, des systèmes qui fonctionnent sur le principe inverse sont également utilisés - des outils basés sur l'IA qui aident à convertir la parole en texte. La présence d'intonations et d'accents dans la parole est également une difficulté pour cette technologie. Leur présence empêche les algorithmes d'intelligence artificielle de reconnaître des mots individuels.

Des employés de Cisco, de l'Institut de physique et de technologie de Moscou et de la Higher School of Economics ont récemment

présenté une solution possible au problème de la conversion de l'anglais américain en texte. Leur système utilise la

base de prononciation

CMUdict et les capacités de réseau de neurones récurrents. Leur méthode consiste en un «nettoyage» préliminaire automatique de la parole des sons «supplémentaires». Ainsi, en termes de son, la parole est proche de l'anglais américain parlé, sans «traces» régionales ou ethniques clairement exprimées.

L'avenir de la recherche sur la parole

À l'avenir, le professeur Chang

souhaite également

explorer le fonctionnement du cerveau des personnes parlant chinois. En eux, les variations de la fréquence du ton fondamental peuvent changer considérablement le sens du mot. Les scientifiques s'intéressent à la façon dont les gens perçoivent différentes constructions phonétiques dans ce cas.

Benjamin Dichter, l'un des collègues de Chang,

pense que la prochaine étape est d'aller plus loin dans la compréhension de la relation cerveau-larynx. L'équipe doit maintenant apprendre à deviner quelle fréquence de tonalité le locuteur choisira en analysant son activité neuronale. C'est la clé pour créer un synthétiseur de parole au son naturel.

Les scientifiques

pensent que dans un proche avenir, il ne sera pas possible de libérer un tel appareil, mais l'étude de Dichter et de l'équipe rapprochera la science du moment où l'appareil de parole artificielle apprend à interpréter non seulement des mots individuels, mais aussi des intonations, ce qui signifie ajouter des émotions à la parole.

Plus intéressant sur le son - dans notre chaîne Telegram :

Comment sonnait Star Wars?

Comment sonnait Star Wars?

Gadgets audio fantaisie

Gadgets audio fantaisie

Sons du monde des cauchemars

Sons du monde des cauchemars

Cinéma dans les assiettes

Cinéma dans les assiettes

Musique au travail

Musique au travail