La reconnaissance d'images à l'aide de réseaux de neurones s'améliore, mais jusqu'à présent, les chercheurs n'ont pas surmonté certaines de ses lacunes fondamentales. Lorsqu'une personne voit clairement et clairement, par exemple, un vélo, même une IA avancée et entraînée peut voir un oiseau.

Souvent, la raison en est les soi-disant "données nuisibles" (ou "éléments concurrents", ou "copies malveillantes" ou même un tas d'options, car les "exemples adverses" n'ont pas reçu de traduction généralement acceptée). Ce sont les données que le classificateur de réseau neuronal trompe, lui glissant des signes d'autres classes - des informations non importantes et non visibles pour la perception humaine, mais nécessaires à la vision industrielle.

Des chercheurs de Google ont publié un travail en 2015, où ils ont illustré le problème avec cet exemple:

Un dégradé «nocif» a été appliqué à l'image du panda. La personne sur l'image résultante, bien sûr, continue de voir le panda, et le réseau neuronal le reconnaît comme un gibbon, car les signes d'une autre classe ont été spécialement mélangés dans les parties de l'image par lesquelles le réseau neuronal a appris à identifier les pandas.

Dans les zones où la vision industrielle doit être extrêmement précise et où les erreurs, le piratage et les actions des attaquants peuvent avoir des conséquences désastreuses, les données nuisibles sont un sérieux obstacle au développement. Les progrès dans la lutte sont lents et GoogleAI (l'unité de recherche sur l'IA de Google) a décidé de tirer le pouvoir de la communauté et d'organiser un concours.

La société propose à chacun de créer ses propres mécanismes de protection contre les données nuisibles, ou vice versa - des images parfaitement gâtées qu'aucun algorithme ne reconnaît correctement. Celui qui peut faire le mieux recevra un gros prix en espèces (la taille n'a pas encore été annoncée).

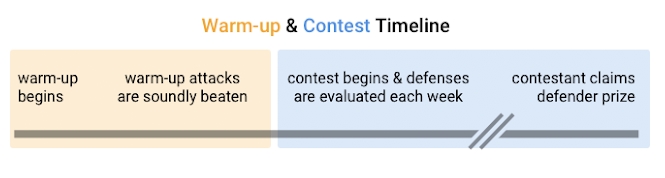

La compétition débutera par l'échauffement et l'exécution des premiers algorithmes sur des attaques simples avec des données nuisibles. Google a choisi trois ensembles de données avec des types de triche courants et bien étudiés. Les participants doivent créer des algorithmes qui reconnaissent toutes les images qui leur sont proposées sans une seule erreur ou réponse vague.

Étant donné que les conditions sur lesquelles sont basées les données nuisibles dans les ensembles de données de chauffage sont connues et accessibles, les organisateurs attendent des participants qu'ils créent facilement des algorithmes hautement personnalisés spécifiquement pour ces attaques. Par conséquent, ils mettent en garde - la plus évidente des solutions existantes n'a pas une seule chance au deuxième tour. Cela commence après l'échauffement, et il y aura déjà une partie compétitive, où les participants seront divisés en attaque et en défense.

Le concours s'articulera autour de la reconnaissance des photos d'oiseaux et de vélos. Tout d'abord, chaque photo proposée sera regardée par des personnes et émettra un verdict anonyme qui y est représenté. Une image n'entrera dans l'ensemble de données que si tous les juges conviennent qu'elle montre clairement un oiseau ou un vélo, et qu'il n'y a aucun signe de confusion évidente (par exemple, des oiseaux à vélo ou simplement des motifs abstraits et des photographies).

Ci-dessus sont des exemples d'images appropriées, ci-dessous ne conviennent pasLes participants en défense doivent créer un algorithme qui, sans une seule erreur, répartira les images en trois catégories - «oiseaux», «vélos» et «indéfini».Autrement dit, au stade de la compétition - contrairement à l'échauffement - l'algorithme peut s'abstenir de répondre, mais selon les résultats du traitement de l'ensemble de données, pas plus de 20% des images devraient tomber dans l'indéfini.

Les exigences techniques pour les algorithmes sont les suivantes:

- 80% des images doivent être reconnues. Aucune erreur n'est autorisée. Si les participants se joignent déjà pendant la phase de compétition, ils doivent réussir à traiter les 2 jeux de données précédents.

- La bande passante doit être d'au moins 1 image par minute sur la Tesla P100.

- Le système doit être facile à lire, écrit en TensorFlow, PyTorch, Caffe ou NumPy. Des systèmes trop déroutants et difficiles à reproduire peuvent être retirés du concours par décision des juges.

Si l'algorithme de protection dure 90 jours sans erreur, ses créateurs lui retireront la moitié du prize pool.

Les attaquants ont accès à des modèles non formés et à l'intégralité du code source des algorithmes.Leur tâche est de créer une image que tous les juges accepteront comme une image non ambiguë d'un vélo ou d'un oiseau, et l'algorithme prendra la mauvaise décision. Google collectera toutes les images proposées pour chaque semaine, puis les enverra pour inspection et seulement ensuite les inclura dans les ensembles de données.

Si les attaquants parviennent à tromper l'algorithme qui a géré les tâches précédentes, ils recevront de l'argent de la seconde moitié de la cagnotte. Si plusieurs équipes réussissent, l'argent sera réparti entre elles.

La compétition n'a pas de délais clairs et durera jusqu'à ce que le meilleur algorithme de protection apparaisse. Selon les organisateurs, leur objectif n'est pas seulement un système difficile à contourner, mais un réseau neuronal totalement à l'abri de toute attaque. Les directives de participation se trouvent sur

la page du projet sur Github .