Travailler avec les priorités est une tâche qui nécessite la préparation, l'expérience et la considération d'une variété de technologies, d'approches scientifiques, ainsi que des méthodes de droit d'auteur.

Cet article est une traduction de matériel de Hackernoon.com. Son auteur propose l'utilisation de son propre outil d'évaluation des priorités dans le cadre du ICE Scoring. Cet article décrit l'approche en détail et présente un exemple simple et accessible, compréhensible par tout chef de produit.

Itamar Gilad

Itamar Gilad est un consultant en gestion de produits bien connu et un conférencier à succès. Au cours de ses nombreuses années d'expérience - postes de direction dans la gestion de produits chez Google, Microsoft et d'autres sociétés bien connues. Nous vous proposons une traduction de son article:

Supposons que vous gérez un produit pour une petite entreprise et ses clients. Votre objectif est d'améliorer l'engagement et la fidélisation des clients. Vous avez deux idées à l'ordre du jour:

- Implémentation de la barre d'outils principale (tableau de bord), qui permet au propriétaire de l'entreprise de suivre les statistiques d'implication et toutes les tendances.

- Chatbot (chatbot) pour automatiser la communication avec les clients.

Une idée avec une barre d'outils est apparue à plusieurs reprises dans les négociations avec les clients, et vous sentez qu'elle a un bon potentiel, mais il y a un risque qu'elle ne soit utilisée que par des utilisateurs expérimentés.

L'idée d'un chatbot est agréable dans toute l'entreprise et la direction est plutôt optimiste. En outre, la fonctionnalité semble gagnante pour les clients.

Que choisiriez-vous?

Ces problèmes de priorisation sont au cœur de la gestion des produits. Les frais pour faire le mauvais choix peuvent être très élevés et inclure les coûts de développement, de déploiement, de maintenance, ainsi que d'autres coûts imprévus.

Nous sommes souvent tentés de prendre des décisions basées sur des signaux peu convaincants: opinions majoritaires, opinions des patrons, tendances de l'industrie, etc. Mais le temps montre que ces signaux sont précis au niveau d'un générateur de nombres aléatoires.

À mon avis, cet article vise à trouver les meilleures idées. Il se compose de trois parties:

- Indicateurs ICE

- Niveaux de confiance

- Vérification supplémentaire

Score ICE

ICE Scoring est une méthode d'établissement des priorités qui a été utilisée pour la première fois par Sean Ellis, connu pour sa participation active au développement de sociétés telles que DropBox et Eventbrite, et la promotion du terme Growth Hacking. L'ICE a été initialement conçu pour prioriser les expériences de croissance, mais a rapidement été utilisé pour évaluer toutes les idées.

Chez ICE, vous évaluez les idées de cette façon:

- L'influence démontre comment l'idée affectera positivement l'indicateur clé que vous essayez d'améliorer.

- La facilité de mise en œuvre ou la simplicité est une évaluation de l'effort et des ressources nécessaires pour mettre en œuvre cette idée.

- La confiance démontre votre confiance dans l'évaluation de l'impact et de la facilité de mise en œuvre.

Les valeurs de l'ICE sont notées sur une échelle de 1 à 10 afin que tous les facteurs équilibrent le score total. Par les valeurs 1 à 10, vous pouvez signifier n'importe quoi, l'essentiel est que les valeurs soient cohérentes les unes avec les autres.

Voyons maintenant un exemple de comment cela fonctionne.

ICE d'abord

Vous avez donc décidé de calculer les points ICE pour deux idées: le tableau de bord et le chatbot. À ce stade précoce, vous utilisez des significations grossières uniquement sur la base de votre propre intuition.

Impact - vous supposez qu'un tableau de bord augmentera considérablement la rétention des utilisateurs, mais seulement ceux expérimentés - vous donnez 5 sur 10. Un chatbot, en revanche, peut être une solution innovante pour de nombreux clients, vous lui donnez donc 8 sur 10.

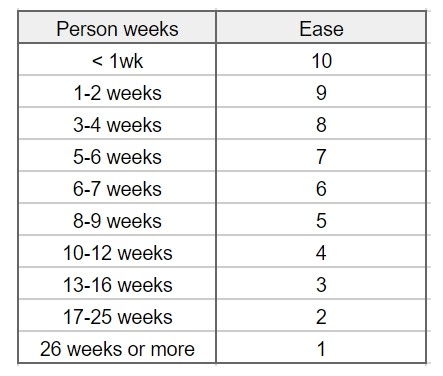

Facilité de mise en œuvre - vous estimez que 10 semaines-homme seront nécessaires pour le tableau de bord et 20 pour le chatbot. Plus tard, vous recevrez de meilleures estimations de l'équipe. Vous utilisez ce tableau simple (choisi par vous et votre équipe) pour convertir votre note en facilité:

Ainsi, la barre d'outils obtient une valeur de facilité de 4 sur 10 et un chatbot obtient une valeur de 2.

Calcul de la confiance

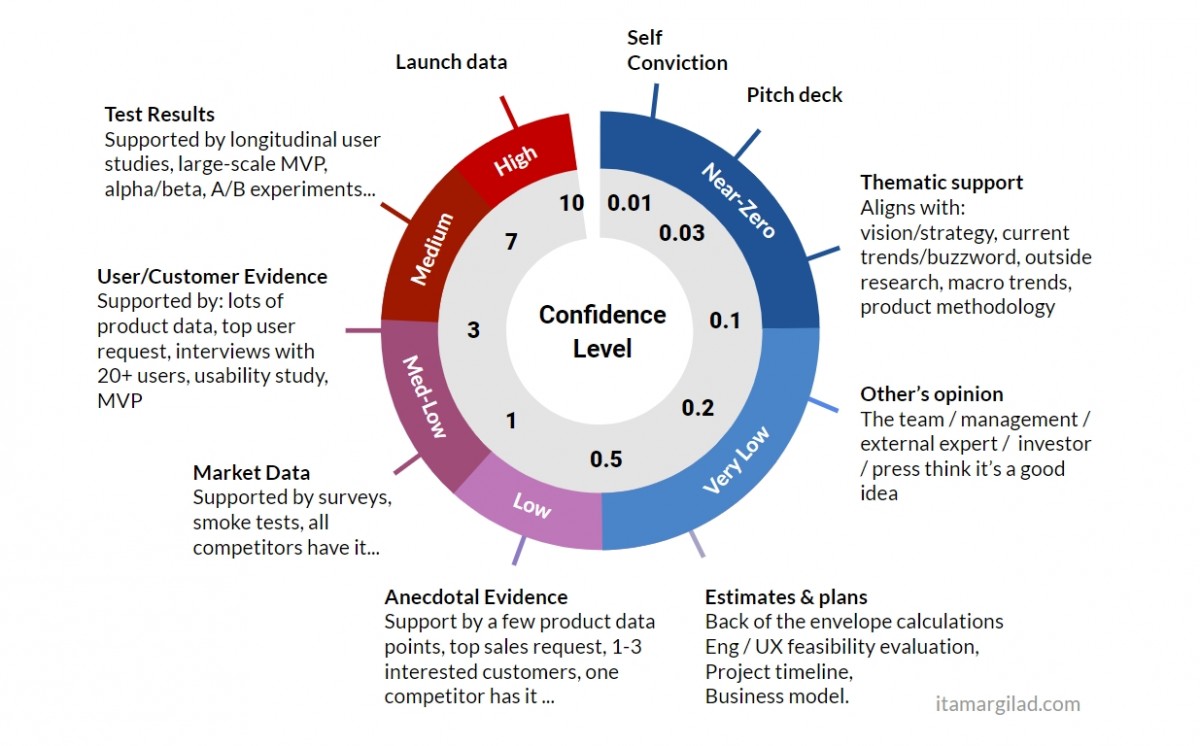

Il n'y a qu'une seule façon de calculer la confiance - c'est la recherche de preuves à l'appui. Pour ce faire, j'ai créé un outil qui peut être vu ci-dessous. Il répertorie les types généraux de tests et de preuves que vous pouvez avoir et le niveau de confiance qu'ils fournissent: résultats des tests, date de lancement, confiance personnelle, support thématique, opinions des autres, données du marché, etc.

Lorsque vous utilisez l'outil, considérez les indicateurs dont vous disposez déjà, le nombre d'entre eux et ce dont vous avez besoin pour gagner en confiance.

Si une autre preuve est possible dans votre produit ou votre industrie, n'hésitez pas à créer votre propre version de cet outil.

Revenons à l'exemple pour évaluer l'outil en action.

Preuve à l'appui d'un chatbot: confiance personnelle (vous pensez que c'est une bonne idée), soutien thématique (l'industrie pense également que c'est une bonne idée) et les opinions des autres (vos supérieurs et collègues considèrent cela comme une bonne idée). Cela lui donne une valeur de confiance générale de 0,1 sur 10 ou une confiance presque nulle. L'outil ne considère clairement pas les opinions comme un indicateur fiable.

Et le tableau de bord? Voici la confiance personnelle (vous pensez que c'est une bonne idée) et un soutien occasionnel (plusieurs clients l'ont demandé). Cela augmente en fait sa valeur de confiance à 0,5 sur 10, ce qui est une faible confiance. Malheureusement, les clients ne prédisent pas bien leur comportement futur.

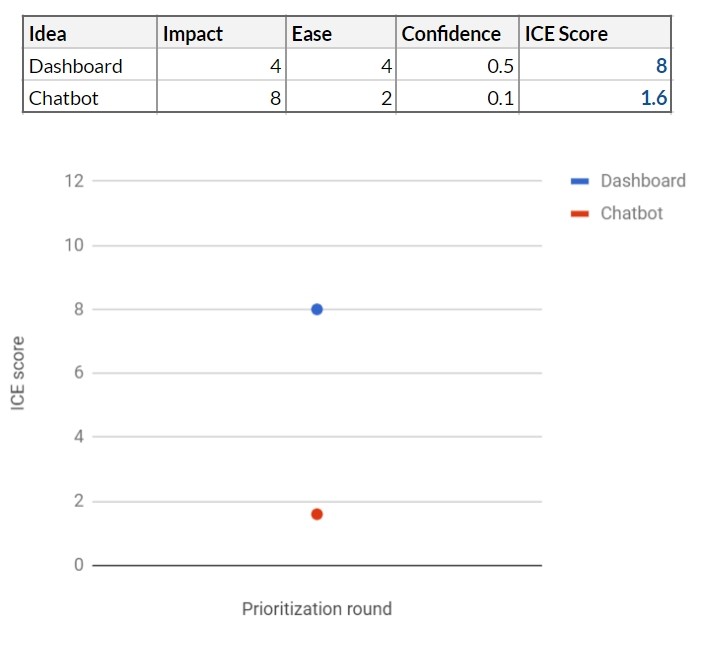

Score ICE dans ce cas:

À ce stade, la barre d'outils semble être la meilleure idée, mais notre outil montre que vous n'êtes pas allé au-delà d'une faible confiance. Il n'y a tout simplement pas assez d'informations pour prendre une décision.

Validation et faisabilité

Ensuite, vous rencontrez vos collègues responsables du développement et de l'expérience utilisateur, et ensemble vous commencez à évaluer les deux idées. Les deux projets semblent réalisables à première vue. Le développeur principal propose une estimation approximative des coûts de main-d'œuvre: travailler avec la barre d'outils prendra 12 semaines-personne pour la publication, et avec un chatbot - 16 semaines-personne. Selon votre échelle Ease, cela facilite la mise en œuvre en 4 et 3 respectivement.

En parallèle, vous effectuez des calculs détaillés. En y regardant de plus près, le tableau de bord semble un peu moins prometteur et obtient 3. Le chatbot regarde toujours 8.

L'utilisation de l'outil de confiance montre que les deux idées réussissent maintenant le test Estimations et plans et gagnent en confiance. Maintenant, la barre d'outils passe à 0,8 et le robot de chat à 0,4.

Chatbot s'est un peu réhabilité. Cependant, le niveau de confiance est faible pour une bonne raison - ce sont principalement des chiffres de nulle part, et vous comprenez que davantage de preuves doivent être recueillies.

Données de marché

Vous envoyez un questionnaire aux clients existants, leur demandant de choisir l'une des 5 nouvelles fonctionnalités possibles, y compris un chatbot et une barre d'outils. Obtenez des centaines de réponses. Les résultats sont très positifs pour le chatbot - il s'agit de la fonction n ° 1 du questionnaire, et 38% des répondants l'ont choisie. Dashboard prend la 3ème place avec 17% des voix.

Cela donne aux deux fonctionnalités un support sur le marché, mais le score du chatbot est 1,5 plus élevé. Pour le panneau de contrôle, la confiance a également augmenté, mais seulement à 1.

De toute évidence, le chatbot a beaucoup avancé. Il semble que vos collègues et les données de l'industrie se soient avérées exactes. Ces données doivent-elles être acceptées à 100%? Probablement pas - le projet coûte assez cher, et nous avons tous cette confiance moyenne. Malheureusement, les résultats de l'enquête ne donnent pas un signal très révélateur. Nous continuons de travailler.

Mot aux clients

Pour en savoir plus, vous exécutez une étude personnalisée sur 10 clients existants, en leur montrant des prototypes interactifs des deux fonctionnalités. En parallèle, vous menez des entretiens téléphoniques avec 20 participants au sondage qui ont choisi l'une des deux fonctionnalités proposées.

L'étude montre une image plus intéressante:

- 8 participants à l'étude sur 10 ont trouvé le tableau de bord utile et ont déclaré qu'ils l'utiliseraient au moins une fois par semaine. Leur compréhension de cette fonction correspondait bien à ce que vous aviez à l'esprit au départ, et ils n'ont eu aucun problème à l'utiliser. Les entretiens téléphoniques ont confirmé la compréhension et le désir d'utiliser la fonctionnalité en moyenne une fois par semaine.

- 9 participants à l'étude sur 10 ont déclaré qu'ils seraient prêts à utiliser le chatbot. Leur niveau d'enthousiasme était très élevé - tout le monde a immédiatement compris pourquoi cela pouvait être utile et beaucoup lui ont demandé dès que possible. Cependant, il y avait des problèmes de facilité d'utilisation, et certains clients se sont dits préoccupés par le fait que leurs clients n'aimeraient pas les réponses répétées et «bidouillées» des robots.

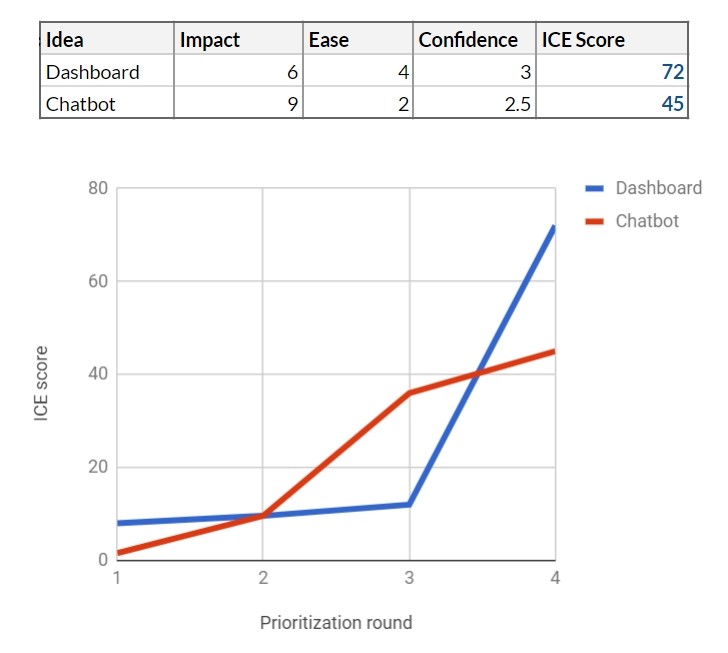

Cette étude de qualité vous donne plus matière à réflexion. La barre d'outils semble plus populaire que prévu. Chatbot ressemble désormais plus à un projet avec un niveau de risque élevé et un prix élevé. Compte tenu de notre outil d'approbation, vous attribuez des barres d'outils et des valeurs d'approbation de chatbot de 3 et 2,5, respectivement.

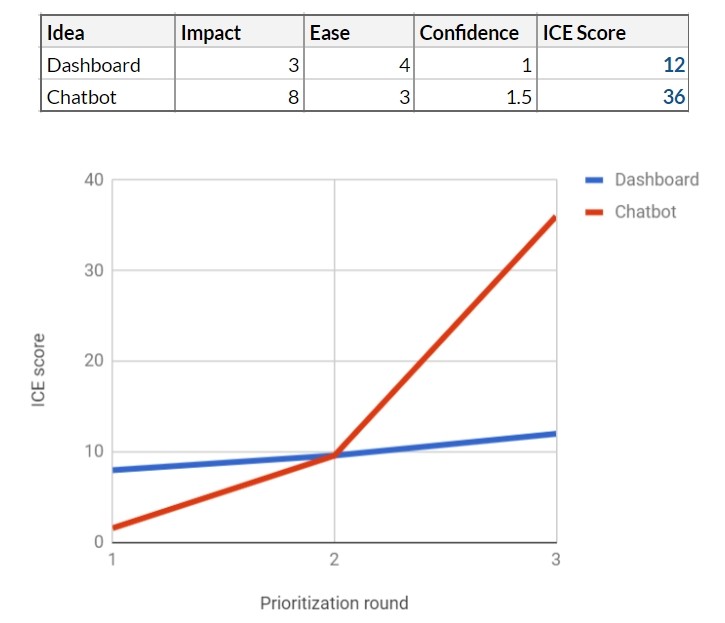

Vous configurez l'effet comme ceci: 6 pour un tableau de bord et 9 pour un chatbot. Enfin, sur la base d'une étude d'utilisabilité, vous vous rendez compte que l'obtention d'une interface utilisateur de qualité pour un chatbot nécessitera plus de travail - vous réduisez la facilité d'utilisation à 2.

Le tableau a de nouveau subi des modifications et la barre d'outils est désormais en tête.

Vous apportez des résultats à votre équipe et à votre leadership. Selon les résultats de l'ICE, la barre d'outils devrait être déclarée gagnante, cependant, d'autre part, les indicateurs de confiance pour les deux fonctionnalités sont loin d'être élevés. Ne voulant pas abandonner une fonctionnalité potentiellement bonne, l'équipe décide de continuer à tester les deux.

Tests finaux et gagnant!

Vous décidez de commencer par créer une version de chatbot pour un produit minimum viable (MVP). Le développement prend 6 semaines et vous exécutez MVP pour 200 répondants qui ont accepté de participer au test. 167 personnes activent la fonctionnalité, mais son utilisation diminue fortement chaque jour, et à la fin de la deuxième semaine, vous n'avez que 24 utilisateurs actifs.

Dans les sondages ultérieurs, une image claire émerge - le chatbot est plus difficile à utiliser, il est beaucoup moins utile que ce que les participants attendaient et, pire encore, il crée un effet négatif pour les clients qui apprécient le contact personnel.

Vous pouvez affiner le chatbot MVP et le rendre beaucoup plus utile pour vos clients, mais cela prend environ 40 à 50 semaines-homme.

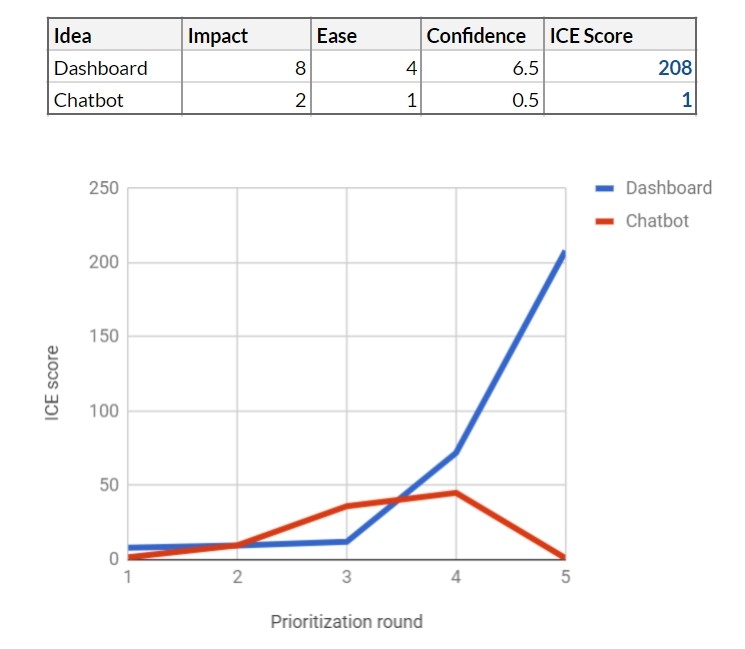

Il est également évident que beaucoup moins de clients que prévu le qualifieraient d’utile. Par conséquent, vous réduisez l'impact de 9 à 2. Cela modifie considérablement la fonctionnalité, de sorte que vous ne pouvez plus faire confiance aux résultats de la recherche des utilisateurs.

Vous lancez des barres d'outils MVP sur 200 autres clients dans les 5 semaines. Les résultats sont très bons: 87% des participants utilisent cette fonctionnalité, beaucoup d'entre eux quotidiennement. La rétroaction est extrêmement positive. Vous comprenez que l'impact est plus élevé que prévu - 8 points au lieu de 6. L'équipe de développement estime qu'il faudra encore 10 semaines-personnes pour lancer la barre d'outils dans son intégralité, de sorte que la facilité de mise en œuvre devient 4. Par conséquent, vous augmentez la note de confiance de 3 à 6,5.

La hiérarchisation devient très simple à ce stade. Maintenant, tout le monde convient que le tableau de bord est la bonne fonctionnalité pour le développement de produits. Vous conservez la fonctionnalité de chatbot dans votre banque d'idées, mais elle restera naturellement «en bas», compte tenu du faible ICE.

Conclusions

1. Arrêtez d'investir dans de mauvaises idéesNotre exemple montre à quel point il est risqué de parier sur des fonctionnalités qui nécessitent beaucoup d'efforts et qui sont basées sur des sentiments, des opinions, des données de l'industrie, les tendances du marché, etc. La plupart des idées s'avèrent en fait beaucoup moins utiles et plus chères qu'on ne le pense avant de les développer. La seule vraie façon de trouver les meilleures idées est de les tester et de réduire le niveau d'incertitude.

2. Inquiétez-vous des avantages, pas des résultats.L'ajout d'une étape de hiérarchisation des fonctionnalités réduit la vitesse de développement des produits - cela semble à première vue. Mais en réalité, cela ne diminue pas, mais augmente la vitesse. Grâce à l'évaluation de la confiance, vous ne faites tout simplement pas de mauvaises fonctionnalités. Il concentre également l'équipe sur des objectifs spécifiques à court terme et augmente la productivité de l'équipe. Ce processus nous permet d'en apprendre davantage sur le produit, les consommateurs, le marché et, finalement, d'obtenir un meilleur produit qui a déjà été testé sur de vrais utilisateurs. Par conséquent, moins de surprises nous attendent le jour du lancement.

3. Encourager une variété d'approchesEn fait, nous devons souvent choisir non pas entre deux idées, mais entre des dizaines. Nous réduisons le coût de développement d'une idée basée sur la confiance en elle. Cela nous permet de tester de nombreuses idées différentes en parallèle et d'éviter les pièges associés à la planification traditionnelle à long terme.

Dans cet exemple, l'équipe teste 4 idées en parallèle, réalisant plusieurs projets (cases jaunes), chacun affinant progressivement l'idée et la testant pour augmenter la confiance.

4. Obtenez l'emplacement de la direction et des parties prenantesHabituellement, lorsque j'explique cette méthode, les gens se préoccupent surtout de savoir comment obtenir le consentement de leur direction et des parties prenantes pour mettre en œuvre un tel processus de priorisation.

Pouvons-nous limiter leur pouvoir sur le produit? Vous serez surpris. J'ai beaucoup entendu les gestionnaires dire qu'ils étaient obligés de s'immerger dans le processus de prise de décisions concernant les produits en raison du manque d'options solides. Une option faible ou forte est, bien sûr, un concept subjectif, mais jusqu'à ce que vous voyiez la situation réelle avec des preuves réelles et un niveau de confiance clair dans l'évaluation de la fonctionnalité.

D'un autre côté, la prochaine fois que le PDG vous obligera à faire votre super idée, montrez-lui comment l'idée est évaluée en utilisant des facteurs d'influence, d'effort et de confiance, comment les indicateurs ICE sur cette idée sont comparés avec les indicateurs d'autres idées, et comment nous pouvons tester lui pour clarifier le facteur de confiance.

Vous pouvez lire sur les lacunes de la méthode ICE, ainsi que sur une méthode alternative de priorisation dans notre dernier article «

RICE et ICE Scoring: Techniques de priorisation simples pour les chefs de produit avancés ».

Cet article vous a-t-il été utile? Souhaitez-vous lire les documents de cet auteur? Veuillez partager ceci dans les commentaires.