Les chercheurs en vision par ordinateur ont découvert le monde caché des signaux visuels à notre disposition, où il y a des mouvements imperceptibles qui donnent ce qui a été dit, et des images floues de ce qui est au coin de la rue

Le spécialiste de la vision par ordinateur

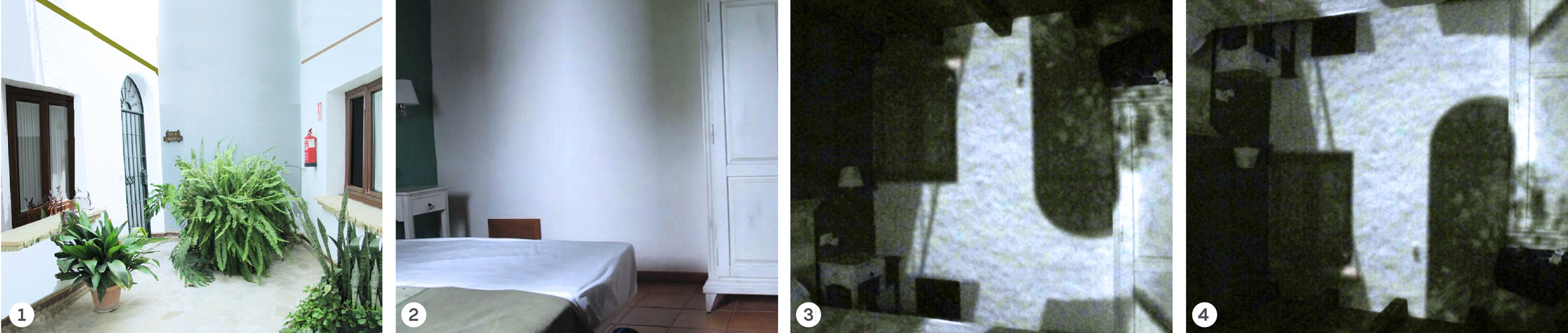

Antonio Torralba , reposant sur la côte espagnole en 2012, a remarqué des ombres aléatoires sur le mur de sa chambre d'hôtel que rien ne semblait projeter. En fin de compte, Torralba a réalisé que les taches décolorées sur le mur n'étaient pas des ombres, mais des images ternes et inversées du patio extérieur. La fenêtre fonctionnait comme un

trou d'épingle - le type d'appareil photo le plus simple dans lequel les rayons lumineux traversent un petit trou et forment une image inversée de l'autre côté. Sur le mur ensoleillé, cette image était à peine perceptible. Mais Torralba s'est rendu compte que notre monde est rempli d'informations visuelles que nos yeux ne perçoivent pas.

"Ces images nous sont cachées", a-t-il dit, "mais elles nous entourent constamment."

L'expérience acquise lui a permis, ainsi qu'à son collègue,

Bill Freeman , également professeur au Massachusetts Institute of Technology, de réaliser que le monde est rempli de "caméras aléatoires", comme ils les appellent: fenêtres, coins, plantes d'intérieur et autres objets ordinaires qui créent des images cachées de leur environnement. Ces images sont 1000 fois moins vives qu'autre chose et ne sont généralement pas visibles à l'œil nu. «Nous avons trouvé des moyens d'isoler ces images et de les rendre visibles», a expliqué Freeman.

Ils ont appris combien d'informations visuelles sont cachées devant tout le monde. Dans le

premier travail, ils ont montré que lors de la prise de vue avec un iPhone ordinaire, des changements de lumière sur le mur de la pièce, à partir de la vidéo reçue, vous pouvez recréer la scène à l'extérieur de la fenêtre. L'automne dernier, ils et leurs collègues ont

signalé que vous pouvez trouver une personne qui se déplace dans un coin en filmant un terrain près du coin sur une caméra. Cet été, ils ont

démontré qu'ils pouvaient enregistrer une plante d'intérieur sur vidéo, puis recréer une image en trois dimensions de la pièce entière à partir des ombres projetées par les feuilles de la plante. Ou ils peuvent transformer les feuilles en un «

microphone visuel », augmentant leurs vibrations et reconnaissant la parole.

1) Le patio à l'extérieur de la chambre d'hôtel où Antonio Torralba a remarqué que la fenêtre fonctionne comme un trou d'épingle. 2) Image floue du patio sur le mur; 3) il peut être affûté en couvrant la majeure partie de la fenêtre avec du carton pour réduire la taille du trou. 4) Si vous la retournez, vous pouvez voir la scène de l'extérieur.

1) Le patio à l'extérieur de la chambre d'hôtel où Antonio Torralba a remarqué que la fenêtre fonctionne comme un trou d'épingle. 2) Image floue du patio sur le mur; 3) il peut être affûté en couvrant la majeure partie de la fenêtre avec du carton pour réduire la taille du trou. 4) Si vous la retournez, vous pouvez voir la scène de l'extérieur.«Notre Marie avait un bélier», explique l'homme sur l'enregistrement audio, recréé à partir des mouvements d'un sac de chips vide que les scientifiques ont filmé à travers une fenêtre insonorisée en 2014 (ce sont les premiers mots enregistrés par Thomas Edison en 1877 sur un phonographe).

La recherche sur la recherche dans les coins et la formulation d'hypothèses sur les objets qui ne sont pas directement visibles ou sur la «construction d'images non en ligne de vue directe» a commencé en 2012 avec les travaux de Torralba et Freeman sur une caméra aléatoire, et avec un autre

travail crucial effectué par un groupe distinct de scientifiques du MIT dirigé par

Ramesh Raskar . En 2016, en particulier, et grâce à ses résultats, l'Agence des projets de recherche avancée du Département américain de la défense (DARPA) a lancé le programme REVEAL de 27 millions de dollars (Revolutionary Enhancement of Visibility by Exploiting Active Light-fields - une amélioration révolutionnaire de la visibilité à l'aide de champs lumineux actifs). Le programme finance des laboratoires émergents à l'échelle nationale. Depuis lors, le flux de nouvelles idées et astuces mathématiques rend l'imagerie hors ligne de visée de plus en plus puissante et pratique.

En plus de l'utilisation évidente à des fins militaires et de reconnaissance, les chercheurs étudient l'application de la technologie dans les robots, la vision robotique, la photographie médicale, l'astronomie, l'exploration spatiale et les missions de sauvetage.

Torralba a déclaré que Freeman et lui au tout début des travaux n'avaient aucune idée de l'application pratique de la technologie. Ils ont juste compris les bases de la formation d'images et ce qu'est une caméra, à partir de laquelle une étude plus complète du comportement de la lumière et de son interaction avec les objets et les surfaces s'est naturellement développée. Ils ont commencé à voir des choses auxquelles personne ne pouvait même penser. La recherche psychologique, selon Torralb, montre que «les gens sont terriblement pauvres pour interpréter les ombres. Peut-être que l'une des raisons en est que bon nombre des choses que nous voyons ne sont pas des ombres. Et à la fin, mes yeux ont jeté des tentatives pour les comprendre. "

Caméras aléatoires

Les rayons de lumière qui transportent l'image du monde en dehors de notre champ de vision tombent constamment sur les murs et autres surfaces, après quoi ils se reflètent et tombent dans nos yeux. Mais pourquoi ces résidus visuels sont-ils si faibles? C'est juste que trop de rayons vont dans trop de directions et que les images deviennent floues.

Pour former une image, il faut limiter sérieusement les rayons incidents à la surface et ne voir qu'un certain ensemble d'entre eux. C'est ce que fait la caméra sténopé. L'idée originale de Torralba et Freeman en 2012 était que dans notre environnement il y a pas mal d'objets et de propriétés diverses qui limitent naturellement les rayons de lumière et forment des images faibles que l'ordinateur peut reconnaître.

Plus l'ouverture du trou d'épingle est petite, plus l'image sera nette, car chaque point de l'objet étudié n'émettra qu'un seul faisceau lumineux à angle droit, qui pourra traverser le trou. La fenêtre de l'hôtel Torralba était trop grande pour que l'image soit nette, et Freeman et lui se sont rendu compte que les caméras à sténopé aléatoire généralement utiles étaient assez rares. Cependant, ils ont réalisé que les anti-trous (caméras «à pointe précise»), constitués de tout petit objet qui bloque la lumière, forment des images en abondance.

Bill Freeman

Bill Freeman Antonio Torralba

Antonio TorralbaImaginez que vous supprimez le mur intérieur d'une pièce à travers un espace dans les stores. Vous ne verrez pas grand-chose. Soudain, une main apparaît dans votre champ de vision. La comparaison de l'intensité lumineuse sur le mur avec et sans une main fournit des informations utiles sur la scène. Un ensemble de faisceaux lumineux incident sur un mur du premier cadre est momentanément bloqué par la main du suivant. En soustrayant les données de la deuxième image des données de la première, comme le dit Freeman, «vous pouvez calculer ce que la main a bloqué» - un ensemble de rayons lumineux représentant l'image d'une partie de la pièce. "Si vous étudiez ce qui bloque la lumière et ce qui laisse passer la lumière", a-t-il dit, "vous pouvez élargir la gamme d'endroits où vous pouvez trouver des caméras sténopé."

Parallèlement à l'étude de caméras aléatoires qui perçoivent de petits changements d'intensité, Freeman et ses collègues ont développé des algorithmes qui déterminent et amplifient de petits changements de couleur - tels qu'un changement de la couleur du visage d'une personne lorsque le sang se précipite ou monte, et de minuscules mouvements - c'est pourquoi vous pouvez enregistrer une conversation en prenant un sac de chips. Maintenant, ils peuvent facilement remarquer le mouvement d'un centième de pixel qui, dans des conditions normales, serait simplement noyé dans le bruit. Leur méthode convertit mathématiquement des images dans une configuration d'onde sinusoïdale. Dans l'espace résultant, le bruit ne domine pas le signal, car les sinusoïdes représentent les valeurs moyennes prises sur de nombreux pixels, donc le bruit est réparti sur eux. Grâce à cela, les chercheurs peuvent déterminer les décalages des sinusoïdes d'une image de la vidéo à une autre, amplifier ces décalages, puis reconvertir les données.

Maintenant, ils ont commencé à combiner toutes ces astuces pour extraire des informations visuelles cachées. Une étude décrite en octobre dernier par

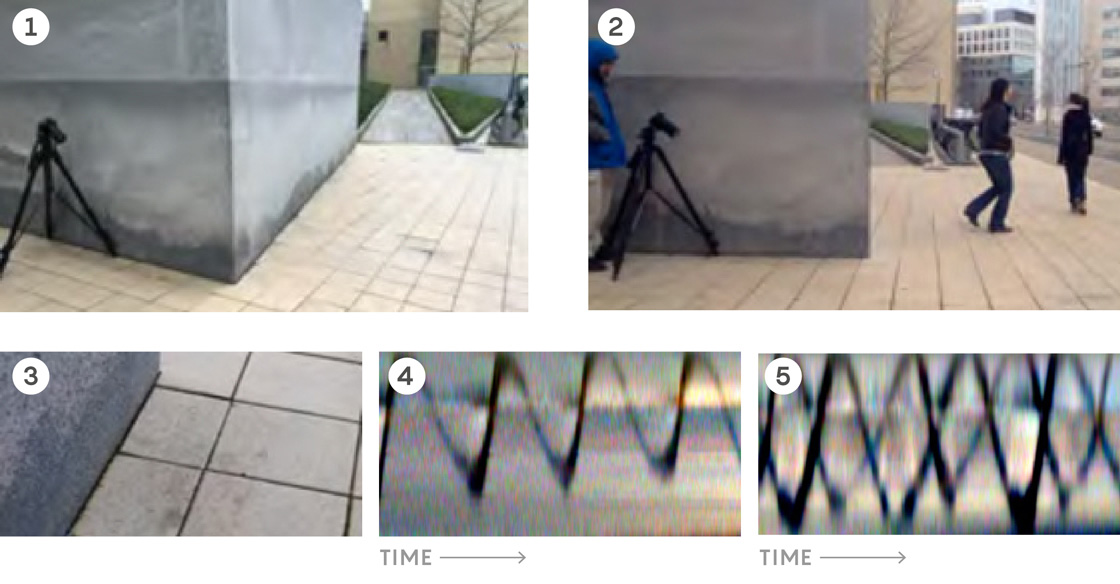

Katie Bowman (alors étudiante dirigée par Freeman et maintenant scientifique du Harvard-Smithsonian Astrophysical Center) a montré que les coins des bâtiments fonctionnent comme des caméras, créant une image approximative de ce qui se trouve au coin de la rue.

En prenant la pénombre au sol près du coin (1), vous pouvez obtenir des informations sur les objets situés autour du coin (2). Lorsque des objets invisibles commencent à se déplacer, la lumière et les ombres qui en découlent se déplacent à différents angles par rapport au mur. Les petits changements d'intensité et de couleur ne peuvent généralement pas être distingués à l'œil nu (3), mais peuvent être améliorés à l'aide d'algorithmes. Des vidéos primitives avec une lumière allant sous différents angles par rapport à la pénombre révèlent la présence d'une personne en mouvement (4) et de deux (5) dans le coin.

En prenant la pénombre au sol près du coin (1), vous pouvez obtenir des informations sur les objets situés autour du coin (2). Lorsque des objets invisibles commencent à se déplacer, la lumière et les ombres qui en découlent se déplacent à différents angles par rapport au mur. Les petits changements d'intensité et de couleur ne peuvent généralement pas être distingués à l'œil nu (3), mais peuvent être améliorés à l'aide d'algorithmes. Des vidéos primitives avec une lumière allant sous différents angles par rapport à la pénombre révèlent la présence d'une personne en mouvement (4) et de deux (5) dans le coin.Les facettes et les coins, comme les trous d'épingle avec des caméras ponctuelles, empêchent le passage de la lumière du soleil. En utilisant des caméras ordinaires, le même iPhone, à la lumière du jour, Bowman et ses collègues ont filmé une ombre partielle au coin du bâtiment - une zone avec des ombres éclairées par un sous-ensemble de rayons lumineux provenant d'une zone cachée au coin de la rue. Si, par exemple, un homme en chemise rouge y passe, cette chemise enverra une petite quantité de lumière rouge dans la pénombre, et cette lumière se déplacera le long de la pénombre pendant que la personne marche, invisible à l'œil ordinaire, mais détectée après le post-traitement.

Dans un ouvrage révolutionnaire publié en juin, Freeman et ses collègues ont recréé le «champ lumineux» de la pièce - une image de l'intensité et de la direction des rayons lumineux dans une pièce - à partir d'ombres projetées par une plante à feuilles caduques à côté du mur. Les feuilles fonctionnaient comme des caméras ponctuelles, chacune bloquant son propre ensemble de rayons lumineux. La comparaison de l'ombre de chaque feuille avec le reste des ombres a produit cet ensemble de rayons manquant et a permis d'obtenir une image d'une partie de la scène cachée. Compte tenu de la parallaxe, les chercheurs ont ensuite pu rassembler toutes ces images.

Cette approche donne des images beaucoup plus nettes que les travaux antérieurs avec des caméras aléatoires, car l'algorithme a une connaissance pré-acquise du monde. Connaissant la forme de la plante, en supposant que les images naturelles devraient être lisses et en tenant compte de plusieurs autres hypothèses, les chercheurs ont pu tirer certaines conclusions concernant les signaux contenant du bruit, ce qui a contribué à rendre l'image finale plus nette. La technologie de travail avec un champ lumineux "nécessite une connaissance du monde environnant pour créer une reconstruction, mais elle vous donne également beaucoup d'informations", a déclaré Torralba.

Lumière dispersée

En attendant, Freeman, Torralba et leur protégé révèlent des images cachées ailleurs sur le campus du MIT, Ramesh Raskar, un spécialiste de la vision par ordinateur qui a pris la parole à TED, a l'intention de «changer le monde» et de choisir une approche appelée «imagerie active». Il utilise des systèmes de caméras laser spécialisés et coûteux pour créer des images haute résolution qui affichent ce qui est au coin de la rue.

Ramesh Raskar

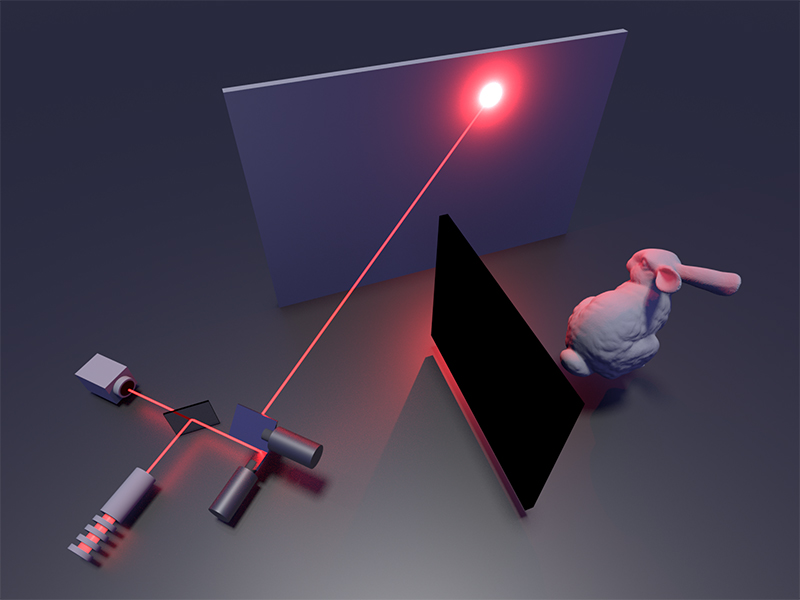

Ramesh RaskarEn 2012, dans le cadre de la mise en œuvre d'une idée qui lui a rendu visite il y a cinq ans, Raskar et son équipe ont d'abord créé une technologie dans laquelle il est nécessaire de libérer des impulsions laser dans le mur. Une petite partie de la lumière diffusée pourra contourner l'obstacle. Et peu de temps après chaque impulsion, ils utilisent une «caméra flash» qui enregistre des photons individuels à un taux de milliards d'images par seconde pour détecter les photons qui rebondissent sur le mur. En mesurant le temps passé par les photons au retour, les chercheurs peuvent découvrir à quelle distance ils se sont envolés et recréer en détail la géométrie tridimensionnelle des objets cachés derrière l'obstacle, sur lesquels les photons se sont dispersés. L'une des difficultés est que pour la formation d'une image tridimensionnelle, il est nécessaire d'effectuer un balayage tramé du mur avec un laser. Disons qu'une personne se cache au coin de la rue. "Ensuite, la lumière réfléchie à partir d'un certain point sur la tête, d'un certain point sur l'épaule et d'un certain point sur le genou peut arriver en même temps à la caméra", a déclaré Raskar. Mais si vous braquez un peu le laser vers un autre endroit, la lumière de ces trois points n'arrivera plus en même temps à la caméra. » Il est nécessaire de combiner tous les signaux et de résoudre le "problème inverse" pour recréer la géométrie tridimensionnelle cachée.

L'algorithme Raskar original pour résoudre le problème inverse nécessitait trop de ressources informatiques, et l'appareil lui-même a coûté un demi-million de dollars. Mais un travail sérieux a été fait pour simplifier les mathématiques et réduire les coûts. En mars, la revue Nature a publié un

ouvrage qui établit une nouvelle norme pour la construction efficace et économique d'images en trois dimensions d'un objet - la figure d'un lapin au coin de la rue a été recréée dans l'ouvrage. Les auteurs

Matthew O'Toole ,

David Lindel et

Gordon Wetstein de l'Université de Stanford ont développé un nouvel algorithme puissant pour résoudre le problème inverse et utilisé des

caméras SPAD relativement peu coûteuses - des dispositifs semi-conducteurs dont la fréquence d'images est inférieure à celle des caméras flash. Raskar, qui travaillait auparavant comme commissaire de deux auteurs de l'œuvre, l'a qualifié de "très ingénieux" et "l'un de mes préférés".

Les algorithmes précédents s'enfonçaient dans le détail: les chercheurs essayaient généralement de détecter les photons de retour qui n'étaient pas réfléchis par le point sur le mur où le laser brillait, afin que la caméra puisse éviter de collecter la lumière laser diffusée. Mais en dirigeant le laser et la caméra presque au même point, les chercheurs ont pu cartographier les photons sortants et entrants à partir d'un «

cône lumineux ». Se dispersant depuis la surface, la lumière forme une sphère de photons en expansion, qui forme un cône, se propageant dans l'espace-temps. O'Toole (qui a depuis changé d'emploi de Stanford à l'Université Carnegie Mellon) a traduit la physique des cônes de lumière - développée par le professeur d'Albert Einstein, German Minkowski au début du 20e siècle - en une expression laconique reliant le temps de vol du photon à l'emplacement des surfaces de diffusion. Il a appelé sa traduction «transformation du cône de lumière».

Les robots utilisent déjà des systèmes LIDAR pour créer des images directes, et on peut imaginer qu’un jour, SPAD pourra regarder au coin de la rue. «Dans un avenir proche, ces capteurs seront également disponibles en format portable», prédit

Andreas Welten , le premier auteur des premiers travaux de Raskar à partir de 2012, qui dirige désormais le groupe engagé dans la construction d'images actives à l'Université du Wisconsin. Le défi consiste maintenant à «gérer des scènes plus complexes» et des scénarios réalistes, a déclaré Welten, «et pas seulement à créer soigneusement une scène avec un objet blanc et un fond noir. Nous avons besoin de technologie pour diriger l'appareil et appuyer sur le bouton. »

Où sont les choses

Les chercheurs du groupe Freeman ont commencé à combiner des approches passives et actives. Les travaux, menés sous la direction du chercheur Christos Trumpulidis, ont montré que lors de la construction active d'images à l'aide d'un laser, une caméra en forme de point de forme connue située autour d'un angle peut être utilisée pour recréer une scène cachée sans utiliser d'informations sur le temps de vol des photons. "Et cela devrait fonctionner pour nous à l'aide d'une

matrice CCD conventionnelle", a déclaré Trampulidis.

L'imagerie hors de vue aidera un jour les équipes de sauvetage et les robots autonomes. Welten collabore avec le Jet Propulsion Laboratory de la NASA, travaillant sur un projet visant à construire des images à distance d'objets à l'intérieur des grottes de la lune. Mais Raskar et l'entreprise utilisent leur approche pour lire les premières pages d'un livre fermé et pour voir dans le brouillard.

En plus des reconstructions audio, l'algorithme d'amélioration du mouvement de Freeman peut aider à créer des dispositifs médicaux et des systèmes de sécurité, ainsi que de petits détecteurs de mouvement astronomiques. Cet algorithme est «une très bonne idée», a déclaré David Hogg, astronome et scientifique des données à l'Université de New York et au Flatiron Institute. "Je pensais - nous devons juste l'utiliser en astronomie."

En ce qui concerne les problèmes de confidentialité soulevés par les récentes découvertes, Freeman se tourne vers son expérience. "J'ai beaucoup réfléchi à ce problème tout au long de ma carrière", dit-il. Un homme à lunettes, un passionné de photographie qui a été impliqué dans la photographie toute sa vie, Freeman a déclaré qu'au début de sa carrière, il ne voulait pas travailler sur quoi que ce soit qui aurait un certain potentiel militaire ou d'espionnage. Mais au fil du temps, il a commencé à penser que «la technologie est un outil qui peut être utilisé de différentes manières. Si vous essayez d'éviter tout ce qui peut avoir au moins une certaine utilité militaire, vous ne pouvez penser à rien d'utile. " Il dit que même dans le cas des militaires, «il existe un très large éventail de possibilités d'utilisation des choses. Vous pouvez aider quelqu'un à survivre. Et, en principe, savoir où sont les choses est utile. »

Mais il était très heureux non pas des capacités technologiques, mais simplement de la découverte d'un phénomène caché à la vue. "Il me semble que le monde est plein de tout ce qui reste à découvrir", a-t-il déclaré.