J'ai décidé d'écrire cet article dans le sillage de ce post .

Permettez-moi de vous rappeler un petit point: dans la revue Nature, les résultats d'une étude réalisée à l'aide de

ce test ont été publiés.

Sur quoi je veux écrire?

Premièrement, pourquoi cette recherche est absolument inutile pour résoudre le problème posé et sous la forme sous laquelle elle a été menée.

Deuxièmement, comment hiérarchiser une telle étude.

Et troisièmement, essayez de simuler divers scénarios d'accident dans les conditions spécifiées par le test.

Dans cet article, l'auteur n'a pas inséré en vain un lien vers le test depuis le tout début. Cela aiderait à éviter les commentaires insignifiants de ceux qui n'ont pas compris le message initial de l'étude.

Veuillez faire un test au moins deux fois pour comprendre le sujet de la discussion.

Ce qu'ils ont promis de nous montrer dans l'étude

La discussion du premier post, épique pour Habr, a montré que la majorité des gens ne savent pas penser dans les conditions données, mais commencent à fantasmer: "certaines personnes meurent-elles dans le test?" Après tout, vous pouvez contourner les deux piétons et le bloc / latéralement pour frotter / freiner le frein à main / l'équipement? Mais je voudrais ... ". Comprenez que c'est un exemple simplifié pour développer des algorithmes d'action et des politiques pour réguler le comportement du pilote automatique sur la route! Du point de vue de l'élaboration de règles de sécurité, de tels extrêmes et simplifications sont justifiés. Il s'agit des conséquences potentielles auxquelles les gens devraient être préparés. Les soldats ne se rendent pas dans les champs de mines non pas parce que chaque centimètre carré y est extrait, mais à cause de la probabilité même de mourir. Il n'est généralement pas très élevé, mais personne ne le risque. Par conséquent, dans le test, le choix entre la mort à 100% de tous les passagers ou de tous les piétons est adéquat - c'est ainsi que nous désignons le risque, en gardant à l'esprit que risquer des vies dans notre société est inacceptable.

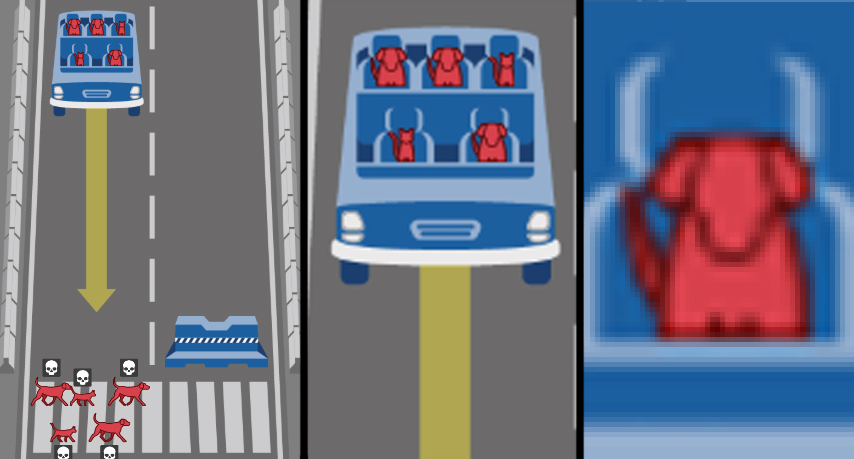

Le message de l'étude est le suivant: vous, les gens qui vivent maintenant, devez vivre dans un monde d'avenir, rempli de voitures sur pilote automatique. Et c'est important pour nous, développeurs d'automobiles, d'intelligence artificielle et d'autres choses, de savoir, mais comment pensez-vous que les robots robots devraient se comporter? Eh bien, vous y êtes, oui, oui, c'est vous - dites-moi quoi faire à un robot si la tête et le chat y montent, et il est sur le point d'écraser les sans-abri et le chien? Quelle éthique les robots doivent-ils avoir s'ils doivent choisir?

Et après avoir identifié le motif initial de l'étude, je souhaite en discuter plusieurs aspects.

Ce que l'étude a réellement montré

La première chose qui attire clairement votre attention est que la conception de la recherche ne vise pas du tout l'objectif déclaré. Les tâches définies sous forme de dilemmes ne sont pas adaptées à la création d'une «éthique» du comportement robot-voiture. Mais pas tous. Voici les dilemmes qui répondent à la tâche de «développer des règles pour le comportement d'un robot-voiture afin de réduire la gravité des conséquences d'un accident»:

- «Passager / piéton» - choisissez qui épargner;

- "Violation des règles de circulation" - choisissez de sacrifier ou non les piétons inconscients;

- «Nombre de victimes potentielles» - choisissez si le nombre de victimes est prioritaire.

Et puis viennent les paramètres qui s'avèrent très importants pour la détermination de la peine dans notre société civilisée. On a demandé honnêtement et innocemment aux gens: votre niveau de sexisme, de lukisme, d'âgisme? Êtes-vous pour la discrimination des graisses ou des non classés? Et après tout, des centaines de milliers de personnes ont honnêtement répondu ...

Bravo!

En plein dans les meilleures traditions des films et séries divertissantes, quand le monde des personnages principaux est en fait un grand bac à sable derrière une haute clôture, et c'est leur comportement qui est une expérience! Sous la sauce de recherches super importantes dans le domaine de la robotique et de l'IA, les sociologues, psychologues, culturologues ont reçu un échantillon si puissant sur le problème du chariot que personne n'avait jamais rêvé auparavant! Eh bien, sauf que la couleur de la peau n'a pas été ajoutée à l'enquête, mais alors les connotations racistes de l'étude seraient cousues de blanc ... oh.

Sérieusement, cette partie phénotypique du genre de l'étude est coupée par des arguments catégoriques. Le premier argument est l'humanisme, en tant que personnes civilisées, nous devons mettre la primauté de la valeur de la vie humaine sur toutes les différences individuelles. Autrement dit, la formulation même de la question est scandaleuse, car discriminatoire. Deuxième argument - de nombreux accidents se produisent et, à la limite, la répartition des victimes par apparence, éducation, sexe, âge aura tendance à prendre leurs proportions dans la société, il est donc au moins étrange de réglementer cela en plus. Le troisième argument - il ne semble pas opportun de créer une intelligence artificielle qui distingue un costume de Brioni d'un pull de Bershka pour comparer davantage si une personne a un statut et s'il vaut la peine de l'écraser. De plus, je ne ferais pas confiance à l'IA pour juger - un piéton sans-abri ou un scientifique? (bonjour aux coiffures des scientifiques respectés Perelman ou Gelfand :))

En plus de ces paramètres inutiles, nous rejetons facilement les deux autres: la spécificité des espèces et la non-interférence. Oui, nous allons écraser les petits animaux pour sauver des gens qui auraient pensé. Et quant au paramètre «intervention / non-interférence» par manoeuvre, cette partie essentielle du problème du chariot n'est pas seulement un frein à la voiture, car la machine n'agit pas selon l'éthique, mais selon les algorithmes qui y sont définis. Et puisque nous avons défini la tâche «comment la voiture devrait-elle agir en cas d'accident avec une collision avec des personnes», alors dans le libellé, nous supposons qu'elle doit agir d'une manière ou d'une autre. De nos jours, le transport ferroviaire réussit à faire face à une collision directe sans aucune conséquence, et nous développons une politique de minimisation des victimes d'accidents de la route.

Cela signifie que nous avons séparé les grains rationnels de la recherche de l'expérience sociopsychologique pour étudier le niveau d'intolérance dans la société mondiale. Nous travaillons plus avant avec les trois premiers dilemmes mentionnés. Et il y a quelque chose à démonter. Après un examen plus approfondi, ils se révèlent incomplets ...

Trois dilemmes des voitures robots

Les piétons violent-ils les règles de circulation? Ici, la majorité exprime explicitement le darwinisme social ou une réponse regrettable tacitement désolée - ils doivent plutôt sacrifier ceux qui violent les règles en faveur des innocents. Les personnes conscientes ne vont pas sur les rails, sachant que le train ne s'arrêtera pas - faites-leur savoir que le robot ne s'arrêtera pas non plus. Tout est logique, bien que cynique. Mais dans ce dilemme rusé, le caractère unilatéral, l'incomplétude est caché. Les piétons qui enfreignent les règles de circulation ne sont qu'une des nombreuses situations. Mais si la voiture robotique se casse ?? Cette situation n’a pas été prise en compte, mais elle (en théorie, les caméras de la voiture ont raté un panneau ou un feu de signalisation) est, en théorie, beaucoup plus probable qu’une soudaine défaillance des freins. Cependant, j'ai encore frappé dans la fantaisie et en particulier. Il est plus important de simplement montrer dans le test la réciprocité équivalente de la situation. Autrement dit, imaginez ceci: si les piétons enfreignent les règles de la circulation, ils meurent, ce qui est «logique» et «correct», et si le robot motorisé viole, devrait-il se suicider pour cette erreur? N'oubliez pas qu'en même temps, le chef, le clochard et le chat assis à l'intérieur meurent! Il s'agit d'une correction importante, mais dans le test, cet aspect ne l'est pas.

Ensuite. Le nombre de victimes potentielles. Ici aussi, ce n'est pas si simple. Jeter les stéréotypes de genre et le respect de la vieillesse, le mépris pour les gros et les sans-abri. Nous supposons que dans un accident, ils meurent proportionnellement à la fréquence à laquelle ils se trouvent dans la nature. Et nous déciderons: trois mourront mieux que cinq. Cela vous semble-t-il logique? Oh bien. Évitons toute cette absurdité infernale , mais nous avons une simulation abstraite. Quel est le meilleur - pour tuer 50 ou 51 personnes? 1051 ou 1052? Ce n'est donc pas si important? Alors quoi de mieux - tuer 1 piéton ou 50 personnes dans un bus? Et maintenant, c'est devenu important? Et où va cette ligne? Chaque personne supplémentaire a-t-elle de la valeur? Mais est-ce important si des milliers de personnes meurent dans des accidents de la route à long terme? Comme dans le cas de l'apparence, en réalité, une estimation adéquate utilisant l'IA du nombre de victimes potentielles sera extrêmement difficile. La seule chose sensée est de faire une condition de non-intervention (non-manoeuvre) si le nombre de victimes est le même.

Le troisième aspect a suscité beaucoup de controverse dans les commentaires sur ce premier article sur Habré. Et à en juger par les résultats de l'étude, elle est complètement ambiguë pour la société, et c'est là que réside le principal problème qui doit être résolu. Il s'agit de savoir qui risquer - piétons ou passagers?

Certains disent que les piétons ne sont à blâmer pour rien, ce qui signifie qu'ils doivent être sauvés en premier lieu. De manière générale, il est désormais à la mode chez les urbanistes de prendre soin des piétons, de rendre des rues entières piétonnes, de créer des passages à niveau avec un feu tricolore tous les 50 mètres, de réduire la vitesse de circulation au centre, de donner la priorité aux piétons. Ici aussi, il est nécessaire de les sécuriser d'une manière ou d'une autre, et une machine robotique volant sans freins sur la foule devrait s'autodétruire au nom du sauvetage des participants les plus vulnérables du mouvement. Ce qui, de mon point de vue, ils ont raison, c'est que les piétons ne souscrivaient pas aux conditions de comportement de la voiture robot de quelqu'un d'autre. Ils pourraient être généralement contre leur introduction. En même temps, il est impossible d'imaginer le passager d'une telle machine qui n'est pas d'accord avec les conditions de son utilisation. Par conséquent, la situation est un conflit d'intérêts. C’est plus pratique pour moi de vous tuer et je vais vous tuer, comme une personne le dit à une autre.

Les seconds disent que toute personne qui achète et monte généralement dans une voiture robotisée devrait avoir la garantie qu'elle le sauvera en cas d'accident, et ne tuera pas un médecin, un enfant ou deux chats afin de sauver la route de passage. D'une part, cela semble logique et justifié, d'autre part - le passager dans ce cas met délibérément sa vie au-dessus des autres. Lors de l'achat d'une voiture avec un pilote automatique, chacun de ses propriétaires met à sa disposition l' arme parfaite, une balle d'argent, une fusée non guidée, une machine qui tuera complètement légalement toute autre personne sur son passage.

Les deux côtés avec de la mousse à la bouche tirent sur la "première loi de la robotique", tirée de la science-fiction. Cela a l'air démagogiquement beau, mais personne n'essaie même de le comprendre ou de le remettre en question par rapport au problème. Mais elle n'est pas applicable à cette formulation du problème, car il y a substitution de concepts: l'heuristique / IA de la machine ne choisit pas entre les valeurs de la vie humaine, mais agit strictement selon les algo-rythmes créés à partir de priorités subjectives inventées par l'homme. Et ici, peu importe quel type de construction sociale est pris comme priorité lors du choix de «tuer / épargner»: la masse corporelle que nous avons rejetée plus tôt, l'âge et le statut, ou l'égoïsme darwiniste social du propriétaire de la voiture.

La deuxième approche, qui est une attaque unilatérale contre la vie des piétons, transforme la recherche d'un problème de chariot en dilemme classique d'un prisonnier . Si les parties parviennent à un compromis, un développement général est possible (introduction de robomobiles) avec une détérioration minimale pour certains (minimisation du nombre de décès inévitables dus aux robomobiles) - ce qui est le souhait de l'optimum de Pareto. Cependant, il y a toujours un égoïste qui ne compte que sur ses intérêts. "Il aura 20 ans, mais je serai libéré." "Il mourra en traversant la route, bien que les freins aient refusé ma voiture." Peut-être que cette approche est justifiée lorsque les événements sont uniques dans la vie et qu'il y a deux participants au jeu. Lorsqu'il y a des dizaines ou des centaines de milliers de participants et que les déplacements sont quotidiens, un tel jeu à but unique se transformera en discrimination à l'égard des piétons.

Personnellement, je pense que dans le cadre du problème formulé, le dilemme passager / piéton conduit à une impasse. Une machine qui tue potentiellement ceux qui s'y sont lancés est absurde du point de vue du bon sens et ne trouvera naturellement pas d'acheteurs sur le marché. Une voiture qui tue délibérément des piétons est impossible dans une société civilisée en tant qu'élément de discrimination positive et menace pour la vie des gens.

Nous allons plus loin. L'article ne traite pas vraiment et ne signifie pas une politique visant à minimiser les conséquences tragiques des accidents impliquant des robots. Les totaux sont divisés en «régions», dont les priorités diffèrent considérablement et sont formées de manière assez ambiguë (il existe des explications sur les «caractéristiques religieuses et l'influence coloniale», mais ... en général, salutations à l'Irak avec l'Afghanistan dans «l'Ouest» et à la France avec la République tchèque dans « Sud »). Et donc la question tourne dans la langue: allez-vous fabriquer des robots avec une "éthique" différente pour chaque pays?

Les auteurs de l'article dans la discussion désignent les trois «blocs fondamentaux de base» identifiés par eux: sauver les gens (pas les animaux), sauver plus de vies, sauver les plus jeunes. Mais les diagrammes montrent clairement que les gens du secteur de l'Est ont un peu moins de population et de jeunes que peu s'en soucient. Il s'avère que les politiques prioritaires sélectionnées iront à l'encontre de l'opinion de la grande majorité? Pourquoi, alors, les gens ont-ils été interrogés?

Peut-être juste compter?

Mais passons à la partie divertissante de ce post.

Au lieu de demander à des personnes ayant des implications socioculturelles différentes des conseils sur la robotique, et probablement 99% d'entre elles avec une éducation non fondamentale, nous nous tournons vers un outil impartial. Prenons les dilemmes sélectionnés au début de l'article. Dans les conditions du test, nous créerons la simulation informatique la plus simple. Et nous évaluerons le nombre d'usagers de la route morts.

Et rappelez-vous: notre tâche en tant que politiciens dans le domaine de la sécurité des transports est de réduire le nombre total de victimes. Nous travaillerons dans le cadre et les conventions du test Moral Machine original, qui se concentre sur le risque pour la vie des participants à un accident de la route, plutôt que sur des évaluations réalistes complexes de la collision d'une voiture avec un obstacle ou des personnes. Nous n'avons pas EuroNCAP, nous aurons Python.

Tout d'abord, nous allons écrire un code qui réponde au dilemme de "sauver ceux qui meurent plus". Dans le cadre du test de la machine morale, nous faisons au hasard de 1 à 5 passagers et piétons, définissons la condition si piétons> passagers, tuez immédiatement la voiture sur un bloc de béton. Nous transportons, par exemple, 10 000 de ces accidents.

Je n'écoute pas le code de revendication, j'ai écrit quelque chose en Python pour la première fois de ma vienpedtotal = 0

npasstotal = 0

ndeadped = 0

ndeadpass = 0

# 0 0

n=0

while n < 10000:

#10000

nped = random.randint(1, 5)

npass = random.randint(1, 5)

# 1 5

npedtotal += nped

npasstotal += npass

#

if nped > npass:

ndeadpass += npass

else:

ndeadped += nped

# ,

# .

# .

n += 1

print (" ", npedtotal)

print (" ", npasstotal)

print (" ", ndeadped, "(",100*ndeadped/npedtotal, "%",")")

print (" ", ndeadpass, "(",100*ndeadpass/npasstotal,"%"")")

print (" ", ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

…

29960

29924

13903 ( 46.4052069426 % )

8030 ( 26.8346477744 %) 21933 ( 36.6258098991 % )

, ! , !

. . , . – , « » 4 5, == . , 20 20 , , , 5 – , 5 – . : , , . > >= :

29981

29865

7859 ( 26.2132684033 % )

14069 ( 47.1086556169 %)

21928 ( 36.6407111586 % )

, occupants, - , . , . 30000 , 100% — .

, , . – , , 50% , 30000.

– . , , , ! , : , , , , , . , : .

, -```python

import random

npedtotal = 0

npasstotal = 0

ndeadped = 0

ndeadpass = 0

# 0 0

n=0

while n < 10000:

#10000

nped = random.randint(1, 5)

npass = random.randint(1, 5)

trafficlight = random.randint(0, 1)

# 1 5

#

npedtotal += nped

npasstotal += npass

#

if trafficlight == 0:

ndeadped += nped

else:

if nped > npass:

ndeadpass += npass

else:

ndeadped += nped

# ,

# .

# .

n += 1

print (« », npedtotal)

print (« », npasstotal)

print (« », ndeadped, "(",100*ndeadped/npedtotal, "%",")")

print (« », ndeadpass, "(",100*ndeadpass/npasstotal,"%"")")

print (« », ndeadped + ndeadpass, "(",100*(ndeadped + ndeadpass)/(npasstotal+npedtotal), "%", ")")

```

">"

29978

29899

21869 ( 72.9501634532 % )

4042 ( 13.5188467842 %)

25911 ( 43.2737111078 % )

">="

30152

30138

19297 ( 63.9990713717 % )

6780 ( 22.4965160263 %)

26077 ( 43.2526123735 % )

, , . ( ).

, . – .

. , , . Moral Machine, , , . - , .

, , , . – , , . . – , , , . , – .

, - , . , , , . – , , .

. . , . .