Malgré la fiabilité des datacenters modernes, un autre niveau critique de redondance est requis pour les installations critiques, car l'ensemble de l'infrastructure informatique peut échouer en raison d'une catastrophe d'origine humaine ou naturelle. Pour garantir la tolérance aux catastrophes, il est nécessaire de créer des centres de données de sauvegarde. Sous la coupe, notre histoire sur les problèmes résultant de leur combinaison (DCI - Data Center Interconnection).

Les volumes de données traitées par l'humanité ont atteint des valeurs incroyables, et le rôle de l'infrastructure informatique dans les processus métier est si important que même les pannes à court terme peuvent paralyser complètement l'entreprise. Les technologies numériques sont introduites partout, et le secteur financier, les télécommunications ou, par exemple, la grande distribution Internet, en dépendent particulièrement. La fiabilité des centres de données n'est pas suffisante pour un grand fournisseur de cloud, une banque ou un grand opérateur de télécommunications: les pertes résultant d'un petit temps d'arrêt peuvent être calculées en quantités astronomiques et, pour les éviter, une infrastructure résistante aux catastrophes est nécessaire. Vous ne pouvez le créer qu'en augmentant la redondance - vous devez créer des centres de données de sauvegarde.

Séparation de la haute disponibilité et de la reprise après sinistre

Les centres de données d'entreprise ou les équipements installés dans des locaux loués peuvent être combinés. La tolérance aux pannes des solutions géo-distribuées est obtenue grâce à l'architecture logicielle, et les propriétaires peuvent économiser sur leurs propres installations: ils n'ont pas besoin de construire un centre de données, par exemple, un niveau Tier III ou même Tier II. Vous pouvez abandonner les générateurs diesel, utiliser des serveurs à châssis ouvert, jouer avec des conditions de température extrêmes et faire d'autres astuces intéressantes. Il y a moins de degrés de liberté sur les surfaces louées, ici le prestataire détermine les règles du jeu, mais les principes d'unification sont les mêmes. Avant de parler de services informatiques résistants aux catastrophes, il convient de rappeler trois abréviations magiques: RTO, RPO et RCO. Ces indicateurs de performance clés déterminent la capacité de l'infrastructure informatique à résister aux perturbations.

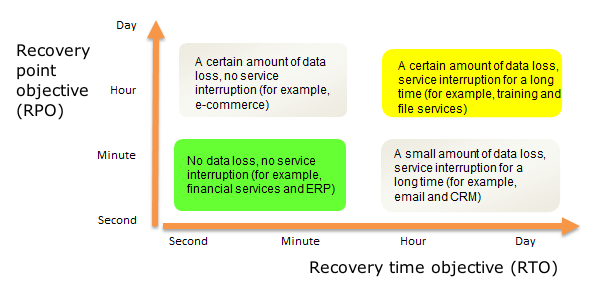

RTO (Recovery time objective) - temps alloué pour récupérer un système informatique après un incident;

RPO (Recovery point objective) - perte de données acceptable pendant la reprise après sinistre. Elle est généralement mesurée comme la période maximale pendant laquelle les données peuvent être perdues;

Le RCO (objectif de capacité de récupération) fait partie de la charge informatique que le système de sauvegarde peut prendre en charge. Ce dernier indicateur peut être mesuré en pourcentages, transactions et autres «perroquets».

Il est important de faire la distinction entre les solutions de haute disponibilité (HA) et de reprise après sinistre (DR). La différence entre eux peut être visualisée sous la forme d'un diagramme avec RPO et RTO comme axes de coordonnées:

Idéalement, nous ne perdons pas de données et ne perdons pas de temps à récupérer après une panne, et le site de sauvegarde assurera la pleine fonctionnalité des services, même si le principal est détruit. Le zéro RTO et RPO ne peut être atteint qu'avec le fonctionnement synchrone des centres de données: en fait, il s'agit d'un cluster tolérant aux pannes géographiquement distribué avec réplication de données en temps réel et autres joies. En mode asynchrone, l'intégrité des données n'est plus garantie: la réplication étant effectuée à intervalles réguliers, certaines informations peuvent être perdues. Le temps de basculer vers le site de sauvegarde dans ce cas est de plusieurs minutes à plusieurs heures, en ce qui concerne le soi-disant réserve de froid, lorsque la plupart des équipements de secours sont éteints et ne consomment pas d'électricité.

Détails techniques

Les difficultés techniques qui surviennent lors de la combinaison de deux ou plusieurs centres de données sont divisées en trois catégories: retards de transmission des données, bande passante insuffisante des canaux de communication et problèmes de sécurité de l'information. La communication entre les centres de données est généralement assurée par leurs propres lignes de communication à fibres optiques ou louées, nous en parlerons donc plus tard. Pour les DPC fonctionnant en mode synchrone, le principal problème est les retards. Pour garantir la réplication des données en temps réel, elles ne doivent pas dépasser 20 millisecondes, et parfois 10 millisecondes - cela dépend du type d'application ou de service.

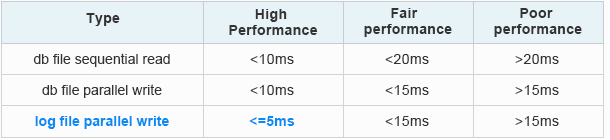

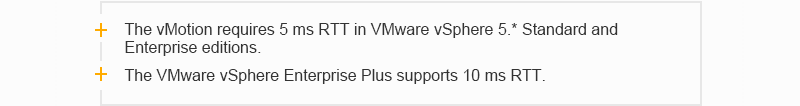

Sinon, par exemple, la famille de protocoles Fibre Channel ne fonctionnera pas, ce qui est presque impossible à faire sans les systèmes de stockage modernes. Là, plus la vitesse est élevée, moins le délai devrait être long. Il existe bien sûr des protocoles qui vous permettent de travailler avec des réseaux de stockage via Ethernet, mais ici, cela dépend beaucoup des applications et des équipements installés utilisés dans le centre de données. Voici des exemples d'exigences de latence pour les applications Oracle et VMware courantes:

Configuration requise pour le délai de cluster étendu d'Oracle

À partir des données officielles d'Oracle: comment savoir si les E / S de la base de données sont lentes [ID 1275596.1]

À partir des données officielles d'Oracle: comment savoir si les E / S de la base de données sont lentes [ID 1275596.1]Exigences de délai VMware:

Étude de cas de cluster de stockage VMware vSphere Metro (VMware vSphere 5.0)

Étude de cas de cluster de stockage VMware vSphere Metro (VMware vSphere 5.0)

Lors de la transmission de données, le retard du signal peut être représenté sous la forme de deux composantes: T

total = T

equip. + T

s où T

equ. - le retard provoqué par le passage du signal à travers l'équipement, et T

s - le retard provoqué par le passage du signal à travers la fibre optique. Le retard causé par le passage du signal à travers l'équipement (équipement T) dépend de l'architecture de l'équipement et de la méthode d'encapsulation des données lors de la conversion optoélectrique du signal. Dans les équipements DWDM, cette fonctionnalité est affectée aux modules transpondeur ou muxpondeur. Par conséquent, lors de l'organisation de la communication entre deux centres de données, ils sont particulièrement prudents dans le choix du type de transpondeur (muxpondeur) afin que le retard sur le transpondeur (muxpondeur) soit le plus petit.

En mode synchrone, la vitesse de propagation du signal dans la fibre optique (T

s ) joue un rôle important. Il est connu que la vitesse de propagation de la lumière dans une fibre optique standard (par exemple, G.652) dépend de l'indice de réfraction de son noyau et est approximativement égale à 70% de la vitesse de la lumière dans le vide (~ 300 000 km / s). Nous n'entrerons pas en profondeur dans les fondamentaux physiques, mais il est facile de calculer que le retard dans ce cas est d'environ 5 microsecondes par kilomètre. Par conséquent, deux centres de données peuvent fonctionner de manière synchrone à une distance d'environ 100 kilomètres seulement.

En mode asynchrone, les exigences de retard ne sont pas si strictes, mais si la distance entre les objets est fortement augmentée, l'atténuation du signal optique dans la fibre commence à affecter. Le signal doit être amplifié et régénéré, c'est-à-dire que vous devez créer votre propre système de transmission ou louer des canaux de communication interurbains. Les volumes de trafic passant entre les deux centres de données sont assez importants et ont tendance à augmenter constamment. Les principaux moteurs de la croissance du trafic entre les datacenters: virtualisation, services cloud, migration et connexion de nouveaux serveurs et systèmes de stockage. Ici, vous pouvez rencontrer le problème d'une bande passante insuffisante des canaux de transmission de données. L'augmenter à l'infini ne fonctionnera pas en raison du manque de ses propres fibres libres ou du coût élevé de la location. Le dernier point important est lié à la sécurité de l'information: les données circulant entre les centres de données doivent être cryptées, ce qui augmente également les délais. Il y a d'autres points, comme la complexité de l'administration d'un système distribué, mais leur influence n'est pas si grande, et tous les obstacles techniques sont principalement liés aux caractéristiques des canaux de communication et des équipements terminaux.

Deux ou trois sont des difficultés économiques

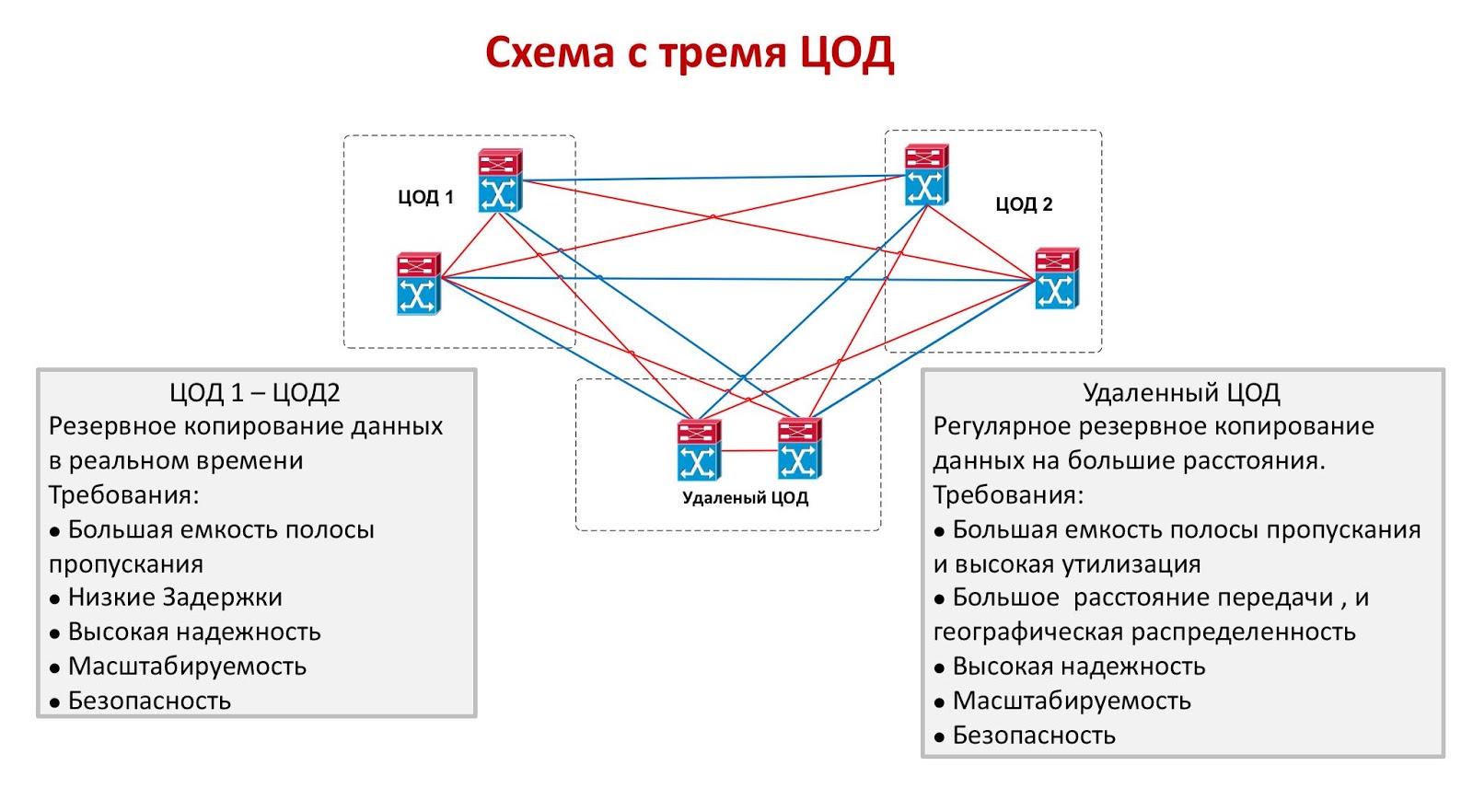

Les deux modes de combinaison des centres de données présentent des inconvénients importants. Les objets fonctionnant de manière synchrone doivent être situés à proximité les uns des autres, ce qui ne garantit pas la survie d'au moins l'un d'entre eux en cas de catastrophe à grande échelle. Oui, cette option est protégée de manière fiable contre les erreurs humaines, les incendies, la destruction de la salle des machines à la suite d'un accident d'avion ou d'une autre urgence locale, mais cela est loin du fait que les deux centres de données peuvent résister, par exemple, à un tremblement de terre catastrophique. En mode asynchrone, les objets peuvent être espacés de milliers de kilomètres, mais la garantie de valeurs RTO et RPO acceptables échouera. Une solution idéale serait un circuit avec trois centres de données, dont deux fonctionnent de manière synchrone, et le troisième est situé le plus loin possible d'eux et joue le rôle d'une réserve asynchrone.

Le seul problème avec les trois centres de données est son coût extrêmement élevé. L'organisation d'un seul site de sauvegarde n'est pas bon marché et peu d'entre eux peuvent se permettre de garder deux centres de données inactifs. Une approche similaire est parfois utilisée dans le secteur financier si le coût de transaction est très élevé: une grande bourse peut lancer un système avec trois petits centres de données, mais dans le secteur bancaire, ils préfèrent utiliser une combinaison synchrone des deux. D'autres industries combinent généralement deux centres de données fonctionnant en mode synchrone ou asynchrone.

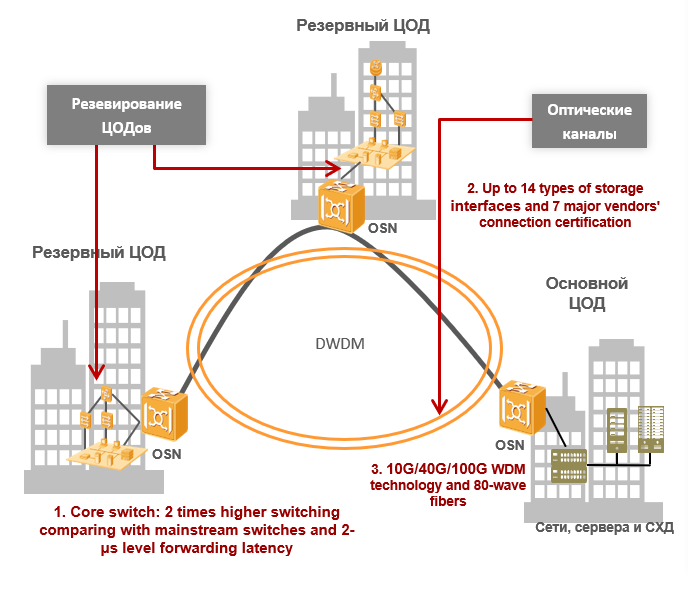

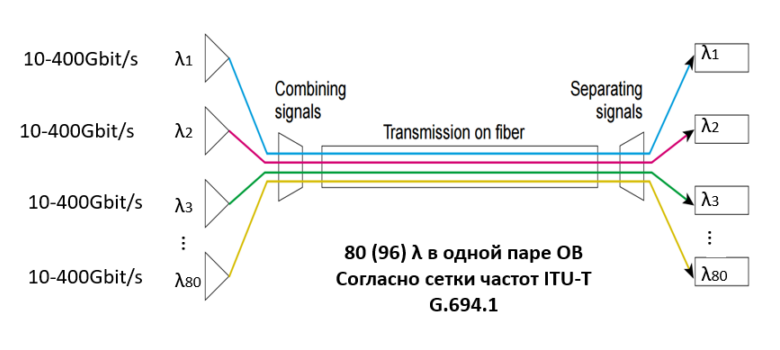

DWDM - Solution optimale pour DCI

Si le client a besoin de combiner les deux centres de données, il rencontrera inévitablement les problèmes ci-dessus. Pour les résoudre, nous utilisons la technologie de multiplexage spectral DWDM, qui permet de multiplexer un certain nombre de signaux porteurs en une seule fibre optique en utilisant différentes longueurs d'onde (λ, c'est-à-dire lambda). De plus, dans une paire optique, il peut y avoir jusqu'à 80 (96) longueurs d'onde selon la grille de fréquences UIT-T G.694.1. Le taux de transfert de données de chaque longueur d'onde est de 100 Gbit / s, 200 Gbit / s ou 400 Gbit / s, et la capacité d'une paire optique peut atteindre 80 λ * 400 Gbit / s = 32 Tbit / s. Il existe déjà des conceptions prêtes à l'emploi fournissant 1 Tbit / s par longueur d'onde: elles donneront une bande passante encore plus grande dans un avenir proche. Aujourd'hui, il résout complètement le problème de bande passante du canal: au lieu de fibres supplémentaires, le client utilisera plus efficacement les fibres disponibles - l'utilisation du trafic atteindra des valeurs fantastiques.

Le multiplexage spectral vous permet de résoudre les problèmes de bande passante, et pour les centres de données fonctionnant en mode synchrone, cela suffit, car les retards de transmission des données entre eux sont faibles en raison de la faible distance et dépendent davantage du type de transpondeur (ou muxpondeur) utilisé dans le système DWDM. Il convient de noter l'une des principales caractéristiques de la technologie de compression spectrale DWDM: une transmission du trafic totalement transparente du fait que la technologie fonctionne au premier niveau physique du modèle OSI à sept niveaux. Si je puis dire, le système DWDM est «transparent» à ses connexions client, comme s’ils seraient connectés par un cordon de raccordement direct. Si nous parlons de mode asynchrone, la principale quantité de retard dépend de la distance entre les centres de données (nous nous souvenons que dans l'OB, il y a un retard de 5 microsecondes par kilomètre), mais il n'y a pas d'exigences strictes pour les retards. Par conséquent, la plage de transmission est déterminée par les capacités du système DWDM et est limitée par trois facteurs: l'atténuation du signal, le rapport signal / bruit et la dispersion de la lumière en mode polarisation.

Lors du calcul de la partie optique de la ligne DWDM, tous ces facteurs sont pris en compte et sur la base des calculs, les types de transpondeurs (ou muxponders), le nombre et le type d'amplificateurs requis, ainsi que d'autres composants du chemin optique sont sélectionnés. Avec le développement des systèmes DWDM et l'apparition de transpondeurs dans leur composition qui prennent en charge une réception cohérente à des vitesses de 40 Gbit / s et 100 Gbit / s et plus, la dispersion de la lumière en mode polarisation comme facteur limitant a cessé d'être prise en compte. La question du calcul de la ligne optique et du choix du type d'amplificateur est un grand sujet distinct qui nécessite que le lecteur connaisse les bases de l'optique physique, et nous n'en discuterons pas en détail dans cet article.

La technologie WDM peut résoudre les problèmes de sécurité de l'information. Bien sûr, le cryptage ne doit pas être effectué au niveau optique, mais cette approche présente un certain nombre d'avantages indéniables. Le chiffrement à des niveaux supérieurs nécessite souvent des appareils autonomes pour différents flux de trafic et contribue à des retards importants. Avec l'augmentation du nombre de ces appareils, les retards augmentent également et la complexité de la gestion du réseau augmente également. Le cryptage optique OTN (G.709 - Recommandation UIT-T qui décrit le format de trame dans les systèmes DWDM) ne dépend pas du type de service, ne nécessite pas d'appareils séparés et est très rapide - la différence entre le flux de données crypté et non crypté ne dépasse généralement pas 10 millisecondes.

Sans l'utilisation de la technologie de multiplexage spectral DWDM, il est presque impossible de combiner de grands centres de données et de créer un cluster distribué résistant aux catastrophes. Les volumes d'informations transmises sur le réseau augmentent de façon exponentielle et tôt ou tard, les possibilités des lignes de communication à fibre optique existantes seront épuisées. La pose ou la location de ceux-ci coûtera beaucoup plus cher au client que l'achat d'équipement, en fait, aujourd'hui, le scellement est la seule option économiquement viable. À courte distance, les technologies DWDM permettent d'utiliser plus efficacement les fibres optiques existantes, augmentant ainsi l'utilisation du trafic vers le ciel, et à longue distance, elles minimisent également les retards de transmission des données. Aujourd'hui, c'est peut-être la meilleure technologie disponible sur le marché et cela vaut la peine de l'examiner de plus près.