Aujourd'hui, je vais parler de la plateforme hyperconvergée SharxBase. Il n'y a pas eu d'examen de ce complexe sur Habré, et il a été décidé de mettre fin à cette injustice. Notre équipe a réussi à tester la solution "en combat", les résultats sont ci-dessous.

PS Il y a beaucoup de tables, de vrais chiffres et d'autres «viandes» sous la coupe. Pour ceux qui sont plongés dans l'essence - bienvenue!

À propos du produit

La plateforme SharxBase est basée sur des serveurs Intel et des logiciels open source OpenNebula et StorPool. Il se présente sous la forme d'une solution en boîte, qui comprend du matériel serveur avec une virtualisation préinstallée et un logiciel de stockage distribué.

L'une des quatre configurations standard de base - Petite, Moyenne, Grande, Stockage - est disponible sur commande, qui diffèrent par la quantité de ressources informatiques disponibles (processeurs, RAM) et l'espace disque. Les serveurs sont conçus comme des modules: un châssis 2RU typique, dans lequel jusqu'à quatre serveurs peuvent être installés pour une installation dans un rack de serveur 19 "standard. La plate-forme prend en charge à la fois une mise à l'échelle horizontale en augmentant le nombre de nœuds et verticale en augmentant la quantité de RAM dans les nœuds , installation de lecteurs supplémentaires et de cartes d'extension.Nous prenons actuellement en charge l'installation d'adaptateurs réseau, de modules de contrôle de démarrage, de lecteurs NVMe.

Architecture de stockage

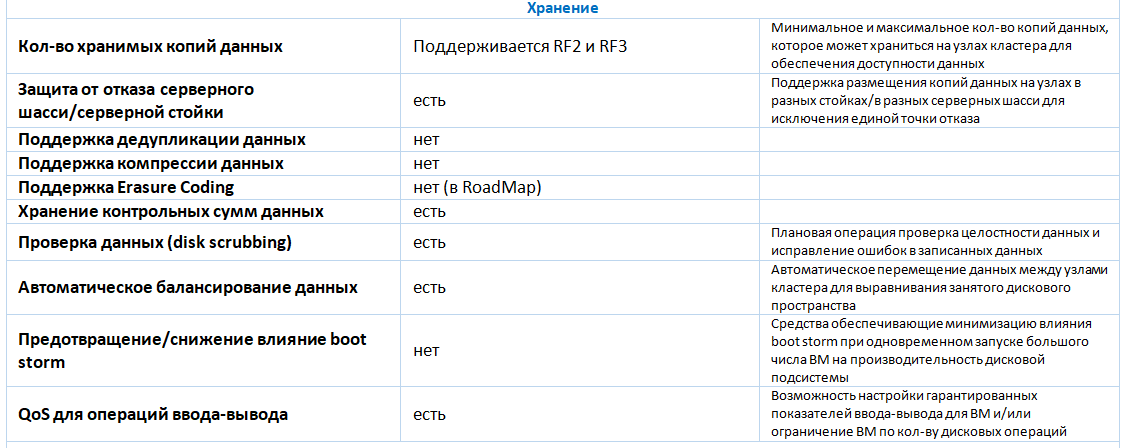

Pour l'organisation des disques flash de stockage à tolérance de panne distribués (SSD et / ou NVMe) sont utilisés. Le support utilisé est Ethernet. Pour transférer le stockage de stockage, il est nécessaire d'utiliser des interfaces réseau dédiées - au moins deux interfaces 25 GbE. Services qui fournissent un travail de stockage distribué sur chaque serveur du cluster et utilisent une partie de ses ressources informatiques. La quantité de ressources dépend du nombre et du volume de disques installés, en moyenne, la surcharge est de 34 Go de RAM par hôte. La connexion au stockage distribué se fait via le protocole d'accès au bloc iSCSI. Pour garantir la tolérance aux pannes, la sauvegarde des données deux ou trois fois est prise en charge. Pour les installations productives, le fabricant recommande d'utiliser une triple redondance. Actuellement, à partir des technologies d'optimisation du stockage, seul le provisionnement fin est pris en charge. La déduplication et la compression des données à l'aide du stockage distribué ne sont pas prises en charge. Les futures versions prendront en charge le codage d'effacement.

Virtualisation

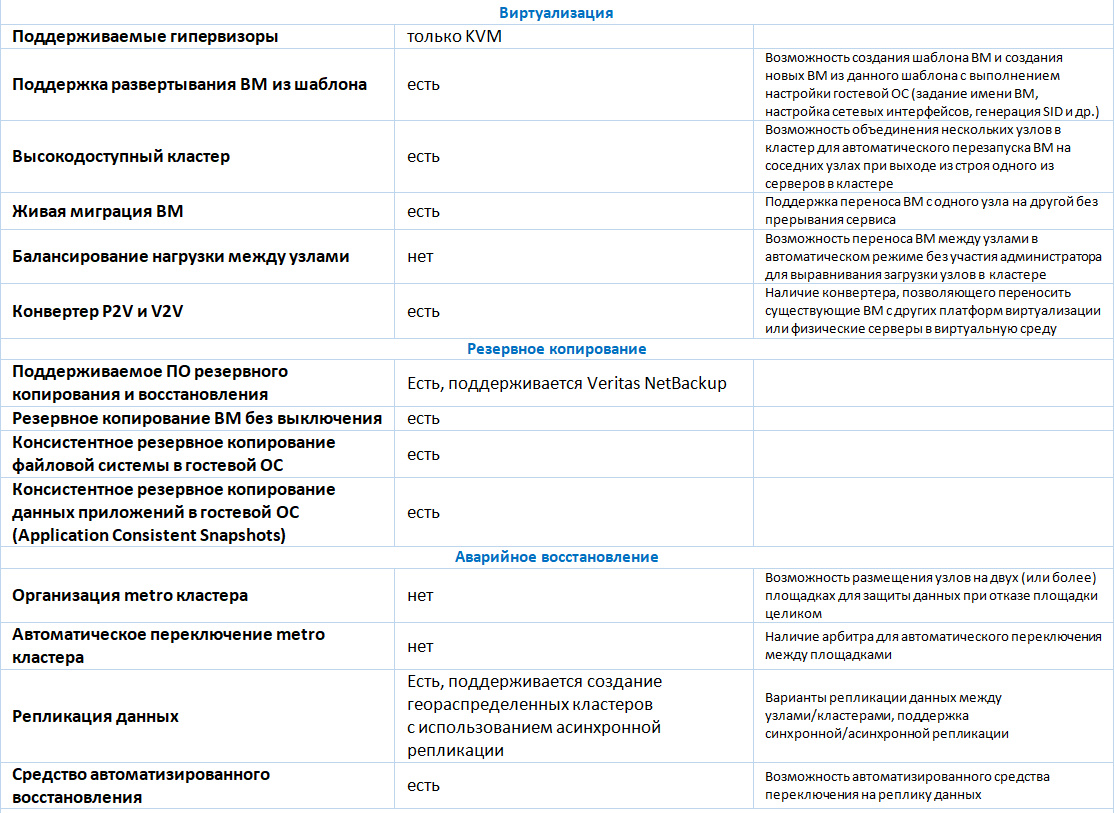

Pour démarrer une machine virtuelle (VM), l'hyperviseur KVM est utilisé. Toutes les fonctionnalités de base pour leur création et leur gestion sont prises en charge:

- création d'une VM à partir de zéro avec indication de la configuration matérielle requise (cœurs de processeur, taille de la RAM, nombre et taille des disques virtuels, nombre d'adaptateurs réseau, etc.);

- Clonage de VM à partir d'un modèle existant ou;

- créer un instantané (instantané), supprimer un instantané, annuler les modifications apportées à la machine virtuelle à partir du moment où l'instantané a été pris;

- Modification de la configuration matérielle d'une machine virtuelle créée précédemment, y compris la connexion ou la déconnexion d'un disque virtuel ou d'un adaptateur réseau pour une machine virtuelle incluse (hotplug / hot unplug);

- Migration de VM entre serveurs de virtualisation

- surveillance de l'état de la machine virtuelle, y compris la surveillance de la charge des ressources informatiques et des disques virtuels (taille actuelle, volume d'E / S en Mo / s ou en IOPS);

- planifier des opérations avec des VMs selon un calendrier (allumer, éteindre, créer un instantané, etc.);

- connexion et gestion de machines virtuelles via les protocoles VNC ou SPICE à partir d'une console Web.

Schéma fonctionnel typique (4 nœuds)

Schéma fonctionnel typique (4 nœuds)La gestion de la plateforme est effectuée à partir de l'interface graphique ou de la ligne de commande (localement ou à distance lors de la connexion via SSH), ainsi que via l'API publique.

Parmi les limites de la plate-forme de virtualisation, on peut noter l'absence de mécanismes pour équilibrer automatiquement les VM entre les hôtes du cluster.

En plus de prendre en charge la virtualisation des serveurs, SharxBase a la capacité de créer des centres de données configurables par logiciel et des infrastructures de cloud privé. A titre d'exemple de telles fonctions, on peut noter:

- gestion des droits d'accès en fonction de l'appartenance des utilisateurs aux groupes et des listes de contrôle d'accès (ACL): des droits peuvent être attribués à différents groupes d'utilisateurs qui restreignent l'accès aux composants de l'infrastructure virtuelle;

- comptabilité de la consommation des ressources (comptabilité): processeurs, RAM, ressources disque;

- Estimation du coût de consommation des ressources informatiques (showback) en unités arbitraires en fonction des ressources consommées et de leurs prix;

- fonctionnalités de base d'IPAM (IP Address Management): attribution automatique des adresses IP pour les interfaces réseau VM à partir d'une plage prédéterminée;

- capacités de base de SDN: création d'un routeur virtuel pour transférer le trafic entre les réseaux virtuels.

À l'aide du module de sécurité des informations développé, SharxBase met en œuvre des mesures supplémentaires pour assurer la sécurité des informations du système de gestion de la plateforme: exigences personnalisables pour les mots de passe des comptes d'utilisateurs (complexité, longueur, durée d'utilisation, répétabilité, etc.), blocage des utilisateurs, gestion des sessions d'accès actuelles à la console de gestion, enregistrement événements et autres Le logiciel est inscrit au registre des logiciels russes (numéro 4445). Une conclusion positive a été reçue du laboratoire d'essais sur les tests de certification réussis du logiciel SharxBase dans le système de certification RF FSTEC pour le niveau 4 de surveillance de l'absence de NDV, ainsi que pour la conformité aux spécifications techniques (répondant aux exigences de protection des environnements de virtualisation) jusqu'au niveau de sécurité GIS classe 1 / ISPD inclus. L'obtention d'un certificat de conformité aux exigences du système de certification des moyens de sécurité de l'information n ° ROSS RU.0001.01BI00 (FSTEC de la Fédération de Russie) est attendue en décembre 2018.

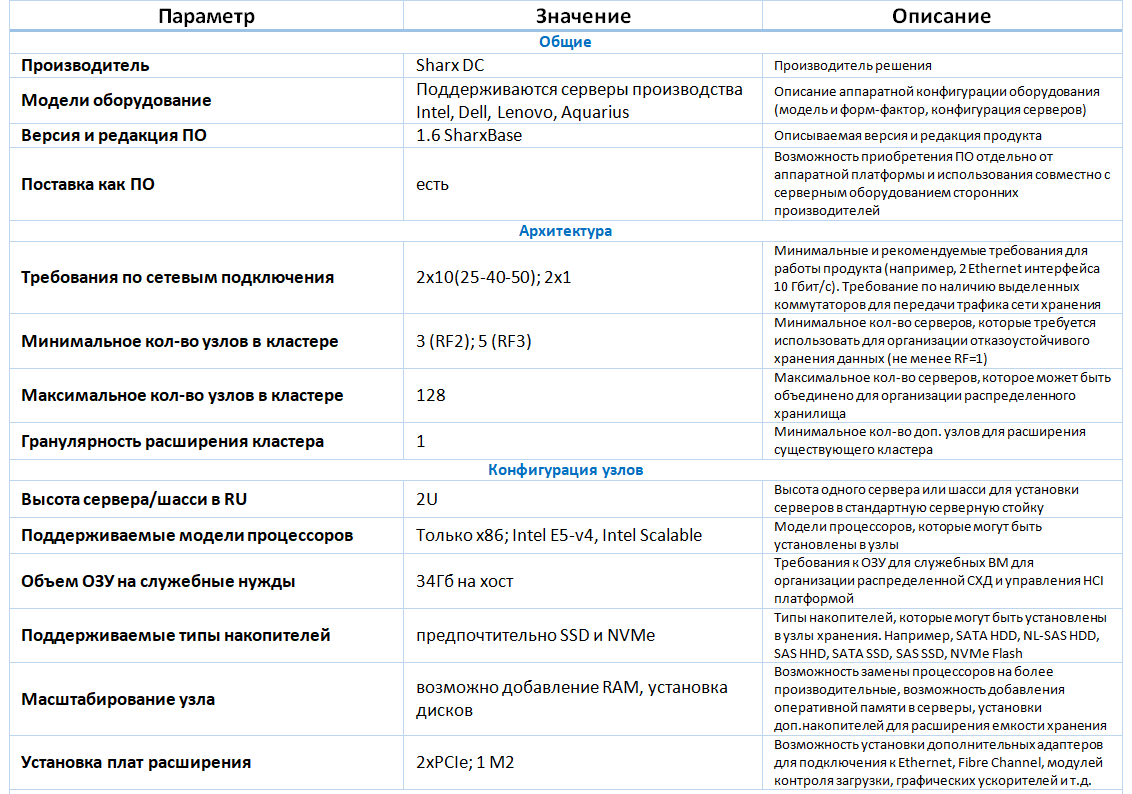

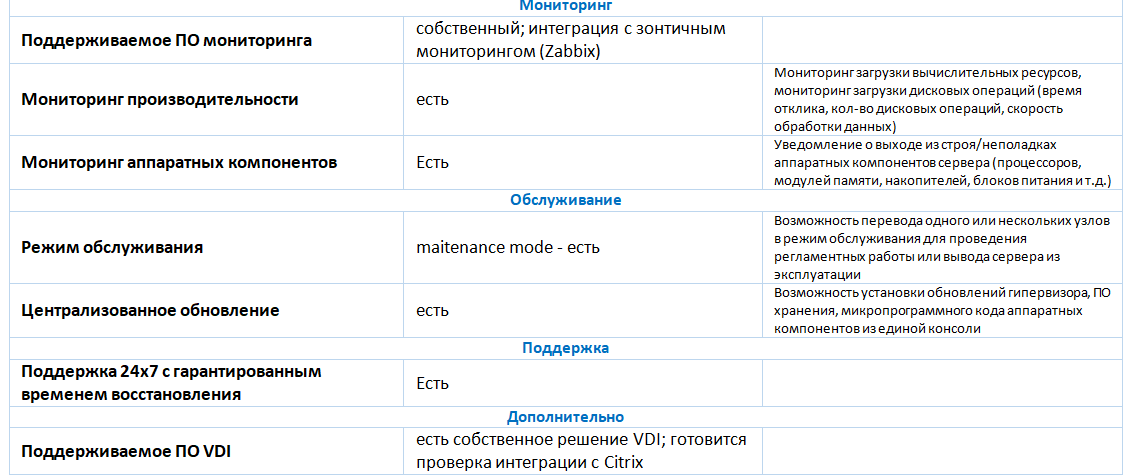

Une description détaillée de la fonctionnalité est donnée dans le tableau ci-dessous.

Suivi

SharxBase Monitoring donne accès à des informations avancées sur l'état de la plateforme, aux paramètres d'alerte et à l'analyse de l'état de la plateforme.

Le sous-système de surveillance est un système distribué installé sur chacun des nœuds de cluster et fournissant des données sur l'état de la plate-forme au système de gestion de la virtualisation.

Le sous-système de surveillance en temps réel collecte des informations sur les ressources de la plateforme, telles que:

| Nœuds de serveur | Alimentations | Commutateurs | Machines virtuelles | Entrepôt de données distribué |

|---|

- Numéro de série de l'unité

- Numéro de série du nœud et de la carte mère

- Unité et température de l'unité

- Modèle CPU et charge

- Numéros d'emplacement, fréquence, taille et disponibilité de la RAM

- Noeud et adresse de stockage

- La vitesse de rotation des ventilateurs de refroidissement

- État de l'adaptateur réseau

- Numéro de série de l'adaptateur réseau

- L'état du disque et ses informations système

| - Numéro de série de l'alimentation

- L'état de l'alimentation et sa charge

| - Modèle de commutateur

- État du commutateur et de ses ports

- La vitesse de rotation des ventilateurs de refroidissement

- Statut des ventilateurs de refroidissement

- Afficher la liste des VLAN

| - Charge CPU

- Charge RAM

- charge réseau

- État de la machine virtuelle

- Vitesse d'écriture / lecture du disque

- Vitesse de connexion entrante / sortante

| - Affichage de l'espace libre / occupé

- État du disque

- Espace disque utilisé

- Erreurs de conduite

|

Sous-totaux

Les avantages de la solution incluent:

- la possibilité de remise aux organisations sur les listes de sanctions;

- La solution est basée sur le projet OpenNebula, qui se développe activement depuis longtemps;

- prise en charge de toutes les fonctions nécessaires concernant la virtualisation des serveurs, suffisante pour les petites et moyennes installations (jusqu'à 128 hôtes);

- la présence d'un module de sécurité de l'information qui assure la mise en œuvre des exigences réglementaires dans le domaine de la sécurité de l'information.

Les inconvénients de la solution incluent:

- fonctionnalités inférieures par rapport aux autres solutions HCI sur le marché (par exemple, Dell VxRail, Nutanix);

- prise en charge limitée des systèmes de sauvegarde (actuellement, la prise en charge de Veritas NetBackup a été annoncée);

- certaines tâches administratives sont effectuées à partir de la console et ne sont pas accessibles via le Web.

Fonctionnalité

Lors de l'élargissement du portefeuille de solutions hyperconvergées, nous avons effectué des tests de performances et de tolérance aux pannes en collaboration avec le fournisseur.

Test de performance

Le banc d'essai était un cluster à 4 nœuds de serveurs Intel HNS2600TP. La configuration de tous les serveurs était identique. Les serveurs avaient les caractéristiques matérielles suivantes:

- modèle de serveur - Intel HNS2600TP;

- deux processeurs Intel Xeon E5-2650 v4 (12 cœurs avec une fréquence d'horloge de 2,2 GHz et la prise en charge d'Hyper Threading);

- 256 Go de RAM (224 Go de mémoire sont disponibles pour exécuter la machine virtuelle);

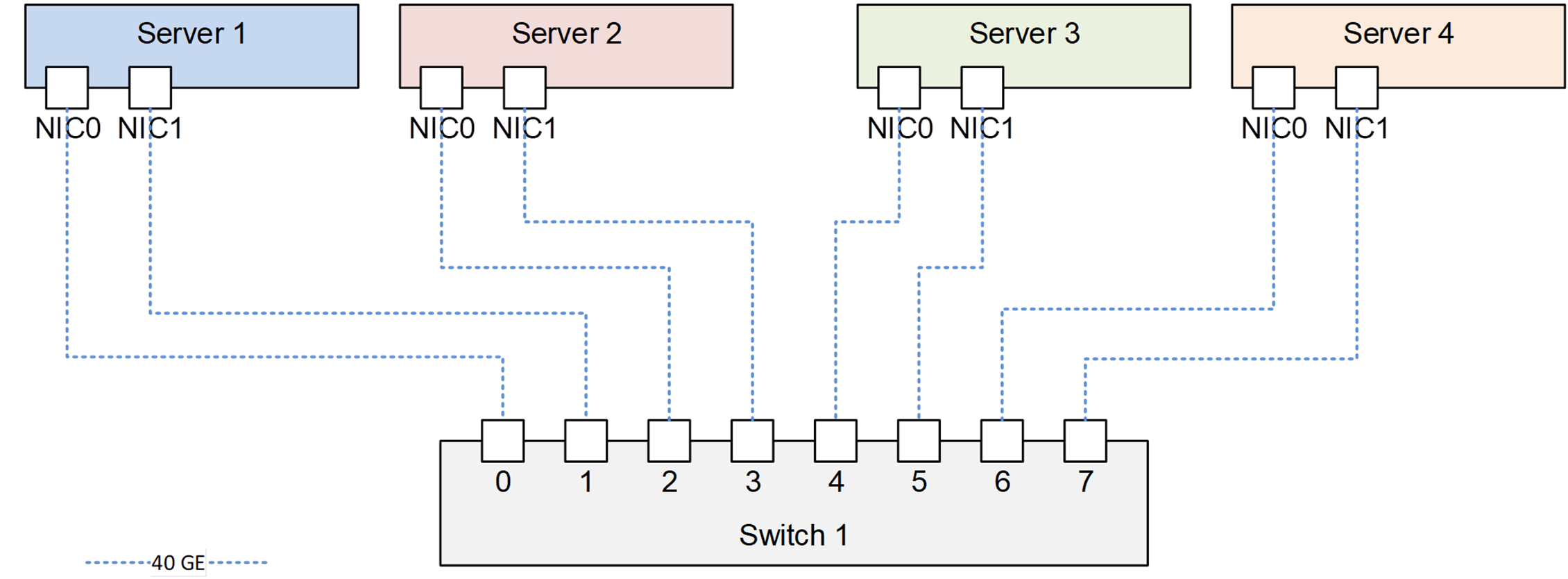

- adaptateur réseau avec 2 ports QSFP + avec un taux de transfert de données de 40 Gb / s;

- un contrôleur RAID LSI SAS3008;

- 6 disques SSD SATA Intel DC S3700 d'une capacité de 800 Go chacun;

- deux alimentations d'une puissance nominale de 1600 W chacune.

- Le logiciel de virtualisation SharxBase v1.5 est installé sur les serveurs.

Tous les serveurs connectés au commutateur réseau Mellanox. Le schéma de connexion est illustré dans la figure.

Schéma de connexion des serveurs sur banc d'essai

Schéma de connexion des serveurs sur banc d'essaiToutes les fonctionnalités décrites précédemment ont été confirmées à la suite des tests fonctionnels.

Le test du sous-système de disque a été effectué à l'aide de la version 5.04.06 du logiciel Vdbench. Sur chaque serveur physique, une machine virtuelle a été créée avec Linux OS avec 8 vCPU, 16 Go de RAM. Pour les tests sur chaque machine virtuelle, 8 disques virtuels de 100 Go chacun ont été créés.

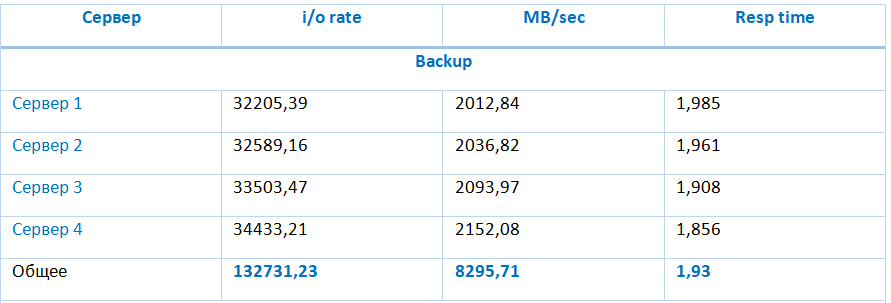

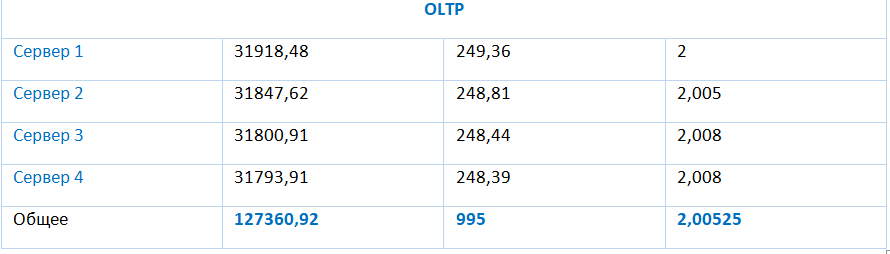

Lors des tests, les types de charges suivants ont été vérifiés:

- (Sauvegarde) 0% aléatoire, 100% en lecture, taille de bloc de 64 Ko, 1 E / S exceptionnelle;

- (Restauration) 0% aléatoire, 100% en écriture, taille de bloc de 64 Ko, 1 E / S exceptionnelle;

- (Typique) 100% aléatoire, 70% en lecture, taille de bloc de 4 Ko, 4 E / S exceptionnelles;

- (VDI) 100% aléatoire, 20% en lecture, taille de bloc de 4 Ko, 8 E / S exceptionnelles;

- (OLTP) 100% aléatoire, 70% en lecture, taille de bloc de 8 Ko, 4 E / S exceptionnelles.

Les résultats des tests de ces types sont présentés dans le tableau:

Le stockage fournit des indicateurs de performances particulièrement élevés sur les opérations de lecture et d'écriture séquentielles de 8295,71 Mo et 2966,16 Mo, respectivement. Les performances de stockage à une charge typique (E / S aléatoires avec des blocs de 4 Ko avec 70% de lecture) atteignent 133977,94 IOPS avec un délai d'E / S moyen de 1,91 ms et diminuent avec une augmentation du rapport des opérations d'écriture aux opérations de lecture.

Test de tolérance aux pannes

Ces tests ont permis de vérifier qu'une défaillance d'un des composants du système n'entraîne pas l'arrêt de l'ensemble du système.

| Test | Détails du test | Commentaires |

|---|

| Échec de disque dans le pool de stockage | 14h00 - le système fonctionne normalement;

14:11 - désactivation du premier SSD du serveur 1;

14:12 - L'échec du SSD est affiché dans la console de gestion de la plateforme;

14:21 - désactivez le premier SSD du serveur 2;

14:35 - la panne de deux SSD est affichée dans la console de gestion de plateforme;

14:38 - renvoyez les disques aux serveurs 1 et 2. Les voyants LED du SSD ne sont pas affichés;

14:40 - l'ingénieur via la CLI a effectué l'ajout de SSD au référentiel;

14:50 - dans la console de gestion de plate-forme sont affichés comme fonctionnant;

15h00 - La synchronisation des composants VM est terminée;

| Le système fonctionnait normalement. L'indicateur de tolérance aux pannes est comme indiqué. |

| Panne de réseau | 15:02 - le système fonctionne normalement;

15:17 - désactivez l'un des deux ports du serveur 1;

15:17 - perte d'une requête Echo à l'adresse IP de la console Web (le serveur isolé a servi de leader), la VM exécutée sur le serveur est accessible sur le réseau;

15:18 - désactivation du deuxième port sur le serveur 1, la machine virtuelle et la console de gestion du serveur sont devenues indisponibles;

15h20 - La machine virtuelle a redémarré sur le nœud du serveur 3;

15:26 - Les interfaces réseau du serveur 1 sont connectées, le serveur est revenu au cluster;

15:35 - la synchronisation des composants des disques VM est terminée;

| Le système fonctionnait normalement. |

| Panne d'un serveur physique | 15h35 - le système fonctionne normalement;

15:36 - arrêt du serveur 3 via la commande poweroff dans l'interface IPMI;

15:38 - la VM de test a redémarré sur le serveur 1;

15h40 - inclusion du serveur 3;

15:43 - fonctionnement du serveur restauré;

15:47 - la synchronisation est terminée.

| Le système fonctionnait normalement. |

Résultats des tests

La plate-forme SharxBase offre un haut niveau de disponibilité et de tolérance aux pannes en cas de défaillance d'un composant matériel principal. En raison de la triple redondance du sous-système de disques, la plateforme garantit la disponibilité et la sécurité des données en cas de double panne.

Les inconvénients de la plate-forme incluent des exigences élevées en espace disque dues à la nécessité de stocker et de synchroniser trois copies complètes de données, et le manque de mécanismes pour une utilisation plus efficace de l'espace disque, tels que la déduplication, la compression ou le codage d'effacement.

Sur la base des résultats de tous les tests effectués, nous pouvons conclure que la plateforme hyperconvergée SharxBase est en mesure de fournir un niveau élevé de disponibilité et de performances pour différents types de charges, y compris les systèmes OLTP, VDI et les services d'infrastructure.

Ilya Kuykin,

Ingénieur de conception leader des systèmes informatiques,

Jet Infosystems