Nuages, nuages et nuages à nouveau. Passer aux clouds, que ce soit votre cloud privé dans votre centre de données, un cloud privé avec un fournisseur ou avec des fournisseurs publics tels qu'Amazon AWS, Microsoft Azure, IBM Cloud, Google Cloud, est implacable. J'ai particulièrement remarqué cela lorsque j'ai déménagé aux États-Unis. Ici, tout le monde en parle et toujours - l'air est littéralement saturé de ce sujet. Les fabricants de logiciels et de matériels l'ont parfaitement compris et ne veulent pas manquer cette fenêtre d'opportunité dans ce monde en mutation.

Service Kuberneties

Service Kubernetiesdevient un outil important et puissant à la fois pour la création et la gestion de Data Fabric (dont il sera question plus loin), et pour la concurrence dans le domaine des systèmes HCI. Auparavant, NetApp HCI était une solution assez simple qui ne fonctionnait qu'avec VMware, car Nutanix avait réellement démarré. Maintenant que NKS est arrivé, NetApp HCI sera beaucoup plus difficile pour Nutanix en termes d'applications de nouvelle génération de DataCenter et de nouvelle génération basées sur des conteneurs, mais en même temps laissant le créneau dans lequel l'hyperviseur Nutanix peut théoriquement fonctionner sur NetApp HCI.

Démonstration du service NetApp Kubernetes .

HCINutanix est l'un des premiers HCI bien mérités que beaucoup connaissent. Malgré le fait que Nutanix soit un produit très intéressant, il n'est pas sans inconvénients. La chose la plus intéressante à propos de Nutanix, à mon avis, est l'écosystème interne, pas l'architecture de stockage. Si nous parlons des lacunes, il convient de noter que le marketing pourrait obscurcir certains ingénieurs en transmettant le mauvais message selon lequel toutes les données sont toujours locales et c'est bien. Alors que les concurrents, faisant allusion à NetApp HCI, doivent accéder aux données sur le réseau, qui est «long» et généralement «pas un véritable HCI», sans donner une définition de ce qu'est un véritable HCI, bien qu'il ne puisse pas être en principe, comme par exemple dans «Cloud», que personne ne s'engage à donner de définition non plus. Parce qu'il a été inventé par des personnes à des fins de marketing, de sorte qu'à l'avenir, il serait possible de compléter et de modifier le contenu de ce concept, et non à des fins purement techniques, dans lesquelles initialement un objet a toujours une définition inchangée.

Initialement, il était plus facile d'entrer sur le marché HCI avec une architecture accessible aux masses, qui est plus facile à consommer, à savoir, il suffit d'utiliser la comody du serveur avec des disques pleins.

Mais cela ne signifie pas que ce sont les propriétés déterminantes de HCI et la meilleure option HCI unique. L'énoncé du problème a en fait donné lieu à un problème, ou comme je l'ai dit une nuance: lorsque vous utilisez le stockage dans une architecture de partage rien, qui comprend Nutanix HCI basé sur des équipements de base, vous devez garantir l'accessibilité et la protection des données, pour cela, vous devez copier tous les enregistrements au moins d'un serveur à l'autre. Et lorsque la machine virtuelle génère un nouvel enregistrement sur le disque local, tout irait bien s'il n'était pas nécessaire de dupliquer cet enregistrement de manière synchrone et de le transférer sur un autre serveur et d'

attendre la réponse qu'il est sain et sauf. En d'autres termes, dans Nutanix, et en fait dans toute architecture de partage rien, la vitesse des enregistrements plus ou moins est au mieux équivalente au fait que ces enregistrements seraient immédiatement transférés sur le réseau vers un stockage partagé.

Les principaux slogans de conception de base de HCI ont toujours été la simplicité de l'installation et de la configuration initiales, la possibilité de partir d'une configuration minimale, simple et peu coûteuse et de s'étendre à la taille souhaitée, la facilité d'expansion / compression, la facilité de gestion à partir d'une seule console, l'automatisation, tout cela est en quelque sorte lié à, simplicité, expérience de type cloud, flexibilité et granularité de la consommation des ressources. Mais que le système de stockage dans l'architecture HCI soit un boîtier séparé ou une partie du serveur ne joue pas vraiment un grand rôle dans la réalisation de cette simplicité.

Pour résumer cela, nous pouvons dire que le marketing a étonnamment induit en erreur de nombreux ingénieurs que les lecteurs locaux sont toujours meilleurs, ce qui n'est pas la réalité, car d'un point de vue technique, contrairement au marketing, ce n'est pas si simple. Après avoir tiré la conclusion erronée qu'il existe des architectures HCI qui n'utilisent que des disques locaux, nous pouvons tirer la conclusion incorrecte suivante que les systèmes de stockage connectés sur le réseau fonctionneront toujours plus lentement. Mais les principes de protection de l'information, de logique et de physique dans ce monde sont conçus de telle manière que cela est impossible à réaliser, et il n'y a aucun moyen de s'éloigner de la communication sur le réseau entre les sous-systèmes de disques dans l'infrastructure HCI, il y a une différence fondamentale dans le fait que les disques seront localement avec des nœuds informatiques ou dans un nœud de stockage séparé connecté sur le réseau là-bas. Au contraire, les nœuds de stockage dédiés vous permettent d'obtenir moins de dépendances des composants HCI les uns des autres, par exemple, si vous réduisez le nombre de nœuds dans un cluster HCI basé sur le même Nutanix ou vSAN, vous réduisez automatiquement l'espace dans le cluster. Et vice versa: lors de l'ajout de nœuds de calcul, vous devez ajouter des disques à ce serveur. Dans l'architecture NetApp HCI, ces composants ne sont pas interconnectés. La redevance pour une telle infrastructure n'est pas du tout liée à la vitesse du sous-système de disque, mais pour démarrer, il est nécessaire d'avoir au moins 2 nœuds de stockage et au moins 2 nœuds de calcul, pour un total de 4 nœuds. 4 nœuds NetApp HCI peuvent être conditionnés en 2U à l'aide de demi-lames.

NetApp HCI

NetApp HCIAvec l'achat de SolidFire, le HCI est apparu dans la gamme de produits NetApp (ce produit n'a pas son propre nom, c'est pourquoi il est simplement appelé HCI). Sa principale différence avec les systèmes HCI «classiques» est un nœud de stockage séparé connecté sur le réseau. Le système SolidFire lui-même, qui est la couche «à cent pour cent» pour HCI, est radicalement différent des systèmes All-Flash AFF, développés à partir de la gamme FAS, qui, à son tour, est sur le marché depuis environ 26 ans.

Lorsque vous apprenez à mieux le

connaître (

ce que vous pouvez également faire ), il devient clair qu'il s'agit d'un produit d'une idéologie complètement différente, destiné à un segment différent de consommateurs (fournisseurs de cloud) et qui correspond idéalement précisément à leurs tâches, à la fois en termes de performances, de tolérance aux pannes et point de vue de l'intégration dans un écosystème de facturation unique.

Recuit pour les 200 tests NetApp SolidFire Arthur Alikulov, Evgeny Elizarov. Instructions NetApp 2018 .

NetApp passe aux nuageset a depuis longtemps cessé d'être seulement un fabricant de systèmes de stockage. Maintenant, c'est plutôt une société de gestion des dates trouble, au moins ils vont obstinément dans cette direction. Un grand nombre de différentes implémentations des produits NetApp en parlent: la sauvegarde SaaS pour O365, la sauvegarde SaaS pour Salesforce (et les plans pour Google Apps, Slack et ServiceNow). ONTAP Select est devenu une décision très importante, indépendante et pas comme avant, une petite lotion pour la réplication vers un SAF "complet". NDAS s'intègre de plus en plus profondément dans les systèmes de stockage apparemment non intégrables auparavant - et le cloud fournissant une sauvegarde, une recherche de type Google dans le répertoire de fichiers et une interface de gestion graphique en tant que service. FabricPool est allé encore plus loin et a combiné le SSD et le cloud, ce qui semblait improbable, voire fou auparavant.

Le fait que NetApp se soit retrouvé dans quatre des plus grands fournisseurs de cloud du monde en un laps de temps assez court indique la gravité de leurs intentions. De plus, le service NFS dans Azure est construit exclusivement sur les systèmes NetApp AFF.

Démo des fichiers Azure NetApp .

Les systèmes de stockage NetApp AFF sont disponibles dans Azure, AWS et Google en tant que service, NetApp est engagé dans leur support, leur mise à jour et leur maintenance, et les utilisateurs du cloud peuvent consommer de l'espace système AFF et des fonctionnalités pour la capture instantanée, le clonage, la QoS en tant que service.

Service NetApp Cloud Volumes pour AWS Demo .

IBM Cloud utilise ONTAP Select, qui a exactement les mêmes fonctionnalités que le système AFF, mais est utilisé comme logiciel pouvant être installé sur le serveur du serveur. Active IQ est un portail Web qui affiche des informations sur les logiciels et équipements NetApp et fournit des recommandations pour anticiper les problèmes et mettre à jour les algorithmes d'IA exécutés sur la télémétrie assemblée à partir des appareils et services NetApp.

Démo NetApp Active IQ .

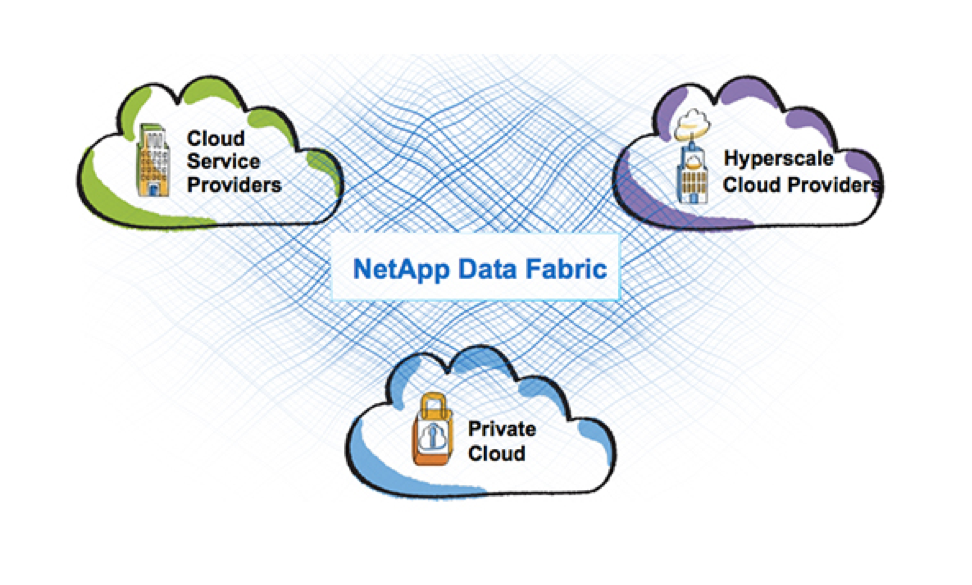

Structure de donnéesEn général, la stratégie Data Fabric que NetApp poursuit actuellement est conçue pour combiner ces environnements complètement différents: les clouds publics et privés et tous les produits NetApp. Après tout, il ne suffit pas de lancer un produit dans le cloud, il faut qu'il s'intègre logiquement et harmonieusement dans les services des fournisseurs de cloud. Et aujourd'hui, NetApp est plus que réussi. Data Fabric de l'idée marketing acquiert en douceur des fonctionnalités assez tangibles sous la forme de technologies et de produits individuels: hiérarchisation FabricPool entre SSD et S3, SnapMirror entre ONTAP et SolidFier / HCI, SnapCenter pour ONTAP et SolidFier (qui n'a pas encore été implémenté), service de sauvegarde de données NDAS leur stockage dans le cloud, le logiciel MAX Data pour la mémoire définie par logiciel, ce sont tous des produits ou des fonctionnalités NetApp qui incarnent cette vision de Data Fabric. ONTAP Select peut désormais fonctionner sur Nutanix, offrant une fonctionnalité de fichier riche à leur écosystème.

Data Fabric est en partie une vision du processus de fusion ou d'intégration de tous les produits NetApp et même des clouds, et je ne vois même pas seulement le marketing, mais même la fusion physique de produits individuels.

Non seulement cela, je veux faire une prédiction. Depuis plusieurs années, je joue à ce jeu au détriment des prédictions avec certains de mes collègues, et jusqu'à présent, j'ai toujours été très proche ou j'ai deviné le fil de la pensée dans cette entreprise, voyons quelle chance j'ai cette fois. Je tiens à souligner qu'il s'agit de mon opinion personnelle, basée sur des informations reçues au cours des 7 années de mon expérience avec NetApp et l'intuition, aucun de NetApp ne m'a dit cela, donc cela ne peut être que le fruit de mon imagination:

- L'AFF fera partie de HCI

- Il sera possible de migrer le LUN en ligne entre AFF / HCI

NetApp finit par être un fournisseur de stockagec'est peut-être un nom de titre trop fort, mais NetApp entre dans la phase où la société devient un opérateur de gestion des données, défini par logiciel, natif du cloud et, comme d'habitude, continue de produire du stockage. Le stockage n'a pas disparu et le bord n'est pas visible du fait que cela peut se produire dans un proche avenir, mais l'accent est mis sur la couverture nuageuse et sur les données elles-mêmes.

Ce texte a été écrit en étroite collaboration avec Dmitry

bbk , si vous voulez en savoir plus sur les technologies NetApp - ne soyez pas trop paresseux pour le mettre +, et les nouveaux articles ne vous feront pas attendre.

Si vous êtes intéressé par les actualités du monde NetApp, bienvenue sur le canal de télégramme

StorageTalks , mais si vous recherchez une communauté de stockage active de langue russe, venez sur le chat du télégramme

StorageDiscussions .