Pendant plusieurs semaines, le spécialiste en informatique Siwei Lyu a regardé les vidéos deepfake créées par son équipe avec une inquiétude tourmentante. Ces faux films réalisés à l'aide de l'algorithme d'apprentissage automatique montraient des célébrités faisant des choses qu'elles ne feraient pas. Ils lui semblaient étrangement effrayants, et pas seulement parce qu'il savait qu'ils étaient faux. "Ils ont l'air mal", se souvient-il de ses pensées, "mais il est très difficile de déterminer exactement ce qui fait cette impression."

Mais une fois dans son cerveau est venu un souvenir d'enfance. Comme de nombreux autres enfants, il jouait avec des enfants "peepers". "J'ai toujours perdu de telles compétitions", dit-il, "parce que quand je regardais leurs visages sans ciller, je me sentais très mal à l'aise."

Il s'est rendu compte que ces faux films lui causaient un malaise similaire: il a joué les regards à ces stars de cinéma, car ils n'ouvraient ni ne fermaient les yeux aussi souvent que de vraies personnes.

Pour savoir pourquoi, Luy, professeur à l'Université d'Albany, et son équipe ont étudié chaque étape du logiciel

DeepFake qui a créé ces vidéos.

Les programmes Deepfake prennent beaucoup d'images d'une personne spécifique à l'entrée - vous, votre ex-petite amie, Kim Jong-un - afin qu'elles puissent être vues sous différents angles, avec différentes expressions faciales disant des mots différents. Les algorithmes apprennent à quoi ressemble ce personnage, puis synthétisent les connaissances acquises dans une vidéo montrant comment cette personne fait ce qu'elle n'a jamais fait.

Pornographie Stephen Colbert prononçant les paroles de John Oliver. Le président met en

garde contre les dangers des fausses vidéos.

Ces vidéos semblent convaincantes pendant quelques secondes sur l'écran du téléphone, mais elles sont (pas encore) parfaites. On peut y voir des signes de faux, par exemple, d'une manière étrange, les yeux constamment ouverts, provenant des lacunes du processus de leur création. En regardant les tripes de DeepFake, Lu a réalisé que parmi les images étudiées par le programme, il n'y avait pas tellement de photos les yeux fermés (parce que vous ne gardez pas un selfie sur lequel vous clignez des yeux?). «Cela devient une distorsion», dit-il. Le réseau neuronal ne comprend pas le clignotement. Les programmes peuvent également manquer d'autres «signaux physiologiques inhérents aux personnes», a déclaré Luya, qui décrit ce phénomène - respirer à une vitesse normale, ou la présence d'un pouls. Bien que cette étude se concentre sur les publicités créées à l'aide de logiciels spécifiques, il est généralement admis que même un grand ensemble de photographies peut ne pas être en mesure de décrire correctement la perception physique d'une personne, de sorte que tout logiciel formé à ces images sera imparfait.

La révélation sur le clignotement a révélé beaucoup de fausses vidéos. Mais quelques semaines après que Lu et l'équipe ont publié un brouillon du travail en ligne, ils ont reçu une lettre anonyme contenant des liens vers les prochaines fausses vidéos publiées sur YouTube, où les stars ont ouvert et fermé les yeux dans un mode plus normal. Les faux créateurs ont évolué.

Et c'est naturel. Comme Lu l'a noté dans

une interview à The Conversation, "des clignotements peuvent être ajoutés aux vidéos deepfake en incluant des images les yeux fermés dans la base de données, ou en utilisant des vidéos pour s'entraîner". Sachant quel est le signe du faux, vous pouvez l'éviter - il s'agit «simplement» d'un problème technique. Ce qui signifie que les fausses vidéos vont s'impliquer dans une course aux armements entre créateurs et reconnaissants. Des recherches comme le travail de Luy ne peuvent que compliquer la vie de faux fabricants. «Nous essayons de relever la barre», dit-il. «Nous voulons compliquer ce processus, le rendre plus long.»

Parce que maintenant c'est très simple. Téléchargez le programme, google célébrités photos, les nourrir à l'entrée du programme. Elle les digère, apprend d'eux. Et bien qu'elle ne soit pas encore complètement indépendante, avec un peu d'aide, elle porte et donne naissance à quelque chose de nouveau et de bien réel.

«Elle est très floue», explique Lu. Et il ne veut pas dire d'images. "Cette ligne est entre la vérité et le faux", a-t-il déclaré.

Cela agace et ne surprend simultanément personne qui a été vivant récemment et qui surfe sur Internet. Mais cela inquiète particulièrement les services militaires et de renseignement. En particulier, c'est pourquoi les études de Lu, comme certaines autres œuvres, sont financées par un

programme DARPA appelé MediFor - Media Forensics [criminalistique des médias].

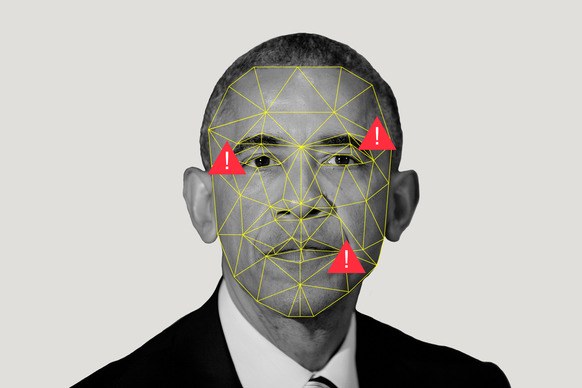

Le projet MediFor a été lancé en 2016, lorsque l'agence a constaté une augmentation de l'activité des fabricants de contrefaçons. Le projet tente de créer un système automatisé qui étudie trois niveaux de signes de faux et produit une «évaluation de la réalité» d'une image ou d'une vidéo. Au premier niveau, les pistes numériques sales sont recherchées - bruit d'une caméra d'un certain modèle ou artefacts de compression. Le deuxième niveau est physique: l'éclairage n'est pas sur le visage, le reflet ne ressemble pas à ce qu'il devrait ressembler avec cette disposition de la lampe. Cette dernière est sémantique: comparer les données avec des informations réelles confirmées. Si, par exemple, il est allégué que la vidéo qui a capturé le match de football a été tournée à Central Park à 14 heures le mardi 9 octobre 2018, l'état du ciel coïncide-t-il avec les archives météorologiques? Rassemblez tous les niveaux et obtenez une évaluation de la réalité des données. La DARPA espère qu'à la fin de MediFor, il y aura des prototypes de systèmes avec lesquels il sera possible d'organiser des contrôles à grande échelle.

Cependant, l'horloge tourne (ou s'agit-il simplement d'un son répétitif créé par une IA formée aux données liées au suivi du temps?) "Dans quelques années, vous pourrez rencontrer une chose telle que la fabrication d'événements", explique Matt Turek, responsable du programme DARPA. "Pas seulement une seule image ou vidéo éditée, mais plusieurs images ou clips essayant de transmettre un message convaincant."

L'informaticien Juston Moore a une vision plus claire de l'avenir potentiel du Los Alamos National Laboratory. Disons: nous informons l'algorithme que nous avons besoin d'une vidéo sur laquelle Moore vole une pharmacie; nous l'introduisons dans les enregistrements vidéo du système de sécurité de cette institution; l'envoyer en prison. En d'autres termes, il craint que si les normes de vérification des preuves ne se développent pas (ou ne puissent pas) parallèlement à la fabrication de contrefaçons, il sera facile de remplacer les personnes. Et si les tribunaux ne peuvent pas s'appuyer sur des données visuelles, il se peut que des preuves réelles soient ignorées.

Nous arrivons à la conclusion logique que voir une fois ne sera pas mieux que d'entendre cent fois. "Il peut arriver que nous ne fassions confiance à aucune preuve photographique", dit-il, "mais je ne veux pas vivre dans un tel monde."

Un tel monde n'est pas si incroyable. Et le problème, selon Moore, s'étend bien au-delà du remplacement des individus. «Les algorithmes peuvent

créer des images de personnes qui n'appartiennent pas à de vraies personnes, ils peuvent étrangement modifier des images, transformant un

cheval en zèbre », explique Moore. Ils peuvent

supprimer des parties d'images et

supprimer des objets

de premier plan

de la vidéo .

Peut-être que nous ne pourrons pas traiter les contrefaçons plus rapidement qu’elles ne le seront. Mais peut-être que cela fonctionnera - et cette opportunité motive l'équipe Moore à étudier les méthodes numériques pour étudier les preuves. Le programme Los Alamos, combinant la connaissance des cyber systèmes, des systèmes d'information, de la biologie théorique et de la biophysique, est environ un an plus jeune que l'agence DARPA. Une approche se concentre sur la «compressibilité», dans les cas où l'image contient moins d'informations qu'il n'y paraît. "Fondamentalement, nous nous appuyons sur l'idée que tous les générateurs d'images d'IA ont un ensemble limité de choses qu'ils peuvent créer", explique Moore. "Donc, même si l'image me semble plutôt compliquée ou pour vous, vous pouvez y trouver une structure répétitive." Lors du recyclage des pixels, il ne reste pas grand-chose.

Ils utilisent également des algorithmes de codage clairsemés pour jouer au jeu avec des allumettes. Disons que nous avons deux collections: un tas d'images réelles et un tas d'images AI créées artificiellement. L'algorithme les étudie, créant ce que Moore appelle un «dictionnaire d'éléments visuels», notant que les images artificielles ont quelque chose en commun et que les images réelles ont quelque chose en commun. Si l'ami de Moore retweete l'image d'Obama et que Moore considère que l'image a été créée à l'aide de l'IA, il pourra la piloter via le programme et découvrir quel dictionnaire sera le plus proche de lui.

Los Alamos, où se trouve l'un des supercalculateurs les plus puissants du monde, télécharge des ressources vers ce programme, non seulement parce que quelqu'un peut remplacer Moore par un faux vol. La mission du laboratoire est de «résoudre les problèmes de sécurité nationale à l'aide de l'excellence scientifique». Leur tâche principale est la sûreté nucléaire, fournissant des garanties que les bombes n'exploseront pas quand elles ne devraient pas et explosent quand elles devraient (veuillez ne pas le faire), ainsi qu'une assistance en matière de non-prolifération. Tout cela nécessite une connaissance générale de l'apprentissage automatique, car cela aide, comme le dit Moore, «à tirer de grandes conclusions à partir de petits ensembles de données».

Mais en plus de tout cela, des entreprises comme Los Alamos devraient pouvoir en croire leurs yeux - ou savoir quand elles n'ont pas besoin de leur faire confiance. Parce que, que se passe-t-il si vous voyez des images satellites de la façon dont un pays mobilise ou teste des armes nucléaires? Et si quelqu'un simule des relevés de capteur?

C'est un avenir effrayant que le travail de Moore et Lu devrait idéalement être évité. Mais dans un monde où tout est perdu, voir ne signifie pas croire, mais des mesures apparemment absolues peuvent être fausses. Tout ce qui est numérique est mis en doute.

Mais «doute» n'est peut-être pas le bon mot. Beaucoup de gens prendront des contrefaçons à leur valeur nominale (rappelez-vous la

photo d'un requin à Houston?), Surtout si le contenu correspond à leurs croyances. «Les gens croiront en ce qu'ils ont tendance à croire», explique Moore.

La probabilité de cette situation est plus élevée pour le grand public qui regarde les informations que dans le domaine de la sécurité nationale. Et afin d'éviter la propagation de la désinformation parmi nous, les simpletons, DARPA propose une collaboration sur les réseaux sociaux afin d'aider les utilisateurs à déterminer que la crédibilité de la vidéo où Kim Jong-un danse les macarons est plutôt faible. Turek souligne que les réseaux sociaux peuvent diffuser l'histoire en réfutant la vidéo aussi vite que la vidéo elle-même.

Mais le feront-ils? L'exposition est un processus

gênant (mais pas aussi

inefficace que la rumeur le dit). Et les gens doivent vraiment montrer les faits avant de pouvoir changer d'avis sur la fiction.

Mais même si personne ne peut changer d'avis des masses quant à la véracité de la vidéo, il est important que les personnes qui prennent des décisions politiques et juridiques - qui transporte des roquettes ou tue des gens - essaient d'utiliser des machines pour séparer la réalité apparente du sommeil de l'IA.