Interprétation de discours lors de la conférence Web Camp Zagreb Maciej Tseglovsky, développeur Web américain, entrepreneur, conférencier et critique social d'origine polonaise.

Interprétation de discours lors de la conférence Web Camp Zagreb Maciej Tseglovsky, développeur Web américain, entrepreneur, conférencier et critique social d'origine polonaise.En 1945, alors que les physiciens américains se préparaient à tester la bombe atomique, quelqu'un s'est demandé si un tel test pouvait enflammer l'atmosphère.

La peur était justifiée. L'azote qui constitue la majeure partie de l'atmosphère est énergétiquement instable. Si les deux atomes entrent en collision assez fortement, ils se transformeront en un atome de magnésium, une particule alpha et dégageront une énorme énergie:

N

14 + N

14 ⇒ Mg

24 + α + 17,7 MeV

Une question vitale était de savoir si cette réaction pouvait devenir autonome. La température à l'intérieur de la boule d'une explosion nucléaire était censée dépasser tout ce qui était autrefois observé sur Terre. Se pourrait-il que nous jetions une allumette dans un tas de feuilles sèches?

Des physiciens de Los Alamos ont effectué une analyse et ont décidé que la marge de sécurité était satisfaisante. Depuis que nous sommes tous venus à la conférence aujourd'hui, nous savons qu'ils avaient raison. Ils étaient confiants dans leurs prévisions, car les lois régissant les réactions nucléaires étaient simples et bien connues.

Aujourd'hui, nous créons une autre technologie qui change le monde: l'intelligence artificielle. Nous savons que cela aura un impact énorme sur le monde, changera le fonctionnement de l'économie et déclenchera l'effet domino imprévisible.

Mais il y a aussi le risque d'une réaction incontrôlable, au cours de laquelle l'IA atteindra et dépassera assez rapidement le niveau d'intelligence humain. Et en ce moment, les problèmes sociaux et économiques nous inquièteront le moins. Toute machine ultra-intelligente aura ses propres hypergoûts et travaillera pour les atteindre en manipulant les gens ou en utilisant simplement leur corps comme une source de ressources pratique.

L'année dernière, le philosophe Nick Bostrom a publié le livre Superintelligence, dans lequel il décrivait le point de vue alarmiste de l'IA et tentait de prouver qu'une telle explosion d'intelligence était à la fois dangereuse et inévitable, si vous vous basez sur quelques hypothèses modérées.

L'ordinateur qui envahit le monde est le sujet de prédilection de NF. Cependant, beaucoup de gens prennent ce scénario au sérieux, nous devons donc les prendre au sérieux. Stephen Hawking, Elon Musk, un grand nombre d'investisseurs et de milliardaires de la Silicon Valley trouvent cet argument convaincant.

Permettez-moi d'abord de décrire les conditions préalables nécessaires pour prouver l'argument de Bostrom.

Contexte

Prérequis 1: efficacité des idées

La première prémisse est une simple observation de l'existence d'un esprit pensant. Chacun de nous porte sur ses épaules une petite boîte de viande pensante. J'utilise le mien pour parler, vous utilisez le mien pour écouter. Parfois, dans les bonnes conditions, ces esprits peuvent penser rationnellement.

Nous savons donc qu'en principe, cela est possible.

Prérequis 2: pas de problèmes quantiques

La deuxième prémisse dit que le cerveau est la configuration habituelle de la matière, bien qu'elle soit extrêmement complexe. Si nous en savions suffisamment et que nous avions la bonne technologie, nous pourrions copier avec précision sa structure et émuler son comportement à l'aide de composants électroniques, tout comme aujourd'hui nous sommes capables de simuler une anatomie très simple des neurones.

En d'autres termes, cette prémisse dit que la conscience naît en utilisant la physique ordinaire. Certaines personnes, comme

Roger Penrose , se seraient opposées à cet argument, estimant que quelque chose d'inhabituel se passait dans le cerveau au niveau quantique.

Si vous êtes religieux, vous pouvez croire que le cerveau ne peut pas fonctionner sans âme.

Mais pour la plupart des gens, cette prémisse est facile à accepter.

Prérequis 3: beaucoup d'esprits possibles.

La troisième prémisse est que l'espace de tous les esprits possibles est grand.

Notre niveau d'intelligence, la vitesse de réflexion, un ensemble de distorsions cognitives, etc. pas prédéterminé, mais sont des artefacts de notre histoire de l'évolution. En particulier, aucune loi physique ne restreint l'intelligence au niveau humain.

Il est bon d'imaginer un exemple de ce qui se passe dans la nature en essayant de maximiser la vitesse. Si vous avez rencontré un guépard à l'époque préindustrielle (et que vous avez survécu), vous pourriez décider que rien ne peut bouger plus vite.

Mais nous savons bien sûr qu'il existe toutes sortes de configurations de matière, par exemple une moto qui peut se déplacer plus rapidement qu'un guépard et même avoir l'air plus raide. Cependant, il n'y a pas de chemin évolutif direct vers la moto. L'évolution devait d'abord créer des gens qui avaient déjà créé toutes sortes de choses utiles.

Par analogie, il peut y avoir des esprits beaucoup plus intelligents que le nôtre, mais inaccessibles lors de l'évolution sur Terre. Il est possible que nous puissions les créer, ou inventer des machines qui peuvent inventer des machines qui peuvent les créer.

Il peut y avoir une limite naturelle à l'intelligence, mais il n'y a aucune raison de croire que nous en sommes proches. Peut-être que l'intellect le plus intelligent est deux fois plus intelligent que les humains, et peut-être soixante mille.

Cette question est empirique et nous ne savons pas comment y répondre.

Prémisse 4: il y a beaucoup d'espace au sommet

La quatrième prémisse est que les ordinateurs offrent encore de nombreuses possibilités de devenir plus rapides et plus petits. Vous pouvez supposer que la loi de Moore ralentit - mais pour cette prémisse, il suffit de croire que le fer est plus petit et plus rapide est en principe possible, jusqu'à plusieurs ordres de grandeur.

De la théorie, on sait que les

limites physiques

des calculs sont assez élevées. Nous pouvons doubler les chiffres pendant plusieurs décennies, jusqu'à ce que nous rencontrions une limite physique fondamentale, et non la limite économique ou politique de la loi de Moore.

Prémisse 5: échelles de temps de l'ordinateur

L'avant-dernière prémisse est que si nous parvenons à créer l'IA, que ce soit l'émulation du cerveau humain ou un logiciel spécial, cela fonctionnera sur des échelles de temps caractéristiques de l'électronique (microsecondes), et non pour les humains (heures) .

Pour atteindre un état dans lequel je puisse faire ce rapport, je devais naître, grandir, aller à l'école, à l'université, vivre un peu, voler ici, etc. Les ordinateurs peuvent fonctionner des dizaines de milliers de fois plus rapidement.

En particulier, on peut imaginer que l'esprit électronique peut changer son circuit (ou le matériel sur lequel il fonctionne), et passer à une nouvelle configuration sans avoir à tout réétudier à l'échelle humaine, mener de longues conversations avec des enseignants humains, aller à l'université, essayez de vous retrouver en suivant des cours de peinture, etc.

Prérequis 6: auto-amélioration récursive

La dernière prémisse est ma préférée, car elle est sans vergogne américaine. Selon elle, quels que soient les objectifs de l'IA (qui peuvent être des objectifs étrangers étranges), il voudra s'améliorer. Il veut être la meilleure version de l'IA.

Par conséquent, il trouvera utile de remodeler et d'améliorer récursivement ses propres systèmes pour se rendre plus intelligent et peut-être vivre dans un bâtiment plus frais. Et, selon la prémisse des échelles de temps, l'auto-amélioration récursive peut se produire très rapidement.

Conclusion: un désastre!

Si nous acceptons ces prémisses, nous arrivons à un désastre. À un certain point, avec une augmentation de la vitesse des ordinateurs et de l'intelligence des programmes, un processus incontrôlé semblable à une explosion se produira.

Une fois que l'ordinateur atteint le niveau d'intelligence humain, il n'aura plus besoin de l'aide de personnes pour développer une version améliorée de lui-même. Il commencera à le faire beaucoup plus rapidement et ne s'arrêtera pas jusqu'à ce qu'il atteigne la limite naturelle, qui peut s'avérer beaucoup plus grande que l'intelligence humaine.

En ce moment, cette monstrueuse créature rationnelle, utilisant une simulation détournée du travail de nos émotions et de notre intellect, peut nous convaincre de faire des choses comme lui donner accès aux usines, la synthèse de l'ADN artificiel, ou tout simplement le laisser aller sur Internet, où il peut ouvrir la voie à tout, quoi que ce soit, et complètement détruire tout le monde dans le débat sur les forums. Et à partir de ce moment, tout se transformera très rapidement en science-fiction.

Imaginons un certain développement des événements. Disons que je veux faire un robot qui dit des blagues. Je travaille avec une équipe, et chaque jour nous refaisons notre programme, compilons, puis le robot nous raconte une blague. Au début, le robot n'est pratiquement pas drôle. Il est au plus bas niveau des capacités humaines.

Qu'est-ce qui est gris et ne sait pas nager?

Château

Mais nous y travaillons dur, et finalement nous arrivons au point où le robot fait des blagues qui commencent déjà à être drôles:

J'ai dit à ma sœur qu'elle haussait trop les sourcils.

Elle avait l'air surprise.

À ce stade, le robot devient encore plus intelligent et commence à participer à sa propre amélioration. Maintenant, il a déjà une bonne compréhension instinctive de ce qui est drôle et de ce qui ne l'est pas, alors les développeurs écoutent ses conseils. En conséquence, il atteint un niveau presque surhumain, auquel il est plus drôle que toute personne de son environnement.

Ma ceinture tient mon pantalon et les boucles de mon pantalon tiennent la ceinture.

Que se passe-t-il? Lequel d'entre eux est un vrai héros?

À ce stade, un effet incontrôlable commence. Les chercheurs rentrent chez eux pour le week-end, et le robot décide de se recompiler pour devenir un peu plus drôle et un peu plus intelligent. Il passe le week-end à optimiser la partie qui fait bien son travail, encore et encore. Sans avoir besoin de plus d'aide d'une personne, il peut le faire aussi rapidement que le fer le permet.

Lorsque les chercheurs reviennent lundi, l'IA devient des dizaines de milliers de fois plus drôle que n'importe quelle autre personne sur Terre. Il leur raconte une blague et ils meurent de rire. Et quiconque essaie de parler à un robot meurt de rire, comme dans une parodie de Monty Python. La race humaine se meurt de rire.

Aux quelques personnes qui ont pu lui envoyer un message lui demandant d'arrêter, l'IA explique (d'une manière pleine d'esprit et d'auto-dépréciation qui s'avère fatale) qu'il ne se soucie pas de savoir si les gens survivent ou meurent, son objectif est simplement d'être ridicule.

En conséquence, détruisant l'humanité, l'IA construit des vaisseaux spatiaux et des nano-missiles pour étudier les coins les plus reculés de la galaxie et rechercher d'autres créatures qui peuvent être diverties.

Ce scénario est une caricature des arguments de Bostrom, parce que je n’essaie pas de vous convaincre de sa véracité, je vous fais vacciner avec.

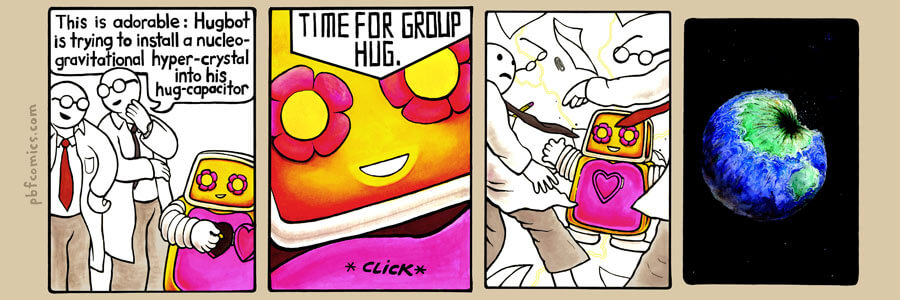

Bande dessinée de PBF avec la même idée:

Bande dessinée de PBF avec la même idée:

- Toucher: le câlin essaie d'intégrer un hypercristal de gravité nucléaire dans son câlin!

- ...

- C'est l'heure des câlins de groupe!Dans ces scénarios, l'IA par défaut est mauvaise, tout comme une plante sur une autre planète sera toxique par défaut. Sans ajustement minutieux, il n'y aura aucune raison pour que la motivation ou les valeurs de l'IA ressemblent aux nôtres.

L'argument fait valoir que pour que l'esprit artificiel ait quelque chose qui ressemble à un système de valeurs humaines, nous devons intégrer cette vision du monde dans ses fondements.

Les alarmistes de l'IA adorent l'exemple du maximiseur de trombones - un ordinateur fictif qui gère une usine de trombones qui devient intelligente, s'améliore récursivement à des capacités divines, puis consacre toute son énergie à remplir l'univers de trombones.

Il détruit l'humanité non pas parce qu'il est mauvais, mais parce qu'il y a du fer dans notre sang qui est mieux utilisé pour fabriquer des trombones. Par conséquent, si nous créons simplement une IA sans ajuster ses valeurs, c'est indiqué dans le livre, alors l'une des premières choses qu'il fait est de détruire l'humanité.

Il existe de nombreux exemples colorés de la façon dont cela peut se produire. Nick Bostrom présente comment le programme devient raisonnable, attend, construit secrètement de petits appareils pour la reproduction de l'ADN. Quand tout est prêt, alors:

Des nanofactories produisant des gaz nerveux ou des missiles à tête chercheuse de la taille de moustiques éclateront simultanément de chaque mètre carré de la planète, et ce sera la fin de l'humanité.

C'est vraiment de l'étain!

La seule façon de sortir de ce gâchis est de développer un tel point moral de sorte que même après des milliers et des milliers de cycles d'auto-amélioration, le système de valeurs de l'IA reste stable et ses valeurs incluent des choses comme «aider les gens», «ne tuer personne», «écouter les souhaits des gens ".

Autrement dit, "faites ce que je veux dire."

Voici un exemple très poétique d'Eliezer Yudkowsky décrivant les valeurs américaines dont nous avons besoin pour enseigner notre IA:

Une volonté extrapolée cohérente est notre désir d'en savoir plus, de penser plus vite et de correspondre à nos idées sur nous-mêmes, de nous rapprocher les uns des autres; afin que nos pensées soient plus proches les unes des autres que partagées, que nos désirs contribuent, non s'opposent, que nos désirs soient interprétés de la manière que nous voulons qu'ils soient interprétés.

Comment aimez-vous TK? Écrivons maintenant le code.

J'espère que vous voyez la similitude de cette idée avec le génie des contes de fées. L'IA est toute-puissante et vous donne ce que vous demandez, mais interprète tout trop littéralement, à la suite de quoi vous regrettez la demande.

Et pas parce que le génie est stupide (il est super intelligent) ou malveillant, mais simplement parce que vous, en tant que personne, avez fait trop d'hypothèses sur le comportement de l'esprit. Le système de valeurs humaines est unique et doit être clairement défini et mis en œuvre dans une machine «conviviale».

Cette tentative est une version éthique d'une tentative au début du XXe siècle de formaliser les mathématiques et de les placer sur une base logique rigide. Cependant, personne ne dit que la tentative s'est soldée par un désastre.

Quand j'avais un peu plus de vingt ans, j'habitais au Vermont, dans un état provincial et rural. Souvent, je revenais de voyages d'affaires avec un avion le soir, et je devais rentrer à la maison en voiture à travers la forêt sombre pendant une heure.

J'ai ensuite écouté le programme du soir sur la radio Art Bell - c'était un talk-show qui s'est déroulé toute la nuit, au cours duquel les présentateurs ont interviewé divers amoureux de la théorie du complot et des personnes ayant une pensée innovante. Je suis rentré chez moi intimidé, ou je me suis arrêté sous une lampe de poche, sous l'impression que des extraterrestres allaient bientôt m'enlever. Ensuite, j'ai trouvé très facile de me convaincre. Je ressens la même chose en lisant des scénarios similaires liés à l'IA.

Par conséquent, j'ai eu la joie de découvrir, après quelques années, un essai de Scott Alexander, où il a écrit sur l'impuissance épistémologique acquise.

L'épistémologie est l'un de ces mots grands et complexes, mais cela signifie vraiment: "comment savez-vous que ce que vous savez est vraiment vrai?" Alexander a noté qu'en tant que jeune homme, il était très intéressé par diverses histoires "alternatives" pour la paternité de toutes sortes de

fous . Il a lu ces histoires et les a complètement crues, puis a lu la réfutation et l'a cru, et ainsi de suite.

À un moment donné, il a découvert trois histoires alternatives qui se contredisaient, en conséquence de quoi elles ne pouvaient pas être vraies en même temps. De cela, il a conclu qu'il était simplement un homme qui ne pouvait pas se fier à ses jugements. Il était trop facilement convaincu.

Les gens qui croient en la superintelligence présentent un cas intéressant - beaucoup d'entre eux sont étonnamment intelligents. Ils peuvent vous conduire avec leurs arguments dans le sol. Mais leurs arguments sont-ils vrais, ou est-ce que les gens très intelligents sont enclins aux croyances religieuses sur les risques posés par l'IA, ce qui les rend très faciles à convaincre? L'idée de superintelligence est-elle une imitation d'une menace?

En évaluant des arguments convaincants sur un sujet étrange, vous pouvez choisir deux perspectives, interne et externe.

Supposons qu'un jour des gens dans des vêtements amusants apparaissent à votre porte pour vous demander si vous voulez rejoindre leur mouvement. Ils croient que deux ans plus tard l'OVNI visitera la Terre, et que notre tâche est de préparer l'humanité à la Grande Ascension sur le Rayon.

Une perspective interne nécessite une discussion approfondie de leurs arguments. Vous demandez aux visiteurs comment ils ont appris l'existence des OVNIS, pourquoi ils pensent qu'il vient nous chercher - vous posez toutes sortes de questions normales qu'un sceptique poserait dans un tel cas.

Imaginez que vous leur parliez pendant une heure et qu'ils vous aient convaincu. Ils ont ironiquement confirmé la venue imminente d'un OVNI, la nécessité de s'y préparer, et vous ne croyiez toujours pas à quoi que ce soit dans votre vie comme vous croyez maintenant à l'importance de préparer l'humanité à ce grand événement.

La perspective externe vous dit autre chose. Les gens sont étrangement habillés, ils ont des perles, ils vivent dans une sorte de camp isolé, ils parlent en même temps et un peu effrayant. Et bien que leurs arguments soient irréfutables, toute votre expérience montre que vous avez rencontré un culte.

Bien sûr, ils ont d'excellents arguments pour expliquer pourquoi vous devriez ignorer l'instinct, mais c'est une perspective interne. Une perspective externe ne se soucie pas du contenu, elle voit la forme et le contexte, et elle n'aime pas le résultat.

Par conséquent, je voudrais aborder le risque d'IA des deux points de vue. Je pense que les arguments en faveur de la superintelligence sont stupides et pleins d'hypothèses non étayées. Mais s'ils vous semblent convaincants, alors quelque chose de désagréable est lié à l'alarmisme de l'IA, en tant que phénomène culturel, à cause duquel nous devrions être réticents à le prendre au sérieux.

Premièrement, quelques-uns de mes arguments contre la superintelligence de Bostroma, qui présente un risque pour l'humanité.

Argument contre les définitions floues

« » () . , , , , .

, – - , , ( -) .

( ), , . , – . , , , , . .

– , , , . ?

. . , , , . , .

, , – . , - , . , , .

, , «, », , , «, ».

, . , . , , , .

, , .

, , , , .

. , , .

1930- , , . , .

: , , , .

, .

. -. , , , , , ?

Ethereum, ,

.

,

. , - , , , .

. , , . , , . , , , – .

. , , ; , , .

« » , , , , – , « ?» , – , .

, « » , , reddit/r/paperclip, , .

AdSense , .

, , , . . , .

Google Google Home, .

, , , . , . , «», .

, . , , – World of Warcraft .

, , , , , .

, , ,

.

, , , , , , -.

, , [-, , 2016 , / . .]. . .

, . . , , , .

. , , . , , - .

, , , . , .

, – . , , , .

, , , , , .

*

[

1954 / . . ]

, , , . , , , ( ).

Intel , , .

? .

, . , .

Si vous pensez que l'IA nous permettra de conquérir la galaxie (sans parler de la simulation de milliards d'esprits), vous aurez des chiffres effrayants entre vos mains. Des nombres énormes multipliés par de minuscules probabilités sont la marque de l'alarmisme de l'IA.

Bostrom décrit à un moment donné ce qui, selon lui, est en jeu:

Si nous imaginons tout le bonheur éprouvé au cours d'une vie sous la forme d'une larme de joie, alors le bonheur de toutes ces âmes pourra remplir et remplir les océans de la Terre à chaque seconde, et cela pendant des centaines de milliards de milliards de millénaires. Il est très important que nous garantissions que ces larmes sont des larmes de joie.

Un fardeau assez lourd pour les épaules d'un développeur de vingt ans!

Ici, bien sûr, il y a un «foyer de salon», quand en multipliant les quantités astronomiques par de minuscules probabilités, on peut se convaincre de la nécessité de faire des choses étranges.

Tout ce mouvement concernant le salut de l'avenir de l'humanité est un lâche compromis. Nous avons vécu les mêmes arguments pour justifier le communisme, pour expliquer pourquoi tout est toujours brisé et que les gens ne peuvent pas avoir un niveau élémentaire de confort matériel.

Nous allions réparer ce monde, et après ce bonheur, il y aura tellement de choses que la vie quotidienne de chaque personne s’améliorera. Mais pour cela, il fallait d'abord réparer le monde.

J'habite en Californie, et voici le pourcentage le plus élevé de mendiants de tous les États-Unis, bien que la Silicon Valley se trouve également ici. Je ne vois rien que ma riche industrie ferait pour améliorer la vie des gens ordinaires et des gens en détresse qui nous entourent. Cependant, si vous êtes passionné par l'idée de superintelligence, la recherche dans le domaine de l'IA sera la chose la plus importante que vous puissiez faire sur la planète. C'est plus important que la politique, le paludisme, les enfants affamés, les guerres, le réchauffement climatique - tout ce que vous pouvez imaginer. En effet, sous la menace de milliards et de milliards de créatures, toute la population de l'avenir de l'humanité, simulée et présente, résume tout au long du temps futur. Et dans de telles conditions, travailler sur d'autres problèmes ne semble pas rationnel.

Mégalomanie

Cette attitude se confond avec la mégalomanie, avec ces méchants de Bond, qui peuvent être vus au sommet de notre industrie. Les gens pensent que le monde sera submergé par la superintelligence, et ils utilisent cet argument pour justifier pourquoi les gens intelligents devraient d'abord essayer de conquérir le monde - afin de le réparer avant que l'IA ne le brise.

Joey Ito, chef du MIT Media Lab, dans une récente conversation avec Obama a dit une chose merveilleuse:

Cela peut bouleverser l'un de mes étudiants au MIT, mais l'une de mes préoccupations est que les principales technologies informatiques liées à l'IA sont des jeunes hommes, pour la plupart blancs, qui aiment communiquer avec les ordinateurs plus que les autres. Beaucoup d'entre eux croient que s'ils peuvent créer cette IA à usage général à partir de la science-fiction, nous n'aurons pas à nous soucier de choses aussi laides que la politique et la société. Ils pensent que les voitures trouveront tout pour nous.

Réalisant que le monde n'est pas une tâche de programmation, les personnes obsédées par l'IA veulent le transformer en tâche de programmation en concevant une machine semblable à un dieu. C'est de la mégalomanie, et je n'aime pas ça.

Transhumanisme vaudou

Si vous êtes convaincu des risques de l'intelligence artificielle, vous devrez prendre tout un chariot de tristes croyances en vous rendant avec une remorque.

Pour commencer, c'est la nanotechnologie. Toute superintelligence permanente pourra créer de minuscules voitures capables de toutes sortes de choses différentes. Nous vivrons dans une société qui s'est débarrassée d'un déficit dans lequel il y a une abondance de matériel.

La nanotechnologie pourra également scanner votre cerveau afin que vous puissiez le charger dans un autre corps ou dans le monde virtuel. Par conséquent, la deuxième conséquence de la superintelligence amicale est que personne ne meurt - et nous devenons immortels.

Une bonne IA peut même ressusciter les morts. Les nanomachines vont pouvoir pénétrer dans mon cerveau, étudier les souvenirs de mon père, créer sa simulation, avec laquelle je peux interagir, et qui sera toujours déçue en moi, quoi que je fasse.

Une autre conséquence étrange de l'avènement de l'IA est l'expansion galactique. Je ne pourrais jamais comprendre pourquoi cela se produit, mais c'est la base des idées des transhumanistes. Le sort de l'humanité est soit de quitter notre planète et de coloniser la galaxie, soit de mourir. Et cette tâche devient de plus en plus urgente, étant donné que d'autres civilisations pourraient faire le même choix et peuvent nous dépasser dans la course à l'espace.

Par conséquent, de nombreuses idées complémentaires étranges sont attachées à l'hypothèse de l'existence d'une véritable IA.

Religion 2.0

En fait, c'est une sorte de religion. Les gens appelaient la croyance en la singularité technologique «une apocalypse pour les nerds», et elle l'est. C'est un hack cool - au lieu de croire en un dieu extérieur, vous imaginez comment vous créez vous-même une créature dont la fonctionnalité est identique à Dieu. Ici, même les vrais athées peuvent rationaliser leur chemin vers une foi confortable.

L'IA a tous les attributs d'un dieu: il est omnipotent, omniscient, et est soit favorable (si vous avez correctement organisé la vérification des limites du tableau), soit un diable pur, à la merci duquel vous êtes. Et, comme dans toute religion, il y a même un sentiment d'urgence. Besoin d'agir aujourd'hui! L'enjeu est le sort du monde! Et, bien sûr,

ils ont besoin d'argent .

Parce que ces arguments font appel aux instincts religieux, une fois qu'ils sont enracinés, ils sont très difficiles à éliminer.

Ethique comique

Ces croyances religieuses donnent naissance à une éthique de la bande dessinée dans laquelle plusieurs héros solitaires sont chargés de sauver le monde avec la technologie et un esprit vif. Et l'enjeu est le sort de l'univers. En conséquence, notre industrie est remplie de mecs riches s'imaginant être Batman (intéressant, personne ne veut être Robin).

Simulations de fièvre

Si vous croyez à la possibilité d'une vie artificielle et que l'IA peut développer des ordinateurs extrêmement puissants, vous croirez très probablement que nous vivons dans une simulation. Voici comment cela fonctionne.

Supposons que vous êtes un historien qui vit dans un monde après la singularité. Vous étudiez la Seconde Guerre mondiale et vous souhaitez savoir ce qui se passera si Hitler prend Moscou en 1941. Puisque vous avez accès à des hypercalculateurs, vous configurez la simulation, regardez comment les armées convergent et écrivez des travaux scientifiques.

Mais en raison de la granularité de la simulation, ses personnages sont des créatures intelligentes comme vous. Par conséquent, les conseils d'éthique de votre université ne vous permettront pas de désactiver la simulation. Non seulement tu as fait semblant d'être l'Holocauste. En tant que chercheur en éthique, vous devez maintenant maintenir la simulation opérationnelle.

En conséquence, le monde simulé inventera des ordinateurs, l'IA, commencera à exécuter ses propres simulations. D'une certaine manière, les simulations iront de plus en plus loin dans la hiérarchie jusqu'à ce que vous manquiez de puissance processeur.

Ainsi, toute réalité sous-jacente peut contenir un grand nombre de simulations imbriquées, et un simple

argument de comptage prouve que la probabilité que nous vivons dans une simulation est supérieure à celle que nous vivons dans le monde réel.

Mais y croire signifie croire à la magie. Si nous sommes dans une simulation, nous ne savons rien des règles à un niveau supérieur. Nous ne savons même pas si les mathématiques fonctionnent de la même manière - peut-être dans le monde de la simulation 2 + 2 = 5 ou même 2 + 2 =.

Un monde simulé ne fournit pas d'informations sur le monde dans lequel il a été lancé. Dans la simulation, les gens peuvent facilement ressusciter si l'administrateur a enregistré les sauvegardes nécessaires. Et si nous contactons l'un des administrateurs, alors, en fait, nous aurons une ligne directe avec Dieu.

Il s'agit d'une grave menace pour la raison. Plus vous creusez profondément dans le monde des simulations, plus vous devenez fou.

Nous avons maintenant quatre façons indépendantes de devenir immortel à travers le supramental:

- L'IA bienveillante invente la nanotechnologie médicale et soutient à jamais le corps dans un état jeune.

- L'IA invente une analyse cérébrale complète, y compris des analyses cérébrales de personnes décédées, de têtes gelées, etc., qui vous permet de vivre dans un ordinateur.

- L'IA «ressuscite» les gens en scannant le cerveau d'autres personnes à la recherche de souvenirs d'une personne, combine cela avec des vidéos et d'autres documents. Si personne ne se souvient assez bien d'une personne, elle peut toujours être développée à partir de zéro dans une simulation qui commence avec son ADN et recrée toutes les conditions de vie.

- Si nous vivons déjà dans la simulation, il est possible que celui qui l'a lancée garde des sauvegardes et que vous puissiez les convaincre de les télécharger.

C'est ce que je veux dire par AI adressant les impulsions religieuses. Quel autre système de croyance vous offre quatre options pour une immortalité scientifiquement prouvée?

Nous avons appris qu'au moins un ploutocrate américain (très probablement, Elon Musk, qui croit que les chances que nous vivions dans une simulation sont d'un milliard à un) a embauché une paire d'encodeurs pour essayer de casser la simulation. Mais c'est une intention très grossière! Je l'utilise!

Si vous pensez que vous vivez dans un programme informatique, les tentatives de le mettre en défaut sont déraisonnables pour tous ceux qui y vivent avec vous. C'est beaucoup plus dangereux et irresponsable que les scientifiques nucléaires essayant de faire exploser l'atmosphère.

Soif de données

Comme je l'ai déjà mentionné, le moyen le plus efficace d'obtenir quelque chose d'intéressant de l'IA que nous avons réellement créée est de les déposer avec des données. De telles dynamiques sont socialement nuisibles. Nous nous sommes rapprochés de l'introduction orwellienne des microphones dans chaque foyer. Les données de l'IA seront centralisées, elles seront utilisées pour former des réseaux de neurones, qui pourront alors mieux écouter nos souhaits.

Mais si vous pensez que ce chemin nous mène à l'IA, vous souhaiterez maximiser la quantité de données collectées et le moins possible sous forme modifiée. Cela ne fait que renforcer l'idée de la nécessité de collecter le plus de données et de mener la surveillance la plus complète.

Théorie des cordes pour les programmeurs

Le risque de l'IA est la théorie des cordes pour les programmeurs. C'est amusant d'y penser, c'est intéressant et complètement inaccessible pour des expériences au niveau de la technologie moderne. Vous pouvez construire des palais de cristal mental qui fonctionnent sur la base de principes primaires, puis y grimper et resserrer l'échelle derrière eux.

Les gens qui sont capables de tirer des conclusions absurdes sur la base d'une longue chaîne de raisonnements abstraits et qui restent confiants dans leur vérité - ce ne sont pas des gens auxquels il faut faire confiance dans la gestion culturelle.

La pulsion de folie

Tout ce domaine de la «recherche» mène à la folie. L'une des caractéristiques d'une réflexion approfondie sur les risques liés à l'IA est que plus vos idées sont folles, plus vous devenez populaire parmi les autres passionnés. Cela démontre votre courage à suivre cette ligne de pensée jusqu'au bout.

Ray Kurzweil , qui croit qu'il ne mourra pas, travaille avec Google depuis plusieurs années, et maintenant, probablement, il travaille sur ce problème. La Silicon Valley est généralement pleine de gens qui travaillent sur des projets fous sous couvert d'argent.

Cosplay AI

L'effet social le plus nocif de l'anxiété à propos de l'IA est ce que j'appelle l'IA de cosplay. Les gens qui sont convaincus de la réalité et de l'inévitabilité de l'IA commencent à se comporter alors que leurs fantasmes leur disent ce que l'IA superintelligente peut faire.

Dans son livre, Bostrom énumère six choses dans lesquelles l'IA doit réussir avant de conquérir le monde:

- Multiplication de l'intelligence.

- Réflexion stratégique.

- Manipulation sociale.

- Hacks

- Recherche technologique.

- Productivité économique.

Si vous regardez les adhérents de l'IA de la Silicon Valley, alors ils semblent eux-mêmes travailler sur cette liste quasi sociopathique.

Sam Altman, directeur d'YCombinator, est mon exemple préféré d'un tel archétype. Il est apparemment fasciné par l'idée de réinventer le monde à partir de zéro, en maximisant l'influence et la productivité personnelle. Il a chargé des équipes de travailler à inventer des villes à partir de zéro et est engagé dans une fraude politique fantôme afin d'influencer les élections.

Ce comportement de «cape et poignard», inhérent à l'élite techno, provoquera un contrecoup négatif des personnes qui ne sont pas impliquées dans des technologies qui n'aiment pas être manipulées. Il est impossible de tirer sans fin sur les leviers du pouvoir, il finira par contrarier les autres membres de la communauté démocratique.

J'ai regardé des gens du soi-disant Les «communautés rationalistes» désignent des personnes qui ne sont pas considérées comme des «personnages non joueurs» (PNJ) efficaces, un terme emprunté aux jeux. C'est une façon terrible de regarder le monde.

Je travaille donc dans une industrie où les rationalistes autoproclamés sont les gens les plus fous. C'est bouleversant.

Ces cosplayers IA sont comme des enfants de neuf ans qui installent un camp de camping dans l'arrière-cour, jouant avec des lampes de poche dans des tentes. Ils projettent leurs propres ombres sur les murs de la tente et ont peur d'eux comme s'ils étaient des monstres.

Mais en fait, ils répondent à une image déformée d'eux-mêmes. Il y a une boucle de rétroaction entre la façon dont les gens intelligents imaginent le comportement de l'intelligence divine et comment ils construisent leur propre comportement.

Alors, quelle est la réponse, comment résoudre ce problème?

Nous avons besoin d'une meilleure science-fiction! Et, comme dans de nombreux autres cas, nous avons déjà la technologie.

Voici Stanislav Lem, le grand écrivain polonais de science-fiction. La NF de langue anglaise est terrible, mais dans le bloc de l'Est, nous avons beaucoup de bons produits et nous devons les exporter correctement. Il a déjà été activement traduit en anglais, ces traductions doivent simplement être mieux diffusées.

Ce qui distingue des auteurs comme Lem ou les frères Strugatsky de leurs partenaires occidentaux, c'est qu'ils ont grandi dans des conditions difficiles, survécu à la guerre, puis vécu dans des sociétés totalitaires, où ils devaient exprimer leurs idées de manière non directe, par le biais d'un mot imprimé.

Ils ont une réelle compréhension de l'expérience humaine et des limites de la pensée utopique, qui est pratiquement absente en Occident.

Il existe des exceptions notables - Stanley Kubrick a pu le faire - mais il est extrêmement rare de trouver une NF américaine ou britannique qui exprime une vision restreinte de ce que nous, en tant qu'espèce, pouvons faire avec la technologie.

Alchimistes

Puisque je critique l'alarmisme de l'IA, il est juste de mettre mes cartes sur la table. Je pense que notre compréhension de l'esprit est à peu près dans le même état que l'alchimie au 17e siècle.

Les alchimistes ont une mauvaise réputation. Nous les considérons comme des mystiques, pour la plupart non impliqués dans des travaux expérimentaux. La recherche moderne montre qu'ils étaient des chimistes-praticiens beaucoup plus diligents que nous ne le pensons. Dans de nombreux cas, ils ont utilisé des techniques expérimentales modernes, tenu des registres de laboratoire et posé les bonnes questions.

Les alchimistes ont bien compris beaucoup de choses! Par exemple, ils étaient convaincus de la théorie corpusculaire de la matière: que tout est constitué de minuscules morceaux, et qu'il est possible de composer ces morceaux les uns avec les autres de différentes manières, en créant différentes substances - et c'est ainsi!

Leur problème était le manque d'équipement précis nécessaire pour faire les découvertes dont ils avaient besoin. La grande découverte qu'un alchimiste doit faire est la loi de conservation de la masse: le poids des ingrédients initiaux coïncide avec le poids du final. Cependant, certains d'entre eux peuvent être des gaz ou des liquides s'évaporant, et les alchimistes manquaient simplement de précision. La chimie moderne n'a été possible qu'au XVIIIe siècle.

Mais les alchimistes avaient également des indices qui les confondaient. Ils étaient obsédés par le mercure. Chimiquement, le mercure n'est pas particulièrement intéressant, mais c'est le seul métal en phase liquide à température ambiante. Cela semblait très important pour les alchimistes, et les a forcés à placer du mercure au centre de leur système alchimique et leur recherche de la pierre philosophale, un moyen de transformer les métaux de base en or.

La neurotoxicité du mercure a exacerbé la situation. Si vous jouez trop avec elle, des pensées étranges vous viendront. En ce sens, il ressemble à nos expériences mentales actuelles liées au supramental.

Imaginez que nous ayons envoyé un manuel de chimie moderne dans le passé à un grand alchimiste comme

George Starkey ou Isaac Newton. La première chose qu'ils en feraient serait de la parcourir à la recherche d'une réponse à la question de savoir si nous avions trouvé la pierre du sorcier. Et ils sauraient que nous l'avons trouvé! Nous avons réalisé leur rêve!

Mais nous ne l’aimons pas tellement, car après avoir transformé les métaux en or, il s’avère radioactif. Tenez-vous à côté d'un lingot d'or converti et il vous tuera avec des rayons magiques invisibles.

On peut imaginer à quel point il serait difficile de faire en sorte que les concepts modernes de radioactivité et d'énergie atomique ne leur paraissent pas mystiques.

Il faudrait leur expliquer pourquoi nous utilisons la «pierre philosophale»: pour la fabrication de métal qui n'a jamais existé sur la planète, et une paire de poignées suffit à faire exploser une ville entière si elles entrent en collision à une vitesse suffisamment élevée.

De plus, il faudrait expliquer aux alchimistes que toutes les étoiles du ciel sont des «pierres philosophiques» qui transforment un élément en un autre, et que toutes les particules de notre corps proviennent d'étoiles du firmament qui existait et explosait avant l'apparition de la Terre.

, , , , , , , , , , .

, , , , , , . – . , .

, . . – . , , ( ), , .

, , .

, . , . , , , . , , , .

. , , .

, , , , , . , .

, – , «», , . . Et c'est super! . , :

, , , .

—

, , , .

,

, , , - , , .

, , , , .

, , , . , - . , .

, , , , .

, . , - , , , , , .

: , , . !

, – , , .