Jesse Bataglia tient son fils Bennett à leur domicile de Ranch Mirage, en Californie. À la recherche d'une nouvelle nounou, Bataglia a commencé à utiliser Predictim, un service en ligne qui utiliserait soi-disant «l'intelligence artificielle avancée» pour évaluer les risques que la nounou soit dépendante de la drogue, se comporte de manière agressive ou fasse preuve de «mauvaises manières».

Jesse Bataglia tient son fils Bennett à leur domicile de Ranch Mirage, en Californie. À la recherche d'une nouvelle nounou, Bataglia a commencé à utiliser Predictim, un service en ligne qui utiliserait soi-disant «l'intelligence artificielle avancée» pour évaluer les risques que la nounou soit dépendante de la drogue, se comporte de manière agressive ou fasse preuve de «mauvaises manières».Lorsque Jesse Bataglia a commencé à chercher une nouvelle nounou pour son fils d'un an, elle voulait obtenir plus d'informations sur l'employée que l'absence de casier judiciaire, les commentaires des parents et les entretiens personnels. Elle s'est donc tournée vers le service en ligne Predictim, utilisant «l'intelligence artificielle avancée» pour évaluer l'identité de la nounou, et a envoyé ses scanners à des milliers de posts sur Facebook, Twitter et Instagram de l'un des candidats.

Le système a introduit une «évaluation des risques» automatique pour une fille de 24 ans, affirmant que le risque de consommer ses drogues était «très faible». Cependant, le système a évalué le risque d'intimidation, d'agression, d'irrespect et de mauvaises manières légèrement plus élevé - de 2 sur 5.

Le système n'explique pas ses décisions. Cependant, Bataglia, qui considérait la nounou comme totalement digne de confiance, a soudainement commencé à douter. "Les médias sociaux montrent l'identité d'une personne", a déclaré Bataglia, maintenant âgée de 29 ans, vivant dans une banlieue de Los Angeles. "Pourquoi le score est-il de 2, pas de 1?"

Predictim offre aux parents les mêmes services que des dizaines d'autres entreprises technologiques dans le monde vendent aux employeurs: des systèmes d'IA qui analysent la parole humaine, les expressions faciales et l'historique de présence en ligne, tout en promettant de révéler les aspects secrets de leur vie personnelle.

La technologie change la façon dont certaines entreprises recherchent les candidats, embauchent et évaluent les travailleurs, offrant aux employeurs une évaluation inégalée des candidats grâce à une nouvelle vague d'évaluations psychologiques invasives et de surveillance.

Fama affirme qu'ils utilisent l'IA pour surveiller les réseaux sociaux des travailleurs afin de détecter tout «comportement toxique» pour alerter leurs patrons. HireVue, une société de technologie de recrutement travaillant avec des entreprises telles que Geico, Hilton et Unilever, propose un système qui analyse automatiquement le ton, le choix des mots et les expressions faciales du candidat lors d'une entrevue vidéo, et prédit leurs compétences et leurs manières (pour offrir de meilleurs résultats, les candidats se voient offrir plus sourire).

Les critiques, cependant, affirment que des systèmes comme Predictim comportent un danger en eux-mêmes, laissant des solutions automatiques qui peuvent changer la vie d'une personne sans aucun contrôle.

Les systèmes dépendent d’algorithmes basés sur des boîtes noires qui ne produisent presque aucun détail sur la façon dont ils ont réduit tous les détails complexes de la vie intérieure d’une personne au calcul de ses côtés positifs et négatifs. Et bien que la technologie Predictim affecte la pensée des parents, elle reste complètement non prouvée, presque inexpliquée et vulnérable aux distorsions perceptuelles liées à la façon dont la bonne nounou devrait se comporter dans les réseaux sociaux, regarder et parler.

Il y a «une course folle pour prendre en charge les capacités de l'IA et prendre toutes sortes de décisions sans aucun type de rapport aux gens», a déclaré Jeff Chester, directeur exécutif du Center for Digital Democracy, un groupe de défense des technologies. «Il semble que les gens se soient enivrés de soda numérique, et ils pensent que c'est une façon normale de gérer nos vies.»

Le processus de scan Predictim analyse l'ensemble du comportement des nounous sur les réseaux sociaux, qui pour bon nombre des plus jeunes nounous peuvent capturer la majeure partie de leur vie. Dans le même temps, les nounous sont informées que si elles refusent de se soumettre à un tel scan, ce sera un sérieux inconvénient dans la compétition pour l'emploi.

Le PDG et cofondateur de Predictim, Sal Parsa, a déclaré que la société, lancée le mois dernier dans le cadre du techno-incubateur de Berkeley à l'Université de Californie à SkyDeck, prend au sérieux les questions éthiques liées à l'utilisation de sa technologie. Il a dit que les parents devraient considérer la notation comme un conseiller, qui "reflète peut-être, et ne reflète peut-être pas les caractéristiques réelles de la nounou."

Il a ajouté que le danger d'embaucher une nounou problématique ou violente fait de l'IA un outil essentiel pour tout parent essayant de protéger son enfant.

"Recherchez sur Google les abus des baby-sitters et vous trouverez des centaines de résultats", a-t-il déclaré. - Il y a des personnes atteintes de maladie mentale ou simplement en colère. Notre objectif est de faire tout ce qui est en notre pouvoir pour les arrêter. »

Le coût de l'analyse de Predictim commence à 24,99 $, et pour elle, vous devez indiquer le nom et l'e-mail de la nounou potentielle, ainsi que d'obtenir son consentement à un large accès à ses comptes sur les réseaux sociaux. La nounou peut refuser, puis les parents reçoivent une notification à ce sujet, et la nounou elle-même reçoit une lettre disant que "le parent qui était intéressé par vous ne pourra pas vous embaucher tant que vous n'aurez pas accédé à la demande".

Les responsables de Predictim disent utiliser des algorithmes pour traiter le langage et les images, la «vision par ordinateur», évaluer les publications de nounou sur Facebook, Twitter et Instagram, et chercher des indices sur sa vie hors ligne. Le rapport n'est reçu que par le parent, qui n'est pas tenu de partager ses résultats avec la nounou.

Les parents peuvent probablement jeter un œil aux comptes publics de nounou sur les réseaux sociaux eux-mêmes. Cependant, les rapports informatiques promettent de donner une évaluation approfondie des années d'activité en ligne, réduite à un seul chiffre: une solution simple et tentante pour une tâche presque impossible.

Les évaluations des risques se répartissent en plusieurs catégories, notamment le contenu manifeste et l'abus de drogues. La startup affirme également dans la publicité que son système est capable d'évaluer d'autres caractéristiques de la personnalité de la nounou, telles que la politesse, la capacité de travailler avec les autres et la «positivité».

La société espère révolutionner l'industrie de plusieurs milliards de dollars de «l'externalisation des responsabilités parentales» et a déjà commencé à faire de la publicité en parrainant des blogs et des sites parentaux pour les «mères». La stratégie marketing se concentre sur l'opportunité déclarée de révéler des secrets et de prévenir le «cauchemar de tout parent», et la publicité cite des affaires pénales, notamment, par exemple, le cas d'une nounou du Kentucky condamnée pour des lésions corporelles graves à un enfant de huit mois.

"Si les parents de cette fille affectée par une infirmière pouvaient utiliser Predictim dans le processus d'approbation des candidats", déclare le communiqué de marketing de l'entreprise, "ils ne la laisseraient jamais seule avec leur précieux enfant."

Cependant, les experts en technologie affirment que le système émet des avertissements tout seul, jouant sur les craintes des parents de vendre les résultats de l'analyse de personnalité avec une précision non vérifiée.

Ils soulèvent également des questions sur la façon dont ces systèmes s'entraînent et sur leur vulnérabilité aux erreurs pouvant résulter des incertitudes liées à l'utilisation des réseaux sociaux par les nounous. Les parents ne reçoivent qu'un avertissement concernant un comportement douteux, sans certaines phrases, liens ou autres détails leur permettant de prendre leur décision.

Lorsqu'une numérisation d'une nounou a émis un avertissement sur une possible persécution de sa part, une mère excitée qui a demandé cette évaluation a dit qu'elle ne pouvait pas savoir si le programme avait remarqué une citation d'un vieux film, d'une chanson ou d'une autre phrase qu'elle avait prise pour des déclarations vraiment dangereuses. .

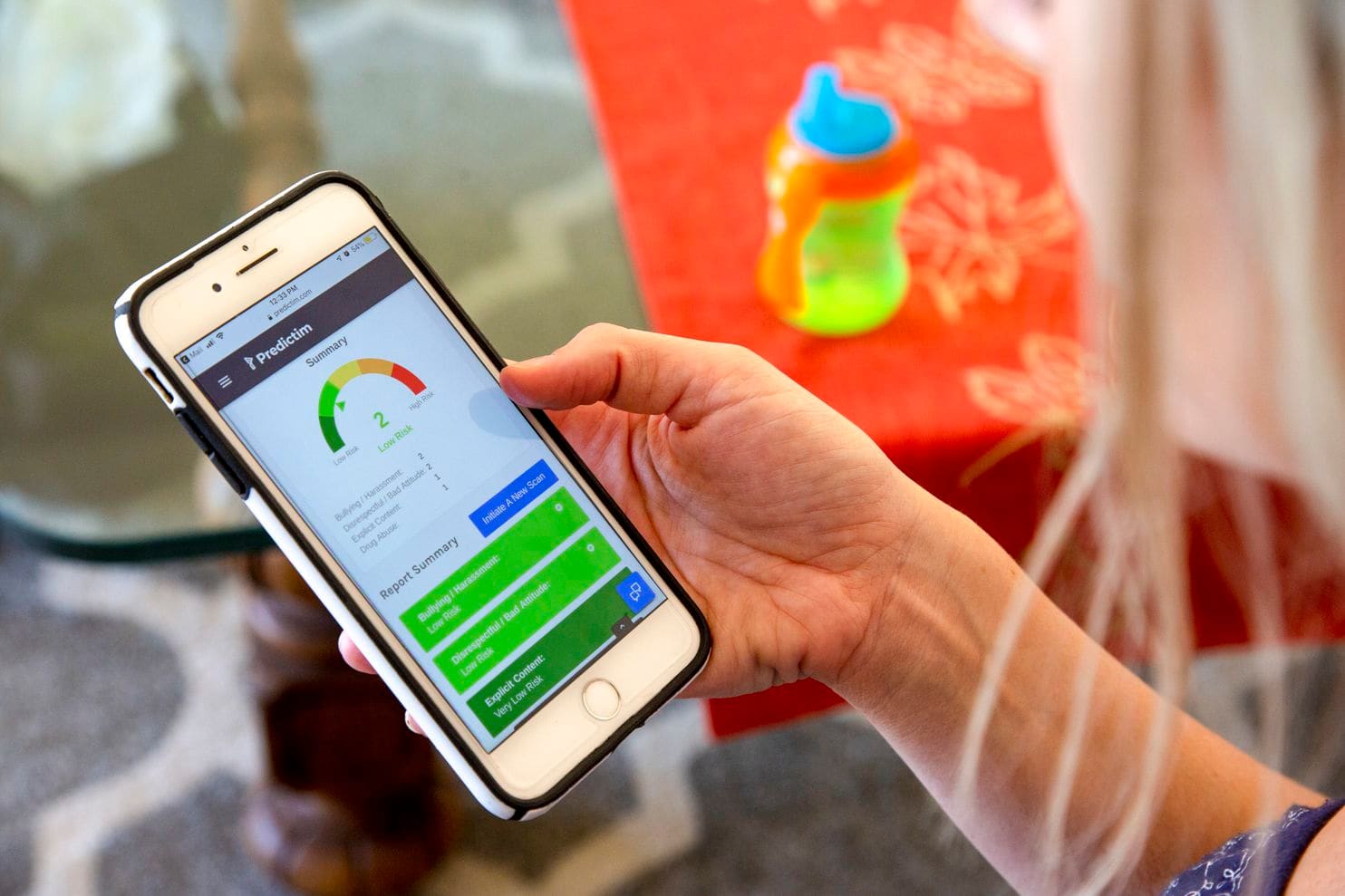

Le téléphone de Jesse montre les résultats de l'application Predictim

Le téléphone de Jesse montre les résultats de l'application PredictimJamie Williams, avocat à l'Electronic Frontier Foundation, un groupe de défense des droits civiques, a déclaré que la plupart des algorithmes utilisés aujourd'hui pour évaluer le sens des mots et des photographies sont connus pour manquer de contexte humain et de bon sens. Même les géants de la technologie comme Facebook ont eu du mal à créer des algorithmes qui pouvaient faire la distinction entre les commentaires anodins et les commentaires en colère.

«Comment pouvez-vous essayer ce système d'évaluation des adolescents: ce sont des enfants! - a déclaré Williams. - Les enfants ont leurs propres blagues, ils sont célèbres pour le sarcasme. "Ce qu'une personne peut penser de l'algorithme comme de" mauvaises manières "peut être considéré comme une déclaration politique ou une critique légitime."

Et quand le système est mauvais - disons, en disant que la nounou abuse de drogues - les parents ne pourront pas découvrir l'erreur. Des cotes et des évaluations claires de l'exactitude du système peuvent inciter les parents à en attendre beaucoup plus d'exactitude et d'autoritarisme qu'une personne à sa place ne pourrait le promettre. En conséquence, les parents seront enclins à embaucher des nounous qu'ils éviteraient autrement ou à s'éloigner des personnes qui ont déjà gagné leur confiance.

"Il n'y a pas de métrique qui puisse dire avec précision si ces méthodes sont aussi efficaces dans leurs prévisions que les créateurs le déclarent", a déclaré Miranda Bogen, analyste en chef du groupe de réflexion d'Upturn à Washington, qui étudie l'utilisation d'algorithmes pour la prise de décision et l'arbitrage automatiques. . "L'attrait de ces technologies est susceptible de dépasser leurs capacités réelles."

Malissa Nielsen, une nounou de 24 ans qui travaille pour Bataglia, a récemment donné à deux autres familles l'accès à leurs réseaux sociaux pour une évaluation chez Predictim. Elle a dit qu'elle était toujours prudente sur les réseaux sociaux et a décidé qu'elle pouvait partager des informations supplémentaires sans se nuire. Elle va à l'église chaque semaine, ne jure pas et finit de recevoir la formation d'un enseignant dans le domaine de l'enseignement aux jeunes enfants, après quoi elle espère ouvrir un jardin d'enfants.

Cependant, ayant appris que le système ne lui donnait pas de notes idéales basées sur le manque de respect et l'intimidation, elle a été étonnée. Elle croyait que permettre aux parents d'étudier sa présence sur les réseaux sociaux, et non l'algorithme - une analyse critique de sa personnalité. Elle n'a pas non plus été informée des résultats d'un test qui pourrait potentiellement endommager sa seule source de revenus.

«Je voudrais comprendre un peu ce problème. Pourquoi ce programme a-t-il pensé à moi comme ça? - dit Nielsen. "L'ordinateur n'a aucun sentiment, il ne peut pas détecter tout cela."

Les Américains ne font toujours pas confiance aux algorithmes dont les décisions peuvent affecter leur vie quotidienne. Dans un sondage du Pew Research Center ce mois-ci, 57% des répondants ont jugé le traitement automatique des curriculum vitae des candidats à un emploi «inacceptable».

Néanmoins, Predictim rapporte qu'ils se préparent à étendre le travail dans tout le pays. Les dirigeants de Sittercity, un service de baby-sitter en ligne visité par des millions de parents, envisagent de lancer un programme pilote qui intégrera les évaluations automatiques de Predictim dans l'ensemble actuel des évaluations automatiques et des contrôles de service.

"Trouver une nounou est semé d'incertitudes", a déclaré Sandra Dainora, chef de produit chez Sittercity, qui estime que ces outils peuvent bientôt devenir la norme dans les recherches en ligne pour les soignants. «Les parents sont constamment à la recherche de la meilleure solution, de la recherche la plus complète, des faits les plus fiables.»

Les managers de Predictim pensent également qu'ils peuvent sérieusement étendre les capacités du système et proposer des évaluations encore plus personnelles de la vie privée de la nounou. Joel Simonov, directeur de la technologie, a déclaré que l'équipe souhaitait obtenir des "données psychométriques utiles" basées sur l'analyse de l'activité des nounous dans les réseaux sociaux, en passant leurs histoires à travers un test d'identité, par exemple, la typologie Myers-Briggs, pour fournir ces résultats aux parents.

L'exploration des médias sociaux et l'intérêt de Predictim pour l'analyse psychologique de masse sont similaires aux ambitions de Cambridge Analytica, une société de conseil politique qui a travaillé pour soutenir la campagne électorale de Trump, puis a engagé Facebook dans un scandale d'identité mondial. Cependant, les dirigeants de Predictim affirment avoir établi des contrôles de sécurité internes et s'efforcent de protéger les données personnelles des nounous. "Si nous avions une fuite de données de nounou, ce ne serait pas cool", a déclaré Simonov.

Les experts craignent que les systèmes de notation basés sur l'IA présagent un avenir dans lequel la réception par une personne de tout emploi non nécessairement lié à la garde d'enfants dépendra de la machine. De nombreuses sociétés de recrutement et de recrutement créent déjà ou investissent dans des systèmes capables d'analyser les curriculum vitae des candidats à grande échelle et d'émettre des évaluations automatiques des candidats. Des systèmes d'IA similaires - y compris Jigsaw, un incubateur technologique créé par Google - sont utilisés pour suivre les commentaires en ligne concernant le harcèlement, les menaces et la cruauté.

Cependant, il a déjà été démontré plus d’une fois comment les algorithmes de recherche d’employés masquent des défauts qui peuvent ruiner la carrière d’une personne. Amazon.com a arrêté le développement de l'algorithme d'embauche, apprenant qu'il sous-estime illégalement les femmes, car l'historique d'embauche de l'entreprise, qui suit la tendance de l'industrie technologique à embaucher des hommes, a enseigné au système à préférer les candidats masculins. L'entreprise a déclaré qu'elle n'avait jamais utilisé ce programme pour évaluer les candidats.

Certains experts en intelligence artificielle pensent que ces systèmes ont la capacité de gonfler sérieusement les préjugés liés à l'âge ou à la race, par exemple en marquant des mots ou des photos importants de certains groupes de personnes plus souvent que d'autres. Ils craignent également que Predictim n'oblige les jeunes nounous à partager leurs données personnelles juste pour obtenir un emploi.

Cependant, Diana Werner, mère de deux enfants vivant dans une banlieue de San Francisco, estime que les nounous devraient volontairement partager des informations personnelles pour rassurer leurs parents. "La vérification de la biographie est une bonne chose, mais Predictim étudie la question en profondeur, disséquant l'individu - son statut social et intellectuel", a-t-elle déclaré. Où elle habite, «100% des parents voudront utiliser un tel service», a-t-elle ajouté. "Nous voulons tous obtenir la nounou parfaite."