Au cours des vingt dernières années, les centres de données apparaissent comme des champignons après la pluie, ce qui est compréhensible. En plus des indicateurs quantitatifs, des indicateurs qualitatifs se développent également - de nouvelles formes, de nouvelles approches pour construire l'environnement. L'une de ces innovations est devenue des centres de données modulaires. Pour la première fois, les militaires ont pu évaluer l'efficacité de solutions basées sur un conteneur standardisé, ce sont eux qui ont été les premiers à utiliser des centres de données construits sur une base modulaire. Le déploiement rapide de la puissance de calcul et la capacité de stocker des données dans les coins les plus reculés de la terre sont devenus une panacée pour les militaires dans le monde avec un volume croissant d'informations générées quotidiennement. Grâce à Sun Microsystems, déjà en 2006, des centres de données modulaires sont devenus accessibles aux consommateurs civils. Mais il semblerait, qui va les acquérir? Dans les conditions de la lutte acharnée des acteurs du marché informatique pour des performances matérielles élevées, les avantages de la modularité des datacenters, dans la plupart des cas de la vie civile, sont impitoyablement biffés par tout un éventail de désavantages générés par cette modularité même. Mais comme le temps l'a montré, tout n'est pas si clair sur ce sujet et le produit a trouvé son consommateur. Le CERN est l'un de ces consommateurs, aussi surprenant soit-il. L'idée originale de l'organisation est un grand collisionneur de hadrons, envahi par quelques nouveaux centres de données modulaires. Une décision très étrange? Ceci et non seulement sera discuté plus loin.

Le conteneur - tout ingénieux est simple!

Le conteneur - tout ingénieux est simple!À notre connaissance, cette idée a d'abord été mise en œuvre avec un conteneur par les militaires - pour remplir un cadre métallique avec des racks de serveurs, y intégrer un système de refroidissement, et voici une solution toute faite. Mais avec tout l'utilitarisme d'un tel conteneur de données, se posent des questions de flexibilité et d'efficacité du fonctionnement de son remplissage. La quantité de matériel standard installé correspond aux tâches effectuées, car le retard de personnalisation des racks de serveur y est très limité. D'une part, le facteur de forme du conteneur ne permet pas à l'administrateur réseau de s'y déployer, au propre comme au figuré. En revanche, remplacer le remplissage par un plus puissant peut corrompre les systèmes de conteneurs auxiliaires: alimentation en énergie, refroidissement. Même avec la possibilité d'augmenter facilement les capacités de sa structure de serveur par la méthode de livraison d'un autre conteneur, le problème de l'augmentation de l'efficacité d'un rack particulier dans le module ne peut être résolu en aucune façon, ce qui limite considérablement la portée de cette conception.

Le CERN choisit un centre de données modulaire«Jusqu'à la fin de 2019, nous prévoyons d'installer deux nouveaux centres de données, dont chacun desservira exclusivement son propre détecteur LHC. Le détecteur lié à l'expérience LHCb se verra attribuer six modules; le détecteur d'expérience ALISA desservira un centre de données de quatre conteneurs. La nécessité d'agrandir l'infrastructure existante est due à la modernisation de ces détecteurs. Après la mise à niveau, la quantité de données générées par les détecteurs augmentera considérablement », a déclaré Niko Neufeld, directeur adjoint de l'un des projets du CERN.

Le CERN choisit un centre de données modulaire«Jusqu'à la fin de 2019, nous prévoyons d'installer deux nouveaux centres de données, dont chacun desservira exclusivement son propre détecteur LHC. Le détecteur lié à l'expérience LHCb se verra attribuer six modules; le détecteur d'expérience ALISA desservira un centre de données de quatre conteneurs. La nécessité d'agrandir l'infrastructure existante est due à la modernisation de ces détecteurs. Après la mise à niveau, la quantité de données générées par les détecteurs augmentera considérablement », a déclaré Niko Neufeld, directeur adjoint de l'un des projets du CERN.

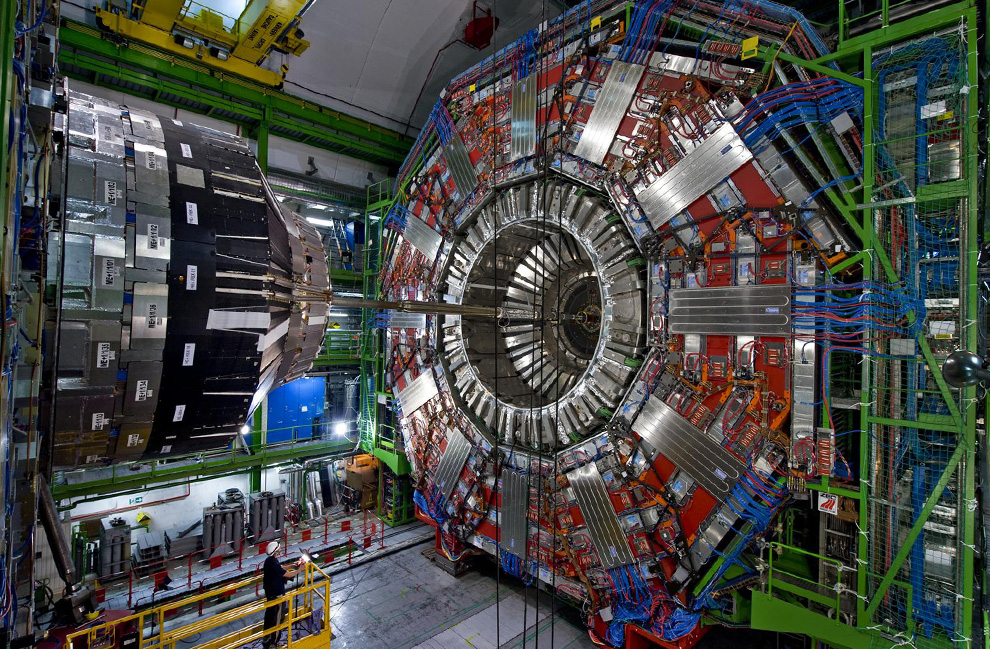

LHC (Large Hadron Collider) - un projet sous les auspices du CERN, c'est une structure colossale qui est située à une profondeur d'environ 100 mètres au cœur de l'Europe occidentale, sur le territoire de deux États - la France et la Suisse. Avec un diamètre de 8,5 km et une longueur d'environ 27 km, il est difficile de reprocher au LHC son éloignement de la civilisation. Le projet lui-même est essentiellement le cœur de la science moderne, le moteur de sa composante fondamentale. En outre, l'infrastructure informatique existante au service du LHC répond à toutes les normes modernes, y compris les centres de données et les routes de fibre optique, qui la combinent avec le monde entier. Quel était l'intérêt de la décision des scientifiques nucléaires européens du CERN d'augmenter la capacité de l'infrastructure informatique grâce à des centres de données modulaires?

À l'heure actuelle, les besoins du collisionneur sont directement satisfaits par cinq centres de données. Parmi ceux-ci, quatre sont affectés aux quatre capteurs principaux de chacune des principales expériences: ATLAS, CMS, ALISA et LHCb. Le cinquième centre de données est le plus grand - il est le centre central de traitement et de stockage des données collectées dans l'ensemble du complexe scientifique du LHC.

"Pour le moment, le détecteur central desservant l'expérience LHCb enregistre les événements qui s'y produisent avec une fréquence de 1 MHz, après modernisation, la fréquence de fixation augmentera de 40 fois et imaginera 40 000 000 d'enregistrements par seconde", a poursuivi Nico.Il n'est pas surprenant que les temps nouveaux nécessitent un nouvel équipement. Une augmentation du flux de données est une tendance répandue et il n'y a rien à s'étonner de la modernisation de l'infrastructure réseau, mais pourquoi des datacenters modulaires? La réponse ne tarda pas à venir.

«Il s'agit d'une économie nette. Les spécificités des détecteurs sont des salves volumétriques à court terme de génération de données. La quantité de données générées par ces rafales est connue avec une très grande précision, nous savons donc exactement combien d'espace disque pour le stockage de données nous avons besoin et cette quantité sera pertinente jusqu'à la phase extrême de l'expérience. De plus, en plaçant les modules serveurs aussi près que possible des capteurs, nous avons réduit la longueur des communications par fibre optique nécessaires pour transférer 30 PB de données en peu de temps, le coût de la mise en place de telles communications est très impressionnant. “- a expliqué Nico.Selon le schéma décrit par l'employé du CERN, la situation concernant le choix des infrastructures a commencé à devenir plus claire. L'énorme flux de données généré par les capteurs du LHC atteindra les centres de traitement et de stockage des données primaires dans les plus brefs délais, après quoi, en attendant le prochain démarrage du capteur, les informations collectées iront progressivement au centre de données central sans surcharger l'infrastructure réseau existante.

La vie après HiggsEn fait, toute cette structure mégalithique, le LHC, a été créée dans le but de révéler / réfuter l'existence du bassin de Higgs. En 2013, des signes indirects d'existence ont été découverts et le problème initial a été résolu. Un an et demi de temps d'arrêt des collisionneurs a été nécessaire aux employés du CERN pour moderniser les détecteurs existants, ce qui pourrait résoudre des problèmes déjà nouveaux. Cependant, pas plus de trois ans ne se sont écoulés depuis la date du nouveau lancement et pour le moment où le LHC attend une nouvelle modernisation, la fermeture du collisionneur devrait durer de 2019 à 2021.

Comme nous le voyons ici, la situation est que cela n'a pas de sens de surcharger le projet avec une infrastructure lourde et stationnaire, car après une courte étape de collecte de données statistiques, il y a de très fortes chances qu'il disparaisse tout simplement. Comme le montre la pratique, les nouveaux projets nécessiteront toujours de nouvelles infrastructures et d'autres équipements impliqués. Les modules installés maintenant peuvent toujours être facilement déplacés vers un autre endroit où leur utilisation sera plus rationnelle.

«Désormais, le capteur du projet LHDb est entretenu par un serveur situé juste à côté - souterrain. Deux facteurs nous ont empêchés de moderniser ce site: l'espace limité par le donjon et les problèmes causés par l'impossibilité de refroidir efficacement le serveur », a expliqué Nico.

La salle des serveurs existante, qui a été mentionnée par un employé du centre scientifique, est située à une profondeur de 100 mètres, aux moments de charge de pointe sur les serveurs, la quantité de chaleur générée par eux crée le besoin de fournir du liquide de refroidissement chauffé à la surface, où il peut transférer l'excès de chaleur dans l'atmosphère puis retourner au fond .

Des coûts élevés de refroidissement des serveurs dans les modules ne sont clairement pas attendus. Compte tenu du climat frais des contreforts alpins, PUE - le coefficient d'efficacité du système de refroidissement sera inférieur à 1,1 (seulement 10% de l'énergie consommée par l'équipement serveur ira à son refroidissement).

Jusqu'en mars 2019, les dix modules devront prendre leur place dans la conception. Vers la fin de l'année, des lignes de fibre optique seront acheminées vers les centres de données, seulement après que l'infrastructure sera fonctionnelle. Cependant, elle pourra faire ses preuves en affaires au plus tôt trois ans plus tard. Le premier lancement du plus grand collisionneur de hadrons, après la modernisation, est déjà prévu en 2021.

"Mais la chose la plus inhabituelle au sujet de nos nouveaux centres de données est que nous ne leur fournirons pas de courant de secours. Au cours des 6 années de travail dans le centre scientifique, nous n'avons jamais connu de panne de courant d'urgence », résume Nico Newfield.

Merci de rester avec nous. Aimez-vous nos articles? Vous voulez voir des matériaux plus intéressants? Soutenez-nous en passant une commande ou en le recommandant à vos amis, une

réduction de 30% pour les utilisateurs Habr sur un analogue unique de serveurs d'entrée de gamme que nous avons inventés pour vous: Toute la vérité sur VPS (KVM) E5-2650 v4 (6 cœurs) 10 Go DDR4 240 Go SSD 1 Gbps à partir de 20 $ ou comment diviser le serveur? (les options sont disponibles avec RAID1 et RAID10, jusqu'à 24 cœurs et jusqu'à 40 Go de DDR4).

VPS (KVM) E5-2650 v4 (6 cœurs) 10 Go DDR4 240 Go SSD 1 Gbit / s jusqu'en janvier gratuitement en payant pour une période de six mois, vous pouvez commander

ici .

Dell R730xd 2 fois moins cher? Nous avons seulement

2 x Intel Dodeca-Core Xeon E5-2650v4 128 Go DDR4 6x480 Go SSD 1 Gbps 100 TV à partir de 249 $ aux Pays-Bas et aux États-Unis! Pour en savoir plus sur la

création d'un bâtiment d'infrastructure. classe utilisant des serveurs Dell R730xd E5-2650 v4 coûtant 9 000 euros pour un sou?