Un chercheur en apprentissage automatique du Virginia Institute of Technology a proposé un moyen d'examiner les articles scientifiques à l'aide de l'IA, en évaluant l'apparence du texte et des graphiques dans un document. Ses méthodes d'évaluation de la «complétude» des travaux scientifiques seront-elles suffisantes pour accélérer le processus d'examen indépendant par les pairs?

Dans le domaine de l'apprentissage automatique, il y a une avalanche de recherches. L'ingénieur de Google Cliff Young a comparé cette situation à

la loi de Moore , adaptée aux publications sur le sujet de l'IA - le nombre d'articles universitaires sur ce sujet apparaissant sur le site Web arXiv double tous les 18 mois.

Et cette situation crée des problèmes lors de l'examen des travaux - des chercheurs expérimentés dans le domaine de l'IA ne sont tout simplement pas suffisants pour lire attentivement chaque nouveau travail. Les scientifiques peuvent-ils confier à l'IA l'acceptation ou le rejet d'emplois?

Cette question intéressante est soulevée par un

rapport récemment publié sur le site Web arXiv; auteur de l'ouvrage, le chercheur en apprentissage automatique Jia-Bin Huang l'a appelé «Deep Work Gestalt».

Juan a utilisé un réseau de neurones convolutionnels, un outil d'apprentissage automatique commun utilisé pour la reconnaissance d'images, pour passer au crible 5000 œuvres publiées depuis 2013. Juan écrit que, selon une seule apparence de l'œuvre - un mélange de texte et d'images - son réseau de neurones peut distinguer un «bon» travail digne de figurer dans les archives scientifiques avec une précision de 92%.

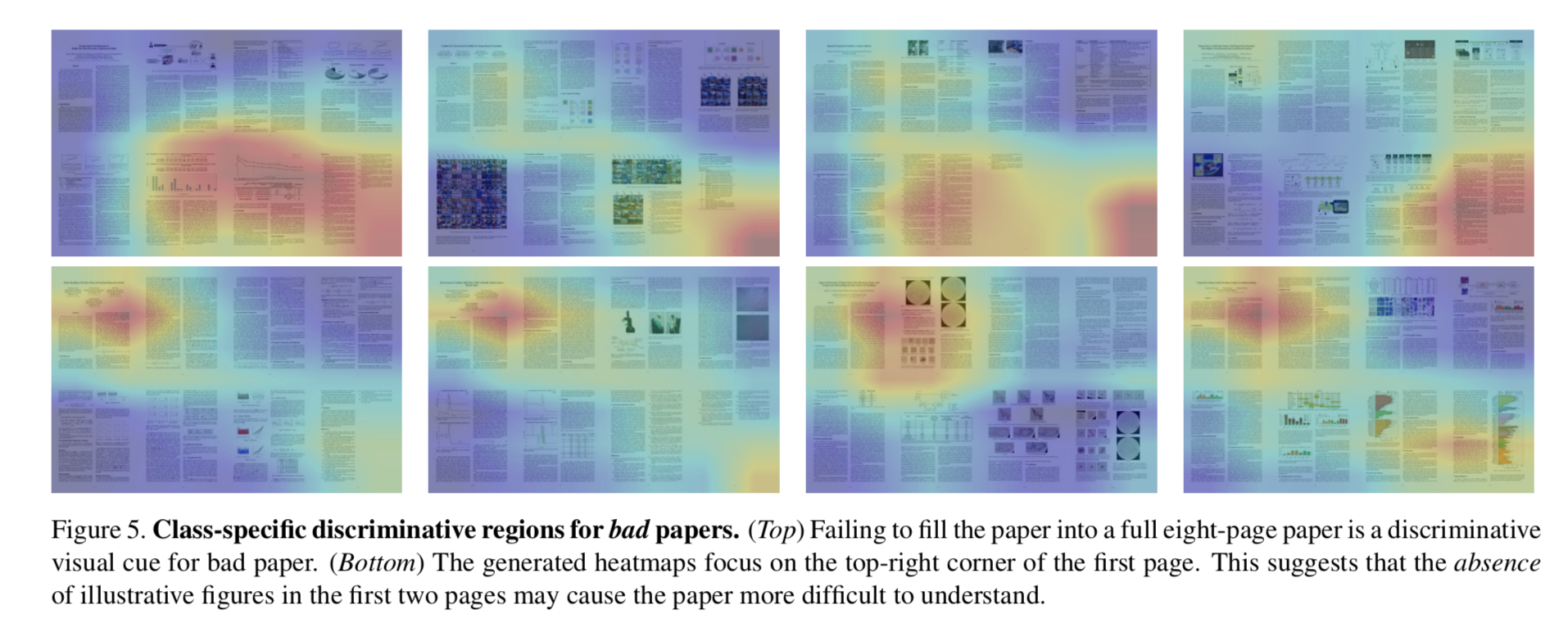

Pour les chercheurs, cela signifie que dans l'apparence de leur document, deux éléments jouent le rôle le plus important: des images lumineuses sur la première page du document de recherche et le remplissage de toutes les pages avec du texte, de sorte qu'il n'y ait pas d'espace vide à la fin de la dernière page.

Le réseau neuronal convolutif de Juan digère des milliers d'articles scientifiques approuvés et non approuvés, créant une «carte thermique» des forces et des faiblesses. Les plus grosses erreurs des œuvres qui n'ont pas réussi la sélection: le manque d'images en couleur et un espace vide en fin de dernière page.

Juan fonde son travail sur un autre ouvrage de 2010, rédigé par Carven von Bearnensquash de l'Université de Phoenix. Le travail n'a pas utilisé de formation approfondie, la technologie traditionnelle de la vision par ordinateur, pour trouver un moyen «d'évaluer d'un coup d'œil l'apparence générale» du travail et de conclure s'il valait la peine d'approuver le travail.

En utilisant cette idée, Juan a alimenté l'ordinateur 5618 œuvres, prises lors de deux grandes conférences sur la vision par ordinateur, CVPR et ICCV au cours des cinq dernières années. Juan a également collecté des œuvres présentées lors d'ateliers de conférence, qui ont joué le rôle d'œuvres rejetées - car il n'y a pas d'accès aux œuvres rejetées lors de conférences.

Juan a formé le réseau à associer le travail passé et non passé au résultat binaire du «bon» et du «mauvais» afin d'isoler les signes de «complétude» ou de gestalt. La Gestalt est un tout qui dépasse la taille de la somme de ses parties. C'est ce que le pionnier de l'apprentissage automatique, Terry Seinowski, a appelé «la perception organisée universelle», quelque chose de plus significatif que les collines et les ravins de la région à proximité de vous.

Le réseau formé a ensuite été testé sur un sous-ensemble des emplois qu'il n'avait pas vu auparavant. La formation a équilibré les faux positifs - un travail accepté qui valait la peine d'être rejeté - avec de faux dénis, un travail rejeté qui valait la peine d'être accepté.

En limitant le nombre d'emplois «bons» mais rejetés, 0,4%, c'est-à-dire seulement 4 emplois, le réseau a pu rejeter correctement la moitié des «mauvais» emplois qui devaient être rejetés.

L'auteur a même pensé à nourrir son propre travail de son propre réseau neuronal. En conséquence, le réseau neuronal l'a rejeté: «Nous avons appliqué un classificateur qualifié à ce travail. Notre réseau a impitoyablement prédit qu'avec une probabilité de 97%, ce travail devrait être rejeté sans examen indépendant. »

En ce qui concerne ces exigences cosmétiques - de belles images dans l'article - Juan ne décrit pas seulement les résultats du travail. Il propose également du code qui vous permet de créer de beaux travaux. Il alimente le «bon» travail dans la base de données de formation du réseau génératif-compétitif, qui peut créer un nouveau plan, en s'appuyant sur des exemples.

Juan propose également un troisième composant, «refaire» le travail rejeté en un travail acceptable, «donner automatiquement des conseils sur ce qui doit être changé dans le travail entrant», par exemple, «ajouter une image pour attirer l'attention et une image sur la dernière page».

Juan suggère qu'un tel processus d'approbation des emplois pourrait être un «préfiltre» pour alléger le fardeau des examinateurs, car il peut afficher des milliers d'emplois en quelques secondes. Et pourtant, «il est peu probable qu'un tel classifieur soit utilisé lors d'une véritable conférence», conclut l'auteur.

L'une des limites de l'œuvre qui peut affecter son utilisation est que même si l'apparence de l'œuvre, sa gestalt visuelle, coïncide avec des résultats historiques, cela ne garantit pas l'existence d'une valeur réelle dans l'œuvre.

Selon Juan, "en ignorant le contenu du travail, nous pouvons injustement rejeter un travail avec un bon matériel et une mauvaise conception visuelle, ou accepter un travail sans valeur qui semble bon."