Il s'agit de la deuxième partie d'une introduction à Kubernetes pour les utilisateurs de VMware. Avant de passer à la partie pratique, lisez l'article précédent

ici .

GCP (Google Cloud Platform) est le moyen le plus simple et le plus rapide de découvrir Kubernetes sans aucune exigence particulière. Obtenez simplement un

accès de test et apprenez Kubernetes. Pour confirmer l'inscription, vous devez fournir des informations sur une carte de crédit. GCP ne déduira rien tant que vous n'aurez pas activé le paiement vous-même. Créez un compte et nous continuerons d'explorer le monde fascinant de Kubernetes.

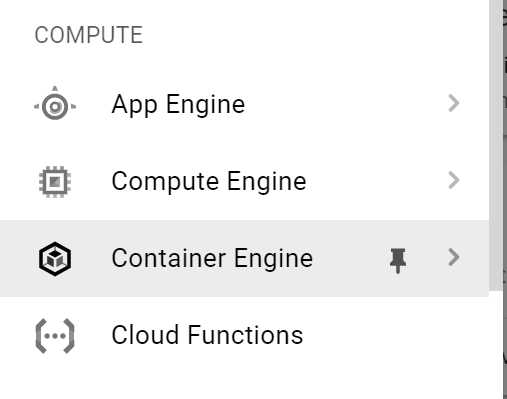

La première étape consiste à se connecter à GKE (Google Kubernetes Engine). Dans le menu de gauche, sélectionnez

Container Engine .

Cliquez sur

Créer un cluster.

Remplissez les champs:

- nom du cluster;

- zone d'accès

- version de Kubernetes;

- détails de l'image, etc.

Le cluster sera créé dans quelques minutes. Lorsque vous êtes prêt, cliquez sur Connecter. Une commande de connexion apparaît. Nous allons l'utiliser. Copiez-le.

Le moyen le plus simple de se connecter au cluster est via le

shell Google Cloud .

Dans le coin supérieur droit, cliquez sur l'icône de coque.

Après quelques secondes, le shell commencera sur la même page. Collez la commande que vous avez copiée à l'étape précédente.

Voyons maintenant les informations sur notre cluster à l'aide de la commande

kubectl cluster-info .

Pour obtenir des informations sur les nœuds, entrez la commande

kubectl get no -o wide. Vous verrez une liste de nœuds avec des informations à leur sujet.

Nous obtenons maintenant une liste de tous les pods qui fonctionnent dans notre cluster K8s. Entrez la commande

kubectl get po -o wide –all-namespaces .

Maintenant, connectons-nous aux nœuds du cluster pour connaître leurs paramètres réseau. Pour ce faire, cliquez à nouveau sur le menu principal à gauche et sélectionnez

Compute Engine dans la liste déroulante. Comme vous pouvez le voir sur la capture d'écran ci-dessous, le cluster k8s est finalement le nombre de machines virtuelles.

Cliquez sur

SSH pour démarrer une session avec le nœud sélectionné. Une nouvelle boîte de dialogue apparaîtra. Assurez-vous que votre navigateur ne bloque pas les fenêtres contextuelles.

Vérifiez quelle distribution Linux est utilisée. Pour ce faire, tapez

uname -a , puis

cat / etc / lsb-release .

Vérifions maintenant les paramètres réseau à l'aide de

ifconfig -a | plus . Voir l'

interface du pont

cbr0 ? C'est celui que nous avons montré dans le schéma de réseau ci-dessus.

Ici, nous voyons également le réseau / 24 alloué à ce nœud - 10.40.1.0/24. De là, nos pods obtiennent leurs adresses IP. Vous pouvez maintenant corréler le schéma de réseau ci-dessus avec la configuration réelle sur les nœuds du cluster k8s. Cool, non?

Revenons maintenant à la fenêtre Google Cloud Shell et essayons de déployer une application de test. Drive dans

git clone https://github.com/hanymichael/NSX-CNA-Lab.git .

Avec cette commande, vous clonerez une de mes applications de test sur GitHub. Allez maintenant dans le dossier d'application et tapez

kubectl create -f. afin que tous les fichiers YAML soient créés dans ce dossier.

Nous allons maintenant afficher la liste des pods et voir leur statut. On peut voir que tout le monde a le statut de

ContainerCreating . Après quelques secondes, l'état passe à

En cours d'

exécution .

Il y a deux déploiements de mon application Web dans K8, chacun avec 4 répliques.

Vérifions maintenant les services associés à ce déploiement avec la commande

kubectl get svc .

La dernière chose à vérifier est l'entrée associée à cette application. La capture d'écran ci-dessus montre que nous nous connectons à l'application via une IP externe. Si nous vérifions la section avec l'équilibreur, nous verrons l'équilibreur de charge associé à l'entrée.

Si vous souhaitez accéder à l'application elle-même, vous pouvez créer un enregistrement DNS pour * .esxcloud.net dans le fichier hôte local.

Ouvrez maintenant un nouvel onglet dans le navigateur et suivez les liens

sphinx-v1.esxcloud.net et

sphinx-v2.esxcloud.net . Nous verrons deux choses:

- la version de l'application est indiquée sur chaque lien;

- après la mise à jour de la page Web, l'adresse IP du conteneur change, ce qui signifie que l'équilibreur fonctionne.

Vous pouvez maintenant corréler la configuration de l'application avec le diagramme ci-dessous et voir à quoi tout cela ressemble dans Kubernetes.

Conclusion

Nous avons vu que Kubernetes, comme tout système distribué, présente de nombreuses similitudes (et quelques différences) avec vSphere, qui nous est familier en tant qu'utilisateurs VMware. J'ai essayé d'expliquer les concepts de base en comparant K8s et vSphere. J'espère que cela vous aidera à découvrir rapidement cette plate-forme cloud incroyablement puissante qui conquiert déjà le monde.

Dans les articles suivants, je vais commencer à approfondir le développement de notre solution d'entreprise pour lancer Kubernetes à l'intérieur du centre de données. Suivez l'actualité!

PS: Vous pouvez également tester les fonctionnalités de Kubernetes dans notre service

KuberLine , après avoir émis un essai routier.