Les disques SSD sont depuis longtemps sortis de la catégorie des exotiques coûteux et peu fiables et sont devenus une composante familière des ordinateurs de tous niveaux, des "machines à écrire" de bureau économiques aux serveurs puissants.

Dans cet article, nous voulons parler d'une nouvelle étape dans l'évolution des SSD - la prochaine augmentation du niveau d'enregistrement de données dans NAND: environ quatre cellules de niveau avec 4 bits

chacune , ou

QLC (Quad-Level Cell). Les périphériques de stockage fabriqués à l'aide de cette technologie ont

une densité d'enregistrement plus élevée, ce qui simplifie l'augmentation de leur volume et le coût est inférieur à celui des SSD avec des cellules MLC et TLC «traditionnelles».

Comme prévu, dans le processus de développement, il a fallu résoudre de nombreux problèmes liés à la transition vers une nouvelle technologie. Les entreprises géantes y font face avec succès, et les petites entreprises chinoises sont toujours à la traîne, leurs moteurs sont moins technologiques, mais moins chers.

Comment cela s'est produit, si un nouveau «tueur de disque dur» est apparu et s'il était nécessaire de courir dans les magasins, en changeant tous les disques durs et SSD des générations précédentes pour de nouveaux - nous le dirons ci-dessous.

Au cours de l'évolution des dispositifs de stockage, le mode de stockage des informations a changé, le processus de fabrication est devenu de plus en plus délicat, et la densité d'enregistrement dans une seule cellule et sur une puce a augmenté. Les contrôleurs ont amélioré leurs algorithmes, la vitesse d'écriture s'est approchée de la vitesse de lecture, puis ils ont commencé à croître rapidement. Aujourd'hui, l'uniformité de la distribution des appels vers les cellules de mémoire NAND a atteint un certain optimum, la fiabilité du stockage des informations a augmenté de nombreuses fois et a presque égalé celle des disques durs traditionnels. Au cours du développement rapide de la technologie, les disques SSD ont commencé à être délivrés dans une variété de facteurs de forme.

Maintenant, sur le marché, il existe une vaste sélection de disques provenant de diverses entreprises, à la fois le premier échelon des marques A et des entreprises chinoises qui ont essayé d'avoir suffisamment de SSD pour tout le monde

Que nous offre la technologie QLC?

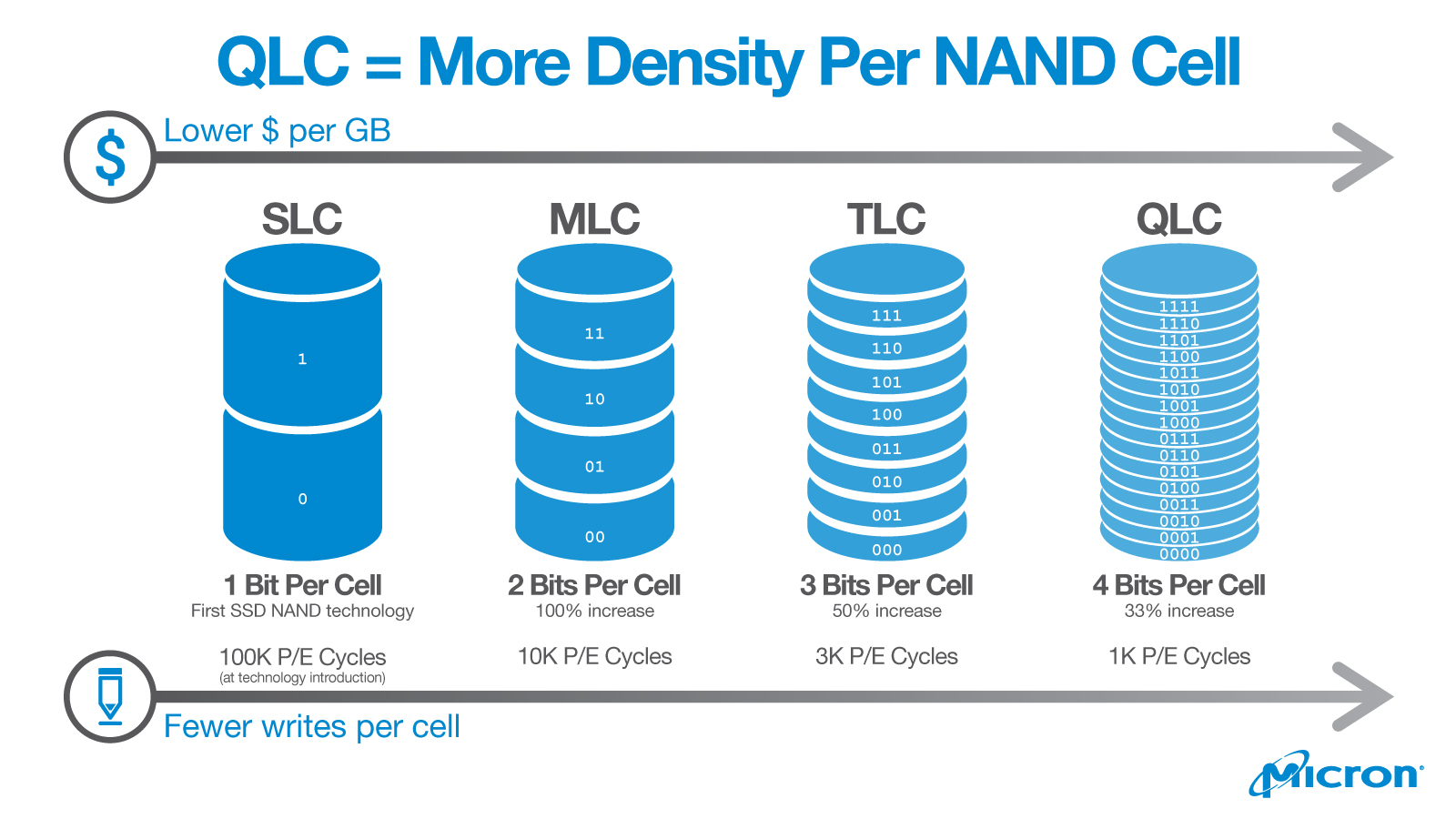

Le nombre de bits enregistrés dans une seule cellule NAND est déterminé par le nombre de niveaux de charge dans le transistor à grille flottante. Plus il y en a, plus un seul transistor peut stocker de bits. Il s'agit de la

principale différence entre la technologie QLC et la «précédente» TLC - le nombre de bits dans une cellule est passé de trois à quatre .

Avec une augmentation du nombre de niveaux de charge, les caractéristiques du lecteur changent beaucoup: la vitesse d'accès diminue, la fiabilité du stockage des informations diminue, mais la capacité augmente et le rapport prix / volume devient plus attractif pour les clients. Par conséquent, les puces basées sur la technologie QLC sont moins chères que la génération précédente TLC, qui stocke trois bits dans une cellule. Dans le même temps, les QLC sont moins fiables, car la probabilité de défaillance d'une cellule augmente considérablement à chaque nouveau niveau.

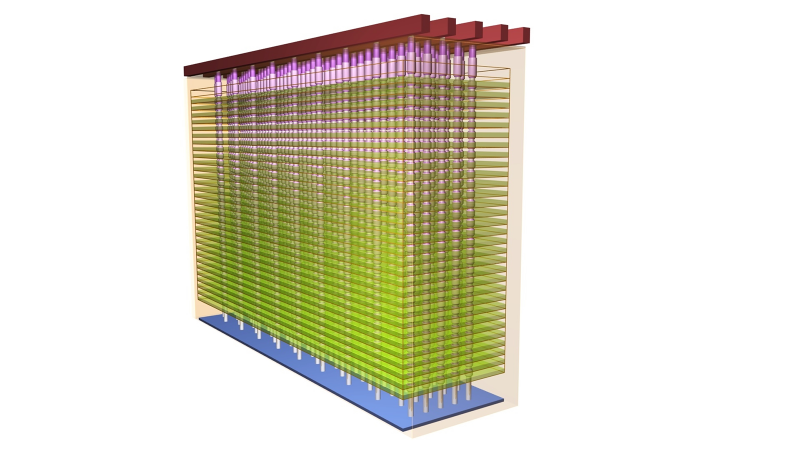

En plus de la complexité d'une seule cellule, d'autres surgissent. En raison du fait que les puces de mémoire sont fabriquées à l'aide de la technologie 3D NAND, ce sont des tableaux tridimensionnels de cellules densément emballées les unes sur les autres, et les cellules des "étages" voisins s'influencent mutuellement, gâchant la vie de leurs voisins. De plus, les puces modernes contiennent plus de couches que les produits des générations précédentes. Par exemple, l'une des technologies pour augmenter la densité de mémoire implique une augmentation du nombre de couches dans le cristal de 48 à 64. Dans le cadre d'une autre technologie, deux cristaux de 48 couches sont «soudés», ce qui porte le nombre total à 96, ce qui impose des exigences très élevées sur l'alignement des limites dans ce « sandwich », il y a plus de points d'échec et la part du mariage augmente. Malgré la complexité du processus, une telle technologie s'avère plus rentable que d'essayer de faire croître des couches dans un cristal, car le rejet augmente de manière non linéaire avec une augmentation du nombre de couches, et un faible rendement de puces appropriées coûterait trop cher. En toute justice, il convient de noter que seules les sociétés de premier plan peuvent se permettre de tels développements. Certains fabricants de puces chinois ne sont pas passés à des cristaux à 64 couches, et jusqu'à présent, seuls les géants électroniques tels qu'Intel et Micron ont la technologie de «coller» deux cristaux à 48 couches.

3D NAND

3D NANDUne autre nouveauté utilisée dans les entraînements d'une nouvelle génération de marques A est le transfert du contrôle et du cerclage d'alimentation à un ensemble de cellules. Pour cette raison, la surface des cristaux a diminué et il est devenu possible de placer quatre banques de mémoire là où auparavant seulement deux étaient situées. Et cela, à son tour, a permis de paralléliser les requêtes et d'augmenter la vitesse de travail avec la mémoire. De plus, la plus petite surface des cristaux a permis d'augmenter la capacité de stockage.

L'augmentation de la densité cellulaire aide également à combattre une dégradation plus rapide de la mémoire. Nous avons traité cette tâche de front, à l'aide d'une redondance encore plus grande du réseau de cellules.

Les prototypes de puces QLC ont été présentés l'été dernier, et les premières promesses de sortie de SSD à l'aide de nouvelles technologies ont été faites plus tôt cette année. Au cours de l'été, presque toutes les entreprises produisant des disques, ont déclaré qu'elles étaient prêtes pour la production de masse, ont annoncé les noms des nouveaux modèles, leurs prix et leurs spécifications. Vous pouvez maintenant acheter des SSD avec des puces QLC. La plupart des modèles sont disponibles en format M.2 et 2,5 ", avec des capacités de 512 gigaoctets, 1 et 2 téraoctets.

Positionnement de stockage QLC

Pour commencer, il est juste d'admettre que les disques créés à l'aide de la nouvelle technologie QLC sont catégoriquement inadaptés aux tâches sérieuses / critiques. Et la raison en est un certain nombre de difficultés techniques que les ingénieurs des grandes sociétés-inventeurs et les "adeptes" chinois doivent résoudre.

Par exemple, sur le site Web d'Intel, les nouveaux SSD ne sont proposés que dans le segment de milieu de gamme pour les ordinateurs personnels. Leur utilisation est particulièrement justifiée dans les netbooks à faible performance, dont les tâches n'incluent pas les jeux ou le travail avec des bases de données, et le coût, au contraire, est très important. Ces «machines à écrire» sont de plus en plus demandées. Pour travailler dans le segment entreprise, seuls les disques avec puces MLC et TLC sont proposés.

Si nous comparons les caractéristiques des SSD de marque (les Chinois bon marché n'ont pas de sens, les contrôleurs peu coûteux tuent toutes les caractéristiques), alors le prix moyen des disques QLC est environ 20-30% inférieur à celui des MLC, avec le même facteur de forme et le même volume.

Vitesse d'accès . Pour un modèle avec des puces QLC, c'est: pour lire jusqu'à 1500 Mb / s, pour écrire jusqu'à 1000 Mb / s. Pour le modèle sur puces TLC - 3210 Mb / s et 1625 Mb / s, respectivement. La vitesse d'écriture du lecteur QLC est une fois et demie inférieure, et la lecture - deux. La différence est significative, mais pour surfer sur Internet et éditer des textes - plus que suffisant.

TBW (Total Bytes Written) . Un paramètre critique caractérisant la ressource SSD. Il parle du nombre maximum de téraoctets pouvant être écrits sur le lecteur. Plus le TBW est élevé, plus le lecteur est tenace et plus il peut fonctionner sans faute. Pour tous les modèles de la série 760p, la ressource est de 288 TBW et pour 660p - seulement 100 TBW. Près de trois fois la différence.

DWPD (Drive Writes Per Day) . Cet indicateur de fiabilité indique combien de fois par jour vous pouvez remplacer l'intégralité du lecteur et est calculé par la formule:

DWPD = TBW / 0,512 * 365 * 5où 0,512 est le volume du lecteur en téraoctets;

365 - le nombre de jours dans une année;

5 - le nombre d'années de garantie.

Le DWPD est plus objectif, car le calcul prend en compte le temps pendant lequel le constructeur s'engage à résoudre gratuitement les problèmes avec le variateur. DWPD est 0,1 pour le modèle QLC et 0,32 pour les modèles TLC. En d'autres termes, dans cet exemple, chaque jour, le QLC peut écraser complètement 50 Go - c'est son mode de fonctionnement normal. Étant donné qu'au même prix, la capacité des lecteurs QLC est supérieure à celle du MLC, il est peu probable que l'utilisateur moyen d'une «machine à écrire avec Internet» ait le temps de développer cette ressource.

Ces deux appareils sont un exemple frappant de la façon dont les ingénieurs doivent résoudre de nombreuses difficultés techniques, qui semblaient plus brillantes dans QLC que dans TLC. En particulier, QLC a une vitesse d'accès en écriture et en lecture plus faible, des ressources plus faibles, un coefficient WAF plus élevé (plus d'informations à ce sujet ci-dessous). Examinons de plus près les principales difficultés et les méthodes pour les résoudre.

Vitesse d'accès

Commençons par l'une des fonctionnalités les plus remarquables du SSD QLC pour l'utilisateur -

une vitesse d'écriture inférieure lorsque le cache du lecteur est plein . Étant donné que la vitesse d'accès de QLC est déjà relativement faible, les fabricants tentent de l'augmenter avec la mise en cache. Le SSD utilise pour cela sa propre matrice de cellules de disque, qui sont transférées vers un mode de fonctionnement à bit unique - SLC.

Il existe plusieurs algorithmes de mise en cache. Souvent, une petite partie de la capacité du disque lui-même est allouée au cache - en moyenne, de 2 à 16 Go, dans certains modèles, il peut y avoir jusqu'à plusieurs dizaines de gigaoctets. L'inconvénient de cette méthode est que s'il y a un échange intensif de données pendant le fonctionnement de l'ordinateur, alors une petite quantité de cache peut se remplir rapidement et la vitesse de lecture / écriture chutera fortement.

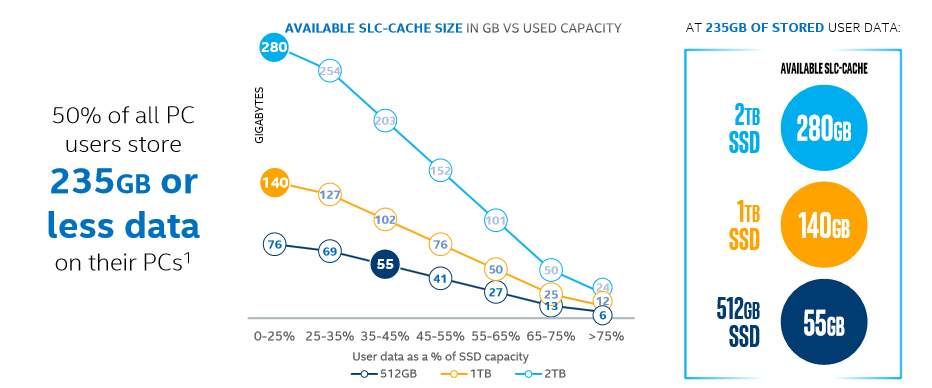

De plus en plus d'entreprises technologiques utilisent des contrôleurs avancés qui peuvent transférer dynamiquement une partie des cellules en mode rapide SLC, dans ce cas, la taille du cache dépend du volume total du disque et peut atteindre 10%. Dans les SSD modernes, les deux méthodes sont utilisées: une quantité relativement petite de cache statique est complétée par un volume alloué dynamiquement, qui est beaucoup plus important. Plus l'espace est libre, plus la taille du cache est grande et plus il est difficile d'épuiser sa taille. Il est logique qu'un disque plus grand ait un cache plus grand, ce qui signifie que le cache dynamique qu'il contient fonctionnera plus efficacement.

Une dépendance claire de la taille du cache SLC sur le volume du lecteur et de l'espace libre sur celui-ci.

Une dépendance claire de la taille du cache SLC sur le volume du lecteur et de l'espace libre sur celui-ci.Erreurs de lecture

La complexité croissante de l'architecture QLC par rapport au TLC a conduit à une augmentation du nombre d'erreurs de lecture des données. Pour les corriger, il a fallu implémenter l'utilisation forcée d'

algorithmes ECC (Error correction code, error correction codes) . Avec leur aide, le contrôleur corrige indépendamment presque toutes les erreurs de lecture des données. Et le développement d'algorithmes de correction efficaces est l'une des tâches les plus difficiles lors de la création de lecteurs QLC, car il est nécessaire non seulement d'assurer une efficacité de correction élevée (exprimée en nombre de bits corrigés pour 1 Ko de données), mais également d'utiliser le moins de cellules de mémoire possible pour économiser leur ressource. . Pour ce faire, les fabricants introduisent des contrôleurs plus productifs, mais surtout, ils utilisent des appareils scientifiques et statistiques puissants pour créer et améliorer des algorithmes.

Ressource

Les caractéristiques de l'architecture QLC réduisent non seulement la fiabilité, mais conduisent également au phénomène

«d'amplification d'écriture» (amplification d'écriture, WA) . Bien qu'il serait plus correct de dire «multiplication d'enregistrement», cependant, l'option

«amplification» est jusqu'à présent plus courante dans Runet.

Qu'est-ce que WA? Dans un SSD, physiquement avec des cellules, il y a beaucoup plus d'opérations de lecture / écriture que nécessaire pour la quantité de données directement reçues du système d'exploitation. Contrairement aux disques durs traditionnels, qui ont un très petit «quantum» de données réinscriptibles, les données sur le SSD sont stockées dans des «pages» assez grandes, généralement 4 Ko chacune. Il y a aussi le concept de «bloc» - le nombre minimum de pages qui peuvent être réécrites. Habituellement, un bloc contient de 128 à 512 pages.

Par exemple, un cycle de réécriture dans un SSD comprend plusieurs opérations:

- déplacer les pages du bloc effacé vers un lieu de stockage temporaire,

- libérer l'espace occupé par le bloc,

- réécrire le bloc temporaire en ajoutant de nouvelles pages,

- écrire le bloc mis à jour à l'ancien endroit,

- nettoyer l'endroit utilisé pour le stockage temporaire.

Comme vous pouvez le voir, cette opération lit et efface à plusieurs reprises des quantités relativement importantes de données dans plusieurs zones différentes du lecteur, même si le système d'exploitation ne souhaite modifier que quelques octets. Cela augmente sérieusement l'usure des cellules. De plus, les opérations de lecture / écriture "supplémentaires" réduisent considérablement le débit de la mémoire flash.

Le degré d '«amplification d'écriture» est exprimé par le WAF (facteur d'amplification d'écriture): le rapport entre la quantité de données

réellement réinscriptible et la quantité

à réécrire. Idéalement, lorsque la compression n'est pas utilisée, le WAF est 1. Les valeurs réelles dépendent beaucoup de divers facteurs, par exemple, de la taille des blocs réinscriptibles et des algorithmes utilisés dans les contrôleurs.

Et puisque les cellules QLC sont beaucoup plus sensibles au nombre de cycles de réécriture, la taille WAF est devenue beaucoup plus importante que pour TLC et MLC.

Quels autres facteurs affectent négativement le WAF dans les lecteurs QLC?

- L'algorithme de récupération de place , qui recherche les blocs inégalement remplis qui contiennent simultanément des pages vides et remplies, les écrase de sorte que les blocs ne contiennent que des pages vides ou uniquement remplies, ce qui réduit encore le nombre d'opérations conduisant à WA.

- Porter le nivellement . Les blocs auxquels le système accède fréquemment se déplacent régulièrement vers les cellules au lieu de blocs moins demandés. Cela permet de garantir une usure uniforme de toutes les cellules de mémoire du lecteur. Mais en conséquence, la ressource totale du lecteur est progressivement réduite, même si vous l'utilisez comme stockage d'archives.

Voici un exemple d '«amélioration de l'écriture» due aux mécanismes de nivellement de l'usure et de collecte des déchets:

- La valeur WAF est également affectée par le fonctionnement du mécanisme de correction d'erreur (ECC). Comme déjà mentionné, il est possible de réduire sa contribution à la «multiplication d'enregistrements» en améliorant les algorithmes, y compris le LDPC .

- Avec suffisamment d'espace libre sur le SSD, certains contrôleurs peuvent mettre certaines des cellules NAND en mode avec moins de niveaux d'enregistrement: de QLC à SLC. Cela accélère considérablement le fonctionnement du lecteur et augmente sa fiabilité. Mais, avec une diminution de l'espace libre, les cellules seront à nouveau écrasées dans le mode avec le nombre maximum de niveaux. Plus il y a d'espace libre sur le SSD, plus il fonctionnera rapidement et efficacement, à condition que son contrôleur soit assez avancé et prenne en charge cette fonction. Si vous conservez une partie des cellules les plus activement utilisées en mode SLC, cela augmente le WAF global, mais réduit l'usure.

Avec la croissance de WAF, QLC est combattu avec différentes méthodes.

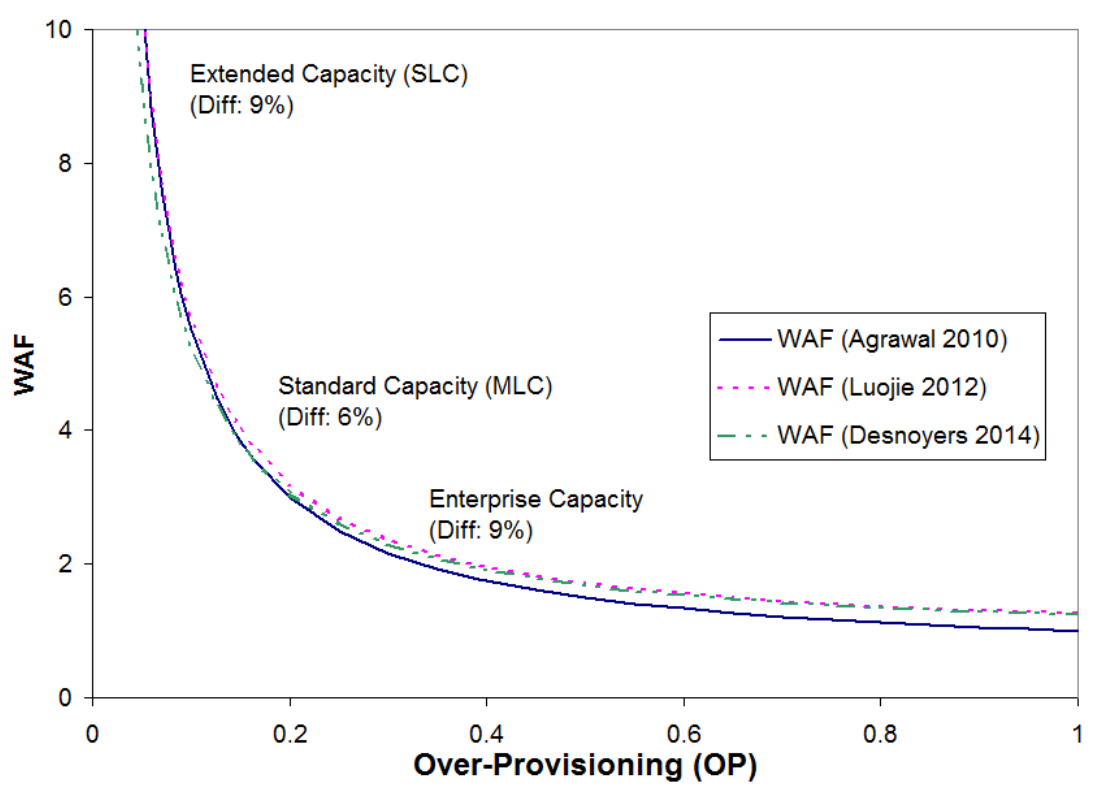

Par exemple, l'utilisation du surapprovisionnement (OP) - l'allocation pour les entreprises a besoin d'une partie du volume qui n'est pas disponible pour l'utilisateur.

OP = ( — ) /Plus la zone allouée est grande, plus le contrôleur dispose de liberté et plus ses algorithmes fonctionnent rapidement. Par exemple, auparavant, sous OP, la différence entre les gigaoctets «réels» et «marketing» était distinguée, c'est-à-dire entre 10

9 = 1 000 000 000 octets et 2

30 = 1 073 741 824 octets et cela équivaut à 7,37% du volume total du lecteur. Il existe un certain nombre d'autres astuces pour allouer des bureaux. Par exemple, les contrôleurs modernes vous permettent d'utiliser dynamiquement l'intégralité du volume libre actuel du lecteur sous OP.

Une dépendance approximative du WAF de la taille de l'OP:

Réduit le WAF et l'algorithme de séparation des données statiques et dynamiques. Le contrôleur calcule les données qui sont souvent écrasées et celles qui sont principalement lues, ou pas du tout modifiées, et regroupe les blocs de données sur le disque en conséquence.

D'autres outils pour réduire le WAF dans les lecteurs QLC incluent des techniques d'enregistrement séquentiel (très grossièrement, cela peut être comparé à la défragmentation habituelle du disque dur). L'algorithme détermine les blocs qui peuvent appartenir à un seul gros fichier et ne nécessitent pas de traitement par le garbage collector. Si le système d'exploitation donne une commande pour supprimer ou modifier ce fichier, alors ses blocs seront effacés ou écrasés dans leur ensemble sans être inclus dans le cycle WA, ce qui augmente la vitesse et use moins les cellules mémoire. Enfin, la compression et la déduplication des données pré-écriture contribuent à la lutte contre WA.

Comme vous l'avez déjà compris, la fiabilité et les ressources des disques QLC dépendent non seulement des puces de mémoire utilisées, mais également des performances du contrôleur, et surtout, de l'avancement de toutes sortes d'algorithmes intégrés dans le contrôleur. De nombreuses sociétés, même les plus grandes, achètent des contrôleurs auprès d'autres sociétés spécialisées dans leur version. Les petites entreprises chinoises utilisent des contrôleurs simples et peu coûteux des générations passées, guidés non pas par la qualité et la nouveauté des algorithmes, mais par le prix. Les grandes entreprises n'économisent pas sur le matériel pour leurs SSD et choisissent des contrôleurs qui fournissent au lecteur une longue durée de vie et un fonctionnement plus rapide. Les leaders parmi les fabricants de contrôleurs pour SSD sont en constante évolution. Mais en dehors des contrôleurs complexes, les algorithmes de micrologiciel jouent également un rôle énorme, que les grands fabricants développent indépendamment, ne faisant pas confiance à cette question importante à des sociétés tierces.

Conclusions

Le principal avantage de QLC sur les disques sur puces TLC et MLC est qu'il a réussi à mettre encore plus de mémoire dans le même volume physique. Ainsi, QLC n'évincera pas les technologies précédentes du marché, encore moins les concurrents pour les disques durs.

La différence de vitesse entre QLC et TLC sera perceptible lors du démarrage de programmes lourds et avec un échange de données intensif. Mais un utilisateur ordinaire peut ne pas le remarquer, car sur les ordinateurs du niveau pour lequel les lecteurs QLC sont recommandés, le programme attend plus longtemps les actions de l'utilisateur qu'il ne fonctionne avec les données.

Nous pouvons affirmer avec certitude que le créneau des lecteurs bon marché pour les ordinateurs de faible performance, lorsqu'il n'est pas logique de surpayer pour une fiabilité accrue ou des vitesses d'écriture et de lecture maximales, a été occupé avec succès. Dans ces ordinateurs, le SSD QLC peut être le seul lecteur sur lequel le système et les programmes nécessaires seront installés, ainsi que les données utilisateur. Mais dans l'entreprise - la révolution n'a pas eu lieu; ici, comme auparavant, ils préféreront toujours le TLC plus fiable et le disque dur lent mais sans prétention.

Cependant, la technologie ne s'arrête pas, les fabricants promettent cette année d'entamer la transition vers la technologie de traitement à 7 nm, et à l'avenir, en 2021 et plus tard, les technologies de traitement à 5 et 3 nm sont à venir. Les algorithmes des contrôleurs sont en cours d'amélioration, certaines entreprises promettent des disques SSD intelligents qui seront plusieurs fois plus rapides, avec certains cas d'utilisation spécifiques, le développement des technologies 3D NAND est prévu.

Alors, attendez quelques années et voyez ce que les fabricants peuvent nous offrir d'autre.

Pour plus d'informations sur les produits Kingston, visitez le site officiel de l'entreprise .