Bonjour, Habr!

Cette année, lors de la rédaction du document final sur le travail de l'entreprise pour l'année, nous avons décidé de refuser de raconter la nouvelle, et bien que nous ne puissions pas nous débarrasser complètement des souvenirs de ce qui s'est passé, nous aimerions partager avec vous ce que nous avons réussi à faire - rassembler nos pensées et tourner les yeux vers où nous nous trouverons certainement dans un avenir très proche - à l'heure actuelle.

Sans plus tarder, les principales conclusions de l'année dernière:

- La durée moyenne des attaques DDoS est tombée à 2,5 heures;

- L'année 2018 a montré la présence d'une puissance de calcul capable de générer des attaques d'une intensité de centaines de gigabits par seconde à l'intérieur d'un pays ou d'une région, nous amenant au bord de la «théorie quantique de la relativité de la bande passante» ;

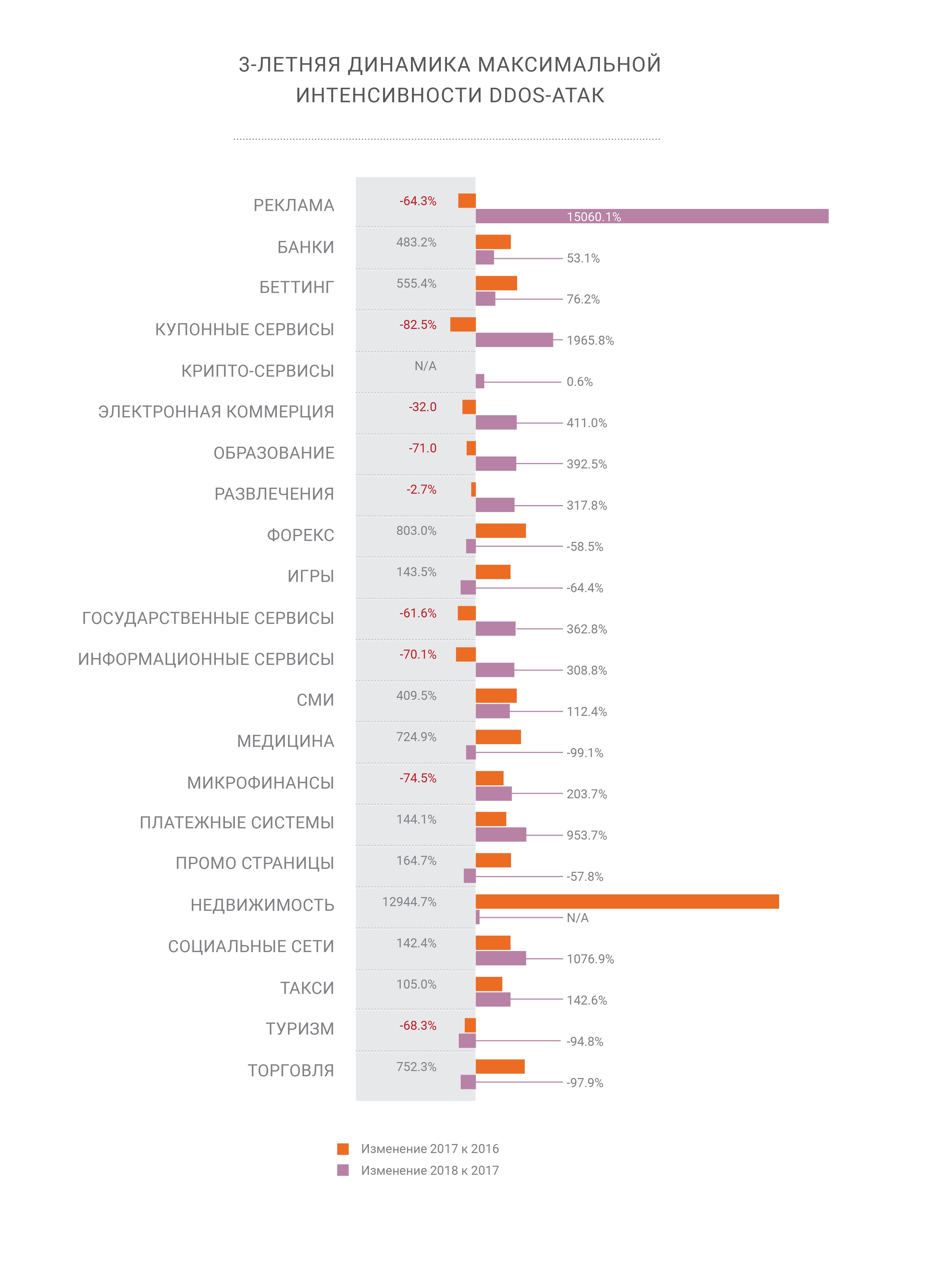

- L'intensité des attaques DDoS continue de croître;

- Parallèlement à l'augmentation simultanée de la part des attaques utilisant HTTPS (SSL);

- Les ordinateurs personnels sont morts - la plupart du trafic moderne est généré sur les appareils mobiles, ce qui représente un défi pour les organisateurs DDoS et le prochain défi pour les sociétés de sécurité réseau;

- Le BGP est finalement devenu un vecteur d'attaque, 2 ans plus tard que prévu;

- La manipulation DNS est toujours le vecteur d'attaque le plus perturbateur;

- Nous attendons de nouveaux amplificateurs à l'avenir, tels que memcached et CoAP;

- Il n'y a plus de "refuges" sur Internet et toutes les industries sont également vulnérables aux cyberattaques de toute nature.

Sous la coupe, nous avons rassemblé les parties les plus intéressantes du rapport en un seul endroit, vous pouvez trouver la version complète

ici . Bonne lecture.

Rétrospective

La crypto a cessé d'être intéressante pour les attaquants

La crypto a cessé d'être intéressante pour les attaquantsEn 2018, notre entreprise a «relevé» deux attaques record sur son propre réseau. Les attaques d'amplification memcached, que nous avons décrites en détail fin février 2018, ont touché le système de paiement Qiwi à 500 Gb / s, mais ont été neutralisées avec succès par le réseau de filtrage. Fin octobre, nous avons assisté à une autre attaque historique - l'amplification du DNS avec des sources localisées dans un seul pays, mais d'une puissance sans précédent.

L'amplification DNS a été et reste l'un des vecteurs d'attaque DDoS au niveau des liens les plus célèbres et soulève toujours deux questions aiguës. En cas d'attaque d'une intensité de centaines de gigabits par seconde, il existe une probabilité considérable de surcharger la connexion à un fournisseur supérieur. Comment y faire face? De toute évidence, il est nécessaire de répartir une telle charge sur autant de canaux que possible - ce qui nous amène au deuxième problème - le retard supplémentaire du réseau résultant des changements dans les trajets de trafic vers leurs emplacements de traitement. Heureusement, nous avons également géré la deuxième attaque grâce aux options flexibles d'équilibrage de charge au sein du réseau Qrator.

C'est ainsi que l'équilibrage nous a montré sa valeur la plus élevée - puisque nous gérons le réseau BGP anycast, notre radar modélise la distribution du trafic sur le réseau après avoir changé le modèle d'équilibrage. BGP est un protocole de vecteur de distance et nous comprenons bien les états, car le graphique de distance reste presque statique. En analysant ces distances en tenant compte du LCP et du Multipath à coût égal, nous pouvons pré-évaluer AS_path du point A au point B avec un haut degré de précision.

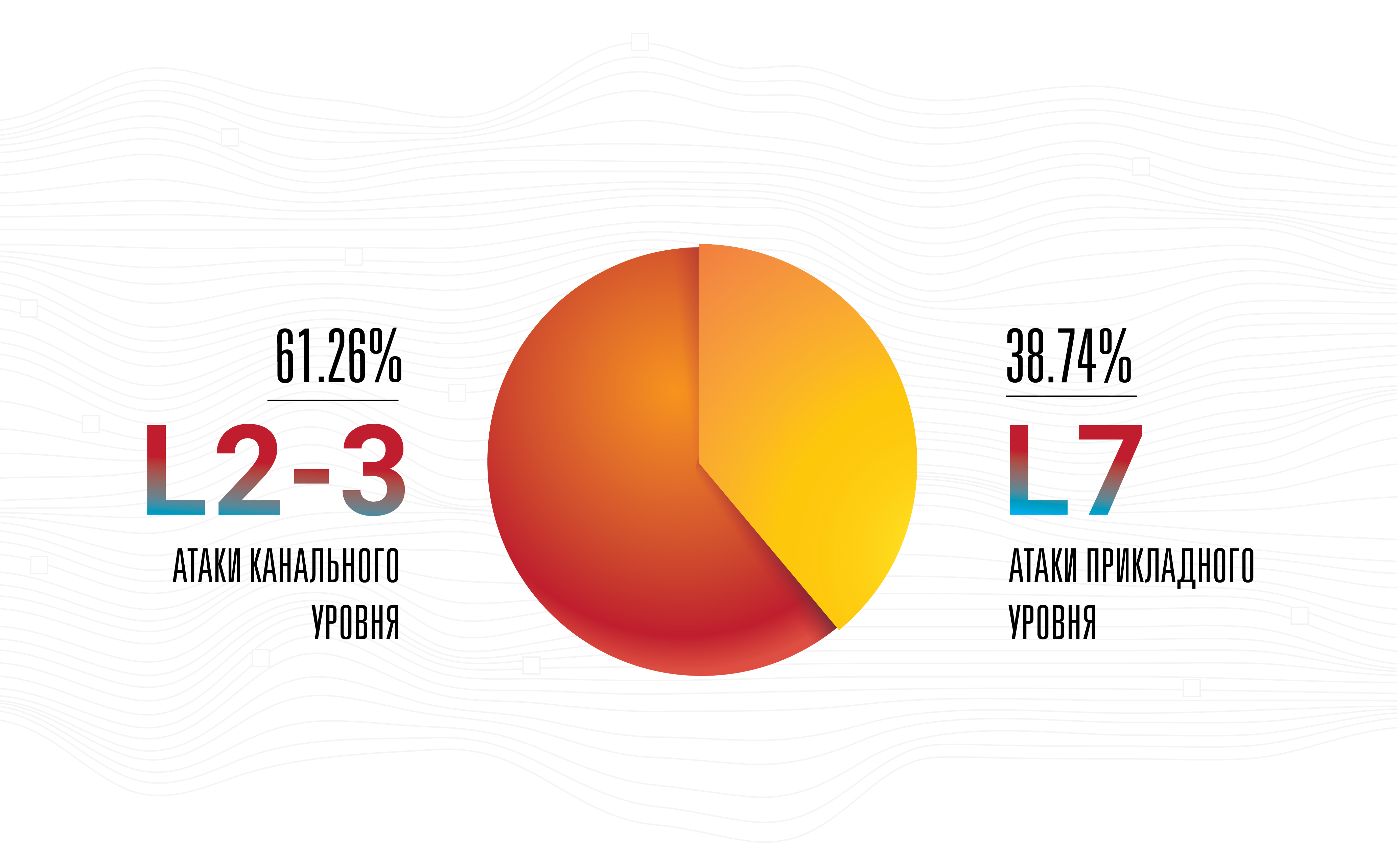

Cela ne signifie pas que l'amplification est la menace la plus grave - non, les attaques au niveau de l'application restent les plus réussies, invisibles et efficaces, car la plupart d'entre elles sont effectuées à une faible intensité de la bande utilisée.

C'est la raison principale pour laquelle notre entreprise améliore sans compromis les connexions avec les opérateurs aux points de présence, tout en augmentant leur nombre. Une telle étape est logique pour tout opérateur de réseau à l'heure actuelle, à condition que l'entreprise se développe. Mais nous continuons de croire que la plupart des attaquants collectent d'abord un botnet et ce n'est qu'ensuite qu'ils commencent à choisir parmi la plus large liste d'amplificateurs disponibles qui peuvent être touchés par toutes les armes possibles à la vitesse de rechargement maximale. De telles attaques hybrides ont lieu depuis longtemps, mais ce n'est que récemment que leur intensité, à la fois en termes de nombre de paquets par seconde et de bande passante réseau impliquée, a commencé à augmenter.

Les attaques avec des intensités supérieures à 100 Gbit / s sont désormais clairement visibles dans les statistiques - ce n'est plus du bruit

Les attaques avec des intensités supérieures à 100 Gbit / s sont désormais clairement visibles dans les statistiques - ce n'est plus du bruitLes botnets se sont développés de manière significative en 2018, et leurs propriétaires ont proposé une nouvelle activité -

clickfraud . Avec l'amélioration des technologies d'apprentissage automatique et la mise à disposition de navigateurs sans tête fonctionnant sans interface graphique, clickfraud est devenu beaucoup plus facile et moins cher - en seulement deux ans.

Aujourd'hui, le site Web moyen reçoit de 50% à 65% du trafic des appareils mobiles, de leurs navigateurs et de leurs applications. Pour certains services réseau, cette part peut atteindre jusqu'à 90% voire 100%, alors que les sites web exclusivement «desktop» n'existent pratiquement plus, sauf dans les environnements d'entreprise, ou sous forme de cas hautement spécialisés.

En fait, les ordinateurs personnels ont disparu du sommet du paysage réseau en 2019, rendant certaines techniques réussies dans le passé, telles que le suivi de la position de la souris, complètement inopérantes pour filtrer le trafic et se protéger contre les bots. En fait, non seulement les ordinateurs personnels, mais la plupart des ordinateurs portables et des boîtiers tout-en-un sont rarement à l'origine d'une part importante des visites de pages, tout en devenant facilement une arme. À un moment donné, un simple refus d'accès à tout ce qui représentait de manière incorrecte un navigateur mobile jusqu'à récemment était tout à fait suffisant pour neutraliser presque complètement les attaques de botnets, nivelant ainsi l'effet négatif des principales mesures commerciales.

Les créateurs et les gestionnaires de réseaux de zombies sont déjà habitués à mettre en œuvre des pratiques qui imitent le comportement des visiteurs de pages réelles dans leur propre code malveillant, tout comme les propriétaires de pages Web sont habitués au fait que les navigateurs sur les ordinateurs personnels comptent. Les deux sont modifiés, tandis que le premier est plus rapide que le second.

Nous avons déjà déclaré que rien n'a changé en 2018, mais les progrès et les changements eux-mêmes ont subi une évolution significative. L'un des exemples les plus frappants est l'apprentissage automatique, où les améliorations et les progrès ont été clairement visibles, en particulier dans le domaine des réseaux génératifs-compétitifs. Lentement mais sûrement, ML atteint le marché de masse. L'apprentissage automatique est déjà devenu assez abordable et, comme l'a montré la frontière de 2018-2019, n'est plus une industrie limitée aux universitaires.

Bien que nous nous attendions à l'apparition des premières attaques DDoS basées sur ML d'ici le début de 2019, cela ne s'est pas produit jusqu'à présent. Cependant, cela ne change pas nos attentes, mais ne fait que les alimenter, en particulier compte tenu de la baisse des coûts de gestion des réseaux de neurones et de la précision toujours croissante de leurs analyses.

D'un autre côté, si l'on considère l'état actuel de l'industrie des «individus humains automatisés», il devient clair que la mise en œuvre d'un réseau neuronal dans cette conception est une idée potentiellement révolutionnaire. Un tel réseau peut apprendre du comportement de personnes réelles dans le cadre de la gestion de pages Web. Une telle chose sera appelée «expérience utilisateur de l'intelligence artificielle» et, bien sûr, un réseau similaire armé d'un navigateur Web peut étendre l'arsenal des deux côtés: attaquer et défendre.

La formation d'un réseau de neurones est un processus coûteux, mais la distribution et l'externalisation d'un tel système pourraient être bon marché, efficaces et potentiellement même gratuites - dans le cas où du code malveillant est caché dans des applications, des extensions et bien plus encore. Potentiellement, un tel changement pourrait changer l'ensemble de l'industrie de la même manière que les réseaux génératifs-compétitifs ont transformé notre compréhension de la «réalité visuelle» et de «l'authenticité».

Compte tenu de la course continue entre les moteurs de recherche - principalement Google et tous ceux qui tentent de les désosser, les choses peuvent aller jusqu'à des choses fantastiques, telles que l'imitation d'une seule personne spécifique par un bot. Généralement assis devant un ordinateur vulnérable. Les versions du projet Captcha et ReCaptcha peuvent servir d'exemple de la rapidité et de la force avec laquelle le côté attaquant développe et améliore ses propres outils et techniques d'attaque.

Après Memcached, il y a eu beaucoup de discussions sur la probabilité (ou l'improbabilité) d'une classe d'armes entièrement nouvelle pour les DDoS - une vulnérabilité, un bot, un service mal configuré, ou quelque chose d'autre qui enverrait sans cesse des données pour une cible spécifique choisie par l'attaquant. Une commande de l'attaquant provoque un flux continu de trafic, tel qu'une des inondations ou l'envoi de syslog. Pour le moment, c'est une théorie. Nous ne pouvons toujours pas dire s'il existe de tels serveurs, appareils, mais si la réponse à cette question est oui, ce sera une sous-estimation de la situation de dire qu'une telle chose peut devenir une arme incroyablement dangereuse entre de mauvaises mains.

En 2018, nous avons également constaté un intérêt croissant pour ce que l'on appelle la «gouvernance de l'Internet» et les services connexes des États et des organisations à but non lucratif du monde entier. Nous sommes neutres face à une telle évolution des événements jusqu'au moment où la suppression des libertés civiles et individuelles fondamentales commence, ce qui, nous l'espérons, ne se produira pas dans les pays développés.

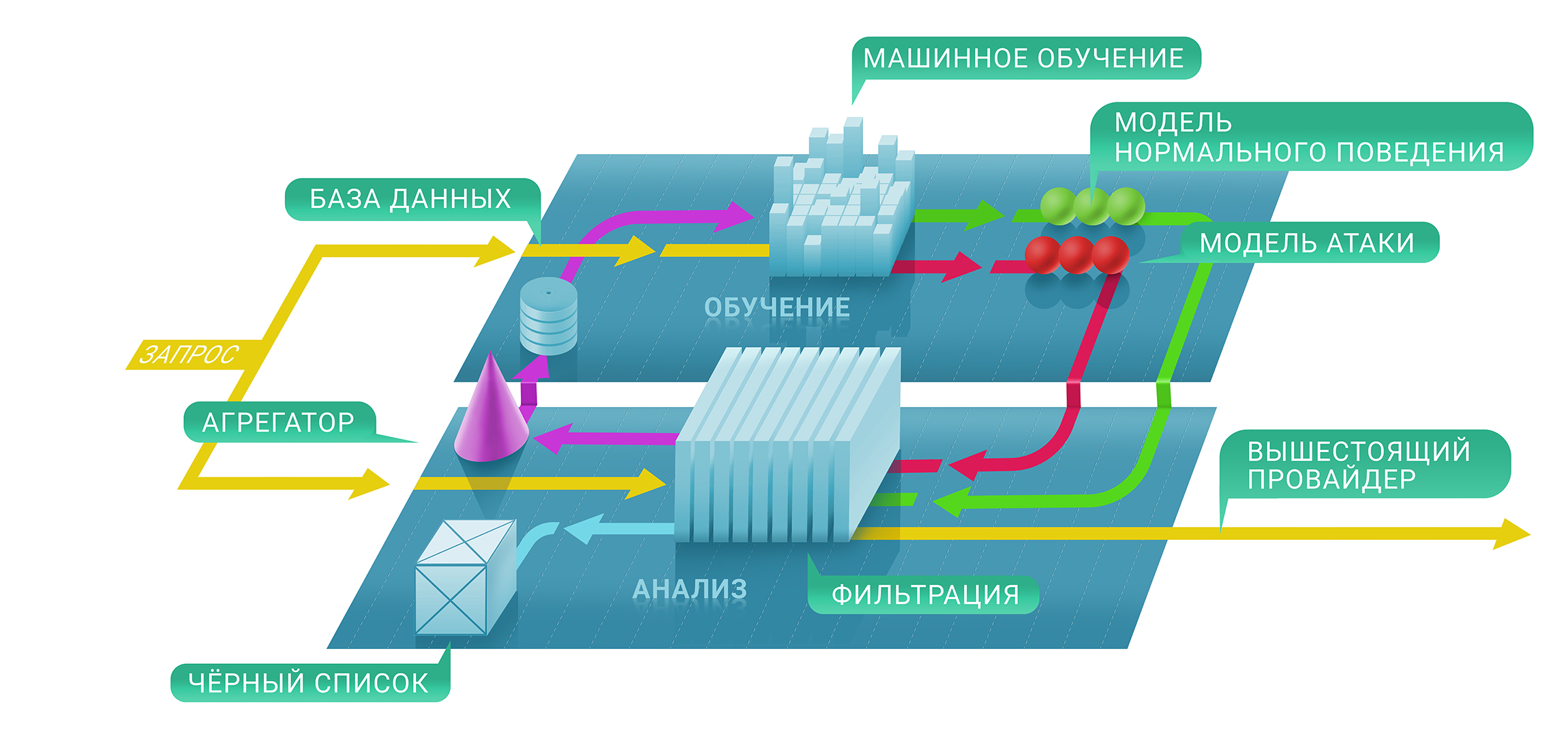

Enfin, après des années de collecte et d'analyse du trafic d'attaque à travers le monde, Qrator Labs est prêt à implémenter le blocage sur la première requête réseau. Les modèles que nous utilisons pour prédire les comportements malveillants nous permettent de déterminer avec précision la légitimité de l'utilisateur pour chaque page particulière. Nous continuons d'insister sur notre propre philosophie de connexion sans obstacle pour l'utilisateur et d'expérience utilisateur inextricable, sans contrôles JavaScript ni captcha, qui à partir de 2019 commencera à fonctionner encore plus rapidement, offrant le plus haut niveau d'accessibilité des services protégés.

L'intensité maximale de la bande d'attaque continue d'augmenter régulièrement.

L'intensité maximale de la bande d'attaque continue d'augmenter régulièrement.Mellanox

Notre société a sélectionné les commutateurs 100G Mellanox à la suite de tests internes effectués sur plusieurs années. Nous sélectionnons toujours les équipements qui répondent le mieux à nos exigences plutôt spécifiques dans certaines conditions de la meilleure façon. Par exemple, un commutateur ne doit pas laisser tomber de petits paquets à un débit de ligne - la vitesse maximale, même une dégradation minimale est inacceptable. De plus, les commutateurs Mellanox ont un bon prix. Cependant, ce n'est pas tout - l'équité du prix est confirmée par la façon dont un fournisseur particulier répond à vos demandes.

Les commutateurs Mellanox fonctionnent sur Switchdev, qui transforme leurs ports en interfaces simples à l'intérieur de Linux. Faisant partie du noyau Linux principal, Switchdev fournit un moyen pratique de gérer l'appareil à l'aide d'interfaces claires et familières, sous une seule API, qui est absolument familière à tout programmeur, développeur et ingénieur réseau moderne. Tout programme qui utilise l'API réseau Linux standard peut être exécuté sur un commutateur. Tous les services de surveillance et de gestion des activités réseau créés pour les serveurs Linux, y compris les solutions propriétaires possibles, sont facilement accessibles. Pour illustrer les changements survenus avec le développement actif de Switchdev, nous notons que la modification des tables de routage est devenue beaucoup plus rapide et plus pratique avec Switchdev. Jusqu'au niveau de la puce réseau, tout le code est visible et transparent, ce qui vous permet d'apprendre et d'apporter des modifications jusqu'à ce que vous ayez besoin de savoir comment la puce elle-même est construite ou, au moins, l'interface externe avec celle-ci.

L'appareil Mellanox exécutant Switchdev s'est avéré être la combinaison tant attendue que nous attendions depuis si longtemps, mais encore mieux - la société de fabrication a répondu à toutes les attentes et exigences, non seulement en ce qui concerne la prise en charge complète d'un système d'exploitation gratuit prêt à l'emploi.

En testant l'équipement avant de le mettre en service, nous avons découvert qu'une partie du trafic redirigé est perdue. Notre enquête a montré que cela était dû au fait que le trafic vers l'une des interfaces était envoyé à l'aide d'un processeur de contrôle qui ne pouvait pas faire face à son volume élevé. Impossible de déterminer la cause exacte de ce comportement, nous avons cependant suggéré que cela était dû au traitement des redirections ICMP. Mellanox a confirmé la source du problème, et nous avons donc demandé à faire quelque chose avec ce comportement de l'appareil, auquel la société a répondu instantanément en fournissant une solution de travail en peu de temps.

Excellent travail, Mellanox!

Protocoles et open source

DNS-over-HTTPS est une technologie plus complète que DNS-over-TLS. Nous observons comment le premier prospère, tandis que le second est lentement oublié. Cet exemple est bon car dans ce cas particulier, «complexité» signifie «efficacité», car le trafic DoH ne se distingue pas de tout autre HTTPS. Nous avons déjà vu la même chose avec l'intégration des données RPKI, qui était initialement positionnée comme une solution anti-interception et, par conséquent, rien de bon ne lui est arrivé. Après un certain temps, RPKI est réapparu sur la scène comme un outil puissant contre les anomalies telles que les fuites de route et les paramètres de routage incorrects. Et maintenant, le bruit a été transformé en signal, et RPKI a commencé à être pris en charge dans les plus grands points d'échange de trafic, ce qui est une excellente nouvelle.

Arrivé et TLS 1.3. Qrator Labs, comme l'ensemble de l'industrie informatique, a suivi de près le processus de développement d'une nouvelle norme de chiffrement à chaque étape, de la version initiale de l'IETF à un protocole compréhensible et gérable que nous sommes prêts à prendre en charge à partir de 2019. Le marché a réagi de la même manière, promettant la mise en œuvre la plus rapide d'un protocole de sécurité fiable. Il est possible que tous les fabricants de solutions de neutralisation DDoS ne soient pas en mesure de s'adapter aussi rapidement à la réalité modifiée, car en raison de la complexité technique de la prise en charge du protocole, il peut y avoir des retards explicables dans le matériel.

Nous suivons également le développement continu de HTTP / 2. Pour le moment, nous ne prenons pas en charge la nouvelle version du protocole HTTP, principalement en raison de l'imperfection de la base de code actuelle. Les bogues et les vulnérabilités sont encore trop souvent découverts dans le nouveau code; En tant que fournisseur de solutions de sécurité, nous ne sommes pas encore prêts à prendre en charge ce protocole dans le cadre du SLA, avec lequel nos consommateurs ont accepté.

En 2018, nous nous sommes souvent posé la question: «Pourquoi les gens veulent-ils tant HTTP / 2?», Ce qui a été à l'origine de nombreux débats acharnés. Les gens sont toujours enclins à considérer les choses avec le préfixe «2» comme de «meilleures» versions de n'importe quoi, ce qui est particulièrement vrai spécifiquement dans le cas de certains aspects de la mise en œuvre de ce protocole. Néanmoins, DoH recommande d'utiliser HTTP / 2, et il est fort possible qu'un degré élevé d'acceptation par le marché des deux protocoles naisse de cette synergie.

L'une des inquiétudes lorsque l'on envisage le développement de protocoles de nouvelle génération et leurs capacités prévues est le fait que très souvent les développements ne dépassent pas le niveau purement académique, sans parler de la prise en compte des cas extrêmes de créateurs de protocoles, tels que la neutralisation des attaques DDoS. C'est peut-être la raison pour laquelle les entreprises engagées dans la cybersécurité et la sécurité de l'information consacrent peu d'efforts à l'élaboration de telles normes.

La section 4.4 du projet

de l'IETF, intitulée «QUIC manageability», qui fait partie du futur paquet de protocoles QUIC, est simplement un exemple idéal de cette approche: elle déclare que «les pratiques actuelles de détection et de neutralisation [attaques DDoS] impliquent principalement une mesure passive utilisant données de couche réseau. " Ce dernier est extrêmement rarement utilisé dans la pratique, sauf peut-être pour les réseaux de fournisseurs Internet et n'est guère un «cas commun» dans la pratique. Cependant, dans le document de recherche universitaire, des «cas généraux» sont formés de cette manière, à la suite de quoi les normes de protocole finales ne sont tout simplement pas applicables en production, après avoir effectué des manipulations simples avant la mise en service comme des tests sous charge et simulant des attaques au niveau de l'application sur l'application, elles en utilisant. Compte tenu du processus en cours d'introduction de TLS dans l'infrastructure Internet mondiale, l'affirmation de toute surveillance passive est généralement sérieusement remise en question. Construire une recherche académique correcte est un autre test pour les fournisseurs de solutions de sécurité en 2019.

Dans le même temps, Switchdev a pleinement répondu aux attentes qui y étaient posées il y a un an. Nous espérons que le travail continu sur Switchdev conduira la communauté et le fruit commun du travail à d'excellents résultats dans un proche avenir.

La poursuite du développement et de la mise en œuvre de Linux XDP aidera l'industrie à atteindre une efficacité élevée de traitement des paquets réseau. L'expédition de certains modèles de filtrage du trafic illégitime du processeur central au processeur de réseau, et dans certains cas même au commutateur, semble déjà prometteuse et notre société poursuit ses propres recherches et développements dans ce domaine.

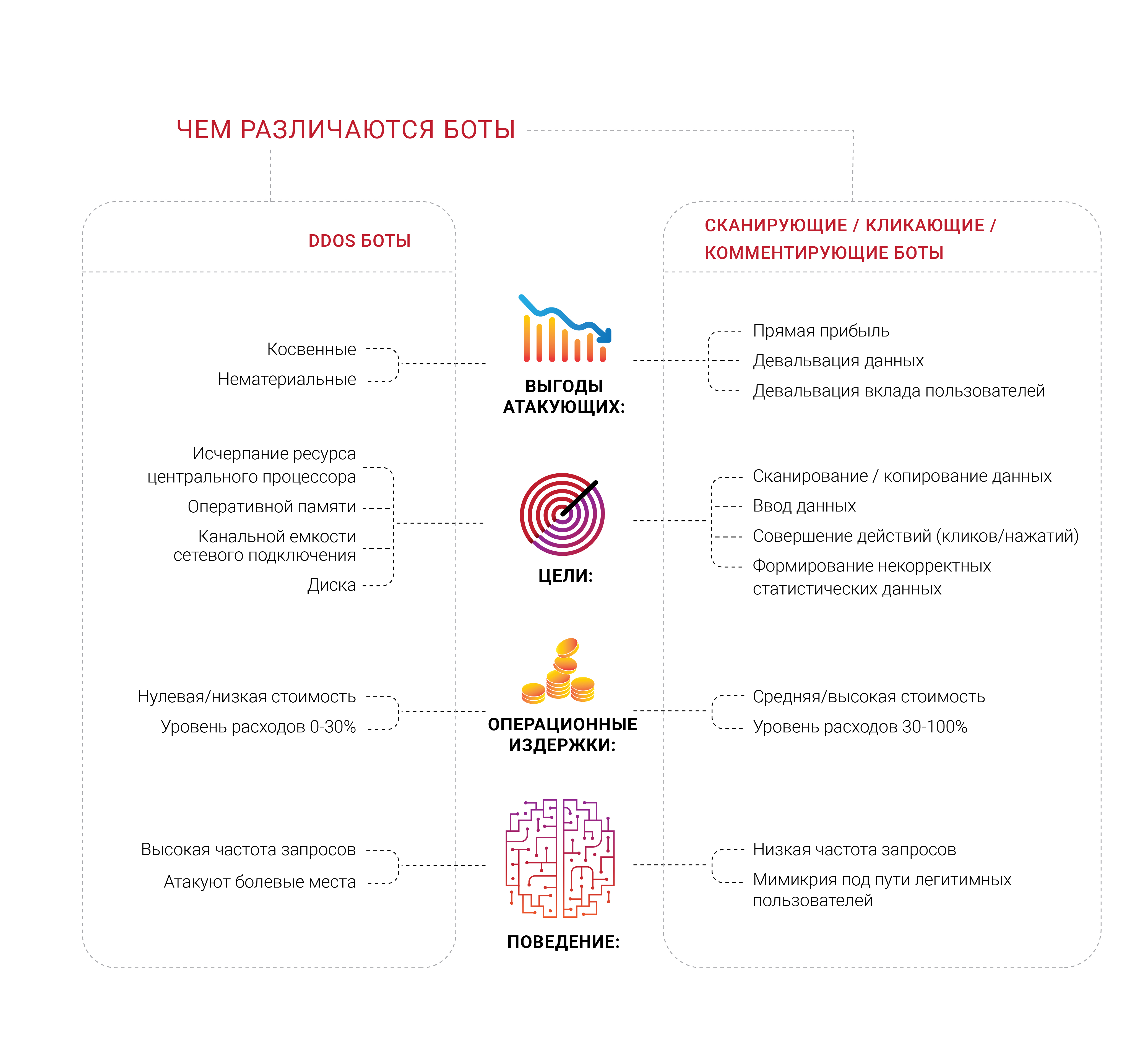

Plongée profonde avec des bots

De nombreuses entreprises sont désireuses d'obtenir une protection contre les bots, et, sans surprise, nous avons vu un grand nombre de groupes diversifiés de professionnels travaillant sur divers domaines de ce problème en 2018. Ce qui nous semble particulièrement intéressant, c'est que la plupart des entreprises générant une telle demande n'ont jamais subi d'attaque DDoS ciblée, du moins typique, visant à épuiser des ressources limitées, telles que la mémoire, un processeur ou un canal de connexion réseau. Ils ont peur des bots, mais ils ne peuvent pas les distinguer des utilisateurs légitimes ni déterminer exactement ce qu'ils font. La plupart des sources de tels appels veulent se débarrasser du sentiment que des personnes non vivantes viennent sur leurs pages.

Le problème des scanners de robots et de nombreuses autres sous-espèces est une composante économique très importante. Si 30% du trafic est illégitime et provient de sources indésirables, alors 30% des coûts de support de ce trafic sont jetés à la poubelle, selon la logique des dépenses. Aujourd'hui, on peut considérer cela comme une «taxe Internet» inévitable pour les entreprises. Ce nombre est presque impossible à réduire à zéro, mais les propriétaires d'entreprise souhaitent que ce pourcentage soit aussi bas que possible.

L'identification devient un problème et un défi extrêmement sérieux sur l'Internet moderne, car les robots les plus avancés n'essaient même pas de représenter une personne - ils la gèrent et sont dans le même espace que lui, comme les parasites. Nous répétons depuis longtemps que toute information disponible publiquement, sans authentification et autorisation est là et, en fin de compte, mettra fin à son existence sous la forme du domaine public - personne ne peut empêcher cela.

Compte tenu de ce problème, nous nous sommes concentrés sur les questions d'identification et de gestion des bots. Cependant, à notre avis, un large éventail de travaux est beaucoup plus intéressant - nous vivons à une époque où il est déjà impossible de savoir pourquoi un client particulier demande quelque chose au serveur. Vous lisez tout correctement - au final, toute entreprise veut savoir que le consommateur est venu acheter, car c'est le but de son entreprise et de son existence. Par conséquent, certaines entreprises veulent examiner en profondeur qui et quoi demande à leurs serveurs - y a-t-il une vraie personne derrière la demande.Il n'est pas surprenant, en fin de compte, que souvent les propriétaires d'entreprise découvrent qu'une partie importante du trafic vers leur site Web est générée par des robots, et non par des acheteurs.Les êtres humains automatisés, que nous avons déjà mentionnés dans un contexte différent, peuvent viser des ressources réseau beaucoup plus spécifiques en utilisant des choses presque imperceptibles, telles que les extensions de navigateur. Nous savons déjà que tant d'extensions difficiles à qualifier de «malveillantes» existent uniquement dans le but de collecter et d'analyser le comportement d'un utilisateur réel. Mais il y a des choses complètement différentes - où l'automatisation ne peut pas passer la clôture devant elle, les personnes avec des modifications du navigateur apparaissent et effectuent toutes les mêmes actions simples, peut-être seulement un peu plus cher pour les organisateurs. En outre, un certain nombre de tâches, telles que la manipulation de publicités et la fraude aux clics, sont exécutées de manière beaucoup plus efficace avec une personne réelle devant l'écran. Imaginez ce qui pourrait arriversi quelqu'un trouve un bon moyen de le renforcer avec l'apprentissage automatique, dans la bonne partie de la chaîne.Les analyseurs et les scanners, qui font partie du problème plus large des robots, ne sont venus à notre horizon qu'en 2018 et, tout d'abord, grâce à nos consommateurs qui nous ont informés de leur propre expérience et ont permis d'étudier et d'analyser plus en profondeur ce qui se passait sur les ressources de leur réseau. Ces robots peuvent même ne pas être visibles au niveau des métriques standard, telles que la bande passante réseau moyenne utilisée ou l'utilisation du processeur du serveur. À l'heure actuelle, Qrator Labs teste une variété d'approches, mais une chose est claire - nos consommateurs souhaitent que les robots malveillants soient bloqués à leur avis lors de la première demande au serveur.Lors de l'épidémie d'analyse que nous avons observée en Russie et dans la CEI tout au long du second semestre 2018, il est devenu évident que les bots avaient parcouru un long chemin dans les problèmes de cryptage. Une demande par minute est une intensité tout à fait normale pour le bot, ce qui est très difficile à remarquer sans analyser les demandes et le trafic de réponse sortant. À notre humble avis, seul le consommateur a le droit de décider quoi faire de toute source indésirable de demandes après avoir analysé et marqué le trafic. Bloquer, sauter ou tricher - pas à nous de décider. Cependant, les solutions purement automatiques, ou comme nous sommes habitués à les appeler «bots», ont certaines difficultés à interagir. Si vous êtes sûr que c'est le bot qui a généré la requête indésirable et assez spécifique, la première chose à faire est de la bloquer sans répondre du serveur. Néanmoins, nous sommes arrivés à la conclusion qu'une telle approche est dénuée de sens, car elle donne trop de commentaires au bot et à son créateur et vous encourage à rechercher une solution de contournement. Si les bots n'essaient pas de mettre le service hors service, en général, nous vous conseillons de ne pas prêcher cette approche - à la suite de jouer au chat et à la souris, un attaquant raisonnablement déterminé vous contournera presque toujours dans la poursuite d'un objectif, quel qu'il soit.C'est la raison pour laquelle Qrator Labs a adopté l'approche d'étiquetage des logiciels malveillants, ainsi que de tout le trafic en général, afin de fournir au propriétaire de l'application un maximum de données et des opportunités pour prendre une décision éclairée, compte tenu des conséquences possibles pour les utilisateurs et les objectifs commerciaux. Les bloqueurs de publicités sont un bon exemple illustrant les conséquences possibles. La plupart des publicités modernes sur Internet sont présentées sous forme de scripts, un blocage que vous ne bloquez pas nécessairement, et non, par exemple, la vérification par javascript du service de protection DDoS. Il est facile d'imaginer où cette piste peut mener, entraînant finalement une baisse des bénéfices des entreprises Internet.Lorsque les attaquants sont bloqués et que le feedback dont ils ont besoin est obtenu, rien ne les empêche de s'adapter, d'apprendre et d'attaquer à nouveau. Nos technologies sont construites autour d'une philosophie simple selon laquelle il n'est pas nécessaire de fournir des commentaires aux robots - vous devez les bloquer ou les ignorer, mais simplement les détecter et les marquer. Une fois un tel marquage effectué et nous sommes sûrs de son exactitude, il est juste de poser la question suivante: "De quoi ont-ils besoin?" et "Pourquoi sont-ils intéressés par cela?" Peut-être suffit-il de modifier légèrement le contenu de la page Web pour qu'aucune personne vivante ne puisse sentir la différence, mais la réalité du bot va-t-elle bouleverser? S'il s'agit d'analyseurs, il est possible qu'un certain pourcentage des données se révèlent incorrectes et fausses, mais dans tous les cas, cela supprimera la protection de la recherche de zéro ou un binaire et donnera quelque chosece qu'il faut vraiment, c'est du temps.En discutant de ce problème tout au long de 2018, nous avons appelé des attaques similaires à celles décrites comme des attaques sur les mesures commerciales. Le site Web, l'application et le serveur peuvent très bien fonctionner, et aucun utilisateur ne se plaindra, mais vous ressentez toujours quelque chose ... comme une baisse du CPA des annonces que vous prenez à placer sur la plate-forme programmatique, poussant les annonceurs vers elle, pas même vos concurrents.Réduire la récompense d'un attaquant est le seul moyen de le contrer. Une tentative d'arrêter les robots n'apportera rien d'autre que le temps et l'argent dépensés. Si quelque chose clique sur ce qui vous fait du profit - annulez ces clics; si vous êtes analysé, vous pouvez inclure une couche de «fausses» informations à travers laquelle un utilisateur ordinaire et curieux passera facilement à la recherche d'informations correctes et fiables.

Cependant, les solutions purement automatiques, ou comme nous sommes habitués à les appeler «bots», ont certaines difficultés à interagir. Si vous êtes sûr que c'est le bot qui a généré la requête indésirable et assez spécifique, la première chose à faire est de la bloquer sans répondre du serveur. Néanmoins, nous sommes arrivés à la conclusion qu'une telle approche est dénuée de sens, car elle donne trop de commentaires au bot et à son créateur et vous encourage à rechercher une solution de contournement. Si les bots n'essaient pas de mettre le service hors service, en général, nous vous conseillons de ne pas prêcher cette approche - à la suite de jouer au chat et à la souris, un attaquant raisonnablement déterminé vous contournera presque toujours dans la poursuite d'un objectif, quel qu'il soit.C'est la raison pour laquelle Qrator Labs a adopté l'approche d'étiquetage des logiciels malveillants, ainsi que de tout le trafic en général, afin de fournir au propriétaire de l'application un maximum de données et des opportunités pour prendre une décision éclairée, compte tenu des conséquences possibles pour les utilisateurs et les objectifs commerciaux. Les bloqueurs de publicités sont un bon exemple illustrant les conséquences possibles. La plupart des publicités modernes sur Internet sont présentées sous forme de scripts, un blocage que vous ne bloquez pas nécessairement, et non, par exemple, la vérification par javascript du service de protection DDoS. Il est facile d'imaginer où cette piste peut mener, entraînant finalement une baisse des bénéfices des entreprises Internet.Lorsque les attaquants sont bloqués et que le feedback dont ils ont besoin est obtenu, rien ne les empêche de s'adapter, d'apprendre et d'attaquer à nouveau. Nos technologies sont construites autour d'une philosophie simple selon laquelle il n'est pas nécessaire de fournir des commentaires aux robots - vous devez les bloquer ou les ignorer, mais simplement les détecter et les marquer. Une fois un tel marquage effectué et nous sommes sûrs de son exactitude, il est juste de poser la question suivante: "De quoi ont-ils besoin?" et "Pourquoi sont-ils intéressés par cela?" Peut-être suffit-il de modifier légèrement le contenu de la page Web pour qu'aucune personne vivante ne puisse sentir la différence, mais la réalité du bot va-t-elle bouleverser? S'il s'agit d'analyseurs, il est possible qu'un certain pourcentage des données se révèlent incorrectes et fausses, mais dans tous les cas, cela supprimera la protection de la recherche de zéro ou un binaire et donnera quelque chosece qu'il faut vraiment, c'est du temps.En discutant de ce problème tout au long de 2018, nous avons appelé des attaques similaires à celles décrites comme des attaques sur les mesures commerciales. Le site Web, l'application et le serveur peuvent très bien fonctionner, et aucun utilisateur ne se plaindra, mais vous ressentez toujours quelque chose ... comme une baisse du CPA des annonces que vous prenez à placer sur la plate-forme programmatique, poussant les annonceurs vers elle, pas même vos concurrents.Réduire la récompense d'un attaquant est le seul moyen de le contrer. Une tentative d'arrêter les robots n'apportera rien d'autre que le temps et l'argent dépensés. Si quelque chose clique sur ce qui vous fait du profit - annulez ces clics; si vous êtes analysé, vous pouvez inclure une couche de «fausses» informations à travers laquelle un utilisateur ordinaire et curieux passera facilement à la recherche d'informations correctes et fiables.Clickhouse

À un niveau élevé, le service de filtrage Qrator se compose de deux niveaux: le premier, nous évaluons immédiatement si une demande particulière est malveillante en utilisant des vérifications avec et sans état, et le second, nous décidons de conserver la source dans la liste noire et pendant combien de temps . La liste noire résultante peut être représentée comme un tableau unique d'adresses IP.À la première étape de ce processus, nous utilisons des techniques d'apprentissage automatique afin de mieux comprendre les niveaux naturels et les caractéristiques du trafic pour chaque ressource individuellement, car chaque paramètre de protection de chaque service individuel est configuré individuellement en fonction des mesures que nous collectons.C'est là que Clickhouse entre en jeu. Afin de mieux comprendre pourquoi une certaine adresse IP a été bloquée de communiquer avec la ressource, nous devons retracer tout le chemin de l'apprentissage automatique jusqu'à la base de données Clickhouse. Il fonctionne très rapidement avec de gros morceaux de données (imaginez une attaque DDoS à 500 Gbit / s et durant plusieurs heures de temps pur en dehors des pauses) et les stocke sous une forme pratique pour le cadre d'apprentissage automatique utilisé dans Qrator Labs. Plus de journaux et plus de trafic enregistré d'attaques DDoS conduisent à des résultats précis de nos modèles, qui aident à affiner le service de filtrage en temps réel, sous les attaques les plus graves.Nous utilisons Clickhouse DB pour stocker tous les journaux du trafic d'attaques illégitimes et des modèles de comportement des bots. Cette solution spécialisée a été choisie par nous en raison du fort potentiel de stockage d'ensembles de données massifs dans le style d'une base de données classique à des fins de traitement ultérieur. L'analyse de ces données est également utilisée pour créer des modèles d'attaques DDoS, aidant l'apprentissage automatique à améliorer constamment nos algorithmes de filtrage du trafic.Un avantage significatif de Clickhouse, par rapport à d'autres bases de données, est qu'il n'a pas besoin de lire une variable de données de chaîne entière - il peut prendre un segment beaucoup plus petit et strictement nécessaire si vous stockez tout conformément aux recommandations. Et ça marche, vite!

À un niveau élevé, le service de filtrage Qrator se compose de deux niveaux: le premier, nous évaluons immédiatement si une demande particulière est malveillante en utilisant des vérifications avec et sans état, et le second, nous décidons de conserver la source dans la liste noire et pendant combien de temps . La liste noire résultante peut être représentée comme un tableau unique d'adresses IP.À la première étape de ce processus, nous utilisons des techniques d'apprentissage automatique afin de mieux comprendre les niveaux naturels et les caractéristiques du trafic pour chaque ressource individuellement, car chaque paramètre de protection de chaque service individuel est configuré individuellement en fonction des mesures que nous collectons.C'est là que Clickhouse entre en jeu. Afin de mieux comprendre pourquoi une certaine adresse IP a été bloquée de communiquer avec la ressource, nous devons retracer tout le chemin de l'apprentissage automatique jusqu'à la base de données Clickhouse. Il fonctionne très rapidement avec de gros morceaux de données (imaginez une attaque DDoS à 500 Gbit / s et durant plusieurs heures de temps pur en dehors des pauses) et les stocke sous une forme pratique pour le cadre d'apprentissage automatique utilisé dans Qrator Labs. Plus de journaux et plus de trafic enregistré d'attaques DDoS conduisent à des résultats précis de nos modèles, qui aident à affiner le service de filtrage en temps réel, sous les attaques les plus graves.Nous utilisons Clickhouse DB pour stocker tous les journaux du trafic d'attaques illégitimes et des modèles de comportement des bots. Cette solution spécialisée a été choisie par nous en raison du fort potentiel de stockage d'ensembles de données massifs dans le style d'une base de données classique à des fins de traitement ultérieur. L'analyse de ces données est également utilisée pour créer des modèles d'attaques DDoS, aidant l'apprentissage automatique à améliorer constamment nos algorithmes de filtrage du trafic.Un avantage significatif de Clickhouse, par rapport à d'autres bases de données, est qu'il n'a pas besoin de lire une variable de données de chaîne entière - il peut prendre un segment beaucoup plus petit et strictement nécessaire si vous stockez tout conformément aux recommandations. Et ça marche, vite!Conclusion

Depuis longtemps, nous vivons dans un monde d'attaques multifactorielles qui exploitent les capacités d'attaque de plusieurs protocoles à la fois pour sortir la cible d'un état sain.

L'hygiène numérique et les mesures de sécurité pertinentes devraient couvrir et, en fait, couvrir environ 99% des risques existants qu'un utilisateur ordinaire peut rencontrer, sauf, peut-être, pour des attaques hautement spécialisées contre des cibles spécifiques.

D'un autre côté, sur l'Internet moderne, il y a des requins qui peuvent mordre l'accessibilité d'états entiers. Cela ne s'applique pas au BGP, où il est possible de ne payer que certains points sur n'importe quelle carte qu'un attaquant souhaite dessiner.

Le niveau de connaissances concernant la sécurité du réseau continue de croître. Néanmoins, si vous regardez les nombres associés au nombre d'amplificateurs dans les réseaux ou recherchez la possibilité de fausses demandes - le nombre de services et de serveurs vulnérables ne diminue pas. Le rythme quotidien auquel les jeunes acquièrent des connaissances en programmation et en gestion de réseaux informatiques ne correspond pas au temps nécessaire pour acquérir une expérience pertinente dans la vie réelle. La confiance que de nouvelles vulnérabilités ne se manifestent pas avec de nouveaux produits prend beaucoup de temps et, surtout, cela fait mal.

L'une des découvertes les plus surprenantes de l'année écoulée est que la plupart des gens attendent beaucoup plus des nouvelles technologies qu'ils ne peuvent en fournir. Cela n'a pas toujours été le cas, mais en ce moment, nous assistons à une tendance croissante des gens à «exiger plus», quelles que soient les capacités des logiciels et, en particulier, du matériel. Cela nous entraîne dans un monde de campagnes marketing assez perverses. Mais les gens continuent néanmoins à «acheter des promesses» et les entreprises, à leur tour, se sentent obligées de les respecter.

C'est peut-être là l'essence du progrès et de l'évolution. Maintenant, beaucoup sont bouleversés par le fait de ne pas obtenir de «garantie» et ce pour quoi les fonds ont été versés. En raison de l'impossibilité d'acheter "complètement" un appareil auprès du fabricant, de nombreux problèmes actuels augmentent, mais le coût des services "gratuits" peut s'avérer fabuleux si l'on considère le coût cumulé des données reçues d'un utilisateur par un grand réseau social qui ne nécessite pas de paiement.

Le consumérisme nous dit que si nous voulons vraiment quelque chose, alors, en fin de compte, nous paierons de notre propre vie. Avons-nous vraiment besoin de produits et services similaires qui ne s'améliorent que pour nous proposer des «offres améliorées» basées sur les données que nous avons recueillies à notre sujet, que cela nous plaise ou non? Néanmoins, cela semble être le proche avenir, comme nous l'ont montré récemment les cas d'Equifax et de Cambridge Analytica. Il n'est pas surprenant qu'il y ait un «big bang» devant nous de l'utilisation des données personnelles et autres relatives à la vie individuelle de chacun.

Après dix ans de travail, nous n'avons pas changé les fondements clés de l'architecture d'Internet. C'est la raison pour laquelle nous continuons à développer un réseau de filtrage BGP anycast avec la capacité de traiter le trafic crypté sous cette forme, en évitant le captcha et d'autres obstacles inattendus pour un utilisateur légitime.

En observant ce qui continue à arriver aux experts dans le domaine de la cybersécurité, ainsi qu'aux entreprises dans ce domaine, nous voulons une fois de plus répéter l'évidence: une approche naïve, simple et rapide n'est pas applicable.

Par conséquent, Qrator Labs ne possède pas des centaines, voire des dizaines de points de présence comparables aux CDN. En gérant moins de centres de filtrage, dont chacun est connecté à des fournisseurs de services Internet d'une classe non inférieure au niveau 1, nous réalisons une véritable décentralisation. Pour la même raison, nous n'essayons pas de construire notre propre pare-feu, qui est une tâche d'un niveau complètement différent de celui sur lequel nous travaillons - la connectivité.

Au fil des ans, nous avons dit qu'au final, ni la vérification captcha ni la vérification javascript ne fonctionneraient, et nous voici en 2019, lorsque les réseaux de neurones sont devenus très efficaces pour résoudre le premier, et le second n'a jamais posé de problème à l'attaquant avec le cerveau.

Je voudrais noter un autre changement intéressant à la date limite: les attaques DDoS ne sont depuis longtemps un problème grave que pour un nombre limité de secteurs d'activité, généralement ceux où l'argent oscille à la surface: commerce électronique, commerce et échange, systèmes bancaires et de paiement. Mais avec le développement continu d'Internet, nous constatons des attaques DDoS d'intensité et de fréquence accrues dans absolument toutes les parties d'Internet. L'ère DDoS a commencé avec un certain seuil pour la bande passante des routeurs domestiques, et il n'est pas surprenant qu'avec l'avènement d'une micropuce dans chaque chose physique autour du paysage d'attaque a commencé à changer rapidement.

Quiconque s'attend à la fin du développement de cette tendance a très probablement tort. Tout comme nous avons tort, ayant écrit tant de prédictions. Personne ne peut dire avec certitude comment Internet se développera et étendra sa propre influence dans les années à venir, mais en regardant ce que nous avons vu, une chose est claire: tout va se multiplier. En 2020, le nombre d'appareils connectés au réseau devrait dépasser les 30 milliards, sans parler du simple fait que les robots génèrent depuis longtemps beaucoup plus de trafic que les humains. Très bientôt, nous devrons décider quoi faire de toute cette «intelligence», artificielle ou non, car nous existons toujours dans un monde où l'individu humain est responsable de ses actes, bons ou mauvais.

2018 a été une année d'opportunité pour le côté obscur. Nous avons vu une augmentation des attaques, tout en les compliquant et en augmentant à la fois le volume en termes de réseau et la fréquence. Les méchants ont obtenu des outils puissants et ont passé beaucoup de temps à les étudier, tandis que les gentils ne faisaient que regarder leurs progrès. Nous espérons sincèrement que cette année au moins quelque chose va changer, du moins dans les endroits les plus douloureux.

→

Lien vers la version complète du rapport en russe.