En travaillant sur le rapport annuel de cette année, nous avons décidé d'éviter de relire les gros titres de l'année précédente et, bien qu'il soit presque impossible d'ignorer absolument les souvenirs, nous voulons partager avec vous le résultat d'une réflexion claire et d'une vision stratégique pour le point où nous allons tous arriver dans le temps le plus proche - le présent.

Laissant de côté les mots d'introduction, voici nos principales conclusions:

- La durée moyenne des attaques DDoS est tombée à 2,5 heures;

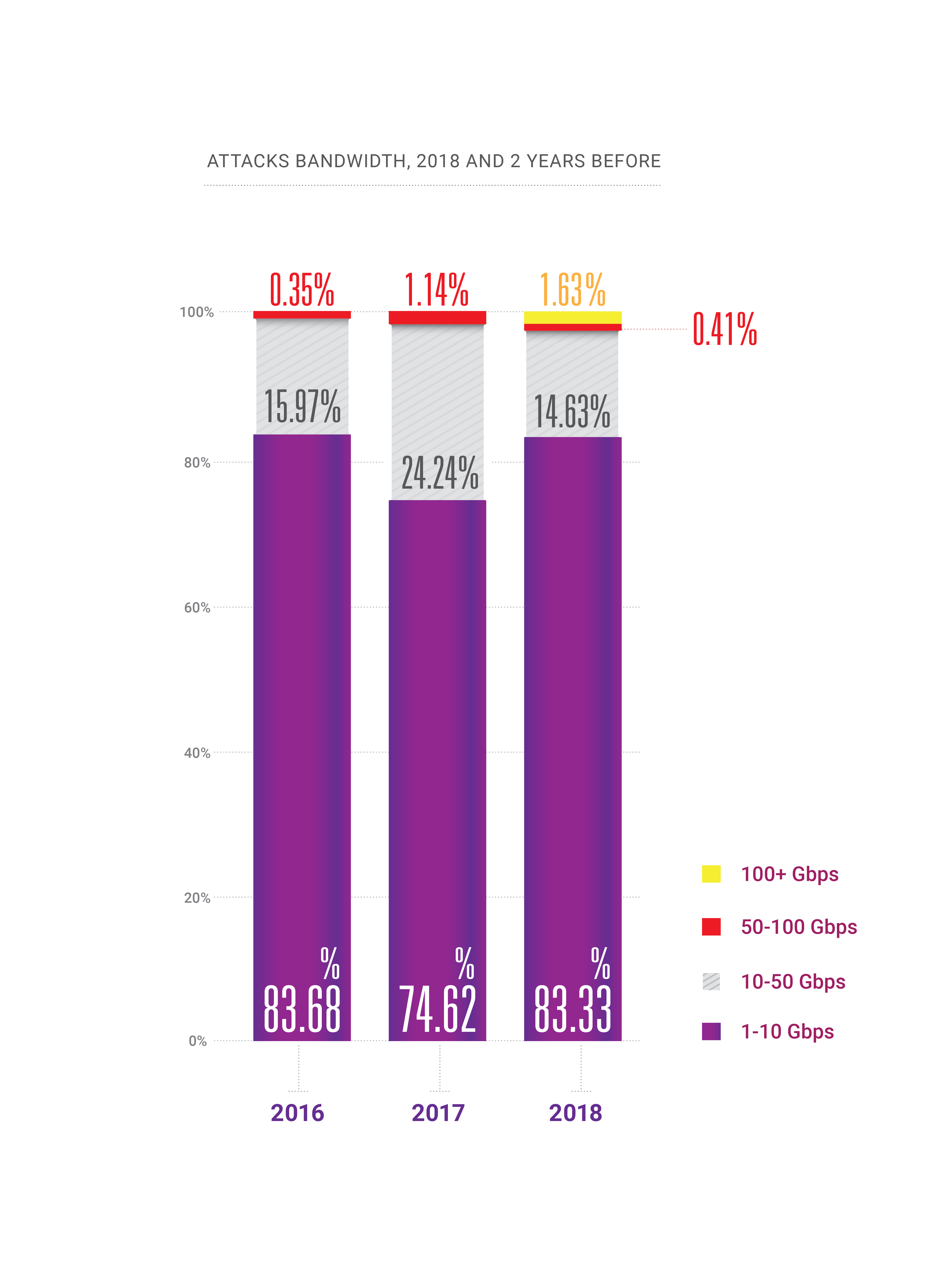

- En 2018, la capacité est apparue pour des attaques à des centaines de gigabits par seconde dans un pays ou une région, nous amenant au bord de la «théorie quantique de la relativité de la bande passante»;

- La fréquence des attaques DDoS continue de croître;

- La croissance continue des attaques compatibles HTTPS (SSL);

- Le PC est mort: la majeure partie du trafic légitime provient aujourd'hui des smartphones, ce qui représente aujourd'hui un défi pour les acteurs DDoS et serait le prochain défi pour les entreprises d'atténuation des DDoS;

- BGP est finalement devenu un vecteur d'attaque, 2 ans plus tard que prévu;

- La manipulation DNS est devenue le vecteur d'attaque le plus dommageable;

- D'autres nouveaux vecteurs d'amplification sont possibles, comme memcached & CoAP;

- Il n'y a plus d '«industries sûres» invulnérables aux cyberattaques de quelque nature que ce soit.

Dans cet article, nous avons essayé de sélectionner toutes les parties les plus intéressantes de notre rapport, mais si vous souhaitez lire la version complète en anglais, le

PDF est disponible .

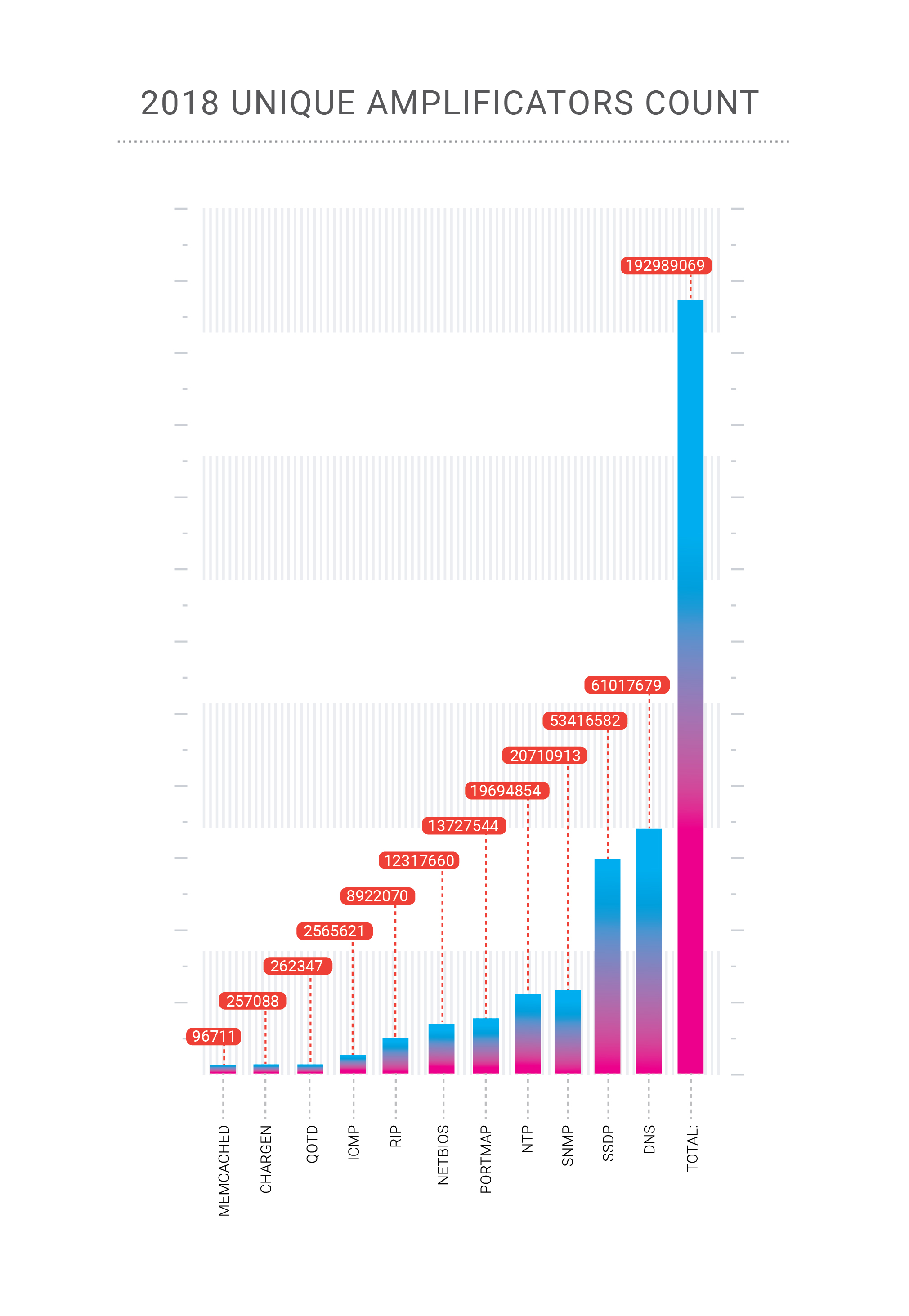

Rétrospective

En 2018, notre entreprise a «célébré» deux attaques record sur son réseau. Les attaques d'amplification Memcached, que nous avons décrites en détail fin février 2018, ont atteint 500 Gbps dans le cas de la plateforme de paiement Qiwi, un client de Qrator Labs. Puis, fin octobre, nous avons reçu une attaque d'amplification DNS très concentrée contre l'un de nos clients en Fédération de Russie.

L'amplification DNS est un vecteur d'attaque DDoS ancien et bien connu qui est principalement volumétrique et pose deux problèmes.En cas d'attaque de centaines de gigabits par seconde, il y a de fortes chances de surcharger notre canal en amont. Comment lutter contre cela? De toute évidence, nous devons répartir une telle charge entre de nombreux canaux, ce qui conduit au deuxième problème - une latence supplémentaire résultant de la modification du flux de trafic vers notre point de traitement. Heureusement, nous avons réussi à atténuer cette attaque particulière avec uniquement l'équilibrage de charge.

C'est là que l'équilibrage de charge flexible démontre sa vraie valeur, et puisque Qrator Labs gère un réseau BGP anycast, Radar modélise la répartition du trafic sur notre réseau après avoir ajusté l'équilibre de charge. BGP est un protocole de vecteur de distance, et nous connaissons ces états parce que le graphe de distance reste statique. En analysant ces distances et en considérant les LCP et les trajets multiples à coût égal, nous pouvons estimer le AS_path du point A au point B avec une grande confiance.

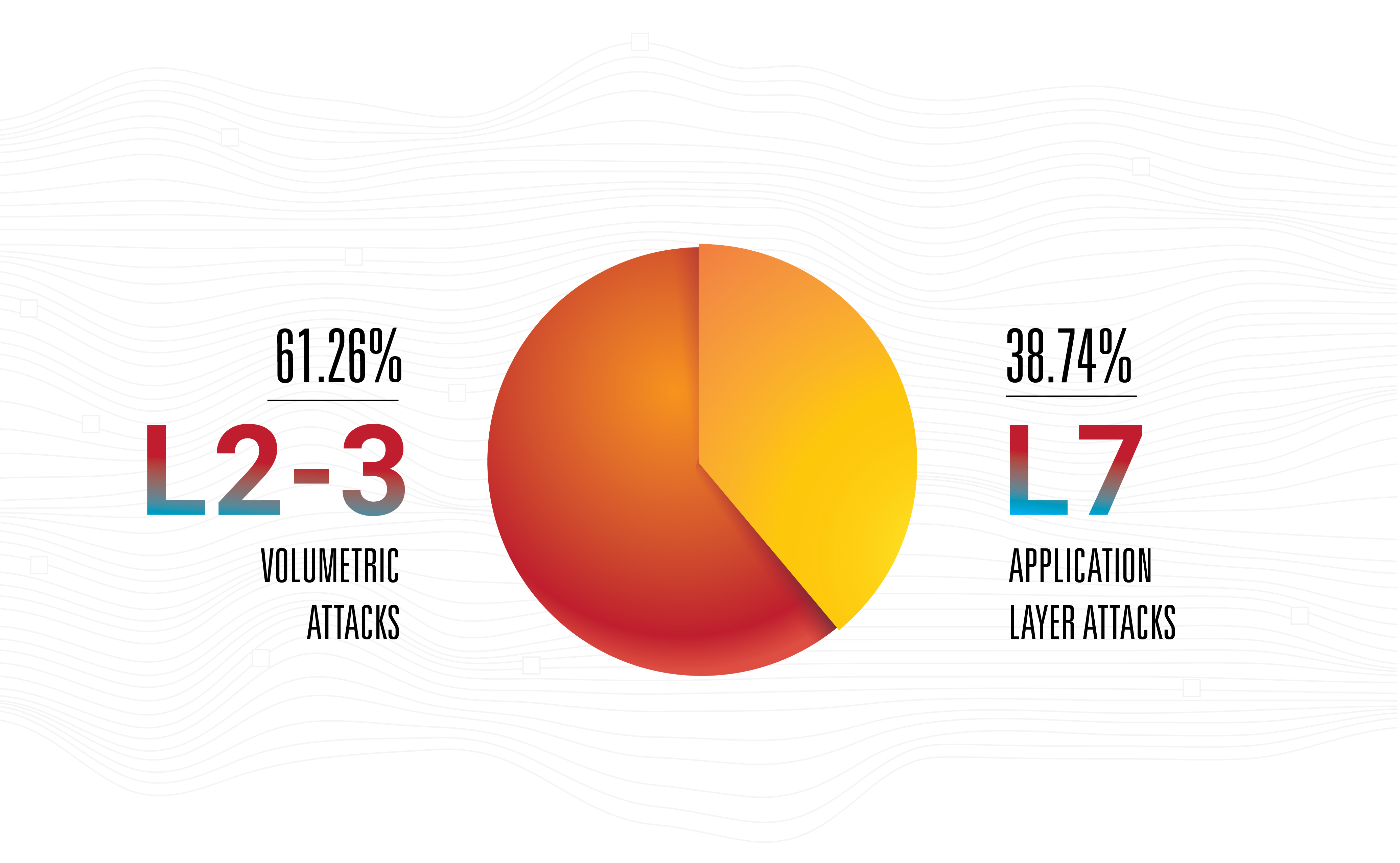

Cela ne veut pas dire que l'amplification est la menace la plus dangereuse - non, les attaques de couche application restent les plus efficaces, nerveuses et invisibles car la plupart d'entre elles sont à faible bande passante.

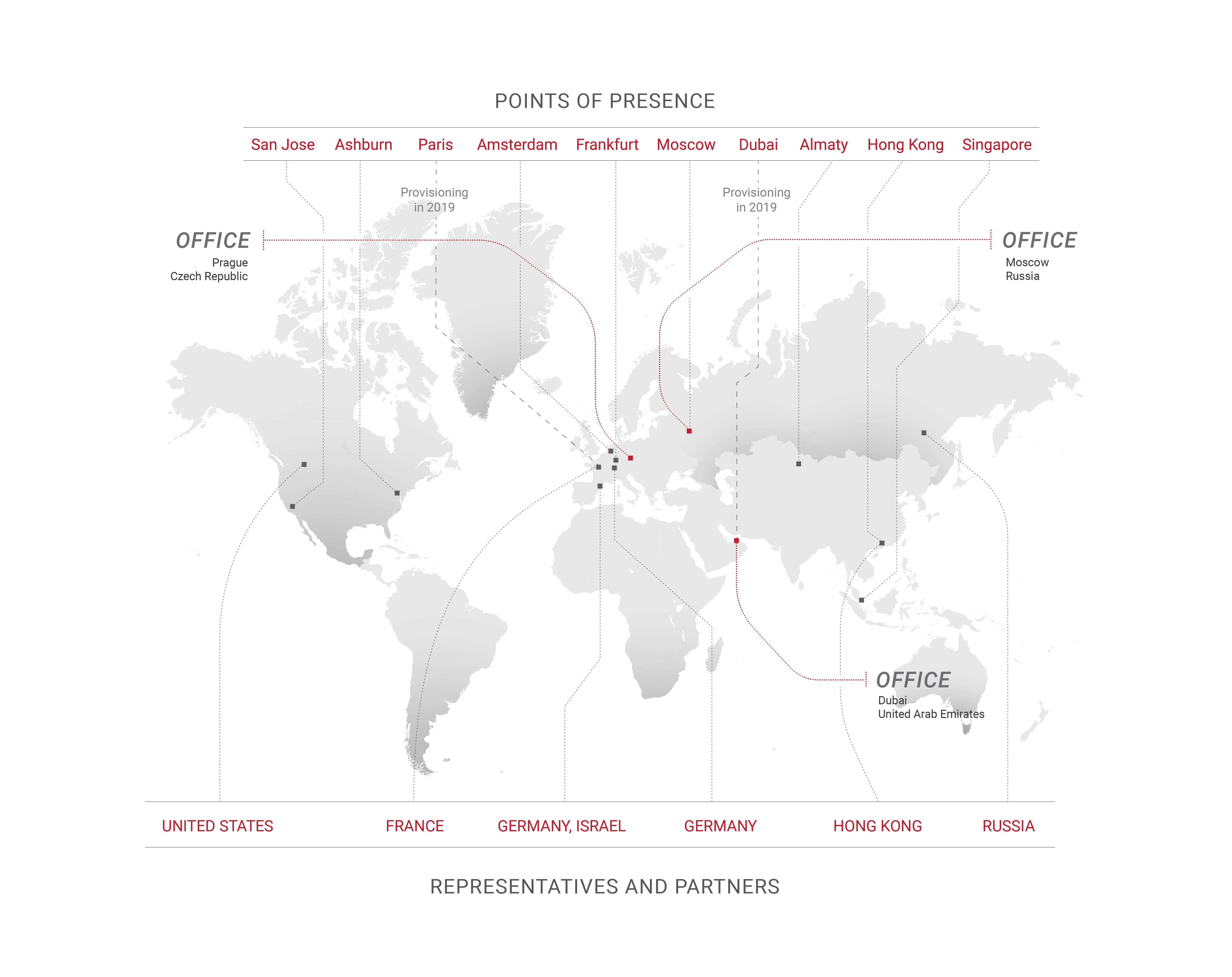

C'est la raison principale pour laquelle Qrator Labs améliore les connexions avec les opérateurs en fonction des points de présence, tout en élargissant également les zones de présence. C'est une étape naturelle pour tout opérateur de réseau de nos jours, en supposant que son nombre augmente. Cependant, du point de vue des attaquants, nous pensons qu'il est courant de collecter un botnet médiocre et de ne se concentrer ensuite que sur la recherche de la gamme la plus riche d'amplificateurs disponibles pour frapper de toutes les armes à feu, au taux de rechargement le plus élevé possible. Les attaques hybrides sont là, augmentant la bande passante, le taux de paquets et la fréquence.

Les botnets ont considérablement évolué en 2018 et leurs maîtres ont trouvé un nouvel emploi pour eux: la fraude aux clics. Avec l'essor de l'apprentissage automatique et des moteurs de navigation sans tête, la fraude par clic est devenue beaucoup plus facile à accomplir qu'il y a quelques années à peine.

Un site Web moyen d'aujourd'hui reçoit environ 50% à 65% de son trafic provenant d'appareils mobiles, de navigateurs de smartphones et d'applications. Pour certains services Web, ce chiffre est proche de 90% ou 100%, alors qu'un site Web de bureau uniquement est aujourd'hui une chose rare rencontrée principalement dans les environnements d'entreprise ou dans certains cas limites.

PC est pratiquement mort en 2019, ce qui rend certaines des approches habituelles, comme le suivi des mouvements de la souris, totalement inutiles pour le suivi et le filtrage des bots. En fait, non seulement le PC (avec tous les ordinateurs portables brillants et les ordinateurs de bureau tout-en-un) est rarement une source de partage de trafic majeur avec certains sites Web, mais il devient souvent plus qu'un simple délinquant. Parfois, il suffit de refuser l'accès à tout ce qui n'est pas un navigateur de smartphone approprié pour atténuer complètement une attaque de botnet, ce qui n'entraîne en même temps aucun impact négatif sur les principaux indicateurs de performance de l'entreprise.

Les auteurs de Botnet sont utilisés pour implémenter ou imiter le comportement des navigateurs de bureau dans leur code malveillant, tout comme les propriétaires de sites Web ont l'habitude de croire que les navigateurs PC comptent vraiment. Ce dernier a changé récemment, donc dans quelques années, il devrait aussi y avoir un changement dans le premier.

Nous avons déjà déclaré que rien n'avait changé de manière significative en 2018, mais le changement et les progrès ont maintenu un rythme soutenu. L'un des exemples les plus significatifs est le Machine Learning, où des améliorations ont été particulièrement évidentes, en particulier dans le domaine des réseaux adverses génératifs. Lentement, mais régulièrement, ML atteint le marché de masse. Le monde du machine learning est devenu plus accessible et, à la fin de l'année, il n'est plus réservé aux universitaires.

Nous nous attendions à voir les premières attaques DDoS basées sur ML (ou autrement liées) d'ici le début de 2019, mais cela ne s'est toujours pas produit. Nous nous attendons à un tel développement en raison du faible coût des données générées par ML en ce moment, mais apparemment, ce n'est pas assez bas.

Si vous pensez à l'état actuel de l'industrie «humaine automatisée», mettre le neuro-réseau au-dessus de cela n'est pas une mauvaise idée. Un tel réseau apprendrait un véritable comportement humain dans le contexte de la gestion du contenu d'une page Web. C'est quelque chose que tout le monde appellerait «expérience utilisateur de l'IA» et, bien sûr, un tel réseau équipé d'un moteur de navigation pourrait produire un arsenal très intéressant pour les deux parties, l'attaque et la défense.

Bien sûr, l'enseignement du réseau coûte cher, mais la distribution et l'externalisation d'un tel système pourraient être très abordables et, éventuellement, gratuites, en particulier si des logiciels malveillants, des applications piratées, etc. sont envisagés. Potentiellement, un tel changement pourrait affecter l'ensemble de l'industrie, de la même manière que les GAN ont transformé ce que nous pensons de la «réalité visuelle» et de la «fiabilité».

Étant donné qu'il s'agit également d'une course entre les moteurs de recherche avec Google en premier lieu et tous les autres essayant de rétroconcevoir les algorithmes, cela pourrait atteindre une situation où un bot imiterait non pas un être humain au hasard, mais une personne spécifique, comme celle habituellement assis derrière un ordinateur vulnérable sélectionné. Les versions de Captcha et Recaptcha pourraient servir d'exemples de la façon dont les attaquants améliorent leurs outils et leurs techniques d'attaque.

Après le memcached, il a été beaucoup question de la possibilité d'une nouvelle classe d'arme d'attaque DDoS - une vulnérabilité, un bot, un service compromis, quelque chose qui pourrait éternellement envoyer des données particulières à une adresse spécifique choisie par l'attaquant. Une commande de l'attaquant pourrait libérer un flux continu et perpétuel de trafic, comme syslog ou une inondation massive. Ce n'est qu'une théorie. Nous ne pouvons pas dire si de tels serveurs ou appareils existent réellement, mais s'ils le font, ce serait un euphémisme de dire qu'ils pourraient représenter une arme extrêmement dangereuse entre de mauvaises mains.

En 2018, nous avons également constaté un intérêt accru pour la gouvernance d'Internet et des services associés de toutes sortes de gouvernements et d'organismes sans but lucratif du monde entier. Nous considérons cela comme une évolution neutre jusqu'au point où les libertés fondamentales pourraient être supprimées, ce qui, nous l'espérons, ne se produira pas, en particulier dans les pays développés.

Après des années de collecte et d'analyse du trafic d'attaque à l'échelle mondiale, Qrator Labs met désormais en œuvre le premier bloc de demande. Les modèles que nous utilisons pour prédire les comportements malveillants nous permettent de déterminer avec une grande confiance si un utilisateur est légitime ou non. Nous adhérons à notre philosophie centrale d'une expérience utilisateur ininterrompue, sans défis JavaScript ni captchas et en 2019, nous espérons atteindre la capacité de bloquer la première demande malveillante de violer nos défenses.

Mellanox

Nous avons choisi les commutateurs 100G Mellanox à la suite de nos tests internes des années précédentes. Nous sélectionnons toujours des équipements qui répondent à nos besoins dans des situations spécifiques. Tout d'abord, les commutateurs ne doivent pas laisser tomber de petits paquets tout en travaillant au débit de ligne - il ne peut y avoir aucune dégradation du tout. Deuxièmement, nous avons aimé le prix. Mais ce n'est pas tout. Le coût est toujours justifié par la façon dont le fournisseur réagit à vos spécifications.

Les commutateurs Mellanox fonctionnent sous Switchdev, transformant leurs ports en interfaces Linux ordinaires. Faisant partie du noyau Linux traditionnel, Switchdev est décrit dans la documentation comme «un modèle de pilote dans le noyau pour les périphériques de commutation qui déchargent le plan de données de transfert du noyau». Cette approche est très pratique, car tous les outils que nous avons utilisés sont disponibles sous une seule API, ce qui est extrêmement naturel pour tout programmeur, développeur et ingénieur réseau moderne. Tout programme, qui utilise l'API de mise en réseau Linux standard, peut être exécuté sur le commutateur. Tous les outils de surveillance et de contrôle du réseau conçus pour les serveurs Linux, y compris ceux faits maison, sont disponibles. Par exemple, l'implémentation de modifications dans la table de routage est beaucoup plus confortable par rapport à la façon dont cela a été fait avant Switchdev. Jusqu'au niveau de la puce réseau, tout le code est visible et transparent, ce qui permet d'apprendre et d'apporter des modifications, jusqu'au moment précis où il faut savoir exactement comment la puce est construite, ou du moins l'interface externe.

Un appareil Mellanox sous le contrôle de Switchdev est la combinaison que nous avons trouvée la plus appropriée à nos besoins, car la société fournit un support complet pour le système d'exploitation open source déjà robuste prêt à l'emploi.

Lors du test de l'équipement avant de le faire fonctionner en production, nous avons découvert qu'une partie du trafic transféré était supprimée. Notre enquête a montré qu'il était causé par le trafic sur une interface qui était acheminée via le processeur de contrôle, qui bien sûr ne pouvait pas en gérer de gros volumes. Nous ne connaissions pas la cause exacte d'un tel comportement, mais nous supposions qu'il était lié à la gestion des redirections ICMP. Mellanox a confirmé la cause du problème et nous leur avons demandé de faire quelque chose. Mellanox a réagi rapidement, nous fournissant une solution de travail à court terme.

Excellent travail, Mellanox!

Protocoles et open source

DNS-over-HTTPS est une technologie plus complexe que DNS-over-TLS. Nous voyons la première fleurir et la dernière lentement oubliée. C'est un exemple clair où «plus complexe» signifie «plus efficace», car le trafic DoH ne se distingue pas de tout autre HTTPS. Nous l'avons déjà vu avec l'intégration des données RPKI, lorsqu'elle était initialement positionnée comme une solution anti-piratage et n'a pas bien fonctionné, mais est ensuite réapparue comme une arme puissante contre les erreurs telles que les fuites statiques et les configurations de routage incorrectes. Le bruit transformé en signal et maintenant RPKI est pris en charge sur les plus grands IX, ce qui est une excellente nouvelle.

TLS 1.3 est arrivé. Qrator Labs, ainsi que l'industrie informatique dans son ensemble, ont suivi de près le processus de développement, de l'ébauche initiale à toutes les étapes de l'IETF, pour devenir un protocole compréhensible et gérable que nous sommes prêts à prendre en charge en 2019. Le soutien est déjà évident sur le marché, et nous voulons suivre le rythme de la mise en œuvre de ce protocole de sécurité robuste et éprouvé. Nous ne savons pas comment les producteurs de matériel d'atténuation des DDoS s'adapteront aux réalités TLS 1.3, mais, en raison de la complexité technique de la prise en charge des protocoles, cela pourrait leur prendre un certain temps.

Nous suivons également HTTP / 2. Pour l'instant, Qrator Labs ne prend pas en charge la nouvelle version du protocole HTTP, en raison de la base de code existante autour de ce protocole. Les bogues et les vulnérabilités se trouvent encore assez fréquemment dans le nouveau code; en tant que fournisseur de services de sécurité, nous ne sommes pas encore prêts à prendre en charge un tel protocole dans le cadre du SLA que nous convenons avec nos consommateurs.

La vraie question de 2018 pour Qrator Labs était: «Pourquoi les gens veulent-ils autant HTTP / 2? Et cela a fait l'objet de vifs débats tout au long de l'année. Les gens ont toujours tendance à considérer le chiffre «2» comme la version «plus rapide, plus forte, meilleure», ce qui n'est pas nécessairement le cas dans tous les aspects de ce protocole particulier. Cependant, DoH recommande HTTP / 2 et c'est là que les deux protocoles peuvent obtenir beaucoup d'élan.

Le développement des suites de protocoles et des fonctionnalités de la prochaine génération est une préoccupation qui dépend généralement de la recherche universitaire, et l'état de celui-ci pour l'industrie de l'atténuation des DDoS est assez médiocre. La section 4.4 du projet de l'IETF «QUIC manageability», qui fait partie de la future suite de protocoles QUIC, pourrait être considérée comme un parfait exemple de cela: elle déclare que «les pratiques actuelles de détection et d'atténuation des [attaques DDoS] impliquent généralement des mesure à l'aide de données de flux réseau », ces dernières étant en fait très rarement un cas dans des environnements d'entreprise réels (et seulement en partie pour les configurations de FAI) - et en aucune façon à peine un« cas général »dans la pratique - mais certainement un cas général dans des documents de recherche universitaire qui, la plupart du temps, ne sont pas soutenus par des implémentations appropriées et des tests réels contre toute la gamme d'attaques DDoS potentielles, y compris celles de la couche application (qui, en raison des progrès du déploiement mondial de TLS, ne pourraient évidemment jamais être manipulé avec tout type de mesure passive). Définir une tendance de recherche universitaire appropriée est un autre défi pour les opérateurs d'atténuation des DDoS en 2019.

Switchdev a pleinement répondu aux attentes que nous avions exprimées il y a un an. Nous espérons que le travail continu pour améliorer Switchdev se renforcera dans les années à venir, car la communauté est forte et en croissance.

Qrator Labs poursuit avec l'activation de Linux XDP pour aider à augmenter encore l'efficacité du traitement des paquets. Décharger certains modèles de filtrage du trafic malveillant du processeur vers la carte réseau, et même vers le commutateur réseau, semble très prometteur, et nous sommes impatients de poursuivre nos recherches et développement dans ce domaine.

Plongée profonde avec des bots

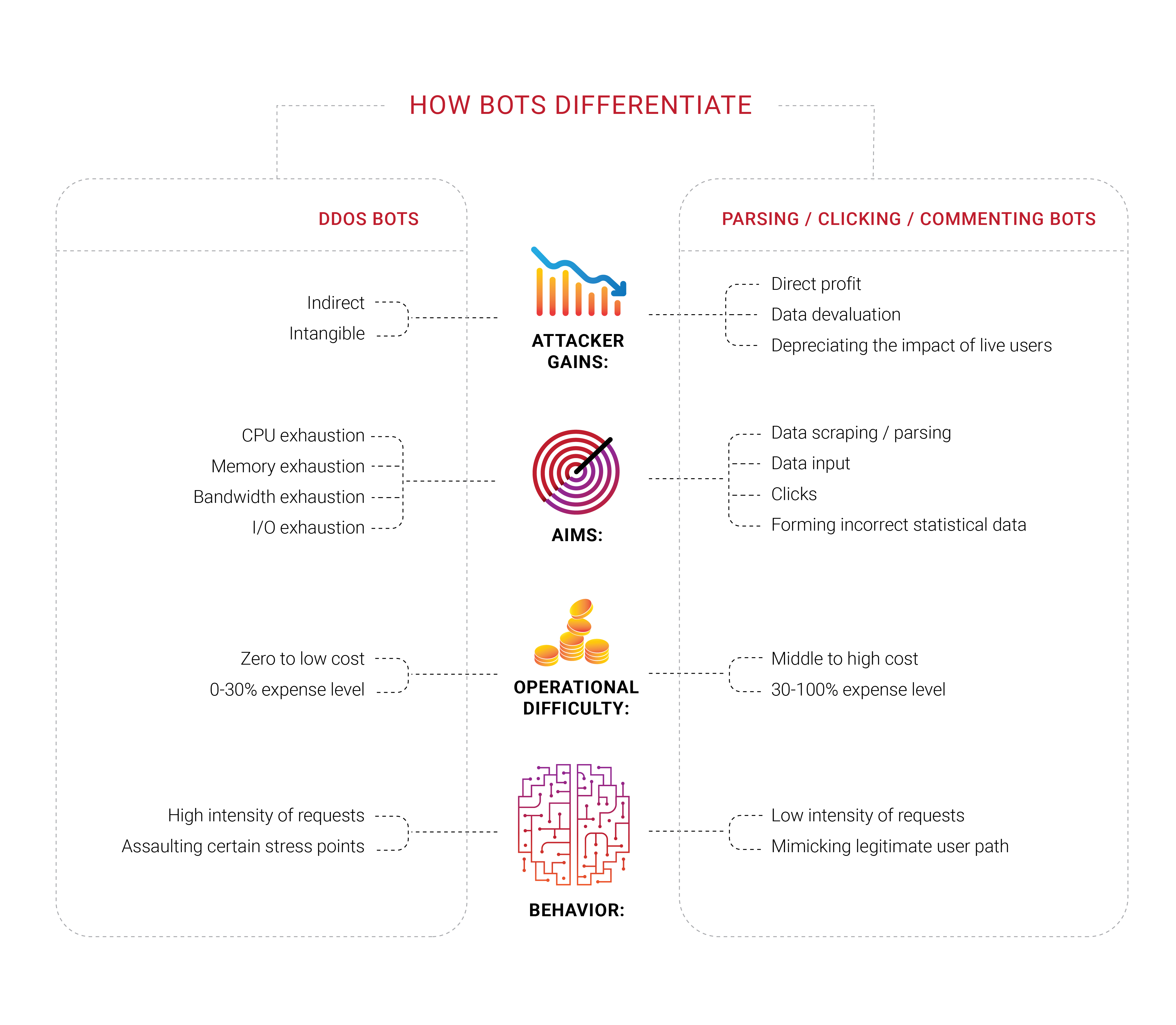

De nombreuses entreprises recherchent la protection des bots, et il n'est pas surprenant que nous ayons vu des groupes travailler dans différents domaines de ce domaine en 2018. Ce que nous avons trouvé intéressant, c'est qu'une grande partie de ces entreprises n'ont jamais subi d'attaque DDoS ciblée, du moins un déni typique de tentative de service pour drainer des ressources limitées comme la bande passante ou la capacité du processeur. Ils se sentent menacés par les bots mais ne peuvent pas les distinguer des utilisateurs réels ou déterminer ce qu'ils font réellement. Ils savent juste qu'ils veulent se débarrasser des robots perçus.

Les problèmes avec les robots et les grattoirs ont également une composante économique importante. Si 30% du trafic est illégitime et d'origine machine, alors 30% des coûts de prise en charge de ce trafic sont gaspillés. Aujourd'hui, cela peut être considéré comme une taxe supplémentaire inévitable sur les entreprises Internet. Il est difficile de réduire le nombre exactement à zéro, mais les propriétaires d'entreprises préféreraient le voir aussi bas que possible.

L'identification devient un problème important dans Internet d'aujourd'hui, car les meilleurs robots n'ont plus à imiter les êtres humains - ils occupent le même espace, comme les parasites. Nous répétons depuis un certain temps que toute information disponible publiquement, sans autorisation ni authentification, est et finirait comme un bien commun - personne ne pourrait empêcher cela.

En 2018, nous nous sommes concentrés sur les problèmes d'identité et de gestion des bots. Cependant, la portée plus large ici est différente; nous vivons à une époque où il n'y a aucun moyen exact de connaître la raison pour laquelle un client demande la réponse du serveur. Vous avez bien lu: en fin de compte, chaque entreprise veut qu'un client achète quelque chose, c'est la raison d'être et l'objectif, donc certaines entreprises veulent regarder plus en profondeur qui demande quoi au serveur - s'il y a une vraie personne derrière.

Il n'est pas étonnant que les propriétaires d'entreprise apprennent souvent des techniciens qu'une partie importante du trafic de leur site Web provient des robots, et non des clients.

Les humains automatisés que nous avons mentionnés plus tôt pourraient également cibler une ressource réseau spécifique avec un module complémentaire de navigateur installé - et nous pensons que la plupart de ces extensions sont installées à dessein, pour poursuivre un objectif spécifique, connu uniquement des créateurs de ces réseaux. Fraude aux clics, manipulation des publicités, analyse - de telles tâches sont efficacement accomplies avec l'aide de vrais êtres humains au moment où l'automatisation échoue. Imaginez simplement comment la situation changerait si l'apprentissage automatique était appliqué au bon maillon de la chaîne.

Les analyseurs et les grattoirs, qui font partie du problème plus large des robots, sont devenus un problème dans lequel nous avons plongé en 2018, tout d'abord grâce à nos clients, qui nous ont approchés de leurs expériences et ont offert la possibilité d'enquêter davantage sur ce qui se passait avec leurs ressources. Ces bots peuvent même ne pas s'enregistrer sur des mesures typiques, comme la bande passante ou la charge CPU du serveur. Nous testons actuellement une variété d'approches, mais en fin de compte, il est clair que les clients ont besoin - de bloquer ces intrus à leur première demande.

Pendant l'épidémie de grattage que nous avons vue en Russie et dans la CEI, il est devenu clair que les bots impliqués sont capables de chiffrement. Une demande par minute est un taux qui pourrait facilement passer inaperçu sans analyse des demandes de trafic entrant. À notre humble avis, le client doit décider de la prochaine étape après avoir obtenu notre analyse et notre balisage. Que ce soit pour les bloquer, les laisser passer ou les usurper (induire en erreur) - ce n'est pas à nous de décider.

Cependant, certains problèmes existent avec les automatisations pures, ou «bots», comme nous avons l'habitude de les appeler. Si vous êtes certain que le bot malveillant a généré une demande spécifique, la première chose à faire est de la bloquer, sans envoyer de réponse du serveur. Nous sommes arrivés à la conclusion que cela était insensé car de telles actions ne font que donner plus de rétroaction à l'automatisation, lui permettant de s'adapter et de trouver une solution de contournement. À moins que les robots ne tentent une attaque par déni de service, nous vous recommandons de ne pas bloquer ces automatisations tout de suite, car le résultat de ces jeux de chat et de souris ne pourrait être rien de plus qu'une grande perte de temps et d'efforts.

C'est la principale raison pour laquelle Qrator Labs choisit de marquer le trafic suspect et / ou malveillant et de laisser la décision sur les prochaines étapes au propriétaire de la ressource en tenant compte de son public, de ses services et de ses objectifs commerciaux. Un tel exemple est l'extension de navigateur bloquant les publicités. La plupart des annonces sont des scripts et en bloquant les scripts, vous ne bloquez pas nécessairement les annonces et vous pouvez bloquer autre chose, comme un défi javascript. Il est facile d'imaginer comment cela pourrait dégénérer, entraînant une perte de revenus pour un grand groupe d'entreprises Internet.

Lorsque les attaquants sont bloqués et reçoivent les commentaires dont ils ont besoin, ils peuvent rapidement s'adapter, réapprendre et attaquer. Les technologies de Qrator Labs sont construites sur la philosophie simple selon laquelle l'automatisation ne peut pas recevoir de commentaires qu'ils peuvent utiliser: vous ne devez ni les bloquer ni les transmettre, il suffit de les marquer. Après que de telles notes soient faites, vous devriez considérer leur véritable objectif - Que veulent-ils? et pourquoi visitent-ils cette ressource ou cette page Web spécifique? Peut-être pourriez-vous modifier légèrement le contenu de la page Web d'une manière qu'aucun humain ne ressentirait la différence, mais la réalité du robot se retournerait-elle? S'ils sont des analyseurs, ils peuvent obtenir des informations d'analyse trompeuses sous la forme de données incorrectes.

En discutant de ces problèmes tout au long de 2018, nous avons qualifié ces attaques d'attaque simple des mesures commerciales. Votre site Web et vos serveurs peuvent sembler corrects, sans plaintes d'utilisateurs, mais vous ressentez quelque chose qui change ... comme le prix CPA d'une annonce que vous prenez lentement sur une plate-forme de programmation, mais qui oriente régulièrement les annonceurs ailleurs.

Tuer l'incitation des attaquants est le seul moyen de contrer cela. Essayer d'arrêter les robots ne se traduit que par une perte de temps et d'argent. S'ils cliquent sur quelque chose dont vous bénéficiez, rendez ces clics inefficaces; S'ils vous analysent, fournissez des informations non fiables qu'ils ne distingueront pas des données légitimes et fiables.

Clickhouse

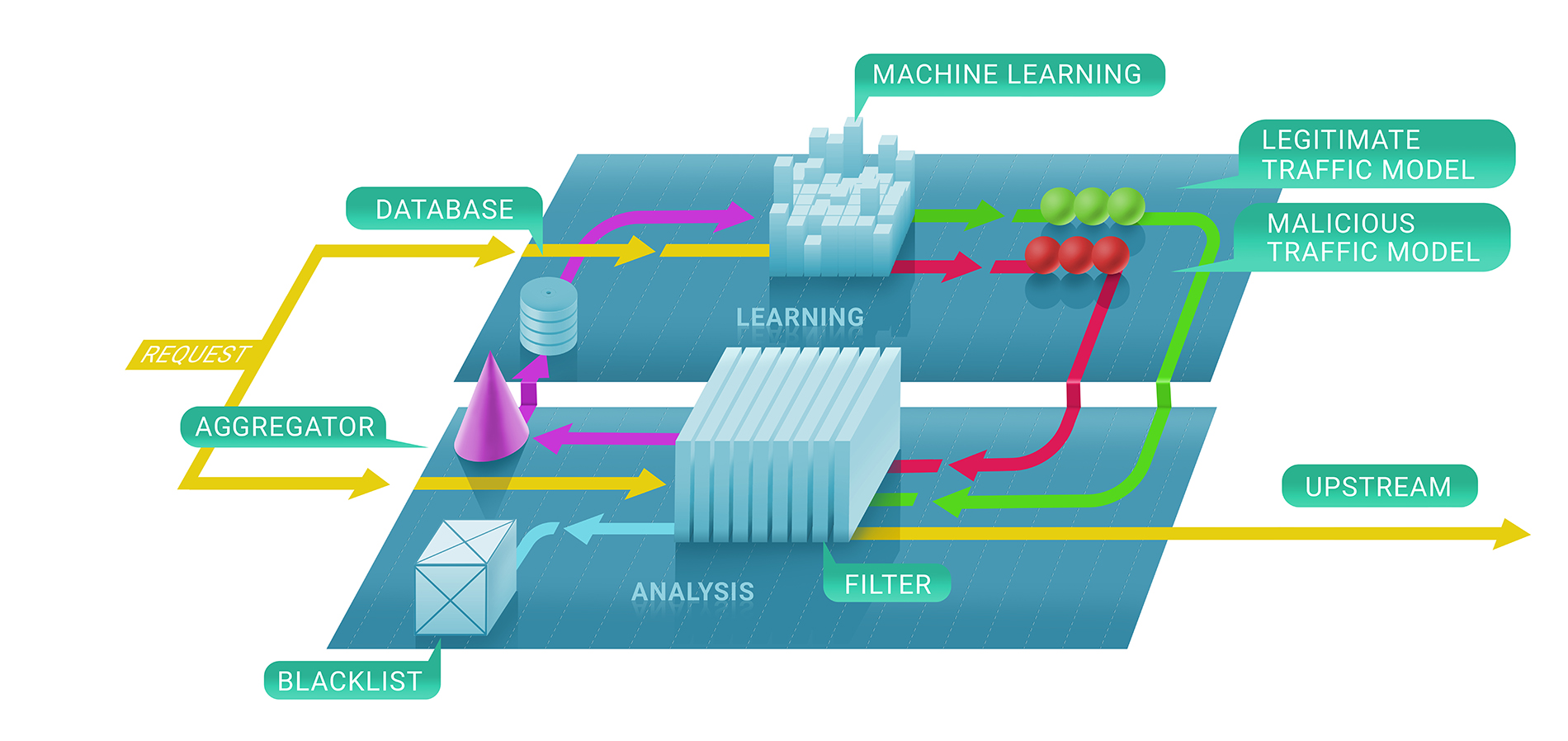

En général, le service de filtrage de Qrator Labs comprend deux étapes: premièrement, nous évaluons immédiatement si une demande est malveillante à l'aide de contrôles sans état et avec état, et, deuxièmement, nous décidons de conserver ou non la source sur liste noire et pendant combien de temps. La liste noire résultante pourrait être représentée comme la liste d'adresses IP uniques.

Dans la première étape de ce processus, nous utilisons des techniques d'apprentissage automatique pour mieux comprendre le flux naturel de trafic pour une ressource donnée, car nous paramétrons le service pour chaque client individuellement en fonction des données que nous collectons.

C'est là que Clickhouse entre en jeu. Pour comprendre précisément pourquoi une adresse IP a été interdite de communiquer avec une ressource, nous devons suivre le modèle d'apprentissage automatique jusqu'à Clickhouse DB. Il fonctionne très rapidement avec de gros blocs de données (pensez à une attaque DDoS à 500 Gbit / s, se poursuivant pendant quelques heures entre les pauses), et les stocke de manière naturellement compatible avec les cadres d'apprentissage automatique que nous utilisons chez Qrator Labs. Plus de journaux et plus de trafic d'attaque conduisent à des résultats meilleurs et plus robustes de nos modèles à utiliser pour affiner davantage le service en temps réel, sous les attaques les plus dangereuses.

Nous utilisons la base de données Clickhouse pour stocker tous les journaux de trafic d'attaque (illégitimes) et les modèles de comportement des bots. Nous avons implémenté cette solution spécifique car elle promettait une capacité impressionnante pour traiter rapidement des ensembles de données massifs dans un style de base de données. Nous utilisons ces données pour l'analyse et pour construire les modèles que nous utilisons dans le filtrage DDoS et pour appliquer l'apprentissage automatique pour améliorer les algorithmes de filtrage.

Un avantage important de Clickhouse, par rapport aux autres bases de données, est qu'il ne lit pas la chaîne de données entière - il ne pourrait prendre que le segment nécessaire, beaucoup plus petit, si vous stockez tout selon les directives.

Conclusion

Depuis un certain temps, nous vivons avec des attaques multifactorielles qui explorent plusieurs protocoles d'attaque pour rendre une cible indisponible.

L'hygiène numérique et des mesures de sécurité à jour devraient et pourraient couvrir 99% des risques réels qu'une entité individuelle est susceptible de rencontrer, à l'exception des cas extrêmes ou délibérément ciblés, et empêcher un service Internet «moyen» de rencontrer des problèmes.

D'un autre côté, les attaques DDoS sont capables de couper la connexion Internet de n'importe quel pays du monde, bien que seuls quelques-uns puissent être efficacement ciblés de l'extérieur. Ce n'est pas le cas dans le BGP, où il est possible de fermer uniquement un certain nombre de points sur n'importe quelle carte que vous souhaitez dessiner.

La connaissance de la sécurité du réseau continue de croître, ce qui est excellent. Néanmoins, une fois que vous regardez les nombres liés aux amplificateurs dans les réseaux ou les options pour usurper quelqu'un d'autre - ils ne baissent pas! En effet, chaque année, le temps que les élèves passent dans une école de sécurité Internet, c'est-à-dire les personnes qui commencent à se soucier de la façon dont ils écrivent du code et créent leurs applications, ne correspond pas au temps nécessaire pour s'assurer qu'ils ne font pas de vulnérabilités qui autoriser quelqu'un à utiliser ces ressources pour organiser une attaque DDoS réussie, ou pire.

L'une des conclusions les plus importantes de 2018 est que la plupart des gens attendent encore beaucoup plus de la technologie que ce qui peut être fourni actuellement. Ce n'était pas toujours le cas, mais en ce moment, nous voyons une forte tendance à en demander trop, quelles que soient les fonctionnalités logicielles ou matérielles. Les gens attendent toujours plus, ce qui ne changera probablement pas en raison des promesses faites dans les campagnes marketing. Cependant, les gens achètent ces promesses, et les entreprises estiment qu'elles devraient s'efforcer de les respecter.

C'est peut-être la nature du progrès et de l'évolution. De nos jours, les gens se sentent frustrés et déçus de ne pas avoir ce qu'ils étaient «garantis» et ce pour quoi ils avaient payé. Donc, c'est là que les problèmes actuels proviennent, où nous ne pouvons pas acheter «entièrement» un appareil et tous ses logiciels qui feront ce que nous voulons, ou où les services «gratuits» ont un prix élevé en termes de données personnelles .

Le consumérisme nous dit que nous voulons quelque chose et que nous devons le payer de notre vie. Avons-nous besoin des types de produits ou de services qui se mettent à niveau pour nous vendre de meilleures offres à l'avenir sur la base des données qu'ils ont recueillies sur nous d'une manière que nous n'aimons peut-être pas? Nous pourrions prévoir qu'en 2019, après les cas d'Equifax et de Cambridge Analytica, nous pourrions assister à une explosion finale de l'acquisition et de l'abus de données personnelles.

Après dix ans, nous n'avons pas changé nos convictions fondamentales sur l'architecture du réseau interconnecté. C'est la raison pour laquelle nous continuons à défendre les principes les plus fondamentaux du réseau de filtrage Qrator Labs - BGP-anycast, la capacité de traiter le trafic crypté, l'évitement des captchas et d'autres obstacles, plus de visibilité pour les utilisateurs légitimes par rapport aux bots attaquants.

En regardant ce qui continue de se produire avec les experts en cybersécurité et les entreprises dans le domaine, nous voulons souligner un autre problème: en matière de sécurité, aucune approche naïve, simple ou rapide n'est applicable.

C'est la principale raison pour laquelle Qrator Labs n'a pas des centaines, voire des dizaines de points de présence, par rapport aux CDN. En maintenant un plus petit nombre de centres de nettoyage tous connectés aux FAI de niveau 1, nous réalisons une véritable décentralisation du trafic. C'est aussi la raison pour laquelle nous n'essayons pas de construire des pare-feu, qui sont entièrement différents de ce que fait Qrator Labs - la connectivité.

Nous racontons des histoires sur les captchas et les tests et vérifications javascript depuis un certain temps et nous y sommes - les réseaux de neurones deviennent extrêmement utiles pour résoudre le premier, et le second n'a jamais été un problème pour l'attaquant qualifié et persistant.

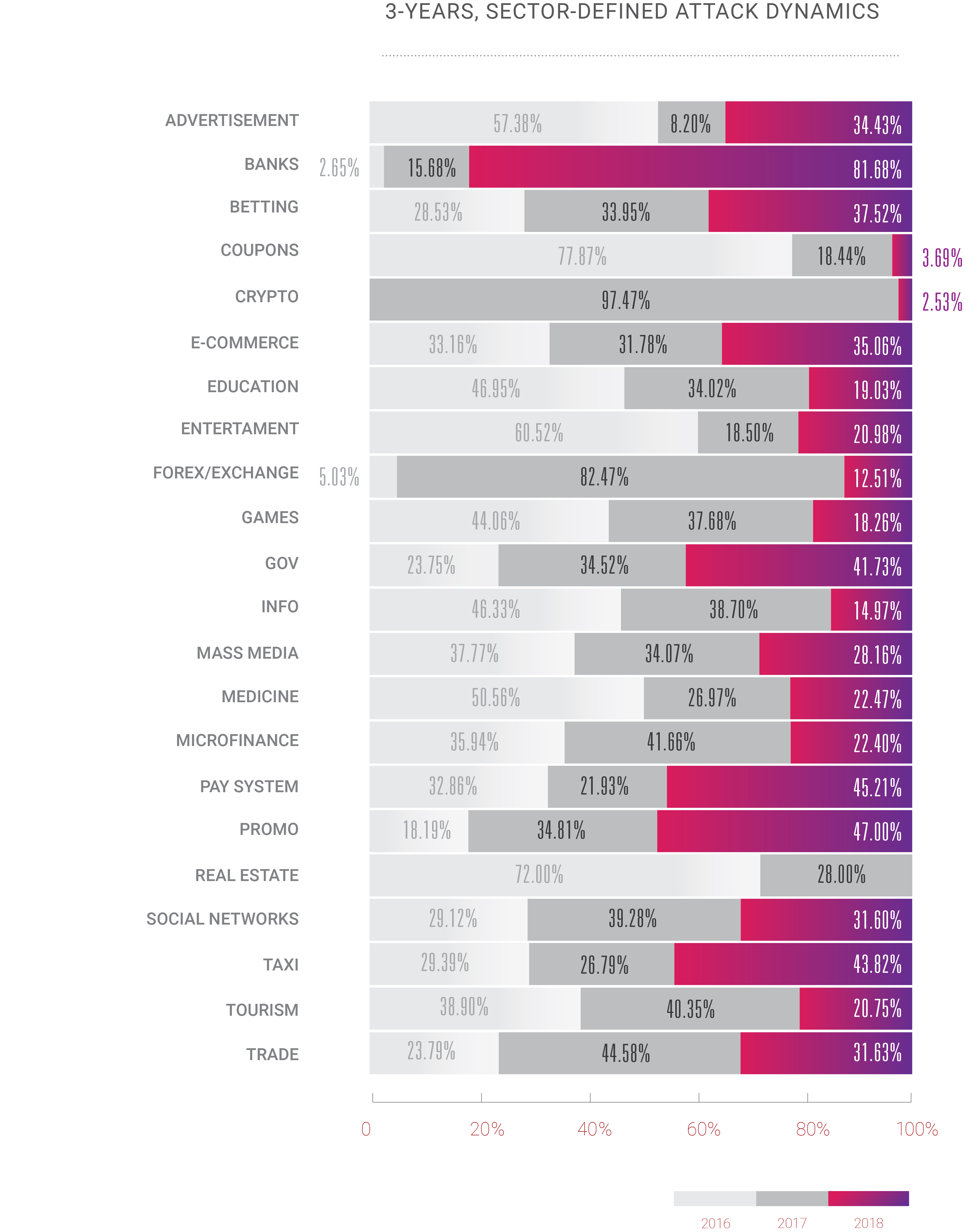

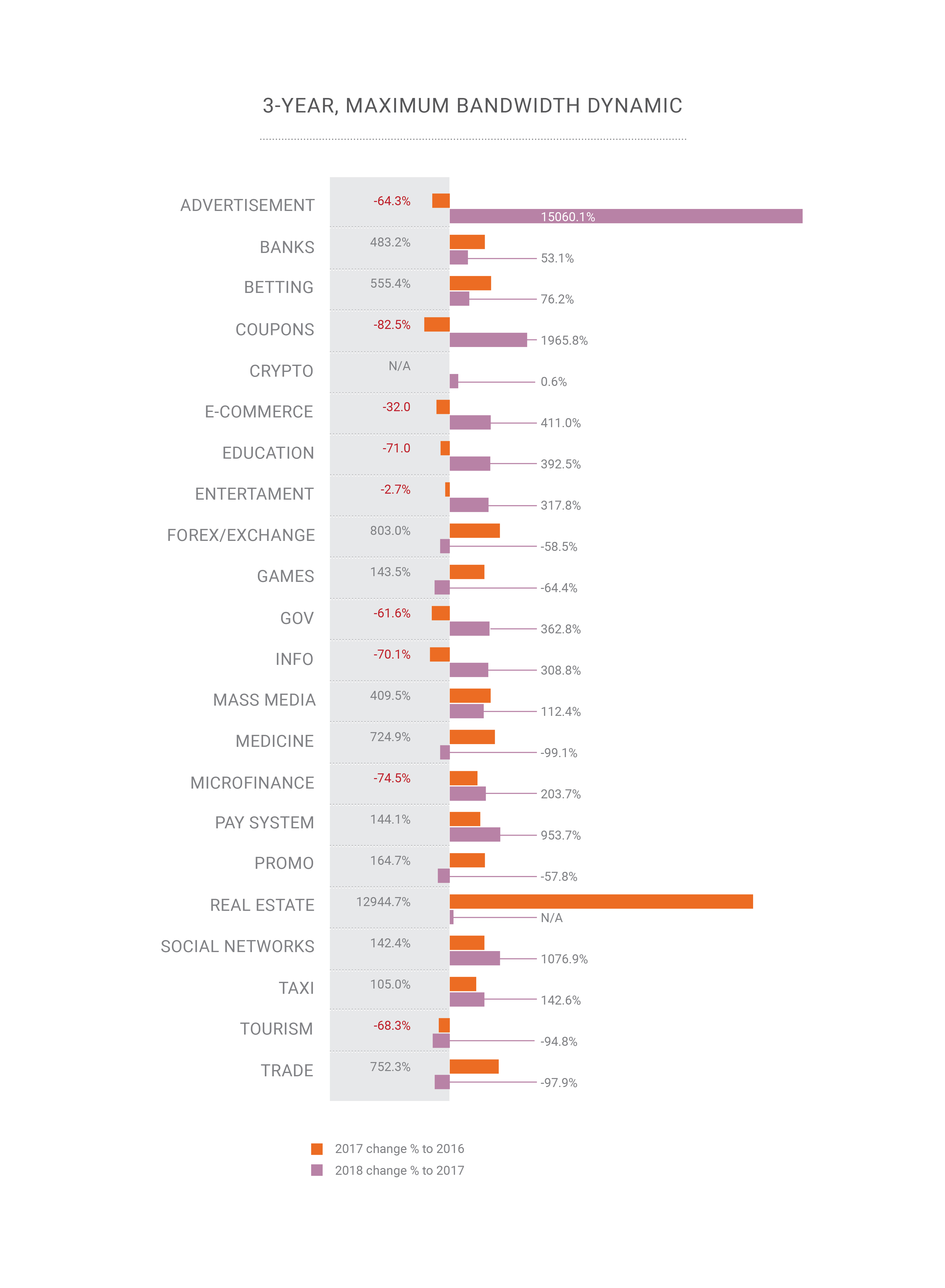

Cette année, nous avons également ressenti un changement plutôt excitant: pendant des années, le DDoS n'a été un problème que pour un nombre limité de secteurs d'activité, généralement ceux où l'argent est au-dessus du niveau de l'eau: commerce électronique, commerce / actions, systèmes bancaires / de paiement. Cependant, avec la croissance continue d'Internet, nous observons que des attaques DDoS sont désormais appliquées à tous les autres services Internet disponibles. L'ère DDoS a commencé avec l'augmentation de la bande passante et du nombre d'ordinateurs personnels utilisés dans le monde; il n'est pas surprenant qu'en 2018, avec des puces en silicium dans chaque appareil autour de nous, le paysage des attaques évolue si vite.

Si quelqu'un s'attend à ce que cette tendance change, il se trompe probablement. Tout comme nous le sommes peut-être aussi. Personne ne peut dire comment Internet va réellement évoluer et diffuser son impact et sa puissance dans les années à venir, mais selon ce que nous avons vu en 2018 et continuons d'observer en 2019, tout va se multiplier. D'ici 2020, le nombre d'appareils connectés sur Internet devrait dépasser les 30 milliards, outre le fait que nous avons déjà dépassé le point où l'humanité a généré plus de trafic que l'automatisation qu'elle a créée. Donc, bientôt, nous devrons décider comment gérer toute cette «intelligence», artificielle ou non, car nous vivons toujours dans un monde où seul un être humain peut être responsable de quelque chose de bien, de mal.

2018 a été une année d'opportunités pour ceux du côté obscur. Nous constatons une croissance des attaques et des hacks en termes de complexité, de volume et de fréquence. Les escrocs ont obtenu des outils puissants et ont appris à les utiliser. Les gentils ont fait un peu plus que regarder ces développements. Nous espérons voir ce changement cette année, du moins sur les questions les plus douloureuses.