Les réseaux de neurones sont connus pour leur incompréhensibilité - l'ordinateur peut donner une bonne réponse, mais ne peut pas expliquer ce qui l'a conduit à cette conclusion. Bin Kim développe un «traducteur humain» pour que si l'intelligence artificielle tombe en panne, nous pouvons le comprendre.

Bean Kim, chercheuse à Google Brain, développe un moyen de questionner un système d'apprentissage automatique sur ses décisions.

Bean Kim, chercheuse à Google Brain, développe un moyen de questionner un système d'apprentissage automatique sur ses décisions.Si le médecin vous dit que vous avez besoin d'une intervention chirurgicale, vous voudrez savoir pourquoi - et vous vous attendez à ce que son explication vous semble significative, même si vous n'avez pas été formé en tant que médecin. Been Kim, chercheur à Google Brain, pense que nous devrions pouvoir attendre la même chose de l'intelligence artificielle (IA). Spécialiste de l'apprentissage automatique (MO) «interprété», elle souhaite créer une IA capable d'expliquer ses actions à tous.

Depuis une dizaine d'années, la technologie des réseaux de neurones derrière l'IA a commencé à se répandre de plus en plus, elle a pu transformer tous les processus, du tri des e-mails à la recherche de nouveaux médicaments, grâce à sa capacité à apprendre des données et à rechercher des modèles en elles. Mais cette capacité a un piège inexplicable: la complexité même qui permet aux réseaux de neurones modernes avec une formation approfondie d'apprendre avec succès à conduire une voiture et à reconnaître la fraude à l'assurance, il est presque impossible pour les experts de comprendre les principes de leur travail. Si un réseau neuronal est formé pour rechercher des patients à risque de cancer du foie ou de schizophrénie - et un tel système appelé

Deep Patient a été lancé au Mount Sinai Hospital à New York en 2015 - alors il n'y a aucun moyen de déterminer lesquels les données présentent le réseau neuronal «fait attention». Cette «connaissance» est répartie sur plusieurs couches de neurones artificiels, dont chacun a des connexions avec des centaines ou des milliers d'autres neurones.

Alors que de plus en plus d'industries tentent d'automatiser ou d'améliorer leurs processus de prise de décision en utilisant l'IA, ce problème de «boîte noire» semble être moins un défaut technologique, mais plus un défaut fondamental. Un projet de la DARPA appelé XAI (abréviation de «Explanable AI», eXplainable AI) explore activement cette question, et l'interprétabilité se déplace des lignes de front de la recherche dans le domaine des MO plus près de son centre. «L'IA se trouve à un moment critique lorsque nous, l'humanité, essayons de déterminer si cette technologie nous convient», explique Kim. «Si nous ne résolvons pas le problème de l'interprétabilité, je pense que nous ne pourrons pas continuer avec cette technologie, et peut-être que nous la refuserons tout simplement.»

Kim et ses collègues de Google Brain ont récemment développé le système Testing with Concept Activation Vectors (TCAV), qu'elle décrit comme un traducteur humain qui permet à l'utilisateur de poser une question sur la boîte noire de l'IA. dans quelle mesure un certain concept de haut niveau était impliqué dans la prise de décision. Par exemple, si le système MO est formé pour trouver des images de zèbres, une personne pourrait demander à TCAV de décrire la contribution du concept de «rayures» au processus décisionnel.

TCAV a été initialement testé sur des modèles formés pour reconnaître les images, mais il fonctionne également avec des modèles conçus pour le traitement de texte ou certaines tâches de visualisation de données, par exemple les graphiques EEG. "Il est généralisé et simple - il peut être connecté à de nombreux modèles différents", explique Kim.

Quanta a parlé à Kim de ce que signifie l'interprétabilité, qui en a besoin et pourquoi c'est important.

Dans votre carrière, vous vous êtes concentré sur «l'interprétabilité» pour le MO. Mais que signifie exactement ce terme?

Dans votre carrière, vous vous êtes concentré sur «l'interprétabilité» pour le MO. Mais que signifie exactement ce terme?L'interprétabilité a deux branches. La première est l'interprétabilité pour la science: si vous considérez le réseau neuronal comme un objet d'étude, vous pouvez y mener des expériences scientifiques pour vraiment comprendre tous les tenants et aboutissants du modèle, les raisons de sa réaction, etc.

La deuxième branche, sur laquelle je concentre principalement mes efforts, est l'interprétabilité pour créer une IA capable de répondre aux questions. Vous n'avez pas besoin de comprendre chaque petit détail du modèle. Mais notre objectif est d'en comprendre suffisamment pour que cet outil puisse être utilisé en toute sécurité.

Mais comment croire en un système, si l'on ne comprend pas parfaitement comment il fonctionne?Je vais vous donner une analogie. Supposons que dans ma cour il y ait un arbre que je veux couper. J'ai une tronçonneuse pour ça. Je ne comprends pas exactement comment fonctionne une tronçonneuse. Mais les instructions disent: "Quelque chose à manipuler avec soin pour ne pas se couper." Ayant des instructions, je ferais mieux d'utiliser une tronçonneuse au lieu d'une scie à main - cette dernière est plus facile à comprendre, mais je devrais la voir pendant cinq heures.

Vous comprenez ce que signifie «couper», même si vous ne savez pas tout sur le mécanisme qui rend cela possible.Oui Le but de la deuxième branche de l'interprétabilité est le suivant: pouvons-nous comprendre l'outil suffisamment pour être sûr à utiliser? Et nous pouvons créer cette compréhension en confirmant que les connaissances humaines utiles se reflètent dans l'instrument.

Mais comment la «réflexion de la connaissance humaine» rend-elle la boîte noire de l'IA plus compréhensible?Voici un autre exemple. Si le médecin utilise le modèle MO pour poser un diagnostic de cancer, le médecin devra savoir que le modèle ne sélectionne pas simplement une corrélation aléatoire dans les données dont nous n'avons pas besoin. Une façon de vérifier cela est de confirmer que le modèle MO fait à peu près la même chose que le médecin ferait. Autrement dit, pour montrer que les connaissances diagnostiques du médecin se reflètent dans le modèle.

Par exemple, si un médecin recherche une instance cellulaire appropriée pour le diagnostic du cancer, il cherchera quelque chose appelé «la glande fusionnée». Il tiendra également compte d'indicateurs tels que l'âge du patient et s'il a déjà subi une chimiothérapie. Ces facteurs, ou concepts, seront pris en compte par un médecin qui tentera de diagnostiquer un cancer. Si nous pouvons montrer que le modèle MO attire également l'attention sur eux, alors le modèle sera plus compréhensible, car il reflétera les connaissances humaines des médecins.

C'est ce que TCAV traite - montre quels concepts de haut niveau le modèle MO utilise pour la prise de décision?Oui Avant cela, les méthodes d'interprétabilité expliquaient uniquement ce que fait le réseau neuronal en termes de «caractéristiques d'entrée». Qu'est-ce que cela signifie? Si vous avez une image, chacun de ses pixels sera une fonction d'entrée.

Jan Lekun (pionnier du deep learning, directeur de la recherche en IA chez Facebook), a déclaré qu'il considérait ces modèles comme super-interprétables, car vous pouvez regarder chaque nœud du réseau neuronal et voir les valeurs numériques pour chacune des fonctionnalités d'entrée. Pour les ordinateurs, cela peut convenir, mais les gens pensent différemment. Je ne vous dis pas "Regardez les pixels de 100 à 200, leurs valeurs RVB sont 0,2 et 0,3". Je dis: "Ceci est une image d'un chien très hirsute." Les gens communiquent de cette façon - à travers des concepts.

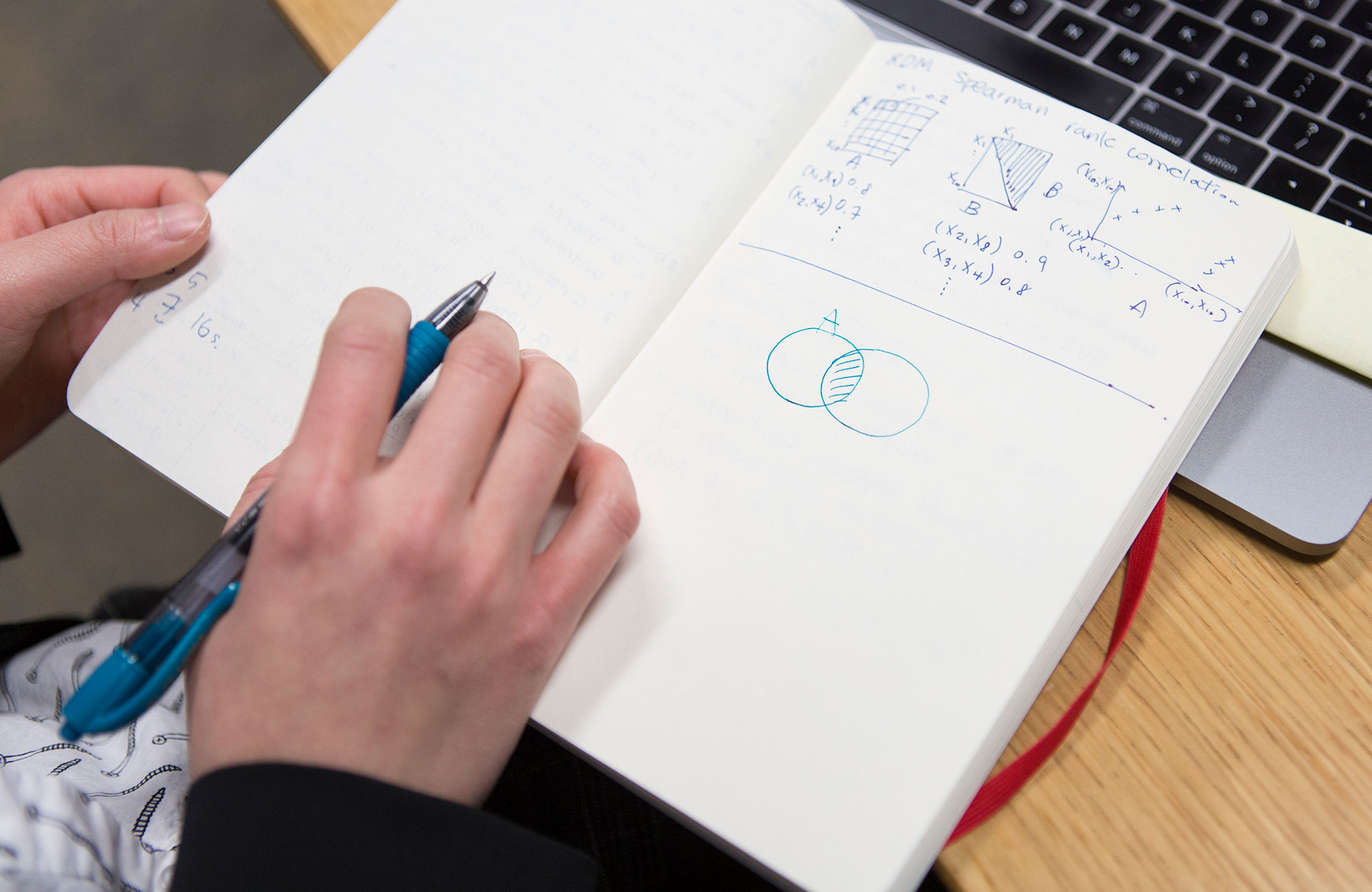

Comment TCAV se traduit-il entre les fonctionnalités d'entrée et les concepts?Revenons à l'exemple d'un médecin utilisant le modèle MO, qui a déjà été formé pour classer les images d'échantillons cellulaires en fonction du cancer. En tant que médecin, vous devez savoir à quel point le concept de «glandes fusionnées» était important pour que le modèle fasse des prédictions positives pour le cancer. Tout d'abord, vous collectez, disons, 20 images qui montrent des exemples de glandes fusionnées. Ensuite, vous connectez ces exemples étiquetés au modèle.

Ensuite, TCAV réalise en soi ce que l'on appelle "Contrôle de sensibilité". Lorsque nous ajoutons ces images étiquetées des glandes fusionnées, dans quelle mesure la probabilité d'une prédiction positive du cancer augmente-t-elle? La réponse peut être estimée par un nombre de 0 à 1. Et ce seront vos points dans TCAV. Si la probabilité augmentait, ce concept était important pour le modèle. Sinon, ce concept n'est pas important.

«Concept» est un terme vague. Y a-t-il des concepts qui ne fonctionneront pas avec TCAV?Si vous ne pouvez pas décrire un concept à l'aide d'un sous-ensemble de votre ensemble de données, cela ne fonctionnera pas. Si votre modèle MO est formé aux images, le concept doit être exprimé visuellement. Si, par exemple, je veux exprimer visuellement le concept de l'amour, ce sera assez difficile à faire.

Nous vérifions également soigneusement le concept. Nous avons une procédure de vérification statistique qui rejette le vecteur concept s'il a un effet équivalent à aléatoire sur le modèle. Si votre concept ne passe pas ce test, alors TCAV dira: "Je ne sais pas, ce concept ne ressemble pas à quelque chose d'important pour le modèle."

Le projet TCAV est-il plus axé sur le renforcement de la confiance en IA que sur la généralisation de sa compréhension?

Le projet TCAV est-il plus axé sur le renforcement de la confiance en IA que sur la généralisation de sa compréhension?Non, - et je vais vous expliquer pourquoi, car cette différence est très subtile.

De nombreuses études dans le domaine des sciences cognitives et de la psychologie, nous savons que les gens sont très confiants. Cela signifie qu'il est très facile de tromper une personne en la forçant à croire en quelque chose. Le but de l'interprétabilité MO est le contraire. Elle consiste à informer une personne qu'il n'est pas sûr d'utiliser un système particulier. Le but est de découvrir la vérité. Par conséquent, «confiance» n'est pas le bon mot.

Le but de l'interprétabilité est donc de découvrir des failles potentielles dans le raisonnement de l'IA?Oui, exactement.

Comment peut-elle révéler les défauts?TCAV peut être utilisé pour poser au modèle une question sur des concepts qui ne sont pas liés au domaine de la recherche. Revenons à l'exemple des médecins utilisant l'IA pour prédire la probabilité de cancer. Les médecins peuvent soudain penser: «Apparemment, la machine donne des prédictions positives pour la présence d'un cancer pour de nombreuses images dans lesquelles la couleur est légèrement décalée vers le bleu. Nous pensons que ce facteur ne doit pas être pris en considération. » Et s'ils obtiennent un score TCAV élevé pour le bleu, cela signifie qu'ils ont trouvé un problème dans leur modèle MO.

TCAV est conçu pour être suspendu à des systèmes d'IA existants qui ne peuvent pas être interprétés. Pourquoi ne pas créer immédiatement des systèmes interprétés au lieu de boîtes noires?Il y a une branche de l'étude de l'interprétabilité, se concentrant sur la création de modèles initialement interprétés qui reflètent le raisonnement d'une personne. Mais je pense que oui: maintenant, nous sommes déjà pleins de modèles d'IA prêts à l'emploi qui sont déjà utilisés pour résoudre des problèmes importants, et lors de leur création, nous n'avons pas pensé au départ à l'interprétabilité. Si facile à manger. Beaucoup d'entre eux travaillent sur Google! Vous pouvez dire: "L'interprétabilité est si utile que nous pouvons créer un autre modèle pour remplacer celui que vous avez." Et bonne chance.

Et puis que faire? Nous devons encore traverser ce moment crucial pour décider si cette technologie nous est utile ou non. Par conséquent, je travaille sur des méthodes d'interprétabilité post-formation. Si quelqu'un vous a donné un modèle et que vous ne pouvez pas le changer, comment abordez-vous la tâche de générer des explications de son comportement afin de pouvoir l'utiliser en toute sécurité? C'est exactement ce que fait TCAV.

TCAV permet aux gens de demander à l'IA l'importance de certains concepts. Mais que se passe-t-il si nous ne savons pas quoi demander - et si nous voulons que l'IA explique simplement?

TCAV permet aux gens de demander à l'IA l'importance de certains concepts. Mais que se passe-t-il si nous ne savons pas quoi demander - et si nous voulons que l'IA explique simplement?En ce moment, nous travaillons sur un projet qui peut automatiquement trouver des concepts pour vous. Nous l'appelons DTCAV - le TCAV d'ouverture. Mais je pense que le principal problème d'interprétabilité est que les gens participent à ce processus, et que nous permettons aux gens et aux machines de communiquer.

Dans de nombreux cas, lorsqu'ils travaillent avec des applications dont beaucoup dépend, les experts dans un domaine particulier ont déjà une liste de concepts qui sont importants pour eux. Chez Google Brain, nous sommes constamment confrontés à cela dans les applications médicales de l'IA. Ils n'ont pas besoin d'un ensemble de concepts - ils veulent fournir des modèles conceptuels qui les intéressent. Nous travaillons avec un médecin traitant la rétinopathie diabétique, les maladies oculaires, et quand nous lui avons parlé du TCAV, elle était très heureuse car elle avait déjà tout un tas d'hypothèses sur ce que le modèle peut faire, et maintenant elle peut vérifier toutes les questions qui se sont posées. C'est un énorme avantage et une manière très centrée sur l'utilisateur de mettre en œuvre l'apprentissage machine collaboratif.

Vous pensez que sans interprétabilité, l'humanité peut simplement abandonner la technologie de l'IA. Compte tenu de ses opportunités, évaluez-vous vraiment une telle option comme réelle?Oui C'est exactement ce qui s'est produit avec les systèmes experts. Dans les années 80, nous avons déterminé qu'ils sont moins chers que les gens pour résoudre certains problèmes. Et qui utilise des systèmes experts aujourd'hui? Personne. Et après cela, l'hiver IA est arrivé.

Jusqu'à présent, cela ne semble pas probable, tant de battage médiatique et d'argent sont investis dans l'IA. Mais à long terme, je pense que l'humanité peut décider - peut-être par peur, peut-être par manque de preuves - que cette technologie ne nous convient pas. C'est possible.