«Les ordinateurs à haut débit ne peuvent pas se passer d'air»

Il y a un moment dans le film Iron Man 2 où Tony Stark regarde un vieux film de son défunt père, où il dit: «Je suis limité par la technologie de mon temps, mais un jour vous pourrez le découvrir. Et puis tu changeras le monde. " C'est fantastique, mais l'idée qu'il exprime est bien réelle. Les idées des ingénieurs sont souvent bien en avance sur leur temps. Il y a toujours eu des gadgets sur Star Trek, mais le reste du monde a dû travailler pendant des décennies pour créer des tablettes et des livres électroniques.

Le concept de refroidissement liquide s'intègre parfaitement dans cette catégorie. L'idée elle-même existe depuis les années 1960, mais elle est restée radicale par rapport à une option beaucoup moins chère et plus sûre pour le refroidissement par air. Il a fallu plus de 40 ans pour que le refroidissement liquide commence à se développer un peu dans les années 2000, et même alors, c'était principalement la prérogative des passionnés de PC qui cherchaient à disperser leurs processeurs bien au-delà des limites recommandées par Intel et AMD.

Aujourd'hui, les systèmes de refroidissement liquide gagnent en popularité. Un tel système pour PC peut être acheté pour moins de 100 $, et l'artisanat destiné aux applications industrielles et aux centres de données (tels que CoolIT, Asetek, Green Revolution Computing, Ebullient) offre un refroidissement liquide (JO) pour les salles de serveurs. Les ZhO sont principalement utilisés dans les superordinateurs, l'informatique à haute vitesse ou d'autres situations où une grande quantité de puissance informatique est requise et où les processeurs fonctionnent avec une charge de près de 100%, mais ces options sont de plus en plus courantes.

Il existe deux types populaires de ZhO: le refroidissement direct par immersion et l'immersion. Avec le refroidissement direct, le radiateur est attaché au CPU, comme un refroidisseur standard, mais au lieu de cela, deux tuyaux y sont connectés. L'un est livré avec de l'eau froide, un dissipateur thermique de refroidissement qui absorbe la chaleur du processeur, et l'autre laisse chaud. Ensuite, il se refroidit et retourne au CPU dans une boucle fermée ressemblant au flux sanguin.

Pendant le refroidissement par immersion, l'équipement est rempli de liquide qui, évidemment, ne doit pas conduire l'électricité. Cette approche est très similaire aux piscines de refroidissement des réacteurs nucléaires. Le refroidissement submersible reste une option plus avancée et nécessite des liquides de refroidissement plus chers qu'une connexion directe, où vous pouvez utiliser de l'eau ordinaire. De plus, il y a toujours un risque de fuite. Par conséquent, l'option de loin la plus populaire est la connexion directe.

Comme l'un des principaux exemples, prenez Alphabet. Lorsque cette société mère de Google a introduit en mai 2018 des processeurs pour AI TensorFlow 3.0, le directeur Sundar Pichai a déclaré que ces puces sont si puissantes que "pour la première fois, nous avons dû installer un refroidissement liquide dans les centres de données". Alphabet a dû payer ce prix pour une productivité multipliée par huit.

D'autre part, Skybox Datacenters a récemment annoncé son intention de créer un énorme supercalculateur avec 40000 serveurs de DownUnder GeoSolutions (DUG), conçu pour l'exploration pétrolière et gazière. Ce projet produira 250 pétaflops de puissance de calcul, plus que tout autre existant, et il est prévu que les serveurs seront refroidis par fluide lorsqu'ils seront immergés dans des réservoirs remplis de fluide diélectrique.

Dans tous les cas, «le refroidissement liquide est le refroidissement de l'avenir, et il le sera toujours», a déclaré Craig Pennington, vice-président du département de conception chez l'opérateur du centre de données Equinix. "Il semble évident que c'est la bonne approche, mais personne ne l'a appliquée."

Comment JO est-il passé de l'art ésotérique au tournant de l'informatique à une méthode presque universellement acceptée dans les centres de données modernes? Comme toutes les technologies, cela s'est produit en partie en raison de l'évolution, des essais et erreurs et d'un grand nombre de solutions d'ingénierie. Cependant, pour ZhO, les centres de données d'aujourd'hui devraient remercier les premiers overclockers qui sont des héros méconnus de cette méthode.

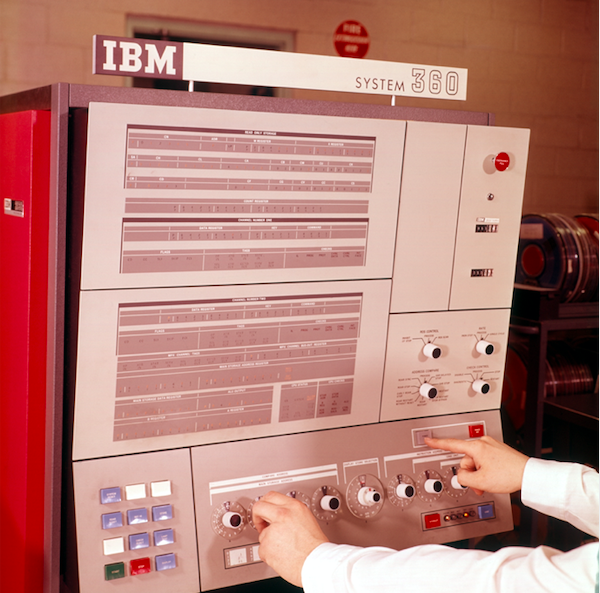

Panneau de configuration de traitement des données IBM System 360

Panneau de configuration de traitement des données IBM System 360Qu'entend-on par refroidissement liquide

Le refroidissement liquide est devenu une idée populaire en 1964 quand IBM a étudié la question du sous-refroidissement pour le mainframe System 360. C'était l'un des mainframes de la société; Les séries 700 et 7000 existaient depuis plus de dix ans et System / 360 «a commencé l'ère de la compatibilité informatique - permettant pour la première fois à différentes machines de la gamme de produits de fonctionner ensemble», comme ils l'écrivent dans IBM. Le concept était simple: l'eau réfrigérée devait traverser un appareil qui la refroidit à une température inférieure à la température ambiante, puis l'eau était directement injectée dans le système. Le circuit utilisé par IBM est désormais appelé refroidissement arrière lorsque le dissipateur thermique est monté derrière le châssis. L'appareil aspirait l'air chaud du châssis principal avec des ventilateurs, puis cet air était refroidi par l'eau, un peu comme un radiateur refroidit le moteur d'une voiture.

Depuis lors, les ingénieurs ont perfectionné ce concept de base et deux formes dominantes de FV ont émergé: l'immersion et le contact direct. L'immersion est ce qu'elle est; L'électronique est dans un bain liquide qui, pour des raisons évidentes, ne peut pas être de l'eau. Le liquide ne doit pas conduire l'électricité, c'est-à-dire être un isolant (des sociétés comme 3M développent même spécifiquement des liquides pour cela).

Mais la plongée a de nombreux problèmes et inconvénients. Le serveur situé dans le liquide n'est accessible que par le haut. Par conséquent, les ports externes doivent s'y trouver. Le placement par le serveur de boîtiers 1U dans un rack serait impossible, de sorte que le serveur ne peut pas être placé séquentiellement. Un diélectrique, et généralement minéral, est petit, très cher et difficile à nettoyer en cas de fuite. Des disques durs spéciaux seront nécessaires et la modification du centre de données nécessitera des investissements importants. Par conséquent, comme dans le cas du supercalculateur mentionné ci-dessus, l'immersion est préférable de faire dans un nouveau centre de données, plutôt que de refaire l'ancien.

Le contact direct JO, en revanche, est que le radiateur (ou échangeur de chaleur) est sur la puce, comme un radiateur ordinaire. Au lieu d'un ventilateur, il utilise deux tuyaux d'eau - un apportant de l'eau froide pour le refroidissement, et le second soufflant de l'eau chaude chauffée par contact avec le radiateur. Cette forme de ZhO est devenue la plus populaire, elle a été adoptée par des fabricants tels que HP Enterprise, Dell EMC et IBM, ainsi que par des fabricants de boîtiers Chatsworth Systems et Schneider Electric.

Le refroidissement direct utilise de l'eau, mais il est très sensible à sa qualité. L'eau du robinet non filtrée ne doit pas être utilisée. Regardez simplement votre robinet ou votre pomme de douche. Personne n'a besoin d'accumulation de calcium dans les serveurs. Le refroidissement direct nécessite au moins de l'eau distillée pure et parfois son mélange avec de l'antigel. La fabrication d'un tel liquide de refroidissement est une science en soi.

Liaison d'Intel

Comment sommes-nous passés des radiateurs IBM à des systèmes de refroidissement modernes et extravagants? Encore une fois, grâce aux overclockers. Au tournant du siècle, le refroidissement liquide a commencé à gagner en popularité parmi les overclockeurs de PC et les amateurs qui assemblaient leurs ordinateurs qui voulaient augmenter leur vitesse au-delà des limites officielles. Cependant, c'était un art ésotérique sans conceptions standard. Tout le monde a fait quelque chose de différent. La personne qui a assemblé tout cela devait être un

donateur si

important que l'assemblage des produits IKEA semblait complètement absurde. La plupart des systèmes de refroidissement ne s'intégraient même pas dans les enceintes.

Début 2004, la situation a commencé à changer en raison de changements internes dans les politiques d'Intel. Un ingénieur du centre de conception de Hillsboro, en Oregon - où la plupart des puces de l'entreprise sont conçues, malgré son siège social à Santa Clara, en Californie - travaille sur un projet de refroidissement spécial depuis plusieurs années. Le projet a coûté 1 million de dollars à la société et visait à créer un refroidisseur de liquide pour les processeurs Intel. Malheureusement, Intel était sur le point de le fermer.

L'ingénieur espérait un résultat différent. Pour sauver le projet, il a eu cette idée chez Falcon Northwest, une société basée à Portland qui a construit des modules complémentaires de jeu pour les ordinateurs. "La raison en était que la société pensait que le refroidissement liquide encourageait les gens à overclocker, et cette activité était interdite à l'époque", a déclaré Kelt Reeves, président de Falcon Northwest. Et dans cette position, Intel avait sa propre logique. À cette époque, des détaillants asiatiques sans principes vendaient des PC overclockés sous le prétexte de plus puissants et avec un mauvais refroidissement, et aux yeux du public, cela s'est en quelque sorte transformé en un problème Intel. Par conséquent, la société s'est opposée à l'overclocking.

Cependant, cet ingénieur de l'Oregon pensait que s'il parvient à trouver des clients et un marché pour un tel refroidisseur, Intel cèdera. (De plus, le produit Intel résultant était de bien meilleure qualité que ce qui était disponible sur le marché, nous a expliqué Reeves). Par conséquent, après une certaine persuasion interne et des négociations entre les sociétés, Intel a autorisé Falcon à vendre des systèmes de refroidissement - en particulier parce qu'Intel les avait déjà produits par milliers. Le seul hic, c'est que Falcon ne pouvait pas mentionner qu'Intel était impliqué. Falcon a accepté et est rapidement devenu le premier fabricant à fournir des systèmes PC tout-en-un entièrement scellés.

Reeves a noté que cette solution ZhO de pointe n'était pas particulièrement conviviale. Falcon a dû changer le boîtier pour s'adapter au radiateur et inventer une plaque de refroidissement pour l'eau. Mais au fil du temps, les fabricants de refroidisseurs, tels que ThermalTake et Corsair, ont appris ce que faisait Intel et ont commencé à apporter des améliorations cohérentes. Depuis lors, plusieurs produits et fabricants sont apparus, par exemple CoolIT et Asetek, qui ont spécifiquement fabriqué ZhO pour les centres de données. Certains de leurs produits - par exemple, les tuyaux qui ne se cassent pas, ne se fissurent pas et ne fuient pas avec une garantie pouvant aller jusqu'à sept ans - ont finalement été accordés sous licence aux fabricants de systèmes de refroidissement pour l'utilisateur final, et un tel échange technologique dans les deux sens est devenu la norme.

Et comme ce marché se développe dans des directions différentes, même Intel a finalement changé d'avis. Maintenant, elle annonce des capacités d'overclocking pour les processeurs des séries K et X, et ne se soucie même pas de vendre des refroidisseurs réguliers avec le meilleur processeur pour les joueurs.

"ZhO est déjà une technologie éprouvée - tout le monde le fait du côté des consommateurs", a déclaré Reeves. Intel a cessé de fournir des refroidisseurs réguliers avec les processeurs les plus puissants, car ils ont besoin de JO; il a déjà été prouvé et une bénédiction d'Intel a été reçue. Je ne pense pas qu'il y ait quelqu'un qui dira que les solutions complètes pour cela ne sont pas assez fiables. "

Refroidissement par immersion dans le centre de données. Les boîtes sont remplies de fluide diélectrique qui s'écoule à travers les tuyaux.

Refroidissement par immersion dans le centre de données. Les boîtes sont remplies de fluide diélectrique qui s'écoule à travers les tuyaux. Refroidissement liquide des centres de données Skybox avec immersion. Les échangeurs de chaleur sont immergés dans du matériel informatique et le fluide diélectrique ne quitte pas le réservoir. Un circuit d'eau traverse les pièces et s'approche de chaque échangeur de chaleur.

Refroidissement liquide des centres de données Skybox avec immersion. Les échangeurs de chaleur sont immergés dans du matériel informatique et le fluide diélectrique ne quitte pas le réservoir. Un circuit d'eau traverse les pièces et s'approche de chaque échangeur de chaleur.Faits en faveur de l'aspect pratique du refroidissement liquide

Pendant longtemps, les centres de données traditionnels prévoyaient un plancher surélevé avec de petites ouvertures à travers lesquelles l'air froid montait, aspiré par les serveurs. Cela s'appelait CRAC, ou climatisation de salle informatique. Le problème est que maintenant il ne suffit plus de souffler de l’air froid à travers les ouvertures du sol.

La raison principale du récent boom du refroidissement liquide est la nécessité. Les processeurs d'aujourd'hui deviennent trop chauds et les serveurs sont trop proches pour que l'air les refroidisse efficacement, même Google dit. La capacité calorifique de l'eau est 3300 fois supérieure à celle de l'air, et un système de refroidissement à eau est capable de pomper 300 litres d'eau par minute, contre 20 mètres cubes d'air par minute.

En termes simples, l'eau peut refroidir beaucoup plus efficacement et dans un espace beaucoup plus petit. Par conséquent, après de nombreuses années à essayer de réduire la consommation d'énergie, les fabricants de processeurs peuvent disperser la puissance et tordre la tension pour des performances maximales - sachant que le refroidissement liquide peut gérer cela.

«On nous demande de refroidir des puces dont la consommation électrique dépassera bientôt les 500 watts», a expliqué Jeff Lyon, directeur de CoolIT. - Certains processeurs qui ne sont pas encore entrés sur le marché consomment 300 watts chacun. Tout cela se développe à la demande de l'IA et du machine learning. Le taux de refroidissement n'est tout simplement pas suffisant. »

Lyon a déclaré que CoolIT envisage d'étendre le système de refroidissement aux chipsets, aux systèmes de contrôle de l'alimentation, aux puces réseau et à la mémoire. "Il n'y aura rien de radical dans le traitement de la mémoire", a-t-il ajouté. - Il existe des options de RAM avec un emballage avancé, consommant 18 watts par DIMM. Un module DIMM typique consomme 4 à 6 watts. Parmi les systèmes avec une grande quantité de mémoire, nous trouvons des serveurs avec 16 ou même 24 modules DIMM installés, ce qui signifie beaucoup de chaleur. »

Un par un, les fabricants sont confrontés à de telles demandes. Equinix observe comment la densité moyenne passe de 5 kW à 7-8 kW, et maintenant à 15-16 kW, certains équipements affichant déjà une densité de 40 kW. «La quantité totale d'air à pomper devient donc trop importante. Cela ne se produira pas instantanément, mais au cours des deux prochaines années, il y aura une adoption fondamentale du refroidissement liquide », a déclaré Pennington d'Equinix.

Un peu sur le refroidissement par immersion

Green Revolution Cooling se concentre sur le refroidissement par immersion, et son directeur Peter Poulin dit que du point de vue de l'efficacité énergétique, le refroidissement par immersion est meilleur que le refroidissement direct pour deux raisons. Tout d'abord, les fans sont supprimés de tous les serveurs. Seul cela réduit la consommation d'énergie de 15% en moyenne. Et un client de l'entreprise l'a réduit de 30%.

Il y a un autre avantage indirect à éliminer les fans: le silence. Malgré le fait que les serveurs utilisent souvent de très petits ventilateurs, ceux du serveur sont terriblement bruyants et être dans le centre de données est désagréable en raison de la chaleur et du bruit. Le refroidissement liquide rend ces endroits beaucoup plus agréables à travailler.

Un autre avantage est que très peu d'énergie est requise pour supporter le système de refroidissement par immersion. Il n'y a que trois pièces mobiles: une pompe pour faire circuler un refroidisseur, une pompe pour le déplacer vers une tour de refroidissement et un ventilateur de tour de refroidissement. Après avoir remplacé l'air refroidi par liquide, la consommation d'électricité peut chuter à 5% de ce qui a été dépensé pour la climatisation. "Vous obtenez une énorme réduction de la consommation d'énergie, ce qui vous permet de faire beaucoup d'autres choses", a déclaré Poulnin. «Selon le consommateur, le datacenter peut être plus économe en énergie ou réduire les émissions de carbone associées à la construction de datacenters.»

Faits en faveur du refroidissement liquide à haute efficacité énergétique

La consommation d'énergie est depuis longtemps une préoccupation pour l'industrie des centres de données (l'Agence américaine de protection de l'environnement suit ce chiffre depuis au moins dix ans). Les centres de données d'aujourd'hui sont de grandes entreprises qui consomment environ 2% de toute l'électricité mondiale et rejettent autant de CO

2 dans l'atmosphère que l'industrie du transport aérien. Par conséquent, l'intérêt pour cette question ne s'estompe pas. Heureusement, le refroidissement liquide réduit les factures d'électricité.

Les premières économies sont dues à la déconnexion de la climatisation dans le centre de données. Le deuxième est l'élimination des fans. Chaque rack de serveur possède de nombreux ventilateurs qui soufflent de l'air, mais leur nombre peut être réduit à un petit nombre ou à zéro, selon la densité.

Et avec la technologie de «refroidissement à sec», sans gel, vous pouvez réaliser des économies encore plus importantes. Initialement, le refroidissement à connexion directe a conduit l'eau à travers un réfrigérateur, qui l'a refroidie à 15-25 degrés Celsius. Mais en fin de compte, il s'est avéré que les refroidisseurs de liquide, qui faisaient passer l'eau à travers une longue séquence de tuyaux et de ventilateurs, les tuyaux froids chauffés par l'eau chaude et la diffusion thermique naturelle refroidissent également l'eau à une température suffisante.

"Parce que ce processus est si efficace, vous n'avez pas à vous soucier de refroidir l'eau à une température basse", explique Pennington. - L'eau chaude enlève toujours efficacement toute la chaleur des serveurs. Vous n'avez pas besoin d'un cycle de compression, vous pouvez simplement utiliser des refroidisseurs secs. "

Les refroidisseurs secs économisent également l'eau. Un grand centre de données qui utilise des réfrigérateurs peut consommer des millions de litres d'eau par an, mais un centre de données avec des refroidisseurs secs ne consomme pas d'eau. Cela permet d'économiser de l'énergie et de l'eau, ce qui peut être très utile si le centre de données est situé dans la ville.

"Nous ne consommons pas beaucoup d'eau", a déclaré Pennington. - Si vous concevez soigneusement tout, vous obtenez un système fermé. L'eau ne coule pas et ne sort pas, il suffit d'ajouter de l'eau environ une fois par an pour garder les réservoirs pleins. Vous n’ajoutez pas constamment d’eau à votre voiture, c’est le cas avec nous. »

L'acceptation suit l'efficacité

Un exemple concret: Dell, passant au refroidissement liquide, a augmenté son efficacité énergétique (

PUE ) de 56%, selon Brian Payne, vice-président de la gestion des produits et du marketing chez PowerEdge Dell EMC.

Le PUE est le rapport entre l'énergie qui doit être dépensée pour refroidir le système et l'énergie nécessaire pour le faire fonctionner [en fait, c'est le rapport entre l'énergie totale utilisée par le centre de données et l'énergie dépensée directement pour alimenter l'infrastructure informatique / env. perev]. Un PUE égal à 3 signifie que 2 fois plus d'énergie est dépensée pour refroidir un système que pour l'alimentation du système, et PUE = 2 signifie que l'énergie et le refroidissement sont consommés de manière égale. Le PUE ne peut pas être égal à 1, car le refroidissement est nécessaire, mais les opérateurs de centres de données sont obsédés par l'idée de ramener le chiffre le plus près possible de 1,0.En plus d'améliorer le PUE, l'augmentation de la puissance de calcul que les clients Dell reçoivent peut aller jusqu'à 23%, et cela ne surcharge pas le système au-delà de toute mesure. «Sur la base des investissements nécessaires dans l'infrastructure, nous prévoyons le rendement annuel du système», explique Payne. - Je comparerais cela à l'achat d'un climatiseur plus économe en énergie pour la maison. Vous investissez un peu, mais avec le temps, vous ressentez les avantages des factures d'électricité. »En tant qu'adhérent complètement différent du refroidissement liquide, prenez le centre du supercalculateur de l'Ohio, OSC. Ce cluster emploie 1800 nœuds. Après être passé à JO, comme l'a dit Doug Johnson, architecte en chef des systèmes, le centre a atteint PUE = 1,5. L'OSC utilise un circuit externe, de sorte que l'eau est évacuée du bâtiment et refroidie à la température ambiante, qui est en moyenne de 30 ° C en été et beaucoup moins en hiver. Les copeaux atteignent 70 ° C, et même si l'eau chauffe jusqu'à 40 ° C, elle reste encore beaucoup plus froide que les copeaux et remplit sa fonction.Comme bon nombre des premiers à adopter la nouvelle technologie, pour OSC, elle est toute nouvelle. Il y a cinq ans, le centre n'utilisait pas du tout ZhO, et aujourd'hui il en occupe 25%. Le centre espère que dans trois ans, la barre passera à 75%, et après quelques années, ils passeront complètement à ZhO. Mais même dans l'état actuel, selon Johnson, le refroidissement du centre nécessite quatre fois moins d'énergie qu'avant la transition vers ZhO, et en général, cette solution a réduit la consommation totale d'énergie de 2/3. «Je pense que le pourcentage augmentera lorsque nous commencerons à intégrer le GPU dans le système de refroidissement.»Du point de vue du client, il faut du temps et de l'énergie pour évaluer une nouvelle technologie - c'est pourquoi une grande entreprise comme Dell a accepté de travailler avec CoolIT pour annoncer ZhO. Il n'est pas surprenant que, en premier lieu, parmi les préoccupations des clients, subsiste la possibilité de fuite. Cependant, malgré toutes les fluctuations, il s'avère que pour le moment, ils n'ont guère le choix s'ils veulent obtenir les meilleures performances.«Il y a toujours eu une peur des fuites», explique Lyon de CoolIT. - La situation a changé, et maintenant il n'y a tout simplement plus d'autres options. Les ordinateurs à haut débit ne peuvent pas faire exactement cela. "