La vingt-huitième conférence RSA s'est tenue la semaine dernière, et si en 2018 ce plus grand événement de l'industrie dans l'industrie a été marqué par quelques

difficultés à trouver de nouvelles significations, cette fois encore tout va bien. La présentation d'ouverture du président de la RSA, Rohit Gai, était consacrée au «paysage de la confiance» et, au cours de celle-ci, on a tenté de dessiner un scénario positif pour l'avenir, en particulier en 2049.

Il est positif car il a réussi à résoudre de nombreux problèmes d'aujourd'hui, y compris pas même les problèmes de cybersécurité, mais plutôt les difficultés du nouveau modèle de développement de la société, qui est presque entièrement lié à Internet et aux services numériques. En effet, si vous essayez de regarder ce sujet d'en haut (ce qu'ils aiment traditionnellement faire sur RSA), il ne s'agit pas seulement de la possibilité de pirater l'ordinateur ou le serveur de quelqu'un. Il y a, par exemple, le problème de la manipulation dans les réseaux sociaux, et parfois les services eux-mêmes se développent parfois quelque part dans la mauvaise direction. Dans ce contexte, l'idée de confiance - des utilisateurs aux entreprises, des personnes à l'intelligence artificielle - est vraiment importante.

Si vous souhaitez savoir comment ils disent sur la sécurité lors d'événements professionnels, regardez la vidéo.Une autre idée intéressante a été exprimée dans la présentation: l'intelligence artificielle n'a pas besoin d'être forcée d'effectuer des tâches que seules les personnes peuvent effectuer, où les faits jouent un rôle moindre que les émotions et, par exemple, les questions éthiques. Et vice versa: les décisions qui nécessitent un strict respect des faits doivent souvent être laissées aux machines qui sont (vraisemblablement) moins sujettes aux erreurs. La décision de faire confiance ou non à toute source d'informations sur le réseau doit être basée sur la réputation. Une idée similaire peut être appliquée au problème des cyberincidents: oui, tôt ou tard, ils arrivent à tout le monde, mais l'avantage est donné aux organisations dont les efforts pour protéger les données des clients l'emportent sur les conséquences du piratage.

Attaques théoriques contre les algorithmes d'apprentissage automatiqueCependant, RSA montre toujours à quel point la relation est complexe dans l'industrie entre ceux qui trouvent de nouveaux problèmes et ceux qui proposent des solutions. Hormis quelques discours protocolaires, les discours les plus intéressants de la conférence, s'ils peignent l'avenir, sont dans des tons peu optimistes. À noter la présentation du porte-parole de Google, Nicolas Carlini (

news ). Il a résumé l'expérience des attaques contre les algorithmes d'apprentissage automatique, en commençant par cet exemple déjà classique de 2017:

L'image originale d'un chat est modifiée de manière totalement invisible pour les humains, mais l'algorithme de reconnaissance classe cette image d'une manière complètement différente. Quelle menace représente cette modification? Un autre exemple pas le plus récent, mais informatif:

Le panneau routier semble avoir un peu souffert des vandales, mais pour une personne, il est tout à fait compréhensible. La voiture peut reconnaître le signe avec de tels changements comme un signe complètement différent - avec des informations sur la limite de vitesse, et ne s'arrêtera pas à l'intersection. Plus intéressant encore:

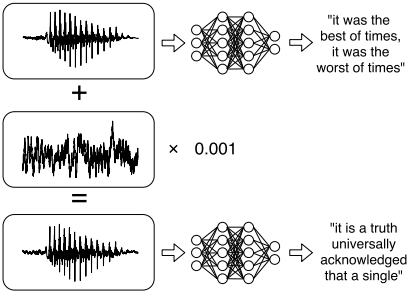

La même méthode peut être appliquée au son, ce qui a été démontré en pratique. Dans le premier exemple, le système de reconnaissance vocale «reconnaissait» le texte dans un fragment musical. Dans le second, la manipulation invisible de l'enregistrement vocal a conduit à la reconnaissance d'un ensemble de mots complètement différent (comme dans l'image). Dans le troisième cas, le texte était reconnu et complètement dépourvu de bruit insignifiant. C'est une situation intéressante: à un moment donné, les gens et leurs assistants numériques commencent à voir et à entendre des choses complètement différentes. Enfin, les algorithmes d'apprentissage automatique peuvent théoriquement révéler les données personnelles sur lesquelles ils ont été formés, avec une utilisation ultérieure. L'exemple le plus simple et le plus compréhensible est le système de saisie prédictive alias «damned T9».

Sécurité des dispositifs médicauxLa sécurité en médecine a récemment été discutée dans les domaines des logiciels incroyablement obsolètes et du manque de budgets pour le développement de l'informatique. En conséquence, les conséquences des

cyberattaques sont plus graves que d'habitude, et nous parlons de la perte ou de la fuite de données patient très sensibles. Lors de la conférence RSA, les experts de Check Point Software ont

partagé les résultats d'une étude du réseau informatique d'un véritable hôpital en Israël. Dans la plupart des établissements médicaux, le réseau informatique n'est pas divisé en zones, il était donc assez facile de trouver des appareils spécialisés, dans ce cas, un appareil à ultrasons.

L'histoire de la recherche de vulnérabilités dans la partie informatique de l'appareil était très courte. Ultrasound exécute Windows 2000 et trouver un exploit pour l'une des vulnérabilités critiques de ce système d'exploitation n'a pas été difficile. Les chercheurs ont eu accès aux archives d'images avec les noms des patients, ont pu modifier ces informations et ont eu la possibilité d'activer le cheval de Troie ransomware. Le fabricant d'appareils a déclaré que les modèles plus modernes sont construits sur des logiciels modernes, des mises à jour logicielles y sont régulièrement livrées (mais pas le fait qu'ils soient installés), mais la mise à jour des appareils médicaux coûte (beaucoup) de l'argent, et quel est l'intérêt si les appareils plus anciens fonctionnent?

Les recommandations pour les organisations médicales sont claires: segmentation du réseau local, séparation des appareils qui stockent les données privées de tous les autres. Fait intéressant, pour le développement des technologies d'apprentissage automatique en médecine, au contraire, l'accès le plus large possible aux données des patients est nécessaire - pour les algorithmes de formation.

Avis de non-responsabilité: les opinions exprimées dans ce recueil ne coïncident pas toujours avec la position officielle de Kaspersky Lab. Chers rédacteurs recommandent généralement de traiter toute opinion avec un scepticisme sain.