Les derniers algorithmes d'IA comprennent l'évolution des galaxies, calculent les fonctions des ondes quantiques, découvrent de nouveaux composés chimiques, etc. Y a-t-il quelque chose dans le travail des scientifiques qui ne peut pas être automatisé?

Personne ou même un groupe de personnes ne peut suivre les informations sur les chutes d'eau produites par un grand nombre d'expériences en physique et en astronomie. Certains d'entre eux laissent quotidiennement des téraoctets de données, et ce flux ne fait qu'augmenter. Le réseau d'antennes Square Kilometer Array, un radiotélescope qu'ils prévoient d'allumer au milieu des années 2020, produira chaque année un volume de données comparable à l'ensemble d'Internet.

Ce flot de données a conduit de nombreux scientifiques à se tourner vers l'intelligence artificielle (IA) pour obtenir de l'aide. Avec une implication humaine minimale, les systèmes d'IA tels que les réseaux de neurones - des réseaux de neurones simulés par ordinateur qui imitent le fonctionnement du cerveau - sont capables de parcourir des montagnes de données, de trouver des anomalies et de reconnaître des séquences que les gens n'auraient jamais remarquées.

Bien sûr, l'aide des ordinateurs dans la recherche scientifique est utilisée depuis environ 75 ans, et la méthode de tri manuel des données à la recherche de séquences significatives a été inventée il y a des milliers d'années. Mais certains chercheurs soutiennent que les dernières technologies en matière d'apprentissage automatique et d'intelligence artificielle représentent une manière fondamentalement nouvelle de faire de la science. L'une de ces approches, la modélisation générative (GM), peut aider à déterminer la théorie la plus probable parmi les explications concurrentes des données observées, basées uniquement sur ces données, et sans aucune connaissance préprogrammée des processus physiques qui peuvent se produire dans le système à l'étude . Les partisans de GM le considèrent suffisamment innovant pour être considéré comme une «troisième voie» potentielle pour étudier l'univers.

Habituellement, nous acquérons des connaissances sur la nature grâce à l'observation. Comment Johannes Kepler a étudié les tableaux de la position des planètes de Tycho Brahe, en essayant de trouver le motif sous-jacent (il a finalement réalisé que les planètes se déplacent sur des orbites elliptiques). La science a également progressé grâce aux simulations. Un astronome peut simuler le mouvement de la Voie lactée et de la galaxie voisine, Andromède, et prédire qu'ils entreront en collision dans quelques milliards d'années. Les observations et les simulations aident les scientifiques à créer des hypothèses qui peuvent être vérifiées à l'aide d'observations futures. GM est différent de ces deux approches.

«Il s'agit essentiellement de la troisième approche, entre l'observation et la simulation», a déclaré

Kevin Shavinsky , astrophysicien et l'un des partisans les plus pro-GM, qui travaillait jusqu'à récemment à l'Institut fédéral suisse de technologie. "C'est une façon différente d'attaquer la tâche."

Certains scientifiques considèrent les OGM et d'autres technologies comme de simples outils puissants pour pratiquer la science traditionnelle. Mais la plupart conviennent que l'IA affectera de manière significative ce processus, et son rôle dans la science ne fera que croître.

Brian Nord , astrophysicien au Laboratoire national des accélérateurs de Fermi qui utilise des réseaux de neurones artificiels pour étudier l'espace, fait partie de ceux qui craignent qu'aucune des activités du scientifique humain n'échappe à l'automatisation. "Cette pensée est assez terrifiante", a-t-il déclaré.

Découverte de génération

Même à l'institut, Shavinsky a commencé à se forger une réputation scientifique basée sur des données. Tout en travaillant sur son doctorat, il a rencontré la tâche de classer des milliers de galaxies en fonction de leur apparence. Il n'y avait pas de programmes prêts à l'emploi pour cette tâche, alors il a décidé d'organiser le crowdsourcing à cette fin - c'est ainsi que le projet

Galactic Zoo est né. Depuis 2007, les utilisateurs ordinaires ont pu aider les astronomes à faire des hypothèses sur la galaxie qui appartient à quelle catégorie, et généralement la plupart des voix ont correctement classé la galaxie. Le projet a été un succès, cependant, comme le note Shavinsky, l'IA l'a rendu inutile: «Aujourd'hui, un scientifique talentueux ayant une expérience dans la région de Moscou et un accès au cloud computing peut réaliser un tel projet en une demi-journée.»

Shavinsky s'est tourné vers le nouvel outil puissant de GM en 2016. En fait, le MJ pose la question: quelle est la probabilité que sous la condition X nous obtenions le résultat Y? Cette approche s'est révélée incroyablement efficace et universelle. Par exemple, supposons que vous ayez nourri GM un ensemble d'images de visages humains, et pour chaque personne son âge est apposé. Le programme examine ces données d'entraînement et commence à trouver un lien entre les vieux visages et la probabilité accrue de rides apparaissant sur eux. En conséquence, elle peut révéler l'âge d'une personne donnée, c'est-à-dire prédire quels changements physiques une personne donnée de tout âge est susceptible de subir.

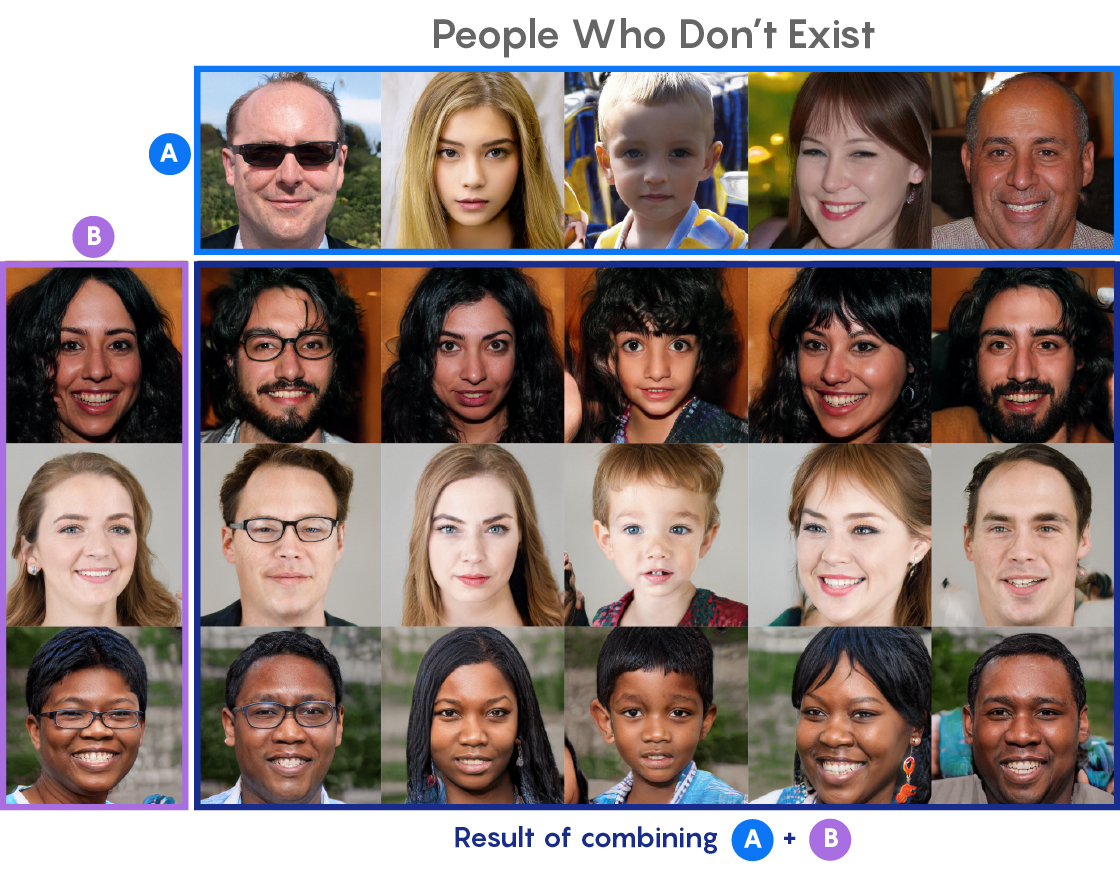

Aucun de ces individus n'est réel. La ligne du haut (A) et la colonne de gauche (B) sont créées par un réseau génératif-accusatoire (GSS) utilisant des blocs de construction dérivés d'éléments de personnes réelles. Ensuite, l'ESG a combiné les principales caractéristiques faciales de la série A, y compris le sexe, la croissance et la forme du visage, avec des caractéristiques faciales plus petites de la colonne B, par exemple, la couleur des cheveux et des yeux, et a créé des visages dans le reste du tableau.

Aucun de ces individus n'est réel. La ligne du haut (A) et la colonne de gauche (B) sont créées par un réseau génératif-accusatoire (GSS) utilisant des blocs de construction dérivés d'éléments de personnes réelles. Ensuite, l'ESG a combiné les principales caractéristiques faciales de la série A, y compris le sexe, la croissance et la forme du visage, avec des caractéristiques faciales plus petites de la colonne B, par exemple, la couleur des cheveux et des yeux, et a créé des visages dans le reste du tableau.Parmi les systèmes GM, les réseaux contradictoires génératifs (GSS) sont les plus connus. Après avoir traité des données d'entraînement adéquates, le GSS peut restaurer des images avec des pixels manquants ou endommagés ou rendre les photos floues nettes. Les ESG sont formées pour extraire les informations manquantes sur la base de la concurrence (d'où le caractère "contradictoire"): une partie du réseau, le générateur, génère de fausses données, et la seconde, le discriminateur, tente de distinguer les fausses données des vraies. Pendant l'exécution du programme, les deux parties fonctionnent progressivement mieux. Vous avez peut-être vu des «visages» super réalistes créés par l'ESG - des images de «personnes incroyablement réalistes qui n'existent pas dans la réalité», comme ils l'ont écrit dans l'un des titres.

Dans un cas plus général, le MJ prend un ensemble de données (généralement des images, mais pas nécessaire) et les divise en sous-ensembles des blocs de construction abstraits de base - les scientifiques les appellent «l'espace caché» des données. L'algorithme manipule des éléments de l'espace caché pour voir comment cela affectera les données initiales, ce qui permet de révéler les processus physiques qui assurent le fonctionnement du système.

L'idée d'espace caché est abstraite et difficile à imaginer, mais comme une analogie grossière, pensez à ce que votre cerveau peut faire lorsque vous essayez de déterminer le sexe d'une personne par le visage. Vous remarquerez peut-être une coiffure, une forme de nez, etc., ainsi que des motifs qui ne sont pas faciles à décrire avec des mots. Un programme informatique recherche également des signes cachés dans les données: bien qu'il ne sache pas ce qu'est une moustache ou un sexe, s'il a été formé sur un ensemble de données dans lequel certaines images sont étiquetées «homme» ou «femme», et certaines ont l'étiquette «moustache» ", Elle comprendra rapidement la relation.

Kevin Shavinsky, astrophysicien, chef de la société d'IA Modulos

Kevin Shavinsky, astrophysicien, chef de la société d'IA ModulosDans un article publié en décembre dans la revue Astronomy & Astrophysics, Shavinsky et ses collègues, Denis Tharp et Che Zhen, ont utilisé GM pour étudier les changements physiques dans les galaxies au cours de l'évolution (le logiciel qu'ils utilisent calcule l'espace caché un peu différemment de GSS, donc c'est techniquement impossible) appelez GSS, bien qu'il soit assez proche dans les propriétés). Leur modèle a créé des ensembles de données artificielles pour tester des hypothèses sur les processus physiques. Ils ont, par exemple, demandé comment «l'atténuation» de la formation des étoiles - une forte diminution de la vitesse de leur formation - est associée à une augmentation de la densité de la galaxie.

Pour Shavinsky, la question clé est de savoir combien d'informations sur les processus stellaires et galactiques peuvent être extraites sur la base d'une seule donnée. "Exclure tout ce que nous savons sur l'astrophysique", a-t-il déclaré. "Dans quelle mesure pouvons-nous redécouvrir ces connaissances en utilisant uniquement des données?"

Tout d'abord, les images des galaxies ont été réduites à un espace caché; alors Shavinsky pourrait corriger un élément de cet espace pour qu'il corresponde à un certain changement dans l'environnement de la galaxie - par exemple, la densité de son environnement. Ensuite, il pourrait régénérer la galaxie et voir quelles différences apparaîtraient cette fois. «Et maintenant, j'ai une machine pour générer des hypothèses», a-t-il expliqué. "Je peux prendre un tas de galaxies qui étaient à l'origine entourées de faible densité, et donner l'impression que leur densité est élevée." Shavinsky, Tarp et Zhen ont découvert qu'en se déplaçant d'une densité plus faible à une densité plus élevée de l'environnement, ils deviennent plus rouges et leurs étoiles se concentrent plus densément. Cela est cohérent avec les observations existantes des galaxies, a déclaré Shavinsky. La seule question est pourquoi.

La prochaine étape, dit Shavinsky, n'a pas encore été automatisée. "Moi, l'homme, j'ai besoin d'intervenir et de dire: Eh bien, quel type de physique peut expliquer cet effet?" Il y a deux explications possibles à ce processus: il est possible que les galaxies deviennent plus rouges dans des environnements plus denses parce qu'elles contiennent plus de poussière, ou parce qu'il y a un déclin dans la formation des étoiles (en d'autres termes, leurs étoiles sont généralement plus anciennes). En utilisant le modèle génératif, nous pouvons tester les deux idées. Nous modifions les éléments de l'espace caché associés à la poussière et la vitesse de formation des étoiles, et voyons comment cela affecte la couleur des galaxies. "Et la réponse est claire", a déclaré Shavinsky. Les galaxies plus rouges sont celles "où la vitesse de formation des étoiles a chuté, et non celles où il y a plus de poussière. Par conséquent, nous sommes favorables à la première explication. »

La rangée du haut représente de vraies galaxies dans les régions à faible densité.

La rangée du haut représente de vraies galaxies dans les régions à faible densité.

Deuxième rangée - reconstruction basée sur un espace caché.

Viennent ensuite les transformations apportées par le réseau, et ci-dessous sont les galaxies générées dans les régions à haute densité.L'approche est associée aux simulations traditionnelles, mais présente des différences cardinales. La simulation, en fait, "est basée sur des hypothèses", a déclaré Shavinsky. "Celui-ci revient à dire:" Je pense avoir compris quels principes physiques sous-tendent tout ce que j'observe dans le système. " J'ai une recette pour former des étoiles, pour le comportement de la matière noire, etc. Je pose toutes mes hypothèses et lance la simulation. Et puis je demande: est-ce que ça ressemble à la réalité? " Et avec la modélisation générative, cela, dit-il, ressemble «en un sens, exactement à l'opposé de la simulation». Nous ne savons rien, nous ne voulons rien supposer. Nous voulons que les données nous disent ce qui peut arriver. »

Le succès apparent de la modélisation générative dans une telle étude ne signifie évidemment pas que les astronomes et les étudiants diplômés ne sont plus nécessaires - mais cela semble démontrer un changement dans la mesure dans laquelle l'IA peut apprendre quoi que ce soit sur les objets et processus astrophysiques, ayant presque seulement une énorme quantité de données. «Ce n'est pas une science entièrement automatisée, mais cela démontre que nous sommes capables de créer des outils qui automatisent le progrès scientifique au moins partiellement», a déclaré Shavinsky.

La modélisation générative est évidemment capable de beaucoup - mais s'il s'agit vraiment d'une nouvelle approche de la science, c'est un point discutable. Pour

David Hogg , cosmologiste à l'Université de New York et au Flatiron Institute, cette technologie, bien qu'impressionnante, est en fait un moyen très complexe d'extraire des séquences de données - et les astronomes le font depuis des siècles. En d'autres termes, c'est une méthode avancée d'observation et d'analyse. Le travail de Hogg, comme Shavinsky, dépend fortement de l'IA; il utilise des réseaux de neurones pour

classer les étoiles par spectre et tirer des conclusions sur d'

autres propriétés physiques des étoiles à l'aide de modèles basés sur les données. Mais il considère son travail et celui de Shavinsky comme une méthode scientifique ancienne, aimable et éprouvée. "Je ne pense pas que ce soit la troisième voie", a-t-il récemment déclaré. «Je pense simplement que nous, en tant que communauté, utilisons de plus en plus nos données. En particulier, nous sommes bien meilleurs pour comparer les données. Mais de mon point de vue, mon travail s'inscrit parfaitement dans le cadre du régime d'observation. »

Assistants zélés

Que l'IA et les réseaux de neurones soient ou non de nouveaux outils conceptuels, il est évident qu'ils ont commencé à jouer un rôle essentiel dans l'astronomie moderne et la recherche physique. À l'Institut de recherche théorique d'Heidelberg, le physicien

Kai Polsterer dirige un groupe sur l'astroinformatique - une équipe de chercheurs travaillant sur de nouvelles méthodes en astrophysique basées sur le traitement des données. Ils ont récemment utilisé un algorithme avec des MO pour

extraire des informations de décalage vers le rouge à partir de jeux de données de galaxies - une tâche qui était auparavant débilitante.

Polsterer considère ces nouveaux systèmes basés sur l'IA comme des «assistants zélés», capables de peigner les données pendant des heures sans s'ennuyer et se plaindre des conditions de travail. Ces systèmes peuvent faire tout le travail monotone et dur, a-t-il dit, nous laissant avec une «science intéressante et cool».

Mais ils ne sont pas parfaits. En particulier, prévient Polsterer, les algorithmes ne peuvent faire que ce pour quoi ils ont été formés. Le système est indifférent à l'entrée. Donnez-lui une galaxie et elle pourra apprécier son décalage vers le rouge et son âge. Mais donnez-lui un selfie ou une photo de poisson pourri, elle appréciera leur âge (naturellement faux). En fin de compte, a-t-il dit, la surveillance de la population reste nécessaire. «Tout se ferme sur nous, les chercheurs. Nous sommes responsables de l'interprétation. »

Pour sa part, Nord du Fermilab prévient qu'il est important que les réseaux de neurones produisent non seulement des résultats, mais aussi des erreurs de travail, comme tout étudiant est habitué. Il est tellement accepté en science que si vous prenez une mesure mais ne donnez pas d'erreur, personne ne prendra vos résultats au sérieux.

Comme de nombreux chercheurs en IA, Nord craint également que les résultats des réseaux de neurones soient difficiles à comprendre; le réseau neuronal donne une réponse sans fournir un moyen clair de l'obtenir.

Cependant, tout le monde ne pense pas que le manque de transparence soit un problème. Lenka Zdeborova, chercheuse à l'Institut de physique théorique de France, souligne que l'intuition humaine est parfois également impossible à comprendre. Vous regardez la photo et découvrez que le chat y est représenté - "mais vous ne savez pas comment vous le savez", dit-elle. "Votre cerveau, en quelque sorte, est aussi une boîte noire."

Non seulement les astrophysiciens et les cosmologistes migrent du côté de la science en utilisant l'IA et le traitement des données. Le spécialiste de la physique quantique Roger Melko de l'Institut de physique théorique du périmètre et de l'Université de Waterloo a utilisé un réseau de neurones pour résoudre certains des problèmes les plus complexes et les plus importants dans ce domaine, par exemple, représentant une fonction d'onde décrivant un système de nombreuses particules. L'IA est nécessaire à cause de ce que Melko appelle la «malédiction exponentielle de la dimension». C'est-à-dire que le nombre de formes possibles de la fonction d'onde augmente exponentiellement avec une augmentation du nombre de particules dans le système décrit. La difficulté est similaire à essayer de choisir le meilleur coup dans un jeu comme les échecs ou le go: vous essayez de calculer le prochain coup en imaginant comment votre adversaire ira et choisir la meilleure réponse, mais à chaque coup le nombre d'opportunités augmente.

Bien sûr, l'IA a maîtrisé ces deux jeux, apprenant à jouer aux échecs il y a quelques décennies et battant le meilleur joueur de go en 2016 - cela a été fait par le système AlphaGo. Elle dit finement qu'ils sont également bien adaptés aux problèmes de la physique quantique.

Esprit machine

Que Shavinsky ait raison de déclarer qu'il a trouvé une «troisième voie» pour s'engager dans la science, ou, comme le dit Hogg, ce ne sont que des observations traditionnelles et une analyse de données «sur les stéroïdes», il est clair que l'IA change l'essence d'une découverte scientifique et l'accélère clairement. Jusqu'où ira la révolution de l'IA dans la science?

Des déclarations bruyantes sont faites périodiquement sur les réalisations des "robo-scientifiques". Il y a dix ans, le robot chimiste Adam a examiné le génome de la levure et a déterminé quels gènes sont responsables de la production de certains acides aminés. Il l'a fait en observant des souches de levure dépourvues de certains gènes et en comparant les résultats de leur comportement les uns avec les autres. Le magazine Wired a écrit: "Le

robot a fait une découverte scientifique par

lui-même ."

Un peu plus tard, Lee Cronin, chimiste à l'Université Glazko, a

utilisé un robot pour mélanger au hasard des produits chimiques pour voir si de nouveaux composés étaient apparus. En suivant les réactions en temps réel à l'aide d'un spectromètre de masse, d'une machine de résonance magnétique nucléaire et d'un spectromètre infrarouge, le système a finalement appris à prédire les combinaisons les plus réactives. Même si cela n'a pas conduit à des découvertes, a déclaré Cronin, un système robotique pourrait permettre aux chimistes d'accélérer leurs recherches de 90%.

L'année dernière, une autre équipe de scientifiques de Zurich a

utilisé des réseaux de neurones pour dériver des lois physiques basées sur des ensembles de données. Leur système, une sorte de Kepler robotique, a redécouvert le modèle héliocentrique du système solaire, basé sur des enregistrements de la localisation du Soleil et de Mars dans le ciel visible depuis la Terre, et a également déduit la loi de conservation de l'élan à partir d'observations de collisions de boules. Étant donné que les lois physiques peuvent souvent s'exprimer de plusieurs manières, les chercheurs souhaitent savoir si ce système peut offrir des façons nouvelles et peut-être plus simples de travailler avec des lois connues.

Tous ces exemples illustrent la façon dont l'IA accélère les découvertes scientifiques, bien que dans chaque cas, on puisse dire à quel point la nouvelle approche était révolutionnaire.

Le plus controversé sera peut-être la question de savoir combien d'informations peuvent être obtenues à partir des seules données - un problème important à l'ère des montagnes de données vastes et toujours croissantes. Dans The Book of Why, 2018, le spécialiste en informatique Jadi Pearl et l'écrivain de science populaire Dana Mackenzie suggèrent que les données sont une chose «incroyablement stupide». Les questions sur la causalité "ne peuvent jamais être répondues uniquement sur la base de données", écrivent-ils. «Chaque fois que vous voyez un travail ou une étude analysant des données sans prendre en compte les modèles, vous pouvez être sûr que le résultat de ce travail résume, et éventuellement transforme, mais n'interprète pas les données.» Shavinsky sympathise avec la position de Pearl, mais décrit l'idée de travailler uniquement avec des données comme quelque chose comme un «petit homme de tirets». Il a dit qu'il n'avait jamais indiqué la possibilité de dériver les causes et les effets des données."Je viens de dire que nous pouvons faire beaucoup plus avec les données que ce n'est habituellement le cas."Un autre argument commun est que la créativité est nécessaire pour la science, et au moins pour l'instant, nous ne savons pas comment la programmer. Une simple énumération de toutes les possibilités, comme l'a fait le robot chimiste Cronin, ne semble pas particulièrement créative. "Je pense que pour arriver à une théorie, des constructions logiques, la créativité est nécessaire", a déclaré Polsterer. "Chaque fois que vous avez besoin de créativité, vous avez besoin d'une personne." Et d'où vient la créativité? Polsterer soupçonne que cela est lié à l'ennui - le fait que, selon lui, la voiture n'a pas été mise à l'essai. «Pour être créatif, il ne faut pas aimer l'ennui. Et je ne pense pas que l'ordinateur s'ennuiera jamais. " D'un autre côté, des mots comme «créativité» et «inspiration» sont souvent utilisés pour décrire des programmes tels que Deep Blue et AlphaGo. Et des tentatives futiles pour décrirece qui se passe à l'intérieur de l'esprit de la machine est très similaire aux difficultés que nous rencontrons lors de l'étude de nos propres processus de pensée.Shavinsky a récemment quitté le monde universitaire en faveur du secteur commercial; Il dirige maintenant la startup Modulos, où travaillent de nombreux scientifiques de l'Institut technique suisse, et, selon leur site Web, «travaille dans l'œil d'une tempête de développements dans le domaine de l'IA et du machine learning». Quels que soient les obstacles entre l'IA moderne et l'intelligence artificielle à part entière, lui et d'autres experts pensent que les machines sont destinées à faire de plus en plus de travail de scientifiques. Y a-t-il des limites à cela, il suffit de le savoir.«Sera-t-il possible dans un avenir prévisible de créer une machine capable de faire des découvertes en physique ou en mathématiques dont les personnes les plus intelligentes qui utilisent des équipements biologiques ne sont pas capables? - pense Shavinsky. - La science du futur se développera-t-elle grâce à des machines fonctionnant à un niveau qui nous est inaccessible? Je ne sais pas.

C'est une bonne question. "