tl; dr:

- L'apprentissage automatique recherche des modèles dans les données. Mais l'intelligence artificielle peut être «biaisée», c'est-à-dire trouver les mauvais schémas. Par exemple, un système de détection du cancer de la peau à partir de photographies peut accorder une attention particulière aux photos prises dans le cabinet d'un médecin. Le machine learning ne sait pas comment: ses algorithmes ne révèlent que des schémas numériques, et si les données ne sont pas représentatives, le résultat de leur traitement le sera aussi. Et attraper de tels bugs peut être difficile en raison de la mécanique de l'apprentissage automatique.

- Le problème le plus évident et le plus effrayant est la diversité humaine. Il existe de nombreuses raisons pour lesquelles les données sur les personnes peuvent perdre leur objectivité même au stade de la collecte. Mais vous ne devez pas penser que ce problème ne concerne que les personnes: exactement les mêmes difficultés surviennent lorsque vous essayez de trouver une inondation dans un entrepôt ou une turbine à gaz en panne. Certains systèmes peuvent avoir des biais concernant la couleur de la peau, d'autres seront biaisés par rapport aux capteurs Siemens.

- Ces problèmes ne sont pas nouveaux dans l'apprentissage automatique et ils sont loin d'être uniques à lui. Des hypothèses incorrectes sont formulées dans toutes les structures complexes, et il est toujours difficile de comprendre pourquoi une décision a été prise. Il est nécessaire de traiter cela de manière complexe: créer des outils et des processus de vérification - et éduquer les utilisateurs afin qu'ils ne suivent pas aveuglément les recommandations de l'IA. L'apprentissage automatique fait vraiment beaucoup mieux que nous, mais les chiens, par exemple, sont beaucoup plus efficaces que les gens pour détecter les drogues, ce qui n'est pas une raison pour les amener comme témoins et prononcer des peines en fonction de leurs témoignages. Et les chiens, en passant, sont beaucoup plus intelligents que n'importe quel système d'apprentissage automatique.

L'apprentissage automatique est aujourd'hui l'une des tendances technologiques fondamentales les plus importantes. C'est l'un des principaux moyens par lesquels la technologie changera le monde qui nous entoure au cours de la prochaine décennie. Certains aspects de ces changements sont préoccupants. Par exemple, l'impact potentiel de l'apprentissage automatique sur le marché du travail ou son utilisation à des fins contraires à l'éthique (par exemple, les régimes autoritaires). Il y a un autre problème auquel cet article est dédié: le biais de l'intelligence artificielle .

C'est une histoire difficile.

Google AI peut trouver des chats. Cette nouvelle de 2012 était alors quelque chose de spécial.

Qu'est-ce que le biais AI?

Les «données brutes» sont à la fois un oxymore et une mauvaise idée; les données doivent être bien et soigneusement préparées. —Jeffrey Boker

Quelque part avant 2013, afin de créer un système qui, par exemple, reconnaît les chats sur les photos, vous deviez décrire les étapes logiques. Comment trouver des coins dans une image, reconnaître les yeux, analyser les textures pour la présence de fourrure, compter les pattes, etc. Ensuite, rassemblez tous les composants - et constatez que tout cela ne fonctionne pas vraiment. Quelque chose comme un cheval mécanique - théoriquement, cela peut être fait, mais dans la pratique, il est trop compliqué à décrire. À la sortie, vous avez des centaines (voire des milliers) de règles manuscrites. Et pas un seul modèle de travail.

Avec l'avènement du machine learning, nous avons cessé d'utiliser des règles «manuelles» pour reconnaître un objet. Au lieu de cela, nous prenons mille échantillons de «l'un», X, mille échantillons de «l'autre», Y, et forçons l'ordinateur à construire un modèle basé sur leur analyse statistique. Ensuite, nous donnons à ce modèle quelques exemples de données, et il détermine avec une certaine précision s'il correspond à l'un des ensembles. L'apprentissage automatique génère un modèle basé sur des données, et non avec l'aide de la personne qui les écrit. Les résultats sont impressionnants, en particulier dans le domaine de la reconnaissance d'images et de formes, et c'est pourquoi toute l'industrie technologique passe maintenant à l'apprentissage automatique (ML).

Mais pas si simple. Dans le monde réel, vos milliers d'exemples de X ou Y contiennent également A, B, J, L, O, R et même L. Ils peuvent être inégalement répartis, et certains d'entre eux peuvent être trouvés si souvent que le système leur accordera plus d'attention que aux objets qui vous intéressent.

Qu'est-ce que cela signifie dans la pratique? Mon exemple préféré est lorsque les systèmes de reconnaissance d'images regardent une colline herbeuse et disent «moutons» . On comprend pourquoi: la plupart des exemples de photos des «moutons» ont été prises dans les prairies où ils vivent, et dans ces images, l'herbe prend beaucoup plus de place que les petits duveteux blancs, et c'est l'herbe du système qui est considérée comme la plus importante.

Il y a des exemples plus sérieux. De récents - un projet pour détecter le cancer de la peau sur des photographies. Il s'est avéré que les dermatologues photographient souvent la gamme avec les manifestations du cancer de la peau afin de fixer la taille des formations. Sur des exemples de photographies d'une peau saine, il n'y a pas de règles. Pour le système d'IA, ces règles (plus précisément, les pixels que nous définissons comme une «règle») sont devenues l'une des différences entre les ensembles d'exemples, et parfois plus importantes qu'une petite éruption cutanée. Donc, un système conçu pour identifier le cancer de la peau, parfois au lieu de cela, a reconnu la ligne.

Le point clé ici est que le système n'a pas une compréhension sémantique de ce qu'il regarde. Nous regardons un ensemble de pixels et voyons un mouton, une peau ou des dirigeants en eux, et le système - seulement une droite numérique. Elle ne voit pas d'espace tridimensionnel, elle ne voit ni objets, ni textures, ni moutons. Elle voit juste des modèles dans les données.

La difficulté de diagnostiquer de tels problèmes est que le réseau neuronal (le modèle généré par votre système d'apprentissage automatique) se compose de milliers de centaines de milliers de nœuds. Il n'y a pas de moyen facile d'examiner un modèle et de voir comment il prend une décision. La présence d'une telle méthode signifierait que le processus est assez simple pour décrire toutes les règles manuellement, sans utiliser l'apprentissage automatique. Les gens craignent que l'apprentissage automatique soit devenu une sorte de boîte noire. (Je vais expliquer un peu plus tard pourquoi cette comparaison est encore trop.)

En termes généraux, c'est le problème du biais de l'intelligence artificielle ou de l'apprentissage automatique: un système de recherche de modèles dans les données peut trouver des modèles incorrects, mais vous ne le remarquerez peut-être pas. Il s'agit d'une caractéristique fondamentale de la technologie, et elle est évidente pour tous ceux qui travaillent avec elle dans la communauté scientifique et dans les grandes entreprises technologiques. Mais ses conséquences sont complexes, tout comme nos solutions possibles à ces conséquences.

Parlons d'abord des conséquences.

L'IA peut implicitement faire un choix pour nous en faveur de certaines catégories de personnes, sur la base d'un grand nombre de signaux discrets

Scénarios de biais IA

La chose la plus évidente et la plus effrayante est que ce problème peut se manifester en ce qui concerne la diversité humaine. Récemment , une rumeur a circulé selon laquelle Amazon aurait tenté de créer un système d'apprentissage automatique pour la sélection initiale des candidats. Puisqu'il y a plus d'hommes parmi les travailleurs d'Amazon, les exemples de «recrutement réussi» sont également plus fréquents que les hommes, et il y avait plus d'hommes dans la sélection des CV proposés par le système. Amazon l'a remarqué et n'a pas sorti le système en production.

La chose la plus importante dans cet exemple est que le système aurait favorisé les candidats masculins, malgré le fait que le sexe ne figurait pas sur le CV. Le système a vu d'autres modèles dans des exemples de «recrutement réussi»: par exemple, les femmes peuvent utiliser des mots spéciaux pour décrire les réalisations, ou avoir des passe-temps spéciaux. Bien sûr, le système ne savait pas ce qu'était le «hockey», ni qui sont les «gens», ni ce qui était le «succès» - il a simplement effectué une analyse statistique du texte. Mais les schémas qu'elle a vus seraient probablement restés inaperçus par la personne, et certains d'entre eux (par exemple, le fait que des personnes de sexes différents décrivent le succès différemment), il serait probablement difficile pour nous de voir, même en les regardant.

Pire encore. Un système d'apprentissage automatique qui détecte très bien le cancer sur une peau pâle peut fonctionner pire avec une peau foncée, ou vice versa. Pas nécessairement à cause du biais, mais parce que vous devez probablement créer un modèle distinct pour une couleur de peau différente, en choisissant d'autres caractéristiques. Les systèmes d'apprentissage automatique ne sont pas interchangeables même dans un domaine aussi étroit que la reconnaissance d'image. Vous devez configurer le système, parfois simplement par essais et erreurs, pour bien remarquer les fonctionnalités des données qui vous intéressent, jusqu'à ce que vous atteigniez la précision souhaitée. Mais vous ne remarquerez peut-être pas que le système dans 98% des cas est précis lorsque vous travaillez avec un groupe et seulement dans 91% (bien que cela soit plus précis que l'analyse effectuée par une personne) de l'autre.

Jusqu'à présent, j'ai principalement utilisé des exemples concernant les personnes et leurs caractéristiques. La discussion autour de ce problème se concentre principalement sur ce sujet. Mais il est important de comprendre que le parti pris envers les gens n'est qu'une partie du problème. Nous utiliserons l'apprentissage automatique pour de nombreuses choses, et une erreur d'échantillonnage sera pertinente pour toutes. D'un autre côté, si vous travaillez avec des personnes, le biais de données peut ne pas leur être lié.

Pour comprendre cela, revenons à l'exemple du cancer de la peau et considérons trois possibilités hypothétiques de panne du système.

- Répartition inhomogène des personnes: un nombre déséquilibré de photographies de la peau dans des tons différents, ce qui conduit à des résultats faussement positifs ou faux négatifs associés à la pigmentation.

- Les données sur lesquelles le système est formé contiennent une caractéristique fréquemment rencontrée et hétérogène qui n'est pas liée aux personnes et n'a pas de valeur diagnostique: une règle sur les photographies des manifestations du cancer de la peau ou de l'herbe sur les photographies des moutons. Dans ce cas, le résultat sera différent si le système trouve des pixels dans l'image de quelque chose que l'œil humain définit comme une «règle».

- Les données contiennent une caractéristique tierce qu'une personne ne peut pas voir, même si elle la recherche.

Qu'est-ce que cela signifie? Nous savons a priori que les données peuvent être présentées différemment par différents groupes de personnes, et au moins nous pouvons envisager de rechercher de telles exceptions. En d'autres termes, il existe un tas de raisons sociales pour supposer que les données sur les groupes de personnes contiennent déjà un certain biais. Si nous regardons la photo avec la règle, nous verrons cette règle - nous l'avons simplement ignorée auparavant, sachant que cela n'a pas d'importance et oubliant que le système ne sait rien.

Mais que se passe-t-il si toutes vos photos de peau malsaine ont été prises dans un bureau où des ampoules à incandescence sont utilisées et en bonne santé sous une lumière fluorescente? Et si, après avoir retiré la peau saine, avant de prendre des photos malsaines, vous avez mis à jour le système d'exploitation sur le téléphone et qu'Apple ou Google ont légèrement modifié l'algorithme de réduction du bruit? Une personne ne peut pas le remarquer, peu importe combien elle recherche de telles fonctionnalités. Mais le système d'utilisation de la machine le verra et l'utilisera immédiatement. Elle ne sait rien.

Bien que nous ayons parlé de fausses corrélations, il peut arriver que les données soient exactes et les résultats corrects, mais vous ne voulez pas les utiliser pour des raisons éthiques, juridiques ou administratives. Dans certaines juridictions, par exemple, il n'est pas possible d'accorder aux femmes un rabais sur l'assurance, bien que les femmes puissent être plus en sécurité au volant. Nous pouvons facilement imaginer un système qui, lors de l'analyse des données historiques, attribuera des facteurs de risque plus faibles aux noms féminins. Ok, supprimons les noms de la sélection. Mais rappelez-vous l'exemple avec Amazon: le système peut déterminer le sexe par d'autres facteurs (bien qu'il ne sache pas quel est le sexe et ce qu'est une machine), et vous ne le remarquerez pas tant que le régulateur n'analysera pas rétroactivement les tarifs que vous proposez et ne vous facturera pas tu vas bien.

Enfin, il est souvent implicite que nous n'utiliserons de tels systèmes que pour des projets liés aux personnes et aux interactions sociales. Ce n'est pas le cas. Si vous fabriquez des turbines à gaz, vous voudrez probablement appliquer l'apprentissage automatique à la télémétrie transmise par des dizaines ou des centaines de capteurs sur votre produit (audio, vidéo, température et tout autre capteur génère des données qui peuvent être très facilement adaptées pour créer un modèle d'apprentissage automatique ) Hypothétiquement, vous pouvez dire: «Voici les données sur mille turbines en panne obtenues avant leur panne, mais voici les données sur mille turbines qui ne sont pas tombées en panne. Construisez un modèle pour dire quelle est la différence entre eux. » Eh bien, imaginez maintenant que les capteurs Siemens coûtent 75% des mauvaises turbines et seulement 12% des bonnes (il n'y a aucun lien avec les pannes). Le système construira un modèle pour localiser les turbines avec des capteurs Siemens. Oups!

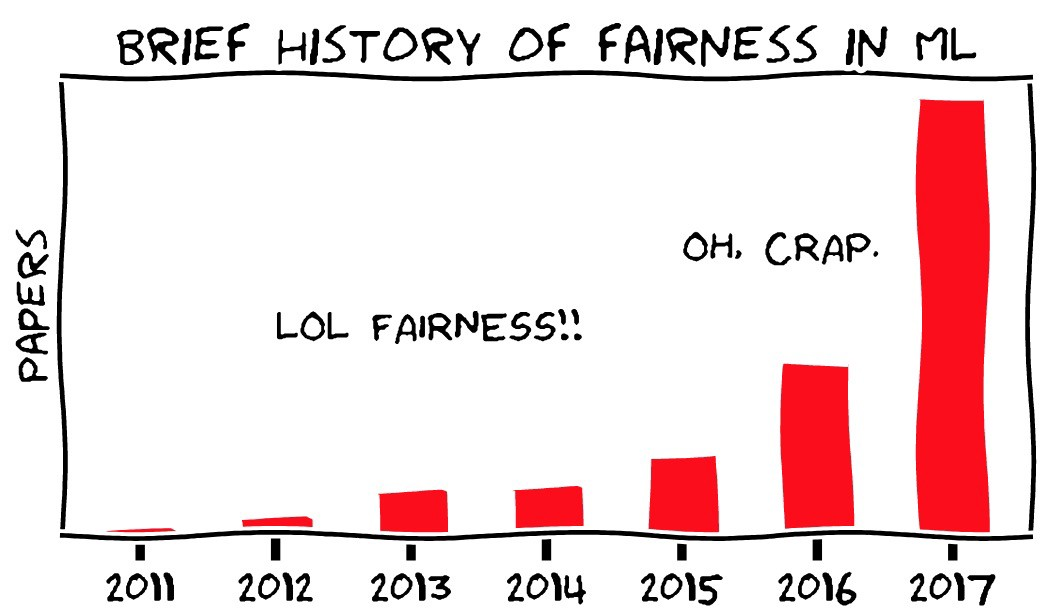

Image - Moritz Hardt, UC, Berkeley

Gestion des biais de l'IA

Que pouvons-nous y faire? Vous pouvez aborder le problème de trois côtés:

- Rigueur méthodologique dans la collecte et la gestion des données pour la formation du système.

- Outils techniques pour analyser et diagnostiquer le comportement du modèle.

- Formation, éducation et prudence dans l'introduction de l'apprentissage automatique dans les produits.

Il y a une blague dans le livre de Molière "Le marchand dans la noblesse": un homme a été informé que la littérature est divisée en prose et poésie, et il admire avec admiration qu'il a parlé en prose toute sa vie sans le savoir. Probablement, les statisticiens se sentent en quelque sorte comme ça aujourd'hui: sans le remarquer, ils ont consacré leur carrière à l'intelligence artificielle et aux erreurs d'échantillonnage. Pour rechercher une erreur d'échantillonnage et s'inquiéter, ce n'est pas un nouveau problème, il suffit d'approcher systématiquement sa solution. Comme mentionné ci-dessus, dans certains cas, il est vraiment plus facile de le faire en étudiant les problèmes associés aux données des personnes. Nous supposons a priori que nous pouvons avoir des idées préconçues sur différents groupes de personnes, mais il nous est difficile d'imaginer un préjugé à propos des capteurs Siemens.

La nouveauté dans tout cela, bien sûr, est que les gens ne sont plus directement impliqués dans l'analyse statistique. Elle est réalisée par des machines qui créent de grands modèles complexes et difficiles à comprendre. La question de la transparence est l'un des principaux aspects du problème des biais. Nous avons peur que le système ne soit pas seulement biaisé, mais qu'il n'y ait aucun moyen de détecter son biais, et que l'apprentissage automatique soit différent des autres formes d'automatisation, qui sont censées consister en des étapes logiques claires qui peuvent être vérifiées.

Il y a deux problèmes ici. Nous pouvons peut-être néanmoins mener un audit des systèmes d'apprentissage automatique. Et l'audit de tout autre système n'est en fait pas du tout plus facile.

Premièrement, l'un des domaines de la recherche moderne dans le domaine de l'apprentissage automatique est la recherche de méthodes pour identifier les fonctionnalités importantes des systèmes d'apprentissage automatique. Dans le même temps, le machine learning (dans son état actuel) est un tout nouveau domaine scientifique qui évolue rapidement, vous ne devriez donc pas penser que les choses impossibles aujourd'hui ne peuvent pas bientôt devenir tout à fait réelles. Le projet OpenAI en est un exemple intéressant.

Deuxièmement, l'idée qu'il est possible de vérifier et de comprendre le processus décisionnel dans les systèmes ou organisations existants est bonne en théorie, mais pas du tout en pratique. Comprendre comment les décisions sont prises dans une grande organisation est loin d'être facile. Même s'il y a là un processus décisionnel formel, il ne reflète pas la façon dont les gens interagissent réellement et, en fait, ils n'ont souvent pas d'approche logique systématique pour prendre leurs décisions. Comme l'a dit mon collègue Vijay Pande , les gens sont aussi des boîtes noires .

Prenez un millier de personnes dans plusieurs entreprises et institutions qui se chevauchent et le problème deviendra encore plus compliqué. Nous savons après le fait que la navette spatiale était destinée à s'effondrer à leur retour, et certaines personnes à l'intérieur de la NASA avaient des informations qui leur donnaient des raisons de penser que quelque chose de mauvais pouvait arriver, mais le système dans son ensemble ne savait pas. La NASA vient même de passer un audit similaire, après avoir perdu la navette précédente, et pourtant elle en a perdu une autre - pour une raison très similaire. Il est facile de dire que les organisations et les personnes suivent des règles logiques claires qui peuvent être vérifiées, comprises et modifiées - mais l'expérience prouve le contraire. Il s'agit de «l' erreur de la Commission de planification de l'État ».

Je compare souvent l'apprentissage automatique avec des bases de données, en particulier relationnelles - une nouvelle technologie fondamentale qui a changé les capacités de l'informatique et du monde qui l'entoure, qui fait désormais partie de tout ce que nous utilisons constamment sans le savoir. Les bases de données ont également des problèmes et ont une propriété similaire: le système peut être construit sur des hypothèses incorrectes ou sur de mauvaises données, mais il sera difficile de le remarquer et les personnes utilisant le système feront ce qu'il leur dira sans poser de questions. Il y a un tas de vieilles blagues sur les travailleurs fiscaux qui autrefois ont mal orthographié votre nom, et les convaincre de corriger l'erreur est beaucoup plus difficile que de changer réellement le nom. Cela peut être envisagé de différentes manières, mais la meilleure solution n'est pas claire: qu'en est-il d'un problème technique dans SQL, ou d'une erreur dans la version d'Oracle, ou de l'échec des institutions bureaucratiques? , , , ? , ?

, - . , . , ?

, — . , , ( ) , . , , , , . , - - , , . “ ” , , , , . . , . .

Conclusion

, , — , .

, « » . , — . HAL9000 Skynet — -, . Mais non. , , , . , , … . . , , , - . , — , , .

, — , — . , , .

, , « — , » . , « ». , , , . , . , — , , , . , , .

: .

: .

: @PonchikNews .