IEEE P802.3ba, une norme pour le transfert de données sur des canaux Ethernet 100 gigabits (100GbE), a été développée de 2007 à 2010 [3], mais n'a été largement utilisée qu'en 2018 [5]. Pourquoi en 2018, et pas plus tôt? Et pourquoi immédiatement en masse? Il y a au moins cinq raisons ...

IEEE P802.3ba a été développé principalement pour répondre aux besoins des centres de données et aux besoins des points d'échange de trafic Internet (entre opérateurs indépendants); ainsi que pour assurer le bon fonctionnement des services Web gourmands en ressources, tels que les portails avec une grande quantité de contenu vidéo (par exemple, YouTube); et pour le calcul haute performance. [3] Les utilisateurs ordinaires d'Internet contribuent également à l'évolution des besoins en bande passante: beaucoup ont des appareils photo numériques et les gens veulent transmettre le contenu qu'ils ont filmé via Internet. T.O. le volume de contenu qui circule sur Internet au fil du temps devient de plus en plus. Tant au niveau professionnel que consommateur. Dans tous ces cas, lors du transfert de données d'un domaine à un autre, la bande passante agrégée des nœuds de réseau clés dépasse depuis longtemps les capacités des ports 10 GbE. [1] C'est la raison de l'émergence d'une nouvelle norme: 100GbE.

Les grands centres de données et les fournisseurs de services cloud utilisent déjà activement le 100 GbE et prévoient de passer progressivement à 200 GbE et 400 GbE dans quelques années. En même temps, ils visent déjà des vitesses dépassant le térabit. [6] Bien que certains grands fournisseurs soient passés au 100 GbE l'année dernière (par exemple, Microsoft Azure). Les centres de données qui effectuent des calculs à haute performance pour les services financiers, les plates-formes gouvernementales, les plates-formes pétrolières et gazières et les services publics ont également commencé à passer au 100GbE. [5]

Dans les centres de données d'entreprise, la demande de bande passante est légèrement inférieure: ce n'est que récemment que le 10 GbE est devenu un besoin urgent ici, et non un luxe. Cependant, comme le taux de consommation de trafic augmente plus rapidement, il est douteux que le 10GbE vive dans les centres de données d'entreprise pendant au moins 10 ou même 5 ans. Au lieu de cela, nous verrons une transition rapide vers 25 GbE et encore plus rapidement vers 100 GbE. [6] Parce que, comme le notent les analystes d'Intel, l'intensité du trafic à l'intérieur du centre de données augmente de 25% par an. [5]

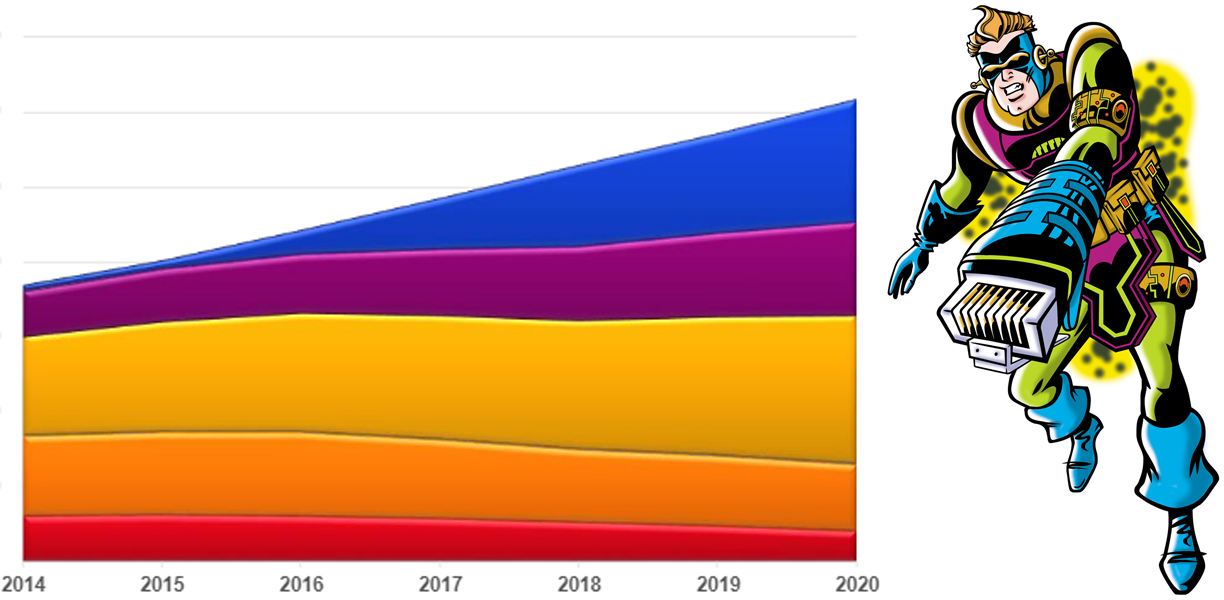

Les analystes de Dell et Hewlett Packard affirment [4] que 2018 est l'année du 100 GbE pour les centres de données. En août 2018, les livraisons d'équipements 100 GbE ont doublé les fournitures pour toute l'année 2017. Et le rythme de l'offre continue de croître, alors que les centres de données ont commencé à s'éloigner massivement du 40GbE. On prévoit que d'ici 2022, 19,4 millions de ports 100 GbE seront livrés chaque année (en 2017, à titre de comparaison, ce chiffre était de 4,6 millions). [4] En ce qui concerne les coûts, 7 milliards de dollars ont été dépensés pour des ports 100 GbE en 2017, et en 2020, selon les prévisions, environ 20 milliards de dollars seront dépensés (voir la figure 1). [1]

Figure 1. Statistiques et prévisions de la demande d'équipements de réseau

Pourquoi maintenant? Le 100GbE n'est pas une technologie si nouvelle, alors pourquoi y a-t-il une telle agitation en ce moment?

1) Parce que cette technologie a mûri et est devenue moins chère. C'est en 2018 que nous avons franchi la ligne d'arrivée lorsque l'utilisation de plates-formes avec des ports de 100 gigabits dans le centre de données est devenue plus rentable que le «cumul» de plusieurs plates-formes de 10 gigabits. Exemple: Ciena 5170 (voir la figure 2) est une plate-forme compacte fournissant un débit global à 800 GbE (4x100 GbE, 40x10 GbE). Si plusieurs ports de 10 gigabits sont nécessaires pour fournir le débit nécessaire, le coût du fer supplémentaire, de l'espace supplémentaire, de la consommation électrique excessive, de la maintenance, des pièces de rechange supplémentaires et des systèmes de refroidissement supplémentaires représente un montant assez rond. [1] Par exemple, les spécialistes de Hewlett Packard, analysant les avantages potentiels du passage de 10GbE à 100GbE, sont arrivés aux chiffres suivants: performances supérieures (56%), coûts totaux inférieurs (27%), consommation électrique réduite (31%), simplification interconnexions de câbles (de 38%). [5]

Figure 2. Ciena 5170: exemple de plateforme avec 100 ports gigabits

2) Juniper et Cisco ont enfin créé leurs propres puces ASIC pour les commutateurs 100GbE. [5] Ce qui est une confirmation éloquente du fait que la technologie 100GbE est vraiment mûre. Le fait est qu'il est rentable de créer des microcircuits ASIC uniquement lorsque, d'une part, la logique mise en œuvre sur eux ne nécessite pas de changements dans un avenir prévisible, et d'autre part, lorsqu'un grand nombre de microcircuits identiques sont fabriqués. Juniper et Cisco ne produiraient pas ces ASIC sans avoir confiance en la maturité du 100GbE.

3) Parce que Broadcom, Cavium et Mellanox Technologie ont commencé à poinçonner des processeurs avec une prise en charge 100GbE, et ces processeurs sont déjà utilisés dans les commutateurs de fabricants tels que Dell, Hewlett Packard, Huawei Technologies, Lenovo Group, etc. [5]

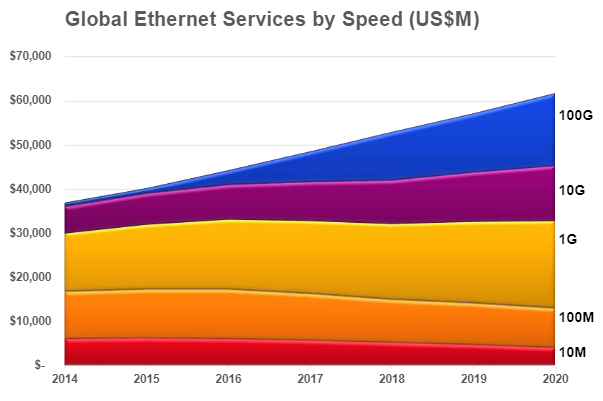

4) Parce que les serveurs situés dans les racks de serveurs sont de plus en plus équipés des dernières cartes réseau Intel (voir figure 3), avec deux ports 25 gigabits, et parfois même des cartes réseau convergées avec deux ports 40 gigabits (XXV710 et XL710) .

Figure 3. Dernières cartes réseau Intel: XXV710 et XL710

5) Parce que l'équipement 100GbE est rétrocompatible, ce qui simplifie le déploiement: vous pouvez réutiliser des câbles déjà câblés (il suffit de leur connecter un nouvel émetteur-récepteur).

De plus, la disponibilité de 100 GbE nous prépare à de nouvelles technologies, telles que NVMe over Fabrics (par exemple, Samsung Evo Pro 256 Go NVMe PCIe SSD; voir Fig. 4) [8, 10], Storage Area Network (SAN) / «Stockage défini par logiciel» (voir Fig. 5) [7], RDMA [11], qui sans 100 GbE ne pourrait pas atteindre son plein potentiel.

Figure 4. SSD Samsung Evo Pro 256 Go NVMe PCIe

Figure 5. «Storage Area Network» (SAN) / «Software Defined Storage»

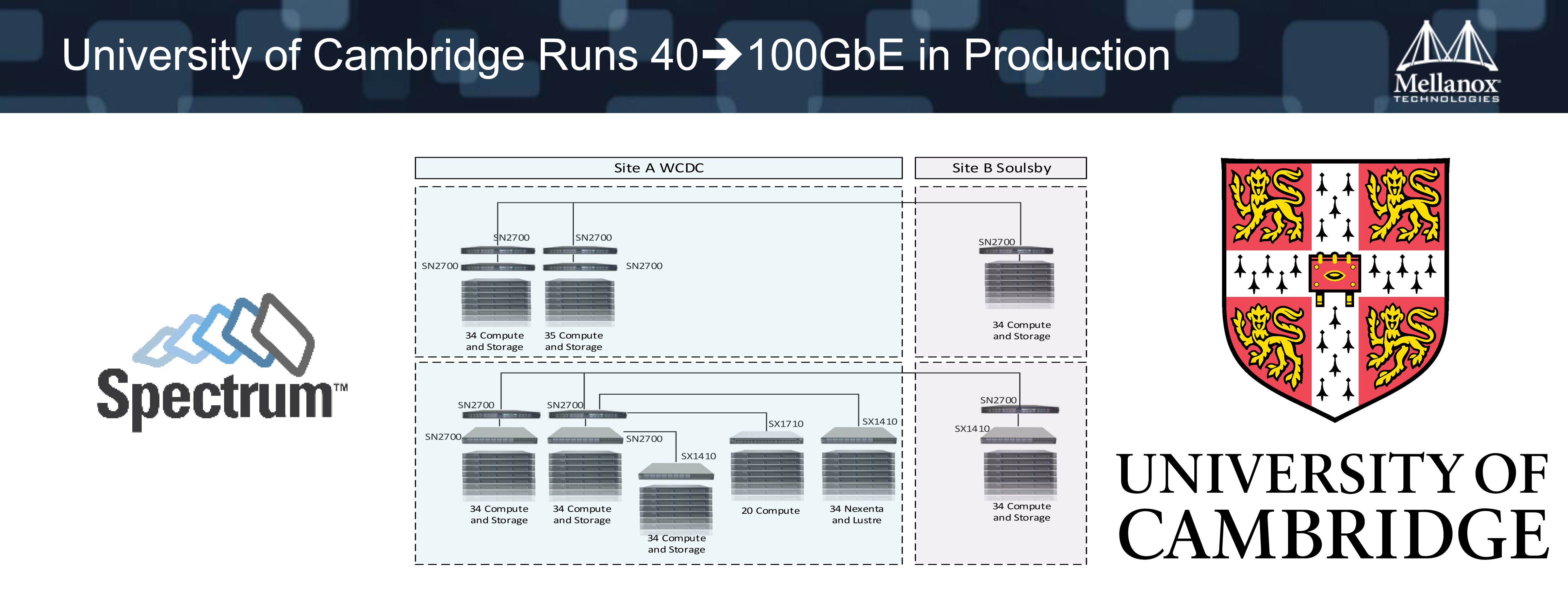

Enfin, comme exemple exotique de la pertinence pratique de l'utilisation du 100GbE et des technologies à haute vitesse associées, nous pouvons citer le cloud scientifique de l'Université de Cambridge (voir figure 6), qui est construit sur la base du 100GbE (commutateurs Ethernet Spectrum SN2700), afin, entre autres, Assurez le fonctionnement efficace du stockage sur disque distribué NexentaEdge SDS, qui peut facilement surcharger un réseau 10 / 40GbE. [2] De tels nuages scientifiques à haute performance sont déployés pour résoudre une grande variété de problèmes scientifiques appliqués [9, 12]. Par exemple, les scientifiques médicaux utilisent de tels nuages pour décrypter le génome humain, et des canaux 100GbE sont utilisés pour transférer des informations entre des groupes de recherche d'universités.

Figure 6. Fragment d'un nuage scientifique à l'Université de Cambridge