Mes amis, beaucoup se souviennent probablement des images du trou noir qui ont choqué tout le monde en avril de cette année. Nous avons trouvé un matériau très intéressant dans lequel nous parlerons de ce que les algorithmes d'intelligence artificielle «pensent» de l'image d'un trou noir. En traduisant ce matériel, nous continuons une série de publications dédiées au lancement du cours

Python Neural Networks . Nous vous avertissons que le matériel s'est avéré plus divertissant qu'informatif, mais ces images valent vraiment la peine d'être vues. Allons-y.

Le 11 avril, des scientifiques et des ingénieurs de l'équipe du télescope Event Horizon ont fait une véritable percée dans la compréhension des processus qui se produisent dans l'espace. Ils ont présenté la première image (photographie) d'un trou noir. Cela a encore renforcé la théorie générale de la relativité d'Einstein, à savoir l'hypothèse selon laquelle «les objets massifs provoquent une distorsion dans l'espace-temps, qui se reflète sous la forme de changements gravitationnels».

Eh bien, je ne suis ni physicien ni astronome pour comprendre ou expliquer comment cela fonctionne, mais moi, comme des millions de personnes travaillant dans divers domaines, je suis fasciné par l'espace et surtout par le phénomène du trou noir. La première image d'un trou noir a provoqué une vague de délices dans le monde entier. Je suis un spécialiste de l'apprentissage profond, qui travaille principalement avec les réseaux de neurones convolutionnels, et il est devenu intéressant pour moi que les algorithmes d'intelligence artificielle «réfléchissent» à l'image d'un trou noir. C'est ce dont nous parlerons dans l'article.

Cet extrait de

Epoch Times décrit le trou noir comme suit: «Les trous noirs sont constitués de« beaucoup de matière emballée dans un très petit espace », principalement formée de« les restes d'une grande étoile décédée lors d'une explosion de supernova ». Les trous noirs ont un champ gravitationnel si puissant que même la lumière ne peut y échapper. L'image résultante du trou noir M87 est présentée ci-dessous. Ce phénomène est bien expliqué dans l'article

«Comment donner un sens à l'image du trou noir, selon 2 astrophysiciens» .

Black Hole - M87 - Télescope Event Horizon

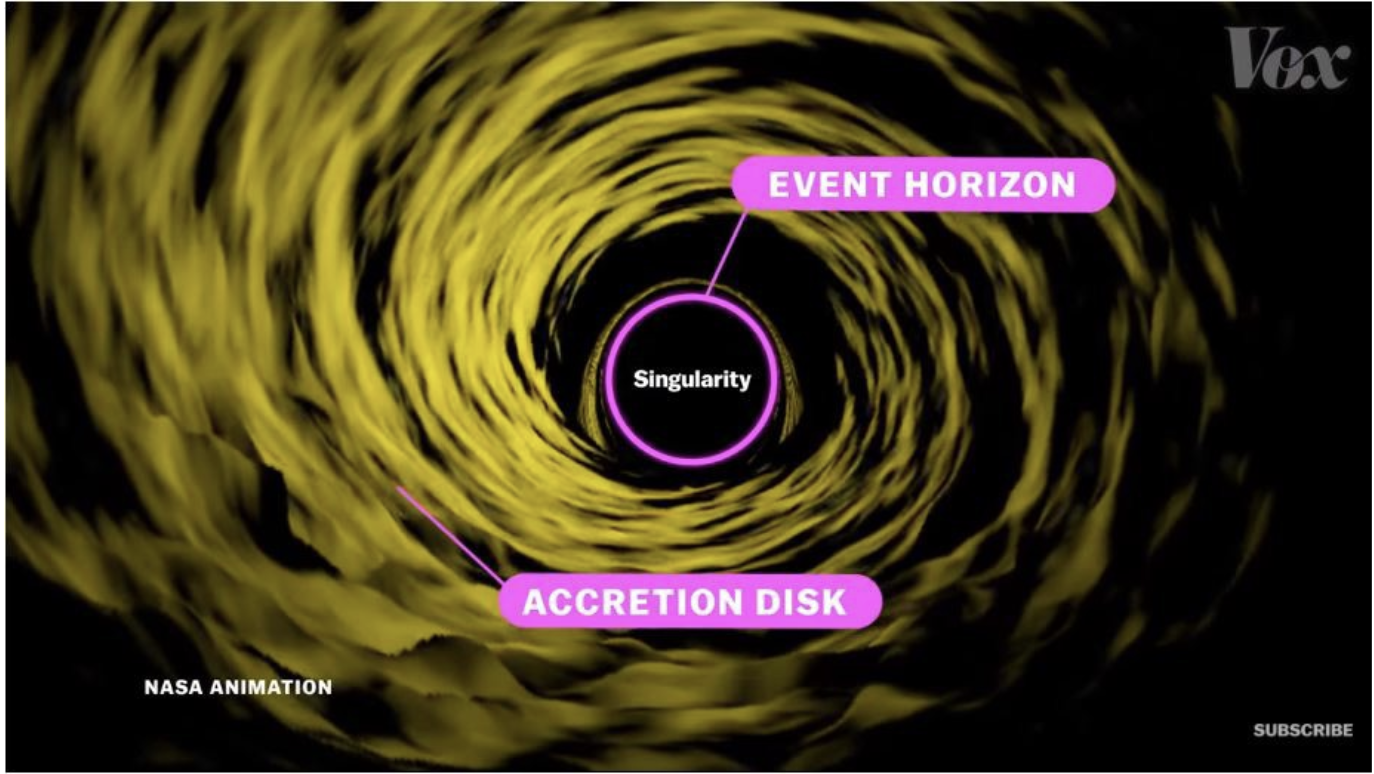

Black Hole - M87 - Télescope Event Horizon Différentes zones d'un trou noir. Capture d'écran de la vidéo vox - Pourquoi cette photo du trou noir est si importante1. Ce que CCN voit dans l'image d'un trou noir

Différentes zones d'un trou noir. Capture d'écran de la vidéo vox - Pourquoi cette photo du trou noir est si importante1. Ce que CCN voit dans l'image d'un trou noirCCN (Convolution Neural Network) - réseaux de neurones à convolution - une classe d'algorithmes d'apprentissage en profondeur qui est extrêmement efficace pour reconnaître des objets du monde réel. Les CCN sont les meilleurs réseaux de neurones pour interpréter et reconnaître les images. Ces réseaux de neurones sont formés sur un million d'images et formés pour reconnaître environ 1000 objets différents du monde environnant. J'ai pensé à montrer l'image d'un trou noir à deux réseaux de neurones convolutionnels formés et voir comment ils le reconnaissent, quel objet du monde qui l'entoure ressemble à un trou noir. Ce n'est pas une idée sage, car l'image d'un trou noir a été générée en combinant divers signaux reçus de l'espace à l'aide d'un équipement spécial, mais je voulais juste savoir comment l'image serait interprétée sans aucune information supplémentaire sur les signaux.

VGG-16 Neural Network Forecast - Correspondance

VGG-16 Neural Network Forecast - Correspondance VGG-19 Neural Network Forecast - Correspondance

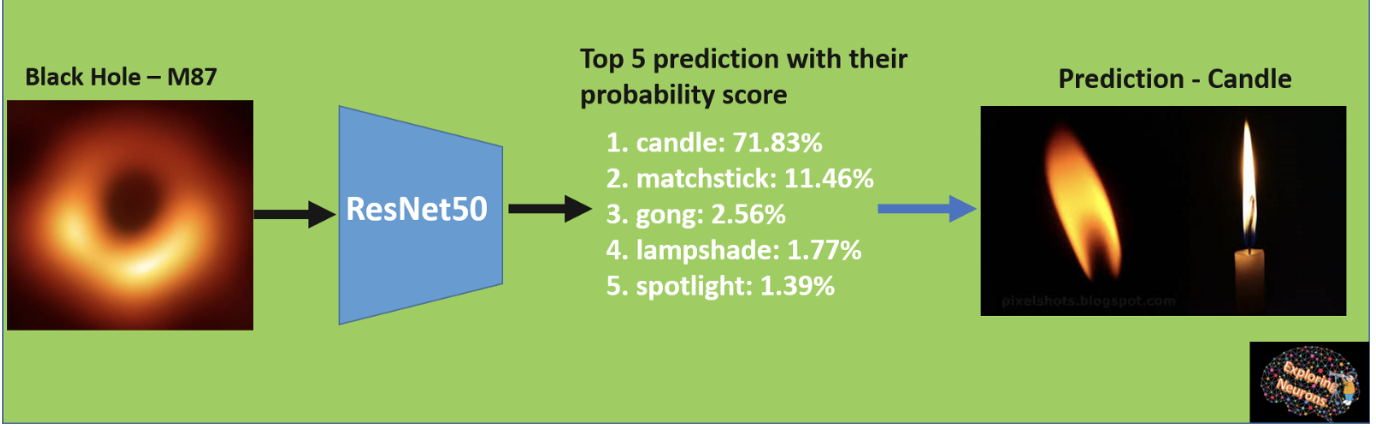

VGG-19 Neural Network Forecast - Correspondance Réseau de neurones Forecast ResNet-50 - Bougie

Réseau de neurones Forecast ResNet-50 - BougieComme nous le voyons dans les images ci-dessus, les VGG-16 et VGG-19 entraînés voient un trou noir comme une correspondance, et ResNet-50 pense que c'est une bougie. Si nous établissons une analogie avec ces objets, nous comprendrons que cela a un certain sens, car l'allumette allumée et la bougie ont un centre sombre entouré d'une dense lumière jaune vif.

2. Quels sont les signes CCN extraits de l'image d'un trou noirJ'ai fait encore une chose, j'ai visualisé ce que génèrent les couches intermédiaires VGG-16. Les réseaux d'apprentissage en profondeur sont appelés profonds, car ils ont un certain nombre de couches, et chacun d'eux traite la représentation et les caractéristiques de l'image à l'entrée. Voyons ce que les différentes couches du réseau apprennent de l'image entrante. Le résultat était plutôt beau.

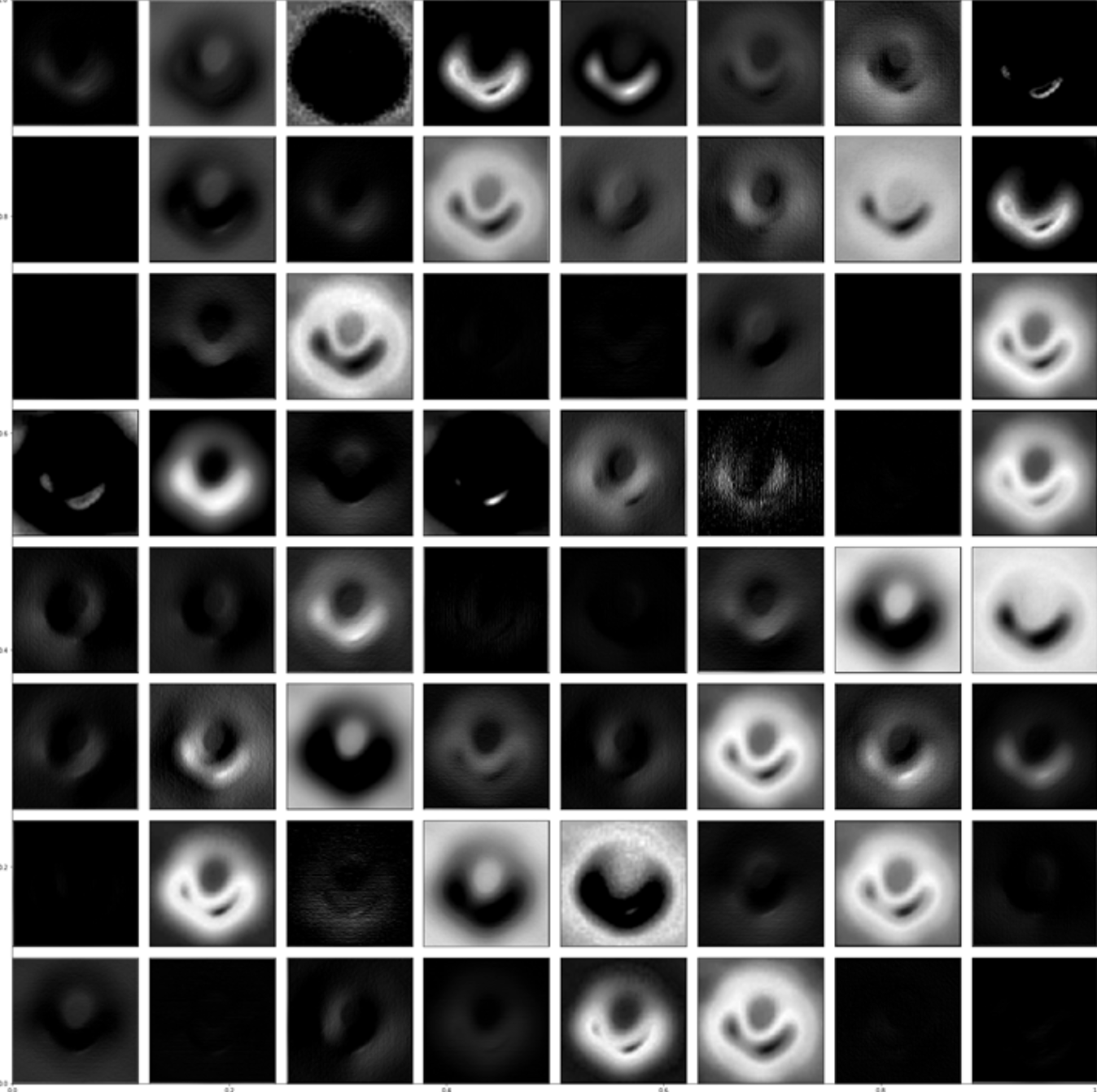

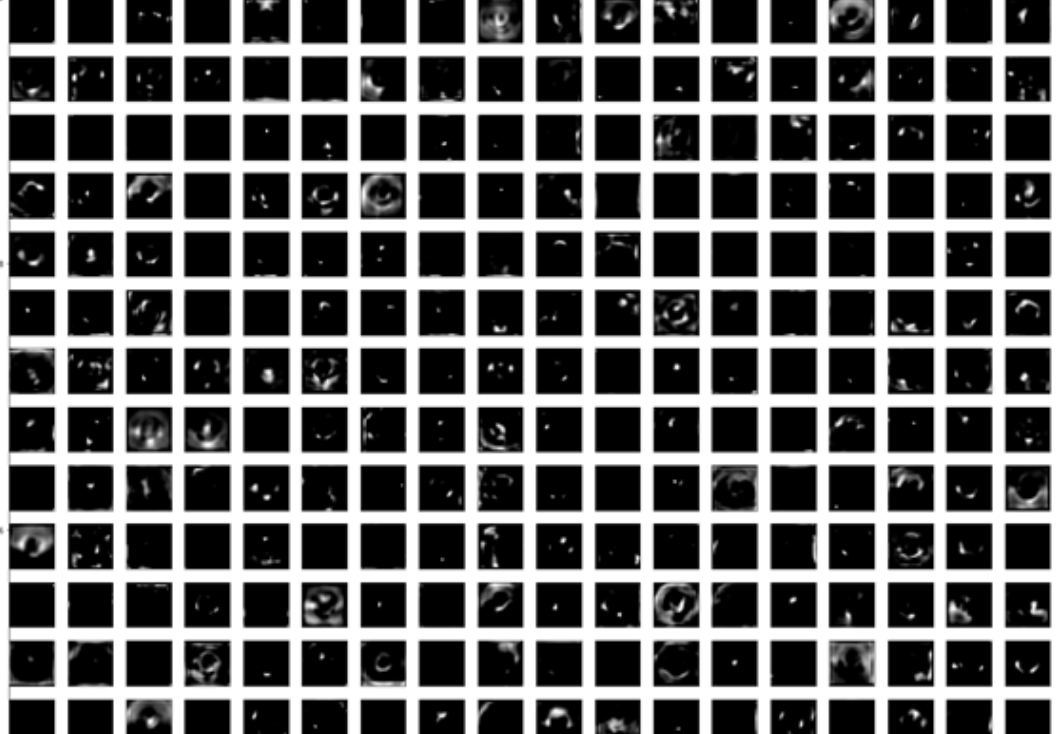

64 cartes caractéristiques de la première couche convolutionnelle VGG-16

64 cartes caractéristiques de la première couche convolutionnelle VGG-16Si vous regardez de plus près, vous verrez qu'une petite zone lumineuse est un signe fort et qu'elle est absorbée après avoir traversé la plupart des filtres. Certaines sorties de filtre intéressantes sont présentées ci-dessous, et elles ressemblent déjà vraiment à une sorte d'objet céleste.

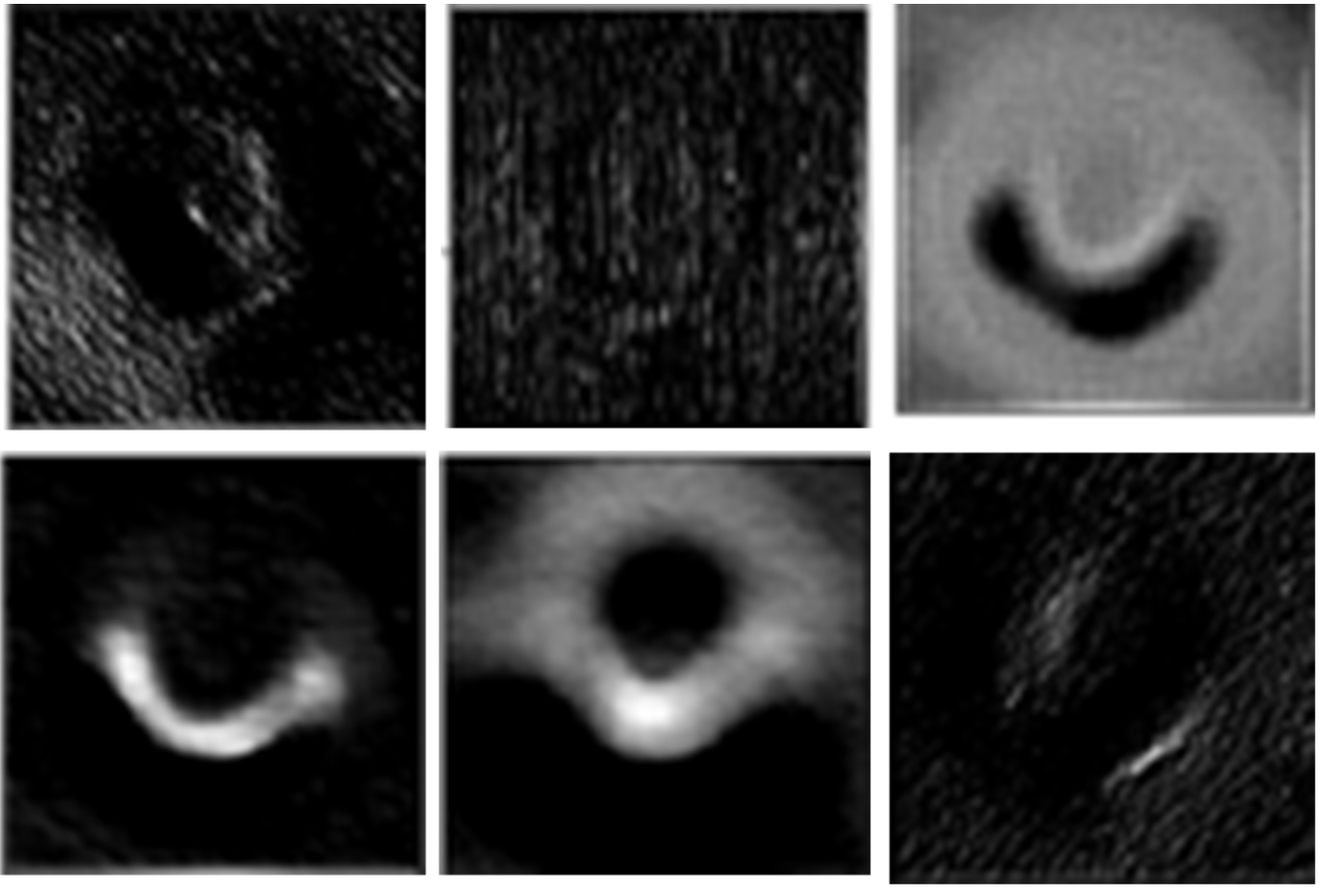

4 des 64 cartes fonctionnelles de la première couche convolutionnelle

4 des 64 cartes fonctionnelles de la première couche convolutionnelle 64 cartes caractéristiques de la deuxième couche convolutionnelle VGG-16

64 cartes caractéristiques de la deuxième couche convolutionnelle VGG-16Zoomez sur des cartes intéressantes de la deuxième couche du réseau neuronal.

6 des 64 cartes caractéristiques de la deuxième couche convolutionnelle

6 des 64 cartes caractéristiques de la deuxième couche convolutionnelleNous allons maintenant aller encore plus loin et regarder la troisième couche convolutionnelle.

128 cartes fonctionnelles de la troisième couche convolutionnelle VGG-16

128 cartes fonctionnelles de la troisième couche convolutionnelle VGG-16Après avoir approché, nous trouvons un modèle familier.

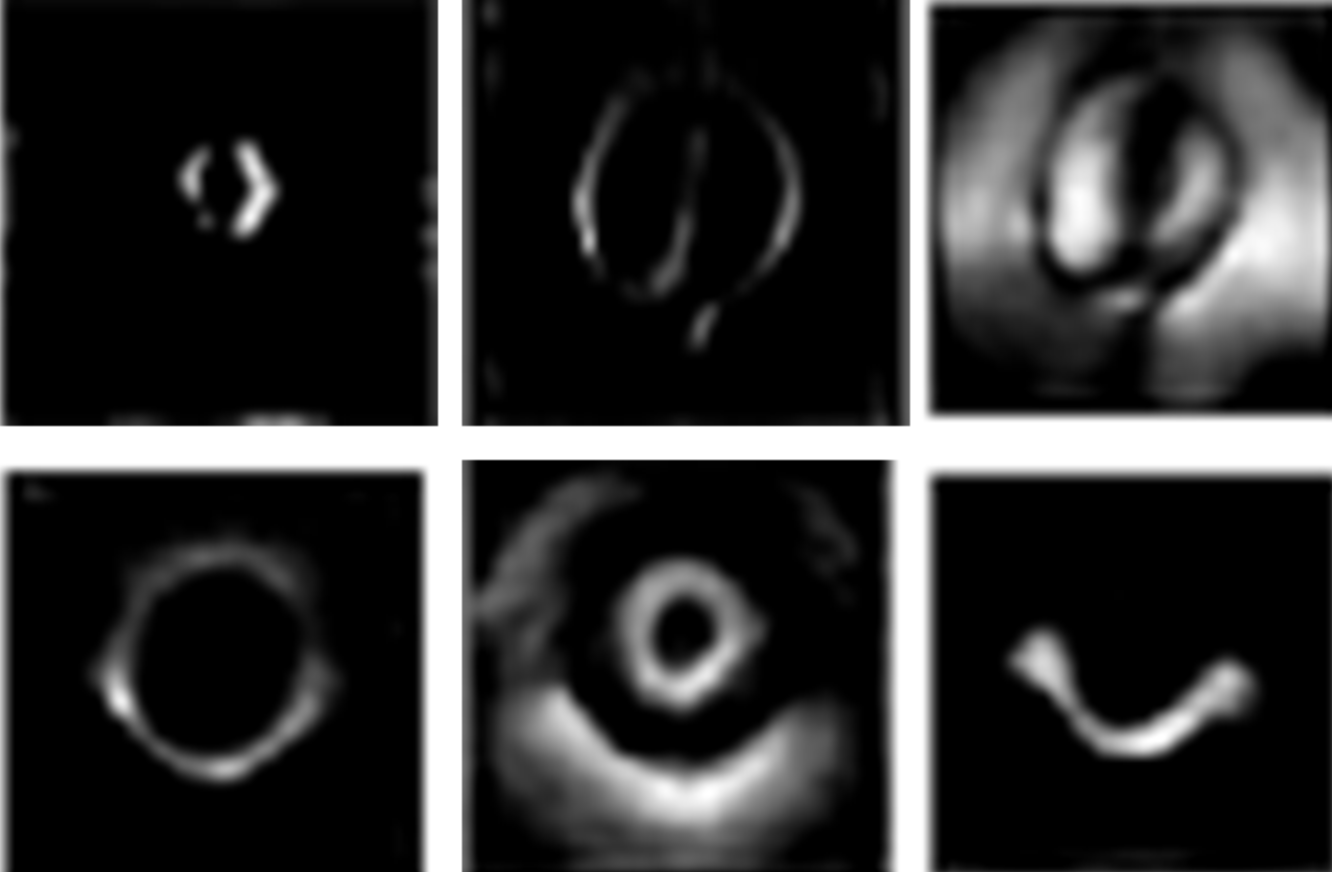

8 des cartes d'entités présentées ci-dessus sur la troisième couche

8 des cartes d'entités présentées ci-dessus sur la troisième coucheEn approfondissant, nous obtenons quelque chose comme ça.

6 cartes sur 128 avec 4 couches convolutives VGG-16

6 cartes sur 128 avec 4 couches convolutives VGG-16En approfondissant, nous obtenons des informations abstraites de plus haut niveau, et lorsque nous visualisons les 7e, 8e et 10e couches de la convolution, nous ne verrons que des informations de haut niveau.

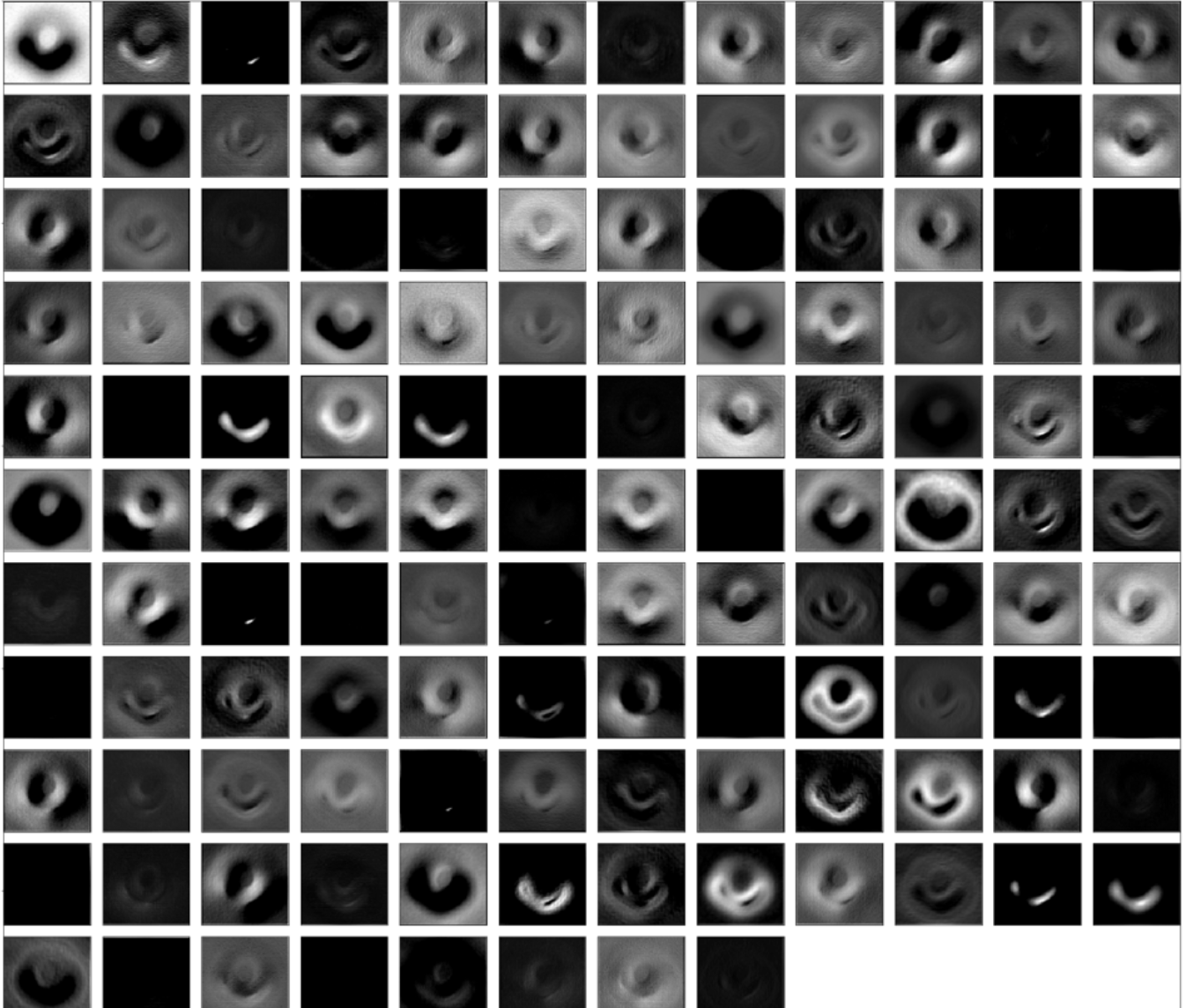

Carte des caractéristiques de la 7e couche convolutionnelle

Carte des caractéristiques de la 7e couche convolutionnelleComme nous pouvons le voir, de nombreuses cartes de fonctionnalités sont sombres et n'apprennent que les fonctionnalités de haut niveau spécifiques nécessaires pour reconnaître cette classe. Dans les couches plus profondes, ils deviennent plus visibles. Maintenant, nous zoomons et jetons un œil à certains filtres.

6 cartes fonctionnelles

6 cartes fonctionnellesConsidérons maintenant 512 cartes de caractéristiques de la 10e couche convolutionnelle.

Cartes fonctionnelles 10 couche convolutionnelle.

Cartes fonctionnelles 10 couche convolutionnelle.Vous voyez maintenant que dans la plupart des cartes d'entités reçues, seule la zone d'image est acceptée comme entité. Ce sont des signes de haut niveau visibles par les neurones. Examinons de plus près certaines des cartes de fonctionnalités ci-dessus.

Certaines des cartes fonctionnelles ont 10 niveaux convolutifs, augmentés en taille

Certaines des cartes fonctionnelles ont 10 niveaux convolutifs, augmentés en tailleMaintenant que nous avons vu que CCN essaye de s'isoler d'une image de trou noir, essayons de passer cette image à d'autres algorithmes de réseau neuronal populaires, tels que Neural Style Transfer et DeepDream.

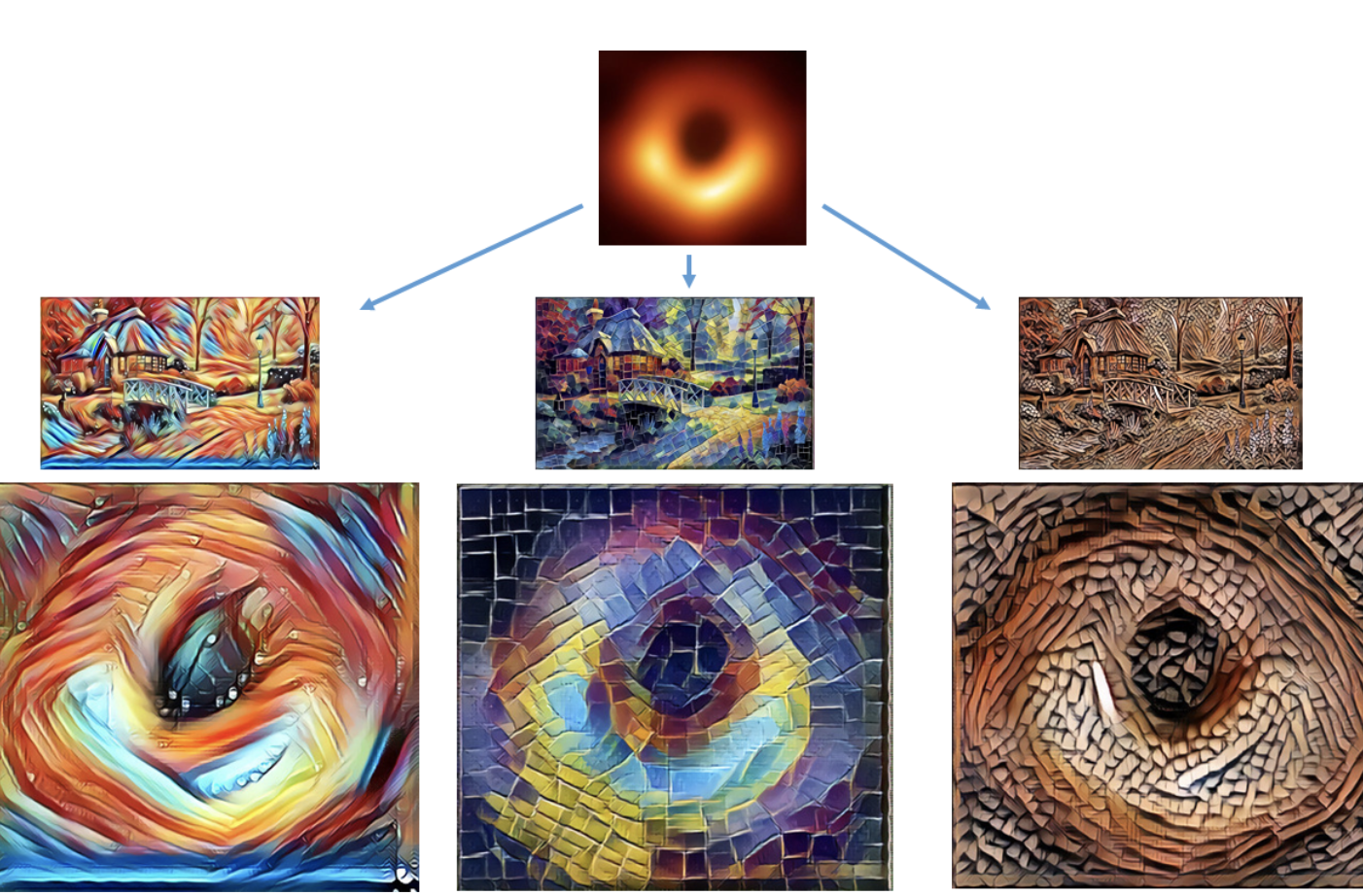

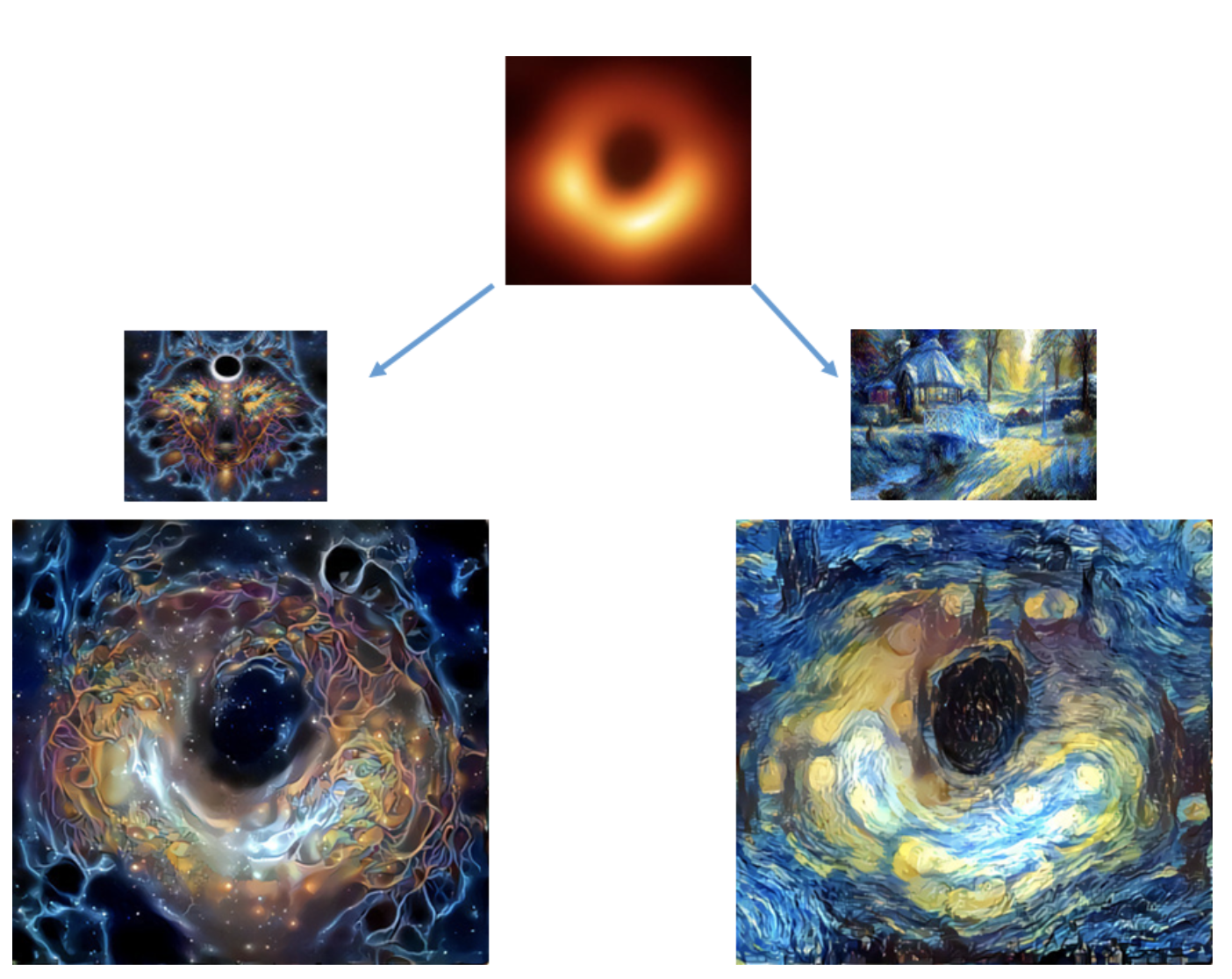

3. Nous essayons Neural Style Transfer et Deep Dream sur l'image d'un trou noirLe transfert de style neuronal est un réseau neuronal intelligent qui donne le «style» d'une image à une autre image source et crée finalement une image artistique. Si vous ne comprenez toujours pas, les images ci-dessous expliqueront le concept. J'ai utilisé le site

deepdreamgenerator.com pour créer diverses images artistiques à partir de l'image originale du trou noir. Les photos se sont avérées assez intéressantes.

Style de transmission. Images générées à l'aide de deepdreamgenerator.comDeepDream

Style de transmission. Images générées à l'aide de deepdreamgenerator.comDeepDream est un programme de vision par ordinateur créé par l'ingénieur Google Alexander Mordvintsev qui utilise un réseau neuronal convolutif pour rechercher et améliorer les modèles dans les images à l'aide d'une para-idole algorithmique, créant ainsi une image hallucinogène à partir d'images traitées intentionnellement.

Rêve profond Images générées à l'aide de deepdreamgenerator.com

Rêve profond Images générées à l'aide de deepdreamgenerator.comDans

ces vidéos sur Deep Dream, vous verrez comment des images hallucinantes peuvent être créées.

C'est tout! J'ai été extrêmement choqué quand j'ai vu la première photo d'un trou noir et j'ai immédiatement écrit ce petit article. Les informations qu'il contient peuvent ne pas être si utiles, mais les images créées lors de son écriture et illustrées ci-dessus en valent la peine. Profitez des photos!

Écrivez dans les commentaires comment vous obtenez le matériel. Nous attendons tout

le monde à

la porte ouverte du cours

"Réseaux de neurones en Python" .