Parfois, il devient nécessaire d'organiser un stockage à tolérance de pannes de petits volumes de stockage jusqu'à 20 To, mais avec des fonctionnalités d'entreprise - All-Flash, cache SSD, MPIO, HA (Activ-Activ) et tout cela à un prix abordable. Les solutions matérielles prêtes à l'emploi avec ces fonctions partent de centaines de téraoctets et de prix de 8 signes ou plus en roubles. Avoir un petit budget de 6-7 caractères dans la rivière. et la nécessité d'un stockage petit et rapide (mais fiable), depuis 2009, deux versions de systèmes de stockage ont été testées et mises en service commercial (La chose courante avec ces systèmes est qu'ils sont des systèmes très fiables sans point de défaillance unique + vous pouvez les toucher avant l'achat ou «s'en passer» (GRATUIT)).

Les personnes intéressées par cette expérience seront décrites ci-dessous:

- Expérience du logiciel StarWind Virtual SAN (VSAN) .

- Comment faire du stockage pour petites entreprises.

- Historique d'overclocking IOPS (pratique).

- Aide-mémoire pour le déploiement et l'exploitation des systèmes de stockage EMC ScaleIO (VxFlexOS) (en l'absence de support technique par les spécialistes de «NOT Linux-gourou») 1 partie.

1. Expérience d'exploitation du logiciel StarWind Virtual SAN (VSAN)

StarWind Virtual SAN (VSAN) - dans la solution Activ-Activ (réplication synchrone sur 3 serveurs), en fonctionnement de 2009 à 2016 dans différentes éditions (Starwind ISCSI SAN HA-3) basée sur des serveurs avec des matrices RAID matérielles.

Avantages :

- Facile et rapide, même pas installé par un professionnel;

- MPIO sur Ethernet iSCSI;

- HA (Activ-Activ);

- Sur les nouveaux serveurs (sous garantie) (avec de nouveaux disques), vous pouvez oublier de conserver le stockage pendant plusieurs années (les utilisateurs ne remarqueront même pas la panne de deux serveurs sur trois);

- Volumes de cache RAM et SSD;

- Rapide Synchronisation rapide pour les pannes de réseau mineures.

Inconvénients :

- Auparavant, il n'y avait qu'une version pour la plate-forme Windows;

- Avec un fonctionnement à long terme (plus de 3 ans) - il est difficile de trouver un disque pour remplacer un disque défectueux (hors production) pour réparer une matrice RAID (avec des disques hétérogènes, des pannes de matrice peuvent se produire);

- Une augmentation du nombre d'interfaces réseau et des emplacements PCI qu'elles occupent (en plus pour la synchronisation, les cartes réseau, les commutateurs);

- Lors de l'utilisation de LSFS - «journing file system», arrêt prolongé du système, qui peut être préjudiciable lorsque l'onduleur est déclenché lorsque l'alimentation est coupée;

- Une très longue période de synchronisation complète avec un grand volume.

Peut-être des problèmes déjà résolus (survenus précédemment pendant le fonctionnement dans notre centre de données):

- Lorsque la matrice RAID s'effondre, le serveur reste visible via le canal de synchronisation et de données, mais le disque du serveur Windows est hors réseau, le journal Starwind est gonflé et la mémoire du serveur est consommée, à la suite du gel du serveur. Traitement possible: affectation d'un fichier de contrôle et suppression des messages non critiques des paramètres du journal.

- Si le commutateur ou les interfaces réseau échouent, un choix ambigu du serveur hôte (parfois c'est arrivé, le système ne peut pas comprendre avec qui se synchroniser).

Actualités utiles (non encore testées):

StarWind Virtual SAN pour vSphere (solution hyperconvergée), vous permet d'intégrer la virtualisation Vmware dans un cluster sans liaison avec les serveurs Windows (basés sur des machines virtuelles Linux).

Résumé : Une solution tolérante aux pannes s'il existe un programme de remplacement de serveur matériel normal à la fin de la garantie et un support technique StarWindSoftWare est disponible.

2. Comment faire du stockage pour petites entreprises

Énoncé du problème:Créez un réseau de stockage de données à faible volume de sécurité avec un total de 4 To-20 To, avec un fonctionnement garanti à moyen terme sans coûts financiers supplémentaires importants.

- Le système doit être tolérant aux pannes (transférer calmement la défaillance d'au moins un commutateur, un serveur, des disques et des cartes réseau dans le serveur).

- Utiliser au maximum toutes les ressources du parc matériel disponible de serveurs (serveurs et commutateurs de 3 à 10 ans).

- Assurer le fonctionnement des volumes de différents niveaux: All-Flash et cache HDD + SSD.

Données sources:- budget limité;

- équipement de production il y a 3 à 10 ans;

- Spécialistes - Pas Linux-Guru.

Calcul des caractéristiquesPour éviter les goulots d'étranglement des performances lors de l'utilisation de disques SSD, qui seront coupés par rapport à quelque chose de la chaîne matérielle: cartes réseau, contrôleur RAID (HBA), module d'extension (panier), disques.

Il est nécessaire au moment de la création de fournir, en fonction de leurs caractéristiques requises, une certaine configuration d'équipement.

Vous pouvez bien sûr exécuter une configuration avec SSD de cache SAS HDD sur les réseaux 1 Gbit / s et les contrôleurs 3G, mais le résultat sera 3-7 fois pire que sur les réseaux RAID 6 Gbit et 10 Gbit / s (vérifié par des tests).

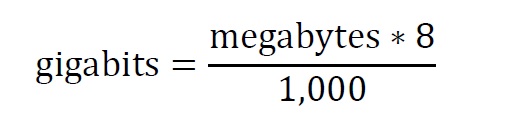

Les instructions de réglage VxFlexOS décrivent des instructions simples pour calculer la bande passante nécessaire, basées sur les classements SSD -450 Mo / C et HDD -100 Mo / C, pour l'enregistrement séquentiel (par exemple, lorsque le serveur est rééquilibré et reconstruit).

Par exemple:

- (Cache SSD + 3 HDD), nous obtenons ((450 * 1) + (3 * 100)) * 8/1000 = 6 Go

- (TOUS SSD FLASH) + (Cache SSD + 3 HDD) ((450 * 2) + (3 * 100)) * 8/1000 = 9,6 Go

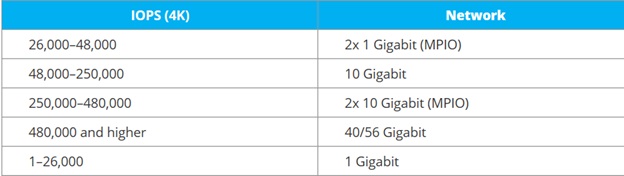

Pour déterminer la bande passante réseau par IOPS (charge standard sur les serveurs de base de données et les serveurs virtuels chargés), il existe un

tableau indicatif de StariWindSoftware Configuration finale

Configuration finale :

- Logiciel de stockage, qui peut ne pas combiner des disques en matrices RAID, mais les transférer vers le stockage sous forme de disques séparés (afin qu'il n'y ait aucun problème à remplacer les disques après un certain laps de temps où ils échouent, mais simplement les sélectionner par capacité);

- Serveurs de génération de processeurs e55xx-x56xx et supérieurs, bus pci-express v 2.0 et supérieurs, contrôleurs Raid (HBA) 6G-12G avec mémoire, paniers d'extension pour 6-16 disques;

- Commutateurs SMB 10G couche 2 (JUMBO FRAME, LACP).

Méthode de solutionAucune option budgétaire pour un «stockage matériel de petite entreprise» n'a été trouvée pour le petit volume avec les exigences ci-dessus.

Nous nous sommes arrêtés sur des solutions logicielles qui vous permettent de profiter du stockage d'entreprise, avec la possibilité d'utiliser des serveurs existants, qui dans ce cas ont le droit de mourir de vieillesse sans compromettre le stockage.

- Ceph - pas assez de spécialistes Linux;

- EMC ScaleIO - pour quelques années de support technique - vous pouvez vous en tirer avec le personnel existant.

- (il s'est avéré que les connaissances sous Linux peuvent être minimes, plus sur cela plus tard dans la feuille de triche).

3. Historique de l'overclocking IOPS (pratique budgétaire)

Pour accélérer les opérations de lecture et d'écriture dans les systèmes de stockage, les périphériques SSD suivants ont été utilisés:

3.1. Contrôleurs avec fonctionnalités de mise en cache SSD.

En 2010, des contrôleurs RAID avec des fonctions de mise en cache SSD Adaptec 5445 avec un disque

MaxIQ sont apparus (pour un résultat tangible, vous devez avoir au moins 10% du disque MaxIQ du volume du volume mis en cache), le résultat est mais insignifiant * testé sur soi-même;

Plus tard, il y avait des contrôleurs qui peuvent utiliser un disque SSD arbitraire pour la mise en cache, à la fois la série Adaptec Q et

LSI CacheCade (mais les licences y sont distinctes);

3.2. Mise en cache logicielle à l'aide de disques, tels que

Intel DC S3700 , qui est vu par le contrôleur et l'expandeur des serveurs de marque HP, IBM, FUJI (la plupart des serveurs les reconnaissent avec succès, coûteux pour All-Flash, mais pour 10% sur le cache SSD, il est tolérable de ne pas les publier sous partenaires d'IBM, HP, FUJI et juste Intel). * Mais maintenant, il existe des options compatibles moins chères (voir paragraphe 3.5.);

3.3. La mise en cache logicielle à l'aide de l'adaptateur PCIe-M.2,

Synology M.2 M2D18 SSD , est vérifiée, elle fonctionne sur des serveurs ordinaires (pas seulement dans Synology), elle est utile lorsque le contrôleur RAID et le panier refusent de voir les SSD que le fabricant n'a pas indiqués dans les compatibles (n HP D2700)? *;

3.4. Disques hybrides

Seagate EXOS 600 Go Seagate Exos 10E2400 (ST600MM0099) {SAS 12 Gb / s, 10000 tr / min, 256 Mo, 2,5 "}, * vérifié reconnu par les serveurs HP, IBM, FUJI (alternative aux versions 3.1.-3.3.);

3.5. Disques SSD avec une grande ressource et un prix comparable avec SAS de classe entreprise,

Crucial Micron 5200 MAX MTFDDAK480TDN-1AT1ZABYY, * vérifié reconnu par les serveurs HP, IBM, FUJI

(une alternative au remplacement des disques durs par ceux compatibles avec la clause 3.4 et compatibles avec les anciens serveurs SAS: disque dur SAS2.5 "600 Go AL14SEB060N TOSHIBA *,

C10K1800 0B31229 HGST, ST600MM0099 SEAGATE). Permet à un budget de passer des volumes HDD + SSD aux volumes 100% Flash.;

4. Aide-mémoire pour le déploiement et le fonctionnement du stockage EMC ScaleIO (VxFlexOS) 1 partie

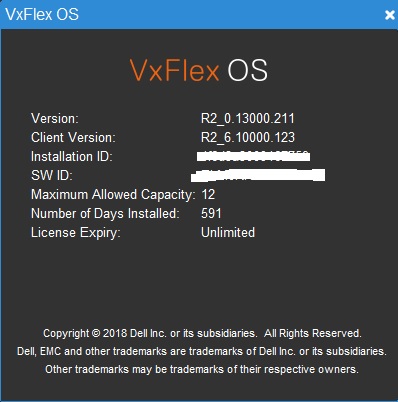

Stockage EMC ScaleIO (VxFlexOS)Après avoir testé la solution avant l'achat, je suis arrivé à la conclusion que pour le fonctionnement normal du système, plus de 3 nœuds sont nécessaires (le basculement est instable à 3), par exemple, prenez une configuration de 8 serveurs (il survivra à l'échec consécutif de 4 serveurs sans perdre de volumes).

Partie matériel :

FUJI CX2550M1 (E5-2xxx) - 3 pièces. (Client SDC et serveur SDS du cluster principal de virtualisation du serveur VmWare VSphere + ScaleIO);

Serveurs de génération +5 HP G6 (G7) ou IBM M3 (e55xx-x56xx) - serveurs ScaleIO SDS;

+ 2 commutateurs NetGear XS712T-100NES

En exécutant le stockage en mode RFCache, j'ai pu overclocker à 44KIops en utilisant Iometer

Configuration de stockage:

Capacité brute de 12 To (licence minimale au moment où elle était encore vendue en tant que logiciel)

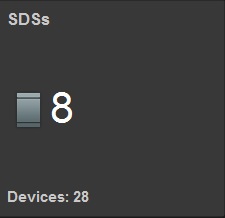

8 serveurs SDS 28 disques

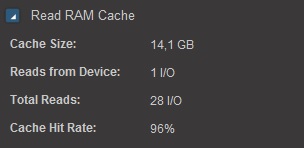

Lire le cache RAM 14 Go

Lire Flash cashe 1,27 To (RFCashe)

Dans la version intermédiaire, où seuls 3 serveurs 2x10Gb ont des cartes réseau, dans les 2 x1Gb restants.

On voit clairement que même avec une mise en cache SSD à 1 Go au lieu de 10 Go, il y a une perte de bande passante SDS trois fois ou plus, avec des supports identiques.

Sans mise en cache, si vous considérez selon ces

"standards" alors avec 28 disques durs,

on obtient 28X140 = 3920 IOPS, soit pour obtenir 44 000 IOPS, il vous faudrait 11 fois plus de disques. Il est économiquement plus rentable pour les petits volumes, non pour augmenter le nombre de disques mais pour le cache SSD.

A la question de savoir pourquoi de telles vitesses avec un petit volume, je répondrai tout de suite!

Il existe de telles petites organisations (comme la nôtre) dans lesquelles il existe un grand nombre de documents électroniques qui sont traités dans le logiciel pendant une longue période (chaque registre contrôle d'envoyer le logiciel jusqu'à 1 heure, même dans ce stockage overclocké). Toutes les autres options ont déjà été appliquées précédemment (augmentation sur RM-RAM, CPU i5, SSD, 1Gb-NET). Même l'utilisation de bundles SSD + SAS uniquement sur le stockage (sans ALL-Flash jusqu'à présent) a permis d'utiliser la plupart des ressources des serveurs de virtualisation, le transfert de machines virtuelles chargées vers ScaleIO - a doublé la charge sur les processeurs FUJI CX400M1 (stockage précédemment retenu).