Nous parlons de deux règles qui commencent également à perdre de leur pertinence.

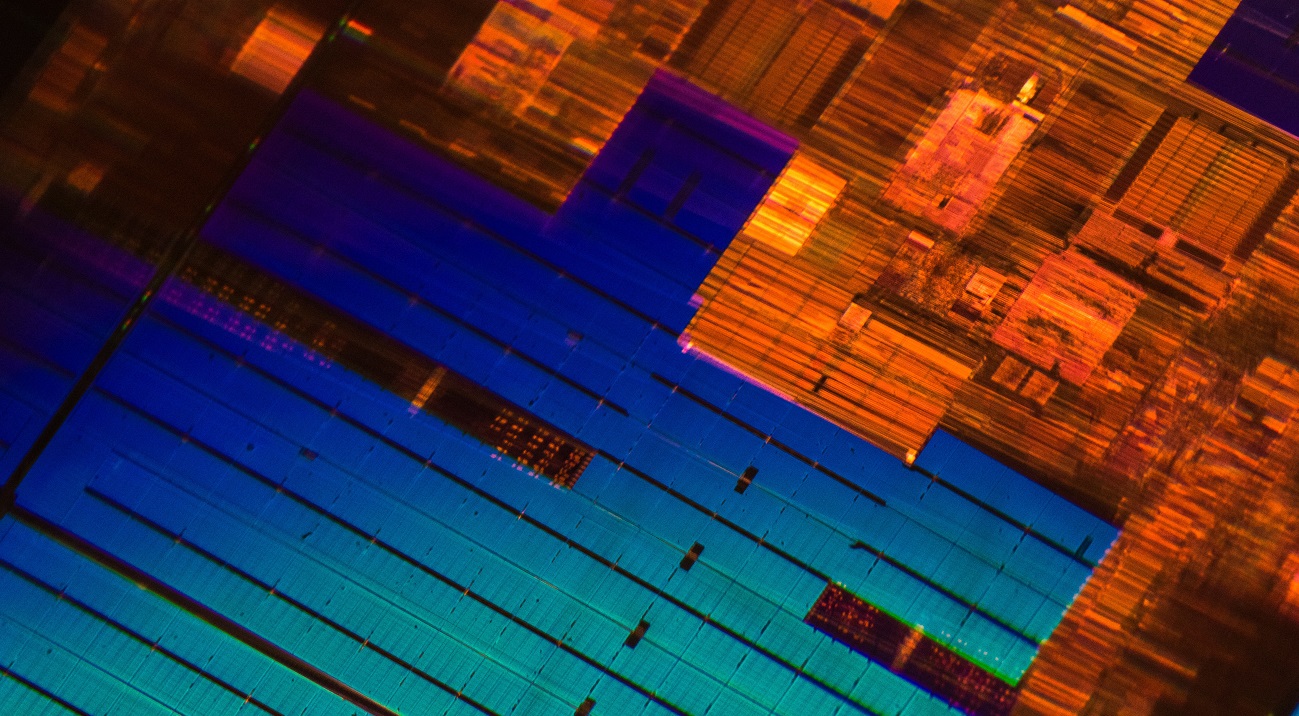

/ photo Laura Ockel Unsplash

/ photo Laura Ockel UnsplashLa loi de Moore a été formulée il y a plus de cinquante ans. Pendant tout ce temps, pour la plupart, il est resté juste. Même aujourd'hui, lors du passage d'un processus technologique à un autre, la densité des transistors sur une puce

augmente environ deux fois . Mais il y a un problème - la vitesse de développement de nouveaux processus technologiques ralentit.

Par exemple, Intel retarde depuis longtemps la production en série de ses processeurs Ice Lake de 10 nanomètres. Bien que le géant de l'informatique commencera à expédier des appareils le mois prochain, l'annonce de l'architecture a eu lieu il y a environ

deux ans et demi . Toujours en août de l'année dernière, GlobalFoundries, un fabricant de circuits intégrés qui a travaillé avec AMD, a

cessé de développer une technologie de processus à 7 nm (nous

avons expliqué les raisons de cette décision

dans notre blog sur Habr).

Les journalistes et les

dirigeants de grandes sociétés informatiques prophétisent la mort de la loi de Moore depuis des années. Même Gordon lui-même

a déclaré une fois que la règle qu'il avait formulée cesserait de s'appliquer. Cependant, la loi de Moore n'est pas la seule loi qui perd de sa pertinence et sur laquelle les fabricants de processeurs sont égaux.

Loi d'échelle de Dennard

Il a été formulé en 1974 par Robert Dennard, ingénieur et développeur de mémoire dynamique DRAM, avec des collègues d'IBM. La règle est la suivante:

"En réduisant la taille du transistor et en augmentant la vitesse d'horloge du processeur, nous pouvons facilement augmenter ses performances."

La règle de Dennard a fixé la réduction de la largeur du conducteur (technologie de processus) comme le principal indicateur de progrès dans l'industrie de la technologie des microprocesseurs. Mais la loi de mise à l'échelle de Dennard a cessé de s'appliquer vers 2006. Le nombre de transistors dans les puces continue d'augmenter, mais ce fait

n'entraîne pas une augmentation significative des performances du dispositif.

Par exemple, des représentants de TSMC (un fabricant de semi-conducteurs) affirment que le passage de la technologie de traitement de 7 nm à 5 nm

n'augmentera la vitesse d'horloge du processeur que de 15%.

La raison du ralentissement de la croissance des fréquences est la fuite de courants, dont Dennard n'a pas tenu compte à la fin des années 70. Avec une diminution de la taille du transistor et une augmentation de la fréquence, le courant commence à chauffer la puce plus fortement, ce qui peut l'endommager. Par conséquent, les fabricants doivent équilibrer la puissance allouée par le processeur. En conséquence, depuis 2006, la fréquence des puces de masse a été établie à environ 4-5 GHz.

/ photo par Jason Leung Unsplash

/ photo par Jason Leung UnsplashAujourd'hui, les ingénieurs travaillent sur de nouvelles technologies qui résoudront le problème et augmenteront les performances des micropuces. Par exemple, des experts australiens

développent un transistor métal-air, qui a une fréquence de plusieurs centaines de gigahertz. Le transistor se compose de deux électrodes métalliques qui agissent comme drain et source et sont situées à une distance de 35 nm. Ils échangent des électrons entre eux en raison du phénomène d'

émission de

champ .

Selon les développeurs, leur appareil vous permettra d'arrêter de «chasser» la réduction des processus technologiques et de vous concentrer sur la construction de structures 3D performantes avec un grand nombre de transistors sur une puce.

Règle de Kumi

Il a été

formulé en 2011 par le professeur de Stanford Jonathan Koomey. Avec des collègues de Microsoft, Intel et Carnegie Mellon University, il a

analysé des informations sur la consommation d'énergie des systèmes informatiques à partir de l'ordinateur ENIAC, construit en 1946. En conséquence, Kumi a tiré la conclusion suivante:

«Le volume de calculs par kilowatt d'énergie sous charge statique double tous les ans et demi.»

Dans le même temps, il a noté que la consommation d'énergie des ordinateurs au cours des dernières années avait également augmenté.

En 2015, Kumi a

repris son travail et a complété l'étude avec de nouvelles données. Il a constaté que la tendance qu'il décrivait s'était ralentie. La performance moyenne des puces par kilowatt d'énergie a commencé à doubler tous les trois ans environ. La tendance a changé en raison des difficultés liées au refroidissement des puces (

page 4 ), car avec la diminution de la taille des transistors, il devient plus difficile d'évacuer la chaleur.

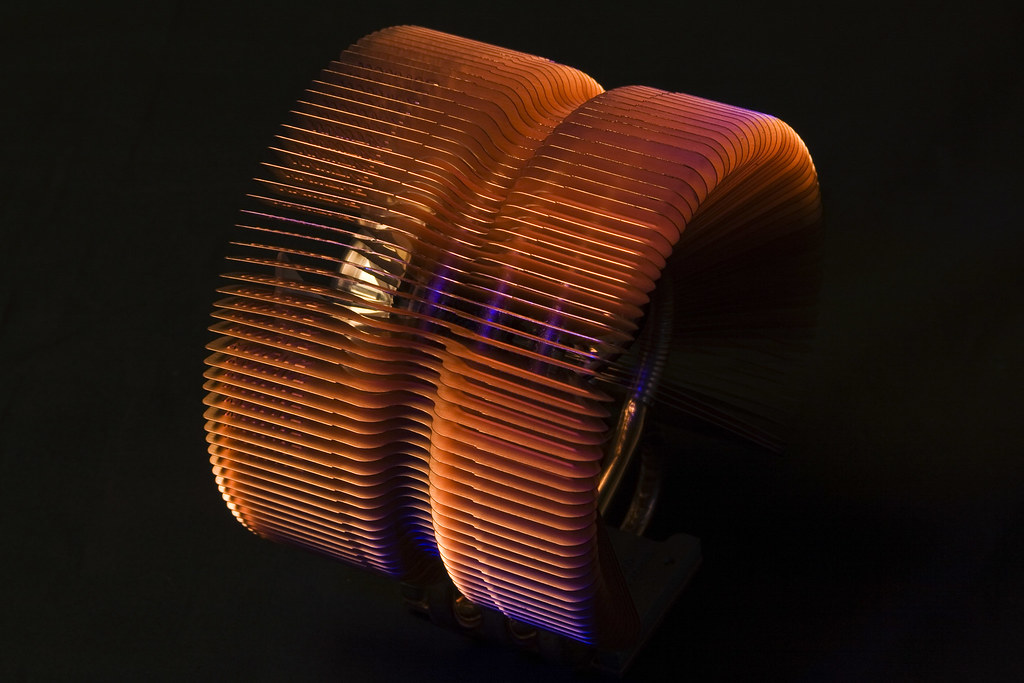

/ photo Derek Thomas CC BY-ND

/ photo Derek Thomas CC BY-NDDe nouvelles technologies de refroidissement des puces sont en cours de développement, mais il n'est pas nécessaire de parler de leur mise en œuvre de masse. Par exemple, les développeurs d'une université de New York ont suggéré d'

utiliser l'impression laser 3D pour appliquer une fine couche conductrice de chaleur de titane, d'étain et d'argent sur un cristal. La conductivité thermique d'un tel matériau est 7 fois meilleure que celle des autres interfaces thermiques (pâte thermique et polymères).

Malgré tous les facteurs,

selon Kumi , la limite d'énergie théorique est encore loin. Il se réfère à une étude du physicien Richard Feynman, qui, en 1985, a noté que l'indice d'efficacité énergétique des processeurs augmentera de 100 milliards de fois. Au moment de 2011, ce chiffre n'a augmenté que de 40 000 fois.

L’industrie informatique est habituée à une forte croissance de la puissance de calcul. Les ingénieurs recherchent donc des moyens d’étendre la loi de Moore et de surmonter les difficultés dictées par les règles de Kumi et Dennard. En particulier, les entreprises et les instituts de recherche cherchent à remplacer la technologie traditionnelle des transistors et le silicium. Nous parlerons de certaines des alternatives possibles la prochaine fois.

Ce que nous écrivons sur un blog d'entreprise:

Nos rapports avec VMware EMPOWER 2019 sur Habré: