Récemment, je l'ai décrit, grâce auquel les robots demain commenceront BEAUCOUP mieux à penser (un article sur

l'accélération matérielle des réseaux de neurones ). Aujourd'hui, nous verrons pourquoi les robots seront bientôt beaucoup mieux à voir. Dans certaines situations, bien mieux qu'une personne.

Nous parlerons des caméras de profondeur qui tournent des vidéos, dans chaque pixel duquel est stockée non pas la couleur, mais la distance à l'objet à ce stade. Ces caméras existent depuis plus de 20 ans, mais ces dernières années, la vitesse de leur développement a augmenté de nombreuses fois et nous pouvons déjà parler de la révolution. Et multi-vecteur. Un développement rapide se déroule dans les domaines suivants:

- Lumière structurée d'une caméra , ou d'une caméra à lumière structurelle, lorsqu'il y a un projecteur (souvent infrarouge) et une caméra qui enregistre la lumière structurelle du projecteur;

- Caméras Time of Flight ou caméras basées sur la mesure du retard de la lumière réfléchie;

- Profondeur des caméras stéréo - la direction classique et, peut-être, la plus célèbre de la profondeur de construction de la stéréo;

- Caméra de champ lumineux - ce sont également des caméras de champ lumineux ou des caméras plénoptiques, sur lesquelles il y avait un poste détaillé séparé;

- Et enfin, les caméras basées sur la technologie Lidar , en particulier les Lidars Solid State frais , qui fonctionnent sans défaillance environ 100 fois plus longtemps que les lidars ordinaires et produisent l'image rectangulaire habituelle.

Peu importe à quoi il ressemblera, ainsi qu'une comparaison des différentes approches et de leur application actuelle et de demain - bienvenue sous la coupe!

Alors! Nous analyserons les principales directions de développement des chambres de profondeur ou en réalité différents principes de mesure de la profondeur. Avec leurs avantages et leurs inconvénients.

Méthode 1: Caméra à lumière structurée

Commençons par l'une des méthodes les plus simples, les plus anciennes et relativement bon marché pour mesurer la lumière structurée en profondeur. Cette méthode est apparue essentiellement tout de suite, dès l'apparition des appareils photo numériques, c'est-à-dire il y a plus de 40 ans et considérablement simplifié un peu plus tard, avec l'avènement des projecteurs numériques.

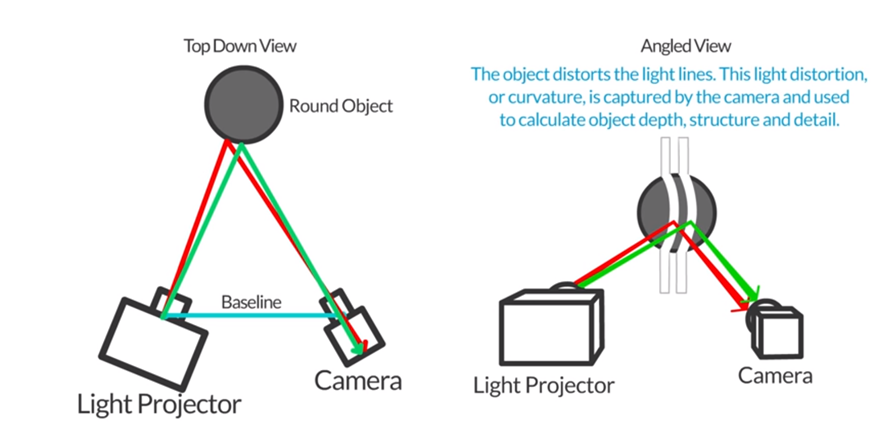

L'idée de base est extrêmement simple. Nous plaçons à côté du projecteur, ce qui crée, par exemple, des rayures horizontales (puis verticales) et à côté de la caméra, qui prend une photo avec des rayures, comme le montre cette figure:

Source: Autodesk: Numérisation 3D à lumière structurée

Source: Autodesk: Numérisation 3D à lumière structuréeÉtant donné que l'appareil photo et le projecteur sont décalés l'un par rapport à l'autre, les bandes seront également déplacées proportionnellement à la distance au sujet. En mesurant ce déplacement, nous pouvons calculer la distance à l'objet:

Source: http://www.vision-systems.com/

Source: http://www.vision-systems.com/En fait, avec le projecteur le moins cher (et leur prix commence à 3000 roubles) et un smartphone, vous pouvez mesurer la profondeur des scènes statiques dans une pièce sombre:

Source: Autodesk: Numérisation 3D à lumière structurée

Source: Autodesk: Numérisation 3D à lumière structuréeIl est clair que ce faisant, un tas de tâches devront être résolues - il s'agit de l'étalonnage du projecteur, de l'étalonnage de la caméra du téléphone, de la reconnaissance de décalage de bande, etc., mais toutes ces tâches sont tout à fait capables même pour les élèves du secondaire avancés qui apprennent la programmation.

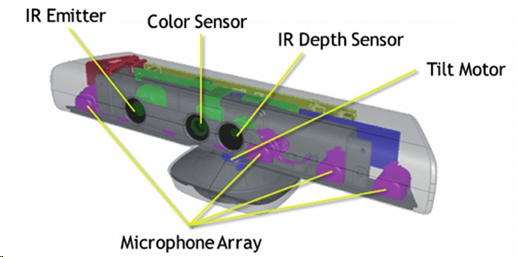

Ce principe de mesure de la profondeur est devenu le plus connu quand, en 2010, Microsoft a sorti le

capteur de profondeur

MS Kinect pour 150 $, ce qui à l'époque était révolutionnaire et bon marché.

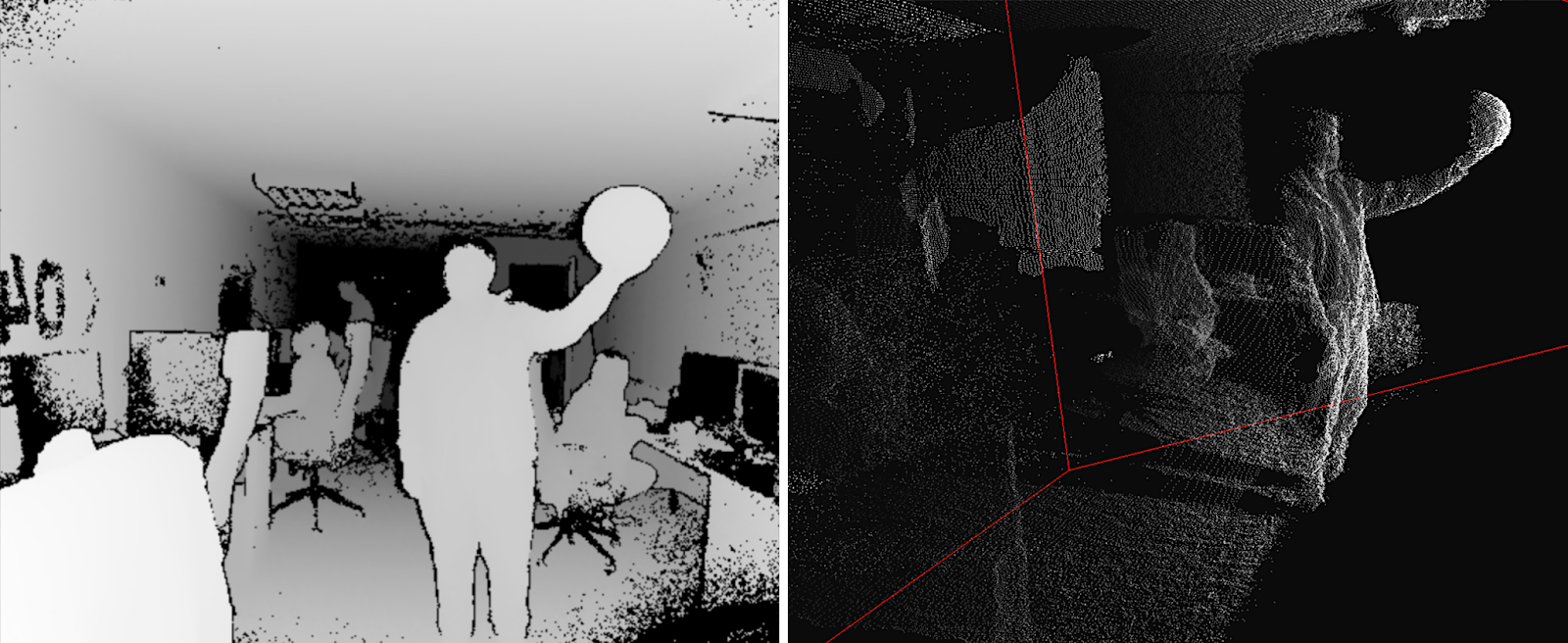

Source: Reconstruction d'objet partiellement occlus à l'aide de plusieurs capteurs Kinect

Source: Reconstruction d'objet partiellement occlus à l'aide de plusieurs capteurs KinectMalgré le fait qu'en plus de mesurer réellement la profondeur avec un projecteur IR et une caméra IR, Kinect a également filmé des vidéos RVB régulières, avait quatre microphones avec réduction du bruit et pouvait s'adapter à une personne en hauteur, s'inclinant automatiquement vers le haut ou vers le bas, il a été immédiatement intégré à l'intérieur traitement des données, qui a délivré à la console immédiatement une carte de profondeur prête:

Source: Implémentation de boutons d'interface utilisateur naturels à l'aide de Kinect

Source: Implémentation de boutons d'interface utilisateur naturels à l'aide de KinectAu total, environ 35 millions d'appareils ont été vendus, faisant de Kinect la première caméra à profondeur de masse de l'histoire. Et si vous considérez qu'il y avait certainement des caméras de profondeur, mais généralement elles se vendaient au maximum par centaines et coûtaient au moins un ordre de grandeur plus cher - c'était une révolution qui a fourni de grands investissements dans ce domaine.

Une raison importante du succès était qu'au moment où Microsoft a sorti la Xbox 360, il y avait déjà quelques jeux qui utilisaient activement Kinect comme capteur. Le décollage a été rapide:

De plus, Kinect a même réussi à entrer dans le livre Guinness des records en tant que gadget le plus vendu de l'histoire. Certes, Apple a rapidement évincé Microsoft de cet endroit, mais néanmoins. Pour un nouveau capteur expérimental qui fonctionne en plus de l'appareil principal pour devenir l'appareil électronique le plus vendu de l'histoire, c'est tout simplement une grande réussite:

En conférence, j'aime demander au public d'où viennent tous ces millions de clients. Qui étaient tous ces gens?

En règle générale, personne ne devine, mais parfois, surtout si le public est plus âgé et plus expérimenté, ils donnent la bonne réponse: les ventes ont été menées par des parents américains, qui ont vu avec plaisir que leurs enfants pouvaient jouer sur la console et ne pas s'asseoir sur le canapé avec un butin épais, et sauter devant le téléviseur. Ce fut une percée !!! Des millions de mères et de pères se sont précipités pour commander un appareil pour leurs enfants.

En général, en ce qui concerne la reconnaissance des gestes, les gens croient généralement naïvement que seules les données d'une caméra 2D sont suffisantes. Après tout, ils ont vu beaucoup de belles démos! La réalité est beaucoup plus grave. La précision de reconnaissance des gestes à partir d'un flux vidéo 2D d'une caméra et la précision de reconnaissance des gestes à partir d'une profondeur de caméra diffèrent d'un ordre de grandeur. À partir d'une caméra de profondeur, ou plutôt d'une caméra RVB combinée à une caméra de profondeur (cette dernière est importante), vous pouvez reconnaître les gestes beaucoup plus précisément et à moindre coût (même si la pièce est sombre), ce qui a fait le succès de la première caméra de profondeur de masse.

À propos de Kinect sur Habré à l'époque, ils ont

beaucoup écrit, donc très brièvement comment cela fonctionne.

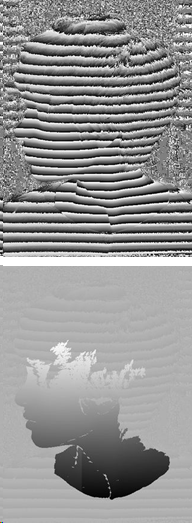

Un projecteur infrarouge donne un ensemble pseudo-aléatoire de points dans l'espace, dont le déplacement détermine la profondeur dans un pixel donné:

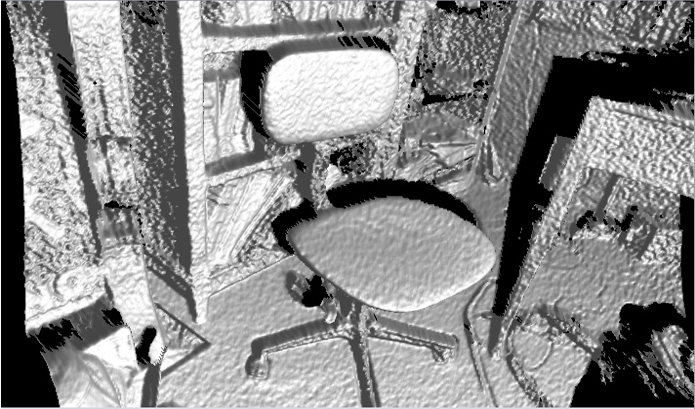

Source: Structures planaires à détection de profondeur: détection des configurations de mobilier de bureau

Source: Structures planaires à détection de profondeur: détection des configurations de mobilier de bureauLa résolution de la caméra est déclarée comme 640x480, mais il y a vraiment quelque part autour de 320x240 avec un filtrage assez fort et l'image sur des exemples réels ressemble à ceci (c'est-à-dire assez effrayant):

Source: Reconstruction d'objet partiellement occlus à l'aide de plusieurs capteurs Kinect

Source: Reconstruction d'objet partiellement occlus à l'aide de plusieurs capteurs KinectLes «ombres» des objets sont clairement visibles, car la caméra et le projecteur sont suffisamment éloignés. On peut voir que des décalages de plusieurs points du projecteur sont pris pour prédire la profondeur. De plus, il y a un filtrage (dur) par les voisins immédiats, mais la carte de profondeur est encore assez bruyante, surtout aux frontières. Il en résulte un bruit assez perceptible à la surface des objets résultants, qui doit en outre être lissé de manière non triviale:

Source: Bibliothèque Java J4K pour le SDK Kinect de Microsoft

Source: Bibliothèque Java J4K pour le SDK Kinect de MicrosoftNéanmoins, seulement 150 $ (

aujourd'hui c'est déjà 69 $ , bien que

ce soit mieux près de 200 $ , bien sûr) - et vous "voyez" la profondeur! Il y a

vraiment beaucoup de produits en série.

Soit dit en passant, en février de cette année, un nouveau

Azure Kinect a été annoncé:

Source: Microsoft annonce Azure Kinect, disponible en pré-commande maintenant

Source: Microsoft annonce Azure Kinect, disponible en pré-commande maintenantSes livraisons aux développeurs aux USA et en Chine devraient débuter le 27 juin, soit littéralement en ce moment. Parmi les capacités, en plus de la résolution nettement meilleure du RVB et de la meilleure qualité des caméras de profondeur (elles promettent

1024x1024 à 15 FPS et 512x512 à 30 FPS et une qualité supérieure est

clairement visible par la démo , la caméra ToF), la prise en charge de la collaboration de plusieurs appareils hors de la boîte est déclarée, moins d'exposition à le soleil, l'erreur est inférieure à 1 cm à une distance de 4 mètres et 1-2 mm à une distance de moins de 1 mètre, ce qui semble extrêmement intéressant, alors nous attendons, nous attendons:

Source: Présentation d'Azure Kinect DK

Source: Présentation d'Azure Kinect DKLe prochain produit de

masse , où une caméra de profondeur a été réalisée dans une lumière structurée, n'était pas une console de jeu, mais ... (roulement de tambour) correctement -

iPhone X !

Sa technologie Face ID est une caméra de profondeur typique avec un projecteur à points infrarouge typique et une caméra infrarouge (à propos, vous comprenez maintenant pourquoi ils sont sur les bords de la frange, espacés le plus possible l'un de l'autre - c'est une

base stéréo ):

La résolution de la carte de profondeur est encore inférieure à celle de Kinect - environ 150x200. Il est clair que si vous dites: "Notre résolution est d'environ 150x200 pixels ou 0,03 mégapixels", les gens diront brièvement et succinctement: "Suce!" Et si vous dites

«Projecteur de points: plus de 30 000 points invisibles sont projetés sur votre visage» , les gens disent: «Wow, 30 000 points invisibles, cool!». Certaines blondes demanderont si des taches de rousseur apparaissent à partir de points invisibles. Et le sujet ira aux masses! Par conséquent, la deuxième option était clairvoyante dans la publicité. La résolution est faible pour trois raisons: premièrement, les exigences de la miniature, deuxièmement, la consommation d'énergie et, troisièmement, les prix.

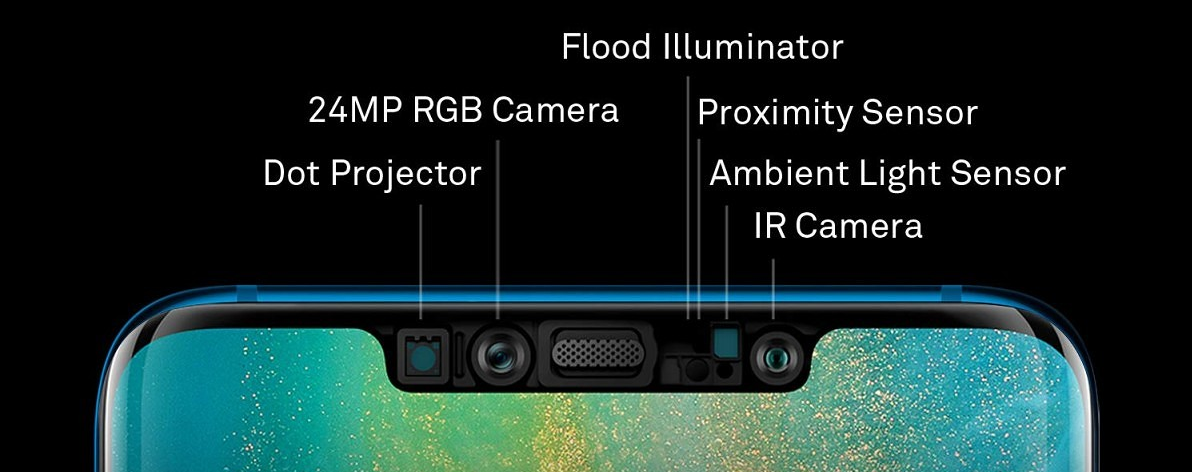

Néanmoins, il s'agit d'un autre appareil photo de profondeur sous une lumière structurée, qui est entré dans une série de millions d'exemplaires et a déjà été répété par d'autres fabricants de smartphones,

par exemple (surprise-surprise!) Huawei (qui a contourné Apple dans les ventes de smartphones l'année dernière). Seul Huawei a un appareil photo à droite, et le projecteur à gauche, mais aussi, bien sûr, le long des bords de la "frange":

Source: la mise à jour Huawei Mate 20 Pro permet aux utilisateurs d'ajouter un deuxième visage pour déverrouiller le visage

Source: la mise à jour Huawei Mate 20 Pro permet aux utilisateurs d'ajouter un deuxième visage pour déverrouiller le visageDans le même temps, 300 000 points sont déclarés, soit

10 fois plus qu'Apple , et la caméra frontale est meilleure,

et la police est plus grande . Y a-t-il une exagération concernant 300 000 - c'est difficile à dire, mais Huawei démontre une très bonne

numérisation 3D d'objets avec une caméra frontale . Les tests indépendants sont

plus effrayants , mais c'est clairement le tout début du sujet et les balbutiements de la technologie des caméras miniatures à faible consommation d'énergie et des annonces de caméras à la fin de cette année sont déjà nettement meilleurs en termes de performances.

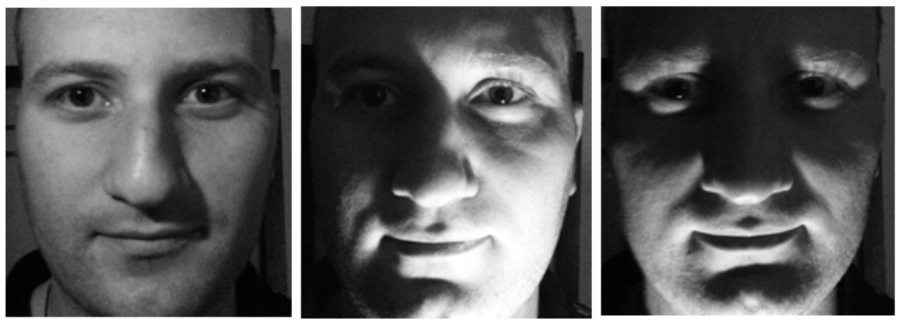

Dans le même temps, on comprend pourquoi la technologie d'identification faciale a été utilisée dans les téléphones. Tout d'abord, vous ne pouvez plus tromper le détecteur en montrant une photo de votre visage (ou une vidéo de la tablette). Deuxièmement, le visage change beaucoup lorsque l'éclairage change, mais sa forme ne change pas, ce qui nous permet d'identifier plus précisément la personne avec les données de la caméra RVB:

Source: photo TI de la même personne

Source: photo TI de la même personneDe toute évidence, le capteur infrarouge a des problèmes inhérents. Premièrement, notre projecteur relativement faible brille une ou deux fois sur le soleil, de sorte que ces caméras ne fonctionnent pas dans la rue. Même à l'ombre, si le mur blanc d'un bâtiment est éclairé par le soleil, vous pouvez avoir de gros problèmes avec Face ID. Le niveau de bruit dans Kinect roule également même lorsque le soleil est couvert de nuages:

Source: ceci et les deux images suivantes

Source: ceci et les deux images suivantes -

matériaux Basler AGUn autre gros problème est la réflexion et la réflexion. Étant donné que la lumière infrarouge est également réfléchie, photographier une bouilloire en acier inoxydable coûteuse, une table vernie ou un abat-jour en verre avec Kinect sera problématique:

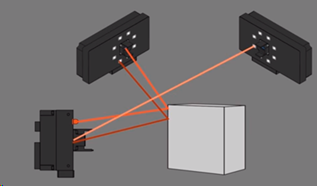

Et enfin, deux caméras photographiant un objet peuvent interférer. Fait intéressant, dans le cas de la lumière structurée, vous pouvez faire scintiller le projecteur et comprendre où sont nos points et où ils ne le sont pas, mais c'est une histoire distincte et plutôt compliquée:

Vous savez maintenant comment casser FaceID ...

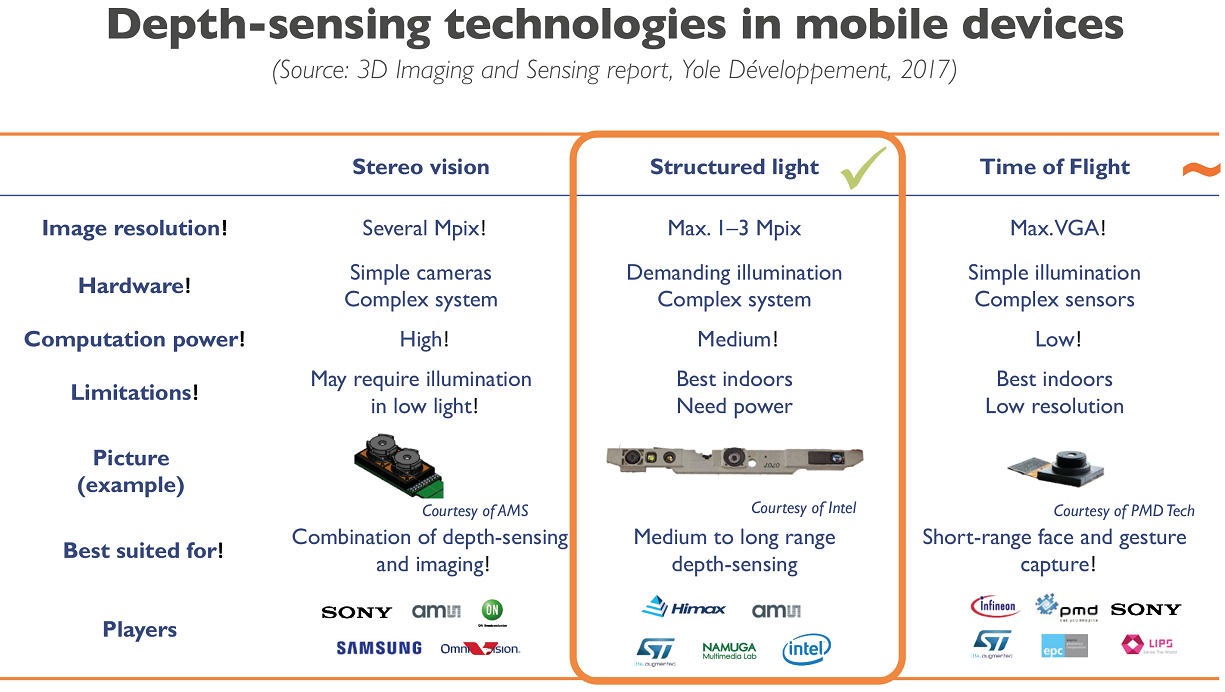

Cependant, pour les appareils mobiles, la lumière structurée semble être le compromis le plus raisonnable aujourd'hui:

Source: Les entreprises de smartphones se démènent pour correspondre aux performances et aux coûts des caméras 3D Apple

Source: Les entreprises de smartphones se démènent pour correspondre aux performances et aux coûts des caméras 3D ApplePour la lumière structurée, le bon marché d'un capteur conventionnel est tel que son utilisation dans la plupart des cas est plus que justifiée. Ce qui a donné vie à un grand nombre de startups fonctionnant selon la formule: capteur bon marché + logiciel complexe = résultat tout à fait acceptable.

Par exemple, notre ancien étudiant diplômé

Maxim Fedyukov , qui est impliqué dans la reconstruction 3D depuis 2004, a créé

Texel , dont le produit principal est une plate-forme avec 4 caméras Kinect et un logiciel qui transforme une personne en monument potentiel en 30 secondes. Eh bien, ou une figurine de bureau. C'est qui a assez d'argent. Ou vous pouvez envoyer à vos amis des photos d'amis bon marché et joyeuses de votre modèle 3D (pour une raison quelconque, le cas le plus populaire pour une raison quelconque). Maintenant, ils envoient leurs plates-formes et logiciels à l'étranger du Royaume-Uni en Australie:

Source: Création d'un modèle 3D d'une personne en 30 secondesEn tant que ballerine, je ne peux pas me tenir magnifiquement, donc je ne regarde que pensivement la nageoire d'un requin qui nage:

Source: documents de l'auteur

Source: documents de l'auteurEn général, un nouveau type de capteurs a engendré de nouveaux projets artistiques. En hiver, j'ai vu un film VR assez curieux tourné avec Kinect. Ci-dessous, une visualisation intéressante de la danse, également réalisée avec Kinect (il semble que 4 caméras aient été utilisées), et contrairement à l'exemple précédent, ils ne se sont pas battus avec le bruit, ils ont plutôt ajouté des détails amusants:

Source: Une performance de danse capturée avec un capteur Kinect et visualisée avec un logiciel 3D

Source: Une performance de danse capturée avec un capteur Kinect et visualisée avec un logiciel 3DQuelles tendances peuvent être observées dans la région:

- Comme vous le savez, les capteurs numériques des appareils photo modernes sont sensibles au rayonnement infrarouge, vous devez donc utiliser des filtres de blocage spéciaux afin que le bruit infrarouge ne gâche pas l'image (même la direction de la prise de vue artistique dans la plage infrarouge apparaît, y compris lorsque le filtre est retiré du capteur). Cela signifie que d'énormes sommes d'argent sont investies dans la miniaturisation, une résolution accrue et des capteurs moins chers, qui peuvent être utilisés comme infrarouges (avec un filtre spécial ).

- De même, les algorithmes de traitement des cartes de profondeur s'améliorent rapidement, y compris les méthodes de filtrage croisé, lorsque les données d'un capteur RVB et les données bruyantes par profondeur vous permettent d'obtenir une très bonne vidéo de profondeur ensemble. Dans le même temps, en utilisant des approches de réseau neuronal, il devient possible d'augmenter considérablement la vitesse d'obtention d'un bon résultat.

- Toutes les grandes entreprises travaillent dans ce domaine, en particulier les fabricants de smartphones.

En conséquence:

- Nous pouvons nous attendre à une augmentation spectaculaire de la résolution et de la précision du tournage des caméras de profondeur de lumière structurée au cours des 5 prochaines années.

- Il y aura une réduction (bien que plus lente) de la consommation d'énergie des capteurs mobiles, ce qui simplifiera l'utilisation des capteurs de nouvelle génération dans les smartphones, tablettes et autres appareils mobiles.

En tout cas, ce que nous voyons maintenant, c'est le début de la technologie. Les premiers produits de masse sur lesquels le débogage de production et d'utilisation d'un nouveau type de données inhabituel vient d'être lancé - la vidéo en profondeur.

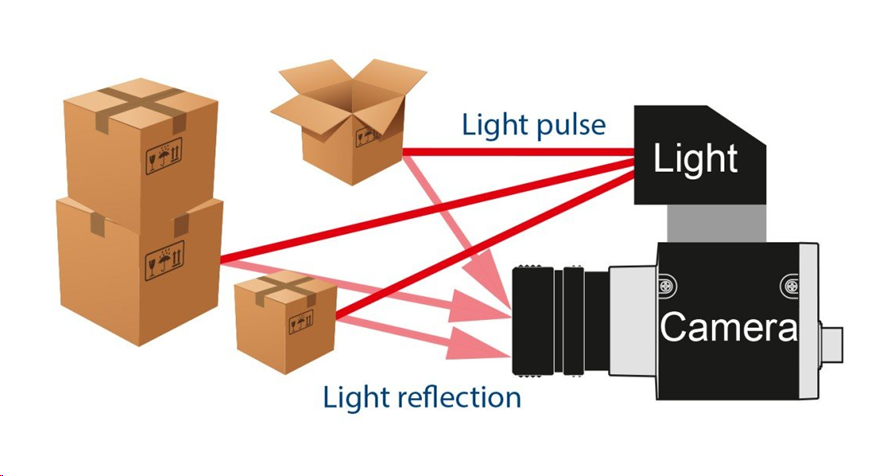

Méthode 2: caméra de temps de vol

La prochaine façon d'obtenir de la profondeur est plus intéressante. Il est basé sur la mesure du retard lumineux aller-retour (ToF -

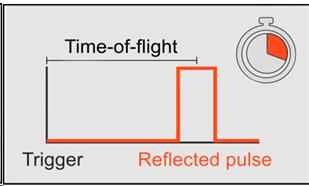

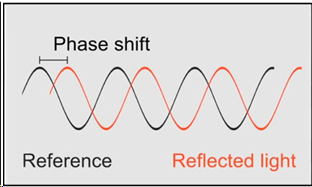

Time-of-Flight ). Comme vous le savez, la vitesse des processeurs modernes est élevée et la vitesse de la lumière est faible. Dans un cycle d'horloge du processeur à 3 GHz, la lumière parvient à voler à seulement 10 centimètres. Ou 10 mesures par mètre. Beaucoup de temps, si quelqu'un était engagé dans l'optimisation de bas niveau. En conséquence, nous installons une source de lumière pulsée et une caméra spéciale:

Source: La caméra Basler Time-of-Flight (ToF)

Source: La caméra Basler Time-of-Flight (ToF)En fait, nous devons mesurer le retard avec lequel la lumière revient à chaque point:

Source: La caméra Basler Time-of-Flight (ToF)

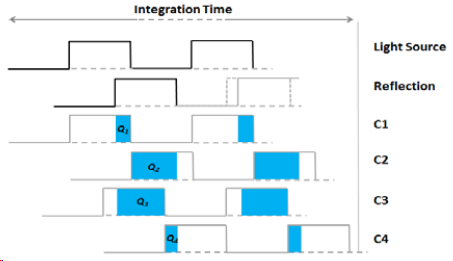

Source: La caméra Basler Time-of-Flight (ToF)Ou, si nous avons plusieurs capteurs avec des temps d'accumulation de charge différents, alors, connaissant le décalage temporel par rapport à la source pour chaque capteur et la luminosité du flash, nous pouvons calculer le décalage et, en conséquence, la distance à l'objet, et en augmentant le nombre de capteurs, nous augmentons la précision:

Source: Larry Li Camera Time-of-Flight - An Introduction

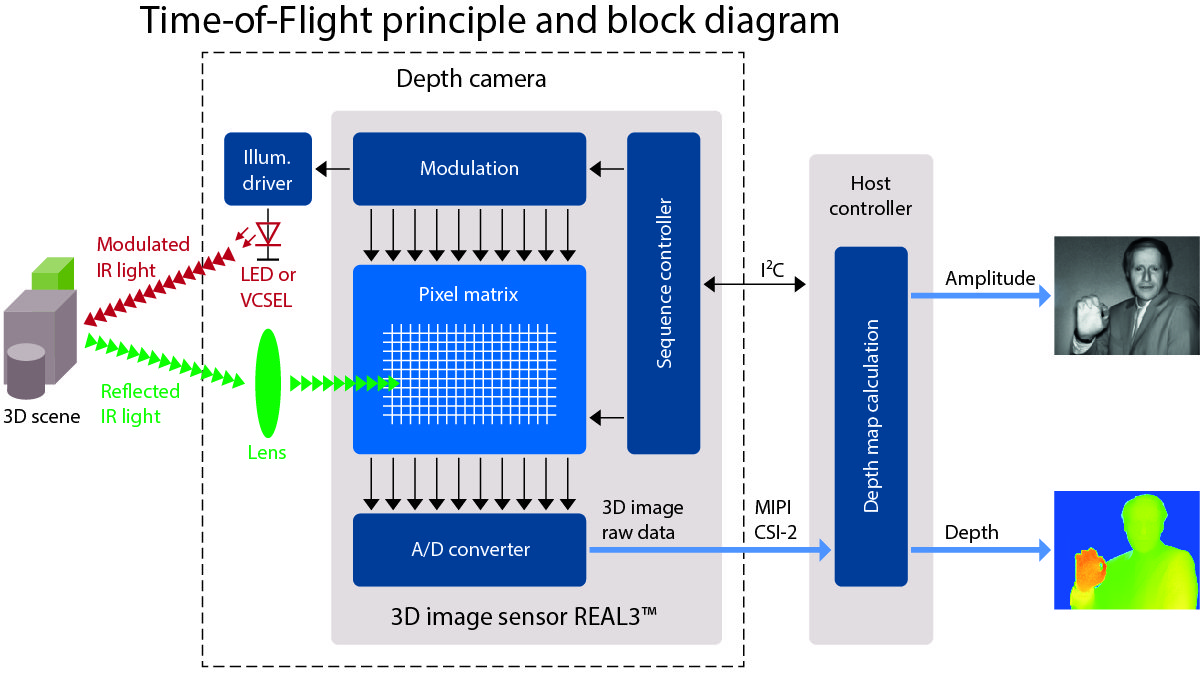

Source: Larry Li Camera Time-of-Flight - An IntroductionLe résultat est un tel schéma de la caméra avec éclairage infrarouge LED ou, plus communément, laser (

VCSEL ):

Source: Une très bonne description de poste de ToF sur allaboutcircuits.com

Source: Une très bonne description de poste de ToF sur allaboutcircuits.comDans le même temps, l'image est obtenue à une résolution assez faible (après tout, nous devons placer plusieurs capteurs à côté d'eux avec des temps d'interrogation différents), mais potentiellement avec des FPS élevés. Et les problèmes se situent principalement aux limites des objets (ce qui est typique pour toutes les caméras de profondeur). Mais sans les «ombres» typiques de la lumière structurée:

Source: vidéo Basler AG

Source: vidéo Basler AGEn particulier, c'est ce type de caméra (ToF) qui à une époque a activement testé Google dans le projet

Google Tango , qui était bien représenté dans

cette vidéo . Le sens était simple - combiner les données du gyroscope, de l'accéléromètre, de la caméra RVB et de la caméra de profondeur, créant une scène en trois dimensions devant le smartphone:

Source: le projet Tango de Google est désormais dimensionné pour les smartphones

Source: le projet Tango de Google est désormais dimensionné pour les smartphonesLe projet lui-même n'a pas abouti (mon avis était qu'il était quelque peu en avance sur son temps), mais il a créé des conditions préalables importantes pour créer une vague d'intérêt pour la réalité augmentée - et, par conséquent, développer des capteurs qui peuvent fonctionner avec. Maintenant, toutes ses réalisations sont versées dans

ARCore de Google.

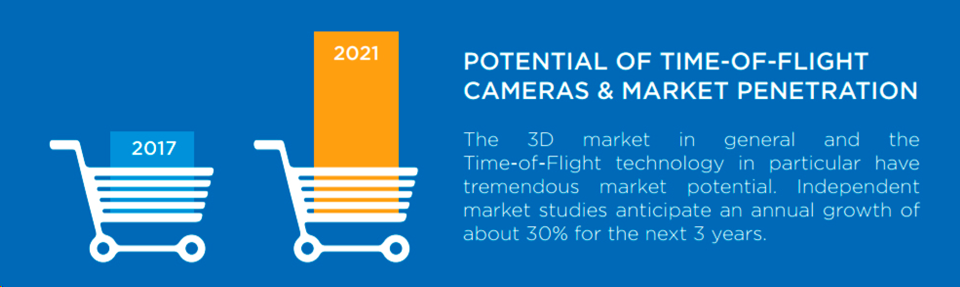

En général, le volume du marché des caméras ToF augmente d'environ 30% tous les 3 ans, ce qui est une croissance assez exponentielle, et peu de marchés se développent aussi rapidement:

Source: Potentiel des caméras à temps de vol et pénétration du marché

Source: Potentiel des caméras à temps de vol et pénétration du marchéUn moteur sérieux du marché aujourd'hui est le développement rapide (et aussi exponentiel) des robots industriels, pour lesquels les caméras ToF sont une solution idéale. Par exemple, si votre robot emballe des boîtes, alors avec une caméra 2D ordinaire, déterminer que vous commencez à bloquer le carton est une tâche extrêmement simple. Et pour une caméra ToF, il est trivial de «voir» et de la traiter. Et très vite. En conséquence, nous voyons un

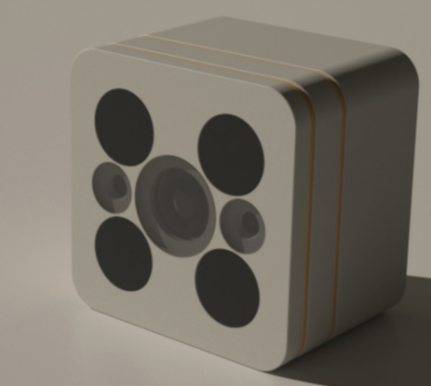

boom des caméras ToF industrielles :

Naturellement, cela conduit également à l'apparition de produits faits maison utilisant des caméras de profondeur. Par exemple, une caméra de sécurité avec une unité vidéo de nuit et une caméra de profondeur ToF de la société allemande

PMD Technologies , qui développe des caméras 3D depuis

plus de 20 ans :

Source: La détection de la profondeur du temps de vol 3D apporte de la magie à la nouvelle caméra Smart Home Lighthouse

Source: La détection de la profondeur du temps de vol 3D apporte de la magie à la nouvelle caméra Smart Home LighthouseVous vous souvenez de la cape d'invisibilité sous laquelle Harry Potter se cachait?

Source: La cape d'invisibilité de Harry Potter obtient une histoire d'origine et pourrait bientôt exister dans la vraie vie

Source: La cape d'invisibilité de Harry Potter obtient une histoire d'origine et pourrait bientôt exister dans la vraie vieJ'ai peur que la caméra allemande le détecte une ou deux fois. Et il sera difficile de placer un écran avec une image devant un tel appareil photo (ce n'est pas un garde distrayant pour vous):

Source: Fragment du film «Mission impossible: protocole fantôme»

Source: Fragment du film «Mission impossible: protocole fantôme»Il semble que pour les nouvelles caméras de vidéosurveillance, la magie non enfantine de Poudlard sera nécessaire pour les tromper avec une caméra de profondeur ToF, capable de filmer une telle vidéo dans l'obscurité totale:

Faire semblant d'être un mur, un écran et d'autres moyens de se protéger du fait que la caméra ToF + RGB combinée détectera un objet étranger devient techniquement cardinalement plus difficile.

Une autre application pacifique massive pour les caméras de profondeur est la reconnaissance des gestes. Dans un avenir proche, vous pouvez vous attendre à des téléviseurs, des consoles et des aspirateurs robotiques qui seront capables de percevoir non seulement les commandes vocales comme des haut-parleurs intelligents, mais aussi les imprudents "nettoyez-le!" d'un geste de la main. Ensuite, la télécommande (alias paresseux) de la Smart TV deviendra complètement inutile et la science-fiction prendra vie. En conséquence, ce qui

était fantastique en 2002 est devenu expérimental en 2013 et, enfin, en

série en 2019 (alors que les gens ne sauront pas qu'il y a une caméra de profondeur à l'intérieur,

quelle différence cela fait-il, comment fonctionne cette magie? ):

Source: article , expériences et produit

Source: article , expériences et produitEt la gamme complète d'applications est encore plus large, bien sûr:

Source: vidéo des capteurs de profondeur de Terabee (au fait, quel type de souris courent-ils sur le sol pour 2 et 3 vidéos? Les voir? Je plaisante, c'est de la poussière dans l'air - les frais pour la petite taille du capteur et la proximité de la source de lumière avec le capteur)

Source: vidéo des capteurs de profondeur de Terabee (au fait, quel type de souris courent-ils sur le sol pour 2 et 3 vidéos? Les voir? Je plaisante, c'est de la poussière dans l'air - les frais pour la petite taille du capteur et la proximité de la source de lumière avec le capteur)Soit dit en passant - dans les célèbres «magasins sans caissiers» d'Amazon Go, il y a aussi de nombreuses caméras sous le plafond:

Source: À l'intérieur du dépanneur sans contrôle, alimenté par la surveillance d'Amazon

Source: À l'intérieur du dépanneur sans contrôle, alimenté par la surveillance d'AmazonDe plus, comme l'écrit

TechCrunch :

"Ils sont augmentés par des caméras de détection de profondeur distinctes (en utilisant une technique de temps de vol , ou j'ai compris de Kumar) qui se fondent dans l'arrière-plan comme le reste, tout noir mat." C'est-à-dire que le miracle de déterminer de quelle étagère le yaourt est tiré est fourni, entre autres, par les mystérieuses caméras ToF noires mates (une bonne question, sont-elles sur la photo):

Malheureusement, les informations directes sont souvent difficiles à trouver. Mais il y en a un indirect. Par exemple, il y avait une société

Softkinetic , qui depuis 2007 développe des caméras ToF. 8 ans plus tard, ils ont été

achetés par Sony (qui, soit dit en passant, est prêt à conquérir de nouveaux marchés sous la marque

Sony Depthsensing ). Ainsi, l'un des

meilleurs employés de Softkinetic

travaille désormais uniquement sur Amazon Go. Quelle coïncidence! Dans quelques années, lorsque la technologie sera mise en place et les principaux brevets déposés, les détails seront très probablement révélés.

Eh bien, comme d'habitude, les Chinois s'enflamment.

Pico Zense , par exemple, a présenté au CES 2019 une gamme très impressionnante de caméras ToF, y compris pour une utilisation en extérieur:

Ils promettent une révolution partout. Les wagons seront plus denses en raison du chargement automatisé, les distributeurs automatiques de billets seront plus sûrs, grâce aux caméras de profondeur dans chacun, la navigation des robots deviendra plus facile et plus précise, les gens (et, surtout, les enfants!) Seront comptés un ordre de grandeur mieux dans le flux, de nouveaux simulateurs de fitness apparaîtront c la capacité de contrôler l'exactitude des exercices sans instructeur, et ainsi de suite. Naturellement, les caméras chinoises bon marché d'une profondeur nouvelle génération sont déjà prêtes pour toute cette magnificence. Prenez et construisez!

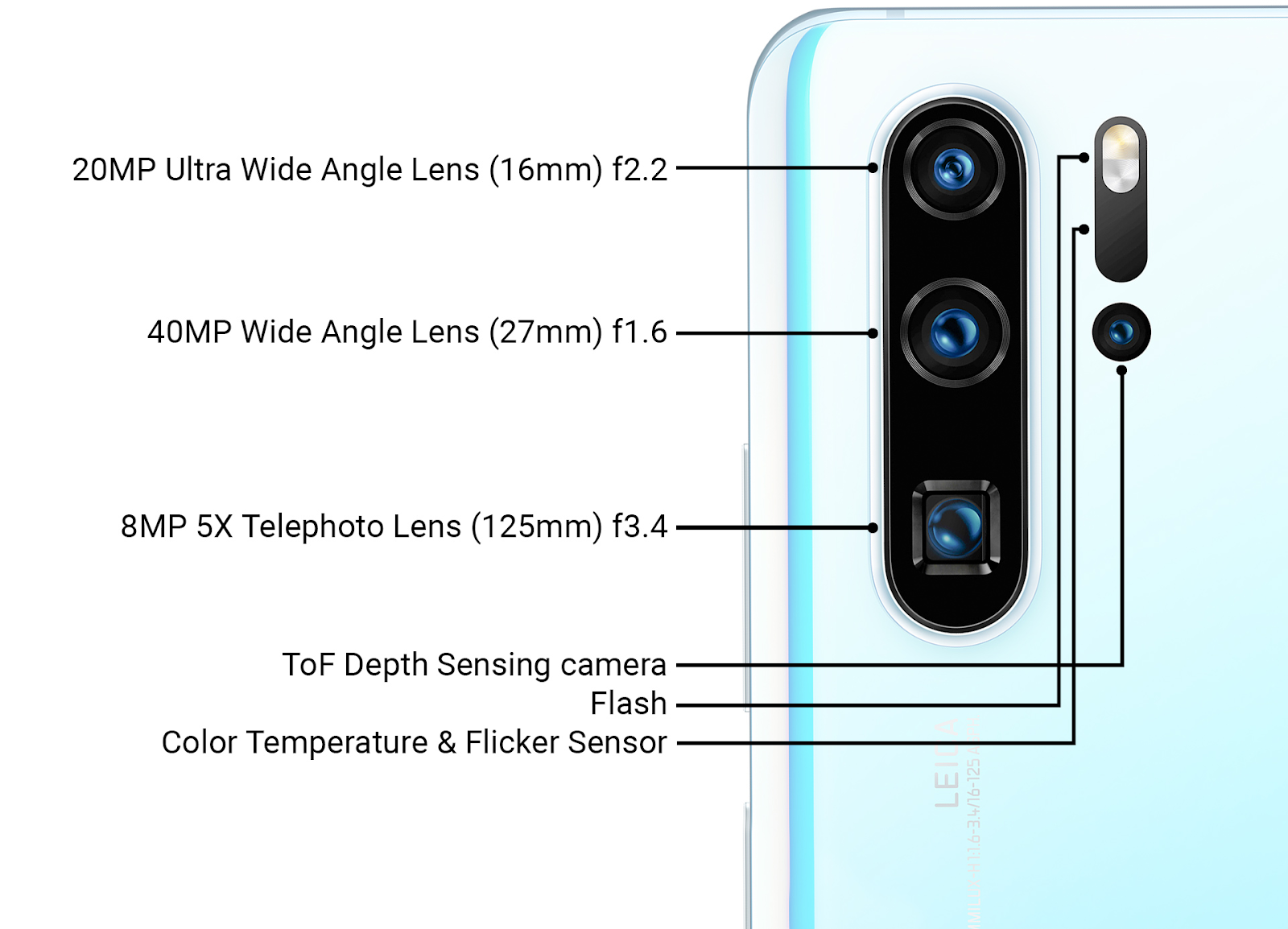

Fait intéressant, la dernière série Huawei P30 Pro dispose d'un capteur ToF à côté des caméras principales, c'est-à-dire Huawei, qui souffre depuis longtemps, est mieux à même de faire fabriquer des capteurs de lumière structurés frontaux par Apple et, semble-t-il, avec plus de succès Google (Project Tango, qui a

été fermé ) a mis en place une caméra à côté des principales caméras ToF:

Source: revue de la nouvelle technologie Ars Technica Huawei à fin mars 2019

Source: revue de la nouvelle technologie Ars Technica Huawei à fin mars 2019Les détails de l'utilisation, bien sûr, ne sont pas divulgués, mais en plus d'accélérer la mise au point (ce qui est important pour les trois appareils photo principaux avec des objectifs différents), ce capteur peut être utilisé pour augmenter la qualité du flou de l'arrière-plan des photos (simulant une faible

profondeur de champ ).

Il est également évident que la prochaine génération de capteurs de profondeur à côté des caméras principales sera utilisée dans les applications AR, ce qui augmentera la précision de l'AR du niveau actuel "cool, mais souvent buggy" à un niveau de travail de masse. Et, évidemment, à la lumière des succès chinois, la grande question est de savoir combien Google voudra prendre en charge le matériel révolutionnaire chinois dans

ARCore . Les guerres de brevets peuvent ralentir considérablement le marché des technologies. Le développement de cette histoire dramatique, nous verrons littéralement dans les deux prochaines années.

Sous-totaux

Il y a environ 25 ans, lorsque les premières portes automatiques sont apparues, j'ai personnellement observé comment des oncles tout à fait respectables accéléraient périodiquement devant de telles portes. Réussit à s'ouvrir ou n'a pas le temps? Elle est grande, lourde, en verre! À propos de la même chose que j'ai observée lors d'une tournée de professeurs tout à fait respectables dans une usine automatique en Chine récemment. Ils ont pris un peu de retard sur le groupe pour voir ce qui se passerait si vous vous teniez devant le robot, transportant paisiblement des pièces et jouant une mélodie silencieuse et agréable en chemin. Moi aussi, je me repens, je n'ai pas pu résister ... Tu sais, ça s'arrête! Peut-être en douceur. Peut-être en tant que mort. Les capteurs de profondeur fonctionnent!

Source: À l'intérieur du nouveau campus de Huawei Technology

Source: À l'intérieur du nouveau campus de Huawei TechnologyL'hôtel a également fonctionné comme robot de nettoyage, qui ressemblait à ceci:

En même temps, ils étaient plus intimidés que les robots à l'usine. Pas aussi dur que dans l'

inhumain dans tous les sens de la

dynamique de

Bosstown , bien sûr. Mais j'ai personnellement vu comment ils se sont levés sur la route, le robot a essayé de contourner une personne, la personne a bougé, bloquant la route ... Une sorte de chat et de souris. En général, il semble que lorsque des véhicules sans pilote apparaissent sur les routes, la première fois, ils seront coupés plus souvent que d'habitude ... Oh, les gens-les gens ... Hmmm ... Cependant, nous étions distraits.

Résumant les points clés:

- En raison d'un autre principe de fonctionnement, nous pouvons positionner la source de lumière dans la caméra ToF aussi près que possible du capteur (même sous le même objectif). De plus, de nombreux modèles industriels ont des LED situées autour du capteur. En conséquence, les «ombres» sur la carte de profondeur sont radicalement réduites, voire disparaissent. C'est-à-dire travail simplifié avec des objets géométriques complexes, ce qui est important pour les robots industriels.

- Étant donné que l'éclairage pulsé reste généralement infrarouge - tous les inconvénients de la caméra infrarouge décrits dans la dernière section sont préservés: exposition au soleil, difficultés lorsque deux caméras fonctionnent côte à côte, etc. Cependant, les robots industriels fonctionnent souvent à l'intérieur et des caméras avec éclairage laser sont en cours de développement.

- Hélas, les capteurs ToF sont plus difficiles à "suivre" l'amélioration globale des capteurs des caméras RVB, donc leur développement est plus lent, mais étonnamment confiant et les nouvelles concernant l'introduction des caméras ToF sont TRÈS nombreuses et ce qui (là) n'est pas là (seulement dans les smartphones a annoncé l'intégration des capteurs et Samsung, Google Pixel et Sony Xperia ...).

- Le nouveau Sony promet que 2 caméras sur 8 caméras de téléphone (!!!) seront des caméras de profondeur ToF (!), C'est-à-dire caméras de profondeur seront des deux côtés du téléphone:

Source: Le téléphone Sony Hexa-cam révèle les spécifications de l'appareil photo

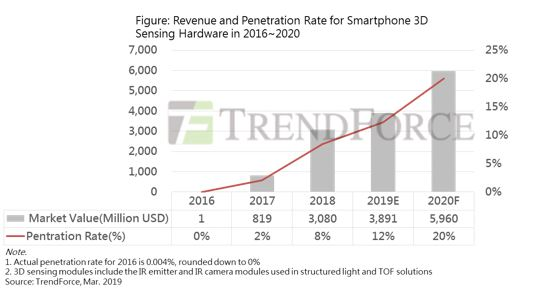

- En conséquence, nous trouverons beaucoup de choses intéressantes dans ce domaine même dans l'année à venir! Et l'année prochaine, jusqu'à 20% des nouveaux téléphones seront équipés de caméras de profondeur (Structured Light + ToF). Étant donné qu'en 2017, seul Apple était sur le marché dans un splendide isolement avec «30 000 points», et maintenant ils n'en mettent pas moins de 300 000, le sujet s'est clairement bien passé:

Source: croissance limitée du marché de la détection 3D de smartphones en 2019; Apple sera le principal promoteur de la croissance en 2020

Vous doutez encore de la révolution en cours?

C'était la première partie! Une comparaison générale sera dans la seconde.

Dans la prochaine série, attendez:

- Méthode 3, classique: profondeur de la stéréo;

- Méthode 4, nouvelle génération: profondeur des plénoptiques;

- Méthode 5, à croissance rapide: les lidars, y compris les lidars à l'état solide;

- Quelques problèmes de traitement vidéo en profondeur;

- Et enfin, une brève comparaison des 5 méthodes et des conclusions générales.

Carthage doit être brisée ... L' ensemble de la vidéo sera en trois dimensions d'ici la fin du siècle!Restez à l'écoute! (Si j'ai assez de temps, je décrirai de nouvelles caméras, y compris des tests de Kinect frais, d'ici la fin de l'année.)

2e partieRemerciementsJe remercie chaleureusement:

- Laboratoire d'infographie VMK Université d'État de Moscou MV Lomonosov pour sa contribution au développement de l'infographie en Russie en général et au travail avec les caméras de profondeur en particulier,

- Microsoft, Apple, Huawei et Amazon pour des produits basés sur une caméra de grande profondeur,

- Texel pour le développement de produits russes de haute technologie avec des caméras de profondeur,

- personnellement Konstantin Kozhemyakov, qui a fait beaucoup pour rendre cet article meilleur et plus visuel,

- et, enfin, un grand merci à Roman Kazantsev, Eugene Lyapustin, Egor Sklyarov, Maxim Fedyukov, Nikolai Oplachko et Ivan Molodetsky pour un grand nombre de commentaires judicieux et de corrections qui ont rendu ce texte bien meilleur!