Au cours des dernières années, j'ai travaillé en étroite collaboration avec les clusters Proxmox: de nombreux clients ont besoin de leur propre infrastructure pour développer leur projet. C'est pourquoi je peux vous parler des erreurs et des problèmes les plus courants que vous pouvez également rencontrer. En plus de cela, nous allons bien sûr configurer un cluster de trois nœuds à partir de zéro.

Un cluster Proxmox peut être composé de deux serveurs ou plus. Le nombre maximal de nœuds dans un cluster est de 32 pièces. Notre propre cluster sera composé de trois nœuds sur une multidiffusion (dans l'article, je décrirai également comment élever un cluster sur l'unicité - cela est important si vous basez votre infrastructure de cluster sur Hetzner ou OVH, par exemple). En bref, la multidiffusion permet le transfert de données vers plusieurs nœuds simultanément. Avec la multidiffusion, nous ne pouvons pas penser au nombre de nœuds dans le cluster (en se concentrant sur les limitations ci-dessus).

Le cluster lui-même est construit sur un réseau interne (il est important que les adresses IP soient sur le même sous-réseau), les mêmes Hetzner et OVH ont la possibilité de combiner des nœuds dans différents centres de données en utilisant la technologie Virtual Switch (Hetzner) et vRack (OVH) - à propos de Virtual Switch nous parlerons également dans l'article. Si votre hébergeur ne dispose pas de technologies similaires au travail, vous pouvez utiliser OVS (Open Virtual Switch), qui est pris en charge nativement par Proxmox, ou utiliser un VPN. Cependant, dans ce cas, je recommande d'utiliser Unicast avec un petit nombre de nœuds - des situations surviennent souvent où le cluster «s'effondre» simplement sur la base d'une telle infrastructure réseau et doit être restauré. Par conséquent, j'essaie d'utiliser OVH et Hetzner dans mon travail - j'ai vu moins de tels incidents, mais tout d'abord, étudiez le fournisseur d'hébergement qui sera hébergé: a-t-il une technologie alternative, quelles solutions offre-t-il, prend-il en charge la multidiffusion, etc. .

Installer Proxmox

Proxmox peut être installé de deux manières: installateur ISO et installation via shell. Nous choisissons la deuxième méthode, alors installez Debian sur le serveur.

Nous procédons directement à l'installation de Proxmox sur chaque serveur. L'installation est extrêmement simple et est décrite dans la documentation officielle ici.

Ajoutez le référentiel Proxmox et la clé de ce référentiel:

echo "deb http://download.proxmox.com/debian/pve stretch pve-no-subscription" > /etc/apt/sources.list.d/pve-install-repo.list wget http://download.proxmox.com/debian/proxmox-ve-release-5.x.gpg -O /etc/apt/trusted.gpg.d/proxmox-ve-release-5.x.gpg chmod +r /etc/apt/trusted.gpg.d/proxmox-ve-release-5.x.gpg

Mise à jour des référentiels et du système lui-même:

apt update && apt dist-upgrade

Après une mise à jour réussie, installez les packages Proxmox nécessaires:

apt install proxmox-ve postfix open-iscsi

Remarque : Postfix et grub seront configurés pendant l'installation - l'un d'eux peut échouer. Cela peut être dû au fait que le nom d'hôte ne se résout pas par son nom. Modifiez les entrées des hôtes et effectuez la mise à jour apt-get

À partir de maintenant, nous pouvons nous connecter à l'interface Web de Proxmox à l'adresse https: // <adresse-ip-externe>: 8006 (vous rencontrerez un certificat non approuvé lors de la connexion).

Image 1.

Image 1. Interface Web du nœud Proxmox

Installez Nginx et Let's Encrypt Certificate

Je n'aime pas vraiment la situation avec le certificat et l'adresse IP, donc je suggère d'installer Nginx et de configurer le certificat Let's Encrypt. Je ne décrirai pas l'installation de Nginx, je ne laisserai que les fichiers importants pour que le certificat Let's encrypt fonctionne:

/etc/nginx/snippets/letsencrypt.conf location ^~ /.well-known/acme-challenge/ { allow all; root /var/lib/letsencrypt/; default_type "text/plain"; try_files $uri =404; }

Commande pour l'émission du certificat SSL:

certbot certonly --agree-tos --email sos@livelinux.info --webroot -w /var/lib/letsencrypt/ -d proxmox1.domain.name

Configuration du site dans NGINX upstream proxmox1.domain.name { server 127.0.0.1:8006; } server { listen 80; server_name proxmox1.domain.name; include snippets/letsencrypt.conf; return 301 https://$host$request_uri; } server { listen 443 ssl; server_name proxmox1.domain.name; access_log /var/log/nginx/proxmox1.domain.name.access.log; error_log /var/log/nginx/proxmox1.domain.name.error.log; include snippets/letsencrypt.conf; ssl_certificate /etc/letsencrypt/live/proxmox1.domain.name/fullchain.pem; ssl_certificate_key /etc/letsencrypt/live/proxmox1.domain.name/privkey.pem; location / { proxy_pass https://proxmox1.domain.name; proxy_next_upstream error timeout invalid_header http_500 http_502 http_503 http_504; proxy_redirect off; proxy_buffering off; proxy_set_header Host $host; proxy_set_header X-Real-IP $remote_addr; proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for; }

Après avoir installé le certificat SSL, n'oubliez pas de le mettre à renouvellement automatique via cron:

0 */12 * * * /usr/bin/certbot -a \! -d /run/systemd/system && perl -e 'sleep int(rand(3600))' && certbot -q renew --renew-hook "systemctl reload nginx"

Super! Nous pouvons maintenant accéder à notre domaine via HTTPS.

Remarque : pour désactiver la fenêtre d'informations d'abonnement, exécutez cette commande:

sed -i.bak "s/data.status !== 'Active'/false/g" /usr/share/javascript/proxmox-widget-toolkit/proxmoxlib.js && systemctl restart pveproxy.service

Paramètres réseauAvant de vous connecter au cluster, configurez les interfaces réseau sur l'hyperviseur. Il convient de noter que la configuration des nœuds restants n'est pas différente, à l'exception des adresses IP et des noms de serveur, donc je ne dupliquerai pas leurs paramètres.

Créons un pont réseau pour le réseau interne afin que nos machines virtuelles (dans ma version il y aura un conteneur LXC pour plus de commodité), tout d'abord, elles sont connectées au réseau interne de l'hyperviseur et peuvent interagir entre elles. Deuxièmement, un peu plus tard, nous ajouterons un pont pour le réseau externe afin que les machines virtuelles aient leur propre adresse IP externe. En conséquence, les conteneurs seront en ce moment derrière NAT'om avec nous.

Il existe deux façons de travailler avec la configuration réseau de Proxmox: via l'interface Web ou via le fichier de configuration / etc / network / interfaces. Dans la première option, vous devrez redémarrer le serveur (ou vous pouvez simplement renommer le fichier interfaces.new en interfaces et redémarrer le service réseau via systemd). Si vous commencez tout juste à configurer et qu'il n'y a pas encore de machines virtuelles ou de conteneurs LXC, il est conseillé de redémarrer l'hyperviseur après les modifications.

Créez maintenant un pont réseau appelé vmbr1 dans l'onglet réseau du panneau Web Proxmox.

Figure 2.

Figure 2. Interfaces réseau du nœud proxmox1

Figure 3.

Figure 3. Création d'un pont réseau

Figure 4.

Figure 4. Configuration de la configuration du réseau vmbr1

La configuration est extrêmement simple - nous avons besoin de vmbr1 pour que les instances aient accès à Internet.

Redémarrez maintenant notre hyperviseur et vérifiez si l'interface a été créée:

Figure 5.

Figure 5. Interface réseau vmbr1 dans la sortie d'une commande ip

Remarque: J'ai déjà l'interface ens19 - c'est l'interface avec le réseau interne, sur la base de laquelle un cluster sera créé.

Répétez ces étapes sur les deux autres hyperviseurs, puis passez à l'étape suivante - préparation du cluster.

En outre, une étape importante consiste désormais à activer le transfert de paquets - sans lui, les instances n'auront pas accès au réseau externe. Ouvrez le fichier sysctl.conf et modifiez la valeur du paramètre net.ipv4.ip_forward à 1, après quoi nous entrons la commande suivante:

sysctl -p

Dans la sortie, vous devriez voir la directive net.ipv4.ip_forward (si vous ne l'avez pas modifiée auparavant)

Configuration d'un cluster ProxmoxPassons maintenant directement au cluster. Chaque nœud doit se résoudre et résoudre les autres nœuds du réseau interne, pour cela, il est nécessaire de modifier les valeurs dans les enregistrements d'hôtes comme suit (chaque nœud doit avoir un enregistrement sur les autres):

172.30.0.15 proxmox1.livelinux.info proxmox1 172.30.0.16 proxmox2.livelinux.info proxmox2 172.30.0.17 proxmox3.livelinux.info proxmox3

Il est également nécessaire d'ajouter les clés publiques de chaque nœud aux autres - cela est nécessaire pour créer un cluster.

Créez un cluster via le panneau Web:

Figure 6.

Figure 6. Création d'un cluster via l'interface Web

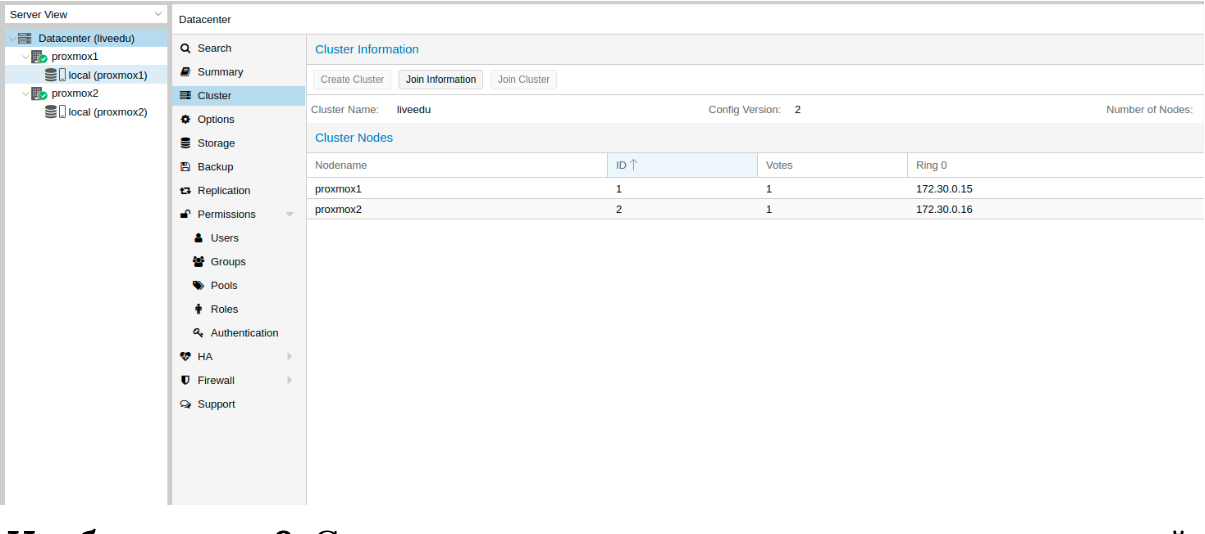

Après avoir créé le cluster, nous devons obtenir des informations à ce sujet. Accédez au même onglet du cluster et cliquez sur le bouton «Join Information»:

Image 7.

Image 7. Informations sur le cluster créé

Ces informations nous sont utiles lors de la jonction des deuxième et troisième nœuds du cluster. Nous sommes connectés au deuxième nœud et dans l'onglet Cluster, cliquez sur le bouton "Join Cluster":

Figure 8.

Figure 8. Connexion à un cluster de nœuds

Analysons plus en détail les paramètres de connexion:

- Adresse de l'homologue: adresse IP du premier serveur (à celui auquel nous nous connectons)

- Mot de passe: mot de passe du premier serveur

- Empreinte digitale: nous tirons cette valeur des informations du cluster

Figure 9.

Figure 9. État du cluster après la connexion du deuxième nœud

Le deuxième nœud est correctement connecté! Cependant, cela ne se produit pas toujours. Si vous suivez les étapes de manière incorrecte ou si des problèmes de réseau surviennent, alors la jointure du cluster échouera et le cluster lui-même sera "divisé". La meilleure solution consiste à déconnecter le nœud du cluster, à supprimer toutes les informations sur le cluster, puis à redémarrer le serveur et à vérifier les étapes précédentes. Comment déconnecter en toute sécurité un nœud d'un cluster? Tout d'abord, supprimez-le du cluster sur le premier serveur:

pvecm del proxmox2

Après quoi, le nœud sera déconnecté du cluster. Maintenant, allez sur le nœud cassé et désactivez-y les services suivants:

systemctl stop pvestatd.service systemctl stop pvedaemon.service systemctl stop pve-cluster.service systemctl stop corosync systemctl stop pve-cluster

Le cluster Proxmox stocke des informations sur lui-même dans la base de données sqlite, il doit également être effacé:

sqlite3 /var/lib/pve-cluster/config.db delete from tree where name = 'corosync.conf'; .quit

Les données sur l'écorce sont supprimées avec succès. Supprimez les fichiers restants, pour cela, vous devez démarrer le système de fichiers du cluster en mode autonome:

pmxcfs -l rm /etc/pve/corosync.conf rm /etc/corosync/* rm /var/lib/corosync/* rm -rf /etc/pve/nodes/*

Nous redémarrons le serveur (ce n'est pas nécessaire, mais nous sommes sûrs: tous les services doivent être finis et fonctionner correctement à la fin. Pour ne rien manquer, nous allons redémarrer). Après la mise sous tension, nous obtiendrons un nœud vide sans aucune information sur le cluster précédent et nous pouvons recommencer la connexion.

Installer et configurer ZFS

ZFS est un système de fichiers qui peut être utilisé avec Proxmox. Avec lui, vous pouvez vous permettre de répliquer des données vers un autre hyperviseur, migrer le conteneur machine virtuelle / LXC, accéder au conteneur LXC à partir du système hôte, etc. L'installation est assez simple, passons à l'analyse. Trois SSD sont disponibles sur mes serveurs, que nous allons combiner en une matrice RAID.

Ajouter des référentiels:

nano /etc/apt/sources.list.d/stretch-backports.list deb http://deb.debian.org/debian stretch-backports main contrib deb-src http://deb.debian.org/debian stretch-backports main contrib nano /etc/apt/preferences.d/90_zfs Package: libnvpair1linux libuutil1linux libzfs2linux libzpool2linux spl-dkms zfs-dkms zfs-test zfsutils-linux zfsutils-linux-dev zfs-zed Pin: release n=stretch-backports Pin-Priority: 990

Mise à jour de la liste des packages:

apt update

Définissez les dépendances requises:

apt install --yes dpkg-dev linux-headers-$(uname -r) linux-image-amd64

Installez ZFS lui-même:

apt-get install zfs-dkms zfsutils-linux

Si à l'avenir vous obtenez une erreur fusermount: dispositif fusible introuvable, essayez d'abord 'modprobe fuse', puis exécutez la commande suivante:

modprobe fuse

Passons maintenant directement à la configuration. Nous devons d'abord formater les SSD et les configurer via parted:

Configurer / dev / sda parted /dev/sda (parted) print Model: ATA SAMSUNG MZ7LM480 (scsi) Disk /dev/sda: 480GB Sector size (logical/physical): 512B/512B Partition Table: msdos Disk Flags: Number Start End Size Type File system Flags 1 1049kB 4296MB 4295MB primary raid 2 4296MB 4833MB 537MB primary raid 3 4833MB 37,0GB 32,2GB primary raid (parted) mkpart Partition type? primary/extended? primary File system type? [ext2]? zfs Start? 33GB End? 480GB Warning: You requested a partition from 33,0GB to 480GB (sectors 64453125..937500000). The closest location we can manage is 37,0GB to 480GB (sectors 72353792..937703087). Is this still acceptable to you? Yes/No? yes

Des actions similaires doivent être effectuées pour les autres lecteurs. Une fois tous les disques préparés, passez à l'étape suivante:

zpool create -f -o ashift = 12 rpool / dev / sda4 / dev / sdb4 / dev / sdc4

Nous choisissons ashift = 12 pour des raisons de performances - c'est la recommandation de zfsonlinux lui-même, vous pouvez en lire plus sur leur wiki:

github.com/zfsonlinux/zfs/wiki/faq#performance-considerationsAppliquer certains paramètres pour ZFS:

zfs set atime=off rpool zfs set compression=lz4 rpool zfs set dedup=off rpool zfs set snapdir=visible rpool zfs set primarycache=all rpool zfs set aclinherit=passthrough rpool zfs inherit acltype rpool zfs get -r acltype rpool zfs get all rpool | grep compressratio

Maintenant, nous devons calculer certaines variables pour calculer zfs_arc_max, je fais cela comme suit:

mem =`free --giga | grep Mem | awk '{print $2}'` partofmem=$(($mem/10)) echo $setzfscache > /sys/module/zfs/parameters/zfs_arc_max grep c_max /proc/spl/kstat/zfs/arcstats zfs create rpool/data cat > /etc/modprobe.d/zfs.conf << EOL options zfs zfs_arc_max=$setzfscache EOL echo $setzfscache > /sys/module/zfs/parameters/zfs_arc_max grep c_max /proc/spl/kstat/zfs/arcstats

Pour le moment, le pool a été créé avec succès, nous avons également créé un sous-pool de données. Vous pouvez vérifier l'état de votre pool avec la commande zpool status. Cette action doit être effectuée sur tous les hyperviseurs, puis passez à l'étape suivante.

Ajoutez maintenant ZFS à Proxmox. Nous allons dans les paramètres du centre de données (à savoir lui, et non un nœud séparé) dans la section "Stockage", cliquez sur le bouton "Ajouter" et sélectionnez l'option "ZFS", après quoi nous verrons les paramètres suivants:

ID: Nom de la centaine. Je lui ai donné le nom local-zfs

Pool ZFS: Nous avons créé rpool / data, et nous l'ajoutons ici.

Nœuds: spécifiez tous les nœuds disponibles

Cette commande crée un nouveau pool avec les lecteurs que nous avons sélectionnés. Sur chaque hyperviseur, un nouveau stockage doit apparaître, appelé local-zfs, après quoi vous pouvez migrer vos machines virtuelles du stockage local vers ZFS.

Réplication d'instances vers un hyperviseur voisin

Le cluster Proxmox a la capacité de répliquer des données d'un hyperviseur à un autre: cette option vous permet de basculer l'instance d'un serveur à un autre. Les données seront pertinentes au moment de la dernière synchronisation - leur heure peut être définie lors de la création de la réplication (15 minutes est défini comme standard). Il existe deux façons de migrer une instance vers un autre nœud Proxmox: manuelle et automatique. Examinons d'abord l'option manuelle, et à la fin je vous donnerai un script Python qui vous permettra de créer une machine virtuelle sur un hyperviseur accessible lorsque l'un des hyperviseurs n'est pas disponible.

Pour créer la réplication, accédez au panneau Web Proxmox et créez une machine virtuelle ou un conteneur LXC. Dans les paragraphes précédents, nous avons configuré le pont vmbr1 avec NAT, ce qui nous permettra d'accéder au réseau externe. Je vais créer un conteneur LXC avec MySQL, Nginx et PHP-FPM avec un site de test pour tester la réplication. Voici une instruction étape par étape.

Nous chargeons le modèle approprié (allez dans stockage -> Contenu -> Modèles), un exemple dans la capture d'écran:

Image 10.

Image 10. Stockage local avec des modèles de VM et des images

Cliquez sur le bouton "Modèles" et chargez le modèle de conteneur LXC dont nous avons besoin:

Image 11.

Image 11. Sélection et chargement d'un modèle

Nous pouvons maintenant l'utiliser lors de la création de nouveaux conteneurs LXC. Sélectionnez le premier hyperviseur et cliquez sur le bouton «Créer CT» dans le coin supérieur droit: nous verrons le panneau pour créer une nouvelle instance. Les étapes d'installation sont assez simples et je ne donnerai que le fichier de configuration de ce conteneur LXC:

arch: amd64 cores: 3 memory: 2048 nameserver: 8.8.8.8 net0: name=eth0,bridge=vmbr1,firewall=1,gw=172.16.0.1,hwaddr=D6:60:C5:39:98:A0,ip=172.16.0.2/24,type=veth ostype: centos rootfs: local:100/vm-100-disk-1.raw,size=10G swap: 512 unprivileged:

Le conteneur a été créé avec succès. Vous pouvez vous connecter aux conteneurs LXC via la commande pct enter, j'ai également ajouté la clé SSH de l'hyperviseur avant l'installation pour vous connecter directement via SSH (il y a quelques problèmes avec l'affichage du terminal dans PCT). J'ai préparé le serveur et y ai installé toutes les applications serveur nécessaires, vous pouvez maintenant procéder à la création de la réplication.

Nous cliquons sur le conteneur LXC et allons dans l'onglet «Réplication», où nous créons le paramètre de réplication à l'aide du bouton «Ajouter»:

Figure 12.

Figure 12. Création de réplication dans l'interface Proxmox

Image 13.

Image 13. Fenêtre de création de travail de réplication

J'ai créé la tâche de répliquer le conteneur sur le deuxième nœud, comme vous pouvez le voir dans la capture d'écran suivante, la réplication a réussi - faites attention au champ "Statut", il informe de l'état de la réplication, il convient également de prêter attention au champ "Durée" pour savoir combien de temps la réplication des données prend.

Image 14.

Image 14. Liste de synchronisation des VM

Essayez maintenant de migrer la machine vers le deuxième nœud en utilisant le bouton «Migrer»

La migration du conteneur va commencer, le journal peut être consulté dans la liste des tâches - il y aura notre migration. Après cela, le conteneur sera déplacé vers le deuxième nœud.

Erreur «Échec de la vérification de la clé d'hôte»Parfois, lors de la configuration d'un cluster, un problème similaire peut survenir: il empêche les machines de migrer et de créer une réplication, ce qui élimine les avantages des solutions de cluster. Pour corriger cette erreur, supprimez le fichier known_hosts et connectez-vous via SSH au nœud en conflit:

/usr/bin/ssh -o 'HostKeyAlias=proxmox2' root@172.30.0.16

Acceptez Hostkey et essayez d'entrer cette commande, elle devrait vous connecter au serveur:

/usr/bin/ssh -o 'BatchMode=yes' -o 'HostKeyAlias=proxmox2' root@172.30.0.16

Caractéristiques des paramètres réseau sur Hetzner

Accédez au panneau Robot et cliquez sur le bouton «Commutateurs virtuels». Sur la page suivante, vous verrez un panneau pour créer et gérer des interfaces de commutateur virtuel: vous devez d'abord le créer, puis y «connecter» des serveurs dédiés. Dans la recherche, ajoutez les serveurs nécessaires pour vous connecter - ils n'ont pas besoin d'être redémarrés, il suffit d'attendre 10 à 15 minutes lorsque la connexion au commutateur virtuel sera active.

Après avoir ajouté les serveurs à Virtual Switch via le panneau Web, nous nous connectons aux serveurs et ouvrons les fichiers de configuration des interfaces réseau, où nous créons une nouvelle interface réseau:

auto enp4s0.4000 iface enp4s0.4000 inet static address 10.1.0.11/24 mtu 1400 vlan-raw-device enp4s0

Examinons de plus près ce que c'est. À la base, il s'agit d'un VLAN qui se connecte à une seule interface physique appelée enp4s0 (cela peut varier pour vous), avec le numéro de VLAN indiqué - il s'agit du numéro de commutateur virtuel que vous avez créé dans le panneau Web du robot Hetzner. Vous pouvez spécifier n'importe quelle adresse, tant qu'elle est locale.

Je note que vous devez configurer enp4s0 comme d'habitude, en fait, il doit contenir une adresse IP externe qui a été délivrée à votre serveur physique. Répétez ces étapes sur d'autres hyperviseurs, puis redémarrez le service réseau sur eux, envoyez une requête ping à un nœud voisin à l'aide de l'adresse IP du commutateur virtuel. Si le ping a réussi, vous avez réussi à établir une connexion entre les serveurs à l'aide de Virtual Switch.

Je joindrai également le fichier de configuration sysctl.conf, il sera nécessaire si vous avez des problèmes avec le package de transfert et d'autres paramètres réseau:

net.ipv6.conf.all.disable_ipv6=0 net.ipv6.conf.default.disable_ipv6 = 0 net.ipv6.conf.all.forwarding=1 net.ipv4.conf.all.rp_filter=1 net.ipv4.tcp_syncookies=1 net.ipv4.ip_forward=1 net.ipv4.conf.all.send_redirects=0

Ajout de sous-réseaux IPv4 à HetznerAvant de commencer le travail, vous devez commander un sous-réseau dans Hetzner, vous pouvez le faire via le panneau Robot.

Créez un pont réseau avec l'adresse qui proviendra de ce sous-réseau. Exemple de configuration:

auto vmbr2 iface vmbr2 inet static address ip-address netmask 29 bridge-ports none bridge-stp off bridge-fd 0

Accédez maintenant aux paramètres de la machine virtuelle dans Proxmox et créez une nouvelle interface réseau qui sera attachée au pont vmbr2. J'utilise le conteneur LXC, sa configuration peut être modifiée immédiatement dans Proxmox. Configuration finale pour Debian:

auto eth0 iface eth0 inet static address ip-address netmask 26 gateway bridge-address

Veuillez noter: j'ai spécifié 26 masque, pas 29 - cela est nécessaire pour que le réseau fonctionne sur la machine virtuelle.

Ajout d'adresses IPv4 à HetznerLa situation avec une seule adresse IP est différente - généralement Hetzner nous donne une adresse supplémentaire à partir du sous-réseau du serveur. Cela signifie qu'au lieu de vmbr2, nous devons utiliser vmbr0, mais pour le moment nous ne l'avons pas. L'essentiel est que vmbr0 doit contenir l'adresse IP du serveur Iron (c'est-à-dire, utiliser l'adresse qui a utilisé l'interface réseau physique enp2s0). L'adresse doit être déplacée vers vmbr0, la configuration suivante convient à cela (je vous conseille de commander KVM, auquel cas pour reprendre le fonctionnement du réseau):

auto enp2s0 iface enp2s0 inet manual auto vmbr0 iface vmbr0 inet static address ip-address netmask 255.255.255.192 gateway ip-gateway bridge-ports enp2s0 bridge-stp off bridge-fd 0

Redémarrez le serveur, si possible (sinon, redémarrez le service réseau), puis vérifiez les interfaces réseau via ip a:

2: enp2s0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast master vmbr0 state UP group default qlen 1000 link/ether 44:8a:5b:2c:30:c2 brd ff:ff:ff:ff:ff:ff

Comme vous pouvez le voir ici, enp2s0 est connecté à vmbr0 et n'a pas d'adresse IP, car il a été réaffecté à vmbr0.

Maintenant, dans les paramètres de la machine virtuelle, ajoutez l'interface réseau qui sera connectée à vmbr0. Pour la passerelle, spécifiez l'adresse attachée à vmbr0.

À la fin

J'espère que cet article vous sera utile lorsque vous configurerez le cluster Proxmox à Hetzner. Si le temps le permet, je développerai l'article et ajouterai des instructions pour OVH - là aussi, tout n'est pas évident, comme cela semble à première vue. Le matériel s'est avéré assez volumineux, si vous trouvez des erreurs, alors veuillez écrire dans les commentaires, je les corrigerai. Merci à tous pour votre attention.

Publié par Ilya Andreev, édité par Alexei Zhadan et Live Linux Team