Découvrez quelle approche Huawei propose lors de l'organisation de l'accès direct à distance à la mémoire à l'aide de la technologie AI Fabric et en quoi il diffère d'InfiniBand et du RDMA Ethernet pur.

L'informatique distribuée est utilisée dans une grande variété d'industries. Ce sont la recherche scientifique et les développements techniques comme la reconnaissance faciale ou les outils de reconnaissance du pilote automatique, et l'industrie. En général, l'analyse des données trouve de plus en plus d'applications, et nous pouvons affirmer avec confiance qu'elle ne perdra pas de popularité dans un proche avenir. En fait, nous vivons actuellement une transition de l'ère du cloud computing, où les facteurs les plus importants étaient les applications et la vitesse de déploiement des services, à l'ère de la monétisation des données, notamment grâce à l'utilisation d'algorithmes d'intelligence artificielle. Selon nos données internes (rapport

GIV 2025: Dérouler le schéma directeur d'un monde intelligent ), d'ici 2025, 86% des entreprises utiliseront l'IA dans leur travail. Beaucoup d'entre eux considèrent ce domaine comme le principal moteur de la modernisation des activités et, éventuellement, l'outil de base pour prendre des décisions commerciales à l'avenir. Et cela signifie que chacune de ces entreprises aura besoin d'une sorte de traitement des données brutes - très probablement via des clusters distribués.

L'évolution de l'architecture

Avec la popularité croissante de l'informatique distribuée, le volume de trafic échangé entre les machines individuelles des centres de données augmente. Traditionnellement, lorsque l'on discute des réseaux, l'attention est focalisée sur la croissance du trafic entre le centre de données et les utilisateurs finaux sur Internet, et il est vraiment en croissance. Mais l'augmentation du trafic horizontal au sein des systèmes distribués dépasse de loin tout ce que les utilisateurs génèrent. Selon Facebook, le trafic entre leurs systèmes internes double en moins d'un an.

Pour tenter de gérer ce trafic, vous pouvez augmenter les clusters, mais vous ne pouvez pas le faire indéfiniment. Par conséquent, en prédisant la croissance de la charge de calcul sur les clusters, il est nécessaire d'augmenter l'efficacité du traitement - tout d'abord, pour trouver et éliminer les goulots d'étranglement à l'intérieur de ces réseaux distribués.

Si auparavant le «maillon faible» des systèmes distribués était les ressources de chacun de ces systèmes séparément, tout en développant constamment des réseaux de transmission de données dépassant même les besoins, ce sont aujourd'hui les communications réseau qui sont la principale source du problème. La pile de protocoles TCP / IP et la topologie d'arborescence familières ne correspondent plus aux tâches assignées. Par conséquent, de plus en plus de centres de données abandonnent celui centralisé et migrent vers une nouvelle architecture CLOS qui offre une plus grande bande passante et une meilleure évolutivité du cluster, comme, par exemple, Facebook l'a fait il y a plusieurs années.

Dans le même temps, il est nécessaire d'optimiser le processus à un niveau différent - au niveau de l'interaction de deux systèmes distincts. Dans cet article, nous voulons parler des outils d'optimisation fournis par le centre de données Huawei Ai Fabric. Il s'agit de notre technologie propriétaire qui accélère l'échange de données entre les nœuds.

Modifications de mise en réseau

Le principal «truc» de Huawei Ai Fabric est de réduire les frais généraux lors du transfert de paquets de données entre les systèmes du cluster en implémentant RDMA (Remote Direct Memory Access) - accès direct à la mémoire des systèmes du cluster.

RDMA - un moyen de réduire les retards de transmission

RDMA n'est pas une nouvelle idée. La technologie permet un échange direct de données entre la mémoire et l'interface réseau, réduisant la latence et éliminant la copie inutile des données vers les tampons. Ses racines remontent aux années 1990 par Compaq, Intel et Microsoft.

Il existe trois types de retards dans la transmission d'un paquet d'un système à un autre:

- en raison du traitement du processeur nécessaire, par exemple, pour la mise en mémoire tampon des données dans le système d'exploitation et le calcul des sommes de contrôle;

- en raison des bus et des canaux de transmission de données (il est techniquement impossible d'augmenter considérablement la bande passante);

- en raison de l'équipement réseau.

Pour réduire les pertes tout au long de cette chaîne, dès les années 1990, il a été proposé d'utiliser un accès direct à la mémoire des systèmes en interaction - un modèle abstrait d'architecture d'interface virtuelle. Son idée principale est que les applications fonctionnant sur deux systèmes interactifs remplissent complètement leur mémoire locale et établissent une connexion P2P pour le transfert de données sans affecter le système d'exploitation. De cette façon, les retards de transmission des paquets peuvent être considérablement réduits. De plus, puisque le modèle VIA n'impliquait pas de placer les données transmises dans des tampons intermédiaires, il économisait les ressources nécessaires à l'opération de copie.

En ce qui concerne le modèle abstrait, VIA RDMA, en tant que technologie, a encore progressé vers une utilisation optimale des ressources. En particulier, il n'attend pas que le tampon soit rempli pour établir une connexion et autorise les connexions à plusieurs ordinateurs simultanément. De ce fait, la technologie peut réduire les retards de transmission jusqu'à 1 ms, réduisant ainsi la charge sur le processeur.

InfiniBand vs Ethernet

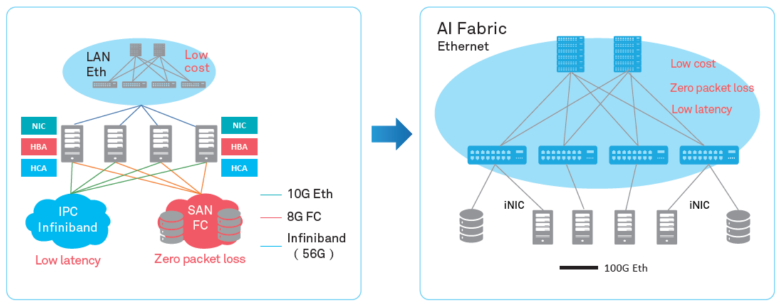

Les deux principales implémentations RDMA sur le marché - le protocole de transport propriétaire InfiniBand et le RDMA Ethernet "pur", ne sont malheureusement pas sans inconvénients.

Le protocole de transport InfiniBand a un mécanisme de contrôle de livraison de paquets intégré (protection contre la perte de données), mais il est pris en charge par un équipement spécifique et n'est pas compatible avec Ethernet. En effet, l'utilisation de ce protocole ferme le data center chez un équipementier, ce qui comporte certains risques et promet des difficultés en termes de service (puisque InfiniBand a une petite part de marché, il ne sera pas si facile de trouver des spécialistes). Bien sûr, lors de la mise en œuvre du protocole, vous ne pouvez pas utiliser l'équipement de réseau IP existant.

RDMA sur Ethernet vous permet d'utiliser les équipements existants sur le réseau, prend en charge les réseaux Ethernet, ce qui signifie qu'il sera plus facile de trouver des spécialistes de service. Comparé à Infiniband, cela réduit considérablement le coût de possession de l'infrastructure et simplifie son déploiement.

Le seul inconvénient grave qui a empêché l'adoption généralisée de RDMA sur Ethernet est le manque de protection contre la perte de paquets, qui limite la bande passante de l'ensemble du réseau. Des mécanismes tiers doivent être utilisés pour réduire la perte de paquets ou empêcher la congestion du réseau. Nous sommes allés dans ce sens, offrant nos propres algorithmes intelligents pour compenser les inconvénients de RDMA sur Ethernet tout en conservant ses avantages dans le nouvel outil - Huawei Ai Fabric.

Huawei AI Fabric - à sa façon

AI Fabric implémente RDMA sur Ethernet, complété par son propre algorithme de gestion intelligente de la congestion du réseau, qui fournit une perte de paquets nulle, une bande passante réseau élevée et un faible délai de transmission pour les flux RDMA.

Huawei Ai Fabric est construit sur des normes ouvertes et prend en charge une gamme d'équipements différents, ce qui optimise le processus de mise en œuvre. Cependant, certains outils supplémentaires - des modules complémentaires aux normes ouvertes, permettant d'augmenter l'efficacité de l'échange de données, dont nous discuterons dans les publications ultérieures - ne sont disponibles que pour les appareils fabriqués par Huawei. Les commutateurs de la gamme CloudEngine qui prennent en charge la solution ont une puce intégrée qui analyse les caractéristiques du trafic et ajuste dynamiquement les paramètres du réseau, ce qui permet une utilisation plus efficace du tampon du commutateur. Les caractéristiques collectées sont également utilisées pour prédire les futurs schémas de trafic.

À qui est-ce utile?

Huawei Ai Fabric vous permet de réaliser des bénéfices à deux niveaux.

D'une part, la solution permet d'optimiser l'architecture du centre de données - en réduisant le nombre de nœuds (en raison d'une utilisation plus optimale des ressources), en créant un environnement convergent sans la séparation traditionnelle en sous-réseaux séparés, qui sont difficiles et coûteux à maintenir en partie. À l'aide de l'outil, vous n'avez pas à sélectionner des sous-réseaux distincts pour chaque type de service dans le contrôleur de domaine (avec ses propres exigences de réseau). Vous pouvez créer un environnement unique qui fournit tous les services.

D'un autre côté, AI Fabric vous permet d'augmenter la vitesse de l'informatique distribuée, en particulier lorsque vous avez souvent besoin d'accéder à la mémoire de systèmes distants. Par exemple, l'introduction de l'IA dans n'importe quel domaine implique une période d'apprentissage de l'algorithme, qui peut inclure des millions d'opérations, de sorte que le gain de retard sur chacune de ces opérations entraînera une sérieuse accélération du processus.

L'effet de l'introduction d'un outil spécialisé, tel que Huawei Ai Fabric, sera perceptible dans un centre de données avec six commutateurs ou plus. Mais plus le centre de données est grand, plus les bénéfices sont élevés - en raison de l'utilisation optimale des ressources, un cluster de la même échelle avec Ai Fabric offrira de meilleures performances. Par exemple, un cluster de 384 nœuds peut atteindre les performances d'un cluster "régulier" de 512 nœuds. De plus, la solution n'a aucune restriction sur le nombre de commutateurs physiques au sein de l'infrastructure. Il peut y en avoir des dizaines de milliers (si vous oubliez que les projets sont généralement limités à la taille du domaine administratif).