Dans la

première partie de ce texte, nous avons examiné les caméras de profondeur basées sur des mesures de lumière structurelle et de retard de lumière aller-retour, qui utilisent principalement un éclairage infrarouge. Ils fonctionnent très bien à l'intérieur à des distances de 10 centimètres à 10 mètres, et surtout - sont très bon marché. D'où la vague massive de leur utilisation actuelle dans les smartphones. Mais ... Dès que nous sortons, le soleil même à travers les nuages illumine la lumière infrarouge et leur travail se dégrade fortement.

Comme le dit Steve Blank (

pour une autre raison cependant): "Si vous voulez réussir, quittez le bâtiment." Ci-dessous, nous parlerons des caméras de profondeur fonctionnant à l'extérieur. Aujourd'hui, ce sujet est fortement porté par les voitures autonomes, mais, comme nous le verrons, non seulement.

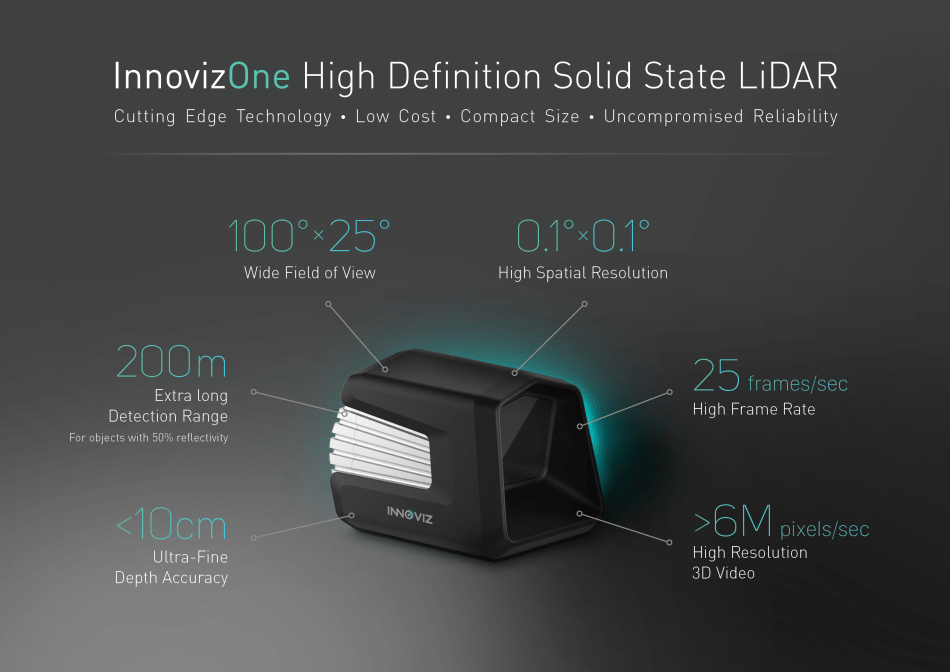

Source: Innoviz envisage des voitures autonomes produites en série avec LiDAR à semi-conducteurs

Source: Innoviz envisage des voitures autonomes produites en série avec LiDAR à semi-conducteursAinsi, les caméras de profondeur, c'est-à-dire appareils qui tournent des vidéos, dans chaque pixel dont la distance à l'objet de la scène, travaillant en plein soleil!

Peu importe - bienvenue à Kat!

Commençons par les classiques intemporels ...

Méthode 3: Profondeur de la caméra stéréo +

La construction d'une carte de profondeur à partir de la stéréo est bien connue et est utilisée depuis

plus de 40 ans . Voici un exemple d'un appareil photo compact pour 450 $, qui peut être utilisé pour contrôler les gestes, avec la photographie professionnelle ou avec des casques VR:

Source

SourceLe principal avantage de ces caméras est que la lumière du soleil non seulement ne les dérange pas, mais vice versa, améliore leurs résultats.En conséquence, l'utilisation active de ces caméras pour toutes sortes de cas de rue, par exemple, est un excellent exemple de la façon de photographier un modèle tridimensionnel d'un ancien fort en quelques minutes:

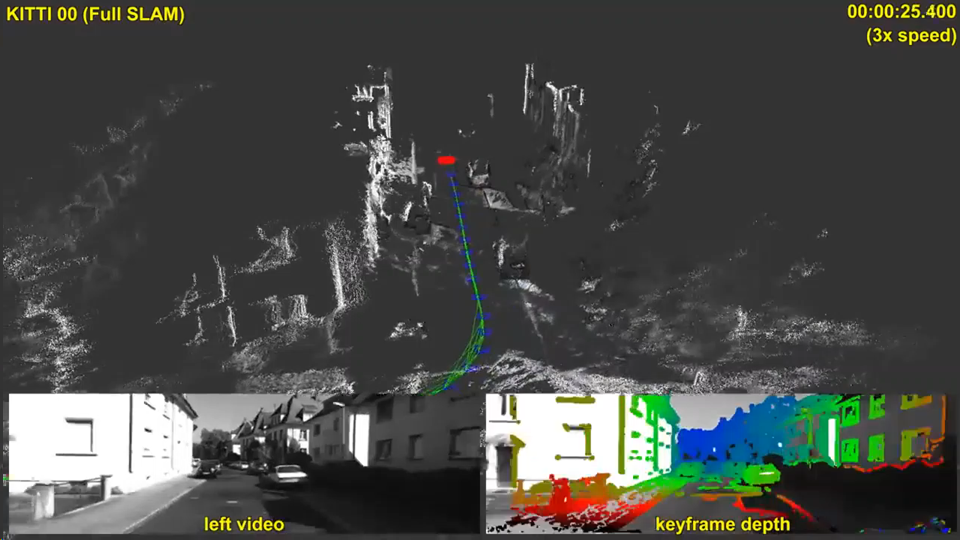

Un exemple d'utilisation de la caméra ZED dans la rueL'argent considérable utilisé pour traduire la construction de la profondeur de la stéréo à un nouveau niveau a été bien sûr influencé par le thème des voitures autonomes. Sur les 5 méthodes envisagées pour construire une vidéo de profondeur, seulement deux - celle-ci et la suivante (stéréo et plénoptique) n'interfèrent pas avec le soleil et n'interfèrent pas avec les voitures voisines. Dans le même temps, la plénoptique est beaucoup plus chère et moins précise sur de longues distances. Cela peut arriver de toute façon, il est difficile de faire des prévisions, mais dans ce cas, cela vaut la peine d'être d'accord avec Elon Musk - la stéréo sur les 5 méthodes a les meilleures perspectives. Et les résultats actuels sont très encourageants:

Source: SLAM direct à grande échelle avec caméras stéréo

Source: SLAM direct à grande échelle avec caméras stéréoMais il est intéressant de noter que ce ne sont pas les véhicules sans pilote (dont peu sont produits à ce jour), mais les appareils beaucoup plus massifs, où une carte de profondeur stéréo est en cours de construction, auront une influence encore plus forte sur le développement de la profondeur de construction à partir de la stéréo, à savoir ... C'est vrai! Smartphones!

Il y a trois ans, le boom des smartphones «à deux yeux» a tout simplement explosé, dans lequel pratiquement toutes les marques ont été notées, car la qualité des photos prises avec un appareil photo et la qualité des photos prises avec deux appareils différaient considérablement, mais du point de vue de l'augmentation du prix d'un smartphone, ce n'était pas si important:

De plus, l'année dernière, le processus est allé encore plus loin: «Avez-vous 2 caméras dans votre smartphone? Suce! J'en ai

trois quatre !!! ”:

Source: Samsung Galaxy A8 et A9

Source: Samsung Galaxy A8 et A9L'avenir à six yeux Sony a été mentionné dans la première partie. En général, les smartphones multi-yeux gagnent en popularité parmi les fabricants.

Les causes fondamentales de ce phénomène sont simples:

- La résolution des téléphones-appareils photo augmente et la taille de l'objectif est petite. En conséquence, malgré de nombreuses astuces, le niveau de bruit augmente et la qualité diminue, en particulier lors de la prise de vue dans l'obscurité.

- De plus, sur la deuxième caméra, nous pouvons retirer le soi-disant filtre Bayer de la matrice, c'est-à-dire une caméra sera en noir et blanc et la deuxième couleur. Cela augmente la sensibilité en noir et blanc d'environ 3 fois. C'est-à-dire la sensibilité de 2 caméras augmente conditionnellement non pas 2, mais 4 fois (!). Il existe de nombreuses nuances, mais une telle augmentation de la sensibilité est vraiment clairement visible à l'œil nu.

- Entre autres choses, lorsqu'une paire stéréo apparaît, nous avons la possibilité de modifier par programmation la profondeur de champ, c'est-à-dire flouter l'arrière-plan, dont de nombreuses photos bénéficient de manière significative (nous avons écrit à ce sujet dans la seconde moitié ici ). Cette option de nouveaux modèles de smartphones est rapidement devenue extrêmement populaire.

- Avec une augmentation du nombre de caméras, il est également possible d'utiliser d'autres objectifs - plus grand-angle (mise au point courte) et, inversement, mise au point longue, ce qui peut améliorer considérablement la qualité lors de "l'approche" d'objets.

- Fait intéressant, une augmentation du nombre de caméras nous rapproche du sujet d'un champ lumineux raréfié, qui a beaucoup de ses caractéristiques et avantages, cependant, c'est une autre histoire.

- Nous notons également que l'augmentation du nombre de caméras vous permet d'augmenter la résolution par des méthodes de récupération de résolution .

En général, il y a tellement d'avantages que lorsque les gens en sont conscients, ils commencent à se demander pourquoi au moins 2 caméras n'ont pas été réglées depuis longtemps.

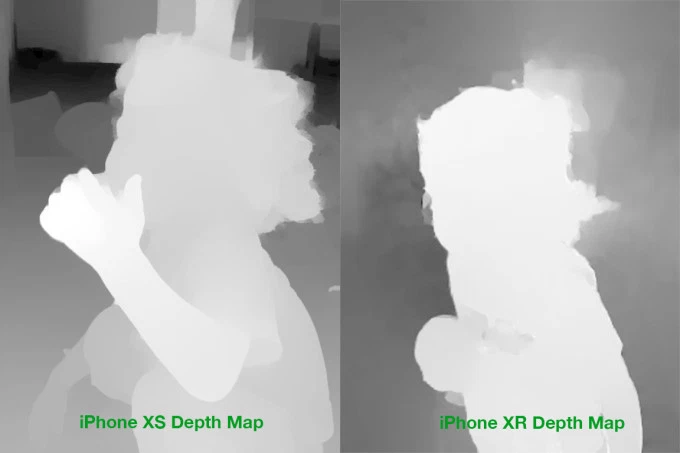

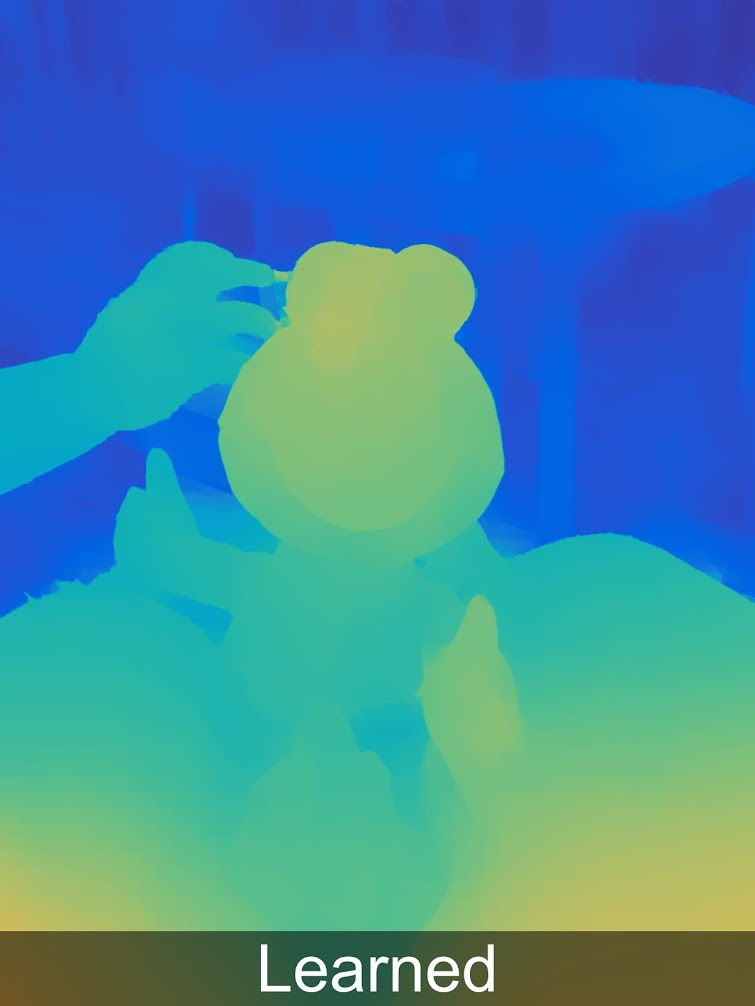

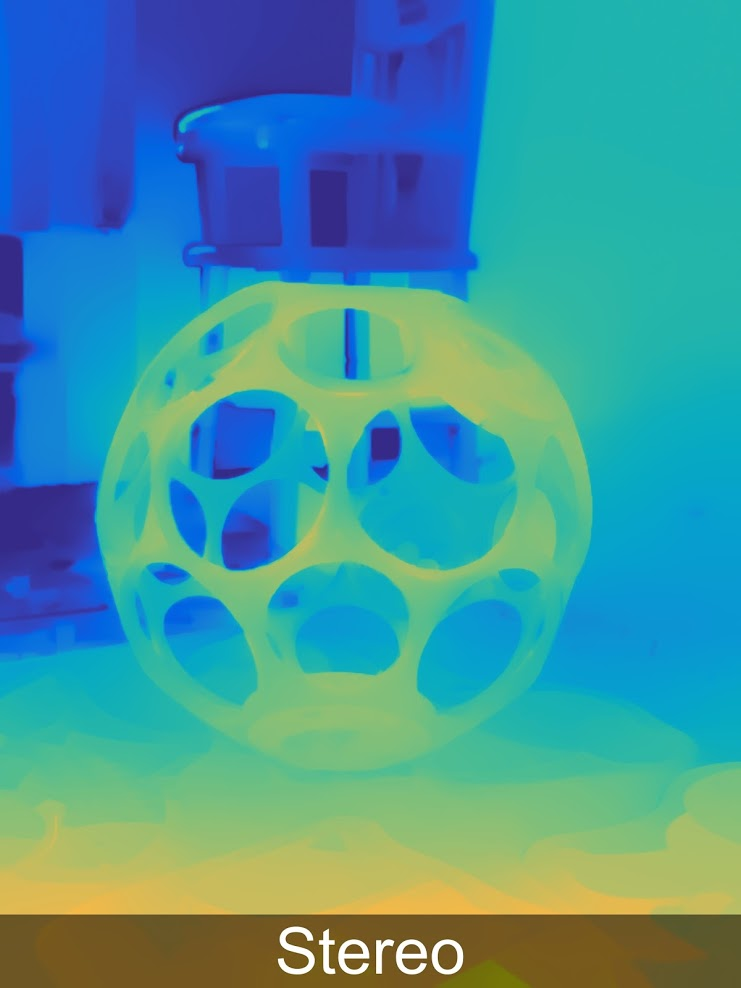

Et puis il s'avère que tout n'est pas si simple. Afin d'utiliser de manière significative des caméras supplémentaires pour améliorer l'image (et non pas simplement passer à une caméra avec un objectif différent), nous sommes obligés de construire une carte dite de disparité, qui est directement convertie en carte de profondeur. Et c'est une tâche très simple, à la solution de laquelle vient la puissance des smartphones. Et même maintenant, les cartes de profondeur sont souvent de qualité plutôt douteuse. Autrement dit, avant que la correspondance exacte "pixel sur l'image de droite au pixel sur la gauche" ait encore besoin de survivre. Par exemple, voici de vrais exemples de cartes de profondeur pour l'iPhone:

Source: comparaison de cartes de profondeur iPhone XS et XR

Source: comparaison de cartes de profondeur iPhone XS et XRMême à l'oeil, des problèmes de masse sont clairement visibles en arrière-plan, aux bordures, je me tais sur les cheveux

translucides . Par conséquent, de nombreux problèmes surviennent à la fois lors du transfert de couleur d'un appareil photo noir et blanc vers un appareil photo couleur et lors d'un traitement ultérieur.

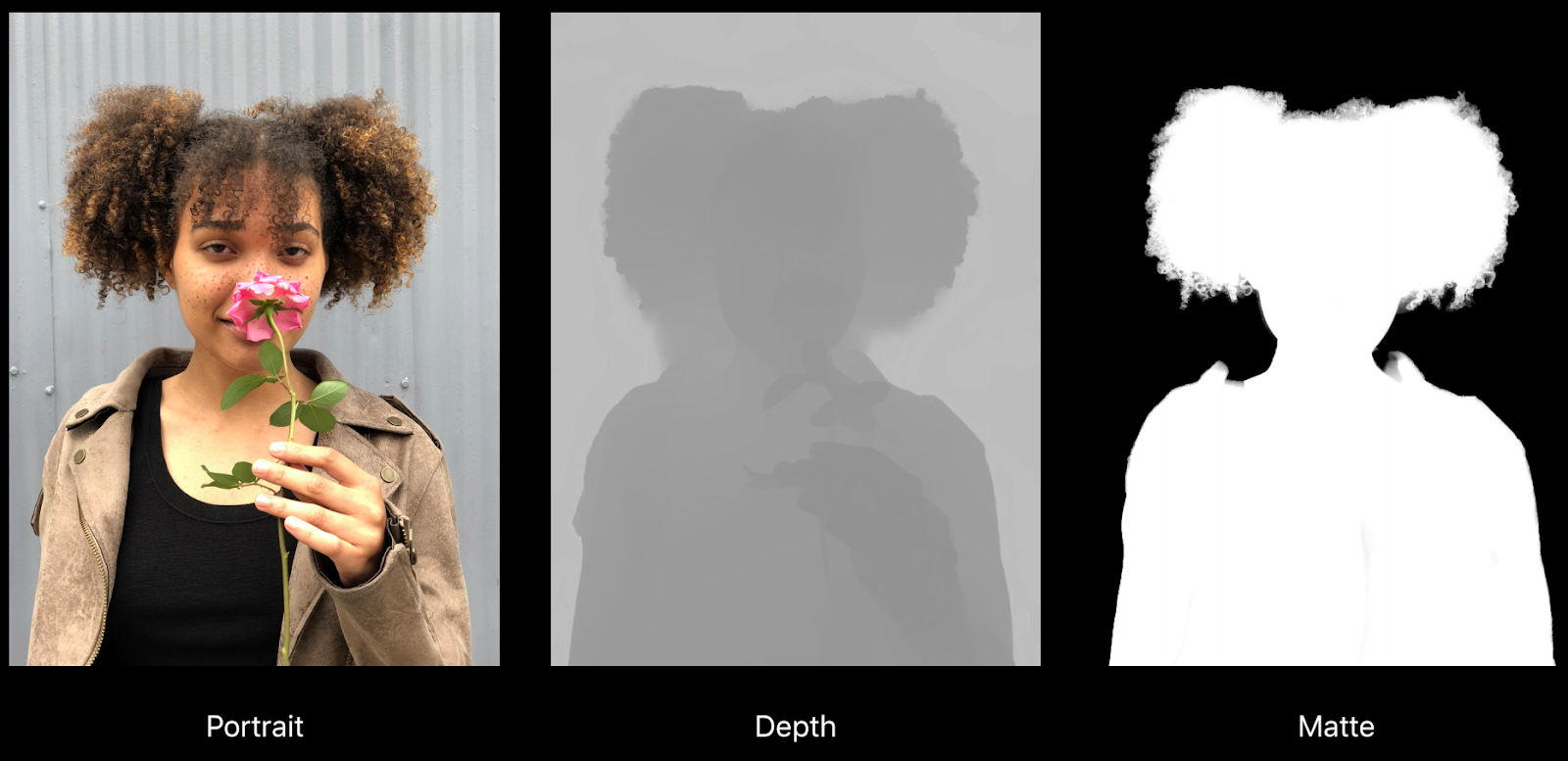

Par exemple, voici un assez bon exemple tiré d'un rapport sur «Créer des effets photo et vidéo en utilisant la profondeur» d'Apple:

Source: Création d'effets photo et vidéo • Utilisation de Depth, Apple, WWDC18

Source: Création d'effets photo et vidéo • Utilisation de Depth, Apple, WWDC18Vous pouvez clairement voir comment la profondeur est buggée sous les cheveux, et en effet sur un fond plus ou moins uniforme, mais plus important encore, sur la carte de tapis de droite, le collier est allé en arrière-plan (c'est-à-dire qu'il sera flou). Un autre problème est la résolution réelle de la profondeur et la carte des nattes est nettement inférieure à la résolution de l'image, ce qui affecte également la qualité pendant le traitement:

Cependant, tout cela est un problème de croissance. S'il n'y a pas 4 ans, il n'était pas question d'effets graves sur la vidéo, le téléphone «ne les a tout simplement pas tirés», mais aujourd'hui le traitement vidéo en profondeur se montre sur les meilleurs téléphones série (c'était dans la même présentation par Apple):

Source: Création d'effets photo et vidéo • Utilisation de Depth, Apple, WWDC18

Source: Création d'effets photo et vidéo • Utilisation de Depth, Apple, WWDC18En général, le sujet des téléphones multi-multi-cellulaires et, par conséquent, le sujet de la profondeur de la stéréo sur les téléphones mobiles - conquiert les masses sans se battre:

Source: "trouvé sur ceux de votre internet"

Source: "trouvé sur ceux de votre internet"Constatations clés:

- Profondeur de la stéréo - en termes de coût d'équipement - le moyen le moins cher d'obtenir de la profondeur, car les caméras sont désormais peu coûteuses et continuent de devenir moins chères rapidement. La difficulté est que le traitement ultérieur est beaucoup plus gourmand en ressources que pour les autres méthodes.

- Sur les téléphones portables, vous ne pouvez pas augmenter le diamètre de l'objectif, tandis que la résolution augmente rapidement. Par conséquent, l'utilisation de deux appareils photo ou plus peut améliorer considérablement la qualité de la photo, réduire le bruit dans des conditions de faible luminosité et augmenter la résolution. Depuis aujourd'hui, un téléphone mobile est souvent choisi pour la qualité de l'appareil photo, c'est un plus extrêmement tangible. Construire une carte de profondeur est un bonus latéral discret.

- Les principaux inconvénients de la profondeur de construction à partir de la stéréo:

- Dès que la texture disparaît ou devient simplement moins contrastée, le bruit augmente fortement en profondeur, de ce fait, même sur des objets simples, la profondeur est souvent mal utilisée (de graves erreurs sont possibles).

- De plus, la profondeur est mal déterminée sur des objets fins et de petite taille (doigts "coupés", voire mains, colonnes coulées, etc.)

- Dès que la puissance du fer vous permettra de créer une carte de profondeur pour la vidéo, la profondeur sur les smartphones donnera une impulsion puissante au développement de la RA (à un moment donné, de manière complètement inattendue pour le public, la qualité des applications de RA sur tous les nouveaux modèles de téléphones, y compris les modèles économiques, deviendra soudainement sensiblement plus élevée et une nouvelle vague ira) . Totalement inattendu!

La méthode suivante est moins triviale et célèbre, mais très cool. Rencontrez-moi!

Méthode 4: caméras de profondeur de champ lumineux

Le sujet de la plénoptique (du latin plénus - plein et optikos - visuel) ou des champs lumineux est encore relativement mal connu des masses, bien que les professionnels aient commencé à l'étudier de manière très dense. Des sections distinctes ont été attribuées aux articles sur Light Field lors de nombreuses conférences de haut niveau (l'auteur a déjà été frappé par le nombre de chercheurs asiatiques à la Conférence internationale de l'IEEE sur le multimédia et l'Expo qui sont étroitement impliqués dans ce sujet).

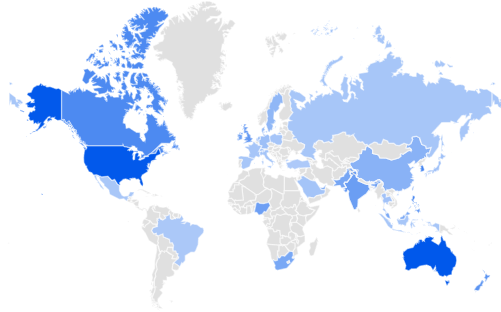

Google Trends indique que les États-Unis et l'Australie dominent l'intérêt pour Light Field, suivis de Singapour et de la Corée. Grande-Bretagne La Russie est à la 32ème place ... Nous corrigerons l'arriéré de l'Inde et de l'Afrique du Sud:

Source: Google Trends

Source: Google TrendsIl y a quelque temps, votre humble serviteur a rédigé un

article détaillé sur Habré, avec une description détaillée de son fonctionnement et de ses avantages. Passons donc brièvement en revue.

L'idée principale est d'essayer de fixer à chaque point non seulement la lumière, mais un réseau bidimensionnel de rayons lumineux, ce qui rend chaque trame en quatre dimensions. En pratique, cela se fait à l'aide d'un réseau de microlentilles:

Source: plenoptic.inf® (recommandé de cliquer et de voir en pleine résolution)

Source: plenoptic.inf® (recommandé de cliquer et de voir en pleine résolution)En conséquence, nous avons

beaucoup de nouvelles opportunités , mais la résolution tombe sérieusement. Après avoir résolu de nombreux problèmes techniques complexes, ils ont radicalement augmenté la résolution de

Lytro (acheté par Google), où dans Lytro Cinema, la résolution du capteur de la caméra a été augmentée à 755 mégapixels de données RAW, et elle semblait volumineuse comme les premières caméras:

Source: NAB: dévoilement d'une nouvelle caméra Lytro à champ lumineux qui pourrait apporter de grands changements au travail des effets visuels

Source: NAB: dévoilement d'une nouvelle caméra Lytro à champ lumineux qui pourrait apporter de grands changements au travail des effets visuelsIl est intéressant de noter que même les professionnels évaluent régulièrement de manière incorrecte la baisse de résolution des caméras plénoptiques, car ils sous-estiment leur capacité à travailler sur

des algorithmes de

super résolution qui restaurent vraiment parfaitement de nombreux détails des micro-décalages de l'image dans le champ lumineux (faites attention aux aiguilles à tricoter floues et aux mouvements de balançoires en arrière-plan) :

Source: Restauration de cadre plénoptique naïf, intelligent et super résolution d' après le rapport technique d'Adobe «Superrésolution avec caméra Plenoptic 2.0»

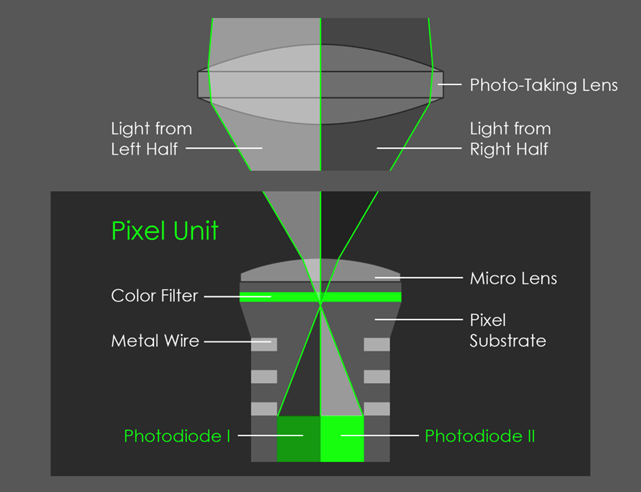

Source: Restauration de cadre plénoptique naïf, intelligent et super résolution d' après le rapport technique d'Adobe «Superrésolution avec caméra Plenoptic 2.0»Tout cela serait d'un intérêt relativement théorique si Google ne mettait pas en œuvre la plénoptique dans Pixel 2 en

couvrant avec une lentille 2 pixels :

Source: AI Google Blog

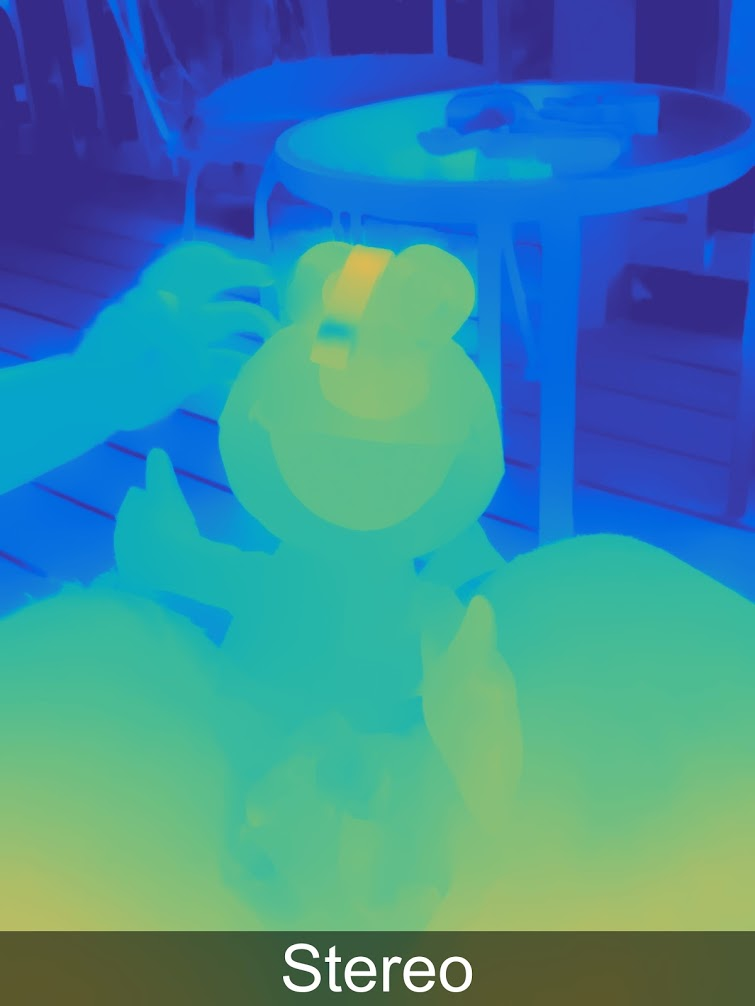

Source: AI Google BlogEn conséquence, une micro-paire stéréoscopique a été formée, ce qui a permis de MESURER la profondeur à laquelle Google, fidèle aux nouvelles traditions, a ajouté des réseaux de neurones, et il s'est avéré généralement remarquablement:

Plus d'exemples de profondeur en pleine résolution

dans une galerie spéciale .

Fait intéressant, la profondeur est stockée par Google (comme Huawei et d'autres) dans l'image elle-même, vous pouvez donc l'extraire de là et voir:

Source: Trois fonctionnalités secrètes de la nouvelle application appareil photo de Google qui vous épateront

Source: Trois fonctionnalités secrètes de la nouvelle application appareil photo de Google qui vous épaterontEt puis vous pouvez transformer la photo en trois dimensions:

Source: Trois fonctionnalités secrètes de la nouvelle application appareil photo de Google qui vous épateront

Source: Trois fonctionnalités secrètes de la nouvelle application appareil photo de Google qui vous épaterontVous pouvez l'expérimenter indépendamment sur le site

http://depthy.me , où vous pouvez télécharger votre photo. Fait intéressant, le site

est disponible en source , c'est-à-dire le traitement en profondeur peut être amélioré, il existe de nombreuses possibilités pour cela, maintenant les algorithmes de traitement les plus simples y sont appliqués.

Points clés:

- Lors d'une des conférences de Google, il a été annoncé que, peut-être, 4 pixels seraient recouverts d'un objectif. Cela réduira la résolution directe du capteur, mais améliorera considérablement la carte de profondeur. Premièrement, en raison de l'apparition de paires stéréoscopiques dans deux directions perpendiculaires, et deuxièmement, en raison du fait que la base stéréo augmentera conditionnellement de 1,4 fois (deux diagonales). Cela signifie également une nette amélioration de la précision de la profondeur à distance.

- La Plénoptique elle-même (c'est aussi une photographie calculée) permet de:

- Changer honnêtement la mise au point et la profondeur de champ après la prise de vue est la meilleure capacité connue des capteurs plénoptiques.

- Calculez la forme de l'ouverture.

- Calculez l'éclairage de la scène.

- Décalez un peu le point de prise de vue, y compris la réception stéréo (ou image multi-angle) avec un objectif.

- Calculez la résolution, car en utilisant la grande complexité de calcul des algorithmes de Super Résolution, vous pouvez réellement restaurer la trame.

- Calculez une carte de transparence pour les bordures translucides.

- Et enfin, construisez une carte de profondeur, ce qui est important aujourd'hui.

- Potentiellement, lorsque l'appareil photo principal du téléphone peut construire une carte de profondeur de haute qualité en temps réel en parallèle avec la prise de vue, cela va créer une révolution . Cela dépend en grande partie de la puissance de calcul à bord (c'est ce qui nous empêche de faire des cartes de profondeur de résolution meilleure et plus élevée en temps réel aujourd'hui). C'est très intéressant pour AR, bien sûr, mais il y aura de nombreuses opportunités de changer les photos.

Et enfin, nous passons au dernier dans cette méthode d'examen de la mesure de la profondeur.

Méthode 5: caméras sur les technologies lidar

En général,

les télémètres laser sont fermement ancrés dans nos vies, sont peu coûteux et offrent une grande précision. Les premiers lidars (de LIDaR -

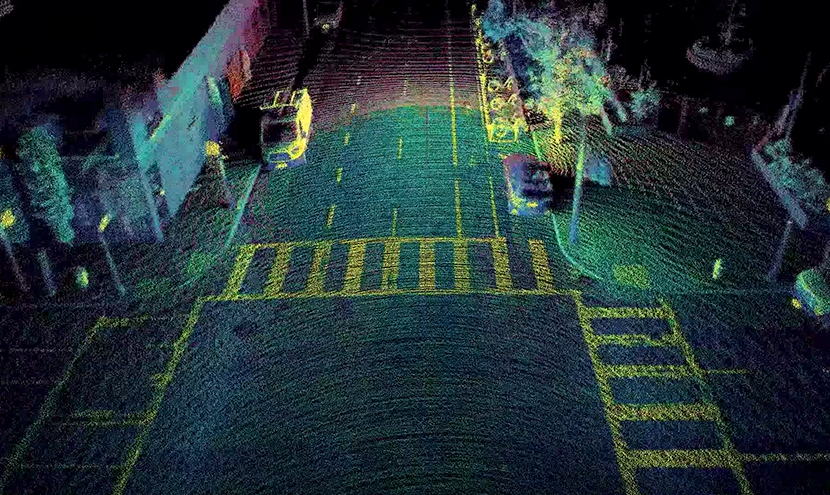

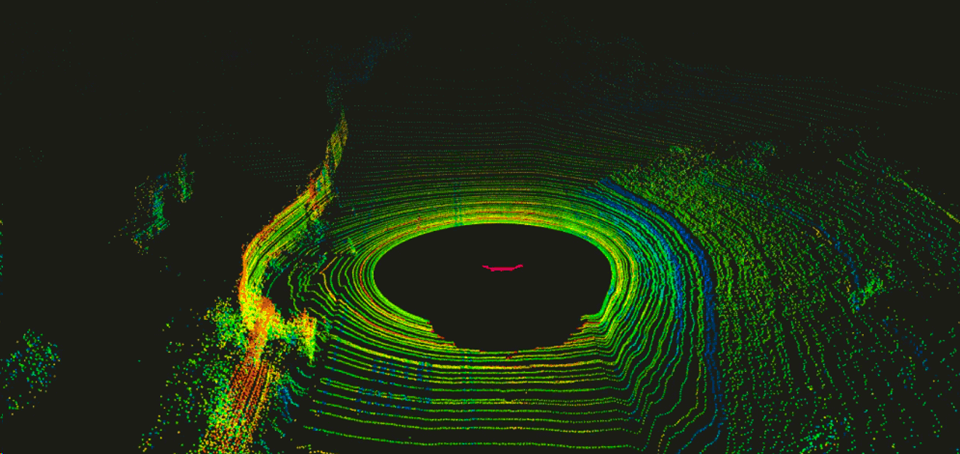

Light Identification Detection and Ranging ), construits sous forme de faisceaux d'appareils similaires tournant autour d'un axe horizontal, ont d'abord été utilisés par les militaires, puis testés dans des pilotes automatiques de voitures. Ils se sont avérés assez bons là-bas, ce qui a provoqué une forte poussée des investissements dans la région. Initialement, les lidars tournaient, donnant une image similaire plusieurs fois par seconde:

Source: Une introduction au LIDAR: le principal capteur de voiture autonome

Source: Une introduction au LIDAR: le principal capteur de voiture autonomeC'était inconfortable, peu fiable en raison des pièces mobiles et assez cher.

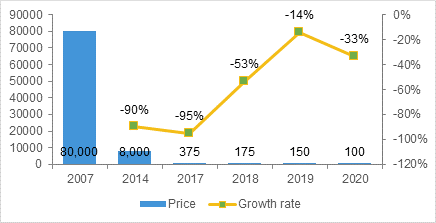

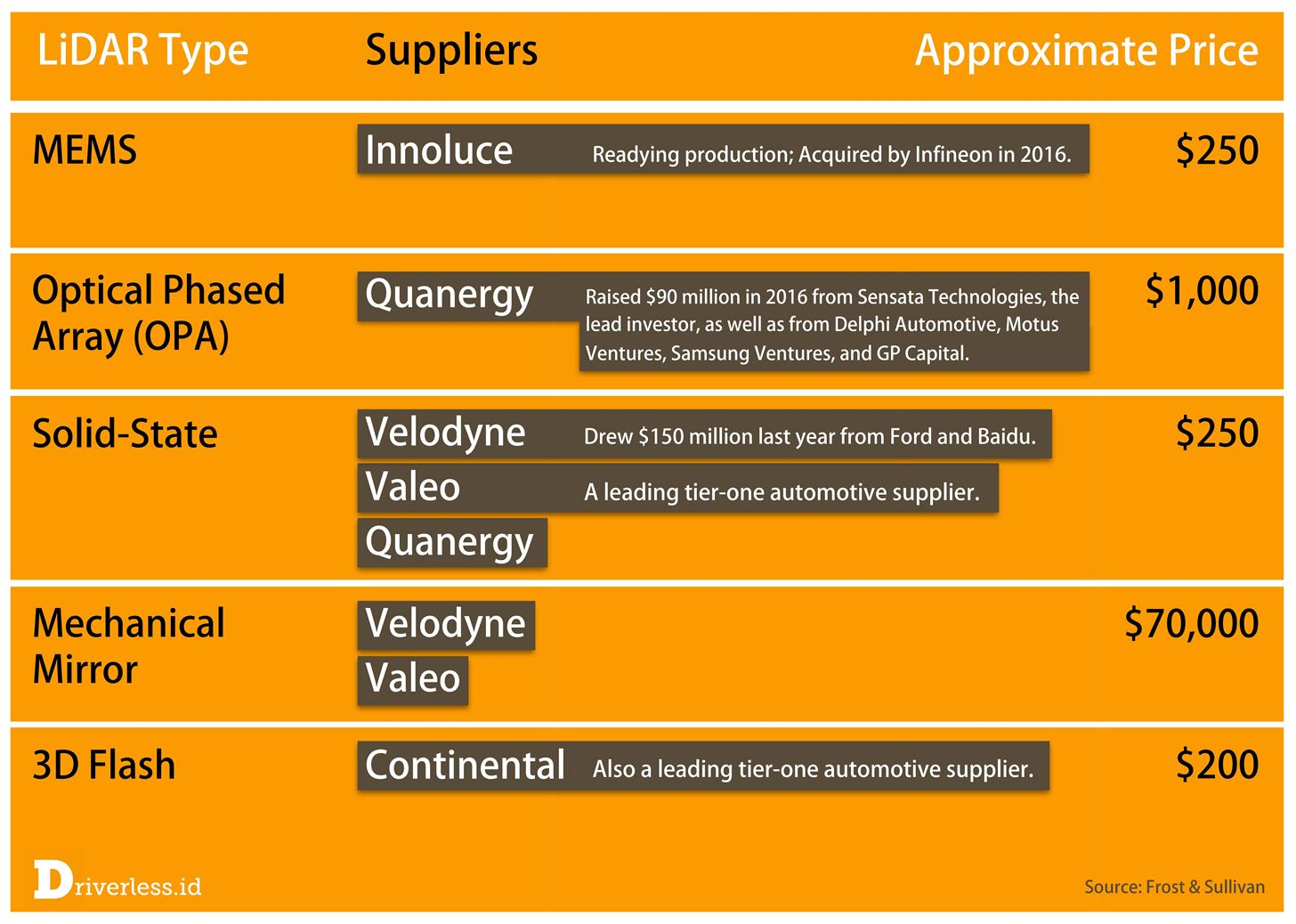

Tony Ceba dans ses conférences fournit des données intéressantes sur le taux de diminution du coût des lidars. Si les lidars coûtent 70 000 $ pour les premières machines autonomes de Google (par exemple, le

HDL-64E spécialisé utilisé sur les premières machines coûte 75 milliers):

Source: ceci et le suivant Du stationnement aux parcs - Bellevue et la perturbation des transports

Source: ceci et le suivant Du stationnement aux parcs - Bellevue et la perturbation des transportsPuis, en production de masse, de nouveaux modèles des prochaines générations menacent de baisser le prix de manière nettement inférieure à 1000 $:

On peut argumenter sur l'exemple de Tony (la promesse d'une startup n'est pas le coût final), mais qu'il y a un boom de la recherche dans ce domaine, l'augmentation rapide des cycles de production, l'apparition de produits complètement nouveaux et une baisse générale des prix sont incontestables. Un peu plus tard en 2017, la prévision d'une baisse des prix était la suivante (et le moment de vérité viendra où ils seront massivement mis dans les voitures):

Source: LiDAR achève la détection du triumvirat

Source: LiDAR achève la détection du triumviratEn particulier, relativement récemment, plusieurs fabricants ont immédiatement lancé le soi-disant

Lidar à semi-conducteurs , qui n'a fondamentalement pas de pièces mobiles qui montrent une fiabilité radicalement plus élevée, en particulier lors des secousses,

des coûts inférieurs , etc. Je recommande de regarder cette vidéo, où leur appareil est expliqué en 84 secondes très clairement:

Source: Capteur Lidar à semi-conducteursCe qui est important pour nous, c'est que le Solid State Lidar donne une image rectangulaire, c'est-à-dire en fait, il commence à fonctionner comme une caméra de profondeur «normale»:

Source: Innoviz envisage des voitures autonomes produites en série avec LiDAR à semi-conducteurs

Source: Innoviz envisage des voitures autonomes produites en série avec LiDAR à semi-conducteursL'exemple ci-dessus donne une vidéo d'environ 1024x256, 25 FPS, 12 bits par composant. Ces lidars seront montés sous la grille de la hotte (car l'appareil chauffe bien):

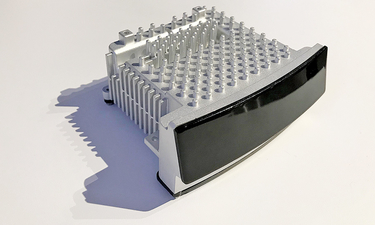

Source: Electronique LiDAR Magna à semi-conducteurs

Source: Electronique LiDAR Magna à semi-conducteursComme d'habitude, les Chinois sont éclairés, qui occupent désormais la première place mondiale dans la production de véhicules électriques et qui visent clairement la première place mondiale dans les voitures autonomes:

Source: Alibaba, RoboSense lance un véhicule sans pilote à l'aide d'un LIDAR à semi-conducteurs

Source: Alibaba, RoboSense lance un véhicule sans pilote à l'aide d'un LIDAR à semi-conducteursEn particulier, leurs expériences avec un «pixel» de profondeur non carré sont intéressantes, si vous effectuez un traitement conjoint avec une caméra RVB, vous pouvez augmenter la résolution et c'est un compromis plutôt intéressant (le «carré» de pixels n'est important, en fait, que pour une personne):

Source: MEMS Lidar for Driverless Vehicles franchit une nouvelle étape

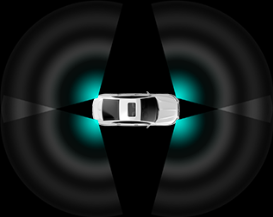

Source: MEMS Lidar for Driverless Vehicles franchit une nouvelle étapeLes lidars sont montés selon différents schémas en fonction du coût du kit et de la puissance du système embarqué, qui devra traiter toutes ces données. En conséquence, les caractéristiques générales du pilote automatique changent également. En conséquence, les voitures plus chères seront mieux portées par des routes poussiéreuses et plus faciles à «esquiver» les voitures entrant dans les voitures aux intersections sur le côté, les voitures bon marché ne feront que contribuer à réduire le nombre (nombreux) d'embouteillages stupides:

Source: Description RoboSense RS-LiDAR-M1

Source: Description RoboSense RS-LiDAR-M1Notez qu'en plus des prix bas pour les semi-conducteurs, il y a encore quelques domaines dans lesquels les lidars se développent. Prédire quelque chose ici est une tâche ingrate, car trop dépendra non pas des caractéristiques d'ingénierie potentielles de la technologie, mais, par exemple, des brevets. C'est juste que plusieurs entreprises sont déjà engagées dans le Solid-State, donc le sujet semble le plus prometteur. Mais ne rien dire du reste serait injuste:

Source: Ce goulot d'étranglement LiDAR 2017 provoque une ruée vers l'or moderne

Source: Ce goulot d'étranglement LiDAR 2017 provoque une ruée vers l'or moderneSi nous parlons de lidars en tant que caméras, il convient de mentionner une autre caractéristique importante qui est importante lors de l'utilisation de lidars à semi-conducteurs.

Ils agissent en soi que les appareils photo oublie la porte en cours d' exécution qui fait des sujets en mouvement de distorsion perceptible: Source: Quelle est la différence du global (global) volet de voyage (roulant)Étant donné que sur la route, en particulier sur l'autoroute à 150 km / h, tout change assez rapidement, cette caractéristique des lidars va déformer considérablement les objets, y compris ceux qui volent rapidement vers nous ... Y compris en profondeur ... Notez que les deux méthodes précédentes pour obtenir la profondeur n'ont pas un tel problème.

Source: Quelle est la différence du global (global) volet de voyage (roulant)Étant donné que sur la route, en particulier sur l'autoroute à 150 km / h, tout change assez rapidement, cette caractéristique des lidars va déformer considérablement les objets, y compris ceux qui volent rapidement vers nous ... Y compris en profondeur ... Notez que les deux méthodes précédentes pour obtenir la profondeur n'ont pas un tel problème. Source: belle animation Wikipédia montrant la distorsion de la voitureCette fonctionnalité, couplée à un FPS faible, nécessite l'adaptation d'algorithmes de traitement, mais dans tous les cas, en raison de leur grande précision, y compris sur de grandes distances, les lidars n'ont pas de concurrents particuliers.Fait intéressant, de par leur nature, les lidars fonctionnent très bien sur les surfaces planes et pire sur les bordures, et les capteurs stéréo sont mauvais sur les surfaces planes et relativement bons sur les bordures. De plus, les lidars donnent un FPS relativement petit et les caméras sont beaucoup plus grandes. En conséquence, ils se complètent essentiellement, ce qui a également été utilisé dans les appareils photo Lytro Cinema (sur la photo près de l'appareil photo, il y a un objectif plénoptique éclairé donnant jusqu'à 300 FPS, et le carré noir de

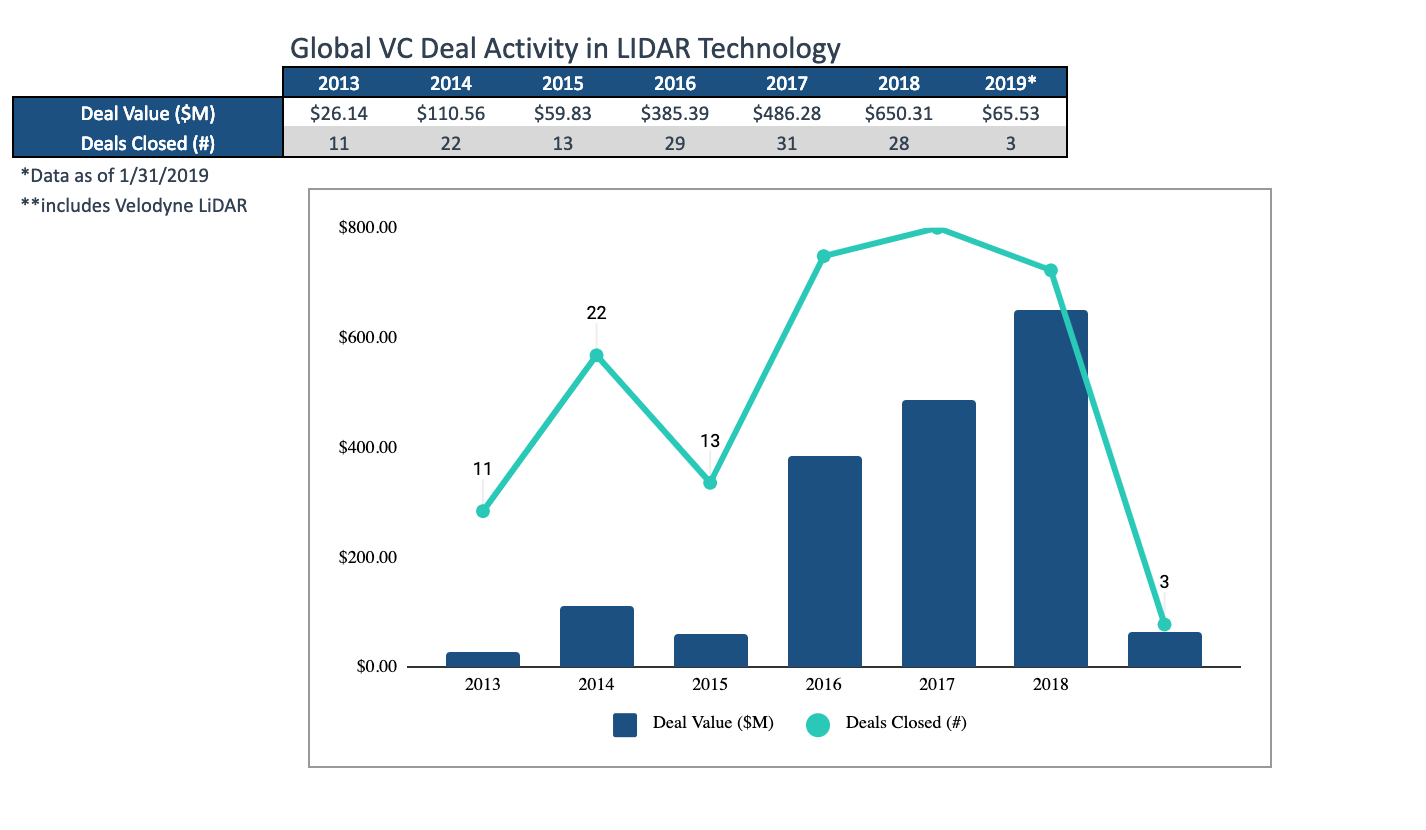

Source: belle animation Wikipédia montrant la distorsion de la voitureCette fonctionnalité, couplée à un FPS faible, nécessite l'adaptation d'algorithmes de traitement, mais dans tous les cas, en raison de leur grande précision, y compris sur de grandes distances, les lidars n'ont pas de concurrents particuliers.Fait intéressant, de par leur nature, les lidars fonctionnent très bien sur les surfaces planes et pire sur les bordures, et les capteurs stéréo sont mauvais sur les surfaces planes et relativement bons sur les bordures. De plus, les lidars donnent un FPS relativement petit et les caméras sont beaucoup plus grandes. En conséquence, ils se complètent essentiellement, ce qui a également été utilisé dans les appareils photo Lytro Cinema (sur la photo près de l'appareil photo, il y a un objectif plénoptique éclairé donnant jusqu'à 300 FPS, et le carré noir de Malevich Lidar ci-dessous ): Source: Lytro prêt à changer à jamais le cinéma : lancement d'un prototype de cinéma et d'un court métrage au NABSi deux capteurs de profondeur étaient combinés dans une caméra, puis dans d'autres appareils (des smartphones aux voitures), la distribution de masse des capteurs hybrides devrait garantir une qualité maximale.Dans un sens, les lidars sont toujours des investissements qui, au cours des trois dernières années, se sont élevés à environ 1,5 milliard de dollars (heureusement, ce marché est estimé à 10 milliards en 6 ans et le graphique ci-dessous montre comment la taille moyenne des transactions a augmenté):

Source: Lytro prêt à changer à jamais le cinéma : lancement d'un prototype de cinéma et d'un court métrage au NABSi deux capteurs de profondeur étaient combinés dans une caméra, puis dans d'autres appareils (des smartphones aux voitures), la distribution de masse des capteurs hybrides devrait garantir une qualité maximale.Dans un sens, les lidars sont toujours des investissements qui, au cours des trois dernières années, se sont élevés à environ 1,5 milliard de dollars (heureusement, ce marché est estimé à 10 milliards en 6 ans et le graphique ci-dessous montre comment la taille moyenne des transactions a augmenté): Source: Intéressant Revue des tendances du marché du lidar en mars par TechcrunchLe cycle de développement d'un produit innovant, même sur des marchés très compétitifs, est de 1,5 à 2 ans, nous verrons donc bientôt des produits extrêmement intéressants. Ils existent déjà en tant que prototypes.Points clés:

Source: Intéressant Revue des tendances du marché du lidar en mars par TechcrunchLe cycle de développement d'un produit innovant, même sur des marchés très compétitifs, est de 1,5 à 2 ans, nous verrons donc bientôt des produits extrêmement intéressants. Ils existent déjà en tant que prototypes.Points clés:- Avantages des lidars:

- la plus grande précision, y compris la meilleure parmi toutes les méthodes à longue distance,

- fonctionne mieux sur des surfaces planes sur la chaîne stéréo ne fonctionne plus,

- ne brillent presque pas avec le soleil,

- Inconvénients des lidars:

- consommation d'énergie élevée

- fréquence d'images relativement faible

- le volet roulant et la nécessité de le compenser lors du traitement,

- les lidars voisins interfèrent les uns avec les autres, ce qui n'est pas si facile à compenser.

- Néanmoins, nous assistons à l'apparition, littéralement en 2 ans, essentiellement d'un nouveau type de caméras de profondeur avec d'excellentes perspectives et un énorme marché potentiel. Dans les années à venir, on peut s'attendre à une baisse sérieuse des prix, avec notamment l'apparition de petits lidars universels pour robots industriels.

Traitement vidéo avec profondeur

En résumé, demandez-vous pourquoi la profondeur n'est pas si facile à manipuler.

Vous trouverez ci-dessous un exemple de données brutes détaillées d'une très bonne gamme de

caméras Intel RealSense . Sur les doigts de cette vidéo, vous pouvez relativement facilement évaluer «à l'œil nu» le fonctionnement de la caméra et les algorithmes de traitement:

Source: ci-après - les documents de l'auteur

Source: ci-après - les documents de l'auteurLes problèmes typiques des caméras de profondeur sont clairement visibles:

- Les données sont instables en valeur, les pixels «bruit» en profondeur.

- Le long des frontières sur une assez grande largeur, les données sont également très bruyantes (pour cette raison même, les valeurs de profondeur le long des frontières masquent souvent simplement pour ne pas interférer avec le travail).

- Autour de la tête, vous pouvez voir beaucoup de pixels «marchant» (apparemment, la proximité du mur à l'arrière + les cheveux commence à influencer).

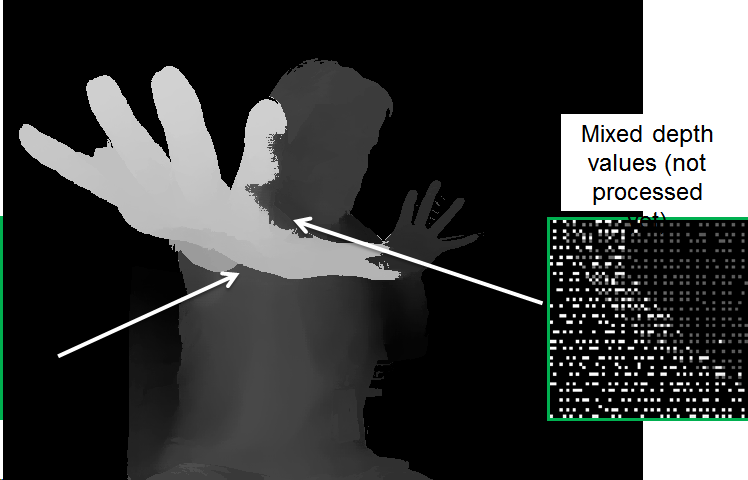

Mais ce n'est pas tout. Si nous regardons les données de plus près, il est clair que, dans certains endroits, les données plus profondes «transparaissent» les plus proches:

En effet, pour la commodité du traitement, l'image est réduite à l'image de la caméra RVB, et comme les limites ne sont pas déterminées avec précision, il devient nécessaire de traiter spécialement ces «chevauchements», sinon des problèmes surviennent, tels que de tels «trous» en profondeur sur le bras:

Lors du traitement, il y a beaucoup de problèmes, par exemple:

- "Fuite" de profondeur d'un objet à un autre.

- Instabilité de la profondeur dans le temps.

- Aliasing (formation d'une "échelle"), lorsque la suppression du bruit en profondeur conduit à une discrétisation des valeurs de profondeur:

Néanmoins, il est clair que l'image s'est considérablement améliorée. Notez que des algorithmes plus lents peuvent encore améliorer considérablement la qualité.

En général,

le traitement vidéo en profondeur est un vaste sujet distinct qui, jusqu'à présent, ne concerne pas tant de personnes, mais qui gagne rapidement en popularité. Le marché précédent, qu'elle a complètement changé - est la conversion de films de 2D en 3D. Le résultat de la construction manuelle de la stéréo à partir de la vidéo 2D s'est amélioré si rapidement, a montré un résultat beaucoup plus prévisible, a causé tellement moins de maux de tête et moins de coûts qu'au cinéma 3D, après presque 100 ans de tournage (!), Assez rapidement, ils ont arrêté de filmer presque complètement et n'ont commencé à convertir . Il y avait même une spécialité distincte - l'

artiste en profondeur , et les

stéréographes de la vieille école étaient sous le choc («ka-ak-a-ak?»). Et le rôle clé dans cette révolution a été joué par l'amélioration rapide des algorithmes de traitement vidéo. Peut-être qu'un jour, je trouverai le temps d'écrire à ce sujet une série distincte d'articles, car mon matériel est en grande quantité.

À peu près la même chose peut être attendue dans un avenir proche pour les caméras de profondeur de robots, smartphones et voitures autonomes.

Réveille-toi! La révolution arrive!Au lieu d'une conclusion

Il y a quelques années, votre humble serviteur a introduit une comparaison de différentes approches pour obtenir une vidéo avec profondeur dans une seule plaque. En général, pendant cette période, la situation n'a pas changé. La séparation ici est plutôt arbitraire, car les fabricants sont bien conscients des inconvénients des technologies et essaient de les compenser (parfois avec beaucoup de succès). Néanmoins, en général, il peut être utilisé pour comparer différentes approches:

Source: documents de l'auteur

Source: documents de l'auteurPassons en revue la table:

- Par résolution, la profondeur de la stéréo est en tête, mais tout dépend beaucoup de la scène (si elle est monophonique, la chose est une pipe).

- En termes de précision , les lidars sont au-delà de la concurrence, la situation avec la plénoptique est d'ailleurs la pire.

- En raison de la complexité du traitement - seuls les ToF et les lidars obtiennent directement la «profondeur», obtenir la profondeur de la stéréo et de la plénoptique nécessite beaucoup de calculs très simples.

- Selon FPS, les caméras ToF sont structurellement bonnes et dans un avenir proche, lorsque le fer se redressera, elles seront rattrapées par des caméras stéréo (capables de fournir jusqu'à 300 images par seconde). Lidaram n'a pour l'instant que rêvé.

- Selon les résultats obtenus dans des conditions de faible luminosité, la stéréo et la plénoptique devraient perdre.

- Lorsque vous travaillez à l'extérieur - les caméras ToF et à lumière structurée ne fonctionnent pas bien.

Dans le même temps, il est important de bien comprendre la situation sur des marchés spécifiques. Par exemple, l'approche plénoptique semble clairement à la traîne. Cependant, s'il s'avère être le meilleur pour la RA (et cela deviendra clair dans les 3-4 prochaines années), alors il occupera la place qui lui revient dans

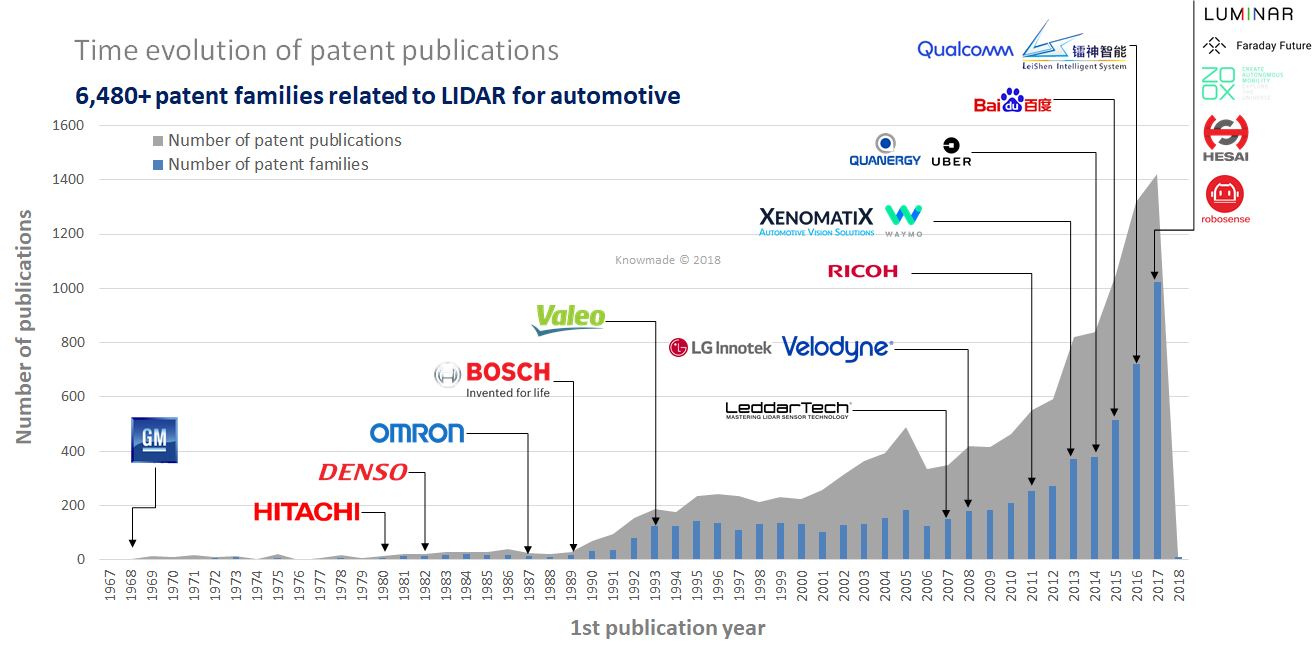

chaque téléphone et tablette. On voit également que les lidars à l'état solide sont les meilleurs (les plus «verts»), mais il s'agit de la technologie la plus récente, et ce sont leurs propres risques, principalement les brevets (dans le domaine, il existe un grand nombre de nouveaux brevets qui n'expireront pas bientôt):

Source: LiDAR: un aperçu du paysage des brevets

Source: LiDAR: un aperçu du paysage des brevetsNéanmoins, nous n'oublions pas - le marché des capteurs de profondeur pour smartphones est prévu à

6 milliards de dollars l'année prochaine

, et il ne peut être inférieur à 4, car il s'élevait à plus de 3 milliards l'an dernier. Il s'agit d'une énorme somme d'argent qui servira non seulement au retour sur investissement (aux investisseurs les plus prospères), mais aussi au développement de nouvelles générations de capteurs. Il n'y a pas encore de croissance similaire dans les lidars, mais selon toutes les indications, cela ira littéralement au cours des 3 prochaines années. Et puis il s'agit d'un processus exponentiel semblable à une avalanche, qui s'est déjà produit plus d'une fois.

L'avenir proche des caméras de profondeur semble extrêmement intéressant!

Carthage doit être brisée ... L' ensemble de la vidéo sera en trois dimensions d'ici la fin du siècle!Restez à l'écoute!

Qui n'a pas lu - la

première partie du texte !

RemerciementsJe remercie chaleureusement:

- Laboratoire d'infographie VMK Université d'État de Moscou MV Lomonosov pour sa contribution au développement de l'infographie en Russie et pas seulement

- Google, Apple et Intel pour d'excellentes solutions compactes, et tous les fabricants de lidar pour des progrès rapides,

- personnellement Konstantin Kozhemyakov, qui a fait beaucoup pour rendre cet article meilleur et plus visuel,

- et enfin, un grand merci à Roman Kazantsev, Eugene Lyapustin et Yegor Sklyarov pour un grand nombre de commentaires judicieux et de corrections qui ont rendu ce texte bien meilleur!