Bonjour à tous. Déjà ce mois-ci, un nouveau cours commence à OTUS - «Mathématiques pour la science des données» . En prévision du début de ce cours, nous partageons traditionnellement avec vous la traduction de matériel intéressant.

Annotation . L'apprentissage en profondeur est à l'avant-garde de la recherche sur l'apprentissage automatique (ML). Il se compose de plusieurs couches cachées de réseaux de neurones artificiels. La méthodologie d'apprentissage en profondeur utilise des transformations non linéaires et des abstractions de modèle de haut niveau sur de grandes bases de données. Les progrès récents dans la mise en œuvre d'une architecture d'apprentissage en profondeur dans de nombreux domaines ont déjà apporté une contribution significative au développement de l'intelligence artificielle. Cet article présente une étude moderne de la contribution et des nouvelles applications de l'apprentissage en profondeur. L'aperçu suivant, par ordre chronologique, présente comment et dans quelles applications les plus importantes les algorithmes d'apprentissage en profondeur ont été utilisés. En outre, les avantages et les avantages de la méthodologie d'apprentissage en profondeur sont présentés dans sa hiérarchie multicouche et ses opérations non linéaires, qui sont comparées à des algorithmes plus traditionnels dans des applications ordinaires. Un examen des progrès récents dans le domaine révèle en outre des concepts communs, les avantages et la popularité sans cesse croissants de l'apprentissage en profondeur.

1. Introduction

L'intelligence artificielle (IA) comme l'intelligence démontrée par les machines est une approche efficace pour comprendre l'apprentissage humain et la formation du raisonnement [1]. En 1950, le test de Turing a été proposé comme une explication satisfaisante de la façon dont un ordinateur peut reproduire le raisonnement cognitif d’une personne [2]. En tant que domaine de recherche, l'IA est divisée en sous-domaines plus spécifiques. Par exemple: le traitement automatique du langage naturel (NLP) [3] peut améliorer la qualité de l'écriture dans diverses applications [4.17]. L'unité la plus classique de la PNL est la traduction automatique, qui est comprise comme la traduction entre les langues. Les algorithmes de traduction automatique ont contribué à l'émergence de diverses applications qui prennent en compte la structure grammaticale et les fautes d'orthographe. De plus, l'ensemble des mots et du vocabulaire liés au sujet de la matière sont automatiquement utilisés comme source principale lorsque l'ordinateur suggère des changements pour l'auteur ou l'éditeur [5]. Dans la fig. La figure 1 montre en détail comment l'IA couvre sept domaines de l'informatique.

Récemment, l'apprentissage automatique et l'exploration de données ont été mis à l'honneur et sont devenus les sujets les plus populaires parmi la communauté des chercheurs. L'ensemble de ces axes de recherche analyse les nombreuses possibilités de caractérisation des bases de données [9]. Au fil des ans, des bases de données ont été compilées à des fins statistiques. Les courbes statistiques peuvent décrire le passé et le présent afin de prédire les futurs modèles de comportement. Cependant, au cours des dernières décennies, seules des méthodes et des algorithmes classiques ont été utilisés pour traiter ces données, tandis que l'optimisation de ces algorithmes pourrait constituer la base d'un auto-apprentissage efficace [19]. Un processus décisionnel amélioré peut être mis en œuvre sur la base des valeurs existantes, de plusieurs critères et de méthodes statistiques avancées. Ainsi, l'une des applications les plus importantes de cette optimisation est la médecine, où les symptômes, les causes et les décisions médicales créent de grandes bases de données qui peuvent être utilisées pour déterminer le meilleur traitement [11].

Fig. 1. Recherche dans le domaine de l'intelligence artificielle (IA) Source: [1].

Étant donné que le ML couvre un large éventail d'études, de nombreuses approches ont déjà été développées. Le clustering, le réseau bayésien, le deep learning et l'analyse de l'arbre de décision n'en sont que quelques-uns. La revue suivante se concentre principalement sur l'apprentissage en profondeur, ses concepts de base, ses applications éprouvées et modernes dans divers domaines. En outre, il présente plusieurs chiffres reflétant la croissance rapide des publications avec des recherches dans le domaine de l'apprentissage en profondeur ces dernières années dans les bases de données scientifiques.

2. La base théorique

Le concept d'apprentissage en profondeur (Deep Learning - DL) est apparu pour la première fois en 2006 comme un nouveau domaine de recherche en apprentissage automatique. Initialement, il était connu sous le nom d'apprentissage hiérarchique dans [2], et en règle générale, il comprenait de nombreux domaines de recherche liés à la reconnaissance des formes. Le deep learning prend principalement en compte deux facteurs clés: le traitement non linéaire en plusieurs couches ou étapes et la formation sous ou sans supervision [4]. Le traitement non linéaire dans plusieurs couches fait référence à un algorithme dans lequel la couche actuelle accepte la sortie de la couche précédente en entrée. Une hiérarchie est établie entre les couches pour ordonner l'importance des données dont l'utilité doit être établie. En revanche, l'apprentissage contrôlé et incontrôlé est associé à une étiquette de classes d'objectifs: sa présence implique un système contrôlé, et l'absence signifie incontrôlé.

3. Applications

L'apprentissage en profondeur implique des couches d'analyse abstraite et des méthodes hiérarchiques. Cependant, il peut être utilisé dans de nombreuses applications du monde réel. À titre d'exemple, dans le traitement d'image numérique; Les images en noir et blanc étaient auparavant peintes à la main par des utilisateurs qui devaient choisir chaque couleur en fonction de leur propre jugement. En appliquant l'algorithme d'apprentissage en profondeur, la coloration peut être effectuée automatiquement à l'aide d'un ordinateur [10]. De la même manière, le son peut être ajouté à une vidéo de lecture de batterie sans son à l'aide de réseaux de neurones récurrents (RNN), qui font partie des méthodes d'apprentissage en profondeur [18].

Le deep learning peut être présenté comme une méthode pour améliorer les résultats et optimiser le temps de traitement dans plusieurs processus de calcul. Dans le domaine du traitement du langage naturel, des méthodes d'apprentissage approfondi ont été appliquées pour créer des légendes d'images [20] et la génération de texte manuscrit [6]. Les applications suivantes sont classées plus en détail dans des domaines tels que l'imagerie numérique, la médecine et la biométrie.

3.1 Traitement d'image

Avant que l'apprentissage en profondeur ne soit officiellement établi en tant que nouvelle approche de recherche, certaines applications ont été mises en œuvre dans le cadre du concept de reconnaissance de formes via le traitement des couches. En 2003, un exemple intéressant a été développé en utilisant le filtrage des particules et l'algorithme de propagation de croyance bayésienne. Le concept de base de cette application estime qu'une personne peut reconnaître le visage d'une autre personne en n'observant que la moitié de l'image du visage [14], de sorte que l'ordinateur peut restaurer l'image du visage à partir de l'image recadrée.

Plus tard en 2006, l'algorithme gourmand et la hiérarchie ont été combinés en une application capable de traiter les chiffres manuscrits [7]. Des études récentes ont utilisé l'apprentissage en profondeur comme principal outil de traitement d'image numérique. Par exemple, l'utilisation de réseaux de neurones convolutifs (CNN) pour reconnaître l'iris peut être plus efficace que l'utilisation de capteurs conventionnels. L'efficacité du CNN peut atteindre une précision de 99,35% [16].

La reconnaissance de l'emplacement mobile permet actuellement à l'utilisateur de trouver une adresse spécifique en fonction de l'image. L'algorithme SSPDH (Supervised Semantics - Preserving Deep Hashing) s'est avéré être une amélioration significative par rapport à VHB (Visual Hash Bit) et SSFS (Space - Saliency Fingerprint Selection). La précision SSPDH est jusqu'à 70% plus efficace [15].

Enfin, une autre application remarquable dans le traitement d'image numérique utilisant la méthode d'apprentissage en profondeur est la reconnaissance faciale. Google, Facebook et Microsoft ont des modèles uniques de reconnaissance faciale avec apprentissage en profondeur [8]. Récemment, l'identification basée sur une image de visage est passée à la reconnaissance automatique en déterminant l'âge et le sexe comme paramètres initiaux. Sighthound Inc., par exemple, a testé un algorithme de réseau de neurones à convolution profonde qui peut reconnaître non seulement l'âge et le sexe, mais même les émotions [3]. De plus, un système fiable a été développé pour déterminer avec précision l'âge et le sexe d'une personne à partir d'une seule image en appliquant l'architecture de l'apprentissage multitâche approfondi [21].

3.2 Médecine

Le traitement d'image numérique est sans aucun doute une partie importante des domaines de recherche où l'apprentissage profond peut être appliqué. De la même manière, des applications cliniques ont récemment été testées. Par exemple, une comparaison entre l'apprentissage de bas niveau et l'apprentissage profond dans les réseaux de neurones a conduit à une meilleure efficacité dans la prévision des maladies. L'image obtenue par imagerie par résonance magnétique (IRM) [22] du cerveau humain a été traitée pour prédire une éventuelle maladie d'Alzheimer [3]. Malgré le succès rapide de cette procédure, certains problèmes devraient être sérieusement envisagés pour les applications futures. L'une des limites est la formation et la dépendance à l'égard de la haute qualité. Le volume, la qualité et la complexité des données sont des aspects complexes, cependant, l'intégration de types de données hétérogènes est un aspect potentiel de l'architecture d'apprentissage en profondeur [17, 23].

La tomographie par cohérence optique (OCT) est un autre exemple où les techniques d'apprentissage en profondeur montrent des résultats significatifs. Traditionnellement, les images sont traitées par développement manuel de matrices convolutives [12]. Malheureusement, le manque d'ensembles de formation limite la méthode d'apprentissage en profondeur. Néanmoins, au cours de plusieurs années, l'introduction de kits d'entraînement améliorés permettra de prédire efficacement les pathologies rétiniennes et de réduire le coût de la technologie PTOM [24].

3.3 Biométrie

En 2009, une application de reconnaissance automatique de la parole a été appliquée pour réduire la fréquence des erreurs téléphoniques (Phone Error Rate - PER) à l'aide de deux architectures de réseaux à confiance profonde [18]. En 2012, la méthode CNN [25] a été appliquée dans le cadre d'un réseau neuronal hybride - le modèle de Markov caché - NN - HMM. En conséquence, un PER de 20,07% a été atteint. Le PER résultant est meilleur par rapport à la méthode de référence du réseau neuronal à 3 couches précédemment utilisée [26]. Les smartphones et la résolution de leurs caméras ont été testés pour reconnaître l'iris. Lors de l'utilisation de téléphones portables développés par diverses sociétés, la précision de reconnaissance de l'iris peut atteindre jusqu'à 87% d'efficacité [22,28].

Du point de vue de la sécurité, notamment le contrôle d'accès; l'apprentissage en profondeur est utilisé conjointement avec les caractéristiques biométriques. DL a été utilisé pour accélérer le développement et l'optimisation des appareils de reconnaissance faciale FaceSentinel. Selon ce fabricant, leurs appareils peuvent étendre le processus d'identification de un à un à un à plusieurs en neuf mois [27]. Cette mise à niveau du moteur pourrait prendre 10 années-hommes sans l'introduction de DL. Ce qui a accéléré la production et le lancement des équipements. Ces appareils sont utilisés à l'aéroport de Londres Heathrow et peuvent également être utilisés pour enregistrer les heures de travail et la fréquentation, ainsi que dans le secteur bancaire [3, 29].

4. Présentation

Le tableau 1 résume plusieurs des applications qui ont été mises en œuvre au cours des années précédentes en ce qui concerne l'apprentissage en profondeur. La reconnaissance de la parole et le traitement d'image sont principalement mentionnés. Cette revue ne couvre que quelques-unes de la longue liste d'utilisations.

Tableau 1. Applications d'apprentissage approfondi, 2003-2017

( Application: 2003 - Inférence hiérarchique bayésienne dans le cortex visuel; 2006 - Classification des nombres; 2006 - Réseau de confiance profond pour la reconnaissance téléphonique; 2012 - Reconnaissance vocale de plusieurs sources; 2015 - Reconnaissance de l'iris à l'aide de caméras de smartphone; 2016 - Mastering Go deep réseaux de neurones de recherche d'arbres; 2017 - Modèle de reconnaissance sensorielle de l'iris).

4.1 Analyse des publications de l'année

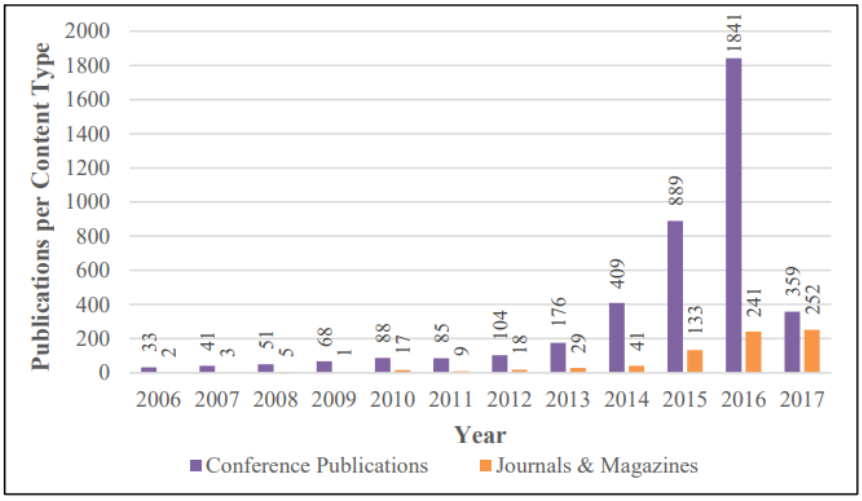

Dans la fig. La figure 1 montre le nombre de publications d'apprentissage approfondi de la base de données ScienceDirect par an de 2006 à juin 2017. De toute évidence, une augmentation progressive du nombre de publications pourrait décrire une croissance exponentielle.

Dans la fig. La figure 2 montre le nombre total de publications Springer sur l'apprentissage en profondeur par an de janvier 2006 à juin 2017. En 2016, il y a eu une augmentation soudaine des publications, atteignant 706 publications, ce qui prouve que le deep learning est en effet au centre de la recherche moderne.

Dans la fig. La figure 3 montre le nombre de publications lors de conférences, de magazines et de publications de l'IEEE de janvier 2006 à juin 2017. Il est à noter que depuis 2015, le nombre de publications a considérablement augmenté. La différence entre 2016 et 2015 représente plus de 200% de l'augmentation.

Fig. 1. L'augmentation du nombre de publications sur le deep learning dans la base de données Sciencirect (janvier 2006 - juin 2017)

Fig. 2. L'augmentation du nombre de publications sur l'apprentissage profond à partir de la base de données Springer. (Janvier 2006 - juin 2017)

Fig. 3. L'augmentation des publications d'apprentissage en profondeur de la base de données IEEE. (Janvier 2006 - juin 2017)

5. Conclusions

Le Deep Learning est une application en pleine croissance du Machine Learning. Les nombreuses applications décrites ci-dessus prouvent son développement rapide en quelques années seulement. L'utilisation de ces algorithmes dans différents domaines montre sa polyvalence. Une analyse des publications réalisées dans cette étude démontre clairement la pertinence de cette technologie et fournit une illustration claire de la croissance de l'apprentissage en profondeur et des tendances concernant la recherche future dans ce domaine.

En outre, il est important de noter que la hiérarchie des niveaux et le contrôle de l'apprentissage sont des facteurs clés dans le développement d'une application d'apprentissage en profondeur réussie. La hiérarchie est importante pour la bonne classification des données, tandis que le contrôle prend en compte l'importance de la base de données elle-même dans le cadre du processus. La valeur fondamentale de l'apprentissage en profondeur est d'optimiser les applications d'apprentissage automatique existantes grâce à un traitement hiérarchique innovant. L'apprentissage en profondeur peut fournir des résultats efficaces dans le traitement d'image numérique et la reconnaissance vocale. Une réduction du pourcentage d'erreurs (de 10 à 20%) confirme clairement l'amélioration par rapport aux méthodes existantes et éprouvées.

À cette époque et à l'avenir, l'apprentissage en profondeur peut être un outil de sécurité utile grâce à une combinaison de reconnaissance faciale et vocale. De plus, le traitement d'image numérique est un domaine de recherche qui peut être appliqué dans de nombreux autres domaines. Pour cette raison, et ayant prouvé une véritable optimisation, le deep learning est un sujet moderne et intéressant pour le développement de l'intelligence artificielle.

Littérature utilisée

- Abdel, O.: Application des concepts de réseaux de neurones convolutifs au modèle hybride NN-HMM pour la reconnaissance vocale. Acoustics, Speech and Signal Processing 7, 4277-4280 (2012).

- Mosavi A., Varkonyi-Koczy AR: Intégration de l'apprentissage automatique et optimisation pour l'apprentissage robotique. Advances in Intelligent Systems and Computing 519, 349-355 (2017).

- Bannister, A.: Biométrie et IA: comment FaceSentinel évolue 13 fois plus rapidement grâce au deep learning (2016).

- Bengio, Y.: Apprentissage des architectures profondes pour l'IA. Fondements et tendances de l'apprentissage automatique 2, 1-127 (2009).

- Mosavi, A., Varkonyi-Koczy, AR, Fullsack, M.: Combinaison d'apprentissage automatique et d'optimisation pour la prise de décision automatisée. MCDM (2015).

- Deng L, Yu D Deep learning: méthodes et applications. Fondements et tendances du traitement du signal 7, 197-387 (2014)

- Goel, B.: Développements dans le domaine du traitement du langage naturel. Journal international de recherche avancée en informatique 8, (2017).

- Vaezipour, A.: Mosavi, A. Seigerroth, U.: Machine learning integrated optimisation for decision making, 26e Conférence européenne sur la recherche opérationnelle, Rome (2013).

- Hinton GE, Simon O, Yee-Whye TA algorithme d'apprentissage rapide pour les réseaux de croyances profondes. Calcul neuronal 18, 1527-1554 (2006)

- Hisham, A., Harin, S.: Deep Learning - le nouveau né de l'intelligence artificielle. (2017)

- Kim IW, Oh, M.: Deep learning: de la chimio-informatique à la médecine de précision. Journal of Pharmaceutical Investigation: 1-7 (2017)

- Mosavi, A., Vaezipour, A.: Développement d'outils efficaces pour l'analyse prédictive et les décisions éclairées. Rapport technique. Université de Tallinn (2013)

- Mosavi A., Y., Bathla, Varkonyi-Koczy AR: Prédire l'avenir en utilisant le Web

Knowledge: State of the Art Survey Advances in Intelligent Systems and Computing (2017). - Mosavi, A., Vaezipour, A.: Optimisation de la recherche réactive; Application au multiobjectif

Problèmes d'optimisation. Mathématiques appliquées 3, 1572-1582 (2012) - Lee JG (2017) Deep Learning in Medical Imaging: General Overview. Journal coréen de

Radiologie 18 (4): 570-584 - Lee T.: David M Inférence hiérarchique bayésienne dans le cortex visuel. JOSA 20, 1434-1448

(2003). - Liu W Hachage d'apprentissage en profondeur pour la recherche visuelle mobile. Journal EURASIP sur l'image et

Traitement vidéo 17, (2017). - Marra F.: A Deep Learning Approach for Iris Sensor Model Identification. Pattern Recognition Letters (2017).

- Miotto R et al (2017) Deep learning for healthcare: review, opportunities and challenges.

Briefings in Bioinformatics - Mohamed A.: Deep belief networks for phone recognition. Nips workshop on deep learning

for speech recognition and related applications: 1, 635-645 (2009). - Moor. J.: The Turing test: the elusive standard of artificial intelligence. Springer Science &

Business Media (2003). - Vaezipour, A. Mosavi, U. Seigerroth, A.: Visual analytics and informed decisions in health

and life sciences, International CAE Conference, Verona, Italy (2013) - Raja KB, Raghavendra R, Vemuri VK, Busch C (2015) Smartphone based visible iris

recognition using deep sparse filtering. Pattern Recognition Letters 57:33-42. - Safdar S, Zafar S, Zafar N, Khan NF (2017) Machine learning based decision support systems (DSS) for heart disease diagnosis: a review. Artificial Intelligence Review: 1-17

- Mosavi, A. Varkonyi. A.: Learning in Robotics. Learning 157, (2017)

- Xing J, Li K, Hu W, Yuan C, Ling H et al (2017) Diagnosing deep learning models for high

accuracy age estimation from a single image. Pattern Recognition - Mosavi, A. Rabczuk, T.: Learning and Intelligent Optimization for Computational Materials

Design Innovation, Learning and Intelligent Optimization, Springer-Verlag, (2017) - Vaezipour, A., et al., Visual analytics for informed-decisions, International CAE Conference, Verona, Italy, (2013).

- Dehghan, A.: DAGER: Deep Age, Gender and Emotion Recognition Using Convolutional

Neural Network3, 735-748 (2017) - Mosavi, A: predictive decision model, 2015, https://doi.org/10.13140/RG.2.2.21094.630472

- Vaezipour, A., et al.: Visual analytics and informed decisions in health and life sciences."

Paper in Proceedings of International CAE Conference, Verona, Italy. (2013). - Vaezipour, A.: Visual analytics for informed-decisions, CAE Conference, Italy, (2013).

- A.Vaezipour, A.:Machine learning integrated optimization for decision making. 26th European Conference on Operational Research, Rome (2013).

- Vaezipour, A.: Visual Analytics for Multi-Criteria Decision Analysis, in Proceedings of International CAE Conference, Verona, Italy (2013).

- Mosavi, A., Vaezipour, A.: Developing Effective Tools for Predictive Analytics and Informed Decisions. Technical Report. (2013). https://doi.org/10.13140/RG.2.2.23902.84800

- Mosavi A., Varkonyi-Koczy AR: Integration of Machine Learning and Optimization for

Robot Learning. Advances in Intelligent Systems and Computing 519, 349-355 (2017). - Mosavi, A., Varkonyi, A.: Learning in Robotics. Learning, 157, (2017).

- Mosavi, A.: Decision-making software architecture; the visualization and data mining assisted approach. International Journal of Information and Computer Science 3, 12-26 (2014).

- Mosavi, A.: The large scale system of multiple criteria decision making; pre-processing,

Large Scale Complex Systems Theory and Applications 9, 354-359 (2010). - Esmaeili, M., Mosavi, A.: Variable reduction for multiobjective optimization using data

mining techniques. Computer Engineering and Technology 5, 325-333 (2010) - Mosavi, A.: Data mining for decision making in engineering optimal design. Journal of AI

and Data Mining 2, 7-14 (2014). - Mosavi, A., Vaezipour, A.: Visual Analytics, Obuda University, Budapest, (2015).

- Mosavi, A., Vaezipour, A.: Reactive Search Optimization; Application to Multiobjective

Optimization Problems. Applied Mathematics 3, 1572-1582 (2012). - Mosavi, A., Varkonyi-Koczy, AR, Fullsack, M.: Combination of Machine Learning and

Optimization for Automated Decision-Making. MCDM (2015). - Mosavi, A., Delavar, A.: Business Modeling, Obuda University, Budapest, (2016).

- Mosavi, A.: Application of data mining in multiobjective optimization problems. International Journal for Simulation and Multidisciplinary Design Optimization, 5, (2014)

- Mosavi, A. Rabczuk, T.: Learning and Intelligent Optimization for Material Design Innovation, Theoretical Computer Science and General Issues, LION11 (2017).

- Mosavi, A., Visual Analytics, Obuda University, 2016.

- Mosavi, A.: Predictive decision making, Tech Rep 2015. doi: 10.13140/RG.2.2.16061.46561

- Mosavi. A.: Predictive Decision Making, Predictive Decision Model, Tech. Report. (2015).

https://doi.org/10.13140/RG.2.2.21094.63047 - Mosavi, A., Lopez, A.: Varkonyi-Koczy, A.: Industrial Applications of Big Data: State of

the Art Survey, Advances in Intelligent Systems and Computing, (2017). - Mosavi, A., Rabczuk, T., Varkonyi-Koczy, A.: Reviewing the Novel Machine Learning

Tools for Materials Design, Advances in Intelligent Systems and Computing, (2017). - Mousavi, S., Mosavi, A., Varkonyi-Koczy, AR: A load balancing algorithm for resource

allocation in cloud computing, Advances in Intelligent Systems and Computing, (2017). - Baranyai, M., Mosavi, A., Vajda, I., Varkonyi-Koczy, AR: Optimal Design of Electrical

Machines: State of the Art Survey, Advances in Intelligent Systems and Computing, (2017). - Mosavi, A., Benkreif, R., Varkonyi-Koczy, A.: Comparison of Euler-Bernoulli and Timoshenko Beam Equations for Railway System Dynamics, Advances in Intelligent Systems

and Computing, (2017). - Mosavi, A., Rituraj, R., Varkonyi-Koczy, AR: Reviewing the Multiobjective Optimization

Package of modeFrontier in Energy Sector, Advances in Intelligent Systems and Computing,

(2017). - Mosavi, A., Bathla, Y., Varkonyi-Koczy AR: Predicting the Future Using Web

Knowledge: State of the Art Survey, Advances in Intelligent Systems and Computing,

(2017).