Nos clients turcs nous ont demandé de configurer correctement la sauvegarde du centre de données. Nous menons des projets similaires en Russie, mais c'est ici que l'histoire portait davantage sur la meilleure façon de faire.

Étant donné: il existe un stockage S3 local, il y a Veritas NetBackup, qui a acquis de nouvelles fonctionnalités avancées pour déplacer les données vers les magasins d'objets maintenant avec prise en charge de la déduplication, et il y a un problème d'espace libre dans ce stockage local.

Objectif: tout faire pour que le processus de stockage de sauvegarde soit rapide et bon marché.

En fait, avant cela, dans S3, tout n'était que des fichiers, et il s'agissait de moulages complets de machines critiques de datacenter. Ce n'est pas pour qu'il soit très optimisé, mais tout a fonctionné au départ. Il est maintenant temps de le comprendre et de le faire correctement.

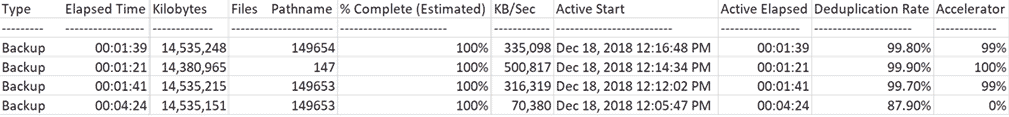

Dans l'image, ce que nous en sommes venus à:

Comme vous pouvez le voir, la première sauvegarde a été effectuée lentement (70 Mo / s), et les sauvegardes suivantes des mêmes systèmes ont été beaucoup plus rapides.

En fait, un peu plus de détails sur les fonctionnalités disponibles.

Journaux de sauvegarde pour ceux qui sont prêts à lire une demi-page de vidageComplet avec rescan

18 déc.2018 12:09:43 - Info L'accélérateur bpbkar (pid = 4452) a envoyé 14883996160 octets sur 14883994624 octets au serveur, optimisation 0,0%

18 décembre 2018 12:10:07 PM - Info NBCC (pid = 23002) StorageServer = PureDisk_rhceph_rawd: s3.cloud.ngn.com.tr; Rapport = Statistiques PDDO (flux multi-thread utilisé) pour (NBCC): analysé: 14570817 Ko, CR envoyé: 1760761 Ko, CR envoyé via FC: 0 Ko, déduplication: 87,9%, cache désactivé

Complet

18 décembre 2018 12:13:18 PM - L'accélérateur Info bpbkar (pid = 2864) a envoyé 181675008 octets sur 14884060160 octets au serveur, optimisation 98,8%

18 décembre 2018 12:13:40 PM - Info NBCC (pid = 23527) StorageServer = PureDisk_rhceph_rawd: s3.cloud.ngn.com.tr; Rapport = Statistiques PDDO pour (NBCC): analysé: 14569706 Ko, CR envoyé: 45145 Ko, CR envoyé via FC: 0 Ko, déduplication: 99,7%, cache désactivé

Incrémental

18 décembre 2018 12:15:32 PM - L'accélérateur bpbkar (pid = 792) a envoyé 9970688 octets sur 14726108160 octets au serveur, optimisation 99,9%

18 décembre 2018 12:15:53 PM - Info NBCC (pid = 23656) StorageServer = PureDisk_rhceph_rawd: s3.cloud.ngn.com.tr; Rapport = Statistiques PDDO pour (NBCC): numérisé: 14383788 Ko, CR envoyé: 15700 Ko, CR envoyé sur FC: 0 Ko, déduplication: 99,9%, cache désactivé

Complet

18 déc.2018 12:18:02 PM - L'accélérateur Info bpbkar (pid = 3496) a envoyé 171746816 octets sur 14884093952 octets au serveur, optimisation 98,8%

18 décembre 2018 12:18:24 PM - Info NBCC (pid = 23878) StorageServer = PureDisk_rhceph_rawd: s3.cloud.ngn.com.tr; Rapport = Statistiques PDDO pour (NBCC): analysé: 14569739 Ko, CR envoyé: 34120 Ko, CR envoyé via FC: 0 Ko, déduplication: 99,8%, cache désactivé

Quel est le problème

Les clients veulent sauvegarder aussi souvent que possible et stocker le moins cher possible. Il est bon marché de les stocker au mieux dans le stockage d'objets de type S3, car ils sont les moins chers au prix de la maintenance par mégaoctet d'où vous pouvez effectuer une restauration dans un délai raisonnable. Lorsqu'il y a beaucoup de sauvegardes, cela devient peu coûteux, car la plupart du stockage est occupé par des copies des mêmes données. Dans le cas de HaaS de collègues turcs, le stockage peut être densifié d'environ 80 à 90%. Il est clair que cela s'applique spécifiquement à leurs spécificités, mais je compterais certainement sur au moins 50% de la déduction.

Pour résoudre le problème, les principaux fournisseurs ont depuis longtemps créé des passerelles sur Amazon S3. Toutes leurs méthodes sont compatibles avec S3 local si elles prennent en charge l'API Amazon. Dans le centre de données turc, la sauvegarde est effectuée dans notre S3, ainsi que dans le «compresseur» T-III en Russie, car un tel schéma de travail s'est avéré bon pour nous.

Et

notre S3 est entièrement compatible avec les méthodes de sauvegarde d'Amazon S3. Autrement dit, tous les outils de sauvegarde qui prennent en charge ces méthodes vous permettent de tout copier sur un tel stockage «prêt à l'emploi».

Veritas NetBackup a créé une fonctionnalité CloudCatalyst:

C'est-à-dire qu'entre les machines qui doivent être sauvegardées et la passerelle, il y a un serveur Linux intermédiaire à travers lequel passe le trafic de sauvegarde des agents CPC et la déduplication est effectuée à la volée avant de les transférer vers S3. Si auparavant il y avait 30 sauvegardes de 20 Go chacune avec compression, maintenant (en raison de la similitude des machines), elles sont devenues 90% plus petites en volume. Le moteur de déduplication est utilisé de la même manière que lorsqu'il est stocké sur des disques normaux à l'aide de Netbackup.

Voici ce qui se passe avant le serveur de transfert:

Nous avons testé et conclu que, une fois implémenté dans nos centres de données, cela économise de l'espace dans les stockages S3 pour nous et pour les clients. En tant que propriétaire de centres de données commerciaux, bien sûr, nous facturons le volume occupé, mais cela est toujours très rentable pour nous aussi - car nous commençons à gagner sur des emplacements plus évolutifs dans les logiciels, et non sur la location de fer. Eh bien, c'est une réduction des coûts internes.

Journaux228 travaux (0 mis en file d'attente 0 actif 0 en attente de nouvelle tentative 0 suspendu 0 incomplet 228 terminé - 13 sélectionnés)

(Filtre appliqué [13])

Type d'ID de travail État État Détails État Stratégie de travail Planification de travail Client Media Server Heure de début Temps écoulé Heure de fin Unité de stockage Tentative d'opération Kilo-octets Fichiers Chemin d'accès% terminé (estimé) Propriétaire du PID du travail Copier l'ID de travail parent KB / Sec Démarrage actif Active écoulée Session de profil du coffre-fort du robot ID Media to Eject Data Movement Off-Host Type Taux de déduplication prioritaire principal Transport Accelerator Optimization Instance ou Database Share Host

- 1358 Snapshot Done 0 VMware - NGNCloudADC NBCC 18 déc. 2018 12:16:19 PM 00:02:18 18 déc. 2018 12:18:37 STU_DP_S3 _ **** sauvegarde 1 100% root 1358 18 déc. 2018 12 : 16: 27 PM 00:02:10 Standard Recovery Disk Instant WIN - *********** 0

1360 Sauvegarde terminée 0 VMware complet NGNCloudADC NBCC 18 décembre 2018 12:16:48 PM 00:01:39 18 décembre 2018 12:18:27 STU_DP_S3 _ **** sauvegarde 1 14 535 248 149654100% 23858 racine 1358 335 098 18 décembre , 2018 12:16:48 PM 00:01:39 Disque de récupération instantanée Standard WIN - *********** 0 99,8% 99%

1352 Snapshot Done 0 VMware - NGNCloudADC NBCC 18 déc. 2018 12:14:04 PM 00:02:01 18 déc. 2018 12:16:05 PM STU_DP_S3 _ **** sauvegarde 1 100% root 1352 18 déc. 2018 12: 14:14 PM 00:01:51 WIN standard de disque de récupération instantanée - *********** 0

1354 Sauvegarde terminée 0 VMware Incremental NGNCloudADC NBCC 18 décembre 2018 12:14:34 PM 00:01:21 18 décembre 2018 12:15:55 STU_DP_S3 _ **** sauvegarde 1 14.380.965 147100% 23617 root 1352 500 817 18 décembre , 2018 12:14:34 PM 00:01:21 WIN standard de disque de récupération instantanée - *********** 0 99,9% 100%

1347 Snapshot Done 0 VMware - NGNCloudADC NBCC 18 déc. 2018 12:11:45 PM 00:02:08 18 déc. 2018 12:13:53 STU_DP_S3 _ **** sauvegarde 1 100% root 1347 18 déc. 2018 12: 11:45 PM 00:02:08 WIN standard de disque de récupération instantanée - *********** 0

1349 Sauvegarde terminée 0 VMware complet NGNCloudADC NBCC 18 décembre 2018 12:12:02 PM 00:01:41 18 décembre 2018 12:13:43 PM STU_DP_S3 _ **** sauvegarde 1 14535215 149653100% racine 23508 1347316319 18 décembre , 2018 12:12:02 PM 00:01:41 Disque de récupération instantanée Standard WIN - *********** 0 99,7% 99%

1341 Snapshot Done 0 VMware - NGNCloudADC NBCC 18 déc. 2018 12:05:28 PM 00:04:53 18 déc. 2018 12:10:21 STU_DP_S3 _ **** sauvegarde 1 100% root 1341 18 déc. 2018 12: 05:28 PM 00:04:53 Gain standard de disque de récupération instantanée - *********** 0

1342 Sauvegarde terminée 0 VMware Full_Rescan NGNCloudADC NBCC 18 décembre 2018 12:05:47 PM 00:04:24 18 décembre 2018 12:10:11 STU_DP_S3 _ **** sauvegarde 1 14.535.151 149653 100% 22999 racine 1341 70.380 18 décembre , 2018 12:05:47 00:04:24 WIN standard de disque de récupération instantanée - *********** 0 87,9% 0%

1339 Snapshot Done 150 VMware - NGNCloudADC NBCC 18 décembre 2018 11:05:46 00:00:53 18 décembre 2018 11:06:39 STU_DP_S3 _ **** sauvegarde 1 100% root 1339 18 décembre 2018 11: 05:46 AM 00:00:53 Gain standard de disque de récupération instantanée - *********** 0

1327 Instantané terminé 0 VMware - *******. ********. Cloud NBCC 17 décembre 2018 12:54:42 17:51:38 17 décembre 2018 18:46:20 STU_DP_S3 _ **** sauvegarde 1 100% racine 1327 17 décembre 2018 12:54:42 PM 05:51:38 WIN standard de disque de récupération instantanée - *********** 0

1328 Sauvegarde terminée 0 VMware complet *******. ********. Cloud NBCC 17 déc.2018 12:55:10 05:29:21 17 déc 2018 18:24:31 STU_DP_S3 _ **** sauvegarde 12226060719 258932100% 12856 root 1327 11326 17 décembre 2018 12:55:10 PM 05:29:21 Instant Recovery Disk Standard WIN - *********** 0 87,9% 0%

1136 Snapshot Done 0 VMware - *******. ********. Cloud NBCC 14 décembre 2018 16:48:22 16:05:16 14 décembre 2018 20:53:38 PM STU_DP_S3 _ **** sauvegarde 1 100% racine 1136 14 décembre 2018 16:48:22 04:05:16 WIN standard de disque de récupération instantanée - *********** 0

1140 Sauvegarde terminée 0 VMware Full_Scan *******. ********. Cloud NBCC 14 décembre 2018 16:49:14 15:49:58 14 décembre 2018 20:39:12 PM STU_DP_S3 _ **** sauvegarde 1 217 631 332 255465100% 26438 racine 1136 15 963 14 décembre 2018 16:49:14 03:49:58 Instant Recovery Disk Standard WIN - *********** 0 45,2% 0%

L'accélérateur vous permet de réduire le trafic des agents, car seules les modifications de données sont transmises, c'est-à-dire que même les sauvegardes complètes ne sont pas intégralement versées, car le serveur multimédia collecte les sauvegardes complètes suivantes à partir des sauvegardes incrémentielles.

Le serveur intermédiaire a son propre référentiel où il écrit un "cache" de données et détient la base de déduplication.

En architecture complète, cela ressemble à ceci:

- Le serveur maître gère la configuration, les mises à jour, etc., et se trouve dans le cloud.

- Le serveur multimédia (machine intermédiaire * nix) doit être situé le plus près des systèmes redondants en termes de disponibilité du réseau. Ici, les sauvegardes sont dédupliquées de toutes les machines redondantes.

- Il y a des agents sur les machines redondantes qui n'envoient généralement au serveur multimédia que ce qui n'est pas dans son stockage.

Tout commence par une analyse complète - il s'agit d'une sauvegarde complète à part entière. À ce stade, le serveur multimédia prend tout, le dédoublonne et le transfère vers S3. La vitesse vers le serveur multimédia est faible, de là - plus élevée. La principale limitation est la puissance de traitement du serveur.

Les sauvegardes suivantes sont effectuées du point de vue de tous les systèmes, mais en réalité, il s'agit de sauvegardes complètes synthétiques. Autrement dit, le transfert et l'enregistrement réels sur le serveur multimédia ne sont que les blocs de données qui n'ont pas encore été vus dans les sauvegardes de VM auparavant. Et le transfert et l'enregistrement vers S3 ne sont que les blocs de données dont le hachage ne se trouve pas dans la base de données de déduplication du serveur multimédia. Si en termes plus simples - qu'il n'y avait aucune machine virtuelle dans aucune sauvegarde auparavant.

Lors de la restauration, le serveur multimédia demande les objets dédupliqués nécessaires à S3, les réhydrate et les transmet aux agents CPC, c'est-à-dire il est nécessaire de prendre en compte le volume de trafic lors de la restauration, qui sera égal au volume réel de données en cours de restauration.

Voici à quoi ça ressemble:

Et voici un autre morceau de journaux169 travaux (0 en file d'attente 0 actif 0 en attente de nouvelle tentative 0 suspendu 0 incomplet 169 terminé - 1 sélectionné)

Type d'ID de travail État État Détails État Stratégie de travail Planification de travail Client Media Server Heure de début Temps écoulé Heure de fin Unité de stockage Tentative d'opération Kilo-octets Fichiers Chemin d'accès% terminé (estimé) Propriétaire du PID du travail Copier l'ID de travail parent KB / Sec Démarrage actif Active écoulée Session de profil du coffre-fort du robot ID Media to Eject Data Movement Off-Host Type Taux de déduplication prioritaire principal Transport Accelerator Optimization Instance ou Database Share Host

- 1372 Restauration terminée 0 nbpr01 NBCC 19 décembre 2018 13:05:58 00:04:32 19 décembre 2018 13:10:30 1 14380577 1100% 8548 racine 1372 70567 19 décembre 2018 13:06:00 PM 00:04:30 WIN - *********** 90000

L'intégrité des données est assurée par la protection de S3 lui-même - il y a une bonne redondance pour se protéger contre les pannes matérielles telles qu'une broche de disque dur morte.

Le serveur multimédia a besoin de 4 téraoctets de cache - c'est la recommandation de Veritas pour la taille minimale. Mieux encore, mais nous l'avons fait.

Résumé

Lorsqu'un partenaire a jeté 20 Go dans notre S3, nous avons stocké 60 Go, car nous fournissons une géo-réservation de données à trois reprises. Maintenant, le trafic est beaucoup moins, ce qui est bon à la fois pour le canal et pour la charge de stockage.

Dans ce cas, les itinéraires sont fermés après le "grand Internet", mais vous pouvez générer du trafic via VPN L2 via Internet, mais il est préférable de configurer le serveur multimédia à l'entrée du fournisseur.

Si vous souhaitez en savoir plus sur ces fonctionnalités dans nos centres de données russes ou si vous avez des questions sur la façon de les mettre en œuvre, posez-les dans les commentaires ou envoyez un e-mail à ekorotkikh@croc.ru.