Dans les deux parties précédentes (

une ,

deux ), nous avons examiné les principes sur la base desquels une nouvelle usine d'utilisateurs a été construite, et nous avons parlé de la migration de tous les emplois. Il est maintenant temps de parler de l'usine de serveurs.

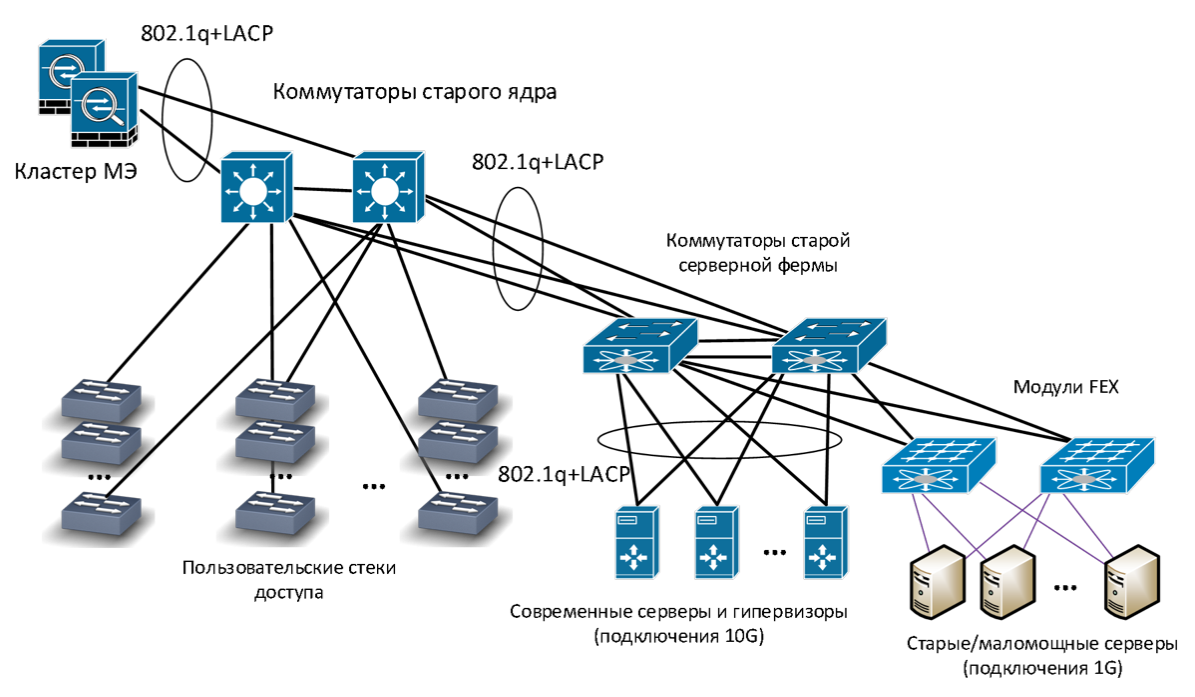

Auparavant, nous n'avions pas d'infrastructure de serveur distincte: les commutateurs de serveur étaient connectés au même cœur que les commutateurs de distribution d'utilisateurs. Le contrôle d'accès a été effectué à l'aide de réseaux virtuels (VLAN), le routage VLAN a été effectué à un moment donné - sur le cœur (selon le principe

Collapsed Backbone ).

Ancienne infrastructure réseau

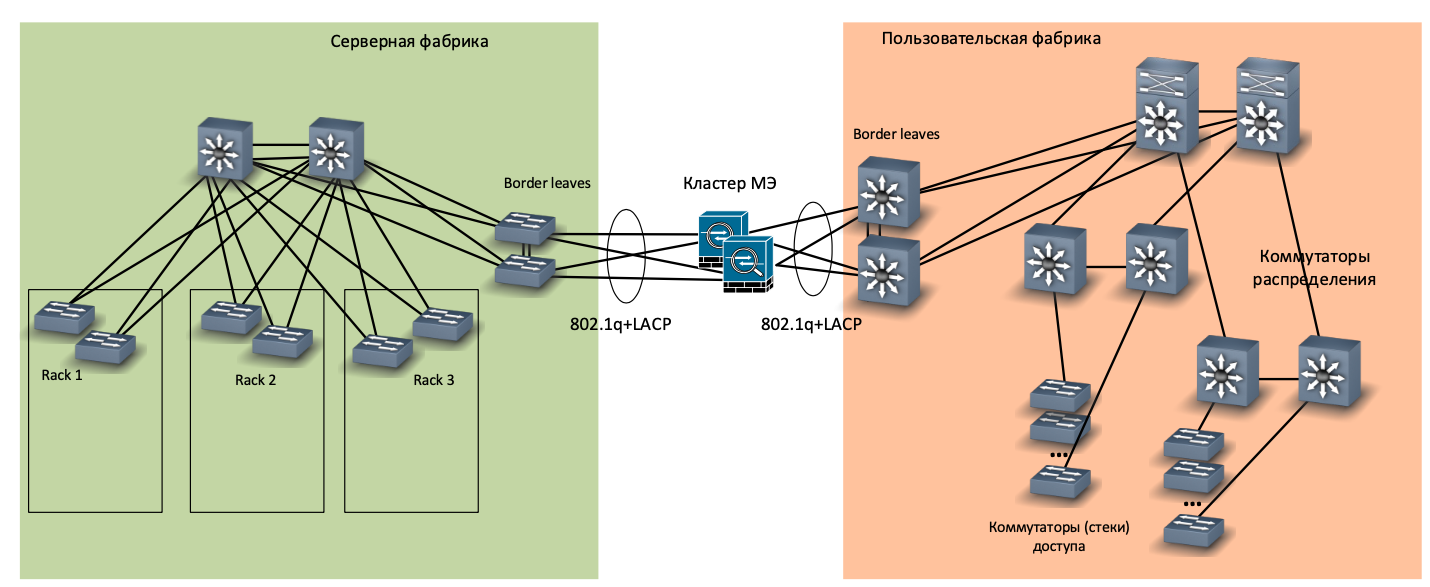

Ancienne infrastructure réseauParallèlement au nouveau réseau de bureaux, nous avons décidé de construire une nouvelle salle de serveurs, et pour cela - une nouvelle usine séparée. Il s'est avéré être petit (trois armoires de serveur), mais suivant tous les canons: un noyau séparé sur les commutateurs CE8850, une topologie entièrement connectée (feuille vertébrale), le haut du rack (ToR) -commutateurs CE6870, une paire séparée de commutateurs pour interfacer avec le reste du réseau (frontière feuilles). En bref, farce complète.

Réseau de la nouvelle usine de serveurs

Réseau de la nouvelle usine de serveursNous avons décidé d'abandonner le serveur SCS au profit de la connexion directe des serveurs aux commutateurs ToR. Pourquoi? Nous avons déjà deux salles de serveurs qui sont construites à l'aide de SCS sur serveur, et nous avons réalisé que c'était:

- gênant dans le fonctionnement (beaucoup de commutation, vous devez mettre à jour soigneusement le journal de câble);

- coûteux en termes d'espace occupé par les panneaux de brassage;

- si nécessaire, augmentez la vitesse de connexion des serveurs (par exemple, passez de connexions cuivre 1 Gbit / s à des optiques 10 Gbit / s).

Lorsque nous avons déménagé dans une nouvelle usine de serveurs, nous avons essayé de nous éloigner des serveurs de connexion à une vitesse de 1 Gbit / s et nous nous sommes limités à des interfaces de 10 gigabits. Virtualisé presque tous les anciens serveurs qui ne savent pas comment, et le reste via des émetteurs-récepteurs gigabit connectés à des ports 10 gigabits. Nous avons calculé et décidé que ce serait moins cher que d'installer des commutateurs gigabit séparés pour eux.

Commutateurs ToR

Commutateurs ToRToujours dans notre nouvelle salle de serveurs, nous avons installé des commutateurs de gestion hors bande (MOO) séparés sur 24 ports, un par rack. Cette idée s'est avérée très bonne, seuls les ports n'étaient pas suffisants, la prochaine fois nous installerons des commutateurs OOM pour 48 ports.

Dans le réseau OOM, nous connectons des interfaces de gestion à distance pour des serveurs tels que iLO ou iBMC selon la terminologie Huawei. Si le serveur a perdu la connexion principale au réseau, vous pouvez y accéder via cette interface. Les commutateurs OOM connectent également les interfaces de gestion des commutateurs ToR, les capteurs de température, les interfaces de contrôle de l'onduleur et d'autres appareils similaires. Le réseau MOO est accessible via une interface de pare-feu distincte.

Connexion réseau OOM

Connexion réseau OOMCouplage des réseaux de serveurs et d'utilisateurs

Dans une usine personnalisée, des VRF séparés sont utilisés à différentes fins - pour connecter les postes de travail des utilisateurs, les systèmes de vidéosurveillance, les systèmes multimédias dans les salles de réunion, pour organiser les stands et les zones de démonstration, etc.

Un ensemble différent de VRF a été créé dans la fabrique de serveurs:

- Pour connecter des serveurs conventionnels sur lesquels des services d'entreprise sont déployés.

- VRF distinct, dans lequel les serveurs sont déployés avec un accès à partir d'Internet.

- VRF distinct pour les serveurs de base de données accessibles uniquement par d'autres serveurs (par exemple, les serveurs d'applications).

- VRF distinct pour notre système de messagerie (MS Exchange + Skype for Business).

Ainsi, nous avons un ensemble VRF du côté usine utilisateur et un ensemble VRF du côté usine serveur. Les deux ensembles sont regroupés sur des pare-feu d'entreprise (ME). Les ME sont connectés aux commutateurs frontaliers de l'usine de serveurs et de l'usine d'utilisateurs.

Interfaçage d'usines par ME - physique

Interfaçage d'usines par ME - physique Interfaçage des usines via ME - logique

Interfaçage des usines via ME - logiqueComment s'est passée la migration

Pendant la migration, nous avons connecté les nouvelles et anciennes usines de serveurs au niveau du canal, via des lignes de réseau temporaires. Pour migrer des serveurs situés dans un VLAN spécifique, nous avons créé un domaine de pont distinct, qui comprenait le VLAN de l'ancienne fabrique de serveurs et le VXLAN de la nouvelle fabrique de serveurs.

La configuration ressemble à ceci, la clé sont les deux dernières lignes:

bridge-domain 22 vxlan vni 600022 evpn route-distinguisher 10.xxx.xxx.xxx:60022 vpn-target 6xxxx:60022 export-extcommunity vpn-target 6xxxx:60022 import-extcommunity interface Eth-Trunk1 mode lacp-static dfs-group 1 m-lag 1 interface Eth-Trunk1.1022 mode l2 encapsulation dot1q vid 22 bridge-domain 22

Migration de machine virtuelle

Migration de machine virtuelleEnsuite, à l'aide de VMware vMotion, les machines virtuelles de ce VLAN ont migré des anciens hyperviseurs (version 5.5) vers les nouveaux (version 6.5). En cours de route, les serveurs matériels ont été virtualisés.

Lorsque vous essayez de répéterConfigurez MTU à l'avance et recherchez les gros paquets de bout en bout.

Dans l'ancien réseau de serveurs, nous utilisions VMware vShield virtual ME. Étant donné que VMware ne prend plus en charge cet outil, nous avons migré de vShield vers des pare-feu matériels lors de la migration vers une nouvelle batterie de serveurs virtuelle.

Après qu'aucun serveur n'a été laissé dans un VLAN spécifique dans l'ancien réseau, nous avons changé de routage. Auparavant, il était implémenté sur un ancien noyau basé sur la technologie Collapsed Backbone, et dans la nouvelle usine de serveurs, nous avons utilisé la technologie Anycast Gateway.

Commutateur de routage

Commutateur de routageAprès avoir changé de routage pour un VLAN spécifique, il s'est déconnecté du domaine de pont et a été exclu de la jonction entre l'ancien et le nouveau réseau, c'est-à-dire qu'il a été complètement transféré à la nouvelle usine de serveurs. Nous avons donc migré environ 20 VLAN.

Nous avons donc créé un nouveau réseau, un nouveau serveur et une nouvelle batterie de virtualisation. Dans l'un des articles suivants, nous parlerons de ce que nous avons fait avec le Wi-Fi.

Maxim Klochkov

Consultant principal, Audit de réseau et projets intégrés

Centre de solutions réseau

Jet Infosystems