L'un des principaux événements dans le domaine de la linguistique informatique et du machine learning en 2018 a été la

sortie du BERT de Google AI, qui a été reconnu comme le meilleur rapport de l'année selon la branche nord-américaine de l'Association of Computer Linguistics (NACL). Dans cet article, nous parlerons de ce modèle de langage et de ses capacités.

Pour ceux qui ne l'ont pas entendu auparavant, le BERT est un réseau de neurones basé sur la méthode de préparation préliminaire des représentations contextuelles des mots, c'est-à-dire qu'il utilise un modèle de langage bidirectionnel et vous permet également d'analyser des phrases entières. Dans ce cas, les mots qui viennent après le donné et à travers sont également pris en compte. Cette méthode permet d'obtenir des résultats avec une large marge de l'état de l'art dans un large éventail de tâches de traitement du langage naturel (NLP), mais nécessite une grande puissance de calcul.

Du discours formel à la conversation

Le BERT a été initialement enseigné dans 104 langues Wikipédia (multilingue). En plus de la version multilingue, Google a publié BERT basé sur Wikipedia anglais et BERT en chinois.

Dans le laboratoire de systèmes neuronaux et d'apprentissage en profondeur, nous avons utilisé BERT pour améliorer les composants PNL de DeepPavlov, une bibliothèque interactive open source pour développer un assistant interactif virtuel et une analyse de texte basée sur TensorFlow et Keras. Nous avons formé le modèle BERT sur Wikipedia russe - RuBERT, améliorant considérablement la qualité des modèles russes. De plus, BERT a été intégré dans les solutions de trois tâches PNL populaires: classification de texte, étiquetage de séquence et réponses aux questions. Vous pouvez en savoir plus sur les modèles BERT de DeepPavlov dans les dernières publications de notre blog:

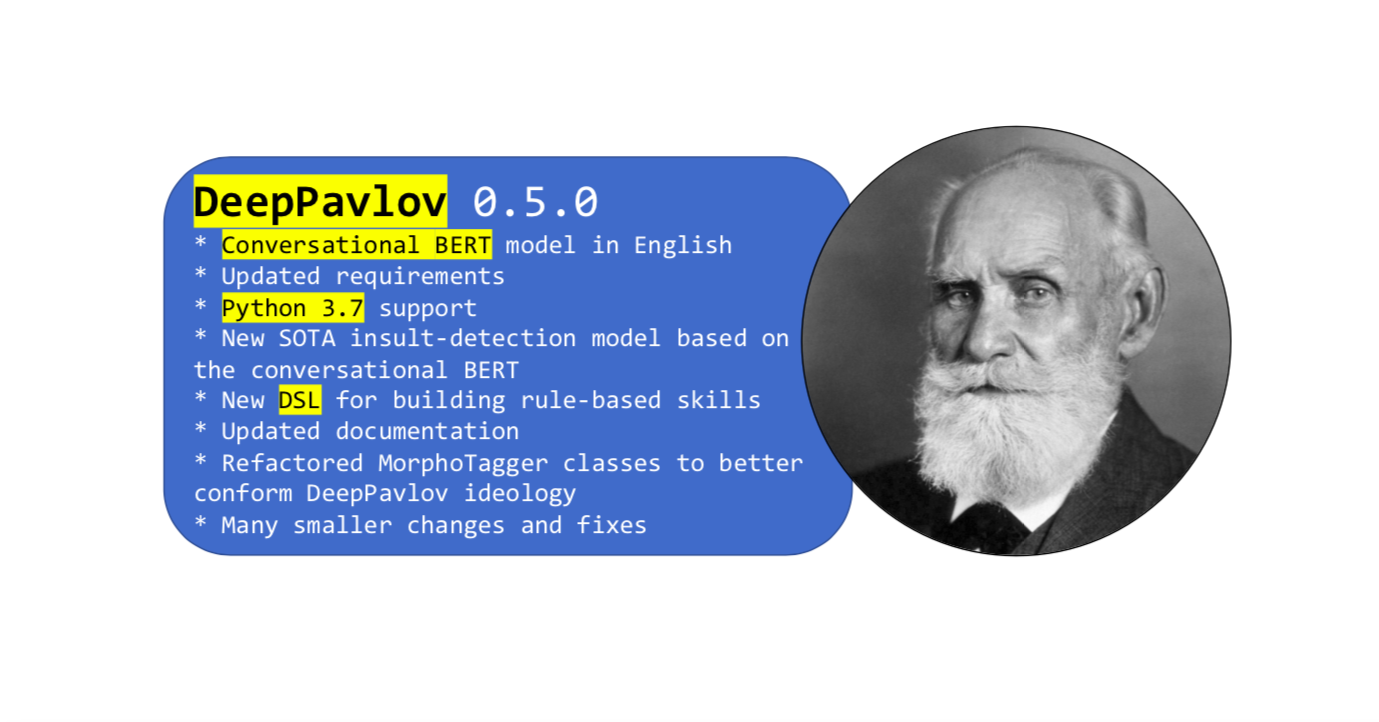

Plus récemment, une nouvelle version de la bibliothèque

L'élément clé de cette mise à jour était le BERT, formé au vocabulaire des réseaux sociaux en anglais. Le langage formel de Wikipedia est différent du langage familier ordinaire, alors que pour résoudre certains problèmes, il vous suffit d'en avoir un.

L'ORET conversationnel a été formé en anglais à l'aide des données ouvertes de Twitter, Reddit, DailyDialogues, OpenSubtitles, des débats, des blogs et des commentaires sur les actualités Facebook. Ces données ont été utilisées pour intégrer le vocabulaire des sous-jetons anglais dans la version anglaise de BERT en tant qu'initialisation pour BERT parlé en anglais. En conséquence, le BERT parlé a montré des résultats de pointe dans les tâches qui comprenaient des données sociales.

Comment utiliser Conversation BERT dans DeepPavlov

Vous pouvez utiliser le nouveau modèle de

détection d'insulte basé sur le BERT parlé en anglais. Ou tout autre modèle basé sur BERT utilisant un

simple guide de la documentation.

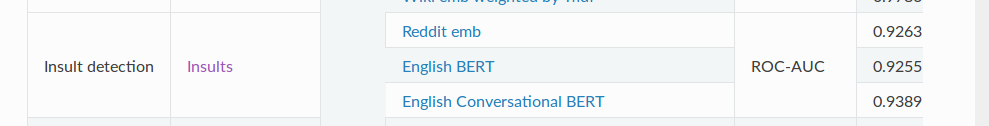

Le modèle de

détection SOTA

Insult contient une tâche de classification binaire pour détecter les abus. Pour la métrique ROC-AUC (mesure des performances pour la tâche de classification à différents paramètres de seuil), ce modèle affiche une valeur de 93,89 sur les données par rapport au BERT habituel - 92,55.

Et enfin

C'est presque tout ce que nous voulions vous dire sur notre BERT conversationnel. Et n'oubliez pas que DeepPavlov a un

forum - posez vos questions concernant la bibliothèque et les modèles. Soyez en affaires!