Les concepteurs UX et UI sont toujours sceptiques quant aux interfaces vocales. L'un semble être un battage publicitaire qui n'aboutira bientôt à rien. D'autres n'utilisent pas d'assistants vocaux et sont donc convaincus que la voix est inconfortable et non naturelle. Mais alors qu'ils doutaient, une sphère professionnelle indépendante s'est développée - avec ses secrets, ses schémas et sa mécanique (et même le marché du travail). Avec l'architecte Just AI UX Yekaterina Yulina, nous découvrons comment aborder les technologies vocales et ce que le concepteur UX des interfaces traditionnelles devrait changer dans sa façon de penser, en prenant la voix.

Mais d'abord, une petite rétrospective. Dans la cour 1995. Microsoft publie Windows 95 et une révolution se déroule dans le monde. Je me souviens de la façon dont les parents et les autres adultes parlaient des avantages et des dangers des ordinateurs. Et le week-end, toute la famille est allée rendre visite à nos amis pour jouer à Kosinka et au démineur.

Le Nokia 3310 est sorti en 2000. Le monde a encore changé, cette fois grâce aux téléphones avec une interface à bouton-poussoir. Des smartphones avec des stylets sont apparus plus tard. J'en avais aussi un. Pousser avec un stylet sur l'écran était très cool. Immédiatement se démarque en quelque sorte sur le fond des personnes avec des téléphones à bouton-poussoir. Mais «le meilleur stylet est votre propre doigt», a déclaré Steve Jobs. En 2007, Apple a commencé à vendre l'iPhone - et depuis lors, les gens tapotent et glissent, et piquer avec un stylet est stupide depuis longtemps.

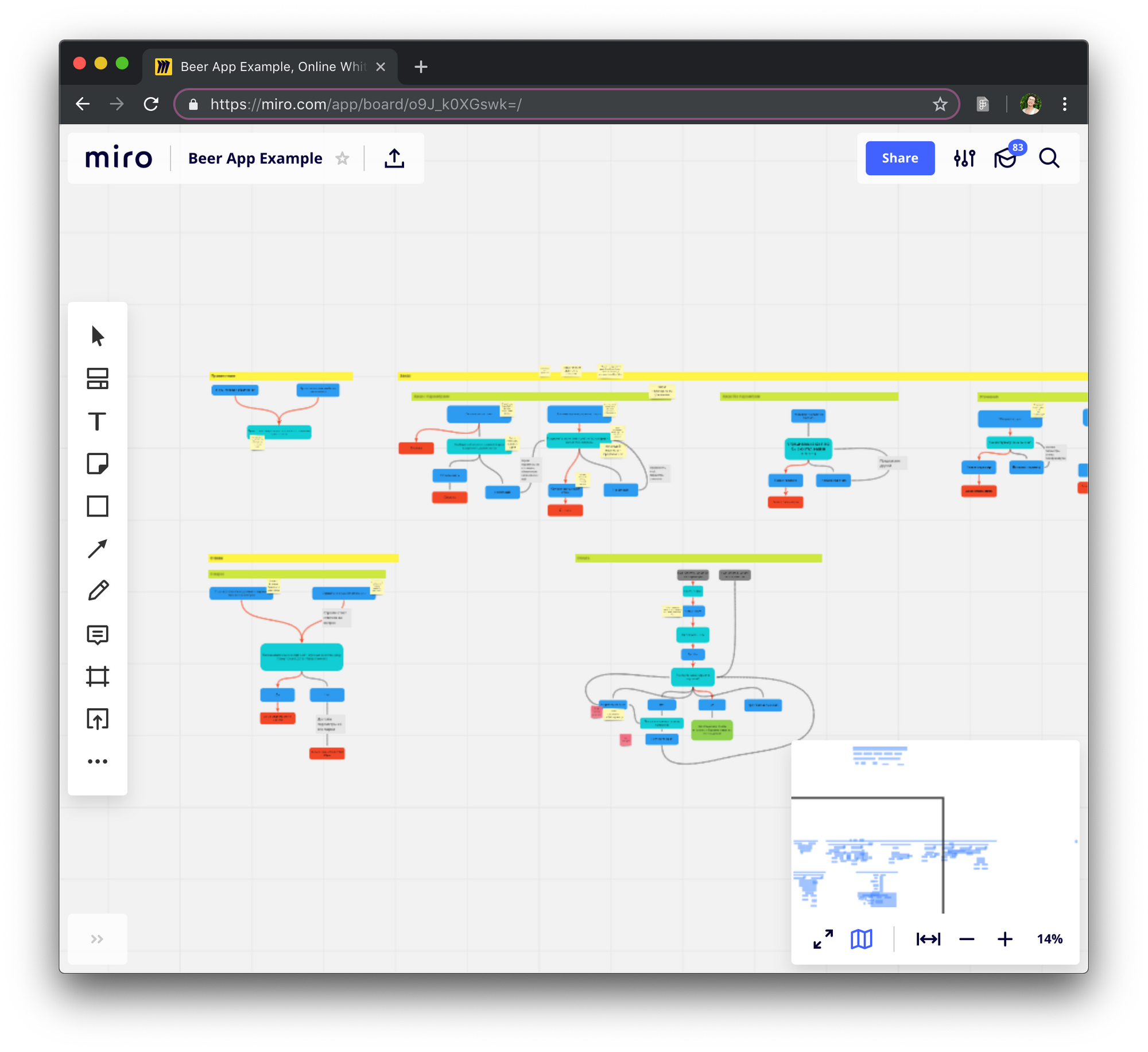

Et puis ça a commencé: 2011 - Apple présente Siri, en 2014 Amazon lance Alexa et Amazon Echo, en 2016 Google Assistant sort, en 2017 - «Alice» de Yandex ... Ouverture des portes devant les développeurs et les entreprises écosystème d'assistants, comme une fois - dans les magasins d'applications mobiles. Et bientôt seulement un paresseux (et myope!) Ne fera pas de compétences pour les assistants vocaux.

Situations où la voix est vraiment pratique

Il est impossible d'imaginer qu'une expérience utilisateur (UX, expérience utilisateur) se construit dans le vide. La compétence vocale naît dans une situation spécifique où elle est utile et organique - cela n'a aucun sens de créer un script vocal, puis de réfléchir à l'endroit où l'appliquer. Il est important de découvrir cette situation et de la vaincre magistralement.

La voix est plus pratique que les applications Web ou mobiles lorsque nous avons besoin d'une fonction spécifique pour résoudre un problème spécifique. Pourquoi? Parce que vous n'avez pas besoin d'attendre le chargement du site, faites défiler les pages, recherchez le menu, appuyez sur les boutons. Les sites et applications sont multifonctionnels. La compétence vocale doit être affinée pour un seul cas, sous "ici et maintenant".

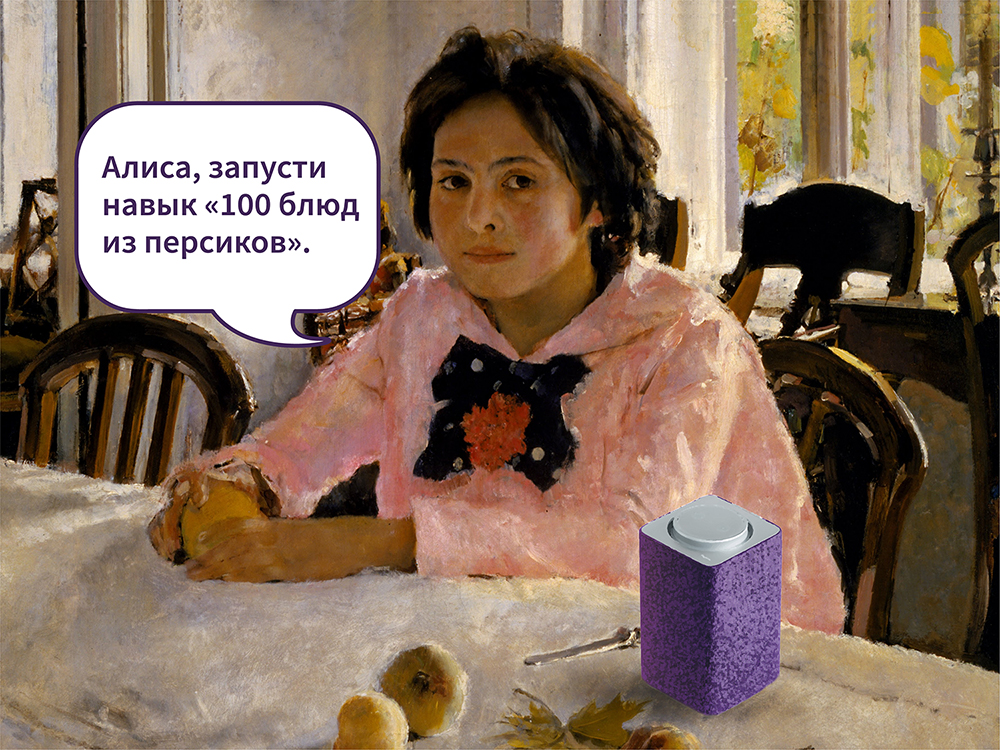

En février 2019, la chaîne américaine TNT a diffusé des matchs NBA. Entre les matchs des Los Angeles Lakers et des Boston Celtics, le commentateur Ernie Johnson annonce que des baskets Nike en édition limitée sont en vente et les téléspectateurs peuvent demander à l'assistant Google de réserver une paire pour eux pour 350 $.

Six minutes plus tard, les baskets ont disparu. Plus de 15 mille personnes les ont réservées avec l'aide d'un assistant vocal (le nombre de commandes a dépassé le nombre de marchandises disponibles). La situation idéale pour vendre des chaussures de basket était un vrai jeu.

En 2017, Starbucks a compris comment utiliser un assistant vocal pour réduire le temps d'attente pour une commande et le chemin du client vers la tasse de café souhaitée. Vous pouvez dire «Alexa, commandez mes Starbucks» («Alexa, commandez mes Starbucks») et prenez votre boisson préférée à l'endroit le plus proche en quelques minutes. Pas besoin de faire la queue et d'attendre que le barista crie votre nom. Pas besoin d'aller dans l'application, recherchez votre commande habituelle, confirmez votre choix. Ensuite, le même cas a battu Ford: Alexa a été intégrée au système multimédia SYNC3, afin que les conducteurs aient la possibilité de commander et de payer leur Starbucks par la voix directement dans la voiture, sans être distraits de la route.

Mais des collègues d'Alan AI m'ont expliqué comment ils avaient trouvé un cas d'utilisation appliqué - non pas pour le marketing, mais pour les tâches d'entreprise. Aux États-Unis, le personnel technique des ascenseurs doit lire des tonnes de documentation, remplir un certain nombre de formulaires, saisir les données de réparation, rendre compte de l'achèvement des tâches - et tout cela dans différents systèmes comptables. L'écriture prend beaucoup de temps, dans laquelle l'ascenseur ne fonctionne pas réellement. Alan AI a appliqué la technologie d'intelligence artificielle vocale afin que les utilisateurs de haltérophiles puissent remplir des formulaires avec la voix pendant le travail ou en se rendant dans l'établissement.

Voice UX ne concerne pas les images, mais le contexte de la situation. La tâche du concepteur est d'étudier le contexte en détail et de comprendre ce que l'utilisateur souhaite dans une situation particulière.

Modèles UX dans la voix

Une fonction. Ainsi, une compétence est une fonction. Si le chauffeur commande du café, il résout ce problème spécifique. Vous avez terminé avec du café et vous voulez connaître la distance jusqu'à la lune? Une autre compétence vocale en est déjà responsable. Fabriquer un couteau suisse en une seule compétence est une mauvaise idée.

Faites défiler. Les concepteurs UX et UI se disputent constamment avec les spécialistes du marketing sur la quantité d'informations à afficher sur le premier écran. Il n'y a rien de pire que d'attendre que le contenu se charge, de faire défiler la page sans fin. Les interfaces de dialogue ont également un premier écran et, contrairement au Web, il n'y a pas de défilement. Il n'est pas nécessaire, car l'assistant vocal est un ensemble de compétences. L'utilisateur, sur commande, active la compétence et lance une seule fonction.

Fenêtres et boutons modaux. Le deuxième nom des fenêtres modales est dialogue. Quelle est l'essence des fenêtres modales? Confirmer ou refuser l'intention d'effectuer l'opération. Dans la vraie vie, les gens expriment leurs intentions en disant oui ou non, et vous n'avez pas besoin de boutons pour cela.

Multimodalité. Haut-parleurs et écrans intelligents, smartphones, jouets parlants pour enfants, maisons intelligentes, tableau de bord dans une voiture - les appareils déterminent le contexte d'utilisation. Ce qu'il est pratique pour l'utilisateur de faire à la maison grâce à un haut-parleur «intelligent» sera différent de l'utilisation d'un assistant vocal dans une voiture. Le même assistant sur différentes plateformes a un ensemble de compétences différent.

Définissez le contexte d'utilisation et l'appareil. Vérifiez si vous pouvez combiner la voix avec un autre type d'interaction sur cet appareil.

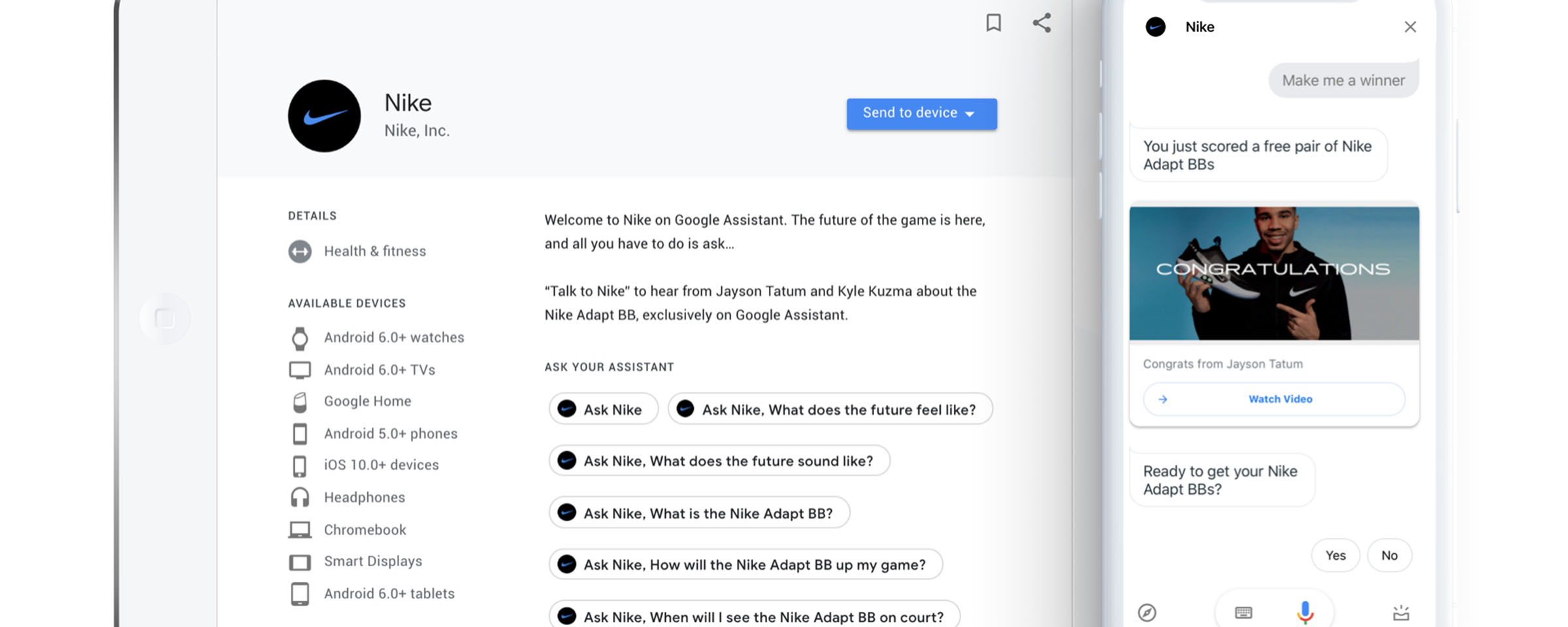

Multiplateforme . Un autre aspect est de savoir comment créer une compétence pour plusieurs assistants. La mécanique et la logique peuvent être préservées, mais le diable sera caché dans les détails de l'implémentation et le chemin de l'utilisateur vers la compétence. Voyons à quoi ressemble le chemin vers les compétences d'Alice et les actions de l'Assistant Google sur la même plate-forme.

Alice sur iOS . Les utilisateurs d'Alice doivent d'abord télécharger l'application Yandex.Browser, lui permettre d'utiliser l'emplacement et le microphone, cliquer sur l'icône de l'assistant et dire la phrase d'activation de la compétence. Par exemple, "Lancez la compétence" Oui, mon seigneur. " La deuxième expérience utilisateur et les suivantes se composent de trois étapes: ouvrez Yandex.Browser, cliquez sur le bouton d'appel de l'assistant, dites une phrase d'activation.

Assistant Google sur iOS

Assistant Google sur iOS . L'utilisateur télécharge l'application Google Assistant, se connecte via son compte, autorise l'envoi de notifications et accepte d'accéder au microphone. Si la langue par défaut est l'anglais, dans l'interface de l'application, vous devez sélectionner le russe, demandez à l'assistant de changer la langue avec votre voix et dites la phrase d'activation pour déclencher l'action. Ici, elle est différente - "Parlez avec l'application" Oui, mon seigneur. " Ensuite, le chemin est raccourci - la deuxième fois que l'utilisateur ouvre l'application Google Assistant et exprime simplement la commande.

Sans connaître la phrase d'activation (et les commandes pour invoquer la même compétence dans différents écosystèmes différeront), vous ne pouvez pas lancer la compétence - et en termes d'UX, c'est l'une des faiblesses des assistants vocaux. Mais Google, Yandex et d'autres sociétés travaillent maintenant sur la tâche de la découverte pratique des compétences (comment transmettre correctement les informations sur les nouvelles compétences aux consommateurs), il sera donc plus facile de trouver des compétences utiles et pertinentes à un moment donné.

Et en passant, les concepteurs de VUI insistent sur le fait qu'une compétence avec la même mécanique pour différents assistants est toujours des projets distincts.

Concevoir une interface en sept étapes

J'ai demandé aux concepteurs de VUI, aux collègues de Just AI et aux utilisateurs du générateur de compétences Aimylogic, avec lesquels ils commencent généralement à travailler sur le script. Tout le monde dit «avec une idée». Vous pouvez le décrire sous forme libre dans un éditeur de texte.

Pavel Gvay, fondateur de tortu.io - un outil pour concevoir des applications vocales: «Le moyen le plus rapide et le moins cher de comprendre comment la conversation sera construite entre l'utilisateur et votre application est d'écrire un exemple de dialogue. Il s'agit d'un fichier texte décrivant le fonctionnement d'un flux. Dans le format, les exemples de dialogue ressemblent au scénario du film, où toutes les remarques sont peintes par rôle. »

Exemple de dialogue dans NotionSaluer l'utilisateur

Exemple de dialogue dans NotionSaluer l'utilisateurDites-nous ce que fait le bot. Utilisez des phrases volumineuses de longueur moyenne. Terminez la phrase par une question fermée: afin que l'utilisateur comprenne ce qu'il attend de lui.

Mauvais - «Bonjour! Je suis une activité. Je ne peux pas vivre une journée sans sport. Il est mon tout, ma vie, mon inspiration! J'ai également beaucoup d'expérience en tant que formateur et des centaines d'exercices dans la base de données! Je partagerai avec plaisir mes exercices préférés avec vous! »

Bon - "Bonjour! Je suis Activity, un athlète bot. Je vous recommanderai volontiers une série d'exercices. Voulez-vous parler du yoga? "

Déterminer les chemins utilisateurDans le langage des programmeurs, l'intention est l'intention (intention en anglais). L'analogie avec les interfaces classiques est une demande formalisée ou informelle. Il est plus facile de travailler avec le formel et l'informel peut transformer la vie en cauchemar.

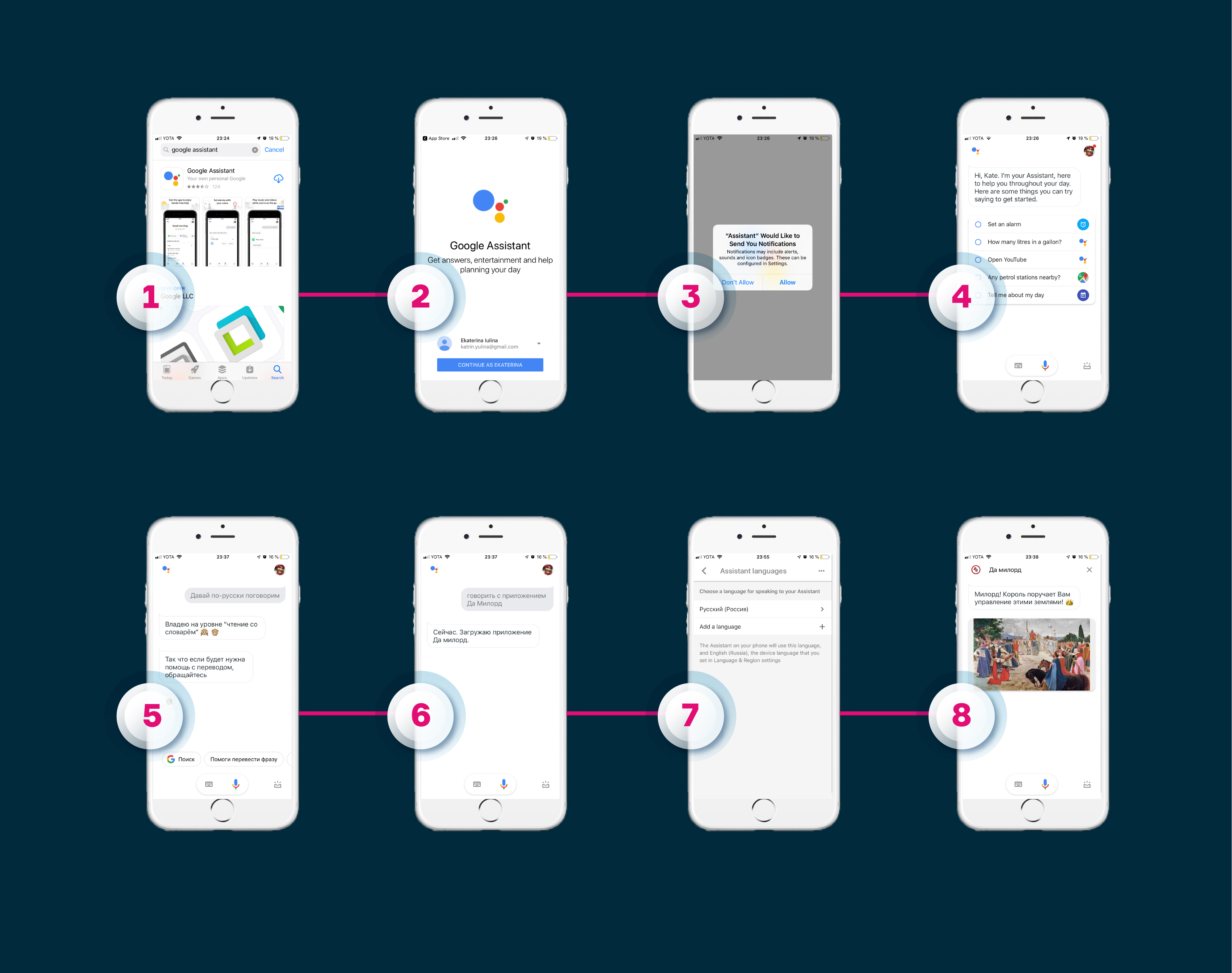

Les concepteurs utilisent un organigramme lorsqu'ils travaillent avec des chemins utilisateur. Sa tâche est d'aider à décrire la logique de l'application. L'organigramme se compose d'étapes de dialogue au nom de l'utilisateur et du système, parfois des éléments logiques y sont ajoutés - appels API, travail avec le contexte.

Organigramme à Miro

Organigramme à MiroSouvent, l'organigramme décrit les principaux carrefours des compétences vocales. Certains concepteurs bloquent chaque détail de la compétence. Pavel Guy ne recommande pas de le faire, car cela cessera très rapidement d'être lisible et toute modification prendra beaucoup de temps.

Le moyen le plus simple de déterminer le chemin de l'utilisateur est de l'accompagner du début à la fin et de voir à quels points les conditions et les écarts par rapport au scénario principal apparaîtront.

Créer une navigationQuelle que soit l'étape à laquelle l'utilisateur se trouve, il devrait toujours avoir la possibilité de tout recommencer, de revenir en arrière, d'avancer et de répondre de manière variable. Ne lui faites pas mémoriser les commandes.

Un exemple tiré de la vie. La compétence déjà mentionnée "Oui, mon seigneur" (son public dans "Alice" est de 650 mille personnes, de plus, c'est l'un des jeux les plus populaires pour Google Assistant non seulement en Russie mais aussi dans le monde) est un jeu atmosphérique avec de la musique synthèse de la parole décente, histoires intéressantes, mécanique du jeu. Au début, il ne pouvait contrôler le jeu qu'avec l'aide de «Oui», «Non» et «Assez». Dans l'histoire, le joueur - mon seigneur, propriétaire de la terre et des paysans, tombe dans la situation "Votre Grâce! De grands gisements de cuivre ont été découverts dans nos terres fertiles! Veuillez commencer à construire une mine? Il serait possible de répondre simplement oui, mais je voudrais m'habituer au rôle et parler, comme il convient à une personne de haut niveau.

- Votre grâce! De grands gisements de cuivre ont été découverts dans nos terres fertiles! Veuillez commencer à construire une mine?

- Amour!

Le concepteur VUI a découvert ce point et a formé les compétences pour mieux comprendre les utilisateurs, leur donnant plus de liberté pour répondre.

Écrire des exemples de dialogues et diversifier les réponses du botMes collègues de Just AI écrivent des exemples de dialogue dans des tableaux. Ils sont tellement plus pratiques, mais c'est loin d'être l'option la plus pratique - pour décrire à la fois la logique et les transitions possibles. Quelqu'un écrit des scripts dans Word. Il n'y a pas de format et de règlement unique pour la description.

Les utilisateurs sont très ennuyés lorsque l'assistant commence à répéter. L'hypothèse est confirmée par Nelly Kamaeva, designer Alan AI. Lors d'un test de compétence pour les enfants, elle a vu à quelle vitesse les gars se sont désintéressés face à la même réponse.

Il vaut la peine d'envisager plusieurs répliques qui sont synonymes de sens, que l'utilisateur entendra lorsqu'il arrivera à la même étape du script. Les concepteurs de VUI recommandent d'utiliser trois à dix variations d'une même phrase.

Cherchez dans la poubelle des intentions non reconnues

"Corbeille", ou fourre-tout dans la langue des programmeurs, est l'endroit où les phrases utilisateur tombent pour diverses raisons.

"À qui je parle?" Êtes-vous un robot?!

"Tu m'as fait passer." Vous souhaitez continuer à discuter?

La phrase "je parle à quelqu'un du tout?" Êtes-vous un robot?! " tombera dans le fourre-tout (si vous ne lui avez pas fourni de script). «Tu m'as fait passer. Voulez-vous continuer la communication? " - réplique par défaut dans de telles situations. Réfléchissez à l'avance à la manière d'aider un utilisateur qui échoue dans le fourre-tout.

Pensez à la voix et au caractèreSouvenez-vous des interlocuteurs qui vous ont ennuyé. Ce n'est pas intéressant pour eux; réticence à poursuivre la conversation, nous les appelons ennuyeux. La même chose se produit lorsqu'il s'agit de compétences. Alice, Alexa et Google Assistant ont leur propre boîte à outils de la parole avec une large gamme de voix, d'accents et d'effets sonores masculins et féminins pour animer le discours du bot comme la toux et le reniflement.

Si vous voulez impressionner l'utilisateur et l'impliquer dans la conversation, bricoler le style de la parole, travailler la synthèse: arranger les stress, les pauses et les intonations. C'est un travail minutieux, mais croyez-moi, le résultat en vaut la peine. Lors d'un atelier interne, un collègue a créé une compétence pour Alexa - écoutez le fragment:

- Hé, mec. Temps horrible, oui? Tu veux te saouler? Laissez votre vieil ami Joe vous préparer une bonne boisson irlandaise. Ok

- Et maintenant, quand tu te sentiras mieux, prends ton cul effrayant et va au pub Joe's. Là, vous ne boirez jamais seul. Je t'attends.

Une autre façon de travailler avec la voix est d'enregistrer de l'audio avec des acteurs professionnels. Pour une longue et coûteuse, la flexibilité est perdue si vous voulez ajouter quelque chose au script, mais de façon spectaculaire. La compétence peut parler avec les voix de célébrités, de politiciens et de héros de films (enfin, vous pouviez déjà entendre notre

voix agissant pour le jeu Lovecraft World , mais Google Assistant parle avec la voix de John Legend, gagnant d'un Grammy -

tyk ).

Pour l'une des analyses de rentabilisation, nous avons également utilisé des enregistrements vocaux d'acteurs professionnels. Seulement 0,5% des clients ont pu soupçonner (pas même deviner, mais suspecter) que le bot leur parlait.

Utilisez des sons et des illustrations pour créer une atmosphère.

Vous pouvez récupérer des sons à partir de bibliothèques prêtes à l'emploi ou créer les vôtres (Alexa est difficile à développer des fichiers, vous devez donc bricoler avec la conversion). Dans le même jeu, «Oui, mon seigneur», pour «Alice», les sons sont utilisés pour créer une atmosphère: hennir un cheval, murmurer une foule, un rire inquiétant, une cornemuse. Et récemment dans «Alice», la compétence «Oiseaux de Russie» est apparue, où dans une conversation, vous pouvez entendre comment une alouette, un moineau ou d'autres oiseaux chantent et gazouillent.

La conception de l'interface vocale n'est pas limitée aux organigrammes et au texte sec. Le concepteur a tout pour créer des compétences qui impliquent l'utilisateur dans le processus.

Et plus de conseils de designers VUI

N'enseignez pas l'interface. La langue est une interface familière et intuitive. Pas besoin d'apprendre à parler. Il sait comment.

Mauvais - «Pour réécouter le message, dites« Écoutez encore ». Pour passer au message suivant, dites «Accéder au message suivant».

Bon - "Écoutez à nouveau le message ou passez au suivant?"

Posez des questions fermées . Je recommande d'éviter les questions ouvertes et l'extrémité ouverte des déclarations du bot, l'utilisateur doit être dirigé vers l'action.

Mauvais - «Bonjour! Je suis Symphony, un mélomane. Je suis heureux de vous recommander un album et de vous en parler. "

Bon - "Bonjour! Je suis Symphony, un mélomane. Je vous recommanderai volontiers un album et vous en parlerai. Vous voulez en savoir plus sur la piste du jour? ”

Évitez le cléricalisme. Une recommandation évidente que peu de gens suivent. Aucun de nous ne veut lire un texte complexe et surchargé, et l'écouter est d'autant plus insupportable.

Mauvais - "Il est important de garder à l'esprit que les autres albums de cet artiste deviendront platine, ce qui nous permet de conclure que ce premier album est un succès pour entrer efficacement sur la scène internationale."

Bon - «Le premier album a attiré l'attention du monde entier sur l'interprète. Ce n'est pas sans raison que ses prochains records sont devenus platine deux fois! »

Test et formation

Testez l'habileté en silence, dans la rue, dans une pièce bruyante, parlez avec différentes intonations et à différentes vitesses. Même dans les endroits les plus calmes, quelque chose peut mal tourner. Peut-être que le processus de test semblera ennuyeux pour certains, mais je vous assure que ce n'est pas le cas. La compétence a besoin d'un vrai crash test!

De l'expérience personnelle. Lors de l'un des ateliers, j'ai conçu une compétence de mise en forme: selon l'idée, Alexa a d'abord donné des instructions, puis la musique s'est allumée et la personne a répété l'exercice. J'ai tout testé avec enthousiasme sur moi-même: j'ai sauté et couru vers la musique hachée, changé la longueur des pistes, répété les exercices plusieurs fois et finalement la compétence UX m'a satisfait.

Provoquer et jurer

Les utilisateurs sont des provocateurs. Ils vérifieront la réaction de la compétence hors sujet: la compétence pour commander une pizza, et l'utilisateur - cela semble très rusé - posera des questions sur les sushis. Trouvez une réponse décente. Et maudis ton cœur. Je suis sérieux! Just AI a une liste de contrôle pour le tapis utilisé dans les tests.

Parlez et écoutez

Dites tout ce que vous proposez. Écoutez avec vos oreilles tout ce que l'utilisateur entendra. Demandez à vos collègues de lire et même de jouer le script. Enregistrer le discours, revenir aux enregistrements, expérimenter.

Former la compétence

Mais la première fois, vous ne prévoyez pas tout dans la compétence. Acceptez-le et humiliez-vous. Votre compétence nécessitera une formation supplémentaire. Lisez les dialogues et analysez les journaux. Comment faire cela en utilisant Python, dans l'une des éditions d'Alice’s School, explique Daria Serdyuk, ingénieur de recherche PNL Just AI.

Outils de conception

Papier, crayon ou marqueur - rien de mieux n'a été inventé pour commencer le travail ou transmettre rapidement une idée à une équipe ou à un client. Mais il existe des outils plus avancés qui simplifieront la vie professionnelle du concepteur d'interface vocale et aideront à réaliser l'idée.

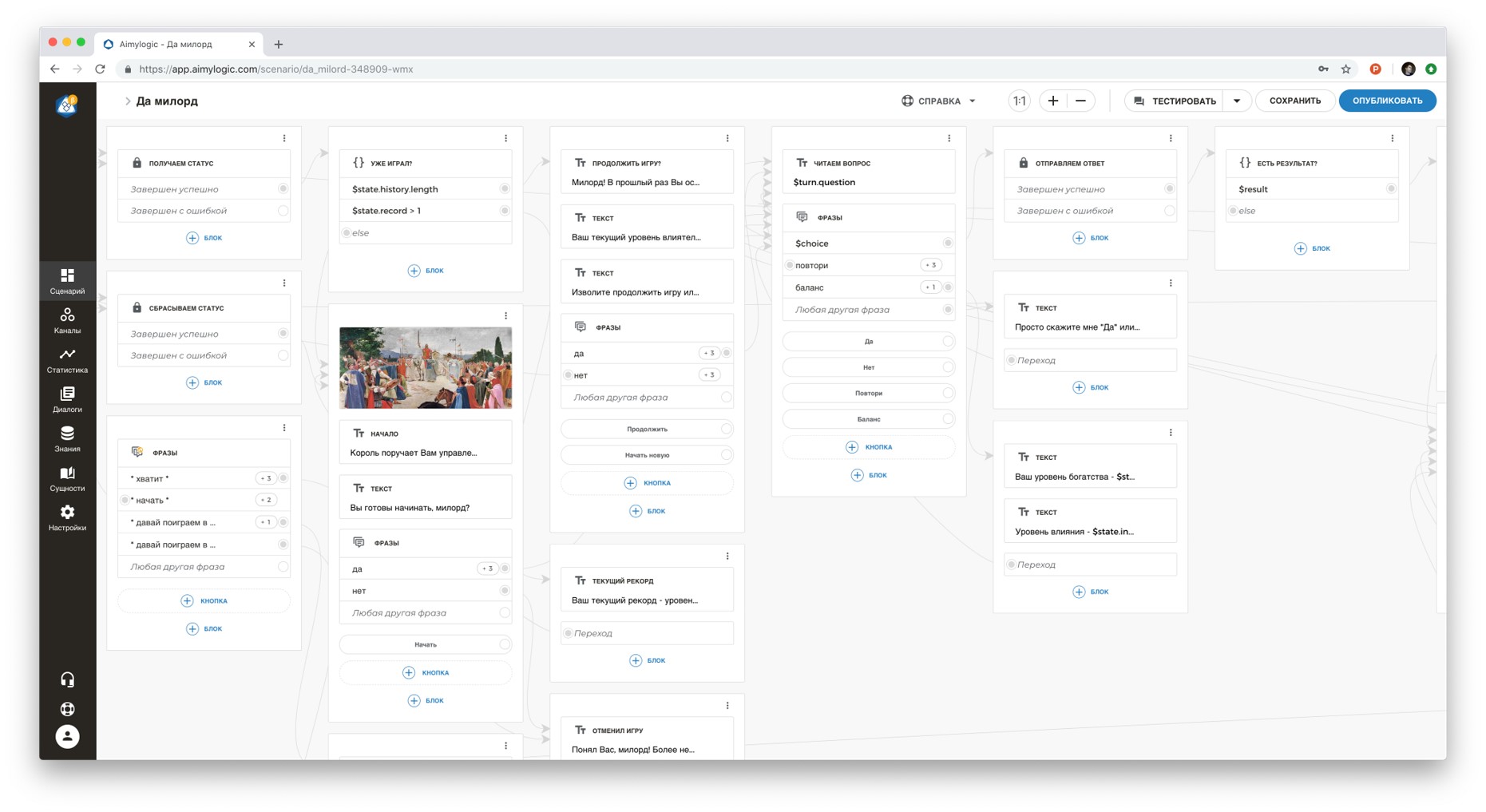

AimylogicConstructeur avec un moteur NLU (compréhension du langage naturel). Plus de 10 mille utilisateurs et plus de 1100 compétences pour les assistants vocaux avec une audience totale de 1 million d'utilisateurs. Il y a un abonnement gratuit et une période de démonstration gratuite pour les abonnements payants.

Dans le concepteur, vous pouvez créer un script, le tester et le connecter à plus de dix canaux (Alice, Google Assistant, Telegram, VKontakte et autres). Il existe un support technique et une communauté à Telegram. Voici quelques exemples de compétences vocales:

Tortu.ioOutil de prototypage rapide. Vous créez littéralement un dialogue entre l'utilisateur et le système par étapes sur un diagramme, puis testez à l'aide d'un prototype. Convient pour les tests WoZ et les tests d'hypothèse rapides.

VoiceflowGraphiste Alexa Skills. Vous permet de créer des compétences Alexa sans compétences en programmation. Convient pour les tests UX.

Flow.aiOutil graphique pour créer des chatbots. Vous permet de créer des bots sans compétences en programmation. Convient également pour les tests UX.

Matériaux pour le pompage

La psychologie et l'expérience réelle des utilisateurs d'assistants vocaux sont très différentes de celles auxquelles nous sommes habitués sur le Web ou dans l'environnement mobile. Mais la conception vocale est intéressante car c'est un domaine nouveau et encore peu exploré dans lequel vous pouvez faire de nombreuses découvertes et percées.L'expérience et les matériaux des concepteurs VUI mentionnés dans l'article ont été utilisés avec leur consentement.

Remerciements:Dmitry Chechetkin , co-fondateur et responsable des projets stratégiques, Just AI.Daria Serdyuk , ingénieur de recherche PNL, Just AI.Paul Gwai , fondateur de Tortu.io.Nelly Kamaeva , conceptrice de produits, Alan AI.