À la fin de l'année dernière, après un accord avec Rostelecom, nous avons reçu à notre disposition une plate-forme SD-WAN / SDN basée sur le cloud pour fournir des services IB aux clients. Nous nous sommes connectés aux fournisseurs de projets fournissant leurs solutions sous une forme virtualisée, et nous avons obtenu un énorme colosse, que nous avons appelé la plate-forme de services de cybersécurité unifiée, ou EPSC. Sa principale caractéristique est la fourniture de technologies de sécurité à partir du cloud avec la possibilité d'une gestion centralisée: le déploiement et la modification d'une fonction réseau unique ou d'une transformation globale dans tous les bureaux desservis ne prennent que quelques minutes. Aujourd'hui, nous vous en dirons plus sur son architecture et son "bourrage".

Mais avant de vous mettre sous le capot, quelques mots sur ce que l'EPSC sait réellement. La plate-forme comprend des services: protection des e-mails (Secure Email Gateway, SEG) et applications Web (Web Application Firewall, WAF), prévention des intrusions sur le réseau (Unified Threat Management, UTM) et Anti-DDoS. Tous peuvent être utilisés simultanément et séparément - ici à chacun selon ses besoins.

Enveloppez-moi de trafic, s'il vous plaît. Principes de travail

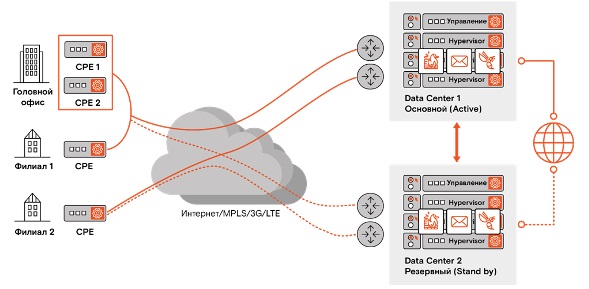

En général: des dispositifs de routage CPE (Customer Premises Equipment) sont installés sur tous les sites clients. CPE fournit un tunnel sécurisé à nos centres de données - à la plate-forme EPSC. Ainsi, seul le trafic dégagé sur notre équipement de sécurité périmétrique parvient au client. Dans le même temps, grâce au SD-WAN et à la tunnellisation, le processus d'acheminement du trafic vers notre plateforme ne dépend pas du réseau de quel fournisseur le client utilise.

Architecture de plateforme

L'infrastructure physique de l'EPSC est constituée de serveurs x86 ordinaires avec des machines virtuelles déployées sur eux, des commutateurs et des routeurs. Le fait est que vous pouvez gérer cette richesse de manière flexible et centralisée. Et ici, deux mots magiques viennent à notre aide - VNF et MANO.

VNF (Virtualized Network Function) sont des fonctions réseau fournies aux utilisateurs finaux (UTM, SEG et WAF). MANO (Management and Orchestration) - un ensemble d'outils pour gérer le cycle de vie des fonctions virtualisées. Ces outils offrent simplement cette centralisation et une orchestration flexible, ce qui vous permet d'apporter des modifications à une vitesse fondamentalement différente.

Et maintenant plus en détail.

Au bord de chaque centre de données se trouve un routeur Nokia 7750 SR-12 avec un débit de 400 Gb / s - il fournit un routage sur le périmètre et à l'intérieur du cloud. À un niveau inférieur se trouvent les commutateurs Juniper 5100 Spine avec des ports 40 Gb / s, regroupant tous les composants réseau des couches inférieures.

Un réseau virtuel comprend deux segments: SD-WAN, qui connecte l'environnement cloud aux sites clients, et SDN DC, un réseau défini par logiciel à l'intérieur du cloud lui-même, via lequel les ports, l'adressage IP, etc. sont configurés. lors de la création d'une chaîne de services.

La partie serveur comprend les serveurs de gestion de plateforme cloud CloudBand, les serveurs de gestion SDN, les serveurs de gestion SD-WAN (VSD, VSC) et NSG-BR (routeurs virtuels qui terminent IPsec sur les tunnels clients VXLAN) ou VXLAN, selon le si le cryptage IPsec.

L'adressage IP blanc pour le trafic client est implémenté sur la base de 2 sous-réseaux avec un masque / 22 (1018 adresses dans chaque sous-réseau): l'un d'eux est routé vers Internet, l'autre vers RSNet.

Tolérance aux pannes

Toute l'infrastructure cloud est réservée sur la base de deux centres de données géographiquement distants à Moscou, qui fonctionnent en mode actif-veille. De plus, toute chaîne de services (un ensemble de fonctions pour un client particulier) est déployée dans chacun d'eux en tant que cluster. En cas d'urgence, lors du passage d'un nœud à un autre, seuls 10 paquets environ sont perdus. Étant donné que des personnes stupides ont créé TCP, la perte ne sera pas perceptible.

À l'avenir, nous prévoyons une expansion géographique au-delà de l'Oural afin de réduire les délais de transmission des données pour les régions. Cependant, pour aujourd'hui, même pour Khabarovsk, les retards ne sont que d'environ 200 ms - les clients jouent assez bien sur Steam et regardent des vidéos de YouTube (à partir d'un véritable avis sur le service ).

Dans un avenir proche, il sera possible de connecter un CPE à deux WAN indépendants. Le canal peut être MPLS, Ethernet (cuivre ou optique selon le CPE utilisé), modem USB LTE, etc. Par exemple, le canal principal peut être à fibre optique et le canal de secours peut être sans fil (car personne n'est à l'abri de l'excavatrice du destin et des fils endommagés). Actuellement, il est possible d'utiliser deux WAN, mais uniquement lors de l'utilisation de deux CPE dans un cluster HA.

Chaînes de service

Le client sélectionne les paramètres de base via le LC et commence la formation de la chaîne de service: les interfaces réseau sont automatiquement augmentées, les adresses IP sont attribuées et les images VNF sont pompées, en fonction de la bande passante sélectionnée. Par exemple, si vous avez commandé FortiGate Firewall pour 300 Mbit, 4 cœurs, 8 Go de RAM vous seront automatiquement alloués, une certaine quantité d'espace disque et l'image sera automatiquement déployée dans une configuration de 0 jour.

Les performances de notre plate-forme sont désormais conçues pour 160 chaînes de service de 1 Gbit chacune, et il est prévu d'étendre jusqu'à 1000 chaînes de service de 50 Mbit chacune (car les chaînes de 1 Gbit seront beaucoup moins populaires, selon notre évaluation du marché).

CPE - mieux mince, oui plus?

En fait, pour notre service, nous avons choisi des CPE «minces» basés sur Nokia NSG-C et NSG-E200. Ils sont subtils uniquement parce qu'ils ne peuvent pas exécuter de VNF tiers, mais sinon ils ont toutes les fonctionnalités nécessaires pour établir une communication entre les sites, un tunnel (IPsec et VPN), cependant, des solutions d'autres fabricants peuvent être utilisées pour cette tâche. Il existe également des listes de contrôle d'accès (ACL) pour le filtrage: une partie du trafic peut être libérée localement, et une partie peut être envoyée pour un nettoyage fin au centre de données EPSC, où les fonctions virtuelles WAF, UTM et SEG sont implémentées.

En outre, l'appareil peut effectuer un routage adapté aux applications (AAR), c'est-à-dire hiérarchiser la bande passante en fonction du type de trafic à l'aide des mécanismes Deep Packet Inspection (DPI). Dans le même temps, les réseaux fixes et mobiles ou leur combinaison pour un trafic différent peuvent être utilisés comme canaux de communication.

L'activation CPE est basée sur le principe du provisionnement sans contact. Autrement dit, tout est élémentaire: nous connectons le CPE à Internet, nous connectons un ordinateur portable à partir de l'interface Ethernet interne, cliquez sur le lien d'activation, puis allumez notre LAN au lieu de l'ordinateur portable et tout fonctionne. De plus, dans notre cloud, le tunnel IPsec sur VXLAN augmente par défaut (c'est-à-dire que l'espace d'adressage est d'abord isolé, puis tunnelé).

En général, l'option avec un CPE fin nous semble plus pratique. Avec cette approche, le client est épargné d'un éventuel blocage du fournisseur et peut adapter la solution à tout moment, sans buter sur l'épaisseur du CPE (50 Mbps).

Dans le cas d'un CPE épais, il implémente également, entre autres, les fonctions virtuelles sélectionnées par le client, et dans le centre de données EPCC il n'y a que la gestion de la chaîne de service. L'avantage de cette approche est que tout le trafic est traité localement. Dans le même temps, le coût d'un tel appareil est beaucoup plus élevé, et vous ne pouvez pas faire plus d'un service spécifique sur celui-ci - vous devez acheter des CPE supplémentaires. Oui, et vous pouvez oublier les fournisseurs multiples.

Mais si le client a une plate-forme assez grande (bureau, agence) qui passe beaucoup de trafic à travers lui-même (plus de 200 Mbit / s), et qu'il veut tout filtrer localement, alors il est logique de prêter attention à la série CPE Nokia NSG E300 (et plus) c Bande passante de 1 à 10 Gbit / s prenant en charge la virtualisation (VNF).

Par défaut, SD-WAN rassemble tous les sites du client dans un réseau maillé complet, c'est-à-dire qu'il les connecte ensemble selon le principe «chacun avec chacun» sans filtrage supplémentaire. Cela réduit les retards dans le périmètre interne. Cependant, il est possible de construire des topologies plus complexes (étoile, étoile complexe, grilles multi-rangs, etc.).

Fonctionnement

Tous les VNF qui sont dans le cloud sont actuellement disponibles dans la doctrine MSSP classique, c'est-à-dire qu'ils sont sous notre contrôle. À l'avenir, les clients auront la possibilité de gérer ces services de manière indépendante, mais il est important d'évaluer judicieusement leurs compétences.

Certaines fonctions simples sont désormais partiellement automatisées. Par exemple, dans Secure Mail Gateway, une stratégie est configurée par défaut, dans laquelle l'utilisateur reçoit une liste de messages potentiellement liés au spam une fois par jour et peut décider lui-même de son sort.

Certains problèmes et vulnérabilités globaux surveillés par notre JSOC seront rapidement fermés, y compris pour les clients de l'EPSC. Et ici, la possibilité d'une gestion centralisée des politiques et des signatures est exactement ce dont nous avons besoin - cela protégera les clients contre les infections comme Petya, NotPetya et d'autres.

Des réponses honnêtes à des questions délicates

En fait, bien que nous croyions beaucoup aux avantages du modèle de service, il est clair que pour beaucoup le concept du système de courrier électronique est trop inhabituel. Ce qu'on nous demande le plus souvent:

- FortiGate se trouve dans votre centre de données, c'est-à-dire, verrez-vous notre trafic?- Non, nous ne voyons pas de trafic. FortiGate le reçoit sous forme cryptée, le déchiffre avec la clé du client, le vérifie et le traite avec un antivirus de flux, le recrypte avec la même clé, puis l'envoie à votre réseau. Nous n'avons aucune option à caler dans ce processus (à moins de s'engager dans la rétro-ingénierie des solutions infobases dures, mais c'est trop cher ).

- Est-il possible de sauvegarder notre segmentation réseau lors du passage au cloud?- Et ici, il y a une limitation. La segmentation du réseau n'est pas une histoire trouble. UTM est un pare-feu de limite du réseau d'un client sur lequel la segmentation ne peut pas être effectuée, c'est-à-dire que vos données vont vers l'extérieur sur un seul canal. Dans un sens, vous pouvez segmenter le réseau à l'intérieur de l'ACL sur le CPE en définissant différentes restrictions pour différents sites. Mais si vous avez des applications métier qui doivent interagir différemment les unes avec les autres via le pare-feu, vous devrez toujours utiliser un FW distinct pour la segmentation interne.

- Qu'adviendra-t-il de nos adresses IP lors du passage au cloud?- Dans la plupart des cas, vous devrez remplacer vos adresses IP blanches par les nôtres. Une exception est possible si vous avez un fournisseur de système autonome non indépendant (PI AS), qui vous est attribué, qui peut être annoncé de nouveau par nous.

Parfois, il est plus logique de choisir une option complexe - par exemple, laisser le trafic utilisateur via UTM et libérer d'autres segments de réseau directement sur Internet.

- Et si vous avez besoin de protéger un site hébergé par un fournisseur externe?- CPE n'y met pas. Vous pouvez connecter WAF en modifiant l'enregistrement ADNS: changez l'IP du site en IP de la chaîne de service, puis le trafic passera par notre cloud sans l'aide de CPE.

Si vous avez d'autres questions, écrivez dans les commentaires, et nous essaierons d'y répondre