Les analyses de produits sur Habré ne sont pas si souvent écrites, mais les publications, et les bonnes, apparaissent avec une régularité enviable. La plupart des articles sur l'analyse de produits ont été publiés au cours des deux dernières années, et cela est logique - après tout, le développement de produits devient de plus en plus important pour l'informatique et les entreprises, seulement indirectement lié aux technologies de l'information.

Ici, sur Habré,

un article a été publié dans lequel les attentes de l'entreprise d'un analyste produit étaient bien décrites. Un tel spécialiste devrait, d'une part, rechercher et trouver des points prometteurs de croissance des produits, et d'autre part, identifier et confirmer l'urgence du problème en le formulant et en le mettant à l'échelle. Vous ne pouvez pas dire plus précisément. Mais l'analyse des produits évolue, de nouveaux outils de travail et des tendances apparaissent qui aident les analystes de produits à travailler. Juste au sujet des tendances, par rapport au travail des applications et services mobiles, nous parlerons dans cet article.

Collecte de données personnalisées

Désormais, les données qui permettent à l'entreprise d'améliorer son travail en mettant en œuvre une approche personnalisée du service client sont collectées par tous - des sociétés Internet comme Google aux détaillants comme Walmart.

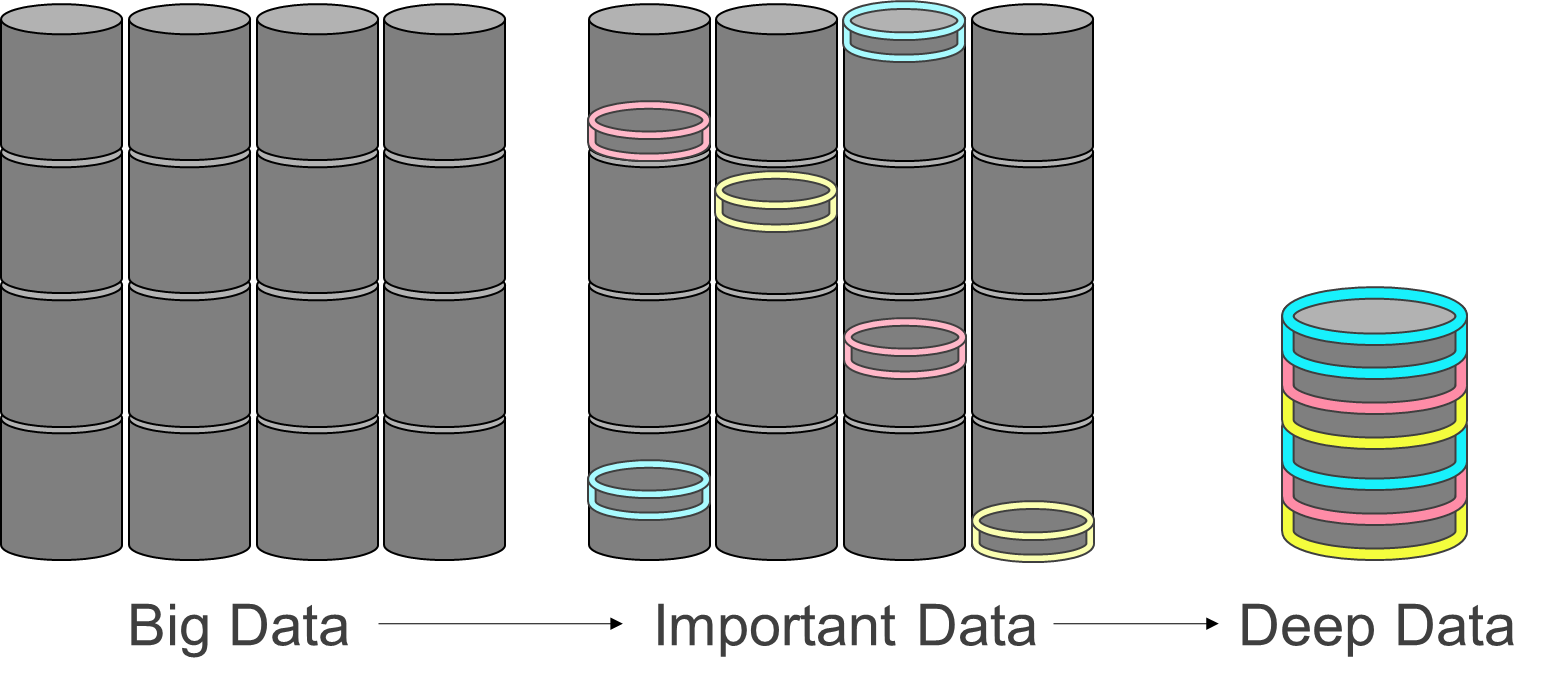

Ces informations concernent non seulement les clients, mais également les conditions météorologiques pouvant affecter le travail de l'entreprise, la taille moyenne des chèques, les préférences des clients, la dynamique des achats de certaines marchandises, l'encombrement des points de vente, etc. Mais le problème est qu'il y a de plus en plus de données, et il est très difficile pour les entreprises de séparer les informations essentielles des informations non essentielles.

Vous pouvez collecter des pétaoctets de données, puis il s'avère qu'une entreprise n'a besoin que d'une petite fraction des informations collectées pour améliorer ses performances. Tout le reste est du «bruit blanc», ce qui n'aide en rien à avancer. Trouver les bonnes données, c'est de plus en plus comme trouver une aiguille dans une botte de foin. Seule une pile de la taille d'un iceberg, et l'aiguille est mince et très petite.

Tout type d'entreprise a besoin d'un outil qui vous permet de clarifier les exigences clés pour les données collectées. La collecte de données doit être réglée là où des problèmes sont attendus, car «là où ils sont minces, ils se cassent». En conséquence, un tel outil devrait identifier les critères les plus pertinents et les plus importants et effectuer une recherche avec leur aide.

La restriction des données collectées permet de réduire les coûts de collecte, de stockage et de traitement des informations. Les méthodes de travail actuelles conduisent souvent au fait que la plupart des données «accumulent simplement la poussière» sur les disques durs pendant des années.

Comme une tendance importante, l'introduction de systèmes de collecte de données «intelligents» - trackers, sur lesquels les retours des résultats des analyses «approximatives» sont présentés est présentée. Une telle approche à grain grossier, qui dans sa logique est similaire aux systèmes hybrides QM / MM dans la modélisation moléculaire de grandes protéines ou des algorithmes de compression d'image fractale: une grande image approximative du chemin de l'utilisateur est analysée par un pipeline rapide et il y a des bords (transitions entre événements) avec le plus grand potentiel d'analyse, de tels bords sont divisés par le tracker en événements plus petits, et la collecte de données en conséquence est constamment adaptée à la précision d'analyse requise et à la tâche analytique ultime.

La même approche avec des retours d'expérience sur la collecte et le stockage des données peut être utilisée pour les «données autonettoyantes», lorsque nous ne stockons pas trop, nous utilisons des bases de données compactes rapides pour les données brutes (Greenplum DB, Clickhouse) et de grandes et lentes pour les données détaillées (Apache Kafka) , en outre, nous cessons de stocker des données communes à tous, rassemblant les segments comportementaux des utilisateurs et préservant séparément leurs modèles de préférence.

Accélération de la rétroaction et analyse prédictive

Il est temps de parler de rétroaction d'une nature plus fondamentale - l'analyse elle-même est une rétroaction qui régule la façon dont l'entreprise travaille avec ses clients.

Pour le fonctionnement normal de toute entreprise disposant d'une application ou d'un service mobile, un retour d'informations est nécessaire qui vous permet d'identifier les problèmes et de les résoudre en recherchant des hypothèses sur les solutions possibles et en exécutant des tests.

Le délai de rétroaction doit être réduit au minimum. Il y a deux façons de le faire.

Utilisez des mesures prédictives plutôt que des mesures historiques. Dans ce cas, la vitesse la rétroaction, de sorte que l'utilisateur ne sera ou non pas attendre que le client, arriver à un but précis pour commencer à corriger la situation. La méthode vous permet de prédire, sur la base de modèles basés sur des données historiques, avec quelle probabilité un client particulier atteindra quels écrans et boutons de l'application, ou des objectifs externes - achats de produits, appels au service commercial, etc. Pourquoi cette entreprise? Pour être en mesure d'influencer le sort d'un client particulier ou de nouveaux clients similaires le plus rapidement possible. Le second est particulièrement important pour redistribuer rapidement les budgets des canaux publicitaires - si un canal change soudainement le type de clients livrés, vous pouvez modifier son budget sans attendre les dernières actions - commandes ou inversement désabonnements, refus.

L'accélération peut souvent être obtenue simplement en remplaçant les mesures réelles par ce qui peut être prévu. Un autre point positif est que le modèle est calibré sur toutes les données, donc si vous utilisez les informations actuelles que vous venez de recevoir, il est possible d'améliorer la prédiction. Un tel modèle sera constamment mis à jour et les dépôts de données pour la formation de métriques historiques ne seront tout simplement pas nécessaires.

Un exemple est la situation où nous créons une interface dynamique pour un service ou une application. Et divers éléments d'interface, par exemple des boutons, apparaissent selon ce que l'on sait de l'utilisateur.

Un autre exemple est le travail d'un assistant vocal et l'achat de billets d'avion. Les assistants numériques existants doivent être considérablement améliorés, tout d'abord - la personnalisation. Donc, si vous essayez de réserver un billet en utilisant Siri, il affichera une vaste sélection d'options disponibles. Mais ici, la personnalisation est nécessaire, de sorte qu'à la fin, l'assistant affiche 2-3 options appropriées, pas plus. Et l'analyse prédictive est un moyen d'atteindre ce que vous voulez, car vous pouvez poursuivre les intentions du client sans le forcer à lire (dans ce cas, il est important de ne pas confondre cette méthode avec ML pour la reconnaissance vocale, l'analyse prédictive discutée fonctionnera au-dessus des événements à partir des mots du client déjà reconnus dans le texte). )

Accélération des tests sur les segments. Les résultats de l'analyse des produits d'une entreprise sont généralement testés sur l'ensemble du public d'une entreprise ou d'un service. Mais il est beaucoup plus efficace d'effectuer des tests sur des segments individuels, précisément ceux où le problème a été observé.

Soit dit en passant, il existe une méthode intéressante, qui peut être appelée «bandit manchot contre les tests A / B». Pourquoi un "bandit manchot"? Dans n'importe quel casino, il y a ces machines à sous, et toutes ces machines sont configurées différemment dans la même institution. Pas toujours, mais plus souvent. Imaginez que nous voulons identifier un "bandit" qui distribue la victoire plus souvent que les autres. Pour ce faire, nous commençons à tester toutes les machines. Mais là où le gain est un peu plus - nous allouerons plus de pièces pour le jeu. L'avantage de ce schéma est que les segments de test individuels peuvent être exécutés en parallèle, et les résultats réussis sont extrapolés à tous les autres segments, et une optimisation continue est obtenue au lieu de tester avec contrôle.

La méthode du «bandit à un bras» peut être utilisée en pratique lors du test d'une application mobile. Ainsi, différentes interfaces / écrans sont présentés à différents segments d'utilisateurs, et le segment de contrôle est également laissé, ce qui permet à l'apprentissage par renforcement au robot et à l'analyste qui le regarde, d'évaluer l'interaction des utilisateurs de différents segments avec différents écrans. Dès que la situation se clarifie, une recherche réussie est formulée comme un raffinement de l’application entière, ou une personnalisation est effectuée, partageant les fonctionnalités de l’application pour différents segments. Les modèles utilisateur et les modèles d'interaction utilisateur avec les applications peuvent être différents. En utilisant des intégrations abstraites (screen2vec par analogie avec word2vec), le modèle peut être construit sur une application et appliqué, quoique avec des limitations, sur la seconde. Cela permet de transférer des informations analytiques entre différentes versions, plates-formes, versions et même des applications affiliées. Bien sûr, il est nécessaire de contrôler l'applicabilité des modèles des autres, afin de ne pas se tirer une balle dans le pied.

Automatisation des commentaires

Afin de réduire légèrement le temps de boucle de rétroaction, vous pouvez essayer de développer des éléments d'application automatiques et autonomes ou des microservices analytiques en temps réel. Cela capte particulièrement l'imagination - les boutons et les éléments d'interface eux-mêmes pourraient évaluer le comportement des utilisateurs et l'influence de divers facteurs sur l'ensemble du parcours utilisateur et de ses paramètres commerciaux - conversion, vérification moyenne, engagement et rétention. Cela ouvre la possibilité, sans intervention humaine, de déterminer la valeur des éléments individuels en termes d'augmentation des commandes ou de fidélisation de la clientèle, et les étapes individuelles de l'analyse ne sont tout simplement pas utilisées, car le processus est automatisé. Les boutons s'ajustent eux-mêmes, ayant retransmis les signaux des autres boutons du parcours utilisateur et du contrôleur central, ils optimisent constamment leur comportement.

À un certain niveau, ce moment peut être comparé à l'autorégulation de l'activité vitale d'un organisme vivant. Il a des agents indépendants - des cellules individuelles qui permettent à tout le corps de s'autoréguler. En ce qui concerne les applications, on peut imaginer une situation où l'écosystème de composants d'interface se régule mutuellement, lisant les chemins des utilisateurs et échangeant des informations importantes, telles que les segments et les types d'utilisateurs et leur expérience d'interaction avec les utilisateurs dans le passé. Nous appelons un tel ensemble de composants intelligents des agents intellectuels axés sur les affaires et maintenant, sur la base de nos recherches, nous collectons un prototype expérimental de cette approche. Probablement la première fois, il jouera une fonction purement de recherche et nous inspirera, ainsi que d'autres équipes, à développer un cadre à part entière compatible avec les plates-formes de création d'interfaces communes - React JS, Java, Kotlin et Swift.

Jusqu'à présent, il n'y a pas une telle technologie, mais son apparence peut être attendue non seulement de nous littéralement tous les jours. Il ressemblera très probablement à un framework ou à un SDK pour l'interface UI prédictive. Nous avons démontré une technologie similaire sur Yandex Data Driven 2019 en utilisant l'exemple d'une modification d'application Kickstarter, quand sur un client un modèle sérialisé considérait la probabilité de perte de l'utilisateur et des éléments d'interface rendus conditionnellement en fonction de celui-ci.

À quoi ressembleront les analyses de produits dans 20 ans? En fait, maintenant l'industrie elle-même, où tout ou presque tout se fait manuellement, est dépassée. Oui, de nouveaux outils peuvent augmenter l'efficacité du travail. Mais tout de même, tout cela est trop lent et lent, dans les conditions modernes, vous devez travailler plus vite. La détection et la correction des problèmes à l'avenir devraient se faire de manière autonome.

Il est probable que les applications «apprennent les unes des autres». Ainsi, par exemple, une application qui est utilisée une fois par mois pourra adopter des modèles d'utilisateur pertinents pour elle et leurs préférences pour les intégrations CJM à partir d'une autre application utilisée quotidiennement. Dans ce cas, la vitesse de développement de la première application peut augmenter considérablement.

A l'intérieur des analyses, de bonnes tâches pour automatiser Pipeline d'analyse est encore très faible, presque partout les analystes se battent avec des données erronées ou des marques clairement définis les objectifs d'affaires. Mais peu à peu, comme la pénétration du développement dans l'application d'analyse au sein des analystes ML strictement pour résoudre des problèmes analytiques, ainsi que la numérisation du transfert des ressources humaines et plus précise des objectifs et des tâches entre les départements, paysage d'analyse de produit commence à changer de façon spectaculaire et des tâches spécifiques sera automatisé. Et l'échange d'informations et de méthodes se transformera en un échange de code et la mise en place d'agents autonomes agissant comme une interface flexible pour l'utilisateur et optimisant le robot d'entreprise pour l'entreprise. Bien sûr, tout cela ne viendra pas bientôt, mais l'avenir est déjà là, donc l'avenir même de l'analyse de produits est quelque part à proximité.