L'idée de l'intelligence artificielle inquiète depuis longtemps l'humanité. Les automates ont reçu beaucoup d'attention dans les mythes de la Grèce antique, et l'exemple le plus célèbre est la femme artificielle Pandora, créée par Zeus. Les golems mystiques se trouvent dans la culture juive. Et les étonnantes poupées karakuri occupent une place importante dans l'épopée japonaise.

Au 17e siècle, certains philosophes ont réfléchi à la possibilité de «mettre l'esprit» dans des objets inanimés. De nombreuses théories ont été avancées. Par exemple, René Descartes croyait au dualisme de l'esprit et du corps. Ses vues rejetaient la possibilité d'une mécanisation de l'intelligence.

Leibniz avait d'autres vues. Il croyait que toute pensée humaine pouvait être représentée mathématiquement à l'aide de symboles élémentaires. Pour cela, il a proposé Characteristica Universalis, la symbolique des concepts nécessaires à la description des connaissances.

L'intelligence artificielle et les automates figurent dans la fiction depuis des temps immémoriaux. Un exemple est le "Frankenstein ou Prométhée moderne" de Mary Shelley et les "Rossum Universal Robots" de Karel Chapek. Grâce à eux, en 1921 le mot "robot" est apparu dans la littérature.

Telles étaient les conditions philosophiques préalables à l'émergence de l'IA. Parlons maintenant de scientifiques spécifiques et de leurs travaux, grâce auxquels l'intelligence artificielle de la fiction est devenue une réalité. Une histoire relativement concrète et factuelle a commencé relativement récemment. Le célèbre test de Turing a été effectué pour la première fois en 1950, mais seulement six ans plus tard, en 1956, l'IA a commencé à se former en tant que discipline distincte. Voyons comment c'était.

Premiers pas

Le nombre d'articles scientifiques liés à l'intelligence artificielle a fortement augmenté dans les années 50 et 60. Mais auparavant, des études ont touché ce sujet. Bertrand Russell et Alfred North Whitehead ont publié Les principes des mathématiques en 1913. À peu près au même moment, George Bull a présenté ses lois de la pensée . Les bases de la logique mathématique ont donc été posées.

Peut-être que tout a commencé au moment où un garçon de 15 ans incompréhensible a fait irruption dans le bureau de Rudolf Karnap. Karnap est alors déjà devenu un philosophe influent et a enseigné à l'Université de Chicago. Il a publié La syntaxe logique de la langue. Le garçon est venu sans permission et a indiqué des erreurs dans ce travail. Rudolph a été choqué. Le visiteur était inhabituel. De plus, il ne s'est même pas présenté et s'est immédiatement enfui. Après des mois de recherches, Rudolph a finalement trouvé son visiteur dans une université locale. Il s'est avéré que c'était Walter Harry Pitts .

Trois ans auparavant (oui, à 12 ans), Walter a écrit une lettre à Bertrand Russell, soulignant les problèmes rencontrés dans les Principes susmentionnés. Russell était tellement impressionné qu'il a invité le garçon à terminer ses études à l'Université de Cambridge au Royaume-Uni. Walter, bien qu'il ait grandi dans une famille dysfonctionnelle, n'a pas osé quitter Detroit. Cependant, lorsque Russell est arrivé à Chicago pour donner des conférences, Pitts s'est enfui pour étudier avec lui. Il n'est pas devenu étudiant à l'Université de Chicago, mais il a assidûment suivi des cours. (La vie de Walter Pitts est généralement très lumineuse et intéressante, malgré sa courte durée. Je vous recommande de lire par vous-même - environ Traducteur ).

En 1942, Walter Pitts a rencontré Warren McCallock . McCullock a invité Pitts à rester chez lui. Ils étaient convaincus de l'exactitude de la théorie de Leibniz , qui suggérait la possibilité d'une "mécanisation" de la pensée humaine. Et ils ont essayé de créer un modèle pour la neurobiologie du système nerveux humain. Ils ont publié leur article principal sur le même sujet en 1943, le qualifiant de " calcul logique des idées liées à l'activité nerveuse ". Ce document a apporté une contribution inestimable au domaine de l'intelligence artificielle. Les scientifiques ont proposé un modèle simple connu sous le nom de neurone mathématique McCullock-Pitts . Elle étudie toujours dans des cours d'apprentissage automatique. Les idées que les scientifiques ont proposées sont le fondement de presque toutes les IA modernes.

Warren McCallock et Walter Pitts

La cybernétique de Norbert Weiner et la théorie de l'information de Claude Shannon ont été publiées en 1948. La cybernétique est une étude du «contrôle et de la communication dans un organisme vivant et dans une machine». La théorie de l'information consiste à mesurer la quantité d'informations, leur stockage et leur transmission. Les deux travaux ont eu un grand impact sur l'IA.

La cybernétique a fourni une étude directe de l'intelligence biologique et mécanique. Et la théorie de l'information a influencé les mathématiques de base.

Après quelques années, Alan Turing a effectué le test de Turing . Il a décrit une méthode pour déterminer si une machine est intelligente. Le test simplifié est le suivant: une personne communique avec un ordinateur et une personne. Sur la base de leurs réponses aux questions, il doit déterminer à qui il parle: une personne ou un programme informatique. La tâche d'un programme informatique est d'induire une personne en erreur, la forçant à faire le mauvais choix. »

Bien que le test de Turing soit trop limité pour tester des systèmes intelligents modernes, il s'agissait à l'époque d'une véritable percée. Le nom d'Alan Turing a frappé la presse, rendant l'industrie plus populaire.

Test de Turing

En 1956, une conférence a eu lieu à Dartmouth sur le thème de l'étude des concepts de «mécanisation» de l'intelligence. Plus tard, les participants à cette conférence deviendront des personnalités exceptionnelles dans le domaine de l'IA. Le plus célèbre était Marvin Minsky , qui a créé en 1951 la première machine de réseau neuronal, SNARC. Il deviendra le nom le plus célèbre du monde de l'intelligence artificielle dans les prochaines décennies.

Claude Shannon a également assisté à la conférence. Et le futur lauréat du prix Nobel Herbert A. Simon et Allen Newell ont fait leurs débuts avec leur « Logic-Theorist ». Par la suite, il résoudra 38 des 52 premiers théorèmes des principes de mathématiques de Russell.

John McCarthy - également l'un des pionniers de l'intelligence artificielle - a inventé le nom «Intelligence artificielle». Les participants ont approuvé ce terme. Ce fut la naissance de l'IA.

Développement de l'industrie (1956-1974)

Réseau sémantique

Grâce à cette conférence, l'intérêt pour l'IA a grandi et de nombreux développements intéressants sont apparus. En 1959, Newell et Simon ont créé le «Common Problem Solver», qui pourrait théoriquement résoudre tout problème formalisé. Et James Slagle a créé un programme heuristique SAINT (Symbical Automatic INTegrator) qui a résolu les problèmes d'intégration symbolique dans le calcul. Ces programmes étaient impressionnants.

Après avoir créé le test de Turing, le naturel de la langue est devenu un domaine important de l'IA. Le programme ÉTUDIANT de Daniel Bobrow a pu résoudre des problèmes de mots au lycée. Un peu plus tard, le concept de réseau sémantique est apparu - une carte des différents concepts et des relations entre eux (comme sur la figure). Plusieurs programmes réussis ont été construits sur ce réseau. En 1966, Joseph Weisenbaum crée ELIZA. Un interlocuteur virtuel pourrait mener des conversations réalistes avec les gens.

Dans le cadre d'un développement si actif de l'industrie de l'IA, les scientifiques ont fait des déclarations extrêmement audacieuses:

- Newell et Simon, 1958: "Dans 10 ans, l'ordinateur numérique deviendra le champion du monde d'échecs." Et "d'ici 10 ans, un ordinateur numérique découvrira et prouvera un nouveau théorème mathématique important".

- Simon GA, 1965: «Les machines seront capables d'effectuer n'importe quel travail qu'une personne peut faire pendant 20 ans.»

- Marvin Minsky, 1967: "Dans une génération ... le problème de la création de" l'intelligence artificielle "sera résolu de manière substantielle."

- Marvin Minsky, 1970: «Dans trois à huit ans, nous aurons une machine avec l'intelligence générale d'une personne ordinaire.»

D'une manière ou d'une autre, l'argent est entré dans l'industrie. Le Bureau des projets de recherche avancée (ARPA, renommé plus tard DARPA) a alloué 2,2 millions de dollars à l'équipe du MIT. Le président de l'époque de la DARPA a décidé qu'ils devaient «financer les gens, pas les projets» et a créé une culture de la recherche libre. Cela a permis aux chercheurs de réaliser tous les projets qu'ils jugeaient corrects.

Refroidissement temporaire (1974-1980)

En 1969, Marvin Minsky et Seymour Papert publient leur livre Perceptrons . Dans ce document, ils ont montré les limites fondamentales des perceptrons et ont souligné l'incapacité des perceptrons à contrôler le schéma élémentaire XOR. Cela a conduit à un déplacement de l'intérêt des chercheurs en intelligence artificielle vers le domaine de l'informatique symbolique, opposé aux réseaux de neurones.

L'approche alternative de l'IA symbolique a connu une croissance explosive. Mais cette approche n'a donné aucun résultat significatif. Dans les années 1970, il est devenu clair que les chercheurs en IA étaient trop optimistes à propos de l'IA. Les objectifs qu’ils ont promis n’ont pas encore été atteints et leur réalisation semble être un avenir très lointain.

Les chercheurs ont réalisé qu'ils reposaient contre le mur. L'IA a été appliquée à des tâches simples. Mais les vrais scénarios étaient trop complexes pour ces systèmes. Le nombre de possibilités que les algorithmes devaient explorer s'est avéré être astronomique. Cela a conduit au problème d'une explosion combinatoire . Et puis la question classique «comment rendre un ordinateur intelligent» s'est posée. C'était un problème de bon sens .

Tout cela a conduit au fait que les investisseurs étaient déçus par la technologie. Le financement de l'IA a donc disparu et la recherche a cessé. Le DARPA, lui aussi, ne pouvait plus soutenir une culture de piratage de la recherche en raison de modifications de la législation. Les sponsors ont gelé le financement de la recherche dans le domaine de l'intelligence artificielle. Par conséquent, la période 1974-1980. appelé " AI d'hiver ."

Renaissance

En 1981, le gouvernement japonais a commencé à investir sérieusement dans la recherche dans le domaine de l'intelligence artificielle. Le pays a alloué 850 millions de dollars au projet informatique de cinquième génération. Il visait à développer l'IA. Les prétendus ordinateurs devaient communiquer, traduire d'autres langues, reconnaître des images. On s'attendait à ce que les ordinateurs soient la base de la création d'appareils capables de simuler la réflexion.

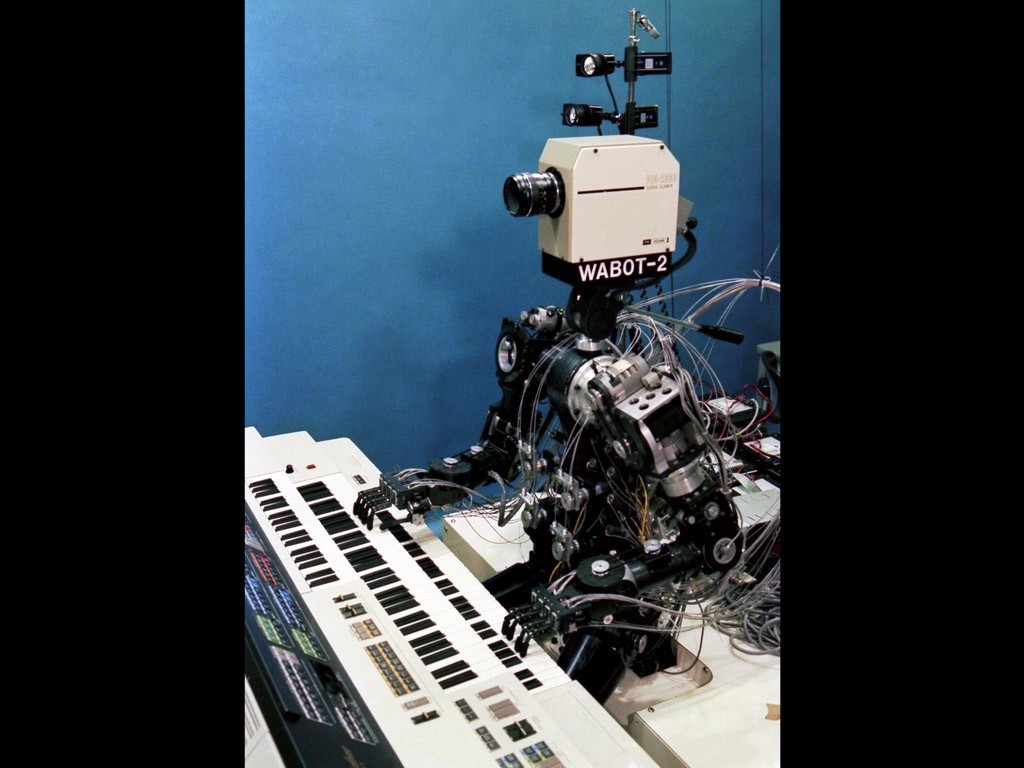

Wabot-2

La recherche au Japon semblait prometteuse. En 1980, le robot Wabot-2 a été développé à l'Université Waseda. Il pouvait communiquer avec les gens, lire des partitions musicales et jouer de l'orgue électronique. Le succès des Japonais a contraint d'autres gouvernements et entreprises privées à se tourner à nouveau vers l'IA.

À ce stade, la question du connexionnisme s'est posée. En 1982, Hopfield a créé une nouvelle forme de réseau de neurones capable d'étudier et de traiter l'information. Jeffrey Hinton et David Rumelhart ont popularisé l'auto-distinction inverse. Cette technologie était phénoménale et reste vitale dans l'apprentissage automatique à ce jour.

L'IA a remporté un succès commercial sous la forme de «systèmes experts». Ces systèmes avaient une connaissance approfondie d'un sujet particulier. L'Université Carnegie Mellon (CMU) a lancé un système expert appelé XCON en 1980. Il a été utilisé chez Digital Equipment Corporation. Jusqu'en 1986, l'entreprise économisait 40 millions de dollars par an.

Deuxième hiver

La révolution des PC a changé le cours du développement de l'IA

À la fin des années 1980, le succès de l'industrie de l'IA a été éclipsé par la révolution informatique. Apple et IBM ont produit en même temps des ordinateurs de plus en plus puissants. Les ordinateurs de bureau sont devenus moins chers et plus puissants que les machines Lisp à intelligence artificielle. Une industrie entière valant un demi-milliard de dollars a été détruite en une nuit. Les succès de l'IA dans des systèmes experts tels que la machine XCON se sont révélés trop chers.

Il y a des problèmes avec les systèmes experts. Ils ne pouvaient pas apprendre. Ils étaient «fragiles» (c'est-à-dire qu'ils pouvaient commettre de graves erreurs s'ils recevaient des données inhabituelles). La portée pratique des systèmes experts est devenue limitée. La nouvelle direction de la DARPA a décidé que l'IA n'est pas la «prochaine vague». Et réorienté les investissements vers des projets qui, de leur point de vue, devraient apporter des résultats immédiats.

En 1991, les objectifs d'un projet informatique au Japon n'avaient pas été atteints. Les scientifiques ont sous-estimé les difficultés auxquelles ils ont dû faire face. Plus de 300 sociétés d'IA ont fermé, fait faillite ou ont été achetées à la fin de 1993. C'était en fait la fin de la première vague d'utilisation commerciale de l'intelligence artificielle.

Flux frais

Lorsque les échos de la révolution informatique ont commencé à se calmer, les gens ont eu l'occasion d'utiliser une grande puissance de calcul. Avec l'omniprésence des ordinateurs, le nombre de bases de données diverses a augmenté. C'était très cool en termes de développement de l'IA.

Les nouvelles technologies ont résolu les problèmes et supprimé les obstacles qui interféraient avec les scientifiques. En utilisant une puissance de calcul croissante, les chercheurs ont repoussé les limites du possible. Des bases de données devenues Big Data, il a été possible d'extraire de plus en plus de connaissances. Les possibilités d'utilisation pratique de l'IA sont devenues plus apparentes.

Un nouveau concept appelé « agent intelligent » a été créé dans les années 1990. Intelligent Agent (IA) est un système qui exécute indépendamment la tâche émise par l'utilisateur pendant de longues périodes. Il y avait un espoir qu'un jour nous pourrons enseigner à l'IA à interagir les uns avec les autres. Cela conduirait à la création de systèmes universels et plus «intelligents».

Dans la communauté de l'IA, différentes opinions sur l'utilisation des mathématiques dans le domaine de l'intelligence artificielle ont erré. Certains pensaient que l'intelligence était trop complexe pour être décrite avec des symboles mathématiques. À leur avis, les gens sont rarement guidés par la logique lorsqu'ils prennent des décisions. Leurs adversaires ont objecté que les chaînes logiques sont la voie à suivre.

G. Kasparov joue avec Deep Blue

Très vite, en 1997, le supercalculateur IBM Deep Blue a vaincu Garry Kasparov. À ce moment, Kasparov était le champion du monde d'échecs. Selon Newell et Simon, ce qui devait arriver en 1968 s'est finalement produit en 1997.

Les ordinateurs d'échecs modernes sont beaucoup plus forts que n'importe qui. La cote Elo la plus élevée jamais atteinte par les humains est de 2 882. Pour les ordinateurs, le chiffre le plus courant est de 3 000 Elo. Le plus haut niveau jamais enregistré était supérieur à 3 350.

En 2005, Stanford a développé un robot pour la conduite autonome. Il a remporté le DARPA Grand Challenge en conduisant 131 miles (211 km) le long d'une piste désertique inexplorée.

Jeopardy

En février 2011, IBM a décidé de tester son IBM Watson dans le quiz Jeopardy. L'ordinateur a réussi à vaincre les deux plus grands champions de Jeopardy par une marge significative.

Avec le développement en avalanche d'Internet et des réseaux sociaux, la quantité d'informations a augmenté. Les sociétés informatiques devaient faire quelque chose avec les données qu'elles recevaient. Et l'utilisation de l'IA est devenue une nécessité, pas un divertissement.

Maintenant, Google trie les SERPs à l'aide du Machine Learning. YouTube sélectionne les vidéos recommandées à l'aide des algorithmes ML, recommande les produits Amazon de la même manière. Le fil d'actualités Facebook est généré par un ordinateur intelligent. Et même Tinder trouve des personnes utilisant des algorithmes ML.

Grâce à la révolution informatique, la technologie de l'IA est devenue notre outil indispensable. Et maintenant, l'humanité regarde vers l'avenir, attendant la création de super machines. Et bien que les effets de l'intelligence artificielle soient parfois controversés, la poursuite du développement de cette technologie est inévitable.

Quoi d'autre est utile de lire sur le blog Cloud4Y

→ L' ordinateur vous rendra savoureux

→ L' IA aide à étudier les animaux en Afrique

→ L' été est presque terminé. Presque aucune donnée n'a été divulguée

→ 4 façons d'économiser sur les sauvegardes dans le cloud

→ IoT, brouillard et nuages: parler de technologie?

Abonnez-vous à notre chaîne Telegram pour ne pas manquer un autre article! Nous écrivons pas plus de deux fois par semaine et uniquement pour affaires.