Bonjour à tous!Il se trouve que notre petite équipe de développement, pour ne pas dire que récemment, et certainement pas tout d'un coup, a grandi pour transférer certains (et à l'avenir, tous) des produits à Kubernetes.

Il y avait plusieurs raisons à cela, mais notre histoire ne concerne pas l'holivar.

Du point de vue des infrastructures, nous avions peu de choix. vCloud Director et vCloud Director. Nous avons choisi une version plus récente et avons décidé de commencer.

Une fois de plus, en parcourant «The Hard Way», j'ai rapidement conclu qu'un outil pour automatiser au moins les processus de base, tels que le déploiement et le dimensionnement, était nécessaire hier. Une immersion profonde dans Google a mis au jour un produit tel que VMware Container Service Extension (CSE) - un produit open source qui vous permet d'automatiser la création et le dimensionnement des clusters k8s pour ceux de vCloud.

Avis de non-responsabilité: le CST a ses limites, mais pour nos besoins, il a parfaitement fonctionné. De plus, la solution doit être prise en charge par le fournisseur de cloud, mais comme la partie serveur est également open-source, demandez-la au gestionnaire le plus proche :)

Installation du client CSE

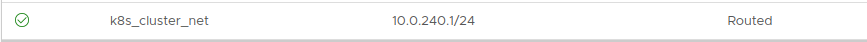

- Pour commencer, vous aurez besoin d'un compte administrateur dans l'organisation vCloud et d'un réseau routé créé à l'avance pour le cluster. Important: pendant le processus de déploiement, vous avez besoin d'un accès Internet à partir de ce réseau, n'oubliez pas de configurer le pare-feu / NAT.

L'adressage n'a pas d'importance. Dans cet exemple, prenez 10.0.240.0/24:

Étant donné qu'après la création du cluster, il sera nécessaire de gérer d'une manière ou d'une autre, la présence d'un VPN avec routage vers le réseau créé est recommandée. Nous utilisons un VPN SSL standard configuré sur la passerelle Edge de notre organisation.

- Ensuite, vous devez installer le client CSE là où les clusters k8s seront gérés. Dans mon cas, il s'agit d'un ordinateur portable fonctionnel et de quelques conteneurs

bien cachés qui dirigent l'automatisation.

Le client nécessite Python installé 3.7.3 et supérieur et un module vcd-cli installé, nous allons donc installer les deux.

pip3 install vcd-cli pip3 install container-service-extension

- Après l'installation, vérifiez la version de CSE et obtenez les éléments suivants:

# vcd cse version Error: No such command "cse".

De façon inattendue, mais réparable. - Il s'est avéré que le CSE devait être vissé en tant que module à vcd-cli.

Pour ce faire, vous devez d'abord vous connecter vcd-cli à notre organisation:

# vcd login MyCloud.provider.com org-dev admin Password: admin logged in, org: 'org-dev', vdc: 'org-dev_vDC01'

- Après cela, vcd-cli créera le fichier de configuration ~ / .vcd-cli / profiles.yaml

À sa fin, vous devez ajouter ce qui suit:

extensions: - container_service_extension.client.cse

- Ensuite, nous vérifions à nouveau:

# vcd cse version CSE, Container Service Extension for VMware vCloud Director, version 2.5.0

La phase d'installation du client est terminée. Essayons de déployer le premier cluster.

Déploiement de cluster

CSE a plusieurs ensembles de paramètres d'utilisation, qui peuvent tous être consultés

ici.- Créez d'abord les clés pour un accès sans mot de passe au futur cluster. Ce point est important, car par défaut, la saisie du mot de passe sur les nœuds sera désactivée. Et, si vous ne spécifiez pas les clés, vous pouvez obtenir beaucoup de travail via la console de la machine virtuelle, ce qui ne veut pas dire pratique.

# ssh-keygen Generating public/private rsa key pair. Enter file in which to save the key (/root/.ssh/id_rsa): Created directory '/root/.ssh'. Enter passphrase (empty for no passphrase): Enter same passphrase again: Your identification has been saved in /root/.ssh/id_rsa. Your public key has been saved in /root/.ssh/id_rsa.pub.

- Nous essayons de commencer à créer un cluster:

vcd cse cluster create MyCluster --network k8s_cluster_net --ssh-key ~/.ssh/id_rsa.pub --nodes 3 --enable-nfs

- Si nous obtenons une erreur: la session a expiré ou l'utilisateur n'est pas connecté. Veuillez vous reconnecter. - reconnectez vcd-cli à vCloud, comme décrit ci-dessus, et réessayez.

Cette fois, tout va bien et la tâche de création d'un cluster a commencé.

cluster operation: Creating cluster vApp 'MyCluster' (38959587-54f4-4a49-8f2e-61c3a3e879e0) from template 'photon-v2_k8-1.12_weave-2.3.0' (revision 1)

- Il faudra environ 20 minutes pour terminer la tâche. En attendant, nous analyserons les principaux paramètres de lancement.

- --network - le réseau que nous avons créé plus tôt.

- --ssh-key - clés créées par nous, qui seront écrites sur les nœuds du cluster.

- --nodes n - Le nombre de nœuds Worker du cluster. Il y aura toujours un assistant, il s'agit d'une limitation CSE.

- --enable-nfs - crée un nœud supplémentaire pour les boules NFS sous des volumes persistants. Un peu une option de pédale, nous reviendrons un peu plus tard pour ajuster ce qu'il fait.

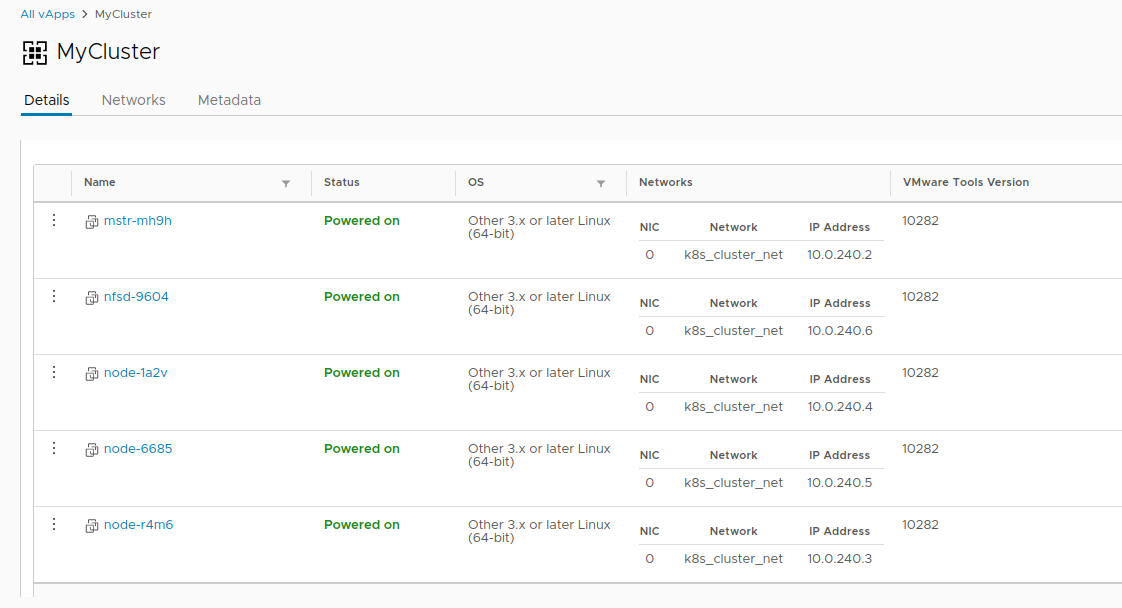

- Pendant ce temps, dans vCloud, vous pouvez observer visuellement la création d'un cluster.

- Une fois la tâche de création d'un cluster terminée, il est prêt à démarrer.

- Vérifiez le déploiement avec la commande MyCluster vcd cse cluster info .

- Ensuite, nous devons obtenir la configuration du cluster pour utiliser kubectl .

# vcd cse cluster config MyCluster > ./.kube/config

- Et vous pouvez vérifier l'état du cluster en l'utilisant:

Pas si simple

À ce stade, le cluster peut être considéré comme conditionnellement opérationnel, sinon pour l'histoire avec des volumes persistants. Puisque nous sommes dans vCloud, l'utilisation de vSphere Provider échouera. L'option

--enable-nfs est conçue pour atténuer ce problème, mais elle n'a pas fonctionné jusqu'à la fin. Un réglage manuel est requis.

- Pour commencer, notre nœud doit créer un disque indépendant distinct dans vCloud. Cela garantit que nos données ne disparaissent pas avec le cluster s'il est supprimé. Connectez également le lecteur à NFS.

# vcd disk create nfs-shares-1 100g --description 'Kubernetes NFS shares' # vcd vapp attach mycluster nfsd-9604 nfs-shares-1

- Après cela, nous passons par ssh (avez-vous vraiment créé les clés?) À notre nœud NFS et enfin connectez le disque:

root@nfsd-9604:~# parted /dev/sdb (parted) mklabel gpt Warning: The existing disk label on /dev/sdb will be destroyed and all data on this disk will be lost. Do you want to continue? Yes/No? yes (parted) unit GB (parted) mkpart primary 0 100 (parted) print Model: VMware Virtual disk (scsi) Disk /dev/sdb: 100GB Sector size (logical/physical): 512B/512B Partition Table: gpt Disk Flags: Number Start End Size File system Name Flags 1 0.00GB 100GB 100GB primary (parted) quit root@nfsd-9604:~# mkfs -t ext4 /dev/sdb1 Creating filesystem with 24413696 4k blocks and 6111232 inodes Filesystem UUID: 8622c0f5-4044-4ebf-95a5-0372256b34f0 Superblock backups stored on blocks: 32768, 98304, 163840, 229376, 294912, 819200, 884736, 1605632, 2654208, 4096000, 7962624, 11239424, 20480000, 23887872 Allocating group tables: done Writing inode tables: done Creating journal (32768 blocks): done Writing superblocks and filesystem accounting information: done

- Créez un répertoire pour les données et montez-y une nouvelle section:

mkdir /export echo '/dev/sdb1 /export ext4 defaults 0 0' >> /etc/fstab mount -a

- Créons cinq sections de test et partageons-les pour le cluster:

>cd /export >mkdir vol1 vol2 vol3 vol4 vol5 >vi /etc/exports

- Après toute cette magie, vous pouvez créer du PV et du PVC dans notre cluster comme ceci:

PV

cat <<EOF | kubectl apply -f - apiVersion: v1 kind: PersistentVolume metadata: name: nfs-vol1 spec: capacity: storage: 10Gi accessModes: - ReadWriteMany nfs:

PVC

cat <<EOF | kubectl apply -f - apiVersion: v1 kind: PersistentVolumeClaim metadata: name: nfs-pvc spec: accessModes: - ReadWriteMany storageClassName: "" resources: requests: storage: 10Gi EOF

Sur ce, l'histoire de la création d'un cluster se termine et l'histoire de son cycle de vie commence. En prime, il existe deux autres commandes CSE utiles qui vous permettent d'économiser des ressources parfois

ou non :

Merci à tous pour votre temps, si vous avez des questions - posez-les dans les commentaires.