Tout au long de son histoire, des premiers robots d'Asimov à AlphaGo, l'IA a connu des hauts et des bas. Mais en fait, son histoire ne fait que commencer.

L'intelligence artificielle est encore très jeune. Cependant, de nombreux événements importants se sont déjà produits dans ce domaine. Certains d'entre eux ont attiré l'attention de la culture, d'autres ont généré une onde de choc, perçue uniquement par les scientifiques. Voici quelques points clés qui ont eu le plus d'impact sur l'IA.

1. Isaac Asimov a mentionné pour la première fois les " Trois lois de la robotique " (1942)

L'histoire d'Azimov «

Round dance » marque la première apparition dans les histoires de ce célèbre écrivain de science-fiction des «Trois lois de la robotique»:

- Un robot ne peut pas nuire à une personne ou, par inaction, permettre à une personne d'être blessée.

- Un robot doit obéir à tous les ordres donnés par une personne, sauf dans les cas où ces ordres sont contraires à la première loi.

- Le robot doit veiller à sa sécurité dans la mesure où il ne contredit pas les première ou deuxième lois.

Dans l'histoire «Round dance», le robot Speedy est placé dans une position dans laquelle la troisième loi est en conflit avec les deux premières. Les histoires d'Azimov sur les robots ont fait réfléchir les fans de NF, y compris les scientifiques, à la possibilité de penser aux machines. À ce jour, les gens se livrent à des exercices intellectuels, appliquant les lois d'Asimov à l'IA moderne.

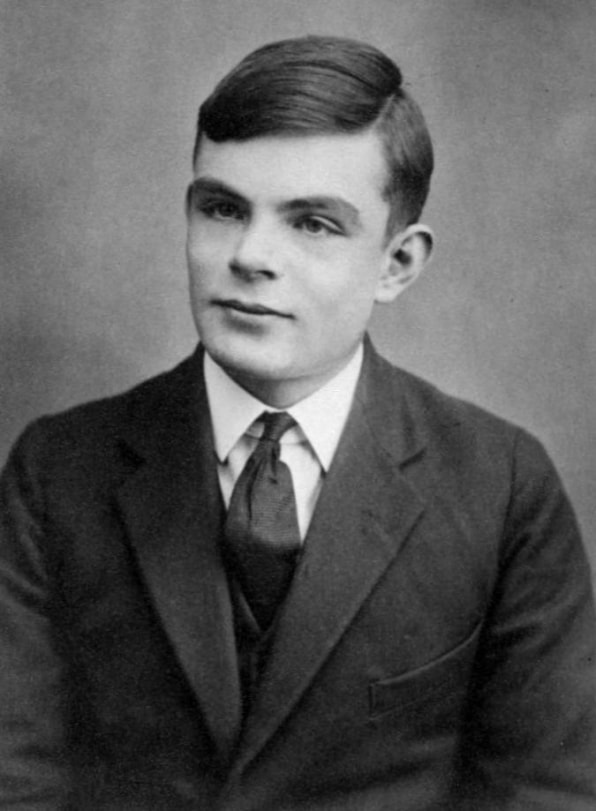

2. Alan Turing a proposé son "Game of Imitation" (1950)

Alan Turing a décrit le premier principe de mesure du degré de rationalité d'une machine en 1950.

Alan Turing a décrit le premier principe de mesure du degré de rationalité d'une machine en 1950.Je propose d'examiner la question "Les voitures peuvent-elles penser?" C'est ainsi qu'a commencé l'influent travail de recherche de Turing de 1950, qui a développé un système de croyance pour raisonner sur l'esprit de la machine. Il a demandé si une machine peut être considérée comme intelligente si elle peut imiter le comportement humain.

Cette question théorique a donné naissance au fameux «jeu de simulation» [il sera appelé plus tard le «

test de Turing » / env. trad.], un exercice dans lequel un chercheur doit déterminer avec qui il correspond - avec un ordinateur ou une personne. A l'époque de Turing, il n'y avait pas de machines capables de passer ce test, il n'y en a pas aujourd'hui. Cependant, son test a donné un moyen simple de déterminer si l'esprit était dans la voiture. Il a également contribué à façonner la philosophie de l'IA.

3. Conférence de Dartmouth sur l'IA (1956)

En 1955, les scientifiques du monde entier avaient déjà formé des concepts tels que les réseaux de neurones et le langage naturel, mais il n'existait toujours pas de concepts unificateurs englobant diverses variétés d'intelligence artificielle. John McCarthy, professeur de mathématiques au Dartmouth College, a inventé le terme «intelligence artificielle» pour les rassembler.

McCarthy a dirigé le groupe qui a demandé une subvention pour organiser une conférence sur l'IA en 1956. De nombreux chercheurs éminents de l'époque ont été invités à Dartmouth Hall à l'été 1956. Les scientifiques ont discuté de divers domaines potentiels d'étude de l'IA, y compris l'apprentissage et la recherche, la vue, le raisonnement logique, le langage et la raison, les jeux (en particulier les échecs), les interactions humaines avec des machines intelligentes telles que les robots personnels.

Le consensus général de ces discussions était que l'IA a un potentiel énorme pour bénéficier aux gens. Le domaine général des domaines de recherche, dont le développement peut être influencé par l'intelligence artificielle, a été décrit. La conférence a organisé et inspiré la recherche sur l'IA pendant de nombreuses années.

4. Frank Rosenblatt crée le perceptron (1957)

Frank Rosenblatt a créé un réseau de neurones mécaniques au Cornell Aeronautics Laboratory en 1957

Frank Rosenblatt a créé un réseau de neurones mécaniques au Cornell Aeronautics Laboratory en 1957Le composant de base du réseau neuronal est appelé le «

perceptron » [ce n'est que le

tout premier et primitif type de neurone artificiel / env. trad.]. Un ensemble de données d'entrée tombe dans le nœud qui calcule la valeur de sortie et donne une classification et un niveau de confiance. Par exemple, les données d'entrée peuvent analyser divers aspects de l'image sur la base des données d'entrée et «voter» (avec un certain niveau de confiance) pour savoir s'il y a un visage dessus. Ensuite, le nœud compte toutes les «voix» et le niveau de confiance, et donne un consensus. Dans les réseaux de neurones d'aujourd'hui, fonctionnant sur des ordinateurs puissants, des milliards de structures similaires fonctionnent ensemble.

Cependant, les perceptrons existaient avant même l'avènement des ordinateurs puissants. À la fin des années 1950, un jeune chercheur en psychologie, Frank Rosenblatt, a créé un modèle électromécanique du perceptron appelé Mark I Perceptron, qui est conservé aujourd'hui à la Smithsonian Institution. Il s'agissait d'un réseau neuronal analogique, composé d'un réseau d'éléments photosensibles connectés par des fils à des banques de nœuds contenant des moteurs électriques et des résistances rotatives. Rosenblatt a développé «l'algorithme perceptron», qui contrôlait le réseau, qui ajustait progressivement la force des signaux d'entrée afin que, par conséquent, les objets soient correctement identifiés - en fait, il a été formé.

Les scientifiques ont discuté de l'importance de cette machine jusqu'aux années 1980. Il a joué un rôle important dans la création de l'incarnation physique du réseau neuronal, qui jusque-là existait principalement sous la forme d'un concept scientifique.

5. AI fait face à son premier hiver (années 1970)

Pendant la majeure partie de son histoire, l'IA n'a existé que dans la recherche. Pendant une grande partie des années 60, les agences gouvernementales, en particulier la DARPA, ont investi de l'argent dans la recherche et n'ont pratiquement pas exigé de rapport d'investissement. Les chercheurs en IA ont souvent exagéré le potentiel de leur travail pour continuer à recevoir du financement. Tout a changé à la fin des années 60 et au début des années 70. Deux rapports - l'un de l'ALPAC Advisory Board pour le gouvernement américain en 1966, et le second de Lighthill pour le gouvernement britannique en 1973 - ont évalué de manière pragmatique les progrès de la recherche sur l'IA et ont donné des prévisions très pessimistes sur le potentiel de cette technologie. Les deux rapports ont mis en doute l'existence de progrès tangibles dans divers domaines de la recherche sur l'IA. Lighthill dans son rapport a fait valoir que l'IA pour les tâches de reconnaissance vocale serait extrêmement difficile à adapter à des tailles qui pourraient être utiles au gouvernement ou aux militaires.

En conséquence, les gouvernements des États-Unis et de la Grande-Bretagne ont commencé à réduire le financement de la recherche sur l'IA pour les universités. La DARPA, qui a financé la recherche sur l'IA sans problème dans les années 1960, a commencé à exiger des délais clairs des projets et une description détaillée des résultats attendus. En conséquence, il a commencé à sembler que l'IA n'était pas à la hauteur des attentes et ne pourrait jamais atteindre le niveau des capacités humaines. Le premier «hiver» de l'IA a duré toutes les années 70 et 80.

6. L'arrivée du deuxième hiver de l'IA (1987)

Les années 80 ont commencé avec le développement et les premiers succès de «

systèmes experts » qui stockaient de grandes quantités de données et imitaient le processus décisionnel par les gens. La technologie a été initialement développée à l'Université Carnegie Mellon pour Digital Equipment Corporation, puis d'autres sociétés ont commencé à la mettre en œuvre rapidement. Cependant, les systèmes experts nécessitaient un équipement spécialisé coûteux, et cela est devenu un problème lorsque la puissance similaire et les postes de travail moins chers de Sun Microsystems ainsi que les ordinateurs personnels d'Apple et d'IBM ont commencé à apparaître. Le marché des systèmes informatiques experts s'est effondré en 1987 lorsque les principaux équipementiers l'ont quitté.

Le succès des systèmes experts au début des années 80 a inspiré la DARPA à augmenter le financement de la recherche sur l'IA, mais elle a rapidement changé à nouveau, et l'agence a réduit la majeure partie de ce financement, ne laissant que quelques programmes. Encore une fois, le terme «intelligence artificielle» dans la communauté des chercheurs est devenu presque interdit. Afin de ne pas être perçus comme des rêveurs peu pratiques à la recherche de financement, les chercheurs ont commencé à utiliser d'autres noms pour des travaux liés aux SS - "informatique", "apprentissage automatique" et "analytique". Ce deuxième hiver de l'IA s'est poursuivi jusqu'aux années 2000.

7. IBM Deep Blue bat Kasparov (1997)

IBM Deep Blue a battu le meilleur joueur d'échecs du monde, Garry Kasparov, en 1997.

IBM Deep Blue a battu le meilleur joueur d'échecs du monde, Garry Kasparov, en 1997.La sensibilisation du public à l'IA s'est améliorée en 1997 lorsque l'ordinateur d'échecs Deep Blue d'IBM a vaincu le champion du monde de l'époque, Garry Kasparov. Sur les six matchs disputés dans le studio de télévision, Deep Blue a gagné en deux, Kasparov en un et trois se sont soldés par un match nul. Plus tôt cette année-là, Kasparov a battu la version précédente de Deep Blue.

L'ordinateur Deep Blue avait suffisamment de puissance de calcul et utilisait la «méthode de la force brute», ou recherche exhaustive, évaluant 200 millions de mouvements possibles par seconde et choisissant le meilleur. Les capacités des gens se limitent à évaluer seulement environ 50 coups après chaque mouvement. Le travail de Deep Blue était similaire au travail de l'IA, mais l'ordinateur n'a pas pensé aux stratégies et n'a pas appris le jeu, comme les systèmes qui l'ont suivi pouvaient le faire.

Néanmoins, la victoire de Deep Blue sur Kasparov a impressionné le retour de l'IA au cercle de l'attention du public. Certaines personnes étaient fascinées. Pour d'autres, la machine n'a pas battu un expert des échecs. Les investisseurs ont été impressionnés: la victoire de Deep Blue de 10 $ a augmenté la valeur des actions IBM, les portant au maximum de ce temps.

8. Un réseau de neurones voit des chats (2011)

En 2011, des scientifiques d'universités du monde entier ont parlé des réseaux de neurones et les ont créés. Le programmeur de Google,

Jeff Dean, a rencontré

Andrew Eun, professeur d'informatique à Stanford cette année-là. Ensemble, ils ont conçu la création d'un grand réseau de neurones, fourni par l'énorme puissance de calcul des serveurs de Google, qui pourrait alimenter un énorme ensemble d'images.

Le réseau neuronal qu'ils ont créé a fonctionné sur 16 000 processeurs de serveur. Ils lui ont donné 10 millions d'images aléatoires et sans étiquette à partir de vidéos YouTube. Dean et Eun n'ont pas demandé au réseau neuronal de donner des informations spécifiques ou de marquer ces images. Lorsqu'un réseau de neurones fonctionne de cette façon, apprenant sans professeur, il essaie naturellement de trouver des modèles dans les données et forme des classifications.

Le réseau neuronal a traité les images pendant trois jours. Ensuite, elle a produit trois images floues dénotant des images visuelles qu'elle a rencontrées encore et encore dans les données d'entraînement - le visage d'une personne, le corps d'une personne et un chat. Cette étude a été une percée majeure dans l'utilisation des réseaux de neurones et l'apprentissage non-enseignant en vision par ordinateur. Cela a également marqué le début du projet Google Brain.

9. Joffrey Hinton a déclenché des réseaux de neurones profonds (2012)

Les recherches de Joffrey Hinton ont ravivé l'intérêt pour le deep learning

Les recherches de Joffrey Hinton ont ravivé l'intérêt pour le deep learningUn an après la percée, Dean et Un, professeur à l'Université de Toronto, Joffrey Hinton, et deux de ses étudiants ont créé un réseau de neurones pour la vision par ordinateur, AlexNet, pour participer au concours de reconnaissance d'images ImageNet. Les participants ont dû utiliser leurs systèmes pour traiter des millions d'images de test et les identifier avec la plus grande précision possible. AlexNet a remporté la compétition avec un pourcentage d'erreurs deux fois et demi inférieur à celui du concurrent le plus proche. Dans cinq versions de la légende d'image fournie par le réseau neuronal, seulement dans 15,3% des cas, il n'y avait pas d'option correcte. Le record précédent était de 26% d'erreurs.

Cette victoire a montré de manière convaincante que les réseaux de neurones profonds fonctionnant sur des GPU, où mieux que d'autres systèmes peuvent déterminer et classer avec précision les images. Cet événement, peut-être plus que d'autres, a influencé le regain d'intérêt pour les réseaux de neurones profonds et a valu à Hinton le surnom de "parrain de l'apprentissage en profondeur". Avec d'autres gourous de l'IA, Yoshua Benggio et Jan Lekun, Hinton a reçu le prix Turing tant attendu en 2018.

10. AlphaGo bat le champion du monde de go (2016)

En 2013, des chercheurs de la startup britannique DeepMind ont publié un article décrivant comment un réseau neuronal a appris à jouer et à gagner dans 50 anciens jeux Atari. Impressionné par cela, Google a acheté la société - comme on dit, pour 400 millions de dollars.Toutefois, la renommée principale de DeepMind était encore à venir.

Quelques années plus tard, les scientifiques de DeepMind, maintenant dans le cadre de Google, sont passés des jeux Atari à l'une des plus anciennes tâches d'IA - le jeu de plateau japonais. Ils ont développé le réseau neuronal AlphaGo, capable de jouer et d'apprendre tout en jouant. Le programme a mené des milliers de jeux contre d'autres versions d'AlphaGo, tirant parti des pertes et des victoires.

Et ça a marché. AlphaGo a battu le plus grand joueur de go du monde,

Lee Sedola , 4-1 dans une série de jeux en mars 2016. Le processus a été filmé pour un documentaire. En le regardant, il est difficile de ne pas remarquer la tristesse avec laquelle Sedol a perçu la perte. Il semblait que tout le monde avait perdu, et pas seulement une personne.

Les progrès récents dans le domaine des réseaux de neurones profonds ont tellement changé le domaine de l'IA que sa véritable histoire ne fait peut-être que commencer. Nous attendons beaucoup d'espoirs, de battage médiatique et d'impatience, mais maintenant il est clair que l'IA affectera tous les aspects de la vie au XXIe siècle - et peut-être même plus qu'Internet à la fois.