Une palette permet aux peintres d'organiser et de mélanger facilement des peintures de différentes couleurs lorsqu'ils créent de l'art sur la toile avant eux. Avoir un outil similaire qui pourrait permettre à l'IA d'apprendre conjointement à partir de diverses sources de données telles que celles pour les conversations, les récits, les images et les connaissances pourrait ouvrir des portes aux chercheurs et aux scientifiques pour développer des systèmes d'IA capables d'une intelligence plus générale.

Une palette permet à un peintre d'organiser et de mélanger des peintures de différentes couleurs. SpaceFusion cherche à aider les scientifiques de l'IA à faire des choses similaires pour différents modèles formés sur différents ensembles de données.

Une palette permet à un peintre d'organiser et de mélanger des peintures de différentes couleurs. SpaceFusion cherche à aider les scientifiques de l'IA à faire des choses similaires pour différents modèles formés sur différents ensembles de données. Pour les modèles d'apprentissage en profondeur aujourd'hui, les ensembles de données sont généralement représentés par des vecteurs dans différents espaces latents utilisant différents réseaux de neurones. Dans l'article "

Jointly Optimizing Diversity and Pertinence in Neural Response Generation ", mes co-auteurs et moi proposons SpaceFusion, un paradigme d'apprentissage pour aligner ces différents espaces latents - les organiser et les mélanger en douceur comme la peinture sur une palette - pour que l'IA puisse tirer parti les modèles et les connaissances intégrés dans chacun d'eux. Ce travail, que nous présentons à la

conférence annuelle 2019 de la section nord-américaine de l'Association for Computational Linguistics: Human Language Technologies (NAACL-HLT) , fait partie du projet

Data-Driven Conversation , et sa mise en œuvre est disponible sur

GitHub .

Capturer la couleur de la conversation humaine

Dans un premier temps, nous avons appliqué cette technique à l'IA conversationnelle neuronale. Dans notre configuration, un modèle neuronal devrait générer des réponses pertinentes et intéressantes compte tenu de l'historique ou du contexte de la conversation. Bien que des progrès prometteurs dans les modèles de conversation neuronaux aient été réalisés, ces modèles ont tendance à jouer le jeu en toute sécurité, produisant des réponses génériques et ennuyeuses. Des approches ont été développées pour diversifier ces réponses et mieux saisir la couleur de la conversation humaine, mais souvent,

il y a un compromis, avec une pertinence en déclin .

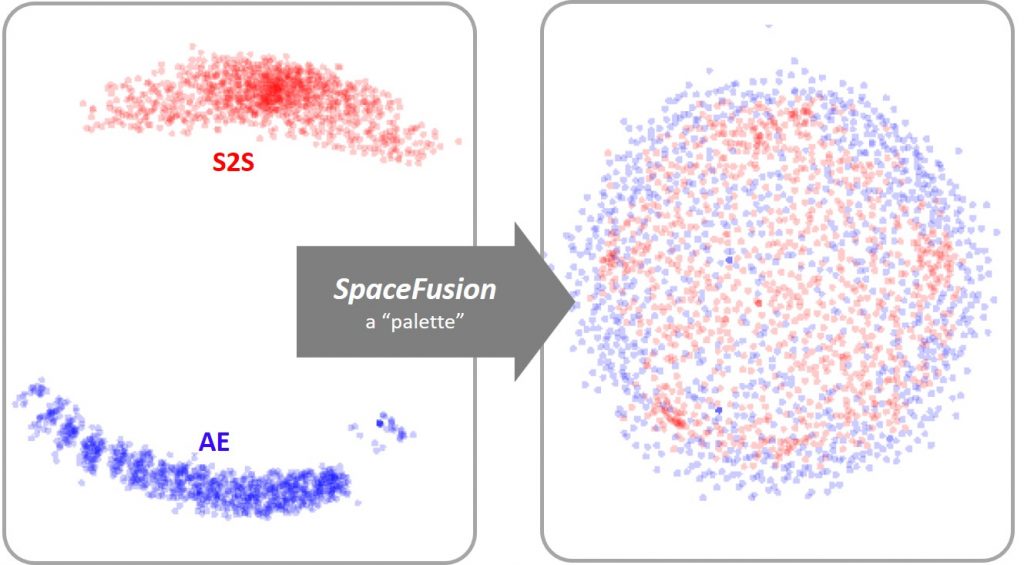

Figure 1: Comme une palette permet la combinaison facile de peintures, SpaceFusion aligne ou mélange, les espaces latents appris à partir d'un modèle de séquence à séquence (S2S, points rouges) et d'un autoencodeur (AE, points bleus) à utiliser conjointement les deux modèles plus efficacement.

Figure 1: Comme une palette permet la combinaison facile de peintures, SpaceFusion aligne ou mélange, les espaces latents appris à partir d'un modèle de séquence à séquence (S2S, points rouges) et d'un autoencodeur (AE, points bleus) à utiliser conjointement les deux modèles plus efficacement.SpaceFusion s'attaque à ce problème en alignant les espaces latents tirés de deux modèles (figure 1):

- un modèle de séquence à séquence (S2S), qui vise à produire des réponses pertinentes, mais peut manquer de diversité; et

- un modèle d'auto-encodeur (AE), qui est capable de représenter diverses réponses, mais ne capture pas leur relation avec la conversation.

Le modèle appris conjointement peut utiliser les points forts des deux modèles et organiser les points de données de manière plus structurée.

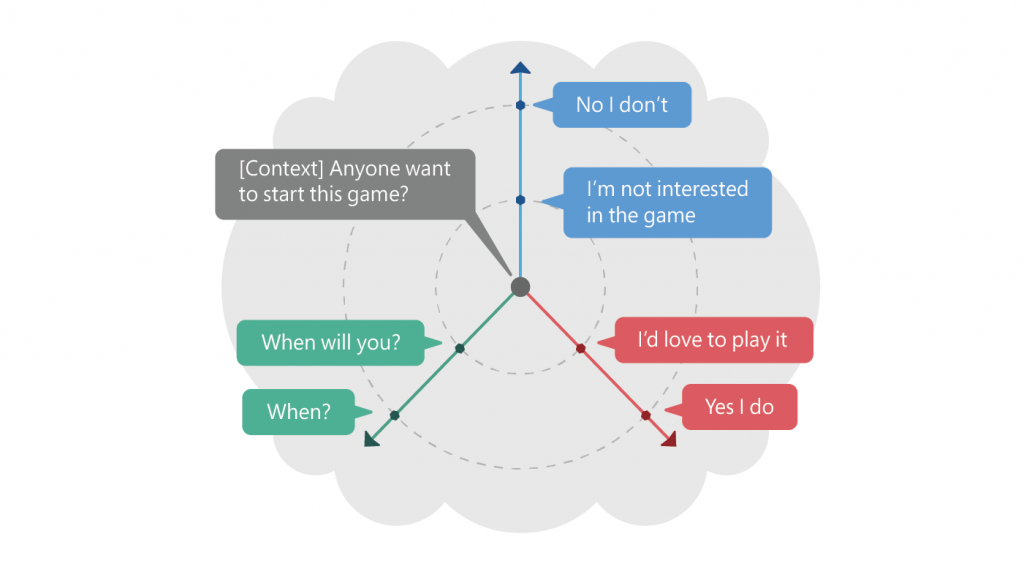

Figure 2: ce qui précède illustre un contexte et ses multiples réponses dans l'espace latent induit par SpaceFusion. La distance et la direction du vecteur de réponse prévu, étant donné le contexte, correspondent approximativement à la pertinence et à la diversité, respectivement.

Figure 2: ce qui précède illustre un contexte et ses multiples réponses dans l'espace latent induit par SpaceFusion. La distance et la direction du vecteur de réponse prévu, étant donné le contexte, correspondent approximativement à la pertinence et à la diversité, respectivement.Par exemple, comme illustré dans la figure 2, étant donné un contexte - dans ce cas, «Quelqu'un veut-il commencer ce jeu?» - les réponses positives «J'adorerais jouer» et «Oui, je le fais» sont disposées le long du même direction. Les points négatifs - «Je ne suis pas intéressé par le jeu» et «Non, je ne le fais pas» - sont cartographiés sur une ligne dans une autre direction. La diversité des réponses est obtenue en explorant l'espace latent dans différentes directions. De plus, la distance dans l'espace latent correspond à la pertinence. Les réponses plus éloignées du contexte - «Oui, je le fais» et «Non, je ne le fais pas» - sont généralement génériques, tandis que celles plus proches sont plus pertinentes pour le contexte spécifique: «Je ne suis pas intéressé par le jeu» et « Quand le ferez-vous? "

SpaceFusion démêle les critères de pertinence et de diversité et les représente en deux dimensions indépendantes - direction et distance - ce qui facilite l'optimisation conjointe des deux. Nos expériences empiriques et notre évaluation humaine ont montré que SpaceFusion fonctionne mieux dans ces deux critères par rapport aux lignes de base compétitives.

Apprendre un espace latent partagé

Alors, comment exactement SpaceFusion aligne-t-il les différents espaces latents?

L'idée est assez intuitive: pour chaque paire de points de deux espaces latents différents, nous minimisons d'abord leur distance dans l'espace latent partagé, puis nous encourageons une transition en douceur entre eux. Cela se fait en ajoutant deux nouveaux termes de régularisation - terme de distance et terme de régularité - à la fonction objectif.

En prenant l'exemple de la conversation, le terme distance mesure la distance euclidienne entre un point de l'espace latent S2S, qui est mappé à partir du contexte et représente la réponse prédite, et les points de l'espace latent AE, qui correspondent à ses réponses cibles. Minimiser une telle distance encourage le modèle S2S à cartographier le contexte à un point proche et entouré de ses réponses dans l'espace latent partagé, comme illustré par la figure 2.

Le terme de lissage mesure la probabilité de générer la réponse cible à partir d'une interpolation aléatoire entre le point mappé à partir du contexte et celui mappé à partir de la réponse. En maximisant cette probabilité, nous encourageons une transition en douceur de la signification des réponses générées à mesure que nous nous éloignons du contexte. Cela nous permet d'explorer le voisinage du point de prédiction fait par le S2S et ainsi générer des réponses diverses qui sont pertinentes pour le contexte.

Avec ces deux nouvelles régularisations ajoutées dans la fonction objectif, nous mettons les contraintes de distance et de douceur sur l'apprentissage de l'espace latent, de sorte que la formation se concentrera non seulement sur les performances de chaque espace latent, mais essaiera également de les aligner ensemble en les ajoutant structures souhaitées. Notre travail s'est concentré sur les modèles conversationnels, mais nous nous attendons à ce que SpaceFusion puisse aligner les espaces latents appris par d'autres modèles formés sur différents ensembles de données. Cela permet de relier différentes capacités et domaines de connaissances appris par chaque système d'IA spécifique et est un petit pas vers une intelligence plus générale.