Si nous considérons les algorithmes d'apprentissage automatique d'aujourd'hui avec un mouvement de l'ignorance (en bas) à la conscience (en haut), alors les algorithmes actuels sont comme un saut. Après le saut, il y a un ralentissement du rythme de développement (capacité d'apprentissage) et un virage et une chute inévitables (recyclage). Tous les efforts sont réduits à des tentatives pour exercer autant de puissance que possible sur le saut, ce qui augmente la hauteur du saut mais ne change pas fondamentalement les résultats. Lors du pompage des sauts, nous augmentons la hauteur, mais n'apprenons pas à voler. Pour maîtriser la technique du "vol contrôlé", il faudra repenser certains principes de base.

Dans les réseaux de neurones, une structure statique est utilisée qui ne permet pas d'aller au-delà de la capacité d'apprentissage établie de l'ensemble de la structure. En fixant la taille du réseau à partir d'un nombre fixe de

neurones, nous limitons la taille de la capacité d'apprentissage du réseau que le réseau ne peut jamais contourner. L'installation d'un plus grand nombre de neurones lors de la création d'un réseau vous permet d'augmenter la capacité d'apprentissage, mais ralentira le temps d'apprentissage. Des changements dynamiques dans la structure du réseau pendant la formation et l'utilisation de données binaires confèrent au réseau des propriétés uniques et contournent ces limitations.

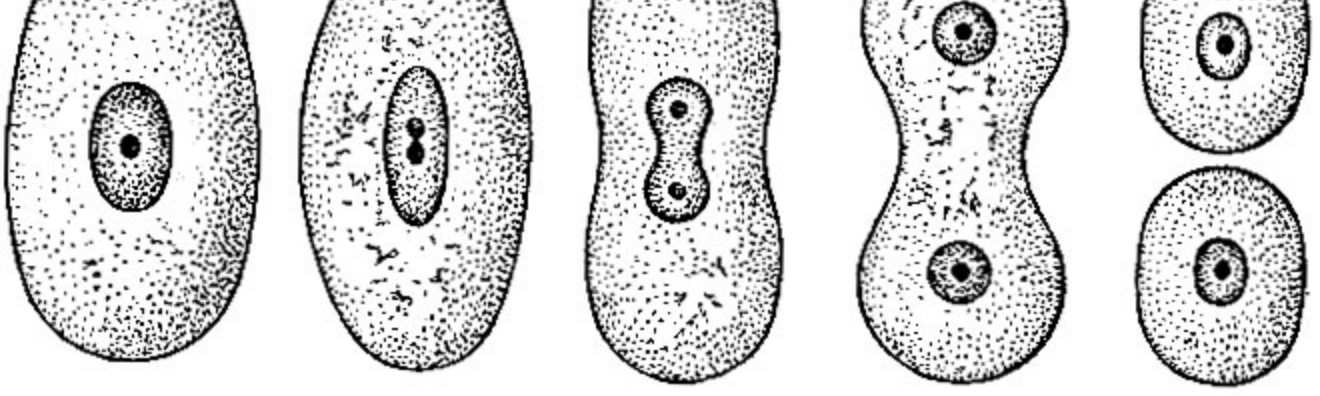

1. Structure de réseau dynamique

Le réseau lui-même doit prendre des décisions concernant sa taille. Au besoin, grandissez dans la bonne direction en augmentant de taille. Lors de la création d'un réseau, un neurone, une couche ou deux, nous ne pouvons pas connaître sans ambiguïté la capacité d'entraînement nécessaire du réseau et, par conséquent, sa taille. Notre réseau devrait repartir de zéro (absence totale de structure) et devrait pouvoir s'étendre dans la bonne direction indépendamment lorsque de nouvelles données de formation arrivent.

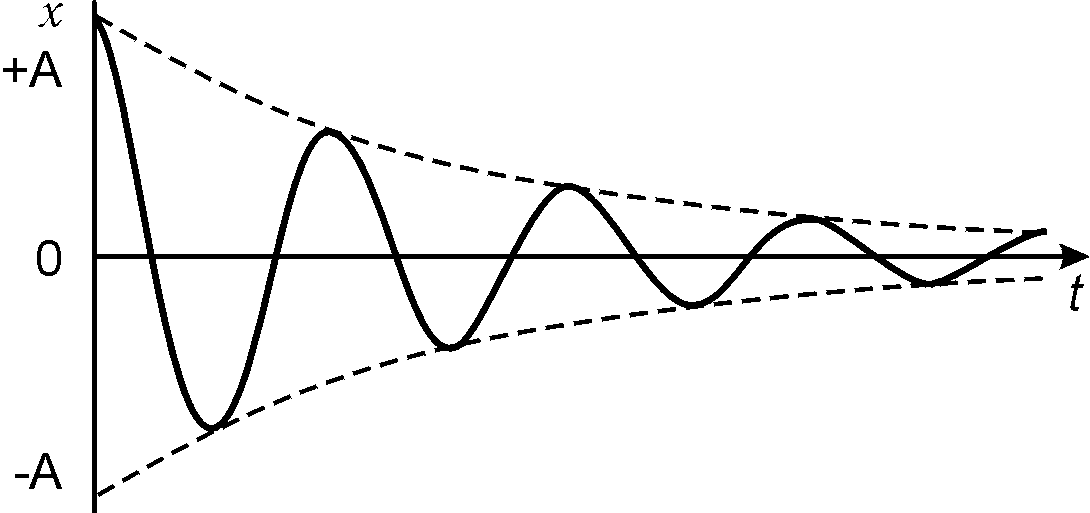

2. Atténuation du signal

Les réseaux de neurones engagés dans la sommation du signal utilisent l'approche "analogique" pour le calcul. De multiples conversions conduisent à une atténuation du signal et à sa perte lors de la transmission. Sur les réseaux de grande taille, les méthodes de calcul «analogiques» entraîneront inévitablement des pertes. Dans les réseaux neuronaux, le problème de l'atténuation du signal peut être résolu par des réseaux récurrents, en fait étant une béquille qui ne fait que réduire le problème, pas le résoudre complètement. La solution est d'utiliser un signal binaire. Le nombre de transformations d'un tel signal n'entraîne pas son atténuation et sa perte lors des transformations.

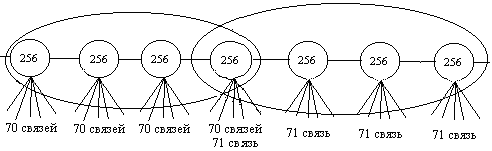

3. Capacité d'apprentissage en réseau

En élargissant la structure à mesure que nous apprenons, nous augmentons sa capacité d'enseignement. Le réseau lui-même détermine à partir de la tâche dans quelle direction se développer et combien de neurones sont nécessaires pour résoudre le problème. La taille du réseau limite uniquement la puissance de calcul des serveurs et les limites de taille du disque dur.

4. Formation en réseau

Lors du changement de signaux des réseaux analogiques aux réseaux binaires, il a la possibilité d'un apprentissage accéléré. La formation fournit un réglage sans ambiguïté du signal de sortie. Le processus d'apprentissage lui-même ne modifie qu'une petite partie des neurones, laissant une partie significative d'entre eux inchangée. Le temps de formation est réduit de nombreuses fois limité aux changements de plusieurs éléments de réseau.

5. Calcul du réseau

Pour calculer le réseau neuronal, nous devons calculer tous les éléments. Ignorer le calcul d'une partie égale des neurones peut conduire à l'effet papillon, où un signal insignifiant peut changer le résultat de tout le calcul. La nature des signaux binaires est différente. À chaque étape, il est possible d'exclure une partie des données du calcul sans conséquences. Plus le réseau est grand, plus nous pouvons ignorer d'éléments dans les calculs. Le calcul des résultats des réseaux se réduit au calcul d'un petit nombre d'éléments jusqu'à des fractions d'un pour cent du réseau. Pour le calcul, 3,2% (32 neurones) avec un réseau de mille neurones, 0,1% (1 mille) avec un million de «neurones» dans un réseau et 0,003% (32 000) avec un réseau d'un milliard de «neurones» de taille sont suffisants. Avec une augmentation de la taille du réseau, le pourcentage de neurones requis pour le calcul diminue.

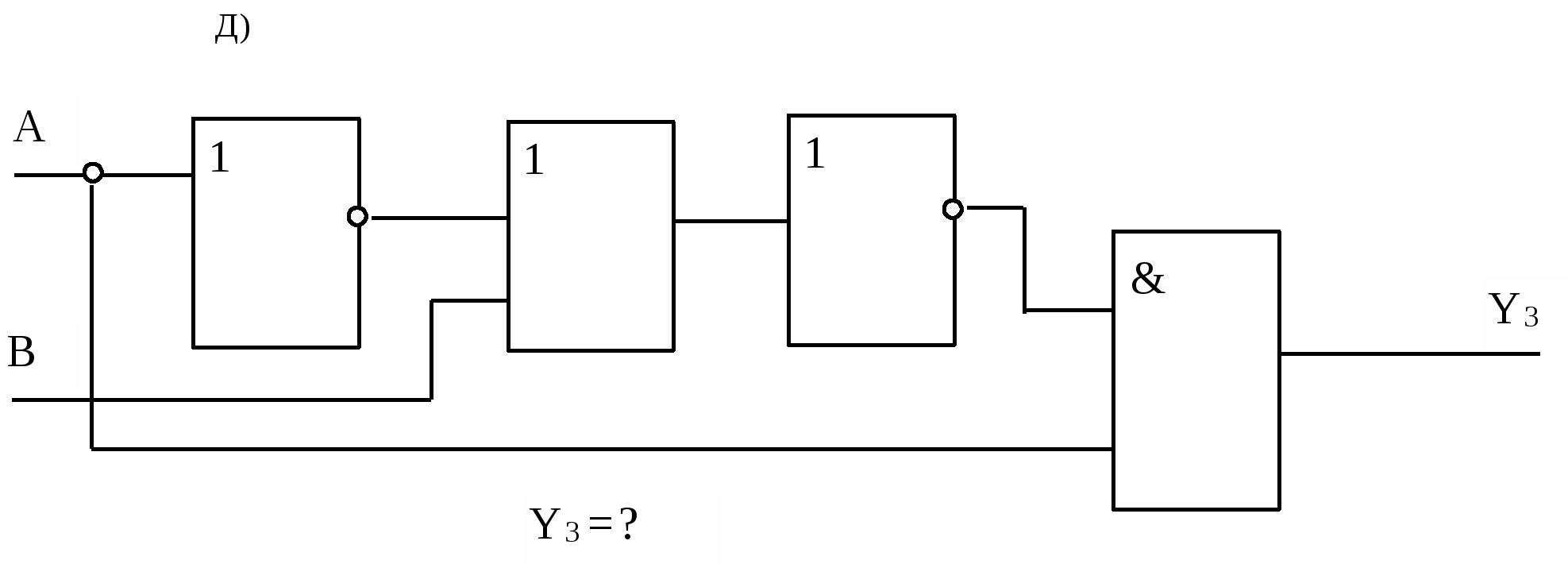

6. Interprétation des résultats

Dans les réseaux de neurones, les poids multipliés par les coefficients rendent impossible l'établissement d'une source de signal. Tous les signaux entrants du réseau neuronal, sans exception, affectent le résultat, compliquant la compréhension des raisons qui ont conduit à sa formation. L'influence des signaux binaires sur le résultat peut être nulle, partielle ou complète, ce qui indique clairement la participation des données sources au calcul. Les méthodes binaires de calcul des signaux vous permettent de suivre la relation des données entrantes avec le résultat et de déterminer le degré d'influence des données sources sur la formation du résultat.

Tout ce qui précède suggère la nécessité de changer les approches des algorithmes d'apprentissage automatique. Les méthodes classiques ne donnent pas un contrôle complet du réseau et une compréhension sans ambiguïté des processus qui s'y produisent. Pour réaliser un «vol contrôlé», il est nécessaire d'assurer la fiabilité de la conversion du signal au sein du réseau et la formation dynamique de la structure à la volée.