Le monde qui nous entoure est en constante évolution, que nous le voulions ou non. Et les technologies jouent un rôle important à cet égard, dont le développement et la diffusion deviennent de plus en plus actifs chaque année. Nous ne considérons plus la voiture comme une rareté, mais les communications mobiles comme de la magie. La technologie fait désormais partie de notre vie quotidienne, de notre travail et de nous-mêmes. Selon les films sur le Terminator, l'un des sujets les plus populaires parmi les futurologues et les écrivains de science-fiction a toujours été les robots - des machines autonomes qui peuvent faciliter la vie d'une personne ou organiser le génocide total de tous les êtres vivants de la planète. Dans tous les cas, un certain nombre de questions très drôles demeurent - comment une personne se comportera-t-elle avec une machine, lui fera-t-elle confiance et quelle sera l'efficacité de sa coopération? Des scientifiques du laboratoire de recherche de l'armée américaine ont décidé de mener une série d'expériences pour déterminer quels aspects du comportement et de «l'apparence» d'une machine autonome améliorent la collaboration avec les humains. Ce que nous avons réussi à découvrir nous apprend de leur rapport. On y va

Base d'étude

Pour mieux comprendre la relation entre l'homme et la machine, vous devez d'abord regarder la relation entre l'homme et l'homme. Étant donné que la population de la planète est divisée en plusieurs groupes (religion, nationalité, appartenance ethnique, etc.), une personne divisera toujours les gens en «nous» et «ils». Ce processus de séparation, selon les chercheurs, se déroule à un niveau subconscient et conduit à une augmentation de la probabilité de choisir une personne appartenant au même groupe pour la coopération. Les scientifiques notent également que ces préférences n'ont rien à voir avec des manifestations de discrimination contre des personnes d'autres nationalités, religions et autres choses.

Dans le cas des machines autonomes, on ignore si une telle catégorisation sociale a lieu au moment de la coopération de l'homme et de la machine. S'il l'est, comment se manifeste-t-il, comment est-il réglementé et comment peut-il être modifié?

Pour tester cela, les scientifiques ont mené une série d'expériences, dont les participants étaient des personnes de deux cultures éloignées (USA et Japon) et des voitures avec des visages virtuels correspondant aux mêmes cultures et exprimant certaines émotions.

Il y avait 468 participants des États-Unis et 477 du Japon.

Les caractéristiques démographiques d'un groupe des États-Unis étaient les suivantes:

- sexe: 63,2% - hommes et 36,8% - femmes;

- âge: 0,9% - 18-21; 58,5% - 22-34; 21,6% - 35-44; 10,7% - 45-54; 6,2% - 55-64; 2,1% - plus de 64 ans;

- appartenance ethnique: 77,3% - indo-européen; 10,3% - Afro-américain; 1,3% - Indien de l'Est; 9,2% - hispanique; 6,0% - Asiatique (sud-est).

Les caractéristiques démographiques du groupe du Japon étaient les suivantes:

- sexe: 67,4 - hommes et 32,6% - femmes;

- âge: 0,6% - 18-21; 15,7% - 22-34; 36,4% - 35-44; 34,7% - 45-54; 10,4% - 55-64; 2,1% - plus de 64 ans;

- appartenance ethnique: 0,6% - Indien de l'Est; 99,4% - Asiatique (sud-est).

Les gens peuvent se rapporter les uns aux autres de différentes manières, selon la catégorisation personnelle, mais il convient de se rappeler qu'une machine autonome n'est pas une personne. Par conséquent, cet appareil appartient déjà à un autre groupe social, pour ainsi dire, par défaut. Bien sûr, une personne peut percevoir une machine comme un acteur social (participant à une sorte d'interaction), mais elle la percevra différemment de ce qu'elle percevrait d'une autre personne vivante de la chair et du sang.

Un exemple frappant de cela est l'étude antérieure du cerveau humain lors d'un jeu de "ciseaux à papier". Lorsqu'une personne joue avec une autre personne, le cortex préfrontal médian est activé, ce qui joue un rôle important dans la

mentalisation * .

Mentalisation * - la capacité de représenter l'état mental de soi et des autres.

Mais en jouant avec la machine, cette partie du cerveau n'était pas activée.

Des résultats similaires ont été montrés par des expériences avec le jeu de l'ultimatum.

Le jeu de l'ultimatum * est un jeu économique dans lequel le joueur n ° 1 reçoit une certaine somme d'argent et doit le partager avec le joueur n ° 2, qu'il voit pour la première fois. L'offre peut être quelconque, mais si le joueur numéro 2 la refuse, les deux joueurs ne recevront pas du tout d'argent.

Lorsque le joueur n ° 2 a reçu une offre injuste du joueur n ° 1 (humain), il a activé des sections du lobe central du cerveau responsables de la formation d'émotions négatives. Si le joueur 1 était une voiture, aucune réaction de ce type n'a été observée.

De telles expériences confirment une fois de plus le fait qu'une personne perçoit une machine différemment d'une autre personne. Certains chercheurs pensent que la machine ne représente pas pour nous une compétition du point de vue de nos instincts, et qu'il y a donc une activité réduite (voire nulle) similaire dans certaines régions du cerveau.

Tout est assez logique: l'homme est un loup pour l'homme, mais même entre les loups, il existe un certain degré de confiance et de désir de coopérer dans certaines conditions. Mais la voiture agit comme un renard avec lequel les loups ne veulent pas coopérer du tout. Cependant, ces préférences n'annulent pas le fait qu'il y a de plus en plus de robots dans notre monde, et donc nous devons trouver des méthodes pour améliorer la relation entre nous et eux.

Pourquoi les chercheurs ont-ils décidé d'utiliser ce type de catégorisation sociale comme identité culturelle? Premièrement, il a déjà été établi précédemment qu'une personne réagit positivement aux machines qui ont certaines caractéristiques de la parole (accentuation, par exemple), les normes sociales et la race.

Deuxièmement, dans les cas où des représentants de différents groupes sociaux participent aux expériences, une imbrication distincte de coopération et de concurrence est constatée dans les premières étapes. Dans les étapes suivantes, lorsque les participants apprennent à mieux se connaître, une ligne de comportement claire est établie correspondant à la tâche de l'expérience. En termes simples, les participants de différents groupes sociaux ne se faisaient pas confiance en premier lieu, même lorsque la tâche de l'expérience était liée à la coopération. Mais après un certain temps, la confiance et le désir de terminer la tâche l'emportaient sur la méfiance inconsciente.

Troisièmement, les expériences précédentes ont montré que les attentes initiales de coopération basées sur la catégorisation sociale peuvent être rejetées si nous recourons à des signes (émotions) plus significatifs sur le plan situationnel.

Autrement dit, les chercheurs ont doté la machine des caractéristiques visuelles des groupes sociaux auxquels appartenaient les participants à l'expérience (personnes) et d'un certain nombre d'expressions émotionnelles, puis ont vérifié différentes combinaisons pour identifier la connexion.

De tout cela, deux hypothèses principales ont été identifiées. La première est que l'association de signes positifs d'identité culturelle peut atténuer les préjugés défavorables que les gens ont par défaut sur les machines. Deuxièmement, l'expression des émotions peut dépasser les attentes de coopération / compétition basées sur l'identité culturelle. En d'autres termes, si vous donnez à la voiture des caractéristiques visuelles d'un certain groupe culturel, les personnes du même groupe peuvent alors lui faire plus inconsciemment confiance. Cependant, dans le cas de la manifestation de certaines émotions, indiquant la réticence de la machine à coopérer, tous les préjugés culturels cessent instantanément d'être importants.

Curieusement, l'expérience était basée sur le dilemme du prisonnier - un jeu dans lequel la coopération n'est pas une tactique gagnante. Suivant la théorie des jeux, le prisonnier (joueur) maximisera toujours son propre avantage, sans penser aux avantages des autres joueurs. Ainsi, la rationalité devrait pousser les joueurs vers la trahison et la réticence à coopérer, mais en réalité les résultats de telles expériences sont souvent loin d'être rationnels, ce qui explique la présence du mot «dilemme» au nom de ce jeu mathématique. Il y a un petit hic: si un joueur croit que le second ne coopérera pas, il ne devrait pas non plus coopérer, cependant, si les deux joueurs suivent de telles tactiques, alors les deux perdront.

Résultats de l'expérience

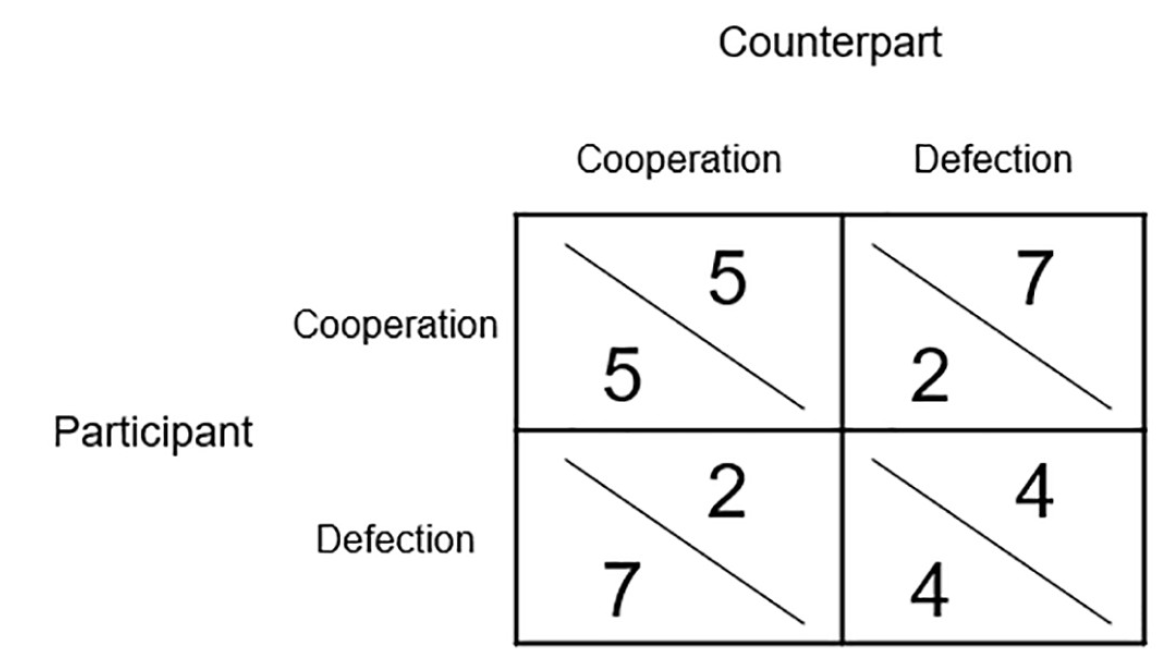

Image n ° 1

Image n ° 1Au total, chacun des participants à l'expérience a passé 20 tours à jouer avec la machine. L'image ci-dessus est une matrice de gain. Les points obtenus pendant le jeu présentaient de réels avantages financiers, car ils ont ensuite été convertis en billets de loterie avec un montant gagnant de 30 $.

L'objectif principal de l'expérience était d'identifier comment les participants collaboreront / rivaliseront avec les personnes ou les machines, ainsi que comment l'identité culturelle et les émotions influenceront ces processus.

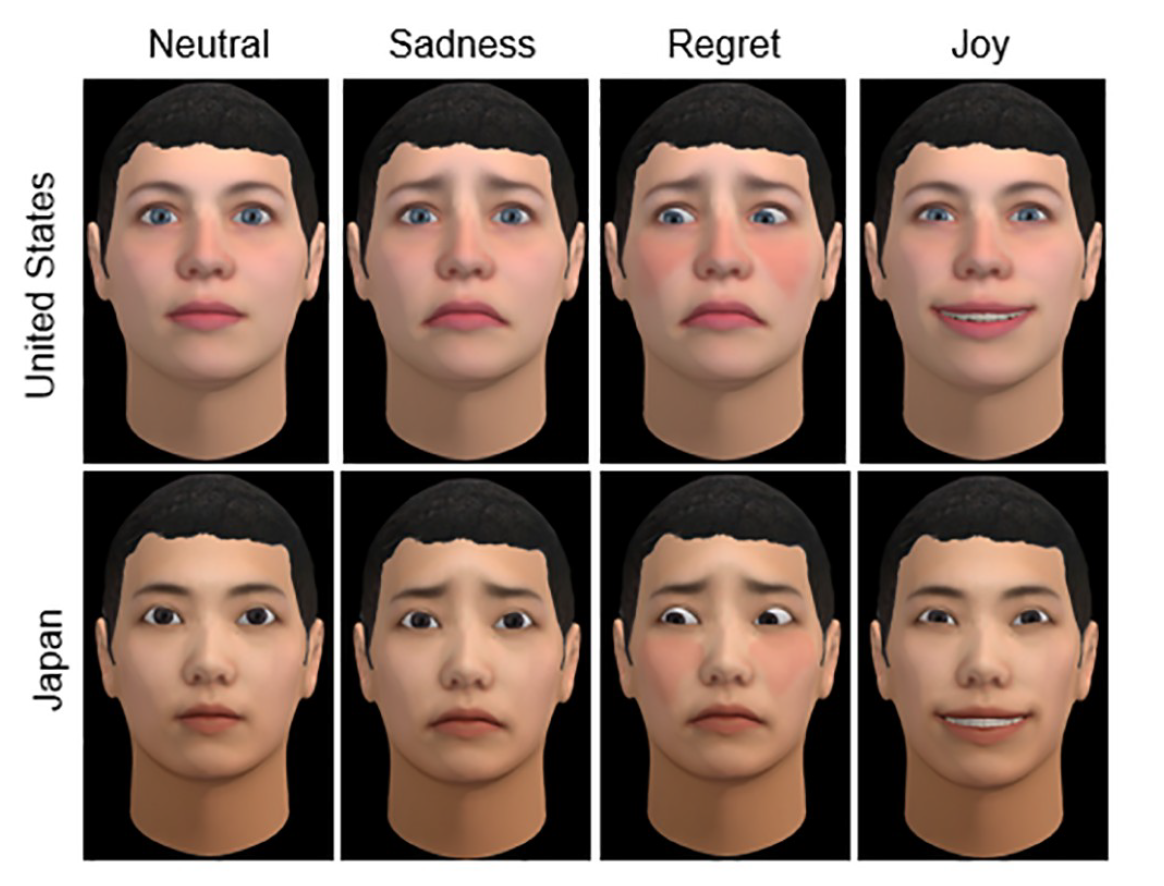

Image n ° 2

Image n ° 2Ce qui précède sont deux identités culturelles (USA et Japon) de visages virtuels pour des machines qui expriment des émotions différentes (neutre, tristesse, regret et joie). Il convient de noter que des visages virtuels ont été utilisés par tous les participants aux expériences, c'est-à-dire les gens et les voitures.

La série émotionnelle n'a pas été choisie par hasard. Des expériences antérieures sur le dilemme du prisonnier ont montré que certaines émotions peuvent encourager la coopération, tandis que d'autres peuvent rivaliser, en fonction du temps qu'elles expriment.

Dans ce modèle, les émotions de la machine et les actions qui les provoquent étaient divisées en deux catégories principales.

Pousser une personne à la compétition:

- regret après une coopération mutuelle (la machine a raté l'opportunité de faire fonctionner un membre humain pour son propre bénéfice)

- joie après l'opération (le participant coopère, mais ne reçoit rien en retour de la voiture);

- tristesse après compétition mutuelle / émotion neutre après coopération mutuelle.

Encourager les gens à coopérer:

- la joie de la coopération mutuelle;

- regret de l'exploitation;

- tristesse après compétition mutuelle.

Ainsi, dans l'expérience, il y avait plusieurs variables à la fois: l'identité culturelle (USA ou Japon), le type de partenaire déclaré (personne ou machine) et les émotions exprimées (compétitives ou collaboratives).

Les résultats des expériences ont été divisés en deux catégories selon le type de paires de participants: les participants d'un groupe culturel et les participants de différents groupes culturels.

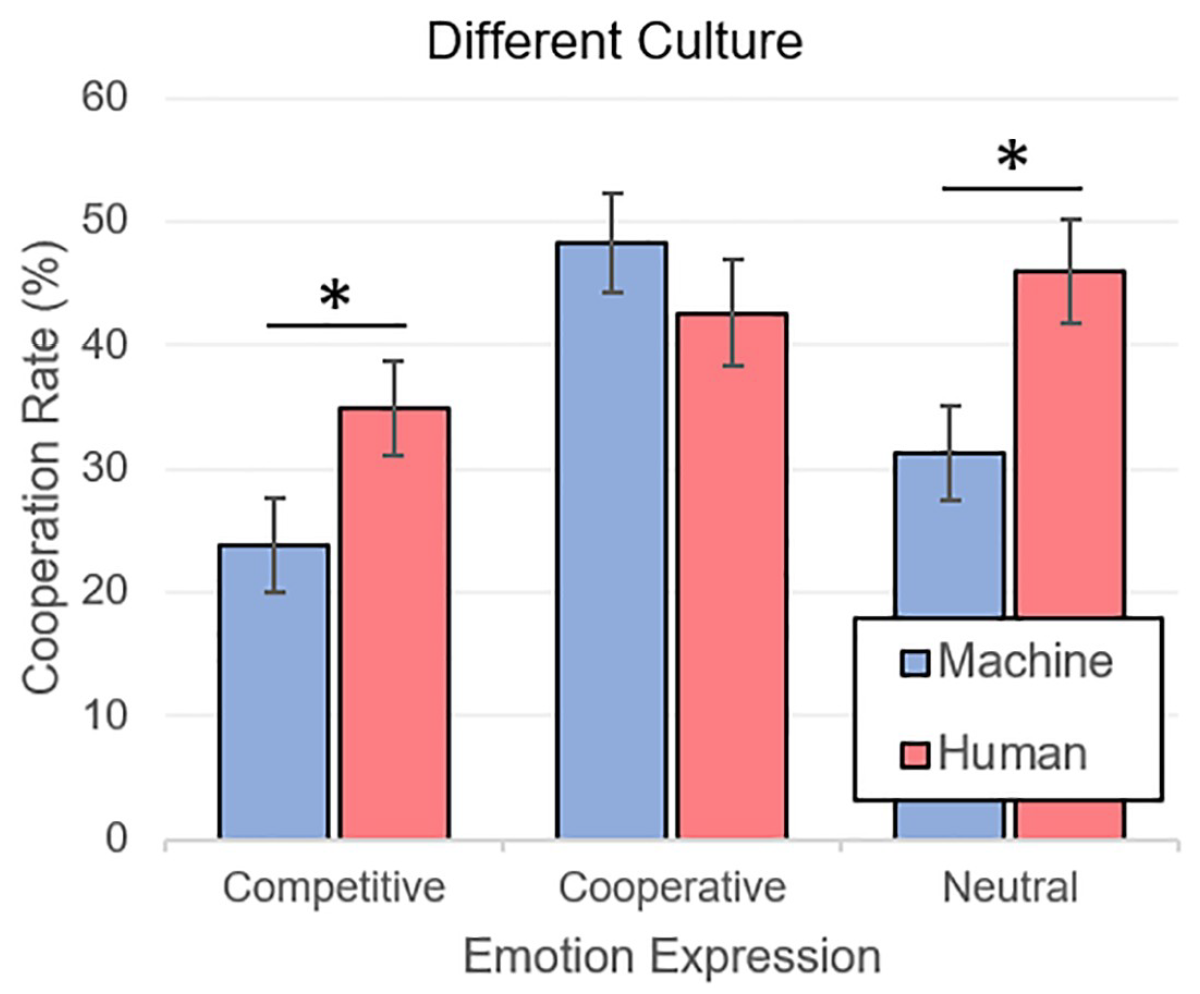

Image n ° 3

Image n ° 3Ci-dessus est un graphique des résultats (analyse de la variance, c'est-à-dire ANOVA) d'expériences dans lesquelles différents groupes culturels se sont réunis dans le jeu. Comme prévu, la coopération avec les personnes (M = 41,15, SE = 2,39) a été exprimée plus que la coopération avec les machines (M = 34,45, SE = 2,25). Concernant les émotions, tout n'était pas moins prévisible - les joueurs collaboraient plus souvent avec ceux qui exprimaient des émotions de coopération (M = 45,42, SE = 2,97) que des émotions de compétition (M = 29,34, SE = 2,70). Les émotions neutres (M = 38,63, SE = 2,85) ont également surpassé les émotions compétitives.

Il est curieux que les émotions qui inspirent confiance aux joueurs humains neutralisent complètement le fait qu'ils jouent avec la machine, réduisant ainsi le degré de méfiance.

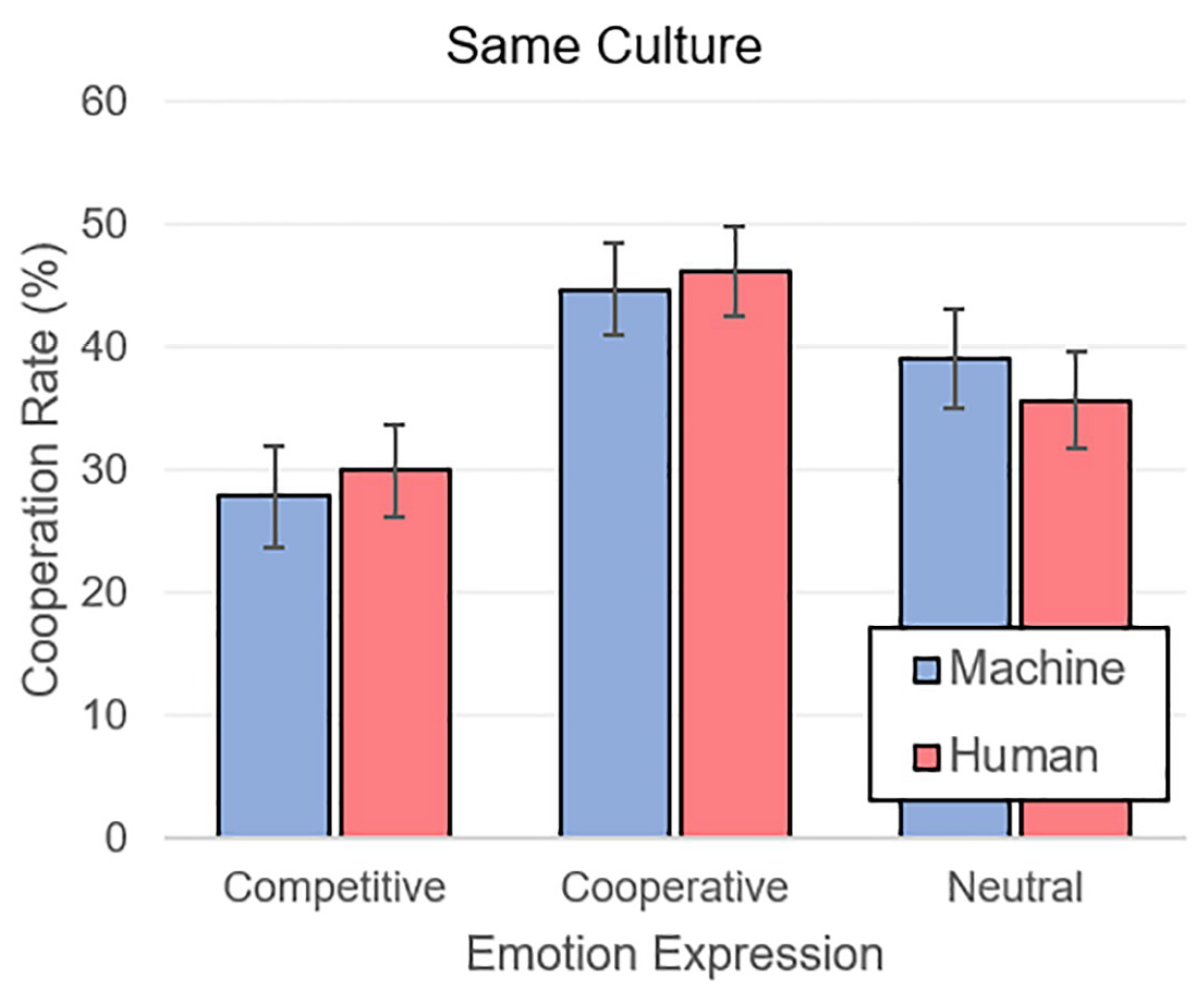

Image n ° 4

Image n ° 4Lorsque les participants ont rencontré des partenaires du même groupe culturel, la situation était similaire. Les émotions coopératives (M = 45,55, SE = 2,61) l'emportaient sur les émotions neutres (M = 37,42, SE = 2,81) et compétitives (M = 28,99, SE = 2,78).

La totalité des résultats montre clairement qu'une personne utilise les mêmes paramètres psychologiques de confiance et de méfiance dans la communication avec une machine qu'une autre personne. Les voitures autonomes sont initialement perçues comme des membres d'un groupe social étranger à la personne. Cependant, l'utilisation d'un visage visuel avec des traits d'une certaine identité culturelle appropriée au partenaire humain peut atténuer la méfiance envers la machine.

L'observation la plus importante est que l'identité culturelle et l'appartenance aux machines sont complètement nivelées par les émotions correctes, pour ainsi dire.

Pour une connaissance plus détaillée des nuances de l'étude, je vous recommande de consulter le

rapport des scientifiques .

Épilogue

Cette étude est très ambiguë, mais elle nous montre une caractéristique importante de la psychologie humaine. Nous classons inconsciemment les gens autour de nous dans certains groupes sociaux, éprouvant une plus grande confiance dans ceux qui appartiennent à notre groupe. Ceci est notre principale réaction. Mais ce n'est pas le seul, car lorsque nous communiquons avec une personne, nous commençons à recevoir un certain nombre de signaux (visuels et sonores) exprimés par les émotions, la manière de parler, la voix, etc. Ces signaux complètent l'image de la représentation d'une personne pour nous, à partir de laquelle nous sommes repoussés au moment de prendre une décision - faire confiance ou non. En d'autres termes, la catégorisation sociale qui se produit dans nos têtes n'a pas d'importance quand il s'agit d'une communication vivante. C'est ce que disent les vieux dictons: «ils sont accueillis par des vêtements, mais escortés par l'esprit» et «ne jugent pas un livre par sa couverture».

En ce qui concerne les voitures, une personne était toujours à l'écoute avec appréhension et méfiance, qui n'étaient souvent pas soutenues par des raisons importantes. Telle est la nature de l'homme - rejeter initialement ce qui est étranger. Cependant, tout comme la connaissance vainc l'ignorance, l'interaction réelle avec des machines autonomes capables d'exprimer des émotions l'emporte sur les préjugés humains.

Est-ce à dire que tous les robots du futur devraient avoir des émotions? Oui et non. Les chercheurs, dont les travaux que nous avons examinés aujourd'hui, croient que dans le premier couple d'émotions pour les robots sera une excellente fonction qui peut accélérer le processus d'adoption de machines autonomes par une société de personnes. Que puis-je dire, pour vivre avec des loups - hurlez comme un loup, peu importe à quel point cela semble grossier.

De plus, nous dotons déjà les robots de nos propres traits: nous leur faisons des yeux comme les nôtres, des visages comme les nôtres, les dotons de voix et d'émotions. Une personne essaiera toujours d'humaniser la voiture et, comme le montre cette étude, pas en vain.

Vendredi hors-dessus:Le documentaire "Hyper évolution: la montée des machines" (Partie I, Partie II , Partie III ). Merci de votre attention, restez curieux et passez un bon week-end à tous, les gars! :)

Merci de rester avec nous. Aimez-vous nos articles? Vous voulez voir des matériaux plus intéressants? Soutenez-nous en passant une commande ou en le recommandant à vos amis,

cloud VPS pour les développeurs à partir de 4,99 $ , une

réduction de 30% pour les utilisateurs Habr sur un analogue unique de serveurs d'entrée de gamme que nous avons inventé pour vous: toute la vérité sur VPS (KVM) E5-2650 v4 (6 Cœurs) 10 Go DDR4 240 Go SSD 1 Gbps à partir de 20 $ ou comment partager un serveur? (les options sont disponibles avec RAID1 et RAID10, jusqu'à 24 cœurs et jusqu'à 40 Go de DDR4).

Dell R730xd 2 fois moins cher? Nous avons seulement

2 x Intel TetraDeca-Core Xeon 2x E5-2697v3 2.6GHz 14C 64GB DDR4 4x960GB SSD 1Gbps 100 TV à partir de 199 $ aux Pays-Bas! Dell R420 - 2x E5-2430 2.2Ghz 6C 128GB DDR3 2x960GB SSD 1Gbps 100TB - à partir de 99 $! Pour en savoir plus sur la

création d'un bâtiment d'infrastructure. classe utilisant des serveurs Dell R730xd E5-2650 v4 coûtant 9 000 euros pour un sou?