Le monde qui nous entoure regorge de toutes sortes d'informations que notre cerveau traite en permanence. Il reçoit cette information par les sens, chacun étant responsable de sa part de signaux: yeux (vision), langue (goût), nez (odeur), peau (toucher), appareil vestibulaire (équilibre, position spatiale et sens du poids) et oreilles (son). En rassemblant les signaux de tous ces organes, notre cerveau peut construire une image précise de l'environnement. Mais nous ne connaissons pas tous les aspects du traitement du signal externe. L'un de ces secrets est le mécanisme de localisation de la source sonore.

Des scientifiques du Laboratoire de neuroingénierie de la parole et de l'ouïe (New Jersey Institute of Technology) ont proposé un nouveau modèle du processus neuronal de localisation sonore. Quels processus se produisent exactement dans le cerveau pendant la perception du son, comment notre cerveau comprend la position de la source sonore et comment cette étude peut aider à lutter contre les malentendants. Nous en apprenons à travers le rapport du groupe de recherche. Allons-y.

Base d'étude

Les informations que notre cerveau reçoit des sens diffèrent les unes des autres à la fois en termes de source et en termes de traitement. Certains signaux apparaissent immédiatement devant notre cerveau sous la forme d'informations précises, tandis que d'autres nécessitent des processus de calcul supplémentaires. Grosso modo, on sent tout de suite le toucher, mais quand on entend le son, il faut quand même trouver d'où il vient.

La base de la localisation des sons dans le plan horizontal est la

différence de temps

interaurale * (ITD à partir de la

différence de temps interaurale ) des sons atteignant les oreilles de l'auditeur.

Base interaurale * - la distance entre les oreilles.

Il y a une certaine zone dans le cerveau (olive supérieure médiale ou MBO) qui est responsable de ce processus. Au moment de recevoir le signal sonore dans le MBO, les différences temporelles interaurales sont converties en vitesse de réaction des neurones. La forme des courbes de vitesse de sortie du MBO en tant que fonction ITD ressemble à la forme de la fonction de corrélation croisée des signaux d'entrée pour chaque oreille.

La façon dont les informations sont traitées et interprétées dans le MBO n'est pas complètement claire, c'est pourquoi il existe plusieurs théories très contradictoires. La théorie la plus connue et en fait classique de la localisation du son est le modèle de Jeffress (

Lloyd A. Jeffress ). Il est basé sur une

ligne marquée * de détecteurs

de neurones qui sont sensibles au synchronisme binaural des signaux d'entrée neuronaux de chaque oreille, et chaque neurone est le plus sensible à une valeur ITD spécifique (

1A ).

Le principe de la ligne marquée * est une hypothèse qui explique comment différents nerfs, qui utilisent tous les mêmes principes physiologiques pour transmettre des impulsions le long de leurs axones, sont capables de générer des sensations différentes. Des nerfs structurellement similaires peuvent générer des perceptions sensorielles différentes s'ils sont associés à des neurones uniques dans le système nerveux central qui sont capables de décoder des signaux nerveux similaires de diverses manières.

Image n ° 1

Image n ° 1Ce modèle est similaire sur le plan informatique au codage neuronal basé sur des corrélations croisées illimitées de sons atteignant les deux oreilles.

Il existe également un modèle dans lequel on suppose que la localisation du son peut être modélisée sur la base des différences de vitesse de réaction de certaines populations de neurones de différents hémisphères du cerveau, c'est-à-dire modèle d'asymétrie interhémisphérique (

1B ).

Jusqu'à présent, il était difficile de dire sans équivoque laquelle des deux théories (modèles) était correcte, étant donné que chacune d'elles prédit des dépendances différentes de la localisation du son sur l'intensité sonore.

Dans l'étude que nous envisageons aujourd'hui, les scientifiques ont décidé de combiner les deux modèles afin de comprendre si la perception des sons est basée sur le codage neuronal ou sur la différence de réponse des populations neuronales individuelles. Plusieurs expériences ont été réalisées auxquelles ont participé des personnes âgées de 18 à 27 ans (5 femmes et 7 hommes). L'audiométrie (mesure de l'acuité auditive) des participants était de 25 dB ou plus à une fréquence de 250 à 8000 Hz. Le participant à l'expérience a été placé dans une pièce insonorisée dans laquelle un équipement spécial a été calibré avec une grande précision. Les participants doivent, après avoir entendu un signal sonore, indiquer la direction d'où il provient.

Résultats de recherche

Pour évaluer la dépendance de la

latéralisation * de l'activité cérébrale à l'intensité du son en réponse à des neurones marqués, nous avons utilisé des données sur la vitesse de réaction des neurones dans le noyau laminaire du cerveau de la chouette effraie.

Latéralité * - asymétrie des moitiés gauche et droite du corps.

Pour évaluer la dépendance de la latéralisation de l'activité cérébrale à la vitesse de réaction de certaines populations de neurones, nous avons utilisé les données d'activité des deux cerveaux inférieurs du singe rhésus, après quoi les différences de vitesse des neurones de différents hémisphères ont été calculées en plus.

Le modèle de la ligne marquée des détecteurs de neurones suggère qu'avec une diminution de l'intensité sonore, la latéralité de la source perçue convergera en valeurs moyennes similaires au rapport des sons faibles et forts (

1C ).

Le modèle d'asymétrie interhémisphérique, à son tour, suggère qu'avec une diminution de l'intensité sonore à presque le seuil, la latéralité perçue se déplacera vers la ligne médiane (

1D ).

À une intensité sonore globale plus élevée, on suppose que la latéralisation sera invariante en intensité (inserts à

1C et

1D ).

Par conséquent, une analyse de la façon dont l'intensité sonore affecte la direction perçue du son vous permet de déterminer avec précision la nature des processus qui se déroulent à ce moment-là - des neurones d'une zone commune ou des neurones de différents hémisphères.

De toute évidence, la capacité d’une personne à faire la distinction entre les ITD peut varier en fonction de l’intensité sonore. Cependant, les scientifiques disent qu'il est difficile d'interpréter les résultats antérieurs concernant la sensibilité aux ITD et l'évaluation par l'auditeur de la direction de la source sonore en fonction de l'intensité sonore. Certaines études affirment que lorsque l'intensité sonore atteint le seuil limite, la latéralité perçue de la source diminue. D'autres études suggèrent qu'il n'y a aucun effet de l'intensité sur la perception.

En d'autres termes, les scientifiques suggèrent «doucement» qu'il n'y a pas suffisamment d'informations dans la littérature concernant la relation entre l'ITD, l'intensité sonore et la détermination de la direction de sa source. Il existe des théories qui existent comme une sorte d'axiomes généralement acceptés par la communauté scientifique. Par conséquent, il a été décidé de tester en détail toutes les théories, modèles et mécanismes possibles de perception auditive dans la pratique.

La première expérience a été menée en utilisant le paradigme psychophysique, qui nous a permis d'étudier la latéralisation basée sur les ITD en fonction de l'intensité sonore dans un groupe de dix participants normalement entendants à l'expérience.

Image n ° 2

Image n ° 2Les sources sonores ont été spécialement réglées pour couvrir la majeure partie de la gamme de fréquences dans laquelle les gens sont capables de reconnaître les ITD, c'est-à-dire 300 à 1200 Hz (

2A ).

Dans chacun des tests, l'auditeur devait indiquer la latéralité attendue, mesurée en fonction du niveau de sensations, dans la plage des valeurs ITD de 375 à 375 ms. Pour déterminer l'effet de l'intensité sonore, le modèle à effets mixtes non linéaires (NMLE) a été utilisé, qui comprenait à la fois l'intensité sonore fixe et aléatoire.

Le graphique

2B montre la latéralisation estimée avec un bruit spectralement plat à deux intensités sonores pour un auditeur représentatif. Un graphique

2C montre les données brutes (cercles) et adaptées au modèle NMLE (lignes) de tous les auditeurs.

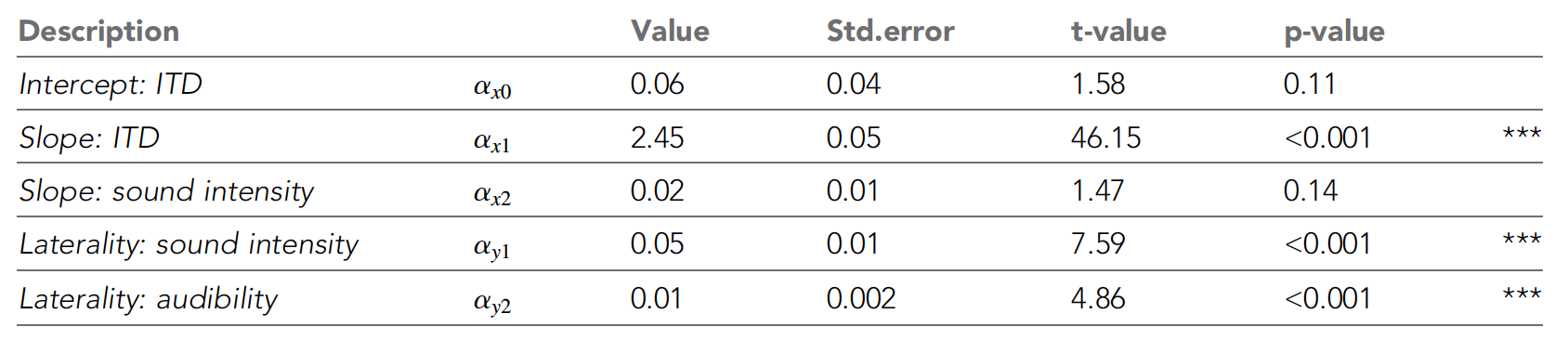

Tableau numéro 1

Tableau numéro 1Le tableau ci-dessus montre tous les paramètres NLME. On peut voir que la latéralité perçue augmentait avec l'augmentation de l'ITD, comme les scientifiques l'avaient prévu. Avec une diminution de l'intensité sonore, la perception s'est déplacée de plus en plus vers la ligne médiane (insérer sur le graphique

2C ).

Ces tendances ont été renforcées par le modèle NLME, qui a montré une influence significative de l'ITD et de l'intensité sonore sur le degré maximal de latéralité, confirmant le modèle des différences interhémisphériques.

De plus, les seuils audiométriques moyens des tons purs ont eu un effet négligeable sur la latéralité perçue. Mais l'intensité sonore n'a pas affecté de manière significative les performances des fonctions psychométriques.

L'objectif principal de la deuxième expérience était de déterminer comment les résultats obtenus lors de l'expérience précédente changent lorsque les caractéristiques spectrales des stimuli (sons) sont prises en compte. La nécessité de tester un bruit spectralement plat à faible intensité sonore est que certaines parties du spectre peuvent ne pas être entendues, ce qui peut affecter la détermination de la direction du son. Par conséquent, le fait que la largeur de la partie audible du spectre puisse diminuer avec une intensité sonore décroissante peut être confondu avec les résultats de la première expérience.

Par conséquent, il a été décidé de mener une autre expérience, mais en utilisant déjà le bruit de retour

pondéré A * .

La pondération A * est appliquée aux niveaux sonores pour tenir compte de l'intensité sonore perçue par l'oreille humaine, car l'oreille est moins sensible aux basses fréquences sonores. La pondération A est mise en œuvre par arithmétique en ajoutant un tableau de valeurs répertoriées en bandes d'octave aux niveaux de pression acoustique mesurés en dB.

Le graphique

2D montre les données brutes (cercles) et les données (lignes) de tous les participants à l'expérience adaptées au modèle NMLE.

Une analyse des données a montré que lorsque toutes les parties du son sont à peu près également audibles (dans les première et deuxième expériences), la latéralité et la pente perçues sur le graphique expliquant le changement de latéralité avec l'ITD diminuent avec la diminution de l'intensité sonore.

Ainsi, les résultats de la deuxième expérience ont confirmé les résultats de la première. Autrement dit, dans la pratique, il a été démontré que le modèle proposé en 1948 par Jeffress n'est pas correct.

Il s'avère que la localisation des sons se détériore avec une diminution de l'intensité sonore, et Jeffress pensait que les sons sont perçus et traités par une personne de manière égale quelle que soit leur intensité.

Pour une connaissance plus détaillée des nuances de l'étude, je vous recommande de consulter le

rapport des scientifiques .

Épilogue

Des hypothèses théoriques et des expériences pratiques les confirmant ont montré que les neurones cérébraux des mammifères sont activés à différentes vitesses en fonction de la direction du signal sonore. Ensuite, le cerveau compare ces vitesses entre tous les neurones impliqués dans le processus pour cartographier dynamiquement l'environnement sonore.

Le modèle de Jeffresson n'est en fait pas 100% erroné, car il peut être utilisé pour décrire parfaitement l'emplacement d'une source sonore dans une chouette effraie. Oui, pour les chouettes effraies, l'intensité du son n'a pas d'importance, elles détermineront en tout cas la position de sa source. Cependant, ce modèle ne fonctionne pas avec des singes rhésus, comme l'ont montré les expériences précédentes. Par conséquent, ce modèle de Jeffresson ne peut pas décrire la localisation des sons pour tous les êtres vivants.

Des expériences avec des personnes ont confirmé une fois de plus que la localisation des sons se produit dans différents organismes de différentes manières. De nombreux participants n'ont pas pu déterminer correctement la position de la source des signaux sonores en raison de la faible intensité des sons.

Les scientifiques pensent que leur travail montre une certaine similitude entre la façon dont nous voyons et la façon dont nous entendons. Les deux processus sont associés à la vitesse des neurones dans différentes parties du cerveau, ainsi qu'à l'évaluation de cette différence pour déterminer à la fois la position des objets que nous voyons dans l'espace et la position de la source du son que nous entendons.

À l'avenir, les chercheurs vont mener une série d'expériences pour examiner de plus près la relation entre l'audition et la vision humaines, ce qui nous aidera à mieux comprendre comment notre cerveau construit dynamiquement une carte du monde qui nous entoure.

Merci de votre attention, restez curieux et bonne semaine de travail, les gars! :)

Merci de rester avec nous. Aimez-vous nos articles? Vous voulez voir des matériaux plus intéressants? Soutenez-nous en passant une commande ou en le recommandant à vos amis,

cloud VPS pour les développeurs à partir de 4,99 $ , une

réduction de 30% pour les utilisateurs Habr sur un analogue unique de serveurs d'entrée de gamme que nous avons inventé pour vous: toute la vérité sur VPS (KVM) E5-2650 v4 (6 Cœurs) 10 Go DDR4 240 Go SSD 1 Gbps à partir de 20 $ ou comment partager un serveur? (les options sont disponibles avec RAID1 et RAID10, jusqu'à 24 cœurs et jusqu'à 40 Go de DDR4).

Dell R730xd 2 fois moins cher? Nous avons seulement

2 x Intel TetraDeca-Core Xeon 2x E5-2697v3 2.6GHz 14C 64GB DDR4 4x960GB SSD 1Gbps 100 TV à partir de 199 $ aux Pays-Bas! Dell R420 - 2x E5-2430 2.2Ghz 6C 128GB DDR3 2x960GB SSD 1Gbps 100TB - à partir de 99 $! Pour en savoir plus sur la

création d'un bâtiment d'infrastructure. classe utilisant des serveurs Dell R730xd E5-2650 v4 coûtant 9 000 euros pour un sou?