L'intelligence artificielle (IA) passe rapidement de la science-fiction à la vie quotidienne. Les appareils modernes reconnaissent la parole humaine, sont capables de répondre aux questions et d'effectuer une traduction automatique. Dans divers domaines, de la conduite d'un véhicule sans pilote au diagnostic du cancer, des algorithmes de reconnaissance d'objets basés sur l'IA sont utilisés, dont les capacités sont supérieures à celles des humains. Les grandes sociétés de médias utilisent le journalisme robotisé pour créer des articles similaires au droit d'auteur à partir des données collectées. L'IA est évidemment prête à devenir une technologie véritablement universelle, comme l'électricité.

Quelles approches et technologies sont considérées comme les plus prometteuses? Quelles découvertes majeures sont possibles dans les années à venir? Est-il possible de créer une machine ou une intelligence artificielle vraiment comparable à l'homme, et dans combien de temps? Quels risques et menaces sont associés à l'IA, et comment les éviter? L'IA causera-t-elle le chaos dans l'économie et le marché du travail? Les machines superintelligentes échapperont-elles au contrôle humain et deviendront-elles une véritable menace?

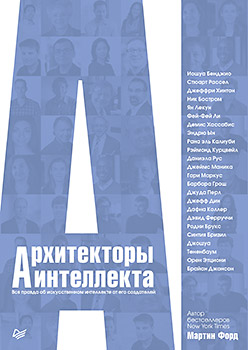

Bien sûr, il est impossible de prédire l'avenir. Néanmoins, les experts en savent plus que quiconque sur l'état actuel de la technologie, ainsi que sur les innovations dans un avenir proche. Vous aurez de brillantes rencontres avec des personnes reconnues comme R. Kurzweil, D. Hassabis, J. Hinton, R. Brooks et bien d'autres.

Yan Lekun

VICE-PRÉSIDENT ET FONDATEUR DU LABORATOIRE DE RECHERCHE EN IA À FACEBOOK (FAIR), PROFESSEUR EN INFORMATIQUE À L'UNIVERSITÉ DE NEW YORK

Avec Jeffrey Hinton et Joshua Benjio, Ian Lekun fait partie d'un groupe de chercheurs dont les efforts et la persévérance ont conduit à la révolution actuelle en relation avec les réseaux de neurones et l'apprentissage profond. Tout en travaillant aux Bell Labs, il a inventé les réseaux de neurones convolutionnels. Il a obtenu un diplôme d'ingénieur électricien à Paris de l'ESIEE, et un doctorat en informatique de l'Université Pierre et Marie Curie. Après ses études supérieures, il a travaillé au laboratoire Jeffrey Hinton de l'Université de Toronto.Martin Ford: L'explosion d'intérêt pour l'apprentissage en profondeur au cours des 10 dernières années est une conséquence de l'amélioration simultanée des réseaux de neurones, augmentant la puissance des ordinateurs et la quantité de données disponibles?

Yang Lekun: Oui, mais le processus était plus délibéré. Apparu en 1986-1987. l'algorithme de rétropropagation a permis de former des réseaux de neurones multicouches. Cela a provoqué une vague d’intérêt qui a duré jusqu’en 1995. En 2003, Jeffrey Hinton, Joshua Benggio et moi avons proposé un plan pour renouveler l’intérêt de la communauté pour ces méthodes parce qu’ils étaient convaincus de leur victoire imminente. On peut donc dire qu'il y a eu une conspiration délibérée.

M.F .: Avez-vous déjà compris toutes les perspectives? L'IA et le deep learning sont désormais considérés comme synonymes.

I. L .: Oui et non. Nous savions que les méthodes formeraient la base de la vision par ordinateur, de la reconnaissance vocale et peut-être de quelques autres choses, mais personne ne s'attendait à ce qu'elles s'étendent à la compréhension du langage naturel, de la robotique, de l'analyse de l'imagerie médicale et même contribuent à l'émergence de véhicules sans pilote. Au début des années 1990. Je pensais que le mouvement vers ces choses serait plus fluide, et ils apparaîtraient un peu plus tôt. Nous attendions la révolution qui s'est produite vers 2013.

M.F.: Et comment est

né votre intérêt pour l'IA et l'apprentissage automatique?

Y. L.: Dès mon enfance, je m'intéressais aux sciences, à la technologie et aux problèmes mondiaux concernant l'origine de la vie, l'intelligence, l'origine de l'humanité. L'idée de l'IA m'a fasciné. Mais dans les années 1960-1970. personne ne faisait ça en France, donc après l'école, je suis allé étudier en tant qu'ingénieur.

En 1980, j'ai beaucoup aimé le livre sur la philosophie du langage et de l'apprentissage: le débat entre Jean Piaget et Noam Chomsky ("Langage et apprentissage: une discussion entre Jean Piaget et Noam Chomsky"), dans lequel le créateur de la théorie du développement cognitif et le linguiste ont discuté de la nature et de l'éducation , ainsi que l'émergence du langage et de l'intelligence.

Du côté de Piaget, le professeur du MIT, Seymour Peypert, a parlé des origines de l'apprentissage automatique à la fin des années 1960. effectivement contribué à l'arrêt du travail avec les réseaux de neurones. Et maintenant, après 10 ans, il a vanté le soi-disant perceptron - un modèle très simple d'apprentissage automatique qui est apparu dans les années 1950. et sur lequel il a travaillé dans les années 1960. Donc, pour la première fois, je me suis familiarisé avec le concept d'apprentissage automatique et j'étais absolument fasciné par celui-ci. La capacité d'apprendre, je considérais une partie intégrante de l'intelligence.

En tant qu'étudiant, j'ai lu tout ce que je pouvais trouver sur l'apprentissage automatique et j'ai réalisé plusieurs projets sur ce sujet. Il s'est avéré qu'en Occident, personne ne travaille avec les réseaux de neurones. Certains chercheurs japonais ont travaillé sur ce qui deviendra plus tard ce terme. Dans notre pays, ce sujet n’intéressait personne, en partie à cause de ce qui apparaissait à la fin des années 60. livres de Peypert et Minsky.

J'ai entamé des recherches indépendantes et en 1987, j'ai soutenu ma thèse de doctorat Modeles connexionnistes de l'apprentissage. Mon manager Maurice Milgram n'a pas traité de ce sujet et m'a directement dit qu'il pouvait officiellement devenir mon consultant, mais il ne pouvait pas m'aider techniquement.

Au début des années 80 J'ai découvert une communauté de personnes qui travaillaient sur des réseaux de neurones et les ai contactés. En conséquence, en parallèle avec David Rumelhart et Jeffrey Hinton, j'ai découvert une chose telle que la méthode de propagation arrière de l'erreur.

M.F.: C'est-à-dire au début des années 80. Au Canada, il y a eu de nombreuses études dans ce domaine?

Y. L.: Non, tout s'est passé aux États-Unis. Au Canada, de telles études n'ont pas encore été menées. Au début des années 80 Jeffrey Hinton était un employé de l'Université de Californie à San Diego, où il a travaillé avec des psychologues cognitifs tels que David Rumelhart et James McClelland. En conséquence, un livre est apparu expliquant la psychologie à l'aide de réseaux neuronaux simples et de modèles informatiques. Jeffrey est ensuite devenu professeur adjoint à l'Université Carnegie Mellon. Il n'a déménagé à Toronto qu'en 1987. Ensuite, j'ai déménagé à Toronto et j'ai travaillé dans son laboratoire pendant un an.

M.F .: Au début des années 80. J'étais étudiant en informatique et je ne me souviens pas que les réseaux de neurones étaient utilisés quelque part. Maintenant, la situation a radicalement changé.

Y. L .: Les réseaux de neurones ne sont pas seulement en marge de la science. Dans les années 1970 et au début des années 80. ils étaient en fait anathématisés. Les articles ont été rejetés pour une mention des réseaux de neurones.

L'article bien connu Optimal Perceptual Inference, qui a été publié en 1983 par Jeffrey Hinton et Terry Seinowski. Pour y décrire l'un des premiers modèles d'apprentissage profond et de réseau neuronal, ils ont utilisé des mots de code, même dans le nom.

M.F.: Vous êtes connu comme l'auteur d'un réseau neuronal convolutif. Veuillez expliquer de quoi il s'agit?

Y. L .: Initialement, ce réseau de neurones a été optimisé pour la reconnaissance d'objets dans les images. Mais il s'est avéré qu'elle peut être appliquée à un large éventail de tâches, telles que la reconnaissance vocale et la traduction automatique. L'idée de sa création a été servie par les caractéristiques du cortex visuel du cerveau des animaux et des humains, étudiées dans les années 1950 et 1960. David Hubel et Thorsten Wiesel, qui ont reçu plus tard le prix Nobel de neurobiologie.

Le réseau convolutionnel est un moyen spécial de connecter des neurones qui ne sont pas une copie exacte des neurones biologiques. Dans la première couche - la couche de convolution - chaque neurone est associé à un petit nombre de pixels d'image et calcule la somme pondérée de ses données d'entrée. Pendant l'entraînement, les poids changent. Des groupes de neurones voient de petites zones de l'image. Si un neurone détecte une caractéristique spécifique dans une zone, un autre neurone détectera exactement la même caractéristique dans la zone adjacente, et tous les autres neurones dans les zones restantes de l'image. L'opération mathématique que les neurones effectuent ensemble est appelée convolution discrète. D'où le nom.

Vient ensuite la couche non linéaire, où chaque neurone s'allume ou s'éteint, selon que la somme pondérée calculée par la couche de convolution s'est avérée supérieure ou inférieure au seuil spécifié. Enfin, la troisième couche effectue une opération de sous-échantillonnage pour s'assurer qu'une légère polarisation ou déformation de l'image d'entrée ne modifie pas considérablement la sortie. Cela offre une indépendance vis-à-vis des déformations de l'image d'entrée.

En fait, un réseau convolutionnel est une pile organisée à partir de couches de convolution, de non-linéarité et de sous-échantillonnage. Lorsqu'ils sont pliés, des neurones apparaissent qui reconnaissent les objets. Par exemple, un neurone qui s'allume lorsque le cheval est sur l'image, un autre neurone pour les voitures, un troisième pour les personnes, etc., pour toutes les catégories dont vous avez besoin.

De plus, ce que fait le réseau neuronal est déterminé par la force des connexions entre les neurones, c'est-à-dire les poids. Et ces poids ne sont pas programmés, mais sont le résultat de l'entraînement.

L'image du cheval est montrée au réseau, et s'il ne répond pas «cheval», il sera informé que c'est faux et sera invité avec la bonne réponse. Après cela, en utilisant l'algorithme de propagation d'erreur de retour, le réseau ajuste les poids de toutes les connexions de sorte que la prochaine fois que la même image sera affichée, le résultat sera plus proche de celui souhaité. En même temps, vous devez lui montrer des milliers d'images.

M. F.: S'agit-il d'un enseignement avec un enseignant? Si je comprends bien, c'est maintenant l'approche dominante.

Y. L .: Exactement. Presque toutes les applications modernes d'apprentissage en profondeur utilisent la formation des enseignants. La magie est que le réseau formé donne la plupart du temps les bonnes réponses même pour des images auxquelles il n'avait pas été montré auparavant. Mais il a besoin d'un grand nombre d'exemples.

M.F.: Et à quoi peut-on s'attendre à l'avenir? Sera-t-il possible d'enseigner une voiture à un enfant qui n'a qu'à montrer une fois un chat et à le nommer?

I. L .: En fait, vous n'avez pas tout à fait raison. Les premières formations convolutionnelles se déroulent réellement sur des millions d'images de différentes catégories. Et puis, si vous devez ajouter une nouvelle catégorie, par exemple, apprendre à un ordinateur à reconnaître les chats, quelques échantillons suffisent. Après tout, le réseau est déjà formé pour reconnaître des objets de presque n'importe quel type. Les ajouts à la formation concernent une paire de couches supérieures.

MF: Cela ressemble déjà à la façon dont les enfants étudient.

Y. L.: Non, malheureusement, ce n'est pas du tout comme ça. Les enfants obtiennent la plupart des informations avant que quelqu'un ne leur dise: "Ceci est un chat." Au cours des premiers mois de la vie, les enfants apprennent sans avoir la moindre idée de la langue. Ils reconnaissent la structure du monde en observant simplement le monde et en interagissant un peu avec lui. Cette façon d'accumuler des connaissances n'est pas disponible pour les machines. Comment l'appeler n'est pas clair. Certains utilisent le terme provocateur «enseignement sans enseignant». Cette formation est parfois appelée formation anticipative ou inductive. J'appelle cela l'auto-apprentissage. Lors de la formation de ce type, il n'est pas question de se préparer à effectuer une tâche, il s'agit simplement d'observer le monde et son fonctionnement.

M.F.: L'apprentissage renforcé entre-t

- il dans cette catégorie?

Y. L.: Non, c'est une catégorie complètement différente. En fait, il existe trois catégories principales: l'apprentissage renforcé, la formation des enseignants et l'auto-apprentissage.

L'entraînement avec renforcement se fait par essais et erreurs et fonctionne bien pour les jeux où vous pouvez faire autant de tentatives que vous le souhaitez. Les bonnes performances d'AlphaGo ont été obtenues après que la machine ait joué plus de jeux que toute l'humanité au cours des trois mille dernières années. Aux problèmes du monde réel, une telle approche n'est pas pratique.

Une personne peut apprendre à conduire une voiture en 15 heures de formation sans s'écraser. Si vous utilisez les méthodes d'entraînement existantes avec des renforts, la voiture, pour apprendre à rouler sans chauffeur, devra tomber 10 000 fois d'une falaise avant de comprendre comment l'éviter.

M.F .: Il me semble que c'est un argument en faveur de la modélisation.

Y. L.: C'est plutôt une confirmation que le type de formation que les gens utilisent est très différent de l'apprentissage renforcé. Ceci est similaire à la formation de renforcement basée sur un modèle. Après tout, une personne qui conduit pour la première fois a un modèle du monde et peut prédire les conséquences de ses actes. Comment amener une machine à étudier indépendamment des modèles prédictifs est un problème majeur non résolu.

M.F.: C'est à ça que

sert votre travail avec Facebook?

I. L .: Oui, c'est l'une des choses sur lesquelles nous travaillons. Nous formons également la machine à observer différentes sources de données. Nous construisons un modèle du monde, en espérant y refléter le bon sens, afin qu'il puisse plus tard servir de pronostic.

M.F.: Certaines personnes pensent que le deep learning seul ne suffit pas, et dans les réseaux il devrait d'abord y avoir une structure responsable de l'intelligence. Et vous semblez convaincu que l'intelligence peut émerger organiquement à partir de réseaux neuronaux relativement universels.

Y. L.: Vous exagérez. Tout le monde est d'accord avec la nécessité de la structure, la question est de savoir à quoi elle devrait ressembler. Et en parlant de gens qui croient qu'il devrait y avoir des structures qui fournissent une réflexion logique et la capacité de discuter, vous voulez probablement dire Gary Marcus et, éventuellement, Oren Etzioni. Nous nous sommes disputés avec Gary sur ce sujet ce matin. Son opinion n'est pas bien reçue dans la communauté, car, sans apporter la moindre contribution à l'apprentissage en profondeur, il a écrit de manière critique à ce sujet. Oren a travaillé dans ce domaine pendant un certain temps et en même temps parle beaucoup plus doucement.

En fait, l'idée de réseaux convolutionnels est née comme une tentative d'ajouter de la structure aux réseaux de neurones. La question est: qui permet à la machine de manipuler des caractères ou, par exemple, de correspondre aux caractéristiques hiérarchiques de la langue?

Beaucoup de mes collègues, dont Jeffrey Hinton et Joshua Benggio, conviennent que tôt ou tard nous pouvons nous passer de structures. Ils peuvent être utiles à court terme, car un moyen d'auto-apprentissage n'a pas encore été inventé. Ce point peut être contourné en reliant tout à l'architecture. Mais la microstructure du cortex, à la fois visuelle et préfrontal, semble complètement homogène.

M.F .: Le cerveau utilise-t-il quelque chose de similaire à la méthode de propagation des erreurs?

I. L .: C'est inconnu. Il peut s'avérer que ce n'est pas la rétropropagation dans la forme telle que nous la connaissons, mais une forme similaire d'approximation de l'estimation du gradient. Joshua Benggio a travaillé sur des formes biologiquement plausibles d'estimation de gradient. Il est possible que le cerveau estime le gradient de toute fonction cible.

M.F.: Sur quelles autres choses importantes travaillez-vous sur Facebook?

Y. L.: Nous sommes engagés dans une variété de recherches fondamentales, ainsi que des problèmes d'apprentissage automatique, par conséquent, nous traitons principalement des mathématiques appliquées et de l'optimisation. Des travaux sont en cours sur l'apprentissage renforcé et les modèles dits génératifs, qui sont une forme d'auto-apprentissage ou d'apprentissage anticipatif.

MF: Facebook développe-t

- il des systèmes capables de maintenir une conversation?

Y. L.: J'ai énuméré les sujets de recherche fondamentale ci-dessus, mais il existe également de nombreux domaines d'application. Facebook développe activement des développements dans le domaine de la vision par ordinateur, et on peut affirmer que nous avons le meilleur groupe de recherche au monde. Nous travaillons beaucoup sur le traitement de texte en langage naturel. Cela comprend la traduction, la généralisation, la catégorisation (trouver le sujet discuté) et les systèmes de dialogue pour les assistants virtuels, les systèmes de questions et réponses, etc.

M.F.: Pensez-vous qu'un jour il y aura une IA qui pourra passer le test de Turing?

I. L .: À un moment donné, cela se produira, mais je ne considère pas le test de Turing comme un bon critère: il est facile de tromper et il est quelque peu dépassé. Beaucoup oublient ou refusent de croire que la langue est un phénomène secondaire par rapport à l'intelligence.

»Plus d'informations sur le livre sont disponibles sur

le site Web de l'éditeur»

Contenu»

Extrait25% de réduction sur les colporteurs -

Intelligence ArchitectsLors du paiement de la version papier du livre, un livre électronique est envoyé par e-mail.