La résolution des problèmes de rayonnement a été un «tournant dans l'histoire de l'électronique spatiale»

Phobos-Grunt

Phobos-Grunt , l'un des projets spatiaux les plus ambitieux de la Russie moderne, est tombé dans l'océan début 2012. Ce vaisseau spatial devait atterrir à la surface de la minable lune martienne Phobos, collecter des échantillons de sol et les ramener sur Terre. Mais au lieu de cela, il a dérivé sans défense pendant plusieurs semaines en

orbite terrestre basse (DOE) en raison de la panne de l'ordinateur de bord avant de démarrer les moteurs, qui étaient censés envoyer le navire vers Mars.

Dans un

rapport ultérieur

, les autorités russes ont accusé les particules lourdes chargées des rayons cosmiques galactiques qui sont entrés en collision avec les puces SRAM et ont provoqué la défaillance de la puce en raison d'un courant excessif qui la traversait. Pour faire face à ce problème, les deux processeurs exécutés sur l'ordinateur, l'ordinateur, ont démarré un redémarrage. Après cela, la sonde est passée en mode veille sécurisé pour les commandes de la Terre. Malheureusement, aucune instruction n'a été reçue.

Les antennes de communication devaient atteindre le mode de fonctionnement prévu après que le navire eut quitté le DOE. Cependant, personne n'a prévu le refus, à cause duquel la sonde n'aurait pas atteint ce stade. Après une collision avec des particules, Phobos-Grunt était dans une impasse étrange. Le démarrage des moteurs embarqués était censé déclencher le déploiement d'antennes. Les moteurs ne pouvaient être démarrés qu'avec une commande de la Terre. Et cette commande n'a pas pu venir, car les antennes n'étaient pas déployées. Une erreur informatique a entraîné l'effondrement de la mission, qui se préparait depuis plusieurs décennies. En particulier, les membres de l'équipe des ONG ONG sont à blâmer pour la surveillance. Lavochkin, le fabricant de l'appareil. Pendant le développement, il était plus facile de répertorier ce qui fonctionnait sur leur ordinateur que ce qui ne fonctionnait pas. Cependant, chaque petite erreur qu'ils ont commise est devenue un rappel brutal que le développement d'ordinateurs de classe spatiale est terriblement compliqué. Une fois que vous trébuchez, et des milliards de dollars sont brûlés.

Les développeurs ont simplement sous-estimé les difficultés des ordinateurs dans l'espace.

Qu'est-ce qui est si lent?

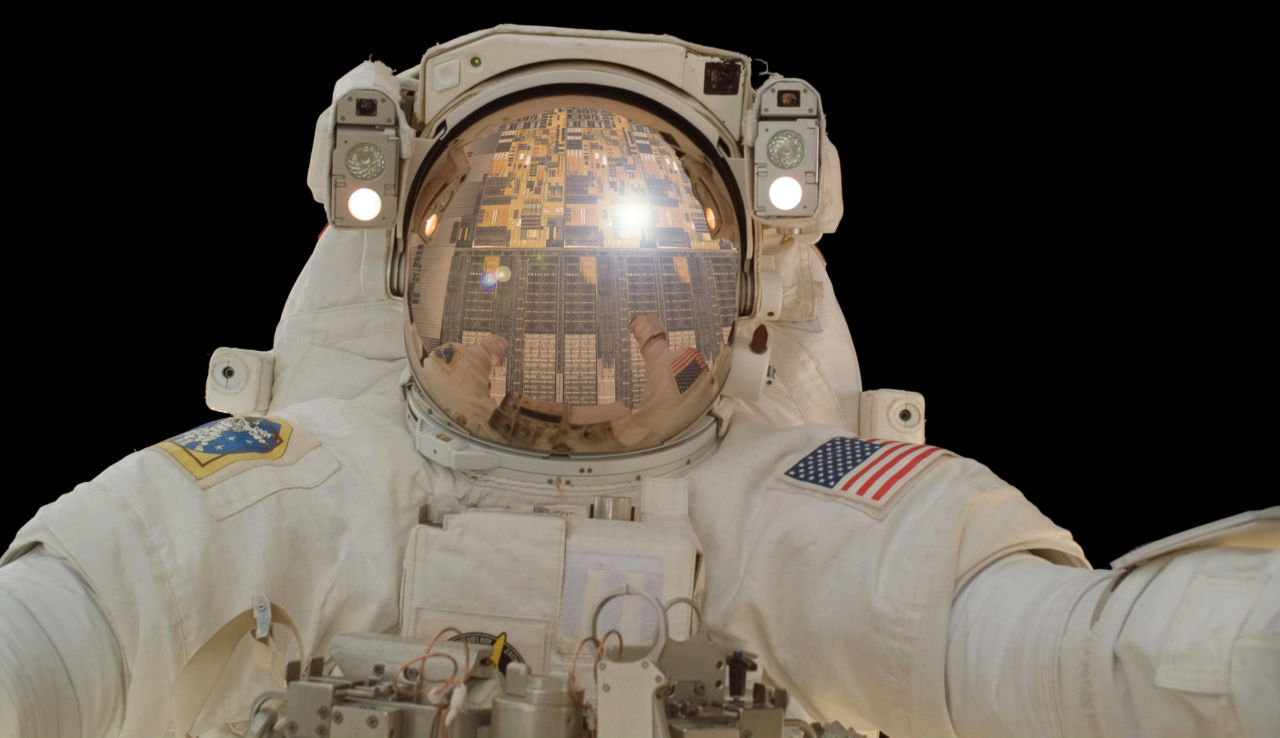

Curiosity, le tout-terrain martien bien-aimé, fonctionne sur deux processeurs BAE RAD750 avec une fréquence d'horloge allant jusqu'à 200 MHz. Il a 256 Mo de RAM et un SSD de 2 Go. À la veille de 2020, le RAD750 est le processeur monocœur de classe spatiale le plus avancé. Aujourd'hui, c'est le meilleur que nous puissions envoyer dans l'espace lointain.

Mais, malheureusement, par rapport au smartphone dans notre poche, les performances du RAD750 ne peuvent que faire pitié. Son circuit est basé sur le PowerPC 750, un processeur qu'IBM et Motorola ont présenté en 1997 en tant que rival de l'Intel Pentium II. Cela signifie que l'équipement spatial le plus technologiquement avancé disponible dans l'espace aujourd'hui peut bien lancer le premier Starcraft (1998) sans problèmes, cependant, il rencontrera des problèmes face à quelque chose de plus exigeant en puissance de calcul. Oubliez de jouer à Mars dans Crysis.

Dans le même temps, le RAD750 coûte environ 200 000 $. Mais vous ne pouvez pas simplement jeter votre iPhone et finir avec lui? En termes de vitesse, les iPhones ont quitté le RAD750 pendant plusieurs générations et ne coûtent que 1 000 $ pièce, ce qui est beaucoup moins que 200 000 $. L'équipe Phobos-Grunt a essayé de faire quelque chose de similaire. Ils ont essayé d'augmenter la vitesse et d'économiser, mais ils sont finalement allés trop loin.

La puce mémoire Phobos Grunt SRAM, endommagée par de lourdes particules chargées, était étiquetée WS512K32V20G24M. Il était bien connu dans l'industrie spatiale car en 2005 ces puces ont été

testées dans l'accélérateur de particules du Brookhaven National Laboratory par T. Page et J. Benedetto pour tester leur comportement lorsqu'elles sont exposées aux radiations. Les chercheurs ont décrit ces puces comme «extrêmement vulnérables» et leurs défaillances se sont produites même sous l'exposition minimale à l'énergie disponible à Brookhaven. Le résultat n'était pas surprenant, car le WS512K32V20G24M n'était pas conçu pour l'espace. Ils ont été développés pour l'aviation militaire. Cependant, ils étaient plus faciles à trouver et ils étaient moins chers que les puces de mémoire de classe spatiale, alors les développeurs de Phobos-Grunt ont décidé de les prendre.

«La découverte de la présence de divers types de rayonnements dans l'espace est devenue l'un des tournants les plus importants de l'histoire de l'électronique spatiale, ainsi qu'une compréhension de l'effet de ces rayonnements sur l'électronique et le développement de technologies de renforcement et de réduction des dommages», a déclaré Tyler Lovely, chercheur au laboratoire de recherche de l'US Air Force. Les principales sources de ce rayonnement sont les rayons cosmiques, les processus solaires et les ceintures de protons et d'électrons situés à la limite du champ magnétique terrestre, connue sous le nom de

ceinture de rayonnement de Van Allen . Parmi les particules entrant en collision avec l'atmosphère terrestre, 89% sont des protons, 9% sont des particules alpha, 1% sont des noyaux plus lourds, 1% sont des électrons libres. Leur énergie peut atteindre 10

19 eV. Utiliser des puces qui ne sont pas adaptées à l'espace dans une sonde qui doit parcourir l'espace pendant plusieurs années signifie demander des ennuis. Le journal Krasnaya Zvezda a

écrit que 62% des puces utilisées sur Phobos-Grunt n'étaient pas destinées à être utilisées dans l'espace. Le programme de sondages pour 62% consistait en le sentiment «visons un iPhone là-bas».

Le rayonnement devient un problème

Aujourd'hui, les rayons cosmiques sont l'un des facteurs clés pris en compte lors de la création d'ordinateurs de classe spatiale. Mais cela n'a pas toujours été le cas.

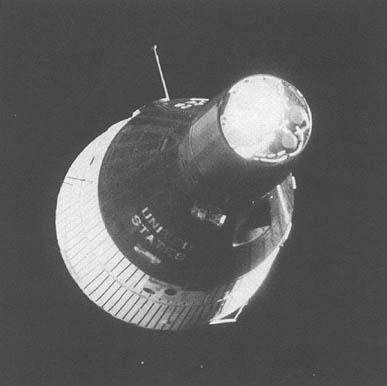

Le premier ordinateur est entré dans l'espace à bord d'un des véhicules Gemini dans les années 1960. Pour obtenir l'autorisation de piloter la voiture, j'ai dû passer plus d'une centaine de tests différents. Les ingénieurs ont testé son comportement en réponse aux vibrations, au vide, aux températures extrêmes, etc. Aucun de ces tests n'a pris en compte les effets des rayonnements. Et pourtant, l'ordinateur de bord "Gemini" fonctionnait très bien, sans aucun problème. C'est parce qu'il était trop grand pour refuser. Littéralement. Jusqu'à 19,5 Ko de mémoire étaient contenus dans une boîte de

11 litres et pesant 12 kg . Et l'ordinateur entier pesait 26 kg.

Dans l'industrie informatique, les progrès du processeur ont généralement consisté à réduire la taille des composants et à augmenter la vitesse d'horloge. Nous avons fait des transistors de plus en plus petits, passant de 240 nm à 65 nm, puis à 14 nm, et déjà à 7 nm, aux smartphones modernes. Plus le transistor est petit, plus la tension nécessaire pour l'activer et le désactiver est faible. Par conséquent, le rayonnement n'a pratiquement pas affecté les anciens processeurs avec de gros composants - plus précisément, les soi-disant

troubles solitaires . La tension créée par la collision avec la particule était trop faible pour affecter le fonctionnement d'un ordinateur suffisamment grand. Mais lorsque les personnes aspirant dans l'espace ont commencé à réduire la taille des composants afin de pousser plus de transistors par puce, les particules créées par la tension sont devenues suffisantes pour causer des problèmes.

Plus communément, les ingénieurs pour améliorer les performances des processeurs augmentent leur vitesse d'horloge. Chez Intel 386SX, sous le contrôle duquel l'automatisation fonctionnait dans la cabine de commande de la navette spatiale, il fonctionnait à une fréquence de 20 MHz. Les processeurs modernes en pointe peuvent atteindre jusqu'à 5 GHz. La fréquence d'horloge détermine le nombre de cycles de traitement dont le processeur est capable par unité de temps. Le problème avec le rayonnement est qu'une collision avec une particule peut ruiner les données dans la mémoire du processeur (cache L1 ou L2) pendant une courte période. Il s'avère que dans chaque seconde, une particule chargée a un nombre limité de possibilités de créer des problèmes. Dans les processeurs avec une petite vitesse d'horloge, ce nombre était assez petit. Mais avec une augmentation de la fréquence, le nombre de ces instants de temps en une seconde a augmenté, ce qui a rendu les processeurs plus sensibles aux radiations. Par conséquent, les processeurs avec une meilleure résistance aux radiations sont presque toujours plus lents que leurs homologues commerciaux. La principale raison pour laquelle les processeurs cosmiques fonctionnent si lentement est que presque toutes les méthodes qui peuvent les accélérer les rendent plus vulnérables.

Heureusement, ce problème peut être contourné.

Nous nous occupons du rayonnement

«Auparavant, le rayonnement était minimisé par un processus semi-conducteur modifié», explique Roland Weigand, ingénieur VISI / ASIC à l'Agence spatiale européenne. «Il suffisait de prendre le cœur commercial du processeur et de lui appliquer un processus qui augmente la résistance aux radiations.» Cette technologie de radioprotection de fabrication utilise des matériaux tels que le saphir ou l'arséniure de gallium, qui réagissent moins aux radiations, contrairement au silicium. Les processeurs ainsi fabriqués fonctionnaient bien dans des environnements à rayonnement élevé, par exemple dans l'espace, mais pour leur production, il était nécessaire de rééquiper toute l'usine.

«Pour augmenter les performances, j'ai dû utiliser des processeurs de plus en plus avancés. Étant donné le coût d'une usine de semi-conducteurs moderne, des changements spéciaux dans le processus de fabrication ont cessé d'être pratiques pour un marché de niche tel que l'espace », explique Weigand. En conséquence, cela a obligé les ingénieurs à utiliser des processeurs commerciaux soumis à des perturbations uniques. «Pour réduire cet effet, nous avons dû passer à d'autres technologies pour augmenter la résistance aux rayonnements - ce que nous appelons la radioprotection de conception», ajoute Weigand.

La protection de la conception a permis aux fabricants d'utiliser le processus de fabrication CMOS standard. De tels processeurs de classe spatiale pourraient être produits dans des usines commerciales, réduisant leur coût à un prix raisonnable et permettant aux développeurs de missions spatiales de rattraper un peu les offres commerciales. Le rayonnement a été traité en utilisant le génie de l'ingénierie, et pas seulement les propriétés physiques du matériau. «Par exemple, la triple redondance modulaire (TMI) est l'un des moyens les plus populaires de protéger une puce des rayonnements, à d'autres égards, elle est complètement standard», a expliqué Weigand. «Trois copies identiques de chaque élément d'information sont gardées en mémoire à tout moment.» Au stade de la lecture, les trois sont lus et la bonne version est choisie par la majorité. »

Si les trois copies sont identiques, les informations sont considérées comme correctes. La même chose se produit lorsque deux copies sont identiques et que l'une en diffère - la bonne copie est choisie à la majorité des voix. Mais lorsque les trois copies sont différentes, le système enregistre une erreur. L'idée est de stocker les mêmes informations dans trois adresses mémoire différentes situées à trois endroits différents sur la puce. Afin de gâcher les données, deux particules doivent simultanément entrer en collision avec les endroits où deux copies de la même particule d'informations sont stockées, ce qui est extrêmement improbable. L'inconvénient de cette approche est la disponibilité d'un travail redondant pour le processeur. Il doit effectuer chaque opération trois fois, ce qui signifie qu'il n'atteindra qu'un tiers de sa vitesse.

La dernière idée est donc venue de rapprocher encore plus les performances des processeurs de classe spatiale de leurs homologues commerciaux. Au lieu de protéger l'ensemble du système d'une puce contre les radiations, les ingénieurs décident où cette protection est la plus pertinente. Et où pouvez-vous le refuser. Cela modifie considérablement les priorités de conception. Les processeurs spatiaux plus anciens étaient insensibles aux radiations. Les nouveaux processeurs y sont sensibles, mais ils sont conçus pour faire face automatiquement à toutes les erreurs que les rayonnements peuvent provoquer.

Par exemple, LEON GR740 est le dernier processeur européen de classe spatiale. On prévoit qu'il subira 9 perturbations uniques par jour alors qu'il se trouve sur l'orbite géostationnaire de la Terre. L'astuce est qu'ils seront tous retenus par le système et ne conduiront pas à des erreurs de fonctionnement. Le GR740 est conçu de sorte qu'une erreur fonctionnelle ne se produise pas plus d'une fois tous les 300 ans. Et même dans ce cas, il peut simplement redémarrer.

L'Europe choisit l'ouverture

La gamme LEON SPARC de processeurs de classe spatiale est le choix le plus populaire d'Europe pour les applications spatiales. «Dans les années 90, lorsque la spécification SPARC a été choisie, elle était profondément ancrée dans l'industrie», explique Weigand. «Sun Microsystems l'a utilisé sur ses stations de travail performantes.» Selon lui, les principales raisons de la transition vers SPARC étaient alors le support logiciel et l'ouverture de la plateforme. «L'architecture ouverte signifiait que tout le monde pouvait l'utiliser sans problème de licence. C'était important car dans un créneau aussi restreint que l'espace, le coût des licences est réparti sur un petit nombre d'appareils, ce qui augmente considérablement leur coût », explique-t-il.

En conséquence, l'ESA a appris par une expérience amère des problèmes de licence. Le premier processeur spatial européen SPARC - ERC32, utilisé à ce jour - utilisait des processeurs commerciaux. Il était basé sur une architecture ouverte, mais les circuits du processeur étaient propriétaires. «Cela a entraîné des problèmes. Il n'y a généralement pas d'accès aux codes sources des systèmes propriétaires, il est donc difficile d'apporter des modifications au projet qui sont nécessaires pour améliorer la radioprotection », explique Weigand. Par conséquent, à l'étape suivante, l'ESA a commencé à travailler sur son propre processeur, LEON. «Son projet était entièrement sous notre contrôle, et nous avons finalement eu l'opportunité d'utiliser toutes les technologies de radioprotection que nous voulions.»

Le dernier développement de la gamme de processeurs LEON est le quadricœur GR740, fonctionnant à une fréquence d'environ 250 MHz. (Weigand dit qu'il s'attend à ce que les premières livraisons soient livrées d'ici la fin de 2019). Le GR740 est

fabriqué en utilisant la technologie de traitement à 65 nm . Il s'agit d'un système à puce conçu pour le calcul à grande vitesse à usage général basé sur l'architecture SPARC32. «L'objectif de la création du GR740 était d'atteindre une plus grande vitesse et la possibilité d'ajouter des dispositifs supplémentaires au circuit intégré, tout en laissant la compatibilité avec les processeurs européens de classe spatiale précédents», explique Weigand. Une autre caractéristique du GR740 est son système avancé de tolérance aux pannes. Le processeur peut faire face à un nombre important d'erreurs causées par les radiations, tout en garantissant un fonctionnement ininterrompu du logiciel. Chaque unité et fonction GR740 est optimisée pour la vitesse la plus élevée. Cela signifie que les composants sensibles à des perturbations uniques sont adjacents à d'autres qui peuvent facilement y faire face. Et tous les composants sensibles sont utilisés dans un circuit qui réduit l'effet des erreurs grâce à la redondance.

Par exemple, certains déclencheurs du GR740 sont des FF CORELIB commerciaux ordinaires. Ils ont été choisis pour être utilisés sur cette puce car ils prennent moins de place, augmentant ainsi la densité de calcul. L'inconvénient est qu'ils sont soumis à des perturbations uniques, mais ils l'ont compris à l'aide de blocs TMI. Chaque information lue à partir de ces déclencheurs est confirmée en votant entre tous les modules situés suffisamment loin pour qu'un événement n'affecte pas plusieurs bits. Des schémas similaires sont mis en œuvre pour les caches de processeur L1 et L2, constitués de cellules SRAM, également soumises à des perturbations uniques. Lorsque de tels systèmes ont commencé à trop influencer les performances, les ingénieurs de l'ESA sont passés à des déclencheurs SKYROB résistants aux perturbations. Cependant, ils occupent deux fois plus d'espace que CORELIB. Lorsque vous essayez d'augmenter la puissance de calcul des ordinateurs dans l'espace, vous devez toujours faire des compromis.

Jusqu'à présent, le GR740 a très bien réussi plusieurs tests de rayonnement. La puce a été tirée avec des ions lourds avec

transfert d'énergie linéaire (LET), atteignant 125 MeV * cm

2 / mg, et ils ont fonctionné sans une seule défaillance. Afin d'avoir quelque chose à comparer, les puces très SRAM, à cause desquelles le Phobos-Grunt est tombé, n'ont échoué que d'environ 0,375 MeV * cm

2 / mg lorsque des particules avec LET ont frappé. Le GR740 a résisté à un rayonnement 300 fois plus puissant. En plus d'une immunité presque complète aux perturbations uniques, le GR740 peut absorber jusqu'à 300 radiations pendant sa durée de vie. Au cours des tests, l'équipe Weigand a même irradié l'un des processeurs jusqu'à 293 degrés, mais malgré cela, la puce a fonctionné, comme d'habitude, sans montrer de signes de dégradation.

Pourtant, des tests montrant la véritable dose maximale d'ionisation que le GR740 est capable d'absorber doivent encore être effectués. L'ensemble de ces chiffres indique que ce processeur, travaillant sur l'orbite géostationnaire de la Terre, devrait produire une erreur fonctionnelle tous les 350 ans. En orbite basse, cette période passe à 1310 ans. Et même de telles erreurs ne tueront pas le GR740. Il n'a qu'à redémarrer.

L'Amérique choisit des solutions brevetées

«Les processeurs de classe spatiale en cours de développement aux États-Unis sont traditionnellement basés sur des technologies propriétaires telles que PowerPC, car les gens avaient plus d'expérience à travailler avec eux et étaient pris en charge par toutes sortes de logiciels», a déclaré Lovelie des laboratoires de recherche de l'US Air Force. Après tout, l'histoire de l'informatique spatiale a commencé avec les processeurs numériques développés par IBM pour les missions Gemini dans les années 1960. Et IBM a travaillé avec une technologie propriétaire.

À ce jour, les processeurs BAE RAD sont basés sur PowerPC, né grâce au travail du consortium IBM, Apple et Motorola. Les processeurs opérant dans les ordinateurs du cockpit de la navette spatiale et du télescope Hubble ont été réalisés sur la base de l'architecture x86 fournie par Intel. PowerPC et x86 étaient des technologies propriétaires. Dans la continuité de cette tradition, le dernier projet dans ce domaine est également basé sur la technologie fermée.

L' ordinateur de vol spatial à grande vitesse ( HPSC ) diffère de PowerPC et x86 en ce que ces derniers étaient mieux connus sous le nom de processeurs de bureau. Et HPSC est basé sur l'architecture ARM qui fonctionne aujourd'hui sur la plupart des smartphones et tablettes.Le HPSC a été développé par la NASA, le laboratoire de recherche de l'US Air Force et Boeing, responsable de la production. HPSC est basé sur des processeurs ARM Cortex A53 à quatre cœurs. Il aura deux de ces processeurs connectés par le bus AMBA, ce qui donnera finalement un système à huit cœurs. Sa vitesse sera donc quelque part dans le domaine des smartphones de milieu de gamme en 2018 comme le Samsung Galaxy J8 ou des cartes de développement comme HiKey Lemaker ou Raspberry Pi. Certes, ces indicateurs sont donnés avant la protection contre les radiations - cela réduira sa vitesse de plus de deux fois. Cependant, nous n'avons plus à lire les gros titres que 200 processeurs du rover Curiosity ne rattraperont pas un iPhone. Après le lancement de HPSC, seulement trois ou quatre de ces puces seront nécessaires pour comparer en vitesse avec un iPhone.«Comme nous n’avons pas encore de véritable HPSC pour les tests, nous ne pouvons que faire des hypothèses raisonnables sur ses performances», explique Lovelie. Le premier paramètre soigneusement étudié était la fréquence d'horloge. Les processeurs commerciaux à huit cœurs Cortex A53 fonctionnent généralement à des fréquences de 1,2 GHz (dans le cas de HiKey Lemaker) à 1,8 GHz (comme le Snapdragon 450). Pour déterminer quelle serait la fréquence d'horloge HPSC après la radioprotection, Lovely a comparédivers processeurs de classe spatiale avec leurs homologues commerciaux. «Nous avons décidé qu'il serait raisonnable de s'attendre à une baisse similaire des performances», dit-il. Lovely a évalué la vitesse d'horloge HPSC à 500 MHz. Et ce sera toujours une vitesse exceptionnellement élevée pour une puce de classe spatiale. Si cette fréquence est vraiment telle, le HPSC sera le champion de la fréquence d'horloge parmi les processeurs de classe spatiale. Cependant, l'augmentation de la puissance de calcul et de la fréquence d'horloge dans l'espace se transforme généralement en graves problèmes.Aujourd'hui, le processeur protégé contre les radiations le plus puissant est le BAE RAD5545. Il s'agit d'une machine à quatre cœurs 64 bits réalisée par le processus de fabrication à 45 nm, fonctionnant à une fréquence d'horloge de 466 MHz et une puissance dissipée jusqu'à 20 W; et 20 watts est décent. Le Quad Core i5 du MacBook Pro 13 pouces 2018 dissipe 28 watts. Il peut chauffer le boîtier en aluminium à des températures très élevées, jusqu'à celles qui commencent à causer des problèmes aux utilisateurs. Pendant une charge de calcul élevée, les ventilateurs se mettent immédiatement en marche pour refroidir l'ensemble du système. les ventilateurs n'aideront pas du tout l'espace, car il n'y a pas d'air qui peut souffler sur une puce chaude.Le seul moyen possible d'éliminer la chaleur du vaisseau spatial est le rayonnement, et cela prend du temps.Bien sûr, les caloducs aideront à éliminer la chaleur du processeur, mais cette chaleur devrait finalement aller quelque part.Certaines missions ont un budget énergétique très limité et ne peuvent tout simplement pas se permettre des processeurs aussi puissants que le RAD5545. Par conséquent, la puissance énergétique dissipée européenne GR740 n'est que de 1,5 watts. Ce n'est pas le plus rapide disponible, mais le plus efficace. Il vous donne juste la quantité maximale de calcul par watt. Un HPSC de 10 W en est proche en deuxième place, mais pas toujours.«Chaque cœur HPSC possède son propre module d'un seul flux de commandes, plusieurs flux de données, OKMD(Données multiples à instruction unique, SIMD). La technologie OKMD a souvent été utilisée dans les ordinateurs de bureau et mobiles commerciaux depuis les années 90. Il aide les processeurs à mieux gérer le traitement de l'image et du son dans les jeux vidéo. Disons que nous devons éclaircir l'image. Il a de nombreux pixels et chacun d'eux a une luminosité qui doit être augmentée de deux. Sans OKMD, le processeur devra effectuer toute cette somme séquentiellement, un pixel après l'autre. En utilisant OKMD, ce problème peut être mis en parallèle. Le processeur prend plusieurs points de données - les valeurs de luminosité de tous les pixels de l'image - et exécute la même instruction avec eux, en ajoutant un deuce à tous en même temps. Et puisque le processeur Cortex A53 a été conçu pour les smartphones et les tablettes qui gèrent une grande quantité de contenu multimédia, HPSC en est également capable.«Ceci est particulièrement bénéfique dans des tâches telles que la compression d'image, le traitement ou la vision stéréo», explique Lovely. - Dans les applications qui n'utilisent pas cette fonctionnalité, HPSC fonctionne un peu mieux que le GR740 et les autres processeurs à espace rapide. Mais quand elle peut être utilisée, la puce est sérieusement en avance sur ses rivaux. "Ramener la science-fiction à l'exploration spatiale

Les développeurs de puces des États-Unis ont tendance à être plus puissants, mais aussi plus exigeants sur les processeurs d'énergie, car les missions de la NASA, à la fois robotiques et habitées, sont généralement à plus grande échelle que leurs homologues européens. En Europe, il n'est pas prévu dans un avenir prévisible d'envoyer des personnes ou des véhicules tout-terrain de la taille d'une voiture sur la Lune ou sur Mars. Aujourd'hui, l'ESA se concentre sur les sondes et les satellites, fonctionnant généralement avec un budget énergétique limité, il est donc plus judicieux de choisir quelque chose de plus léger et plus économe en énergie, comme le GR740. Le HPSC a été initialement conçu pour amener les ambitions de science-fiction de la NASA dans des endroits.Par exemple, en 2011, le Game Changing Development Program de la NASA a commandé une étude sur l'apparence des demandes de calcul dans l'espace dans 15 à 20 ans. Une équipe d'experts de divers centres de l'agence a compilé une liste de tâches que les processeurs avancés pourraient résoudre dans les missions habitées et robotiques. L'une des premières tâches qu'ils ont identifiées a été la surveillance constante de l'état des équipements. Cette tâche se résume à la présence de capteurs qui surveillent en permanence l'état des composants critiques. L'acquisition de données haute fréquence à partir de tous ces capteurs nécessite des processeurs rapides. Un ordinateur lent ferait probablement l'affaire si les données arrivaient quelque part toutes les 10 minutes, mais si vous devez vérifier tous les équipements plusieurs fois par seconde afin d'atteindre l'efficacité,ressemblant à une surveillance en temps réel, votre processeur devrait fonctionner très rapidement. Tout cela doit être développé pour que les astronautes puissent s'asseoir devant le panneau de commande, qui afficherait l'état réel du navire, capable d'émettre des alertes vocales et de superbes graphismes. Pour prendre en charge de tels graphiques, des ordinateurs rapides sont également requis.Cependant, les objectifs de science-fiction ne s'arrêtent pas aux cockpits. Les astronautes qui explorent d'autres mondes ont probablement un système de réalité augmentée intégré à leurs casques. Leur environnement sera complété par des vidéos, des sons et des données GPS générés par ordinateur. En théorie, la réalité augmentée améliorera l'efficacité des chercheurs, marquera les zones à explorer et avertira des situations potentiellement dangereuses. Bien sûr, l'intégration de la réalité augmentée dans un casque n'est qu'une des nombreuses possibilités. Parmi les autres options mentionnées dans l'étude, il y a les appareils portables comme les smartphones, et quelque chose vaguement décrit comme «d'autres possibilités d'affichage des informations». De telles percées informatiques nécessiteront des processeurs de classe spatiale plus rapides.De plus, ces processeurs devraient améliorer les missions robotiques. L'un des principaux exemples est l'atterrissage sur un terrain difficile. Le choix d'un site d'atterrissage en surface est toujours un compromis entre sécurité et valeur scientifique. L'endroit le plus sûr est un plan plat sans pierres, collines, vallées et affleurements rocheux. D'un point de vue scientifique, l'endroit le plus intéressant sera géologiquement diversifié, ce qui signifie une abondance de pierres, de collines, de vallées et d'affleurements rocheux. Une façon de résoudre ce problème est la soi-disant. Navigation basée sur le terrain (NOM). Les véhicules tout-terrain équipés du système NOM seront capables de reconnaître les signes importants, de voir le danger potentiel et de le contourner, ce qui peut réduire le rayon d'atterrissage à 100 m Le problème est que les processeurs de classe spatiale existants sont trop lents pour traiter les images à une telle vitesse.Une équipe de la NASA a lancé le test de performance NOM sur le RAD 750 et a constaté que la mise à jour à partir d'une seule caméra prenait environ 10 secondes. Malheureusement, si vous tombez sur la surface martienne, 10 secondes, c'est beaucoup. Pour faire atterrir un véhicule tout-terrain sur un site d'un rayon de 100 m, les mises à jour de la caméra doivent être traitées toutes les secondes. Pour un atterrissage exact sur le site par mètre, vous aurez besoin de 10 mises à jour par seconde.Parmi les autres souhaits de calcul de la NASA, il y a des algorithmes qui peuvent prédire les catastrophes imminentes en fonction des lectures des capteurs, des graphiques intelligents, de l'autonomie avancée, etc. Tout cela dépasse les capacités des processeurs actuels de classe spatiale. Par conséquent, dans l'étude, les ingénieurs de la NASA donnent leurs estimations de la puissance de calcul nécessaire pour prendre en charge de telles tâches. Ils ont constaté que la surveillance de l'état du navire et l'atterrissage dans des conditions difficiles nécessiteraient 10 à 50 GOPS (giga-opérations par seconde). Les consoles de vol de science-fiction futuristes avec des écrans à la mode et des graphismes avancés nécessiteront 50-100 GOPS. Il en va de même pour les casques de réalité augmentée ou autres appareils; ils consomment également de 50 à 100 GOPS.Idéalement, les futurs processeurs spatiaux pourront facilement prendre en charge tous ces projets. Aujourd'hui, le HPSC, fonctionnant en dissipation de puissance de 7 à 10 watts, est capable de délivrer 9-15 GOPS. Cela pourrait déjà permettre un atterrissage extrême, mais le HPSC est conçu pour que ce chiffre puisse augmenter de manière significative. Tout d'abord, ces 15 GOPS n'incluent pas les avantages de performance reçus d'OKMD. Deuxièmement, ce processeur peut fonctionner en conjonction avec d'autres HPSC et des périphériques externes, par exemple, des processeurs FPGA ou GPU spécialisés. Par conséquent, le vaisseau spatial du futur peut avoir plusieurs processeurs distribués travaillant en parallèle, et des puces spécialisées peuvent traiter certaines tâches telles que le traitement d'image ou les signaux.Peu importe où vont les rêves de l'humanité dans l'espace lointain, les ingénieurs savent déjà à quel stade de développement se situe la puissance de calcul actuelle. Le LEON GR740 devrait être mis à la disposition de l'ESA plus tard cette année, et après avoir passé quelques tests supplémentaires, il devrait être prêt à voler en 2020. La phase de production du HPSC, quant à elle, devrait commencer en 2012 et se terminer en 2022. Le test devrait prendre plusieurs mois en 2022.La NASA devrait recevoir des puces HPSC prêtes à l'emploi d'ici la fin de 2022. Cela signifie que, sans tenir compte d'autres facteurs qui compliquent les progrès, au moins le silicium cosmique se dirige vers l'avenir à une vitesse qui lui permettra de se préparer au retour des gens sur la lune d'ici 2024.