Je viens de Luxoft.

Selon Opennet : LeoFS est une installation de stockage distribuée tolérante aux pannes pour les objets LeoFS , compatible avec les clients utilisant l'API Amazon S3 et l'API REST, et prenant également en charge le mode de fonctionnement en tant que serveur NFS. Il existe des optimisations pour le stockage des objets petits et très grands, il existe un mécanisme de mise en cache intégré, la réplication des stockages entre les centres de données est possible. L'un des objectifs du projet est d'atteindre une fiabilité de 99,9999999% en raison de la réplication excessive des doublons et de l'élimination d'un point de défaillance unique. Le code du projet est écrit en Erlang.

LeoFS se compose de trois composants:

- LeoFS Storage - gère les opérations d'ajout, de récupération et de suppression d'objets et de métadonnées, est responsable de la réplication, de la restauration et de la mise en file d'attente des demandes des clients.

- Passerelle LeoFS - sert les requêtes HTTP et redirige les réponses vers les clients à l'aide de l'API REST ou de l'API S3, fournit la mise en cache des données les plus demandées en mémoire et sur disque.

- LeoFS Manager - surveille le fonctionnement des nœuds LeoFS Gateway et LeoFS Storage, surveille l'état des nœuds et vérifie les sommes de contrôle. Garantit l'intégrité des données et une haute disponibilité de stockage.

Dans ce post, installez Leofs en utilisant ansible-playbook, test S3, NFS.

Si vous essayez d'installer LeoFS en utilisant les playbooks officiels, différentes erreurs vous attendent: 1 , 2 . Dans cet article, j'écrirai ce qui doit être fait pour éviter ces erreurs.

Où vous exécuterez ansible-playbook, vous devez installer netcat.

Exemple d'inventaire

Exemple d'inventaire (dans le référentiel hosts.sample):# Please check roles/common/vars/leofs_releases for available versions [all:vars] leofs_version=1.4.3 build_temp_path="/tmp/leofs_builder" build_install_path="/tmp/" build_branch="master" source="package" #[builder] #172.26.9.177 # nodename of leo_manager_0 and leo_manager_1 are set at group_vars/all [leo_manager_0] 172.26.9.176 # nodename of leo_manager_0 and leo_manager_1 are set at group_vars/all [leo_manager_1] 172.26.9.178 [leo_storage] 172.26.9.179 leofs_module_nodename=S0@172.26.9.179 172.26.9.181 leofs_module_nodename=S0@172.26.9.181 172.26.9.182 leofs_module_nodename=S0@172.26.9.182 172.26.9.183 leofs_module_nodename=S0@172.26.9.183 [leo_gateway] 172.26.9.180 leofs_module_nodename=G0@172.26.9.180 172.26.9.184 leofs_module_nodename=G0@172.26.9.184 [leofs_nodes:children] leo_manager_0 leo_manager_1 leo_gateway leo_storage

Préparation du serveur

Désactiver Selinux. J'espère que la communauté crée des politiques Selinux pour LeoFS.

- name: Install libselinux as prerequisite for SELinux Ansible module yum: name: "{{item}}" state: latest with_items: - libselinux-python - libsemanage-python - name: Disable SELinux at next reboot selinux: state: disabled - name: Set SELinux in permissive mode until the machine is rebooted command: setenforce 0 ignore_errors: true changed_when: false

Installez netcat et redhat-lsb-core . netcat nécessaire pour leofs-adm , redhat-lsb-core nécessaire pour déterminer la version du système d'exploitation ici .

- name: Install Packages yum: name={{ item }} state=present with_items: - nmap-ncat - redhat-lsb-core

Créer un utilisateur leofs et l'ajouter au groupe de roues

- name: Create user leofs group: name: leofs state: present - name: Allow 'wheel' group to have passwordless sudo lineinfile: dest: /etc/sudoers state: present regexp: '^%wheel' line: '%wheel ALL=(ALL) NOPASSWD: ALL' validate: 'visudo -cf %s' - name: Add the user 'leofs' to group 'wheel' user: name: leofs groups: wheel append: yes

Installer Erlang

- name: Remote erlang-20.3.8.23-1.el7.x86_64.rpm install with yum yum: name=https://github.com/rabbitmq/erlang-rpm/releases/download/v20.3.8.23/erlang-20.3.8.23-1.el7.x86_64.rpm

La version complète du livre de jeu ansible corrigé peut être trouvée ici: https://github.com/patsevanton/leofs_ansible

Installation, configuration, démarrage

Ensuite, exécutez comme écrit dans https://github.com/leo-project/leofs_ansible sans build_leofs.yml

Vérification de l'état du cluster sur LeoManager principal

leofs-adm status

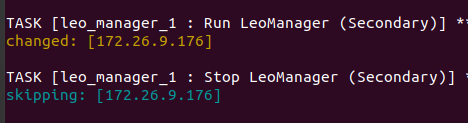

Le primaire et le secondaire peuvent être vus dans les journaux de l'ansible-playbook

La conclusion sera quelque chose comme ça [System Confiuration] -----------------------------------+---------- Item | Value -----------------------------------+---------- Basic/Consistency level -----------------------------------+---------- system version | 1.4.3 cluster Id | leofs_1 DC Id | dc_1 Total replicas | 2 number of successes of R | 1 number of successes of W | 1 number of successes of D | 1 number of rack-awareness replicas | 0 ring size | 2^128 -----------------------------------+---------- Multi DC replication settings -----------------------------------+---------- [mdcr] max number of joinable DCs | 2 [mdcr] total replicas per a DC | 1 [mdcr] number of successes of R | 1 [mdcr] number of successes of W | 1 [mdcr] number of successes of D | 1 -----------------------------------+---------- Manager RING hash -----------------------------------+---------- current ring-hash | a0314afb previous ring-hash | a0314afb -----------------------------------+---------- [State of Node(s)] -------+----------------------+--------------+---------+----------------+----------------+---------------------------- type | node | state | rack id | current ring | prev ring | updated at -------+----------------------+--------------+---------+----------------+----------------+---------------------------- S | S0@172.26.9.179 | running | | a0314afb | a0314afb | 2019-12-05 10:33:47 +0000 S | S0@172.26.9.181 | running | | a0314afb | a0314afb | 2019-12-05 10:33:47 +0000 S | S0@172.26.9.182 | running | | a0314afb | a0314afb | 2019-12-05 10:33:47 +0000 S | S0@172.26.9.183 | attached | | | | 2019-12-05 10:33:58 +0000 G | G0@172.26.9.180 | running | | a0314afb | a0314afb | 2019-12-05 10:33:49 +0000 G | G0@172.26.9.184 | running | | a0314afb | a0314afb | 2019-12-05 10:33:49 +0000 -------+----------------------+--------------+---------+----------------+----------------+----------------------------

Créer un utilisateur

Créer des leofs utilisateur:

leofs-adm create-user leofs leofs access-key-id: 9c2615f32e81e6a1caf5 secret-access-key: 8aaaa35c1ad78a2cbfa1a6cd49ba8aaeb3ba39eb

Liste d'utilisateurs:

leofs-adm get-users user_id | role_id | access_key_id | created_at ------------+---------+------------------------+--------------------------- _test_leofs | 9 | 05236 | 2019-12-02 06:56:49 +0000 leofs | 1 | 9c2615f32e81e6a1caf5 | 2019-12-02 10:43:29 +0000

Créer un seau

Fabriqué un seau

leofs-adm add-bucket leofs 9c2615f32e81e6a1caf5 OK

Liste de seaux:

leofs-adm get-buckets cluster id | bucket | owner | permissions | created at -------------+----------+--------+------------------+--------------------------- leofs_1 | leofs | leofs | Me(full_control) | 2019-12-02 10:44:02 +0000

Configuration de s3cmd

Dans le champ HTTP Proxy server name , spécifiez l'IP du serveur de passerelle

s3cmd --configure Enter new values or accept defaults in brackets with Enter. Refer to user manual for detailed description of all options. Access key and Secret key are your identifiers for Amazon S3. Leave them empty for using the env variables. Access Key [9c2615f32e81e6a1caf5]: Secret Key [8aaaa35c1ad78a2cbfa1a6cd49ba8aaeb3ba39eb]: Default Region [US]: Use "s3.amazonaws.com" for S3 Endpoint and not modify it to the target Amazon S3. S3 Endpoint [s3.amazonaws.com]: Use "%(bucket)s.s3.amazonaws.com" to the target Amazon S3. "%(bucket)s" and "%(location)s" vars can be used if the target S3 system supports dns based buckets. DNS-style bucket+hostname:port template for accessing a bucket [%(bucket)s.s3.amazonaws.com]: leofs Encryption password is used to protect your files from reading by unauthorized persons while in transfer to S3 Encryption password: Path to GPG program [/usr/bin/gpg]: When using secure HTTPS protocol all communication with Amazon S3 servers is protected from 3rd party eavesdropping. This method is slower than plain HTTP, and can only be proxied with Python 2.7 or newer Use HTTPS protocol [No]: On some networks all internet access must go through a HTTP proxy. Try setting it here if you can't connect to S3 directly HTTP Proxy server name [172.26.9.180]: HTTP Proxy server port [8080]: New settings: Access Key: 9c2615f32e81e6a1caf5 Secret Key: 8aaaa35c1ad78a2cbfa1a6cd49ba8aaeb3ba39eb Default Region: US S3 Endpoint: s3.amazonaws.com DNS-style bucket+hostname:port template for accessing a bucket: leofs Encryption password: Path to GPG program: /usr/bin/gpg Use HTTPS protocol: False HTTP Proxy server name: 172.26.9.180 HTTP Proxy server port: 8080 Test access with supplied credentials? [Y/n] Y Please wait, attempting to list all buckets... Success. Your access key and secret key worked fine :-) Now verifying that encryption works... Not configured. Never mind. Save settings? [y/N] y Configuration saved to '/home/user/.s3cfg'

Si vous recevez une erreur ERREUR: erreur S3: 403 (AccessDenied): accès refusé:

s3cmd put test.py s3://leofs/ upload: 'test.py' -> 's3://leofs/test.py' [1 of 1] 382 of 382 100% in 0s 3.40 kB/s done ERROR: S3 error: 403 (AccessDenied): Access Denied

Ensuite, vous devez corriger signature_v2 dans la configuration True s3cmd. Détails dans ce numéro .

Si signature_v2 est False, alors il y aura une telle erreur:

WARNING: Retrying failed request: /?delimiter=%2F (getaddrinfo() argument 2 must be integer or string) WARNING: Waiting 3 sec... WARNING: Retrying failed request: /?delimiter=%2F (getaddrinfo() argument 2 must be integer or string) WARNING: Waiting 6 sec... ERROR: Test failed: Request failed for: /?delimiter=%2F

Test de démarrage

Créez un fichier de 1 Go

fallocate -l 1GB 1gb

Téléchargez-le sur Leofs

time s3cmd put 1gb s3://leofs/ real 0m19.099s user 0m7.855s sys 0m1.620s

Statistiques

leofs-adm du pour 1 nœud:

leofs-adm du S0@172.26.9.179 active number of objects: 156 total number of objects: 156 active size of objects: 602954495 total size of objects: 602954495 ratio of active size: 100.0% last compaction start: ____-__-__ __:__:__ last compaction end: ____-__-__ __:__:__

Nous voyons que la conclusion n'est pas très informative.

Voyons où se trouve ce fichier.

leofs-adm whereis leofs / 1gb

leofs-adm whereis leofs/1gb -------+----------------------+--------------------------------------+------------+--------------+----------------+----------------+----------------+---------------------------- del? | node | ring address | size | checksum | has children | total chunks | clock | when -------+----------------------+--------------------------------------+------------+--------------+----------------+----------------+----------------+---------------------------- | S0@172.26.9.181 | 657a9f3a3db822a7f1f5050925b26270 | 976563K | a4634eea55 | true | 64 | 598f2aa976a4f | 2019-12-05 10:48:15 +0000 | S0@172.26.9.182 | 657a9f3a3db822a7f1f5050925b26270 | 976563K | a4634eea55 | true | 64 | 598f2aa976a4f | 2019-12-05 10:48:15 +0000

Activer NFS

Nous activons NFS sur le serveur Leo Gateway 172.26.9.184.

Sur le serveur et le client, installez nfs-utils

sudo yum install nfs-utils

Selon les instructions, nous corrigerons le fichier de configuration /usr/local/leofs/current/leo_gateway/etc/leo_gateway.conf

protocol = nfs

Sur le serveur 172.26.9.184, exécutez rpcbind et leofs-gateway

sudo service rpcbind start sudo service leofs-gateway restart

Sur le serveur où leo_manager s'exécute, créez un compartiment pour NFS et générez une clé pour vous connecter à NFS

leofs-adm add-bucket test 05236 leofs-adm gen-nfs-mnt-key test 05236 ip--nfs-

Se connecter à NFS

sudo mkdir /mnt/leofs

Afficher l'espace disque via un client NFS

Espace disque étant donné que chaque nœud de stockage possède un disque de 40 Go (3 nœuds en cours d'exécution, 1 nœud connecté):

df -hP Filesystem Size Used Avail Use% Mounted on 172.26.9.184:/test/05236/e7298032e78749149dd83a1e366afb328811c95b 60G 3.6G 57G 6% /mnt/leofs

Installez LeoFS avec 6 nœuds de stockage.

Inventaire (sans constructeur): Sortie d'état Leofs-adm

Sortie d'état Leofs-adm [System Confiuration] -----------------------------------+---------- Item | Value -----------------------------------+---------- Basic/Consistency level -----------------------------------+---------- system version | 1.4.3 cluster Id | leofs_1 DC Id | dc_1 Total replicas | 2 number of successes of R | 1 number of successes of W | 1 number of successes of D | 1 number of rack-awareness replicas | 0 ring size | 2^128 -----------------------------------+---------- Multi DC replication settings -----------------------------------+---------- [mdcr] max number of joinable DCs | 2 [mdcr] total replicas per a DC | 1 [mdcr] number of successes of R | 1 [mdcr] number of successes of W | 1 [mdcr] number of successes of D | 1 -----------------------------------+---------- Manager RING hash -----------------------------------+---------- current ring-hash | d8ff465e previous ring-hash | d8ff465e -----------------------------------+---------- [State of Node(s)] -------+----------------------+--------------+---------+----------------+----------------+---------------------------- type | node | state | rack id | current ring | prev ring | updated at -------+----------------------+--------------+---------+----------------+----------------+---------------------------- S | S0@172.26.9.178 | running | | d8ff465e | d8ff465e | 2019-12-06 05:18:29 +0000 S | S0@172.26.9.179 | running | | d8ff465e | d8ff465e | 2019-12-06 05:18:29 +0000 S | S0@172.26.9.181 | running | | d8ff465e | d8ff465e | 2019-12-06 05:18:30 +0000 S | S0@172.26.9.182 | running | | d8ff465e | d8ff465e | 2019-12-06 05:18:29 +0000 S | S0@172.26.9.183 | running | | d8ff465e | d8ff465e | 2019-12-06 05:18:29 +0000 S | S0@172.26.9.185 | running | | d8ff465e | d8ff465e | 2019-12-06 05:18:29 +0000 G | G0@172.26.9.180 | running | | d8ff465e | d8ff465e | 2019-12-06 05:18:31 +0000 G | G0@172.26.9.184 | running | | d8ff465e | d8ff465e | 2019-12-06 05:18:31 +0000 -------+----------------------+--------------+---------+----------------+----------------+----------------------------

Espace disque, en tenant compte du fait que chaque nœud de stockage dispose d'un disque de 40 Go (6 nœuds en cours d'exécution):

df -hP Filesystem Size Used Avail Use% Mounted on 172.26.9.184:/test/05236/e7298032e78749149dd83a1e366afb328811c95b 120G 3.6G 117G 3% /mnt/leofs

Si 5 nœuds de stockage sont utilisés

[leo_storage] 172.26.9.178 leofs_module_nodename=S0@172.26.9.178 172.26.9.179 leofs_module_nodename=S1@172.26.9.179 172.26.9.181 leofs_module_nodename=S2@172.26.9.181 172.26.9.182 leofs_module_nodename=S3@172.26.9.182 172.26.9.183 leofs_module_nodename=S4@172.26.9.183

df -hP 172.26.9.184:/test/05236/e7298032e78749149dd83a1e366afb328811c95b 100G 3.0G 97G 3% /mnt/leofs

Journaux

Les journaux se trouvent dans les répertoires /usr/local/leofs/current/*/log

Si vous installez / configurez Leofs manuellement, vous pouvez rencontrer les erreurs suivantes.

[ERREUR] Mnesia n'est pas disponible

Démarrer le service systemctl démarrer leofs-manager-master

leofs-adm status [ERROR] Mnesia is not available

Besoin de démarrer systemctl start leofs-manager-slave sur leo_manager_1

Leofs-stockage ne démarre pas.

Il est nécessaire que le statut de leofs-manager-master et leofs-manager-slave et leofs-adm s'exécute pour afficher le statut.

Noeuds attachés inférieurs à # de répliques

Lorsque vous démarrez leofs-adm start, vous obtenez cette erreur:

leofs-adm start [ERROR] Attached nodes less than

Pas assez de nœuds de stockage. Le statut leofs-adm vous montrera moins de 2 nœuds de stockage. Nombre minimal requis de nœuds de stockage 2.

l'état leofs-adm est joint, le reste est en cours d'exécution.

Besoin de rééquilibrer les nœuds

leofs-adm rebalance

Après le démarrage de leofs-gateway, vous ne voyez pas le nœud de passerelle dans l'état leofs-adm

Besoin de démarrer leofs-adm

leofs-adm start

impossible de se connecter à LeoFS Manager sur le nœud esclave

(Par défaut, leofs-adm ne fonctionne pas sur le nœud esclave!] ( Https://leo-project.net/leofs/docs/issues/documentation-issues/ )

Test de charge

Le test a lieu sur 2 nœuds avec la configuration:

CPU: Single Core Intel Core (Broadwell) (-MCP-) speed: 2295 MHz Kernel: 3.10.0-862.3.2.el7.x86_64 x86_64 Up: 1h 08m Mem: 1023.8/1999.6 MiB (51.2%) Storage: 10.00 GiB (43.5% used) Procs: 98 Shell: bash 4.2.46 inxi: 3.0.37

Pour les tests, prenez un petit disque

Sur les deux nœuds, nous voyons un disque d'espace libre de 9.4G et 5.9G.

df -hP Filesystem Size Used Avail Use% Mounted on /dev/vda1 9.4G 5.9G 3.1G 66% /

Canal télégramme: SDS et Cluster FS