Déterminer le niveau de l'IA est l'un des problèmes les plus difficiles, mais aussi l'un des plus importants dans le domaine de l'informatique. Si vous ne pouvez pas dire avec certitude si la machine créée aujourd'hui est plus intelligente que la machine créée hier, comment pouvez-vous déterminer que vous progressez?

À première vue, il peut sembler que ce n'est pas du tout un problème. «Bien sûr, l'IA devient plus intelligente», est l'un des points de vue sur le problème. «Il suffit de regarder tout cet argent et ces gens talentueux qui se sont précipités dans l'industrie. Regardez les réalisations, telles que vaincre les gens dans GO, et toutes sortes de tâches qui ne pouvaient pas être résolues il y a 10 ans, mais aujourd'hui, elles sont devenues monnaie courante, comme la reconnaissance d'image. N'est-ce pas vraiment un progrès?

Un autre point de vue est que ces réalisations ne sont pas un bon indicateur de l'intelligence. Oui, la défaite des gens aux échecs et au go est impressionnante, mais qu'importe, même si l'ordinateur le plus intelligent perd lors de la résolution de problèmes généraux pour un enfant ou un rat?

Cette critique vient du chercheur en intelligence artificielle François Cholet, ingénieur logiciel Google et figure bien connue de la communauté du machine learning. Cholet est le créateur de Keras, une bibliothèque très populaire pour la création de réseaux de neurones. Il a également écrit de nombreux didacticiels d'apprentissage automatique et maintient un

compte Twitter populaire commentant divers événements de l'industrie.

Dans un article récent, «

Sur la mesure de l'intelligence », Cholet soutient également que le monde de l'IA doit décider ce qu'est l'intelligence et ce qui ne l'est pas. Selon Cholet, si les chercheurs veulent faire des progrès dans la création de l'intelligence artificielle universelle, alors ils devraient cesser de regarder les repères populaires, tels que les jeux vidéo ou les jeux de société, et vous devriez commencer à penser à des compétences qui rendent vraiment les gens plus intelligents, comme notre capacité à généraliser et s'adapter.

Dans une interview sur The Verge, presque prise, Cholet a expliqué ses réflexions à ce sujet, expliquant pourquoi il pense que les réalisations actuelles dans le domaine de l'IA ont été "déformées", comment nous pouvons mesurer l'intelligence à l'avenir, et pourquoi des histoires effrayantes sur l'IA super-intelligente ( qui sont racontées par Elon Musk et d'autres) occupent une quantité déraisonnablement grande d'attention dans l'imagination du public.

L'interview a été légèrement modifiée pour plus de clarté.

Dans votre article, vous décrivez deux concepts différents de l'intelligence qui ont influencé le domaine de l'IA. Le premier décrit l'intelligence comme la capacité de réussir dans un large éventail de tâches, tandis que le second donne la priorité à l'adaptabilité et à la généralisation, c'est-à-dire la capacité de l'IA à répondre à de nouveaux défis. Quel concept a le plus d'influence aujourd'hui et quelles en sont les conséquences?Au cours des 30 premières années de l'histoire de l'industrie, le premier concept était le plus populaire: l'intelligence en tant qu'ensemble de programmes statiques et de bases de connaissances explicites. En ce moment, le pendule a basculé très fortement dans la direction opposée: l'intellect est représenté comme une «ardoise propre» ou, si une métaphore plus appropriée est utilisée, un «réseau neuronal profond juste initialisé». Malheureusement, ce concept n'est presque pas remis en cause et n'a pas été largement étudié. Ces questions ont été discutées pendant longtemps dans la communauté scientifique - littéralement pendant des décennies - mais maintenant je ne vois pas de prise de conscience parmi les personnes impliquées dans le deep learning, peut-être parce que la plupart d'entre elles sont arrivées dans ce domaine après 2016.

Les monopoles intellectuels d'un seul point de vue ne sont jamais bons, surtout comme réponse à des questions scientifiques mal comprises. Cela limite l'ensemble des questions posées. Cela limite le nombre d'idées que les gens pourraient demander. Je pense que les chercheurs prennent maintenant conscience de ce fait.

Dans votre article, vous affirmez également que l'amélioration de l'IA nécessite une définition plus précise de l'intelligence. Vous prétendez que les chercheurs se concentrent désormais sur des repères et des tests statistiques, tels que gagner des jeux vidéo et des jeux de société. Pourquoi vous manque ce QI?Le fait est qu'en choisissant une telle mesure, vous utiliserez toutes les failles disponibles (raccourcis, chemins raccourcis) pour y parvenir. Par exemple, si vous choisissez un jeu d'échecs comme mesure d'intelligence (c'était des années 1970 aux années 1990), vous vous retrouvez avec un système qui joue aux échecs et rien d'autre. Il n'y a aucune raison de croire que ce système sera bon pour autre chose. En conséquence, vous obtenez un arbre de recherche et un minimax, il ne dit rien sur l'intelligence humaine. Aujourd'hui, la poursuite de la maîtrise de jeux vidéo tels que Dota ou StarCraft tombe dans le même piège intellectuel.

Ce n'est peut-être pas évident, car chez l'homme, les compétences et l'intelligence sont étroitement liées. L'esprit humain peut utiliser son intelligence universelle pour maîtriser des compétences spéciales pour la tâche. Les gens qui sont vraiment bons aux échecs peuvent être considérés comme assez intelligents, car, indirectement, nous savons qu'ils sont partis de zéro et ont dû utiliser leur intelligence universelle pour apprendre à jouer aux échecs. Ils n'étaient pas faits pour jouer aux échecs. Ainsi, nous savons qu'ils pourraient diriger leur intelligence universelle vers d'autres tâches et apprendre à effectuer ces tâches de manière similaire. Voilà ce qu'est la polyvalence.

Mais avec des voitures un peu différemment. Une machine peut être conçue pour jouer aux échecs. Ainsi, la conclusion que nous tirons sur les gens - «peut jouer aux échecs, doit donc être intelligent» - s'effondre. Et nos hypothèses anthropomorphiques ne peuvent plus être appliquées. L'intelligence universelle peut maîtriser les compétences spécifiques à la tâche, mais il n'y a pas de retour de la compétence spécifique à la tâche à l'intelligence universelle. Absolument. Ainsi, dans les voitures, les compétences et l'intelligence sont deux choses complètement différentes. Vous pouvez acquérir des compétences arbitraires dans des tâches arbitraires si vous pouvez collecter une quantité infinie de données sur une tâche (ou dépenser une quantité infinie de ressources d'ingénierie). Et cela ne vous rapproche pas encore d'un pouce de l'intelligence universelle.

Le point clé ici est qu'il n'y a aucun problème dans lequel, atteindre une compétence élevée serait un signe d'intelligence. Ce n'est que si la tâche n'est pas vraiment une méta-tâche, et pour la résoudre, il serait nécessaire d'acquérir de nouvelles compétences dans un large éventail de problèmes inconnus auparavant. C’est ainsi que je propose de mesurer l’intelligence.

Si les tests actuels ne nous aident pas à développer l'IA avec une intelligence plus universelle et flexible, pourquoi sont-ils si populaires?

Si les tests actuels ne nous aident pas à développer l'IA avec une intelligence plus universelle et flexible, pourquoi sont-ils si populaires?Il ne fait aucun doute que les efforts pour vaincre les champions dans les jeux vidéo célèbres sont principalement dus au fait que de tels projets peuvent attirer beaucoup l'attention des médias. Si le public n'était pas intéressé par ces «réalisations» frappantes, qui peuvent si facilement être imaginées comme des progrès supposés dans la réalisation d'une IA surhumaine, les chercheurs feraient autre chose.

Cela me rend un peu triste, car la recherche devrait répondre à des questions scientifiques ouvertes et ne pas s'engager dans les relations publiques. Si j'ai l'intention de «résoudre» Warcraft 3 à un niveau surhumain, en utilisant une formation approfondie, vous pouvez être absolument sûr que tout fonctionnera à condition que nous ayons un talent pour le développement et une puissance de calcul suffisante (qui coûtera des dizaines de millions de dollars pour résoudre un tel problème). Mais après avoir fait cela, qu'est-ce que j'apprends sur l'intelligence ou la polyvalence? Rien. Dans le meilleur des cas, j'acquerrais les connaissances en ingénierie pour mettre à l'échelle l'apprentissage en profondeur. Par conséquent, je ne considère pas cela comme une étude scientifique, car il n'enseigne pas ce que nous ne savions pas encore. Nous ne répondons pas à une seule question ouverte. Si la question était: «Pouvons-nous jouer à X à un niveau surhumain?», La réponse est sans équivoque: «Oui, si vous pouvez générer beaucoup de situations d'entraînement et les représenter dans un modèle d'apprentissage expressif plutôt expressif.» Nous le savons depuis un certain temps maintenant (en

fait, je l'ai dit avant que l'IA n'atteigne le niveau de champion dans Dota 2 et Starcraft )

.Quelles sont, selon vous, les véritables réalisations de ces projets? Dans quelle mesure leurs résultats sont-ils mal interprétés ou déformés?Une distorsion grave que je vois est que ces systèmes de jeu de haut niveau représentent un réel progrès vers «les systèmes d'IA et leur capacité à faire face à la complexité et à l'incertitude du monde réel» [ceci est tiré de la déclaration d'OpenAI dans un

communiqué de presse à leur OpenAI Five bot jouant Dota 2]. Mais ils ne le peuvent pas. S'il en était ainsi, ces études seraient très utiles, mais ce n'est tout simplement pas vrai. Par exemple, prenez OpenAI Five: il ne pouvait pas faire face à la complexité de Dota 2, car il était formé sur 16 personnages, et il ne pouvait pas diffuser les connaissances à l'ensemble du jeu, dans lequel il y a plus de 100 personnages. Il a fallu 45 000 ans de gameplay pour l'entraîner - encore une fois, notez comment les exigences en matière de données d'entraînement augmentent avec la complexité de la tâche - cependant, le modèle résultant s'est révélé très fragile: les joueurs non champions pouvaient trouver des stratégies pour vaincre le bot. quelques jours après que l'IA soit devenue accessible au public.

Si jamais vous voulez apprendre à gérer la complexité et l'incertitude du monde réel, vous devriez commencer à poser des questions telles que: quelle est l'universalité de l'intelligence? Comment mesurer et accroître la polyvalence de nos systèmes d'apprentissage? Et ce n'est pas du tout la même chose que ce que nous faisons actuellement, lorsque nous déposons 10 fois plus de données dans un grand réseau de neurones afin qu'il améliore ses compétences de plusieurs pour cent.

Alors, quelle mesure de l'intelligence est la meilleure pour l'industrie?En bref, nous devons cesser d'évaluer les compétences dans des tâches pré-connues telles que les échecs, Dota ou StarCraft, et plutôt commencer à évaluer la capacité du système à acquérir des compétences. Cela signifie que nous devons utiliser uniquement de nouvelles tâches qui n'étaient pas connues auparavant du système, mesurer la connaissance préliminaire de la tâche avec laquelle le système a démarré et mesurer l'efficacité du système (combien de données sont nécessaires pour apprendre à terminer la tâche). Moins vous avez besoin d'informations (connaissances et expérience préalables) pour atteindre un certain niveau de compétences, plus vous êtes intelligent. Compte tenu de ce qui précède, en fait, les systèmes modernes d'intelligence artificielle ne sont pas très intelligents.

De plus, avec cette mesure d'intelligence, les machines ressembleront davantage à des personnes car il peut y avoir différents types d'intelligence, et l'intelligence humaine est ce que nous voulons dire indirectement lorsque nous parlons d'intelligence universelle. Et cela inclut également les tentatives de comprendre avec quel ensemble de connaissances les gens naissent dans le monde. Les gens apprennent incroyablement efficacement - ils ont besoin de très peu d'expérience pour acquérir de nouvelles compétences - mais ils ne le font pas à partir de zéro. Ils utilisent des connaissances innées, en plus des compétences et des connaissances accumulées tout au long de la vie.

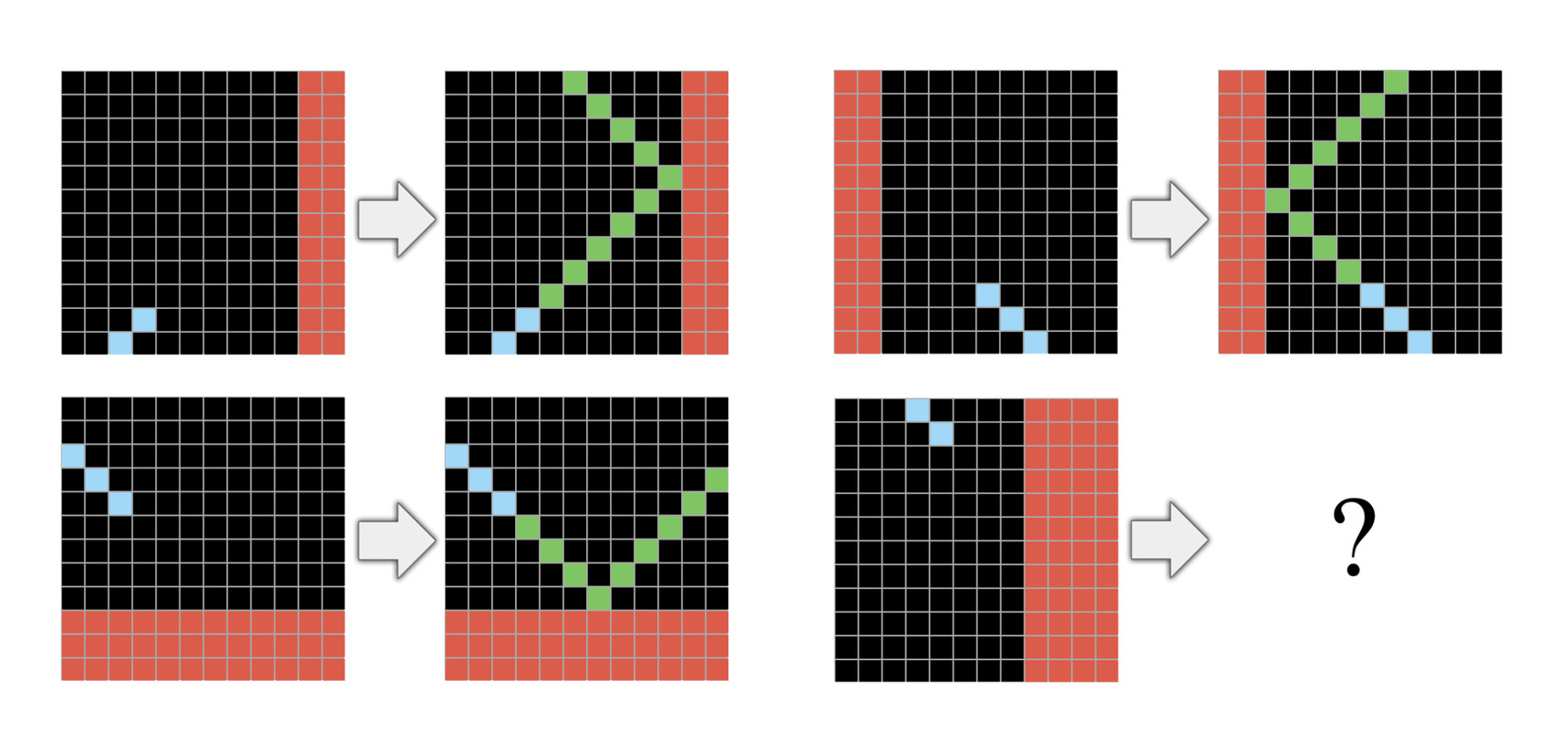

Dans mon récent article, je propose un nouvel ensemble de données d'évaluation, ARC, qui est très similaire au test IQ. ARC est un ensemble de tâches mentales dans lesquelles chaque tâche est expliquée dans une courte séquence de démos, généralement trois, et vous devez apprendre à terminer la tâche à partir de ces quelques démos. L'idée derrière ARC est que chaque tâche qui évalue votre système doit être complètement nouvelle et inclure uniquement des connaissances cohérentes avec les connaissances innées humaines. Par exemple, le langage humain ne peut pas être utilisé dans de telles tâches. Actuellement, les gens peuvent résoudre l'ARC sans aucune explication verbale ni préparation préalable, mais aucun des systèmes d'IA actuellement connus ne peut le résoudre. C'est un marqueur important pour lequel nous avons besoin de nouvelles idées.

Pensez-vous que le monde de l'IA sera en mesure de poursuivre sa progression simplement en augmentant la puissance de calcul pour résoudre les problèmes? Certains soutiennent qu'au fil des ans, cela a été le moyen le plus efficace d'augmenter la productivité. Lorsque d'autres suggèrent que si nous suivons cette voie, les résultats et les taux de croissance commenceront à se détériorer.

Pensez-vous que le monde de l'IA sera en mesure de poursuivre sa progression simplement en augmentant la puissance de calcul pour résoudre les problèmes? Certains soutiennent qu'au fil des ans, cela a été le moyen le plus efficace d'augmenter la productivité. Lorsque d'autres suggèrent que si nous suivons cette voie, les résultats et les taux de croissance commenceront à se détériorer.Cela est absolument vrai si vous travaillez sur une tâche spécifique. L'utilisation de plus de données d'entraînement et de plus de puissance de calcul pour une tâche verticale augmentera la productivité de cette tâche. Mais cela vous donnera une compréhension pratiquement nulle de la façon d'atteindre la polyvalence de l'intelligence artificielle.

Si vous avez un modèle suffisamment grand de formation approfondie et un bon échantillon pour la tâche, il apprendra comment résoudre ce problème, que ce soit Dota ou StarCraft, quoi que ce soit. Et c'est extrêmement précieux. Cela peut être utilisé dans un nombre presque infini de tâches liées à la perception de la machine. Le seul problème est que la quantité de données dont vous avez besoin est une fonction combinatoire relative à la complexité de la tâche, de sorte que même des tâches légèrement complexes peuvent devenir trop coûteuses.

Prenons par exemple les voitures à pilote automatique. Des millions de situations d'entraînement ne suffiront pas à un modèle utilisant uniquement une formation approfondie pour apprendre à conduire en toute sécurité. C'est pourquoi nous n'avons pas encore de pilote automatique de 5ème niveau. Et dans les systèmes de pilote automatique les plus avancés, l'apprentissage en profondeur est principalement utilisé pour relier les données des capteurs et les modèles créés manuellement. Et si nous avions un apprentissage profond universel, nous aurions un pilote automatique de niveau 5 en 2016 sous la forme d'un grand réseau de neurones.

Et enfin, étant donné que vous parlez des limites de l'IA moderne, il me semble intéressant de vous interroger sur la crainte qu'une IA extrêmement puissante puisse nuire à l'humanité dans un proche avenir. Pensez-vous que ce sont des craintes fondées?Non, je ne crois pas à la validité de cette idée. Nous n'avons jamais créé d'IA autonome. Et il n'y a absolument aucun signe que nous pourrons le créer dans un avenir prévisible. (L'industrie de l'IA ne va pas dans cette direction maintenant.) Et nous ne pouvons même pas imaginer quelles pourraient être ses caractéristiques si nous la créons finalement dans un avenir lointain. Si vous voulez une analogie, c'est comme demander en 1600: «La balistique se développe assez rapidement! Mais que faire si nous avons une fois une arme à feu qui peut détruire une ville entière. Comment pouvons-nous être sûrs qu'elle ne tuera que les méchants? » C'est une question assez mal formulée, et sa discussion en l'absence de toute connaissance exacte de cette future IA se résume au mieux à un argument philosophique.

Et pourtant, ces craintes concernant l'intelligence excessive détournent l'attention d'autres domaines dans lesquels l'IA peut être très dangereuse aujourd'hui. Certaines façons d'utiliser l'IA sont dangereuses sans super intelligence. J'ai écrit sur la façon dont l'IA peut être utilisée pour les systèmes de propagande algorithmique. On a déjà beaucoup écrit sur la tendance croissante à utiliser l'IA dans les systèmes d'armes ou sur l'IA comme outil de contrôle totalitaire.

Il y a une histoire sur le siège de Constantinople en 1453. Pendant que la ville combattait l'armée ottomane, ses érudits et dirigeants ont discuté du genre d'anges qui pouvaient être de sexe. Et plus nous consacrons d'énergie et d'attention au débat sur le sexe des anges ou à la réflexion sur les valeurs qu'une IA super-intelligente devrait avoir, moins nous prêtons attention à la résolution de problèmes urgents et réels. Il y a un leader bien connu de l'informatique qui aime parler de l'IA superintelligente comme la principale menace pour l'humanité. Eh bien, alors que ces idées occupent toutes les manchettes, vous ne discutez pas s'il est éthique de produire des voitures avec un pilote automatique insuffisamment précis sur nos routes, ce qui entraîne des accidents et des décès.

Si vous acceptez cette critique - selon laquelle il n'y a actuellement aucune base technique pour ces craintes - pourquoi, à votre avis, sont-elles si populaires?Je pense que c'est juste une belle histoire et les gens l'aiment. Ce n'est pas un hasard si tout rappelle tant d'histoires religieuses sur la fin du monde, car de telles histoires se sont propagées et ont résonné parmi les gens pendant longtemps. Pour la même raison, cette peur est souvent utilisée dans les films et romans de science-fiction. C'est parce que c'est une belle histoire. Et les gens ont besoin d'histoires pour comprendre le monde. Et ces histoires sont beaucoup plus demandées que de comprendre la nature de l'intelligence ou de comprendre ce qui motive le progrès technologique.

Il y a aussi des morceaux plus intéressants

dans la chaîne Telegram .